Neste tutorial, você vai aprender a usar um modelo de série temporal univariada ARIMA_PLUS para prever o valor futuro de uma determinada coluna com base nos valores históricos dela.

Este tutorial prevê uma única série temporal. Os valores previstos são calculados uma vez para cada ponto de tempo nos dados de entrada.

Este tutorial usa dados da tabela de exemplo bigquery-public-data.google_analytics_sample.ga_sessions pública. Essa tabela contém dados de e-commerce ofuscados da Google Merchandise Store.

Objetivos

Este tutorial vai orientar você nas tarefas a seguir:

- Criar um modelo de série temporal para prever o tráfego do site usando a instrução

CREATE MODEL. - Avalie as informações de média móvel integrada autoregressiva (ARIMA) no modelo usando a função

ML.ARIMA_EVALUATE. - Inspecionar os coeficientes do modelo usando a

função

ML.ARIMA_COEFFICIENTS. - Recuperar as informações de tráfego do site previstas pelo modelo usando a

função

ML.FORECAST. - Recuperar componentes da série temporal, como sazonalidade e tendência, usando a função

ML.EXPLAIN_FORECAST. É possível inspecionar esses componentes para explicar os valores previstos.

Custos

Neste tutorial, usamos componentes faturáveis do Google Cloud, incluindo:

- BigQuery

- BigQuery ML

Para mais informações sobre os custos do BigQuery, consulte a página de preços.

Para mais informações sobre os custos do BigQuery ML, consulte os preços do BigQuery ML.

Antes de começar

- Sign in to your Google Cloud account. If you're new to Google Cloud, create an account to evaluate how our products perform in real-world scenarios. New customers also get $300 in free credits to run, test, and deploy workloads.

-

In the Google Cloud console, on the project selector page, select or create a Google Cloud project.

-

Verify that billing is enabled for your Google Cloud project.

-

In the Google Cloud console, on the project selector page, select or create a Google Cloud project.

-

Verify that billing is enabled for your Google Cloud project.

- O BigQuery é ativado automaticamente em novos projetos.

Para ativar o BigQuery em um projeto preexistente, acesse

Enable the BigQuery API.

Para criar o conjunto de dados, é preciso ter a permissão de IAM

bigquery.datasets.create.Para criar o modelo, você precisa das seguintes permissões:

bigquery.jobs.createbigquery.models.createbigquery.models.getDatabigquery.models.updateData

Para executar a inferência, você precisa das seguintes permissões:

bigquery.models.getDatabigquery.jobs.create

Permissões exigidas

Para mais informações sobre os papéis e as permissões do IAM no BigQuery, consulte Introdução ao IAM.

crie um conjunto de dados

Crie um conjunto de dados do BigQuery para armazenar seu modelo de ML.

Console

No console do Google Cloud , acesse a página BigQuery.

No painel Explorer, clique no nome do seu projeto.

Clique em Conferir ações > Criar conjunto de dados.

Na página Criar conjunto de dados, faça o seguinte:

Para o código do conjunto de dados, insira

bqml_tutorial.Em Tipo de local, selecione Multirregião e EUA (várias regiões nos Estados Unidos).

Mantenha as configurações padrão restantes e clique em Criar conjunto de dados.

bq

Para criar um novo conjunto de dados, utilize o

comando bq mk

com a sinalização --location. Para obter uma lista completa de parâmetros, consulte a

referência

comando bq mk --dataset.

Crie um conjunto de dados chamado

bqml_tutorialcom o local dos dados definido comoUSe uma descrição deBigQuery ML tutorial dataset:bq --location=US mk -d \ --description "BigQuery ML tutorial dataset." \ bqml_tutorial

Em vez de usar a flag

--dataset, o comando usa o atalho-d. Se você omitir-de--dataset, o comando vai criar um conjunto de dados por padrão.Confirme se o conjunto de dados foi criado:

bq ls

API

Chame o método datasets.insert com um recurso de conjunto de dados definido.

{ "datasetReference": { "datasetId": "bqml_tutorial" } }

BigQuery DataFrames

Antes de testar esta amostra, siga as instruções de configuração dos BigQuery DataFrames no Guia de início rápido do BigQuery: como usar os BigQuery DataFrames. Para mais informações, consulte a documentação de referência do BigQuery DataFrames.

Para autenticar no BigQuery, configure o Application Default Credentials. Para mais informações, consulte Configurar o ADC para um ambiente de desenvolvimento local.

Visualizar os dados de entrada

Antes de criar o modelo, você pode visualizar os dados de série temporal de entrada para ter uma ideia da distribuição. Faça isso usando o Looker Studio.

Siga estas etapas para visualizar os dados de série temporal:

SQL

Na consulta GoogleSQL a seguir, a instrução

SELECT analisa a coluna date da tabela de entrada

para o tipo TIMESTAMP e a renomeia como parsed_date. Ela usa

as cláusulas SUM(...) e GROUP BY date para criar um valor diário

totals.visits.

No console do Google Cloud , acesse a página BigQuery.

No Editor de consultas, cole a consulta a seguir e clique em Executar:

SELECT PARSE_TIMESTAMP("%Y%m%d", date) AS parsed_date, SUM(totals.visits) AS total_visits FROM `bigquery-public-data.google_analytics_sample.ga_sessions_*` GROUP BY date;

Quando a consulta for concluída, clique em Explorar dados > Explorar com o Looker Studio. O Looker Studio é aberto em uma nova guia. Conclua as etapas a seguir na nova guia.

No Looker Studio, clique em Inserir > Gráfico de série temporal.

No painel Gráfico, escolha a guia Configuração.

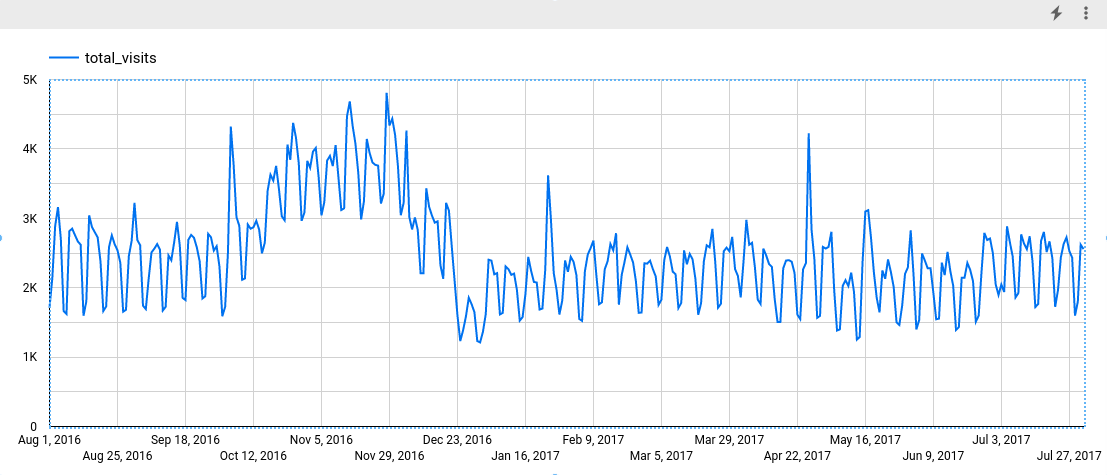

Na seção Métrica, adicione o campo total_visits e remova a métrica padrão Contagem de registros. O gráfico resultante será semelhante a este:

Analisando o gráfico, é possível ver que a série temporal de entrada tem um padrão sazonal semanal.

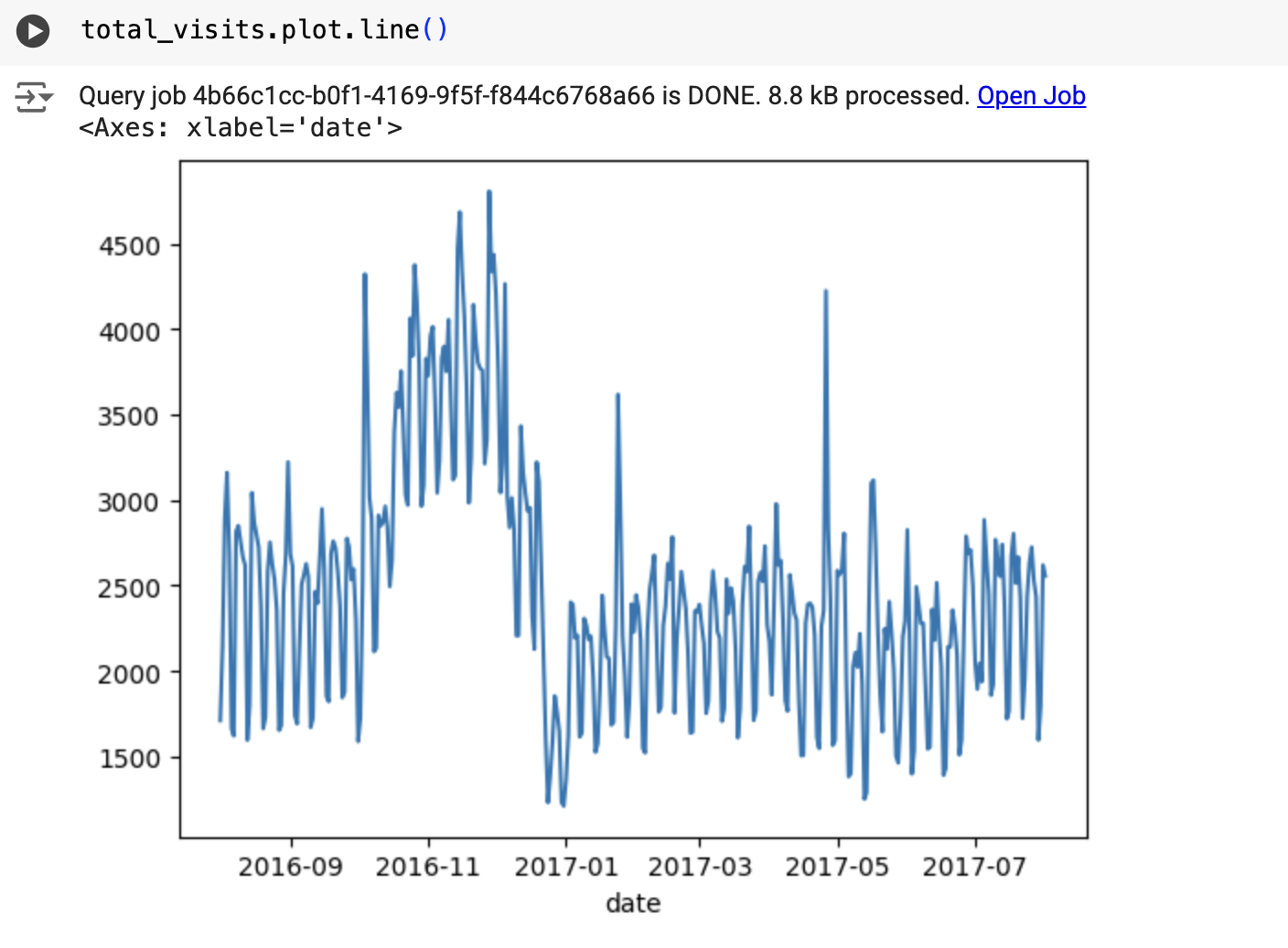

BigQuery DataFrames

Antes de testar esta amostra, siga as instruções de configuração dos BigQuery DataFrames no Guia de início rápido do BigQuery: como usar os BigQuery DataFrames. Para mais informações, consulte a documentação de referência do BigQuery DataFrames.

Para autenticar no BigQuery, configure o Application Default Credentials. Para mais informações, consulte Configurar o ADC para um ambiente de desenvolvimento local.

O resultado será semelhante ao seguinte:

Criar o modelo de série temporal

Crie um modelo de série temporal para prever o total de visitas ao site, representado pela coluna totals.visits, e treine-o com os dados do Google Analytics 360.

SQL

Na consulta a seguir, a cláusula

OPTIONS(model_type='ARIMA_PLUS', time_series_timestamp_col='date', ...)

indica que você está criando um

modelo de série temporal com base em

ARIMA. A opção auto_arima da instrução CREATE MODEL usa TRUE por padrão. Assim, o algoritmo auto.ARIMA ajusta automaticamente os hiperparâmetros no modelo. O algoritmo

se encaixa em dezenas de modelos candidatos e escolhe o melhor, que é aquele

com o menor

critério de informação de Akaike (AIC).

A opção data_frequency das instruções CREATE MODEL usa AUTO_FREQUENCY como padrão. Assim, o processo de treinamento infere automaticamente a frequência de dados da série temporal de entrada. A opção decompose_time_series da instrução CREATE MODEL usa TRUE como padrão. Assim, as informações sobre os dados de série temporal são retornadas quando você avalia o modelo na próxima etapa.

Siga estas etapas para criar o modelo:

No console do Google Cloud , acesse a página BigQuery.

No Editor de consultas, cole a consulta a seguir e clique em Executar:

CREATE OR REPLACE MODEL `bqml_tutorial.ga_arima_model` OPTIONS (model_type = 'ARIMA_PLUS', time_series_timestamp_col = 'parsed_date', time_series_data_col = 'total_visits', auto_arima = TRUE, data_frequency = 'AUTO_FREQUENCY', decompose_time_series = TRUE ) AS SELECT PARSE_TIMESTAMP("%Y%m%d", date) AS parsed_date, SUM(totals.visits) AS total_visits FROM `bigquery-public-data.google_analytics_sample.ga_sessions_*` GROUP BY date;

A consulta leva cerca de 4 segundos para ser concluída. Depois disso, o modelo

ga_arima_modelaparece no painel Explorer. Como a consulta usa uma instruçãoCREATE MODELpara criar um modelo, não é possível ver os resultados dela.

BigQuery DataFrames

Antes de testar esta amostra, siga as instruções de configuração dos BigQuery DataFrames no Guia de início rápido do BigQuery: como usar os BigQuery DataFrames. Para mais informações, consulte a documentação de referência do BigQuery DataFrames.

Para autenticar no BigQuery, configure o Application Default Credentials. Para mais informações, consulte Configurar o ADC para um ambiente de desenvolvimento local.

Avaliar os modelos candidatos

SQL

Avalie os modelos de série temporal usando a função ML.ARIMA_EVALUATE. A função ML.ARIMA_EVALUATE mostra as métricas de avaliação de todos os modelos candidatos avaliados durante o processo de ajuste automático de hiperparâmetros.

Siga estas etapas para avaliar o modelo:

No console do Google Cloud , acesse a página BigQuery.

No Editor de consultas, cole a consulta a seguir e clique em Executar:

SELECT * FROM ML.ARIMA_EVALUATE(MODEL `bqml_tutorial.ga_arima_model`);

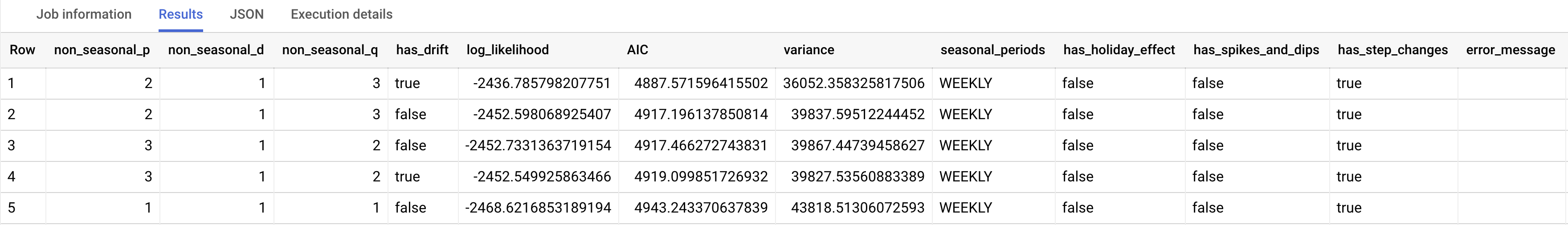

A resposta deve ficar assim:

BigQuery DataFrames

Antes de testar esta amostra, siga as instruções de configuração dos BigQuery DataFrames no Guia de início rápido do BigQuery: como usar os BigQuery DataFrames. Para mais informações, consulte a documentação de referência do BigQuery DataFrames.

Para autenticar no BigQuery, configure o Application Default Credentials. Para mais informações, consulte Configurar o ADC para um ambiente de desenvolvimento local.

As colunas de saída non_seasonal_p, non_seasonal_d, non_seasonal_q e has_drift definem um modelo ARIMA no pipeline de treinamento. As colunas de saída log_likelihood, AIC e variance são relevantes para o processo de ajuste do modelo ARIMA.

O algoritmo auto.ARIMA usa o

teste KPSS para determinar o melhor valor

para non_seasonal_d, que neste caso é 1. Quando non_seasonal_d é 1, o algoritmo auto.ARIMA treina 42 modelos ARIMA candidatos diferentes em paralelo.

Neste exemplo, todos os 42 modelos candidatos são válidos. Portanto, a saída contém 42 linhas, uma para cada modelo ARIMA candidato. Nos casos em que alguns dos modelos não são válidos, eles são excluídos da saída. Esses modelos candidatos são retornados em ordem crescente pelo AIC. O modelo na primeira linha tem o AIC mais baixo e é considerado o melhor modelo. O melhor modelo é salvo como o modelo final e é usado quando você chama funções como ML.FORECAST no modelo.

A coluna seasonal_periods contém informações sobre o padrão sazonal identificado nos dados de série temporal. Ele não tem nada a ver com a modelagem ARIMA. Portanto, ele tem o mesmo valor em todas as linhas de saída. Ele informa um padrão semanal, que concorda com os resultados que você viu se escolheu visualizar os dados de entrada.

As colunas has_holiday_effect, has_spikes_and_dips e has_step_changes

são preenchidas somente quando decompose_time_series=TRUE. Essas colunas também refletem informações sobre os dados de série temporal de entrada e não estão relacionadas à modelagem ARIMA. Essas colunas também têm os mesmos valores em todas as linhas de saída.

A coluna error_message mostra os erros que ocorreram durante o

processo de ajuste de auto.ARIMA. Um possível motivo para erros é quando as colunas selecionadas

non_seasonal_p, non_seasonal_d, non_seasonal_q e has_drift

não conseguem estabilizar a série temporal. Para recuperar a mensagem

de erro de todos os modelos candidatos, defina a opção show_all_candidate_models

como TRUE ao criar o modelo.

Para mais informações sobre as colunas de saída, consulte a

função ML.ARIMA_EVALUATE.

Inspecionar os coeficientes do modelo

SQL

Inspecione os coeficientes do modelo de série temporal usando a função ML.ARIMA_COEFFICIENTS.

Siga estas etapas para recuperar os coeficientes do modelo:

No console do Google Cloud , acesse a página BigQuery.

No Editor de consultas, cole a consulta a seguir e clique em Executar:

SELECT * FROM ML.ARIMA_COEFFICIENTS(MODEL `bqml_tutorial.ga_arima_model`);

A coluna de saída ar_coefficients mostra os coeficientes do modelo da parte autoregressiva (AR) do modelo ARIMA. Da mesma forma, a coluna de saída ma_coefficients mostra os coeficientes do modelo da parte de média móvel (MA) do modelo ARIMA. Ambas as colunas contêm valores de matriz, com comprimentos iguais a non_seasonal_p e non_seasonal_q, respectivamente. Na saída da função ML.ARIMA_EVALUATE, você viu que o melhor modelo tem um valor non_seasonal_p de 2 e um valor non_seasonal_q de 3. Portanto, na saída ML.ARIMA_COEFFICIENTS, o valor ar_coefficients é uma matriz de dois elementos e o valor ma_coefficients é uma matriz de três elementos. O valor intercept_or_drift é o termo constante no modelo ARIMA.

Para mais informações sobre as colunas de saída, consulte a

função ML.ARIMA_COEFFICIENTS.

BigQuery DataFrames

Inspecione os coeficientes do modelo de série temporal usando a função coef_.

Antes de testar esta amostra, siga as instruções de configuração dos BigQuery DataFrames no Guia de início rápido do BigQuery: como usar os BigQuery DataFrames. Para mais informações, consulte a documentação de referência do BigQuery DataFrames.

Para autenticar no BigQuery, configure o Application Default Credentials. Para mais informações, consulte Configurar o ADC para um ambiente de desenvolvimento local.

A coluna de saída ar_coefficients mostra os coeficientes do modelo da parte autoregressiva (AR) do modelo ARIMA. Da mesma forma, a coluna de saída ma_coefficients mostra os coeficientes do modelo da parte de média móvel (MA) do modelo ARIMA. Ambas as colunas contêm valores de matriz, com comprimentos iguais a non_seasonal_p e non_seasonal_q, respectivamente.

Usar o modelo para prever dados

SQL

Preveja valores futuros de série temporal usando a função ML.FORECAST.

Na consulta GoogleSQL padrão a seguir, a

cláusula STRUCT(30 AS horizon, 0.8 AS confidence_level) indica que a consulta

prevê 30 períodos futuros e gera um intervalo de previsão

com um nível de confiança de 80%.

Siga estas etapas para prever dados com o modelo:

No console do Google Cloud , acesse a página BigQuery.

No Editor de consultas, cole a consulta a seguir e clique em Executar:

SELECT * FROM ML.FORECAST(MODEL `bqml_tutorial.ga_arima_model`, STRUCT(30 AS horizon, 0.8 AS confidence_level));

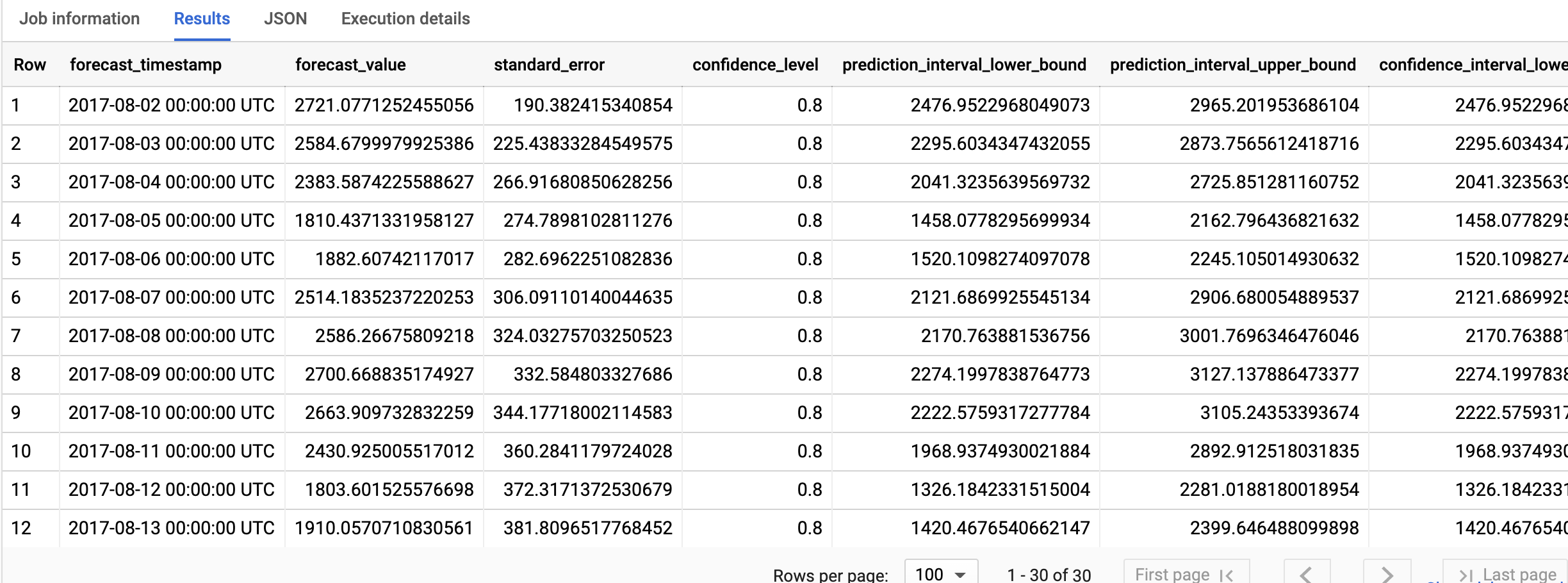

A resposta deve ficar assim:

BigQuery DataFrames

Preveja valores futuros de série temporal usando a função predict.

Antes de testar esta amostra, siga as instruções de configuração dos BigQuery DataFrames no Guia de início rápido do BigQuery: como usar os BigQuery DataFrames. Para mais informações, consulte a documentação de referência do BigQuery DataFrames.

Para autenticar no BigQuery, configure o Application Default Credentials. Para mais informações, consulte Configurar o ADC para um ambiente de desenvolvimento local.

As linhas de saída estão em ordem cronológica pelo valor da coluna forecast_timestamp. Na previsão de série temporal, o intervalo de previsão, representado pelos valores das colunas prediction_interval_lower_bound e prediction_interval_upper_bound, é tão importante quanto o valor da coluna forecast_value. O valor forecast_value é o ponto central do intervalo de previsão. O intervalo de previsão depende dos valores das colunas standard_error e confidence_level.

Para mais informações sobre as colunas de saída, consulte a

função ML.FORECAST.

Explicar os resultados da previsão

SQL

É possível receber métricas de explicabilidade, além de dados de previsão, usando a função

ML.EXPLAIN_FORECAST. A função ML.EXPLAIN_FORECAST prevê valores futuros de série temporal e também retorna todos os componentes separados delas.

Semelhante à função ML.FORECAST, a cláusula STRUCT(30 AS horizon, 0.8 AS confidence_level) usada na função ML.EXPLAIN_FORECAST indica que a consulta prevê 30 pontos no tempo futuro e gera um intervalo de previsão com 80% de confiança.

Siga estas etapas para explicar os resultados do modelo:

No console do Google Cloud , acesse a página BigQuery.

No Editor de consultas, cole a consulta a seguir e clique em Executar:

SELECT * FROM ML.EXPLAIN_FORECAST(MODEL `bqml_tutorial.ga_arima_model`, STRUCT(30 AS horizon, 0.8 AS confidence_level));

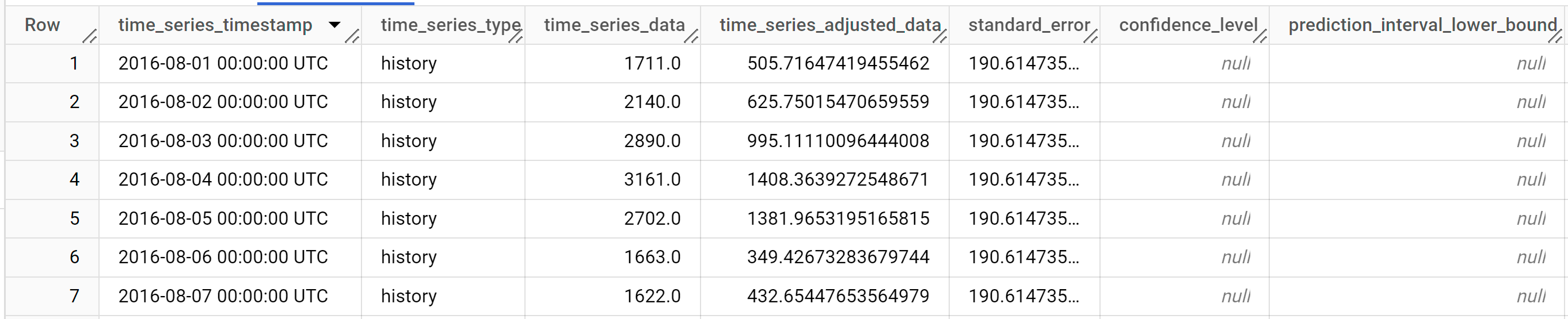

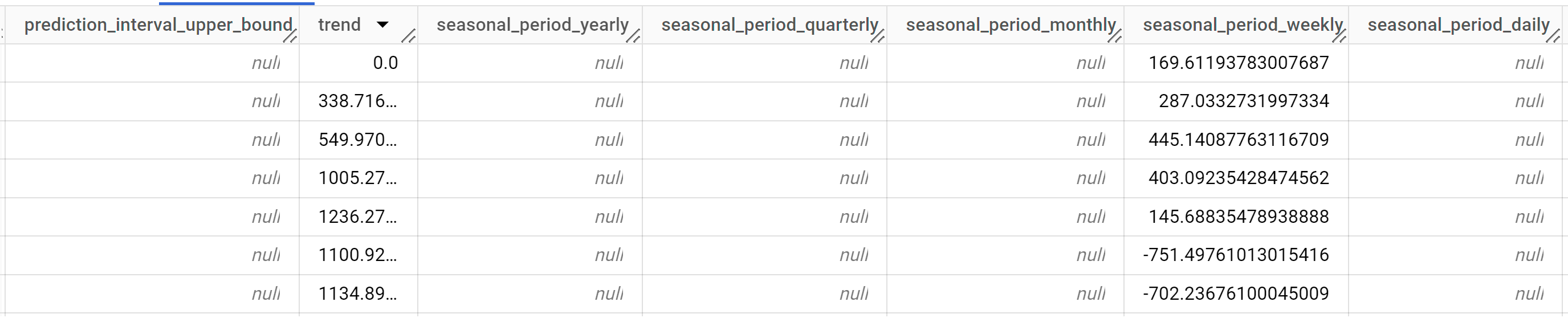

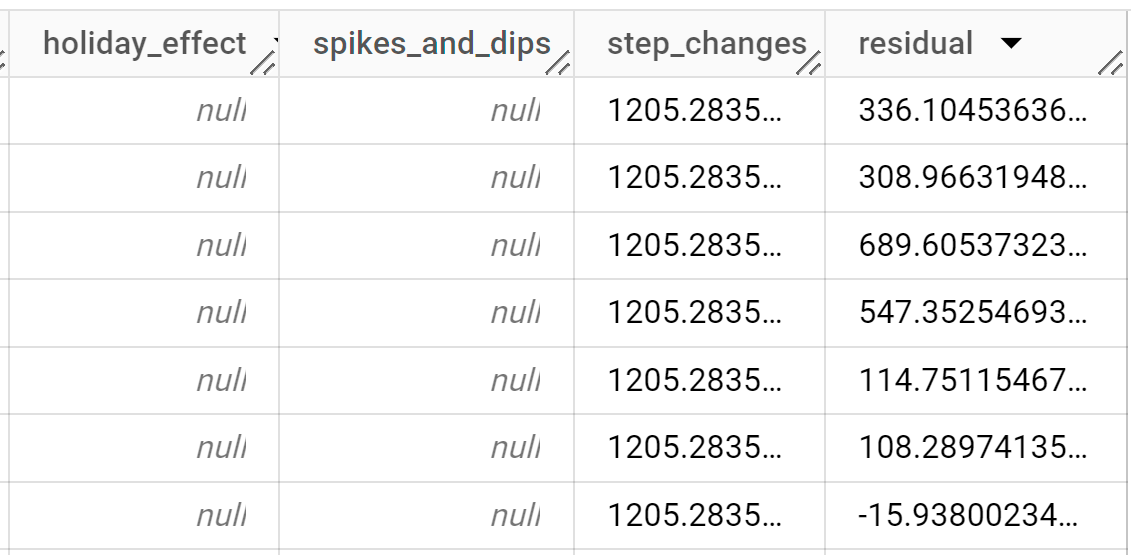

A resposta deve ficar assim:

As linhas de saída são ordenadas cronologicamente pelo valor da coluna

time_series_timestamp.Para mais informações sobre as colunas de saída, consulte a função

ML.EXPLAIN_FORECAST.

BigQuery DataFrames

É possível receber métricas de explicabilidade, além de dados de previsão, usando a função predict_explain. A função predict_explain prevê valores futuros de série temporal e também retorna todos os componentes separados delas.

Semelhante à função predict, a cláusula horizon=30, confidence_level=0.8 usada na função predict_explain indica que a consulta prevê 30 pontos no tempo futuro e gera um intervalo de previsão com 80% de confiança.

Antes de testar esta amostra, siga as instruções de configuração dos BigQuery DataFrames no Guia de início rápido do BigQuery: como usar os BigQuery DataFrames. Para mais informações, consulte a documentação de referência do BigQuery DataFrames.

Para autenticar no BigQuery, configure o Application Default Credentials. Para mais informações, consulte Configurar o ADC para um ambiente de desenvolvimento local.

Se quiser visualizar os resultados, use o Looker Studio, conforme descrito na seção Visualizar os dados de entrada, para criar um gráfico usando as seguintes colunas como métricas:

time_series_dataprediction_interval_lower_boundprediction_interval_upper_boundtrendseasonal_period_weeklystep_changes

Limpar

Para evitar cobranças na sua conta do Google Cloud pelos recursos usados no tutorial, exclua o projeto que os contém ou mantenha o projeto e exclua os recursos individuais.

- exclua o projeto que você criou; ou

- Mantenha o projeto e exclua o conjunto de dados.

Excluir o conjunto de dados

A exclusão do seu projeto removerá todos os conjuntos de dados e tabelas no projeto. Caso prefira reutilizá-lo, exclua o conjunto de dados criado neste tutorial:

Se necessário, abra a página do BigQuery no console doGoogle Cloud .

Na navegação, clique no conjunto de dados bqml_tutorial criado.

Clique em Excluir conjunto de dados no lado direito da janela. Essa ação exclui o conjunto, a tabela e todos os dados.

Na caixa de diálogo Excluir conjunto de dados, confirme o comando de exclusão digitando o nome do seu conjunto de dados (

bqml_tutorial) e clique em Excluir.

Excluir o projeto

Para excluir o projeto:

- In the Google Cloud console, go to the Manage resources page.

- In the project list, select the project that you want to delete, and then click Delete.

- In the dialog, type the project ID, and then click Shut down to delete the project.

A seguir

- Saiba como prever uma única série temporal com um modelo multivariável

- Aprenda a prever várias série temporal com um modelo univariado

- Aprenda a escalonar um modelo univariado ao prever várias série temporal em muitas linhas.

- Aprenda a fazer previsões hierárquicas de várias série temporal com um modelo univariado

- Para uma visão geral do BigQuery ML, consulte Introdução à IA e ao ML no BigQuery.