Para datos de imagen y video, puedes importar datos etiquetados o no etiquetados y agregar etiquetas con la Google Cloud consola. También puedes borrar o agregar etiquetas nuevas a los conjuntos de datos etiquetados existentes.

Para obtener información acerca de cómo importar los datos, consulta la página Preparar datos del tipo de datos y el objetivo con los que estás trabajando en la página Descripción general del entrenamiento. Continúa con la página Crear conjunto de datos correspondiente para tu tipo de datos y objetivo.

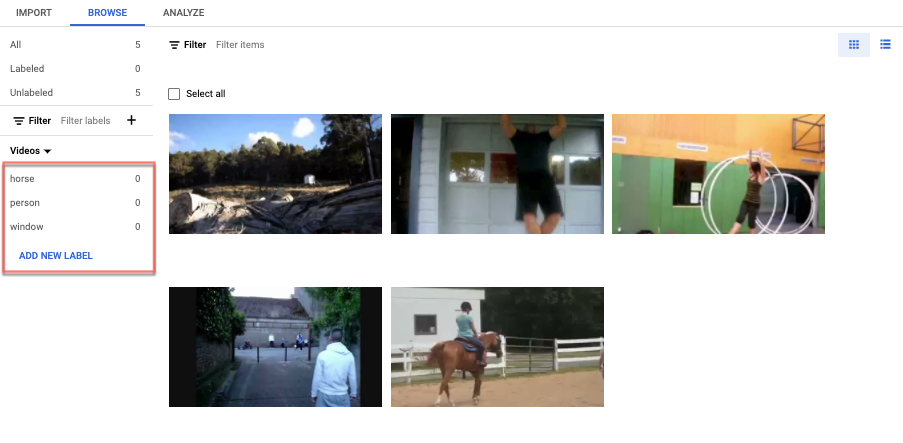

Después de crear el conjunto de datos y de importar los datos sin etiquetar, estarás en el modo de

navegación.

Cómo agregar etiquetas

Las instrucciones para los objetivos de etiquetado se proporcionan aquí para cada tipo de datos.

Imagen

Las imágenes que acabas de importar en el conjunto de datos no están etiquetadas, como se esperaba.

Clasificación

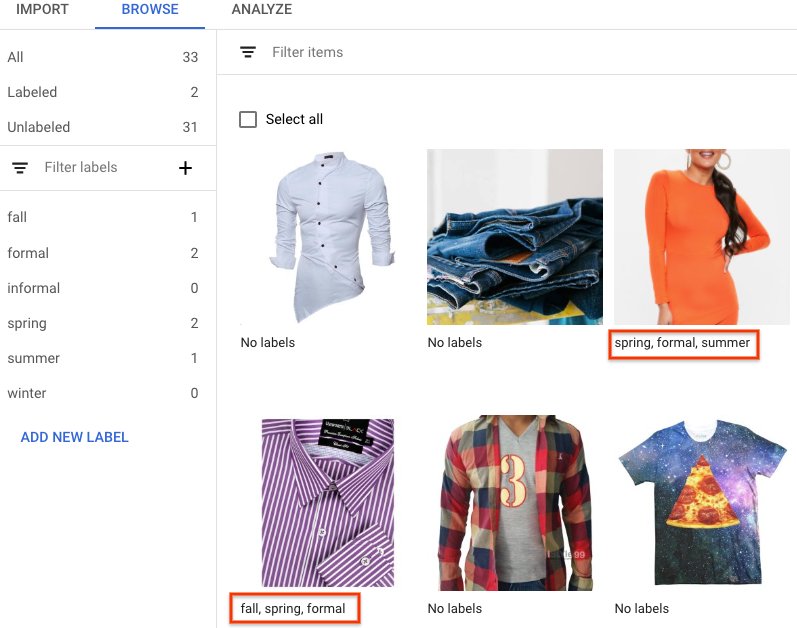

Cuando te encuentras en el modo de exploración y se selecciona el conjunto de datos con las imágenes sin etiquetar, puedes ver las imágenes que subiste.

- Haz clic en Agregar etiqueta nueva y, luego, ingresa la etiqueta nueva.

- Haz clic en Listo.

Repítelo para cada etiqueta que desees agregar. - Selecciona la imagen que deseas etiquetar.

Aparecerá la lista de etiquetas. - Selecciona la etiqueta que deseas asociar a la imagen.

- Haz clic en Guardar.

Clasificación

Cuando te encuentras en el modo de Exploración y se selecciona el conjunto de datos con las imágenes sin etiquetar, puedes ver las imágenes que subiste.

- Haz clic en Agregar etiqueta nueva y, luego, ingresa la etiqueta nueva.

- Haz clic en Listo.

Repítelo para cada etiqueta que desees agregar. - Selecciona la imagen que deseas etiquetar.

Aparecerá la lista de etiquetas. - Selecciona la etiqueta que deseas asociar a la imagen.

- Haz clic en Guardar.

- Puedes ver las etiquetas que se aplicaron a cada imagen en la pestaña Explorar.

Detección de objetos

Cuando te encuentras en el modo de Exploración y se selecciona el conjunto de datos con las imágenes sin etiquetar, puedes ver las imágenes que subiste.

- Haz clic en Agregar etiqueta nueva y, luego, ingresa la etiqueta nueva.

- Haz clic en Listo.

Repítelo para cada etiqueta que desees agregar. - Selecciona la imagen que deseas etiquetar.

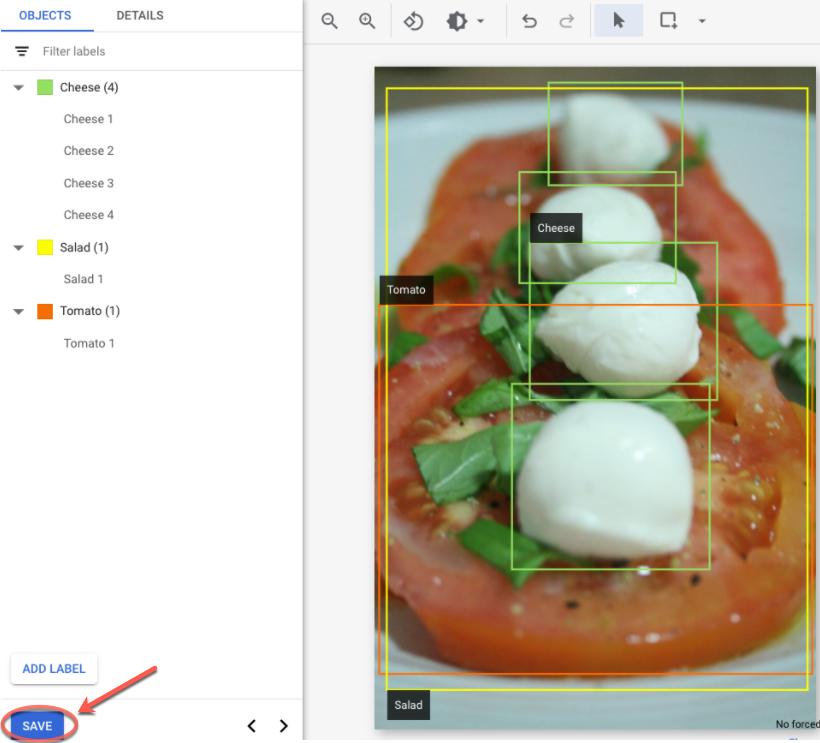

- Aparecerá la lista de objetos de etiquetas, si los hay.

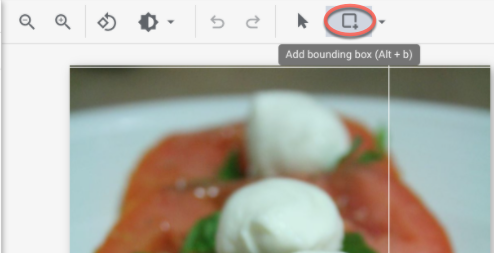

- En la ventana de agregado de anotación, selecciona el botón Agregar cuadro de límite para agregar un cuadro de límite de objeto a la imagen.

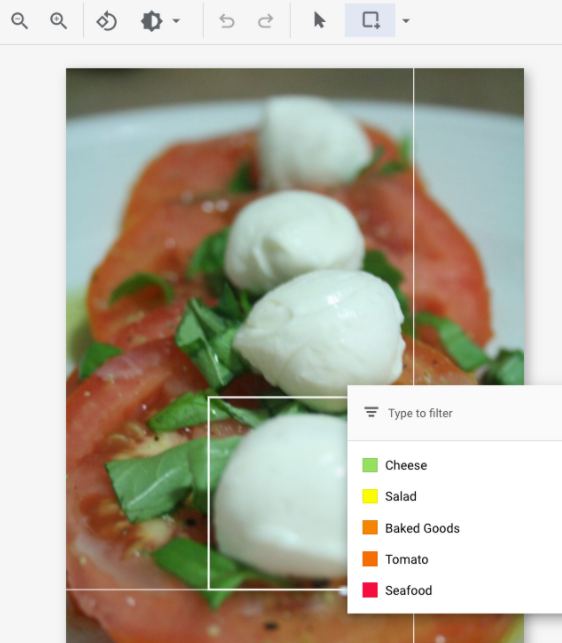

- Después de dibujar un cuadro de límite, aparecerá una lista de etiquetas para aplicar al objeto.

Elige la etiqueta adecuada.

- Después de agregar todas las etiquetas y cuadros de límite, haz clic en Guardar para actualizar las anotaciones de la imagen.

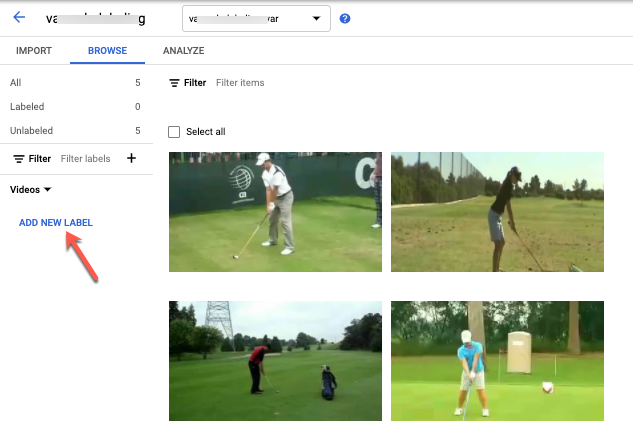

Video

Los videos importaste en el conjunto de datos no están etiquetados, como se esperaba.

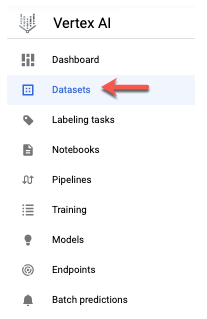

- Para navegar a tu conjunto de datos nuevo, haz clic en “Conjuntos de datos” en el menú de navegación.

- Selecciona el conjunto de datos al que deseas agregarle etiquetas.

Se mostrará el conjunto de datos.

Reconocimiento de acciones

Cuando te encuentras en el modo de Exploración y se selecciona el conjunto de datos con los videos sin etiquetar, deberías ver los videos.

- Agregar etiquetas.

- Selecciona un video y comienza a verlo.

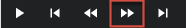

- Cuando la acción comience a aparecer que deseas identificar, avanza con lentitud hasta que encuentres el centro o el momento más representativo de la acción con la opción "Siguiente marco".

- Haz clic en Agregar anotación.

Aparecerá tu lista de etiquetas. - Selecciona la etiqueta que deseas para este segmento de video.

- Haz clic en Guardar.

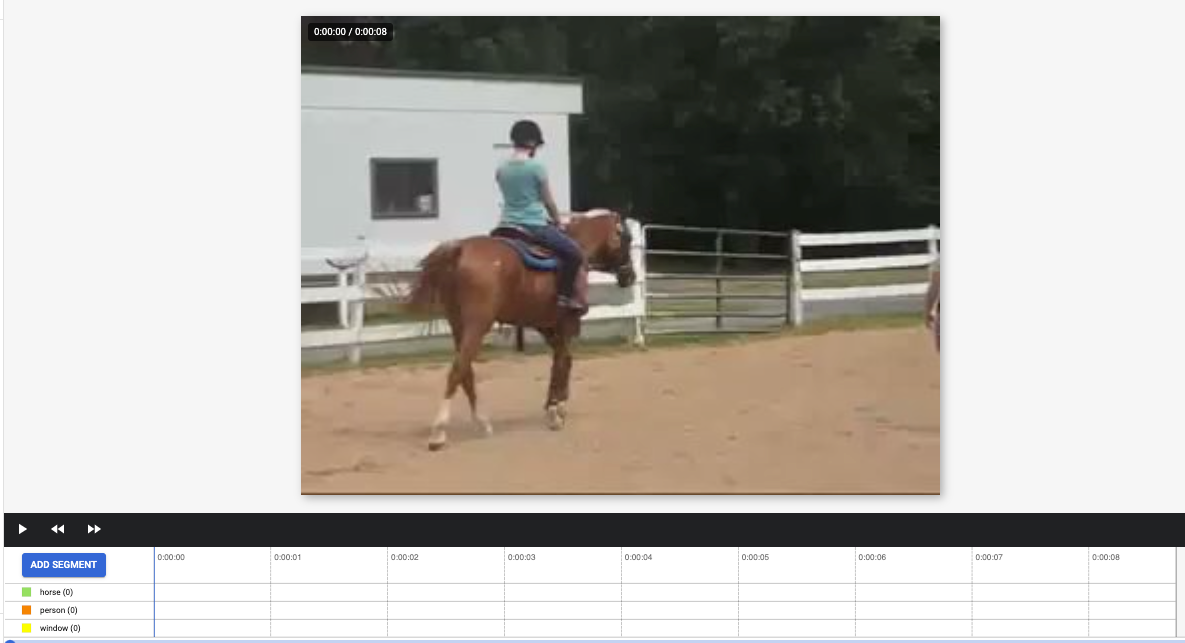

Clasificación

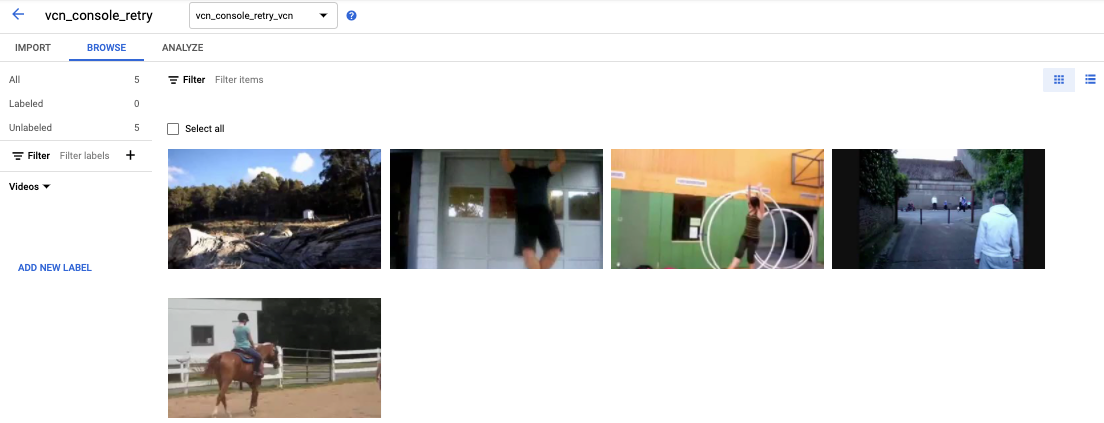

Cuando se selecciona el conjunto de datos con los videos sin etiquetar, verás tus videos.

- Agrega etiquetas.

- Selecciona el video que deseas etiquetar. El video aparecerá debajo con la lista de etiquetas codificadas por.

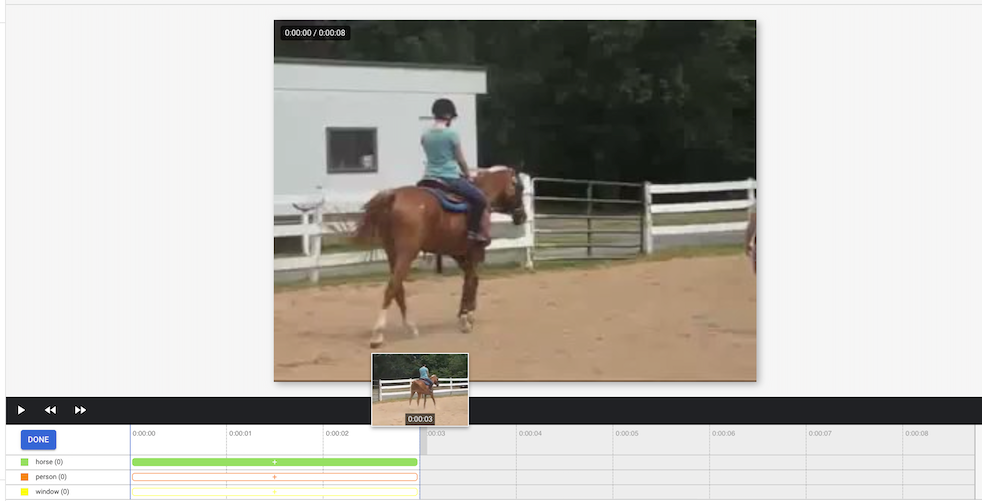

- Navega al punto de partida del segmento. Haz clic en Agregar segmento.

- Selecciona el segmento. A fin de ajustarlo, designa el segmento que se usará para el entrenamiento de tu etiqueta:

- Seleccionar etiqueta. Puedes seleccionar varias etiquetas para un segmento.

- Haz clic en Listo y, luego, en Guardar.

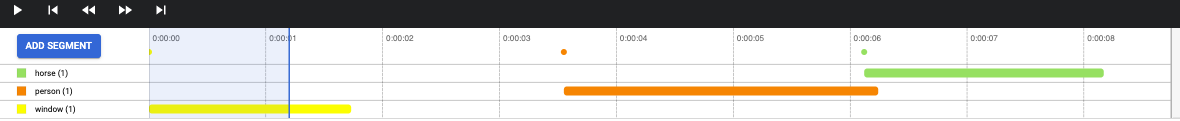

- Repite los pasos para agregar otra etiqueta al mismo video con un segmento de tiempo diferente.

Este es un ejemplo en el que se agregaron dos etiquetas más:

- Selecciona el segmento. A fin de ajustarlo, designa el segmento que se usará para el entrenamiento de tu etiqueta:

- Regresa a la lista Conjuntos de datos para repetir.

Seguimiento de objetos

Cuando te encuentras en el modo de Exploración y se selecciona el conjunto de datos con los videos sin etiquetar, deberías ver los videos.

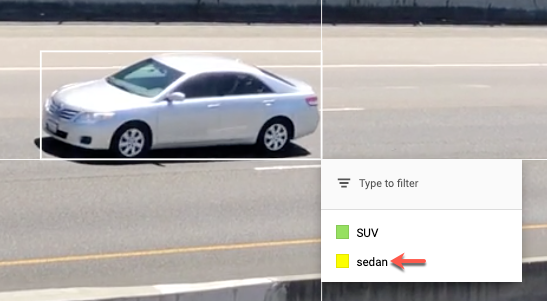

- Haz clic en Agregar etiqueta y agrega las etiquetas que planeas usar (por ejemplo, “sedán”, “pickup”, “SUV”, etcétera).

- Haz clic en Guardar. Si necesitas agregar más etiquetas luego, haz clic en Agregar etiqueta nueva y Guardar.

- Selecciona un video y comienza a verlo.

- Cuando aparece un objeto del cual deseas hacer un seguimiento,

- Detén el video,

- Arrastra un cuadro de límite desde la esquina superior izquierda hacia abajo hasta la esquina inferior derecha.

Asegúrate de que el cuadro sea lo más preciso posible alrededor del objeto.

Se muestra una lista de etiquetas en la parte inferior derecha del cuadro de límite. - Selecciona la etiqueta adecuada.

Nota: Nota: Siempre puedes agregar más etiquetas durante este proceso. Asegúrate de guardar la etiqueta agregada para que aparezca en la lista de ahora en adelante.

Nota: Nota: Siempre puedes agregar más etiquetas durante este proceso. Asegúrate de guardar la etiqueta agregada para que aparezca en la lista de ahora en adelante.

- Haz clic en Guardar.

¿Qué sigue?

- Entrena tu modelo de AutoML con la Google Cloud consola.

Entrena tu modelo de AutoML Edge con la Google Cloud consola. (solo imágenes y videos)

Entrena tu modelo de AutoML Edge con la API de Vertex AI. (solo imágenes y videos)