Estas SSD se han diseñado para casos de almacenamiento provisional, como en caché o en un espacio de procesamiento temporal. Como las SSDs locales se encuentran en la máquina física en la que se ejecuta tu máquina virtual, solo se pueden crear durante el proceso de creación de la máquina virtual. Los SSD locales no se pueden usar como dispositivos de arranque.

En las series de máquinas de tercera generación y posteriores, se añade una cantidad determinada de discos SSD locales a la VM cuando la creas. La única forma de añadir almacenamiento en SSD local a estas VMs es la siguiente:

- En el caso de C4, C4D, C3 y C3D, el almacenamiento SSD local solo está disponible con determinados tipos de máquinas, como

c3-standard-88-lssd. - En las series de máquinas Z3, A4, A4X, A3 y A2 Ultra, todos los tipos de máquinas incluyen almacenamiento en SSD local.

En el caso de los tipos de máquina M3 y de primera y segunda generación, debes especificar discos SSD locales al crear la VM.

Después de crear un disco SSD local, debes formatear y montar el dispositivo para poder usarlo.

Para obtener información sobre la cantidad de almacenamiento SSD local disponible con varios tipos de máquinas y el número de discos SSD locales que puedes conectar a una VM, consulta Elegir un número válido de SSDs locales.

Antes de empezar

- Consulta las limitaciones de los SSD locales antes de usarlos.

- Consulta los escenarios de persistencia de datos de los discos SSD locales.

- Si vas a añadir SSDs locales a instancias de máquinas virtuales (VM) que tengan GPUs conectadas, consulta Disponibilidad de SSDs locales por regiones y zonas de GPU.

-

Si aún no lo has hecho, configura la autenticación.

La autenticación verifica tu identidad para acceder a Google Cloud servicios y APIs. Para ejecutar código o ejemplos desde un entorno de desarrollo local, puedes autenticarte en Compute Engine seleccionando una de las siguientes opciones:

Select the tab for how you plan to use the samples on this page:

Console

When you use the Google Cloud console to access Google Cloud services and APIs, you don't need to set up authentication.

gcloud

-

Instala Google Cloud CLI. Después de la instalación, inicializa la CLI de Google Cloud ejecutando el siguiente comando:

gcloud initSi utilizas un proveedor de identidades (IdP) externo, primero debes iniciar sesión en la CLI de gcloud con tu identidad federada.

- Set a default region and zone.

Terraform

Para usar las muestras de Terraform de esta página en un entorno de desarrollo local, instala e inicializa la CLI de gcloud y, a continuación, configura las credenciales predeterminadas de la aplicación con tus credenciales de usuario.

Instala Google Cloud CLI.

Si utilizas un proveedor de identidades (IdP) externo, primero debes iniciar sesión en la CLI de gcloud con tu identidad federada.

If you're using a local shell, then create local authentication credentials for your user account:

gcloud auth application-default login

You don't need to do this if you're using Cloud Shell.

If an authentication error is returned, and you are using an external identity provider (IdP), confirm that you have signed in to the gcloud CLI with your federated identity.

Para obtener más información, consulta Set up authentication for a local development environment.

Go

Para usar las Go muestras de esta página en un entorno de desarrollo local, instala e inicializa la CLI de gcloud y, a continuación, configura las credenciales predeterminadas de la aplicación con tus credenciales de usuario.

Instala Google Cloud CLI.

Si utilizas un proveedor de identidades (IdP) externo, primero debes iniciar sesión en la CLI de gcloud con tu identidad federada.

If you're using a local shell, then create local authentication credentials for your user account:

gcloud auth application-default login

You don't need to do this if you're using Cloud Shell.

If an authentication error is returned, and you are using an external identity provider (IdP), confirm that you have signed in to the gcloud CLI with your federated identity.

Para obtener más información, consulta Set up authentication for a local development environment.

Java

Para usar las Java muestras de esta página en un entorno de desarrollo local, instala e inicializa la CLI de gcloud y, a continuación, configura las credenciales predeterminadas de la aplicación con tus credenciales de usuario.

Instala Google Cloud CLI.

Si utilizas un proveedor de identidades (IdP) externo, primero debes iniciar sesión en la CLI de gcloud con tu identidad federada.

If you're using a local shell, then create local authentication credentials for your user account:

gcloud auth application-default login

You don't need to do this if you're using Cloud Shell.

If an authentication error is returned, and you are using an external identity provider (IdP), confirm that you have signed in to the gcloud CLI with your federated identity.

Para obtener más información, consulta Set up authentication for a local development environment.

Python

Para usar las Python muestras de esta página en un entorno de desarrollo local, instala e inicializa la CLI de gcloud y, a continuación, configura las credenciales predeterminadas de la aplicación con tus credenciales de usuario.

Instala Google Cloud CLI.

Si utilizas un proveedor de identidades (IdP) externo, primero debes iniciar sesión en la CLI de gcloud con tu identidad federada.

If you're using a local shell, then create local authentication credentials for your user account:

gcloud auth application-default login

You don't need to do this if you're using Cloud Shell.

If an authentication error is returned, and you are using an external identity provider (IdP), confirm that you have signed in to the gcloud CLI with your federated identity.

Para obtener más información, consulta Set up authentication for a local development environment.

REST

Para usar las muestras de la API REST de esta página en un entorno de desarrollo local, debes usar las credenciales que proporciones a la CLI de gcloud.

Instala Google Cloud CLI.

Si utilizas un proveedor de identidades (IdP) externo, primero debes iniciar sesión en la CLI de gcloud con tu identidad federada.

Para obtener más información, consulta el artículo Autenticarse para usar REST de la documentación sobre autenticación de Google Cloud .

Crear una VM con un SSD local

Puedes crear una VM con almacenamiento en disco SSD local mediante la Google Cloud console, la CLI de gcloud o la API de Compute Engine.

Consola

Ve a la página Crear una instancia.

Especifica el nombre, la región y la zona de la VM. De forma opcional, añade etiquetas.

En la sección Configuración de la máquina, elige la familia de máquinas que contenga el tipo de máquina de destino.

Selecciona una serie de la lista Serie y, a continuación, elige el tipo de máquina.

- En el caso de C4, C4D, C3 y C3D, elige un tipo de máquina que termine en

-lssd. - En el caso de Z3, A4, A4X, A3 y A2 Ultra, todos los tipos de máquinas incluyen almacenamiento SSD local.

- En el caso de las series de máquinas M3 o de primera y segunda generación, después de seleccionar el tipo de máquina, haz lo siguiente:

- Expande la sección Opciones avanzadas.

- Expande Discos, haz clic en Añadir SSD local y haz lo siguiente:

- En la página Configurar SSD local, elija el tipo de interfaz de disco.

- En la lista Capacidad del disco, selecciona el número de discos que quieras.

- Haz clic en Guardar.

- En el caso de C4, C4D, C3 y C3D, elige un tipo de máquina que termine en

Continúa con el proceso de creación de la VM.

Después de crear la VM con discos SSD locales, debes formatear y montar cada dispositivo para poder usar los discos.

gcloud

En el caso de las series de máquinas Z3, A4, A4X, A3 y A2 Ultra, para crear una VM con discos SSD locales conectados, crea una VM que utilice cualquiera de los tipos de máquinas disponibles de esa serie siguiendo las instrucciones para crear una instancia.

En las series de máquinas C4, C4D, C3 y C3D, para crear una VM con discos SSD locales conectados, sigue las instrucciones para crear una instancia, pero especifica un tipo de instancia que incluya discos SSD locales (

-lssd).Por ejemplo, puedes crear una VM C3 con dos particiones de SSD local que usen la interfaz de disco NVMe de la siguiente manera:

gcloud compute instances create example-c3-instance \ --zone ZONE \ --machine-type c3-standard-8-lssd \ --image-project IMAGE_PROJECT \ --image-family IMAGE_FAMILY

En las series de máquinas M3 y de primera y segunda generación, para crear una VM con discos SSD locales conectados, sigue las instrucciones para crear una instancia, pero usa la marca

--local-ssdpara crear y conectar un disco SSD local. Para crear varios discos SSD locales, añade más marcas--local-ssd. También puedes definir valores para la interfaz y el nombre del dispositivo de cada marca--local-ssd.Por ejemplo, puedes crear una VM M3 con cuatro discos SSD locales y especificar el tipo de interfaz de disco de la siguiente manera:

gcloud compute instances create VM_NAME \ --machine-type m3-ultramem-64 \ --zone ZONE \ --local-ssd interface=INTERFACE_TYPE,device-name=DEVICE-NAME \ --local-ssd interface=INTERFACE_TYPE,device-name=DEVICE-NAME \ --local-ssd interface=INTERFACE_TYPE,device-name=DEVICE-NAME \ --local-ssd interface=INTERFACE_TYPE \ --image-project IMAGE_PROJECT \ --image-family IMAGE_FAMILY

Haz los cambios siguientes:

- VM_NAME: nombre de la nueva VM

- ZONE: la zona en la que se creará la VM. Esta marca es opcional si ha configurado la propiedad

compute/zonede gcloud CLI o la variable de entornoCLOUDSDK_COMPUTE_ZONE. - INTERFACE_TYPE: el tipo de interfaz de disco que quieres usar para el dispositivo SSD local. Especifica

nvmesi vas a crear una VM M3 o si tu imagen de disco de arranque tiene controladores NVMe optimizados. Especificascsipara otras imágenes. - DEVICE-NAME: opcional. Nombre que indica el nombre del disco que se va a usar en el sistema operativo invitado enlace simbólico (symlink).

- IMAGE_FAMILY: una de las familias de imágenes disponibles que quieras instalar en el disco de arranque

- IMAGE_PROJECT: el proyecto de imagen al que pertenece la familia de imágenes

Si es necesario, puedes conectar SSDs locales a una VM de primera o segunda generación usando una combinación de

nvmeyscsipara diferentes particiones. El rendimiento del dispositivonvmedepende de la imagen del disco de arranque de tu instancia. Las VMs de tercera generación solo admiten la interfaz de disco NVMe.Después de crear una VM con SSD local, debes formatear y montar cada dispositivo para poder usarlo.

Terraform

Para crear una VM con discos SSD locales conectados, puedes usar el recurso

google_compute_instance.Para saber cómo aplicar o quitar una configuración de Terraform, consulta Comandos básicos de Terraform.

Para generar el código de Terraform, puedes usar el componente Código equivalente de la Google Cloud consola.- En la consola de Google Cloud , ve a la página Instancias de VM.

- Haz clic en Crear instancia.

- Especifica los parámetros que quieras.

- En la parte superior o inferior de la página, haz clic en Código equivalente y, a continuación, en la pestaña Terraform para ver el código de Terraform.

Go

Go

Antes de probar este ejemplo, sigue las Goinstrucciones de configuración de la guía de inicio rápido de Compute Engine con bibliotecas de cliente. Para obtener más información, consulta la documentación de referencia de la API Go de Compute Engine.

Para autenticarte en Compute Engine, configura las credenciales predeterminadas de la aplicación. Para obtener más información, consulta el artículo Configurar la autenticación en un entorno de desarrollo local.

Java

Java

Antes de probar este ejemplo, sigue las Javainstrucciones de configuración de la guía de inicio rápido de Compute Engine con bibliotecas de cliente. Para obtener más información, consulta la documentación de referencia de la API Java de Compute Engine.

Para autenticarte en Compute Engine, configura las credenciales predeterminadas de la aplicación. Para obtener más información, consulta el artículo Configurar la autenticación en un entorno de desarrollo local.

Python

Python

Antes de probar este ejemplo, sigue las Pythoninstrucciones de configuración de la guía de inicio rápido de Compute Engine con bibliotecas de cliente. Para obtener más información, consulta la documentación de referencia de la API Python de Compute Engine.

Para autenticarte en Compute Engine, configura las credenciales predeterminadas de la aplicación. Para obtener más información, consulta el artículo Configurar la autenticación en un entorno de desarrollo local.

REST

Usa

instances.insert methodpara crear una VM a partir de una familia de imágenes o de una versión específica de una imagen de sistema operativo.- En el caso de las series de máquinas Z3, A4, A4X, A3 y A2 Ultra, para crear una VM con discos SSD locales conectados, crea una VM que utilice cualquiera de los tipos de máquinas disponibles de esa serie.

En las series de máquinas C4, C4D, C3 y C3D, para crear una VM con discos SSD locales conectados, especifica un tipo de instancia que incluya discos SSD locales (

-lssd).A continuación, se muestra un ejemplo de carga útil de solicitud que crea una VM C3 con un disco de arranque de Ubuntu y dos discos SSD locales:

{ "machineType":"zones/us-central1-c/machineTypes/c3-standard-8-lssd", "name":"c3-with-local-ssd", "disks":[ { "type":"PERSISTENT", "initializeParams":{ "sourceImage":"projects/ubuntu-os-cloud/global/images/family/ubuntu-2204-lts" }, "boot":true } ], "networkInterfaces":[ { "network":"global/networks/default" } ] }En las series de máquinas M3 y de primera y segunda generación, para crear una VM con discos SSD locales conectados, puedes añadir dispositivos SSD locales durante la creación de la VM mediante la propiedad

initializeParams. También debe proporcionar las siguientes propiedades:diskType: elija SSD local.autoDelete: se asigna el valor truetype: se ha definido comoSCRATCH

Las siguientes propiedades no se pueden usar con dispositivos SSD local:

diskNamesourceImagepropiedaddiskSizeGb

A continuación, se muestra un ejemplo de carga útil de solicitud que crea una VM M3 con un disco de arranque y cuatro discos SSD locales:

{ "machineType":"zones/us-central1-f/machineTypes/m3-ultramem-64", "name":"local-ssd-instance", "disks":[ { "type":"PERSISTENT", "initializeParams":{ "sourceImage":"projects/ubuntu-os-cloud/global/images/family/ubuntu-2204-lts" }, "boot":true }, { "type":"SCRATCH", "initializeParams":{ "diskType":"zones/us-central1-f/diskTypes/local-ssd" }, "autoDelete":true, "interface": "NVME" }, { "type":"SCRATCH", "initializeParams":{ "diskType":"zones/us-central1-f/diskTypes/local-ssd" }, "autoDelete":true, "interface": "NVME" }, { "type":"SCRATCH", "initializeParams":{ "diskType":"zones/us-central1-f/diskTypes/local-ssd" }, "autoDelete":true, "interface": "NVME" }, { "type":"SCRATCH", "initializeParams":{ "diskType":"zones/us-central1-f/diskTypes/local-ssd" }, "autoDelete":true, "interface": "NVME" }, ], "networkInterfaces":[ { "network":"global/networks/default" } ] }

Después de crear un disco SSD local, debes formatear y montar cada dispositivo para poder usarlo.

Para obtener más información sobre cómo crear una instancia mediante REST, consulta la API de Compute Engine.

Formatear y montar una unidad SSD local

Puedes formatear y montar cada disco SSD local de forma individual o combinar varios discos SSD locales en un único volumen lógico.

Formatear y montar particiones de SSD locales individuales

La forma más sencilla de conectar SSDs locales a tu instancia es formatear y montar cada dispositivo con una sola partición. También puedes combinar varias particiones en un único volumen lógico.

Instancias de Linux

Formatea y monta el nuevo SSD local en tu instancia de Linux. Puedes usar cualquier formato y configuración de partición que necesites. En este ejemplo, crearemos una sola partición

ext4.Ve a la página Instancias de VM.

Haz clic en el botón SSH situado junto a la instancia que tiene el nuevo SSD local adjunto. El navegador abre una conexión de terminal a la instancia.

En el terminal, usa el comando

findpara identificar la unidad SSD local que quieras montar.$ find /dev/ | grep google-local-nvme-ssdLas SSDs locales en modo SCSI tienen nombres estándar, como

google-local-ssd-0. Las unidades SSD locales en modo NVMe tienen nombres comogoogle-local-nvme-ssd-0, tal como se muestra en el siguiente resultado:$ find /dev/ | grep google-local-nvme-ssd /dev/disk/by-id/google-local-nvme-ssd-0

Formatea el SSD local con un sistema de archivos ext4. Este comando elimina todos los datos del SSD local.

$ sudo mkfs.ext4 -F /dev/disk/by-id/[SSD_NAME]Sustituye

[SSD_NAME]por el ID del SSD local que quieras formatear. Por ejemplo, especificagoogle-local-nvme-ssd-0para dar formato al primer SSD local NVMe de la instancia.Usa el comando

mkdirpara crear un directorio en el que puedas montar el dispositivo.$ sudo mkdir -p /mnt/disks/[MNT_DIR]Sustituye

[MNT_DIR]por la ruta del directorio en el que quieras montar tu disco SSD local.Monta el SSD local en la VM.

$ sudo mount /dev/disk/by-id/[SSD_NAME] /mnt/disks/[MNT_DIR]Haz los cambios siguientes:

[SSD_NAME]: el ID del SSD local que quieras montar.[MNT_DIR]: el directorio en el que quieres montar tu SSD local.

Configura el acceso de lectura y escritura al dispositivo. En este ejemplo, se concede acceso de escritura al dispositivo a todos los usuarios.

$ sudo chmod a+w /mnt/disks/[MNT_DIR]Sustituye

[MNT_DIR]por el directorio en el que has montado tu SSD local.

Opcionalmente, puedes añadir el SSD local al archivo

/etc/fstabpara que el dispositivo se vuelva a montar automáticamente cuando se reinicie la instancia. Esta entrada no conserva los datos de tu SSD local si la instancia se detiene. Para obtener más información, consulta Persistencia de datos de SSD local.Cuando especifiques el archivo

/etc/fstab, asegúrate de incluir la opciónnofailpara que la instancia pueda seguir arrancando aunque no esté presente el SSD local. Por ejemplo, si haces una captura del disco de arranque y creas una instancia sin ningún disco SSD local conectado, la instancia puede continuar con el proceso de inicio y no se detendrá indefinidamente.Crea la entrada

/etc/fstab. Usa el comandoblkidpara buscar el UUID del sistema de archivos del dispositivo y edita el archivo/etc/fstabpara incluir ese UUID con las opciones de montaje. Puedes completar este paso con un solo comando.Por ejemplo, para un SSD local en modo NVMe, usa el siguiente comando:

$ echo UUID=`sudo blkid -s UUID -o value /dev/disk/by-id/google-local-nvme-ssd-0` /mnt/disks/[MNT_DIR] ext4 discard,defaults,nofail 0 2 | sudo tee -a /etc/fstabPara un SSD local en un modo que no sea NVMe, como SCSI, usa el siguiente comando:

$ echo UUID=`sudo blkid -s UUID -o value /dev/disk/by-id/google-local-ssd-0` /mnt/disks/[MNT_DIR] ext4 discard,defaults,nofail 0 2 | sudo tee -a /etc/fstabSustituye

[MNT_DIR]por el directorio en el que has montado tu SSD local.Usa el comando

catpara verificar que las entradas de/etc/fstabson correctas:$ cat /etc/fstab

Si creas una instantánea del disco de arranque de esta instancia y la usas para crear otra instancia que no tenga unidades SSD locales, edita el archivo

/etc/fstaby elimina la entrada de esta unidad SSD local. Aunque tengas la opciónnofailactivada, mantén el archivo/etc/fstabsincronizado con las particiones conectadas a tu instancia y elimina estas entradas antes de crear la instantánea del disco de arranque.Instancias de Windows

Usa la herramienta Administración de discos de Windows para formatear y montar un SSD local en una instancia de Windows.

Conéctate a la instancia mediante RDP. En este ejemplo, ve a la página Instancias de VM y haz clic en el botón RDP situado junto a la instancia que tiene las SSD locales conectadas. Después de introducir tu nombre de usuario y contraseña, se abrirá una ventana con la interfaz de escritorio de tu servidor.

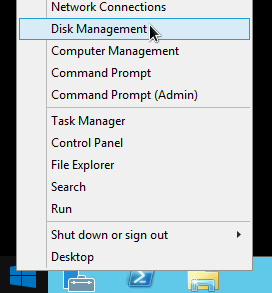

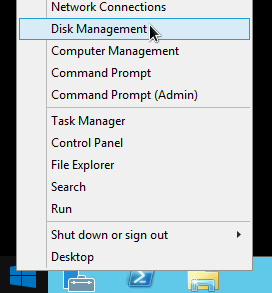

Haz clic con el botón derecho en el botón Inicio de Windows y selecciona Administración de discos.

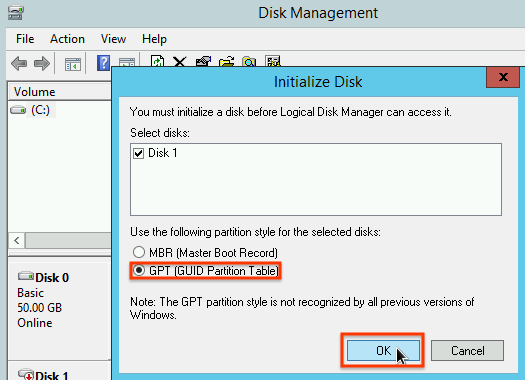

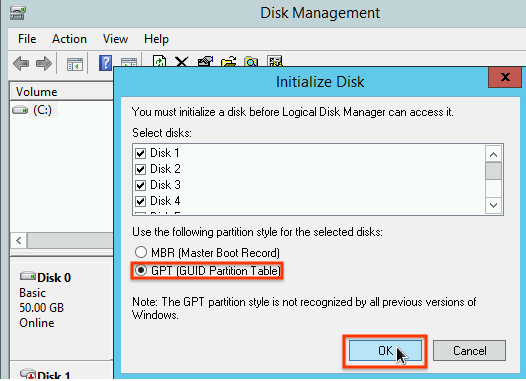

Si no has inicializado el SSD local antes, la herramienta te pedirá que selecciones un esquema de partición para las nuevas particiones. Selecciona GPT y haz clic en Aceptar.

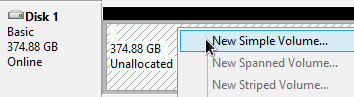

Una vez que se haya inicializado el SSD local, haz clic con el botón derecho en el espacio de disco no asignado y selecciona Nuevo volumen simple.

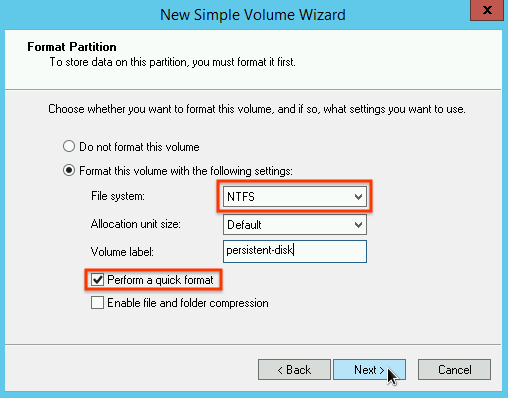

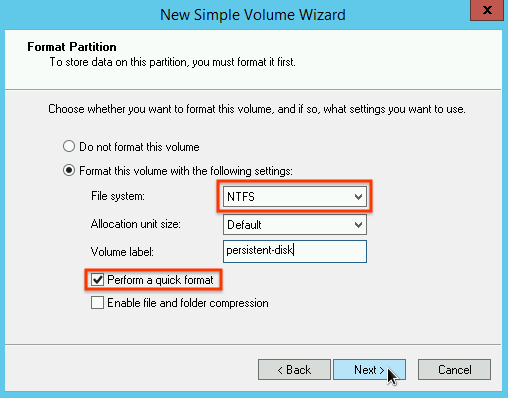

Sigue las instrucciones del Asistente para nuevo volumen simple para configurar el nuevo volumen. Puedes usar el formato de partición que quieras, pero en este ejemplo selecciona

NTFS. También puedes consultar la sección Realizar un formato rápido para acelerar el proceso de formato.

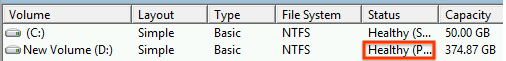

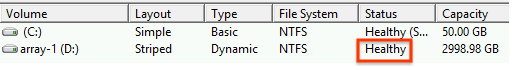

Una vez que hayas completado el asistente y el volumen haya terminado de formatearse, comprueba el nuevo SSD local para asegurarte de que tiene el estado

Healthy.

Eso es todo. Ahora puedes escribir archivos en el SSD local.

Formatear y montar varias particiones de SSD local en un único volumen lógico

A diferencia de los SSD persistentes, los SSD locales tienen una capacidad fija de 375 GB por cada dispositivo que conectes a la instancia. Si quieres combinar varias particiones de SSD local en un único volumen lógico, debes definir la gestión de volúmenes en estas particiones.

Instancias de Linux

Usa

mdadmpara crear un array RAID 0. En este ejemplo, se da formato a la matriz con un solo sistema de archivosext4, pero puedes aplicar el que prefieras.Ve a la página Instancias de VM.

Haz clic en el botón SSH situado junto a la instancia que tiene el nuevo SSD local adjunto. El navegador abre una conexión de terminal a la instancia.

En el terminal, instala la herramienta

mdadm. El proceso de instalación demdadmincluye una petición al usuario que detiene las secuencias de comandos, por lo que debes ejecutar este proceso manualmente.Debian y Ubuntu:

$ sudo apt update && sudo apt install mdadm --no-install-recommendsCentOS y RHEL:

$ sudo yum install mdadm -ySLES y openSUSE:

$ sudo zypper install -y mdadmUsa el comando

findpara identificar todas las unidades SSD locales que quieras montar juntas.En este ejemplo, la instancia tiene ocho particiones de SSD local en modo NVMe:

$ find /dev/ | grep google-local-nvme-ssd /dev/disk/by-id/google-local-nvme-ssd-7 /dev/disk/by-id/google-local-nvme-ssd-6 /dev/disk/by-id/google-local-nvme-ssd-5 /dev/disk/by-id/google-local-nvme-ssd-4 /dev/disk/by-id/google-local-nvme-ssd-3 /dev/disk/by-id/google-local-nvme-ssd-2 /dev/disk/by-id/google-local-nvme-ssd-1 /dev/disk/by-id/google-local-nvme-ssd-0

findno garantiza un orden. No importa si los dispositivos se muestran en un orden diferente, siempre que el número de líneas de salida coincida con el número esperado de particiones SSD. Las SSDs locales en modo SCSI tienen nombres estándar, comogoogle-local-ssd. Las unidades SSD locales en modo NVMe tienen nombres comogoogle-local-nvme-ssd.Usa

mdadmpara combinar varias unidades SSD locales en un solo array llamado/dev/md0. En este ejemplo se combinan ocho dispositivos SSD locales en modo NVMe. En el caso de los dispositivos SSD local en modo SCSI, especifica los nombres que has obtenido con el comandofind:$ sudo mdadm --create /dev/md0 --level=0 --raid-devices=8 \ /dev/disk/by-id/google-local-nvme-ssd-0 \ /dev/disk/by-id/google-local-nvme-ssd-1 \ /dev/disk/by-id/google-local-nvme-ssd-2 \ /dev/disk/by-id/google-local-nvme-ssd-3 \ /dev/disk/by-id/google-local-nvme-ssd-4 \ /dev/disk/by-id/google-local-nvme-ssd-5 \ /dev/disk/by-id/google-local-nvme-ssd-6 \ /dev/disk/by-id/google-local-nvme-ssd-7 mdadm: Defaulting to version 1.2 metadata mdadm: array /dev/md0 started.

Puedes confirmar los detalles de la matriz con

mdadm --detail. Si añades la marca--prefer=by-id, se mostrarán los dispositivos que usan las rutas/dev/disk/by-id.sudo mdadm --detail --prefer=by-id /dev/md0

La salida debería ser similar a la siguiente para cada dispositivo de la matriz.

... Number Major Minor RaidDevice State 0 259 0 0 active sync /dev/disk/by-id/google-local-nvme-ssd-0 ...Formatea la matriz

/dev/md0completa con un sistema de archivos ext4.$ sudo mkfs.ext4 -F /dev/md0Crea un directorio en el que puedas montar

/dev/md0. En este ejemplo, crea el directorio/mnt/disks/ssd-array:$ sudo mkdir -p /mnt/disks/[MNT_DIR]Sustituye

[MNT_DIR]por el directorio en el que quieras montar tu array de SSD local.Monta la matriz

/dev/md0en el directorio/mnt/disks/ssd-array:$ sudo mount /dev/md0 /mnt/disks/[MNT_DIR]Sustituye

[MNT_DIR]por el directorio en el que quieras montar tu array de SSD local.Configura el acceso de lectura y escritura al dispositivo. En este ejemplo, se concede acceso de escritura al dispositivo a todos los usuarios.

$ sudo chmod a+w /mnt/disks/[MNT_DIR]Sustituye

[MNT_DIR]por el directorio en el que has montado tu array SSD local.

Opcionalmente, puedes añadir el SSD local al archivo

/etc/fstabpara que el dispositivo se vuelva a montar automáticamente cuando se reinicie la instancia. Esta entrada no conserva los datos de tu SSD local si la instancia se detiene. Para obtener más información, consulta Persistencia de datos de SSD local.Cuando especifiques el archivo

/etc/fstab, asegúrate de incluir la opciónnofailpara que la instancia pueda seguir arrancando aunque no esté presente el SSD local. Por ejemplo, si haces una captura del disco de arranque y creas una instancia sin ninguna unidad SSD local conectada, la instancia puede continuar con el proceso de inicio y no se detendrá indefinidamente.Crea la entrada

/etc/fstab. Usa el comandoblkidpara buscar el UUID del sistema de archivos del dispositivo y edita el archivo/etc/fstabpara incluir ese UUID con las opciones de montaje. Especifica la opciónnofailpara permitir que el sistema arranque aunque el SSD local no esté disponible.Puedes completar este paso con un solo comando. Por ejemplo:$ echo UUID=`sudo blkid -s UUID -o value /dev/md0` /mnt/disks/[MNT_DIR] ext4 discard,defaults,nofail 0 2 | sudo tee -a /etc/fstabSustituye

[MNT_DIR]por el directorio en el que has montado tu array SSD local.Si usas un nombre de dispositivo como

/dev/md0en el archivo/etc/fstaben lugar del UUID, debes editar el archivo/etc/mdadm/mdadm.confpara asegurarte de que el array se vuelva a ensamblar automáticamente al arrancar. Para ello, sigue estos dos pasos:- Asegúrate de que el conjunto de discos se analice y se vuelva a montar automáticamente al arrancar.

$ sudo mdadm --detail --scan | sudo tee -a /etc/mdadm/mdadm.conf - Actualiza

initramfspara que la matriz esté disponible durante el proceso de arranque inicial.$ sudo update-initramfs -u

- Asegúrate de que el conjunto de discos se analice y se vuelva a montar automáticamente al arrancar.

Usa el comando

catpara verificar que las entradas de/etc/fstabson correctas:$ cat /etc/fstab

Si creas una instantánea del disco de arranque de esta instancia y la usas para crear otra instancia que no tenga unidades SSD locales, edita el archivo

/etc/fstaby elimina la entrada de esta matriz de unidades SSD locales. Aunque tengas la opciónnofailactivada, mantén el archivo/etc/fstabsincronizado con las particiones conectadas a tu instancia y elimina estas entradas antes de crear la instantánea del disco de arranque.Instancias de Windows

Usa la herramienta Administración de discos de Windows para formatear y montar un array de SSDs locales en una instancia de Windows.

Conéctate a la instancia mediante RDP. En este ejemplo, ve a la página Instancias de VM y haz clic en el botón RDP situado junto a la instancia que tiene las SSD locales conectadas. Después de introducir tu nombre de usuario y contraseña, se abrirá una ventana con la interfaz de escritorio de tu servidor.

Haz clic con el botón derecho en el botón Inicio de Windows y selecciona Administración de discos.

Si no has inicializado las unidades SSD locales antes, la herramienta te pedirá que selecciones un esquema de partición para las nuevas particiones. Selecciona GPT y haz clic en Aceptar.

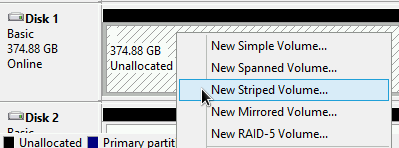

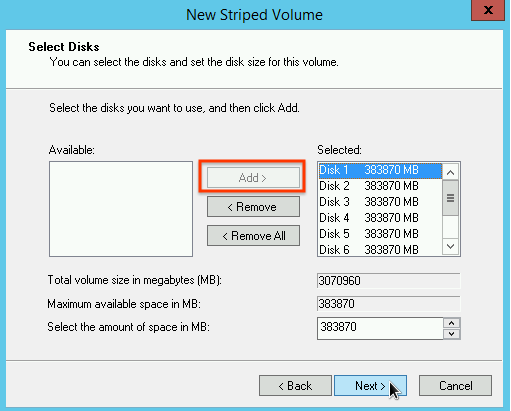

Una vez que se haya inicializado el SSD local, haz clic con el botón derecho en el espacio de disco no asignado y selecciona Nuevo volumen seccionado.

Selecciona las particiones de SSD local que quieras incluir en el array segmentado. En este ejemplo, selecciona todas las particiones para combinarlas en una sola unidad SSD local.

Sigue las instrucciones del Asistente para crear volúmenes rayados para configurar el nuevo volumen. Puedes usar el formato de partición que quieras, pero en este ejemplo selecciona

NTFS. También puedes consultar la sección Realizar un formato rápido para acelerar el proceso de formato.

Una vez que hayas completado el asistente y el volumen haya terminado de formatearse, comprueba el nuevo SSD local para asegurarte de que tiene el estado

Healthy.

Ahora puedes escribir archivos en el SSD local.

Siguientes pasos

- Consulta más información sobre los nombres de los dispositivos de tu VM.

- Consulta cómo hacer comparativas del rendimiento de los discos SSD locales.

A menos que se indique lo contrario, el contenido de esta página está sujeto a la licencia Reconocimiento 4.0 de Creative Commons y las muestras de código están sujetas a la licencia Apache 2.0. Para obtener más información, consulta las políticas del sitio web de Google Developers. Java es una marca registrada de Oracle o sus afiliados.

Última actualización: 2025-10-19 (UTC).

-