Os SSDs locais foram concebidos para exemplos de utilização de armazenamento temporário, como caches ou espaço de processamento temporário. Uma vez que os SSDs locais estão localizados na máquina física onde a VM está a ser executada, só podem ser criados durante o processo de criação da VM. Não é possível usar SSDs locais como dispositivos de arranque.

Para a série de máquinas de terceira geração e posteriores, é adicionada uma quantidade definida de discos SSD locais à VM quando a cria. A única forma de adicionar armazenamento SSD local a estas VMs é:

- Para C4, C4D, C3 e C3D, o armazenamento SSD local só está disponível com determinados tipos de máquinas, como

c3-standard-88-lssd. - Para as séries de máquinas Z3, A4, A4X, A3 e A2 Ultra, todos os tipos de máquinas incluem armazenamento SSD local.

Para os tipos de máquinas M3 e de primeira e segunda geração, tem de especificar discos SSD locais quando cria a VM.

Depois de criar um disco SSD local, tem de formatar e montar o dispositivo antes de o poder usar.

Para obter informações sobre a quantidade de armazenamento SSD local disponível com vários tipos de máquinas e o número de discos SSD locais que pode associar a uma VM, consulte o artigo Escolher um número válido de SSDs locais.

Antes de começar

- Reveja as limitações do SSD local antes de usar SSDs locais.

- Reveja os cenários de persistência de dados para discos SSD locais.

- Se estiver a adicionar SSDs locais a instâncias de máquinas virtuais (VM) com GPUs associadas, consulte o artigo Disponibilidade de SSDs locais por regiões e zonas de GPU.

-

Se ainda não o tiver feito, configure a autenticação.

A autenticação valida a sua identidade para aceder a Google Cloud serviços e APIs. Para executar código ou exemplos a partir de um ambiente de desenvolvimento local, pode autenticar-se no Compute Engine selecionando uma das seguintes opções:

Select the tab for how you plan to use the samples on this page:

Console

When you use the Google Cloud console to access Google Cloud services and APIs, you don't need to set up authentication.

gcloud

-

Instale a CLI Google Cloud. Após a instalação, inicialize a CLI gcloud executando o seguinte comando:

gcloud initSe estiver a usar um fornecedor de identidade (IdP) externo, primeiro tem de iniciar sessão na CLI gcloud com a sua identidade federada.

- Set a default region and zone.

Terraform

Para usar os exemplos do Terraform nesta página num ambiente de desenvolvimento local, instale e inicialize a CLI gcloud e, em seguida, configure as credenciais predefinidas da aplicação com as suas credenciais de utilizador.

Instale a CLI Google Cloud.

Se estiver a usar um fornecedor de identidade (IdP) externo, primeiro tem de iniciar sessão na CLI gcloud com a sua identidade federada.

If you're using a local shell, then create local authentication credentials for your user account:

gcloud auth application-default login

You don't need to do this if you're using Cloud Shell.

If an authentication error is returned, and you are using an external identity provider (IdP), confirm that you have signed in to the gcloud CLI with your federated identity.

Para mais informações, consulte Set up authentication for a local development environment.

Ir

Para usar os Go exemplos nesta página num ambiente de desenvolvimento local, instale e inicialize a CLI gcloud e, em seguida, configure as Credenciais predefinidas da aplicação com as suas credenciais de utilizador.

Instale a CLI Google Cloud.

Se estiver a usar um fornecedor de identidade (IdP) externo, primeiro tem de iniciar sessão na CLI gcloud com a sua identidade federada.

If you're using a local shell, then create local authentication credentials for your user account:

gcloud auth application-default login

You don't need to do this if you're using Cloud Shell.

If an authentication error is returned, and you are using an external identity provider (IdP), confirm that you have signed in to the gcloud CLI with your federated identity.

Para mais informações, consulte Set up authentication for a local development environment.

Java

Para usar os Java exemplos nesta página num ambiente de desenvolvimento local, instale e inicialize a CLI gcloud e, em seguida, configure as Credenciais predefinidas da aplicação com as suas credenciais de utilizador.

Instale a CLI Google Cloud.

Se estiver a usar um fornecedor de identidade (IdP) externo, primeiro tem de iniciar sessão na CLI gcloud com a sua identidade federada.

If you're using a local shell, then create local authentication credentials for your user account:

gcloud auth application-default login

You don't need to do this if you're using Cloud Shell.

If an authentication error is returned, and you are using an external identity provider (IdP), confirm that you have signed in to the gcloud CLI with your federated identity.

Para mais informações, consulte Set up authentication for a local development environment.

Python

Para usar os Python exemplos nesta página num ambiente de desenvolvimento local, instale e inicialize a CLI gcloud e, em seguida, configure as Credenciais predefinidas da aplicação com as suas credenciais de utilizador.

Instale a CLI Google Cloud.

Se estiver a usar um fornecedor de identidade (IdP) externo, primeiro tem de iniciar sessão na CLI gcloud com a sua identidade federada.

If you're using a local shell, then create local authentication credentials for your user account:

gcloud auth application-default login

You don't need to do this if you're using Cloud Shell.

If an authentication error is returned, and you are using an external identity provider (IdP), confirm that you have signed in to the gcloud CLI with your federated identity.

Para mais informações, consulte Set up authentication for a local development environment.

REST

Para usar os exemplos da API REST nesta página num ambiente de desenvolvimento local, usa as credenciais que fornece à CLI gcloud.

Instale a CLI Google Cloud.

Se estiver a usar um fornecedor de identidade (IdP) externo, primeiro tem de iniciar sessão na CLI gcloud com a sua identidade federada.

Para mais informações, consulte o artigo Autenticar para usar REST na Google Cloud documentação de autenticação.

Crie uma VM com um SSD local

Pode criar uma VM com armazenamento em disco SSD local através da Google Cloud console, da CLI gcloud ou da API Compute Engine.

Consola

Aceda à página Criar uma instância.

Especifique o nome, a região e a zona da sua VM. Opcionalmente, adicione etiquetas ou rótulos.

Na secção Configuração da máquina, escolha a família de máquinas que contém o tipo de máquina de destino.

Selecione uma série na lista Série e, em seguida, escolha o tipo de máquina.

- Para C4, C4D, C3 e C3D, escolha um tipo de máquina que termine em

-lssd. - Para o Z3, o A4, o A4X, o A3 e o A2 Ultra, todos os tipos de máquinas incluem armazenamento SSD local.

- Para a série de máquinas M3 ou de primeira e segunda geração, depois de selecionar o tipo de máquina, faça o seguinte:

- Expanda a secção Opções avançadas.

- Expanda Discos, clique em Adicionar SSD local e faça o seguinte:

- Na página Configurar SSD local, escolha o tipo de interface de disco.

- Selecione o número de discos pretendido na lista Capacidade do disco.

- Clique em Guardar.

- Para C4, C4D, C3 e C3D, escolha um tipo de máquina que termine em

Continue com o processo de criação da VM.

Depois de criar a VM com discos SSD locais, tem de formatar e montar cada dispositivo antes de poder usar os discos.

gcloud

Para as séries de máquinas Z3, A4, A4X, A3 e A2 Ultra, para criar uma VM com discos SSD locais anexados, crie uma VM que use qualquer um dos tipos de máquinas disponíveis para essa série seguindo as instruções para criar uma instância.

Para as séries de máquinas C4, C4D, C3 e C3D, para criar uma VM com discos SSD locais anexados, siga as instruções para criar uma instância, mas especifique um tipo de instância que inclua discos SSD locais (

-lssd).Por exemplo, pode criar uma VM C3 com duas partições de SSD local que usam a interface de disco NVMe da seguinte forma:

gcloud compute instances create example-c3-instance \ --zone ZONE \ --machine-type c3-standard-8-lssd \ --image-project IMAGE_PROJECT \ --image-family IMAGE_FAMILY

Para as séries de máquinas M3 e de primeira e segunda geração, para criar uma VM com discos SSD local anexados, siga as instruções para criar uma instância, mas use a flag

--local-ssdpara criar e anexar um disco SSD local. Para criar vários discos SSD locais, adicione mais flags--local-ssd. Opcionalmente, também pode definir valores para a interface e o nome do dispositivo para cada indicador--local-ssd.Por exemplo, pode criar uma VM M3 com quatro discos SSD locais e especificar o tipo de interface de disco da seguinte forma:

gcloud compute instances create VM_NAME \ --machine-type m3-ultramem-64 \ --zone ZONE \ --local-ssd interface=INTERFACE_TYPE,device-name=DEVICE-NAME \ --local-ssd interface=INTERFACE_TYPE,device-name=DEVICE-NAME \ --local-ssd interface=INTERFACE_TYPE,device-name=DEVICE-NAME \ --local-ssd interface=INTERFACE_TYPE \ --image-project IMAGE_PROJECT \ --image-family IMAGE_FAMILY

Substitua o seguinte:

- VM_NAME: o nome da nova VM

- ZONE: a zona na qual criar a VM. Esta flag é opcional se tiver configurado a propriedade

compute/zoneda CLI gcloud ou a variável de ambienteCLOUDSDK_COMPUTE_ZONE. - INTERFACE_TYPE: o tipo de interface de disco que quer usar para o dispositivo SSD local. Especifique

nvmese estiver a criar uma VM M3 ou se a imagem do disco de arranque tiver controladores NVMe otimizados. Especifiquescsipara outras imagens. - DEVICE-NAME: Opcional: um nome que indica o nome do disco a usar no link simbólico (symlink) do sistema operativo convidado.

- IMAGE_FAMILY: uma das famílias de imagens disponíveis que quer instalada no disco de arranque

- IMAGE_PROJECT: o projeto de imagem ao qual a família de imagens pertence

Se necessário, pode anexar SSDs locais a uma VM de primeira ou segunda geração através de uma combinação de

nvmeescsipara diferentes partições. O desempenho do dispositivonvmedepende da imagem do disco de arranque da sua instância. As VMs de terceira geração só suportam a interface de disco NVMe.Depois de criar uma VM com um SSD local, tem de formatar e montar cada dispositivo antes de o poder usar.

Terraform

Para criar uma VM com discos SSD locais anexados, pode usar o recurso

google_compute_instance.Para saber como aplicar ou remover uma configuração do Terraform, consulte os comandos básicos do Terraform.

Para gerar o código do Terraform, pode usar o componente Código equivalente na Google Cloud consola.- Na Google Cloud consola, aceda à página Instâncias de VM.

- Clique em Criar instância.

- Especifique os parâmetros pretendidos.

- Na parte superior ou inferior da página, clique em Código equivalente e, de seguida, clique no separador Terraform para ver o código Terraform.

Ir

Go

Antes de experimentar este exemplo, siga as Goinstruções de configuração no guia de início rápido do Compute Engine com bibliotecas cliente. Para mais informações, consulte a documentação de referência da API Go Compute Engine.

Para se autenticar no Compute Engine, configure as Credenciais padrão da aplicação. Para mais informações, consulte o artigo Configure a autenticação para um ambiente de desenvolvimento local.

Java

Java

Antes de experimentar este exemplo, siga as Javainstruções de configuração no guia de início rápido do Compute Engine com bibliotecas cliente. Para mais informações, consulte a documentação de referência da API Java Compute Engine.

Para se autenticar no Compute Engine, configure as Credenciais padrão da aplicação. Para mais informações, consulte o artigo Configure a autenticação para um ambiente de desenvolvimento local.

Python

Python

Antes de experimentar este exemplo, siga as Pythoninstruções de configuração no guia de início rápido do Compute Engine com bibliotecas cliente. Para mais informações, consulte a documentação de referência da API Python Compute Engine.

Para se autenticar no Compute Engine, configure as Credenciais padrão da aplicação. Para mais informações, consulte o artigo Configure a autenticação para um ambiente de desenvolvimento local.

REST

Use o comando

instances.insert methodpara criar uma VM a partir de uma família de imagens ou de uma versão específica de uma imagem do sistema operativo.- Para as séries de máquinas Z3, A4, A4X, A3 e A2 Ultra, para criar uma VM com discos SSD locais anexados, crie uma VM que use qualquer um dos tipos de máquinas disponíveis para essa série.

Para as séries de máquinas C4, C4D, C3 e C3D, para criar uma VM com discos SSD locais anexados, especifique um tipo de instância que inclua discos SSD locais (

-lssd).Segue-se um exemplo de payload de pedido que cria uma VM C3 com um disco de arranque do Ubuntu e dois discos SSD locais:

{ "machineType":"zones/us-central1-c/machineTypes/c3-standard-8-lssd", "name":"c3-with-local-ssd", "disks":[ { "type":"PERSISTENT", "initializeParams":{ "sourceImage":"projects/ubuntu-os-cloud/global/images/family/ubuntu-2204-lts" }, "boot":true } ], "networkInterfaces":[ { "network":"global/networks/default" } ] }Para as séries de máquinas M3 e de primeira e segunda geração, para criar uma VM com discos SSD locais anexados, pode adicionar dispositivos SSD locais durante a criação da VM através da propriedade

initializeParams. Também tem de fornecer as seguintes propriedades:diskType: definido como SSD localautoDelete: definido como verdadeirotype: definido comoSCRATCH

Não é possível usar as seguintes propriedades com dispositivos SSD local:

diskNamesourceImagepropriedadediskSizeGb

Segue-se um exemplo de uma carga útil de pedido que cria uma VM M3 com um disco de arranque e quatro discos SSD locais:

{ "machineType":"zones/us-central1-f/machineTypes/m3-ultramem-64", "name":"local-ssd-instance", "disks":[ { "type":"PERSISTENT", "initializeParams":{ "sourceImage":"projects/ubuntu-os-cloud/global/images/family/ubuntu-2204-lts" }, "boot":true }, { "type":"SCRATCH", "initializeParams":{ "diskType":"zones/us-central1-f/diskTypes/local-ssd" }, "autoDelete":true, "interface": "NVME" }, { "type":"SCRATCH", "initializeParams":{ "diskType":"zones/us-central1-f/diskTypes/local-ssd" }, "autoDelete":true, "interface": "NVME" }, { "type":"SCRATCH", "initializeParams":{ "diskType":"zones/us-central1-f/diskTypes/local-ssd" }, "autoDelete":true, "interface": "NVME" }, { "type":"SCRATCH", "initializeParams":{ "diskType":"zones/us-central1-f/diskTypes/local-ssd" }, "autoDelete":true, "interface": "NVME" }, ], "networkInterfaces":[ { "network":"global/networks/default" } ] }

Depois de criar um disco SSD local, tem de formatar e montar cada dispositivo antes de o poder usar.

Para mais informações sobre como criar uma instância através da REST, consulte a API Compute Engine.

Formatar e montar um dispositivo SSD local

Pode formatar e montar cada disco SSD local individualmente ou combinar vários discos SSD locais num único volume lógico.

Formate e monte partições SSD locais individuais

A forma mais fácil de ligar SSDs locais à sua instância é formatar e montar cada dispositivo com uma única partição. Em alternativa, pode combinar várias partições num único volume lógico.

Instâncias do Linux

Formate e monte o novo SSD local na sua instância do Linux. Pode usar qualquer formato de partição e configuração de que necessitar. Para este exemplo, crie uma única partição

ext4.Aceda à página de instâncias de VM.

Clique no botão SSH junto à instância que tem o novo SSD local anexado. O navegador abre uma ligação de terminal à instância.

No terminal, use o comando

findpara identificar o SSD local que quer montar.$ find /dev/ | grep google-local-nvme-ssdOs SSDs locais no modo SCSI têm nomes padrão, como

google-local-ssd-0. Os SSDs locais no modo NVMe têm nomes comogoogle-local-nvme-ssd-0, conforme mostrado no seguinte resultado:$ find /dev/ | grep google-local-nvme-ssd /dev/disk/by-id/google-local-nvme-ssd-0

Formate o SSD local com um sistema de ficheiros ext4. Este comando elimina todos os dados existentes do SSD local.

$ sudo mkfs.ext4 -F /dev/disk/by-id/[SSD_NAME]Substitua

[SSD_NAME]pelo ID do SSD local que quer formatar. Por exemplo, especifiquegoogle-local-nvme-ssd-0para formatar o primeiro NVMe Local SSD na instância.Use o comando

mkdirpara criar um diretório onde pode montar o dispositivo.$ sudo mkdir -p /mnt/disks/[MNT_DIR]Substitua

[MNT_DIR]pelo caminho do diretório onde quer montar o disco SSD local.Monte o SSD local na VM.

$ sudo mount /dev/disk/by-id/[SSD_NAME] /mnt/disks/[MNT_DIR]Substitua o seguinte:

[SSD_NAME]: o ID do SSD local que quer montar.[MNT_DIR]: o diretório onde quer montar o SSD local.

Configurar o acesso de leitura e escrita ao dispositivo. Para este exemplo, conceda acesso de escrita ao dispositivo a todos os utilizadores.

$ sudo chmod a+w /mnt/disks/[MNT_DIR]Substitua

[MNT_DIR]pelo diretório onde montou o SSD local.

Opcionalmente, pode adicionar o SSD local ao ficheiro

/etc/fstabpara que o dispositivo seja montado automaticamente novamente quando a instância for reiniciada. Esta entrada não preserva os dados no SSD local se a instância for interrompida. Consulte o artigo Persistência de dados do SSD local para ver os detalhes completos.Quando especificar o ficheiro

/etc/fstab, certifique-se de que inclui a opçãonofailpara que a instância possa continuar a ser iniciada mesmo que o SSD local não esteja presente. Por exemplo, se tirar uma captura instantânea do disco de arranque e criar uma nova instância sem discos SSD locais anexados, a instância pode continuar o processo de arranque e não pausar indefinidamente.Crie a entrada

/etc/fstab. Use o comandoblkidpara encontrar o UUID do sistema de ficheiros no dispositivo e edite o ficheiro/etc/fstabpara incluir esse UUID com as opções de montagem. Pode concluir este passo com um único comando.Por exemplo, para um SSD local no modo NVMe, use o seguinte comando:

$ echo UUID=`sudo blkid -s UUID -o value /dev/disk/by-id/google-local-nvme-ssd-0` /mnt/disks/[MNT_DIR] ext4 discard,defaults,nofail 0 2 | sudo tee -a /etc/fstabPara um SSD local num modo não NVMe, como SCSI, use o seguinte comando:

$ echo UUID=`sudo blkid -s UUID -o value /dev/disk/by-id/google-local-ssd-0` /mnt/disks/[MNT_DIR] ext4 discard,defaults,nofail 0 2 | sudo tee -a /etc/fstabSubstitua

[MNT_DIR]pelo diretório onde montou o SSD local.Use o comando

catpara verificar se as entradas/etc/fstabestão corretas:$ cat /etc/fstab

Se criar um instantâneo a partir do disco de arranque desta instância e o usar para criar uma instância separada que não tenha SSDs locais, edite o ficheiro

/etc/fstabe remova a entrada para este SSD local. Mesmo com a opçãonofailativada, mantenha o ficheiro/etc/fstabsincronizado com as partições anexadas à sua instância e remova estas entradas antes de criar a imagem instantânea do disco de arranque.Instâncias do Windows

Use a ferramenta de gestão de discos do Windows para formatar e montar um SSD local numa instância do Windows.

Ligue-se à instância através do RDP. Para este exemplo, aceda à página de instâncias de VMs e clique no botão RDP junto à instância que tem os SSDs locais anexados. Depois de introduzir o nome de utilizador e a palavra-passe, é aberta uma janela com a interface de computador para o seu servidor.

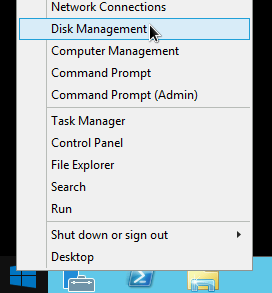

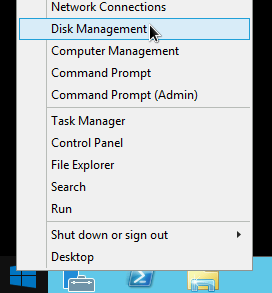

Clique com o botão direito do rato no botão Iniciar do Windows e selecione Gestão de discos.

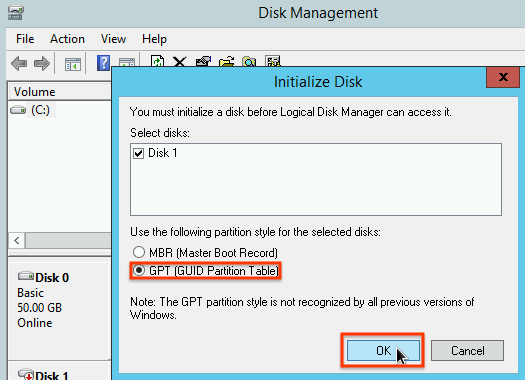

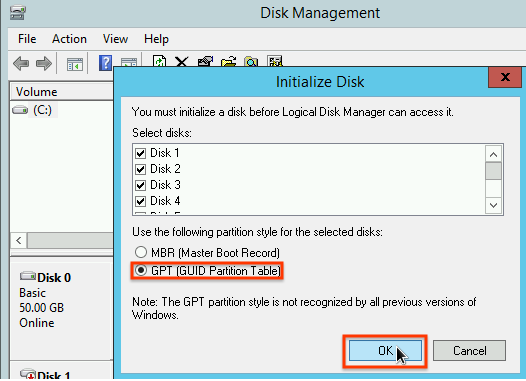

Se não tiver inicializado o SSD local anteriormente, a ferramenta pede-lhe que selecione um esquema de partição para as novas partições. Selecione GPT e clique em OK.

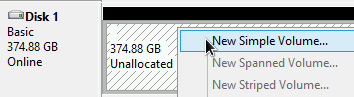

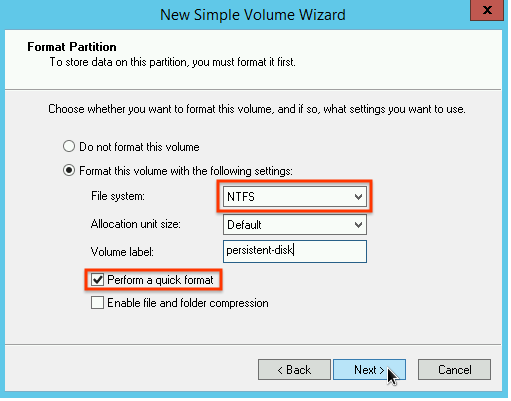

Após a inicialização do SSD local, clique com o botão direito do rato no espaço não atribuído do disco e selecione New Simple Volume.

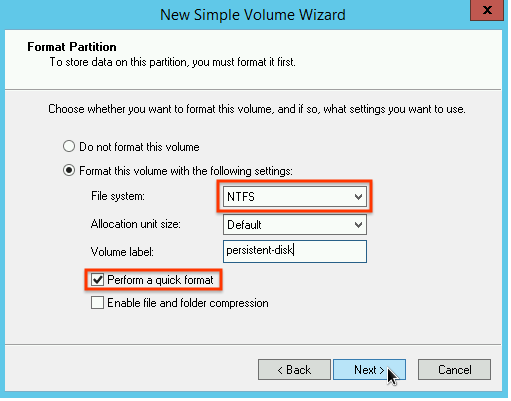

Siga as instruções no New Simple Volume Wizard para configurar o novo volume. Pode usar qualquer formato de partição que quiser, mas, para este exemplo, selecione

NTFS. Além disso, selecione Perform a quick format para acelerar o processo de formatação.

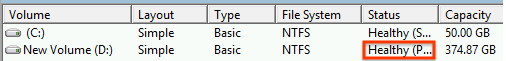

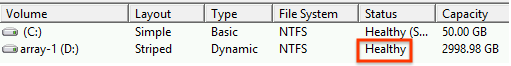

Depois de concluir o assistente e a formatação do volume, verifique o novo SSD local para garantir que tem o estado

Healthy.

E é tudo! Agora, pode escrever ficheiros no SSD local.

Formate e monte várias partições de SSD local num único volume lógico

Ao contrário dos SSDs persistentes, os SSDs locais têm uma capacidade fixa de 375 GB para cada dispositivo que associa à instância. Se quiser combinar várias partições de SSD local num único volume lógico, tem de definir a gestão de volumes nestas partições.

Instâncias do Linux

Use

mdadmpara criar uma matriz RAID 0. Este exemplo formata a matriz com um único sistema de ficheirosext4, mas pode aplicar qualquer sistema de ficheiros que preferir.Aceda à página de instâncias de VM.

Clique no botão SSH junto à instância que tem o novo SSD local anexado. O navegador abre uma ligação de terminal à instância.

No terminal, instale a ferramenta

mdadm. O processo de instalação domdadminclui um pedido ao utilizador que interrompe os scripts, pelo que deve executar este processo manualmente.Debian e Ubuntu:

$ sudo apt update && sudo apt install mdadm --no-install-recommendsCentOS e RHEL:

$ sudo yum install mdadm -ySLES e openSUSE:

$ sudo zypper install -y mdadmUse o comando

findpara identificar todos os SSDs locais que quer montar em conjunto.Para este exemplo, a instância tem oito partições de SSD local no modo NVMe:

$ find /dev/ | grep google-local-nvme-ssd /dev/disk/by-id/google-local-nvme-ssd-7 /dev/disk/by-id/google-local-nvme-ssd-6 /dev/disk/by-id/google-local-nvme-ssd-5 /dev/disk/by-id/google-local-nvme-ssd-4 /dev/disk/by-id/google-local-nvme-ssd-3 /dev/disk/by-id/google-local-nvme-ssd-2 /dev/disk/by-id/google-local-nvme-ssd-1 /dev/disk/by-id/google-local-nvme-ssd-0

findnão garante uma encomenda. Não há problema se os dispositivos forem apresentados por ordem diferente, desde que o número de linhas de saída corresponda ao número esperado de partições SSD. Os SSDs locais no modo SCSI têm nomes padrão, comogoogle-local-ssd. Os SSDs locais no modo NVMe têm nomes comogoogle-local-nvme-ssd.Use

mdadmpara combinar vários dispositivos SSD locais num único conjunto denominado/dev/md0. Este exemplo une oito dispositivos SSD locais no modo NVMe. Para dispositivos SSD locais no modo SCSI, especifique os nomes que obteve através do comandofind:$ sudo mdadm --create /dev/md0 --level=0 --raid-devices=8 \ /dev/disk/by-id/google-local-nvme-ssd-0 \ /dev/disk/by-id/google-local-nvme-ssd-1 \ /dev/disk/by-id/google-local-nvme-ssd-2 \ /dev/disk/by-id/google-local-nvme-ssd-3 \ /dev/disk/by-id/google-local-nvme-ssd-4 \ /dev/disk/by-id/google-local-nvme-ssd-5 \ /dev/disk/by-id/google-local-nvme-ssd-6 \ /dev/disk/by-id/google-local-nvme-ssd-7 mdadm: Defaulting to version 1.2 metadata mdadm: array /dev/md0 started.

Pode confirmar os detalhes da matriz com

mdadm --detail. A adição da flag--prefer=by-idapresenta uma lista dos dispositivos que usam os caminhos/dev/disk/by-id.sudo mdadm --detail --prefer=by-id /dev/md0

O resultado deve ser semelhante ao seguinte para cada dispositivo na matriz.

... Number Major Minor RaidDevice State 0 259 0 0 active sync /dev/disk/by-id/google-local-nvme-ssd-0 ...Formate a matriz

/dev/md0completa com um sistema de ficheiros ext4.$ sudo mkfs.ext4 -F /dev/md0Crie um diretório onde possa montar

/dev/md0. Para este exemplo, crie o diretório/mnt/disks/ssd-array:$ sudo mkdir -p /mnt/disks/[MNT_DIR]Substitua

[MNT_DIR]pelo diretório onde quer montar a sua matriz de SSD local.Monte a matriz

/dev/md0no diretório/mnt/disks/ssd-array:$ sudo mount /dev/md0 /mnt/disks/[MNT_DIR]Substitua

[MNT_DIR]pelo diretório onde quer montar a sua matriz de SSD local.Configurar o acesso de leitura e escrita ao dispositivo. Para este exemplo, conceda acesso de escrita ao dispositivo a todos os utilizadores.

$ sudo chmod a+w /mnt/disks/[MNT_DIR]Substitua

[MNT_DIR]pelo diretório onde montou a matriz de SSD local.

Opcionalmente, pode adicionar o SSD local ao ficheiro

/etc/fstabpara que o dispositivo seja montado automaticamente novamente quando a instância for reiniciada. Esta entrada não preserva os dados no SSD local se a instância for interrompida. Consulte o artigo Persistência de dados do SSD local para ver detalhes.Quando especificar o ficheiro

/etc/fstab, certifique-se de que inclui a opçãonofailpara que a instância possa continuar a ser iniciada mesmo que o SSD local não esteja presente. Por exemplo, se tirar uma captura instantânea do disco de arranque e criar uma nova instância sem SSDs locais anexados, a instância pode continuar o processo de arranque e não pausar indefinidamente.Crie a entrada

/etc/fstab. Use o comandoblkidpara encontrar o UUID do sistema de ficheiros no dispositivo e edite o ficheiro/etc/fstabpara incluir esse UUID com as opções de montagem. Especifique a opçãonofailpara permitir que o sistema seja iniciado mesmo que o SSD local esteja indisponível.Pode concluir este passo com um único comando. Por exemplo:$ echo UUID=`sudo blkid -s UUID -o value /dev/md0` /mnt/disks/[MNT_DIR] ext4 discard,defaults,nofail 0 2 | sudo tee -a /etc/fstabSubstitua

[MNT_DIR]pelo diretório onde montou a matriz de SSD local.Se usar um nome de dispositivo como

/dev/md0no ficheiro/etc/fstab, em vez do UUID, tem de editar o ficheiro/etc/mdadm/mdadm.confpara se certificar de que a matriz é remontada automaticamente no arranque. Para o fazer, conclua os dois passos seguintes:- Certifique-se de que a matriz de discos é analisada e remontada automaticamente no arranque.

$ sudo mdadm --detail --scan | sudo tee -a /etc/mdadm/mdadm.conf - Atualize

initramfspara que a matriz esteja disponível durante o processo de arranque inicial.$ sudo update-initramfs -u

- Certifique-se de que a matriz de discos é analisada e remontada automaticamente no arranque.

Use o comando

catpara verificar se as entradas/etc/fstabestão corretas:$ cat /etc/fstab

Se criar um instantâneo a partir do disco de arranque desta instância e o usar para criar uma instância separada que não tenha SSDs locais, edite o ficheiro

/etc/fstabe remova a entrada para esta matriz de SSDs locais. Mesmo com a opçãonofailativada, mantenha o ficheiro/etc/fstabsincronizado com as partições anexadas à sua instância e remova estas entradas antes de criar a imagem instantânea do disco de arranque.Instâncias do Windows

Use a ferramenta de gestão de discos do Windows para formatar e montar uma matriz de SSDs locais numa instância do Windows.

Ligue-se à instância através do RDP. Para este exemplo, aceda à página de instâncias de VMs e clique no botão RDP junto à instância que tem os SSDs locais anexados. Depois de introduzir o nome de utilizador e a palavra-passe, é aberta uma janela com a interface de computador para o seu servidor.

Clique com o botão direito do rato no botão Iniciar do Windows e selecione Gestão de discos.

Se não tiver inicializado os SSDs locais anteriormente, a ferramenta pede-lhe que selecione um esquema de partição para as novas partições. Selecione GPT e clique em OK.

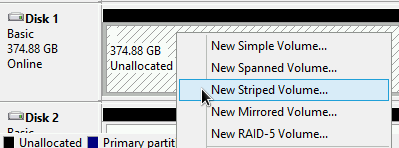

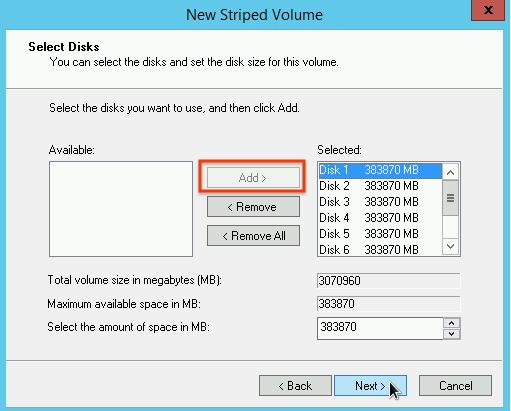

Após a inicialização do SSD local, clique com o botão direito do rato no espaço não atribuído do disco e selecione New Striped Volume.

Selecione as partições de SSD local que quer incluir na matriz em faixas. Para este exemplo, selecione todas as partições para as combinar num único dispositivo SSD local.

Siga as instruções no Novo assistente de volume listrado para configurar o novo volume. Pode usar qualquer formato de partição que quiser, mas, para este exemplo, selecione

NTFS. Além disso, selecione Perform a quick format para acelerar o processo de formatação.

Depois de concluir o assistente e a formatação do volume, verifique o novo SSD local para garantir que tem o estado

Healthy.

Agora, pode escrever ficheiros no SSD local.

O que se segue?

- Saiba mais sobre os nomes dos dispositivos da sua MV.

- Saiba como comparar o desempenho dos discos SSD locais

Exceto em caso de indicação contrária, o conteúdo desta página é licenciado de acordo com a Licença de atribuição 4.0 do Creative Commons, e as amostras de código são licenciadas de acordo com a Licença Apache 2.0. Para mais detalhes, consulte as políticas do site do Google Developers. Java é uma marca registrada da Oracle e/ou afiliadas.

Última atualização 2025-10-19 UTC.

-