Migra un esquema y datos desde Teradata

La combinación del Servicio de transferencia de datos de BigQuery y un agente de migración especial te permite copiar los datos de una instancia de almacén de datos local de Teradata a BigQuery. En este documento, se describe el proceso paso a paso para migrar datos desde Teradata con el Servicio de transferencia de datos de BigQuery.

Antes de comenzar

- Sign in to your Google Cloud account. If you're new to Google Cloud, create an account to evaluate how our products perform in real-world scenarios. New customers also get $300 in free credits to run, test, and deploy workloads.

-

In the Google Cloud console, on the project selector page, select or create a Google Cloud project.

Roles required to select or create a project

- Select a project: Selecting a project doesn't require a specific IAM role—you can select any project that you've been granted a role on.

-

Create a project: To create a project, you need the Project Creator

(

roles/resourcemanager.projectCreator), which contains theresourcemanager.projects.createpermission. Learn how to grant roles.

-

Verify that billing is enabled for your Google Cloud project.

-

Enable the BigQuery, BigQuery Data Transfer Service, Cloud Storage, and Pub/Sub APIs.

Roles required to enable APIs

To enable APIs, you need the Service Usage Admin IAM role (

roles/serviceusage.serviceUsageAdmin), which contains theserviceusage.services.enablepermission. Learn how to grant roles. -

Create a service account:

-

Ensure that you have the Create Service Accounts IAM role

(

roles/iam.serviceAccountCreator). Learn how to grant roles. -

In the Google Cloud console, go to the Create service account page.

Go to Create service account - Select your project.

-

In the Service account name field, enter a name. The Google Cloud console fills in the Service account ID field based on this name.

In the Service account description field, enter a description. For example,

Service account for quickstart. - Click Create and continue.

-

Grant the following roles to the service account: roles/bigquery.user, roles/storage.objectAdmin, roles/iam.serviceAccountTokenCreator.

To grant a role, find the Select a role list, then select the role.

To grant additional roles, click Add another role and add each additional role.

- Click Continue.

-

Click Done to finish creating the service account.

Do not close your browser window. You will use it in the next step.

-

Ensure that you have the Create Service Accounts IAM role

(

-

Create a service account key:

- In the Google Cloud console, click the email address for the service account that you created.

- Click Keys.

- Click Add key, and then click Create new key.

- Click Create. A JSON key file is downloaded to your computer.

- Click Close.

-

In the Google Cloud console, on the project selector page, select or create a Google Cloud project.

Roles required to select or create a project

- Select a project: Selecting a project doesn't require a specific IAM role—you can select any project that you've been granted a role on.

-

Create a project: To create a project, you need the Project Creator

(

roles/resourcemanager.projectCreator), which contains theresourcemanager.projects.createpermission. Learn how to grant roles.

-

Verify that billing is enabled for your Google Cloud project.

-

Enable the BigQuery, BigQuery Data Transfer Service, Cloud Storage, and Pub/Sub APIs.

Roles required to enable APIs

To enable APIs, you need the Service Usage Admin IAM role (

roles/serviceusage.serviceUsageAdmin), which contains theserviceusage.services.enablepermission. Learn how to grant roles. -

Create a service account:

-

Ensure that you have the Create Service Accounts IAM role

(

roles/iam.serviceAccountCreator). Learn how to grant roles. -

In the Google Cloud console, go to the Create service account page.

Go to Create service account - Select your project.

-

In the Service account name field, enter a name. The Google Cloud console fills in the Service account ID field based on this name.

In the Service account description field, enter a description. For example,

Service account for quickstart. - Click Create and continue.

-

Grant the following roles to the service account: roles/bigquery.user, roles/storage.objectAdmin, roles/iam.serviceAccountTokenCreator.

To grant a role, find the Select a role list, then select the role.

To grant additional roles, click Add another role and add each additional role.

- Click Continue.

-

Click Done to finish creating the service account.

Do not close your browser window. You will use it in the next step.

-

Ensure that you have the Create Service Accounts IAM role

(

-

Create a service account key:

- In the Google Cloud console, click the email address for the service account that you created.

- Click Keys.

- Click Add key, and then click Create new key.

- Click Create. A JSON key file is downloaded to your computer.

- Click Close.

- Logs Viewer (

roles/logging.viewer) - Storage Admin (

roles/storage.admin) o un rol personalizado que otorgue los siguientes permisos:storage.objects.createstorage.objects.getstorage.objects.list

- BigQuery Admin (

roles/bigquery.admin) o un rol personalizado que otorga los siguientes permisos:bigquery.datasets.createbigquery.jobs.createbigquery.jobs.getbigquery.jobs.listAllbigquery.transfers.getbigquery.transfers.update

- El agente de migración usa una conexión JDBC con la instancia de Teradata y las APIs de Google Cloud . Asegúrate de que un firewall no bloquee el acceso a la red.

- Asegúrate de tener instalado Java Runtime Environment 8 o una versión posterior.

- Asegúrate de tener suficiente espacio de almacenamiento para el método de extracción que elegiste, como se describe en Método de extracción.

- Si decidiste usar la extracción del Transportador paralelo de Teradata (TPT), asegúrate de que la utilidad

tbuildesté instalada. Para obtener más información sobre cómo elegir un método de extracción, consulta Método de extracción. Asegúrate de tener el nombre de usuario y la contraseña de un usuario de Teradata con acceso de lectura a las tablas del sistema y a las tablas que se están migrando.

Asegúrate de conocer el nombre de host y el número de puerto para conectarte a la instancia de Teradata.

client_emailprivate_key: Copia todos los caracteres dentro de-----BEGIN PRIVATE KEY-----y-----END PRIVATE KEY-----, incluidos todos los caracteres/ny sin las comillas dobles de cierre.ACCESS_ID: Es el ID de la clave de acceso o el valor declient_emailen el archivo de claves de tu cuenta de servicio.ACCESS_KEY: Es la clave de acceso secreta o el valor deprivate_keyen el archivo de claves de tu cuenta de servicio.En la consola de Google Cloud , ve a la página BigQuery.

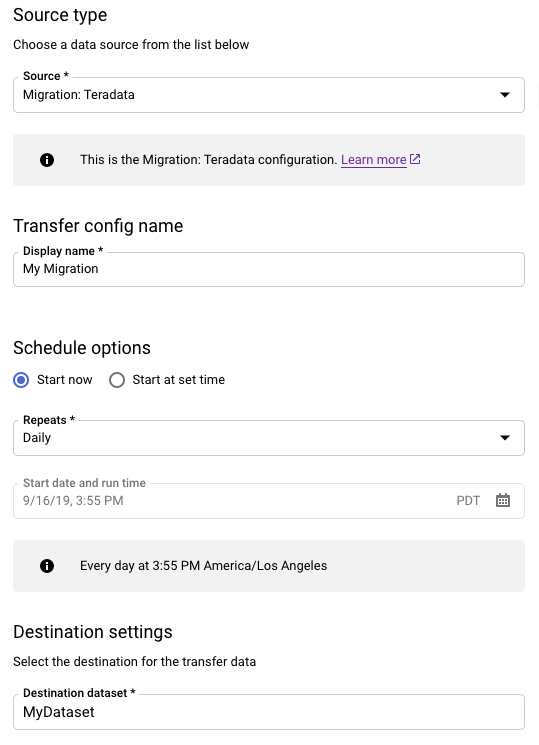

Haz clic en Transferencias de datos.

Haz clic en Crear transferencia.

En la sección Tipo de fuente, haz lo siguiente:

- Selecciona Migración: Teradata.

- En Nombre de la configuración de transferencia, ingresa un nombre para la transferencia, como

My Migration. El nombre visible puede ser cualquier valor que te permita identificarla con facilidad si es necesario hacerle modificaciones más tarde. - En Opciones de programa, puedes dejar el valor predeterminado Diario (según la hora de creación) o elegir otro momento si deseas una transferencia incremental recurrente. De lo contrario, elige Bajo demanda para una transferencia única.

En Configuración de destino, selecciona el conjunto de datos que corresponda.

En la sección Detalles de la fuente de datos, continúa configurando los detalles específicos para tu transferencia de Teradata.

- En Tipo de base de datos, elige Teradata.

- En Bucket de Cloud Storage, busca el nombre del bucket de Cloud Storage para la etapa de pruebas de los datos de migración. No escribas el prefijo

gs://; ingresa solo el nombre del bucket. - En Nombre de la base de datos, ingresa el nombre de la base de datos de origen en Teradata.

En Patrones de nombres de tabla, ingresa un patrón para hacer coincidir los nombres de tablas en la base de datos de origen. Puedes usar expresiones regulares para especificar el patrón. Por ejemplo:

sales|expensescoincide con las tablas llamadassalesyexpenses..*coincide con todas las tablas.

En Correo electrónico de la cuenta de servicio, ingresa la dirección de correo electrónico asociada con las credenciales de la cuenta de servicio que usa un agente de migración.

Opcional: En Ruta del archivo de esquema, ingresa la ruta y el nombre de un archivo de esquema personalizado. Para obtener más información sobre cómo crear un archivo de esquema personalizado, consulta Archivo de esquema personalizado. Puedes dejar este campo en blanco para que BigQuery detecte automáticamente el esquema de tu tabla de origen.

Opcional: En Directorio raíz de salida de la traducción, ingresa la ruta y el nombre del archivo de asignación de esquemas que proporciona el motor de traducción de BigQuery. Para obtener más información sobre cómo generar un archivo de asignación de esquema, consulta Usa el resultado del motor de traducción para el esquema (versión preliminar). Puedes dejar este campo en blanco para que BigQuery detecte automáticamente el esquema de tu tabla de origen.

Opcional: Para Habilitar la descarga directa en GCS, selecciona la casilla de verificación para habilitar el módulo de acceso para Cloud Storage.

En el menú Cuenta de servicio, selecciona una cuenta de servicio de las cuentas de servicio asociadas a tu Google Cloud proyecto. Puedes asociar una cuenta de servicio con tu transferencia en lugar de usar tus credenciales de usuario. Para obtener más información sobre cómo usar cuentas de servicio con transferencias de datos, consulta Usa cuentas de servicio.

- Si accediste con una identidad federada, se requiere una cuenta de servicio para crear una transferencia. Si accediste con una Cuenta de Google, la cuenta de servicio para la transferencia es opcional.

- La cuenta de servicio debe tener los permisos necesarios.

Opcional: En la sección Opciones de notificación, haz lo siguiente:

- Haz clic en el botón de activar o desactivar las Notificaciones por correo electrónico si deseas que el administrador de transferencias reciba una notificación por correo electrónico cuando falle una ejecución de transferencia.

- Haz clic en el botón de activar o desactivar las Notificaciones de Pub/Sub a fin de configurar las notificaciones de ejecución de Pub/Sub para tu transferencia. En Seleccionar un tema de Cloud Pub/Sub, elige el nombre de tu tema o haz clic en Crear un tema.

Haz clic en Guardar.

En la página Detalles de la transferencia, haz clic en la pestaña Configuración.

Toma nota del nombre del recurso de esta transferencia, ya que lo necesitarás para ejecutar el agente de migración.

--data_source--display_name--target_dataset--params- project ID es el ID del proyecto. Si no proporcionas

--project_idpara especificar un proyecto en particular, se usa el proyecto predeterminado. - dataset es el conjunto de datos al que deseas orientar (

--target_dataset) para la configuración de transferencia. - name es el nombre visible (

--display_name) de la configuración de transferencia. El nombre visible de la transferencia puede ser cualquier valor que te permita identificar la transferencia si necesitas modificarla más adelante. - service_account es el nombre de la cuenta de servicio que se usa para autenticar tu transferencia. La cuenta de servicio debe ser propiedad del mismo

project_idque se usa para crear la transferencia y debe tener todos los permisos necesarios enumerados. - parameters contiene los parámetros (

--params) para la configuración de la transferencia creada en formato JSON. Por ejemplo:--params='{"param":"param_value"}'.- Para las migraciones de Teradata, usa los siguientes parámetros:

bucketes el depósito de Cloud Storage que actuará como un área de etapa de pruebas durante la migración.database_typees Teradata.agent_service_accountes la dirección de correo electrónico asociada a la cuenta de servicio que creaste.database_namees el nombre de la base de datos de origen en Teradata.table_name_patternsson los patrones para hacer coincidir los nombres de las tablas en la base de datos de origen. Puedes usar expresiones regulares para especificar el patrón. El patrón debe seguir la sintaxis de la expresión regular de Java. Por ejemplo:sales|expensescoincide con las tablas llamadassalesyexpenses..*coincide con todas las tablas.

is_direct_gcs_unload_enabledes una marca booleana para habilitar la descarga directa en Cloud Storage.

- Para las migraciones de Teradata, usa los siguientes parámetros:

- data_source es la fuente de datos: (

--data_source):on_premises. Abre una sesión nueva. En la línea de comandos, ejecuta el comando de inicialización, que sigue este formato:

java -cp \ OS-specific-separated-paths-to-jars (JDBC and agent) \ com.google.cloud.bigquery.dms.Agent \ --initialize

En el siguiente ejemplo, se muestra el comando de inicialización cuando el controlador de JDBC y los archivos JAR del agente de migración se encuentran en un directorio

migrationlocal:Unix, Linux y Mac OS

java -cp \ /usr/local/migration/terajdbc4.jar:/usr/local/migration/mirroring-agent.jar \ com.google.cloud.bigquery.dms.Agent \ --initialize

Windows

Copia todos los archivos en la carpeta

C:\migration(o ajusta las rutas en el comando) y, luego, ejecuta lo siguiente:java -cp C:\migration\terajdbc4.jar;C:\migration\mirroring-agent.jar com.google.cloud.bigquery.dms.Agent --initialize

Cuando se te solicite, configura las siguientes opciones:

- Elige si deseas guardar la plantilla del Transportador paralelo de Teradata (TPT) en el disco. Si planeas usar el método de extracción de TPT, puedes modificar la plantilla guardada con parámetros que se ajusten a tu instancia de Teradata.

- Escribe la ruta de acceso a un directorio local que el trabajo de transferencia puede usar para la extracción de archivos. Asegúrate de tener el espacio de almacenamiento mínimo recomendado como se describe en Método de extracción.

- Escribe el nombre de host de la base de datos.

- Escribe el puerto de la base de datos.

- Elige si deseas usar el Transportador paralelo de Teradata (TPT) como método de extracción.

- Opcional: Escribe la ruta de acceso a un archivo de credenciales de la base de datos.

Elige si deseas especificar un nombre de configuración del Servicio de transferencia de datos de BigQuery.

Si estás inicializando el agente de migración para una transferencia que ya configuraste, haz lo siguiente:

- Escribe el Nombre del recurso de la transferencia. Puedes encontrarlo en la pestaña Configuración de la página Detalles de la transferencia.

- Cuando se te solicite, escribe una ruta de acceso y el nombre de archivo para el archivo de configuración del agente de migración que se creará. Haz referencia a este archivo cuando ejecutes el agente de migración para iniciar la transferencia.

- Omite los pasos restantes.

Si usas el agente de migración a fin de configurar una transferencia, presiona Intro para pasar al siguiente mensaje.

Escribe el Google Cloud ID del proyecto.

Ingresa el nombre de la base de datos de origen en Teradata.

Ingresa un patrón para hacer coincidir los nombres de tablas en la base de datos de origen. Puedes usar expresiones regulares para especificar el patrón. Por ejemplo:

sales|expensescoincide con las tablas llamadassalesyexpenses..*coincide con todas las tablas.

Opcional: Escribe la ruta de acceso a un archivo de esquema JSON local. Esto es muy recomendable para las transferencias recurrentes.

Si no usas un archivo de esquema o si deseas que el agente de migración cree uno por ti, presiona Intro para pasar al siguiente mensaje.

Elige si deseas crear un archivo de esquema nuevo.

Si deseas crear un archivo de esquema, haz lo siguiente:

- Tipo

yes. - Escribe el nombre de usuario de un usuario de Teradata que tenga acceso de lectura a las tablas del sistema y las tablas que deseas migrar.

Escribe la contraseña para ese usuario.

El agente de migración crea el archivo de esquema y muestra como resultado su ubicación.

Modifica el archivo de esquema con el fin de marcar las particiones, los clústeres, las claves primarias y las columnas de seguimiento de cambios, y también a fin de verificar que deseas usar este esquema para la configuración de transferencia. Consulta Archivo de esquema personalizado para obtener sugerencias.

Presiona

Enterpara pasar al siguiente mensaje.

Si no deseas crear un archivo de esquema, escribe

no.- Tipo

Escribe el nombre del bucket de destino de Cloud Storage para almacenar los datos de migración en etapa intermedia antes de cargarlos en BigQuery. Si hiciste que el agente de migración creara un archivo de esquema personalizado, también se subirá a este bucket.

Ingresa el nombre del conjunto de datos de destino en BigQuery.

Escribe un nombre visible para la configuración de transferencia.

Escribe una ruta de acceso y un nombre de archivo para el archivo de configuración del agente de migración que se creará.

Después de ingresar todos los parámetros solicitados, el agente de migración creará un archivo de configuración y lo enviará a la ruta local que especificaste. Consulta la siguiente sección para obtener más detalle del archivo de configuración.

transfer-configuration: Información sobre esta configuración de transferencia en BigQuery.teradata-config: Información específica para esta extracción de Teradata. En ella, se incluye lo siguiente:connection: Información sobre el nombre de host y el puerto.local-processing-space: La carpeta de extracción en la que el agente extraerá los datos de la tabla antes de subirla a Cloud Storage.database-credentials-file-path: (opcional) La ruta a un archivo que contiene credenciales para conectarse a la base de datos de Teradata de forma automática. El archivo debe contener dos líneas para las credenciales. Puedes usar un nombre de usuario y una contraseña, como se muestra en el siguiente ejemplo:username=abc password=123

username=abc secret_resource_id=projects/my-project/secrets/my-secret-name/versions/1

max-local-storage: La cantidad máxima de almacenamiento local que se usará para la extracción en el directorio de etapa de pruebas especificado. El valor predeterminado es50GB. El formato admitido esnumberKB|MB|GB|TB.En todos los modos de extracción, los archivos se borran de tu directorio de etapa de pruebas local después de que se suben a Cloud Storage.

use-tpt: Dirige el agente de migración para que use el Transportador paralelo de Teradata (TPT) como método de extracción.Para cada tabla, el agente de migración genera una secuencia de comandos de TPT, inicia un proceso

tbuildy espera a que se complete. Una vez que el procesotbuildse completa, el agente enumera y sube los archivos extraídos a Cloud Storage y, luego, borra la secuencia de comandos de TPT. Para obtener más información, consulta Método de extracción.transfer-views: Dirige el agente de migración para que también transfiera datos desde vistas. Usa esto solo cuando necesites personalizar los datos durante la migración. En otros casos, migra las vistas a las vistas de BigQuery. Esta opción tiene los siguientes requisitos previos:- Solo puedes usar esta opción con la versión 16.10 de Teradata o una superior.

- Una vista debe tener una columna de números enteros “particionada” que apunte a un ID de partición para la fila en cuestión de la tabla subyacente.

max-sessions: Especifica la cantidad máxima de sesiones que usa el trabajo de extracción (ya sea de FastExport o TPT). Si se establece en 0, la base de datos de Teradata determinará la cantidad máxima de sesiones para cada trabajo de extracción.gcs-upload-chunk-size: Se sube un archivo grande a Cloud Storage en fragmentos. Este parámetro, junto conmax-parallel-upload, se usa para controlar cuántos datos se suben a Cloud Storage al mismo tiempo. Por ejemplo, sigcs-upload-chunk-sizees 64 MB ymax-parallel-uploades 10 MB, en teoría, un agente de migración puede subir 640 MB (64 MB * 10) de datos al mismo tiempo. Si el fragmento no se sube, se debe reintentar todo el fragmento. El tamaño del fragmento debe ser pequeño.max-parallel-upload: Este valor determina la cantidad máxima de subprocesos que usa el agente de migración para subir archivos a Cloud Storage. Si no se especifica, se establece de forma predeterminada en la cantidad de procesadores disponibles para la máquina virtual de Java. La regla general es elegir el valor según la cantidad de núcleos que tienes en la máquina que ejecuta el agente. Por lo tanto, si tienesnnúcleos, la cantidad óptima de subprocesos debe sern. Si los núcleos tienen hipersubprocesos, la cantidad óptima debe ser(2 * n). También existen otras opciones de configuración, como el ancho de banda de red, que debes tener en cuenta cuando ajustasmax-parallel-upload. Ajustar este parámetro puede mejorar el rendimiento de las cargas a Cloud Storage.spool-mode: En la mayoría de los casos, el modo NoSpool es la mejor opción.NoSpooles el valor predeterminado en la configuración del agente. Puedes cambiar este parámetro si alguna de las desventajas de NoSpool se aplica a tu caso.max-unload-file-size: Determina el tamaño máximo del archivo extraído. Este parámetro no se aplica a las extracciones de TPT.max-parallel-extract-threads: Esta configuración solo se usa en el modo FastExport. Determina la cantidad de subprocesos paralelos que se usan para extraer los datos de Teradata. Ajustar este parámetro podría mejorar el rendimiento de la extracción.tpt-template-path: Usa esta configuración para proporcionar una secuencia de comandos de extracción de TPT personalizada como entrada. Puedes usar este parámetro para aplicar transformaciones a tus datos de migración.schema-mapping-rule-path: La ruta a un archivo de configuración que contiene una asignación de esquema para anular las reglas de asignación predeterminadas (opcional). Algunos tipos de asignación solo funcionan con el modo Transportador paralelo de Teradata (TPT).Ejemplo: Asignación del tipo

TIMESTAMPde Teradata al tipoDATETIMEde BigQuery:{ "rules": [ { "database": { "name": "database.*", "tables": [ { "name": "table.*" } ] }, "match": { "type": "COLUMN_TYPE", "value": "TIMESTAMP" }, "action": { "type": "MAPPING", "value": "DATETIME" } } ] }

Atributos:

database:namees una expresión regular para las bases de datos que se incluirán (opcional). Todas las bases de datos se incluyen de forma predeterminada.tables: Contiene un array de tablas (opcional).namees una expresión regular para las tablas que se incluirán. Todas las tablas se incluyen de forma predeterminada.match: (Obligatorio)- Valores admitidos de

type:COLUMN_TYPE - Valores admitidos de

value:TIMESTAMP,DATETIME

- Valores admitidos de

action: (Obligatorio)- Valores admitidos de

type:MAPPING - Valores admitidos de

value:TIMESTAMP,DATETIME

- Valores admitidos de

compress-output: (Opcional) determina si los datos deben comprimirse antes de almacenarse en Cloud Storage. Esto solo se aplica en modo tpt. De forma predeterminada, este valor esfalse.gcs-module-config-dir: (Opcional) Es la ruta de acceso al archivo de credenciales para acceder al bucket de Cloud Storage. El directorio predeterminado es$HOME/.gcs, pero puedes usar este parámetro para cambiarlo.gcs-module-connection-count: (Opcional) Especifica la cantidad de conexiones TCP al servicio de Cloud Storage. El valor predeterminado es 10.gcs-module-buffer-size: (Opcional) Especifica el tamaño de los búferes que se usarán para las conexiones TCP. El valor predeterminado es 8 MB (8,388,608 bytes). Para facilitar el uso, puedes usar los siguientes multiplicadores:k (1000)K (1024)m (1000 * 1000)M (1024*1024)

gcs-module-buffer-count: (Opcional) Especifica la cantidad de búferes que se usarán con las conexiones TCP especificadas porgcs-module-connection-count. Recomendamos usar un valor igual al doble de la cantidad de conexiones TCP al servicio de Cloud Storage. El valor predeterminado es 2 *gcs-module-connection-count.gcs-module-max-object-size: (Opcional) Este parámetro controla los tamaños de los objetos de Cloud Storage. El valor de este parámetro puede ser un número entero o un número entero seguido, sin un espacio, de uno de los siguientes multiplicadores:k (1000)K (1024)m (1000 * 1000)M (1024*1024)

gcs-module-writer-instances: (Opcional) Este parámetro especifica la cantidad de instancias de escritura de Cloud Storage. De forma predeterminada, el valor es 1. Puedes aumentar este valor para incrementar el rendimiento durante la fase de escritura de la exportación de TPT.

Para ejecutar el agente, especifica las rutas de acceso al controlador de JDBC, el agente de migración y el archivo de configuración que se creó en el paso de inicialización anterior.

java -cp \ OS-specific-separated-paths-to-jars (JDBC and agent) \ com.google.cloud.bigquery.dms.Agent \ --configuration-file=path to configuration file

Unix, Linux y Mac OS

java -cp \ /usr/local/migration/Teradata/JDBC/terajdbc4.jar:mirroring-agent.jar \ com.google.cloud.bigquery.dms.Agent \ --configuration-file=config.json

Windows

Copia todos los archivos en la carpeta

C:\migration(o ajusta las rutas en el comando) y, luego, ejecuta lo siguiente:java -cp C:\migration\terajdbc4.jar;C:\migration\mirroring-agent.jar com.google.cloud.bigquery.dms.Agent --configuration-file=config.json

Si estás listo para continuar con la migración, presiona

Enter, y el agente continuará si la ruta de clase proporcionada durante la inicialización es válida.Cuando se te solicite, ingresa el nombre de usuario y la contraseña para la conexión de la base de datos. Si el nombre de usuario y la contraseña son válidos, comenzará la migración de datos.

Opcional En el comando para iniciar la migración, también puedes usar una marca que pasa un archivo de credenciales al agente, en lugar de ingresar el nombre de usuario y contraseña cada vez. Consulta el parámetro opcional

database-credentials-file-pathen el archivo de configuración del agente para obtener más información. Cuando uses un archivo de credenciales, toma las medidas adecuadas para controlar el acceso a la carpeta en la que lo almacenas en el sistema de archivos local, ya que no se encriptará.Deja esta sesión abierta hasta que se complete la migración. Si creaste una transferencia de migración recurrente, mantén esta sesión abierta de manera indefinida. Si se interrumpe esta sesión, fallan las ejecuciones de transferencia actuales y futuras.

Supervisa periódicamente si el agente está en ejecución. Si una ejecución de transferencia está en curso y ningún agente responde en un plazo de 24 horas, la ejecución de transferencia falla.

Si el agente de migración deja de funcionar mientras la transferencia está en curso o programada, la consola de Google Cloud muestra el estado del error y te solicita que reinicies el agente. Si deseas volver a iniciar el agente de migración, continúa desde el principio de esta sección y ejecuta el agente de migración con el comando para ejecutar el agente de migración. No es necesario repetir el comando de inicialización. La transferencia se reanuda desde el momento en que las tablas no se completaron.

- Prueba una migración de prueba de Teradata a BigQuery.

- Obtén más información acerca del Servicio de transferencia de datos de BigQuery.

- Migra el código SQL con la traducción de SQL por lotes.

Establece los permisos necesarios

Asegúrate de que la cuenta principal que crea la transferencia tenga los siguientes roles en el proyecto que contiene el trabajo de transferencia:

Cree un conjunto de datos

Crea un conjunto de datos de BigQuery para almacenar tus datos. No es necesario crear ninguna tabla.

Cree un bucket de Cloud Storage

Crea un bucket de Cloud Storage para almacenar los datos en etapa intermedia durante el trabajo de transferencia.

Prepara el entorno local

Completa las tareas de esta sección a fin de preparar el entorno local para el trabajo de transferencia.

Requisitos de la máquina local

Detalles de la conexión de Teradata

Descarga el controlador de JDBC

Descarga el archivo del controlador de JDBC terajdbc4.jar de Teradata a una máquina que pueda conectarse al almacén de datos.

Configura la variable GOOGLE_APPLICATION_CREDENTIALS

Configura la variable de entorno GOOGLE_APPLICATION_CREDENTIALS con la clave de la cuenta de servicio que descargaste en la sección Antes de comenzar.

Actualiza la regla de salida de los Controles del servicio de VPC

Agrega un proyecto administrado Google Cloud de Servicio de transferencia de datos de BigQuery (número de proyecto: 990232121269) a laregla de salidaen el perímetro de los Controles del servicio de VPC.

El canal de comunicación entre el agente que se ejecuta de forma local y el Servicio de transferencia de datos de BigQuery es publicar mensajes de Pub/Sub en un tema de transferencia. El Servicio de transferencia de datos de BigQuery debe enviar comandos al agente para extraer datos, y el agente debe volver a publicar mensajes en ese servicio a fin de actualizar el estado y mostrar respuestas de extracción de datos.

Crea un archivo de esquema personalizado

Para usar un Archivo de esquema personalizado en lugar de la detección automática de esquemas, crea uno de forma manual o haz que el agente de migración cree uno por ti cuando inicialices el agente.

Si creas un archivo de esquema de forma manual y quieres usar la consola de Google Cloud para crear una transferencia, sube el archivo de esquema a un bucket de Cloud Storage en el mismo proyecto que planeas usar para la transferencia.

Descarga el agente de migración

Descarga el agente de migración a una máquina que pueda conectarse al almacén de datos. Mueve el archivo JAR del agente de migración al mismo directorio que el archivo JAR del controlador de JDBC de Teradata.

Configura el archivo de credenciales para el módulo de acceso

Se requiere un archivo de credenciales si usas el módulo de acceso para Cloud Storage con la utilidad Teradata Parallel Transporter (TPT) para la extracción.

Antes de crear un archivo de credenciales, debes crear una clave de cuenta de servicio. Obtén la siguiente información del archivo de claves de la cuenta de servicio que descargaste:

Una vez que tengas la información requerida, crea un archivo de credenciales. El siguiente es un ejemplo de un archivo de credenciales con una ubicación predeterminada de $HOME/.gcs/credentials:

[default] gcs_access_key_id = ACCESS_ID gcs_secret_access_key = ACCESS_KEY

Reemplaza lo siguiente:

Configura una transferencia

Crea una transferencia con el Servicio de transferencia de datos de BigQuery.

Si deseas que se cree automáticamente un archivo de esquema personalizado, usa el agente de migración para configurar la transferencia.

No puedes crear una transferencia a pedido con la herramienta de línea de comandos de bq; en su lugar, debes usar la Google Cloud consola o la API del Servicio de transferencia de datos de BigQuery.

Si creas una transferencia recurrente, te recomendamos que especifiques un archivo de esquema para que los datos de las transferencias posteriores puedan particionarse correctamente cuando se carguen en BigQuery. Sin un archivo de esquema, el Servicio de transferencia de datos de BigQuery infiere el esquema de la tabla desde los datos de origen que se transfieren, y se pierde toda la información sobre particiones, clústeres, claves primarias y el seguimiento de cambios. Además, las transferencias posteriores omiten las tablas migradas de forma previa después de la transferencia inicial. Para obtener más información sobre cómo crear un archivo de esquema, consulta Archivo de esquema personalizado.

Console

bq

Cuando creas una transferencia de Cloud Storage con la herramienta de bq, la configuración de transferencia se configura para que se repita cada 24 horas. Para las transferencias a pedido, usa la Google Cloud consola o la API del Servicio de transferencia de datos de BigQuery.

No puedes configurar las notificaciones con la herramienta de bq.

Ingresa el comando bq mk y suministra la marca de creación de transferencias --transfer_config. También se requieren las siguientes marcas:

bq mk \ --transfer_config \ --project_id=project ID \ --target_dataset=dataset \ --display_name=name \ --service_account_name=service_account \ --params='parameters' \ --data_source=data source

Donde:

Por ejemplo, el siguiente comando crea una transferencia de Teradata llamada My Transfer mediante el bucket de Cloud Storage mybucket y el conjunto de datos de destino mydataset. La transferencia migrará todas las tablas del almacén de datos mydatabase de Teradata y el archivo de esquema opcional es myschemafile.json.

bq mk \ --transfer_config \ --project_id=123456789876 \ --target_dataset=MyDataset \ --display_name='My Migration' \ --params='{"bucket": "mybucket", "database_type": "Teradata", "database_name":"mydatabase", "table_name_patterns": ".*", "agent_service_account":"myemail@mydomain.com", "schema_file_path": "gs://mybucket/myschemafile.json", "is_direct_gcs_unload_enabled": true}' \ --data_source=on_premises

Después de ejecutar el comando, recibirás un mensaje como el siguiente:

[URL omitted] Please copy and paste the above URL into your web browser and

follow the instructions to retrieve an authentication code.

Sigue las instrucciones y pega el código de autenticación en la línea de comandos.

API

Usa el método projects.locations.transferConfigs.create y suministra una instancia del recurso TransferConfig.

Java

Antes de probar este ejemplo, sigue las instrucciones de configuración para Java incluidas en la guía de inicio rápido de BigQuery sobre cómo usar bibliotecas cliente. Para obtener más información, consulta la documentación de referencia de la API de BigQuery para Java.

Para autenticarte en BigQuery, configura las credenciales predeterminadas de la aplicación. Si deseas obtener más información, consulta Configura la autenticación para bibliotecas cliente.

Agente de migración

De manera opcional, puedes configurar la transferencia directamente desde el agente de migración. Para obtener más información, consulta Inicializa el agente de migración.

Inicializa el agente de migración

Debes inicializar el agente de migración para una transferencia nueva. La inicialización es necesaria solo una vez para cada transferencia, ya sea recurrente o no. La inicialización solo configura el agente de migración; no inicia la transferencia.

Si vas a usar el agente de migración a fin de crear un archivo de esquema personalizado, asegúrate de tener un directorio que admita operaciones de escritura en tu directorio de trabajo con el mismo nombre que el proyecto que deseas usar para la transferencia. Aquí es donde el agente de migración crea el archivo de esquema.

Por ejemplo, si trabajas en /home y configuras la transferencia en el proyecto myProject, crea el directorio /home/myProject y asegúrate de que los usuarios puedan escribir en él.

Archivo de configuración del agente de migración

El archivo de configuración creado en el paso de inicialización es similar a este ejemplo:

{

"agent-id": "81f452cd-c931-426c-a0de-c62f726f6a6f",

"transfer-configuration": {

"project-id": "123456789876",

"location": "us",

"id": "61d7ab69-0000-2f6c-9b6c-14c14ef21038"

},

"source-type": "teradata",

"console-log": false,

"silent": false,

"teradata-config": {

"connection": {

"host": "localhost"

},

"local-processing-space": "extracted",

"database-credentials-file-path": "",

"max-local-storage": "50GB",

"gcs-upload-chunk-size": "32MB",

"use-tpt": true,

"transfer-views": false,

"max-sessions": 0,

"spool-mode": "NoSpool",

"max-parallel-upload": 4,

"max-parallel-extract-threads": 1,

"session-charset": "UTF8",

"max-unload-file-size": "2GB"

}

}

Opciones de trabajo de transferencia en el archivo de configuración del agente de migración

Ejecuta el agente de migración

Después de inicializar el agente de migración y crear el archivo de configuración, sigue estos pasos para ejecutar el agente y, luego, iniciar la migración:

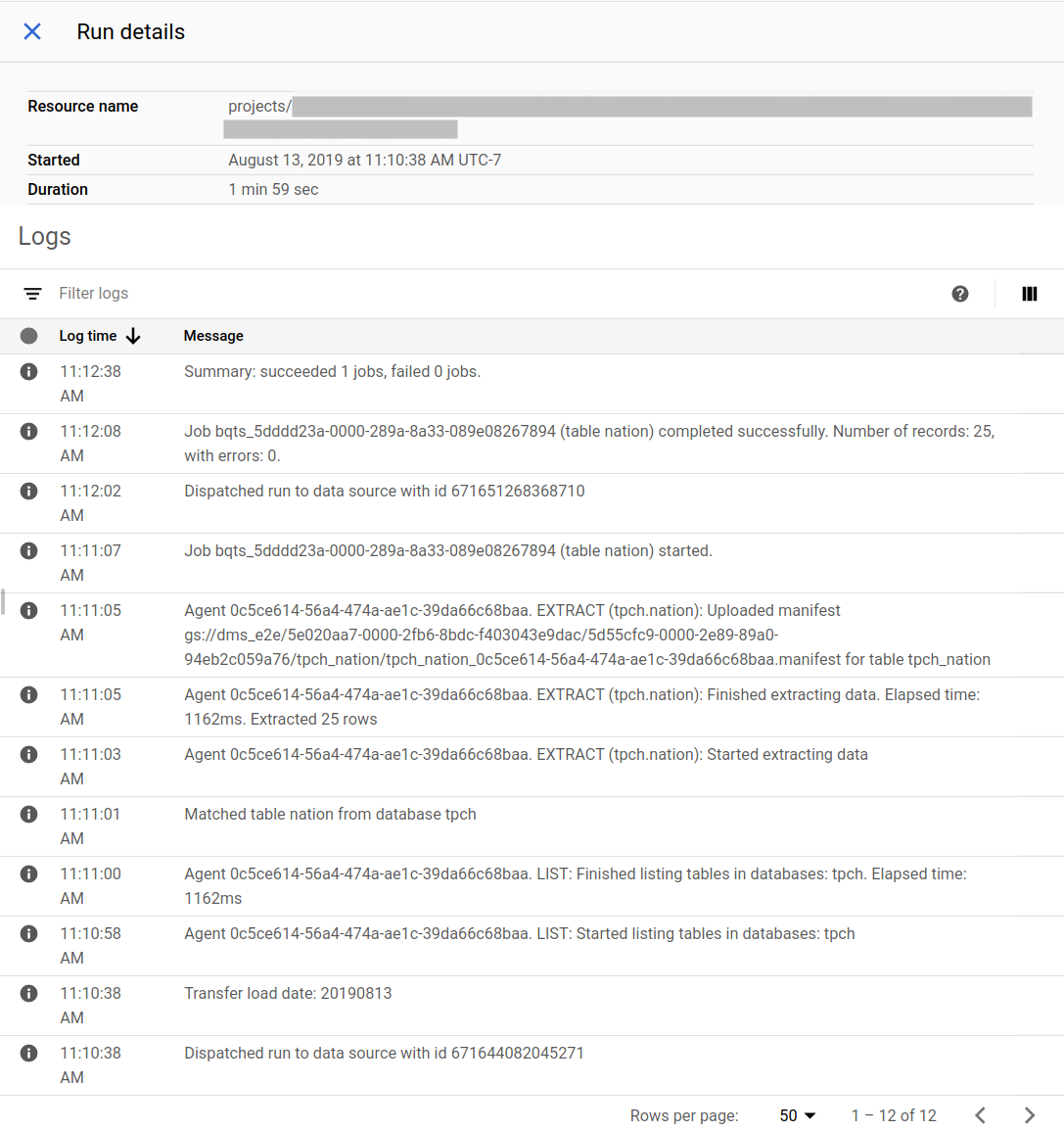

Realiza un seguimiento del progreso de la migración

Puedes ver el estado de la migración en la consola de Google Cloud . También puedes configurar notificaciones de Pub/Sub o correo electrónico. Consulta las notificaciones del Servicio de transferencia de datos de BigQuery.

El Servicio de transferencia de datos de BigQuery programa y, luego, inicia una ejecución de transferencia en función de un programa especificado durante la creación de la configuración de transferencia. Es importante que el agente de migración esté en ejecución cuando esté activa la ejecución de una transferencia. Si no hay actualizaciones del agente en un plazo de 24 horas, la ejecución de transferencia falla.

Ejemplo de estado de migración en la Google Cloud consola:

Actualiza el agente de migración

Si hay una versión nueva del agente de migración disponible, debes actualizar el agente de migración de forma manual. Para recibir avisos sobre el Servicio de transferencia de datos de BigQuery, suscríbete a las notas de la versión.