Evaluación de la migración

La evaluación de la migración a BigQuery te permite planificar y revisar la migración de tu almacén de datos a BigQuery. Puedes ejecutar la evaluación de migración de BigQuery para generar un informe que evalúe el coste de almacenar tus datos en BigQuery, ver cómo BigQuery puede optimizar tu carga de trabajo para ahorrar costes y preparar un plan de migración que describa el tiempo y el esfuerzo necesarios para completar la migración de tu almacén de datos a BigQuery.

En este documento se describe cómo usar la evaluación de la migración de BigQuery y las diferentes formas de revisar los resultados de la evaluación. Este documento está dirigido a usuarios que conocen la Google Cloud consola y el traductor de SQL por lotes.

Antes de empezar

Para preparar y ejecutar una evaluación de migración de BigQuery, sigue estos pasos:

Extrae metadatos y registros de consultas de tu almacén de datos con la herramienta

dwh-migration-dumper.Sube tus metadatos y registros de consultas a tu segmento de Cloud Storage.

Opcional: Consulta los resultados de la evaluación para obtener información detallada o específica sobre la evaluación.

Extraer metadatos y registros de consultas de tu almacén de datos

Para preparar la evaluación con recomendaciones, se necesitan tanto los metadatos como los registros de consultas.

Para extraer los metadatos y los registros de consultas necesarios para ejecutar la evaluación, selecciona tu almacén de datos:

Teradata

Requisitos

- Una máquina conectada a tu almacén de datos de Teradata de origen (se admiten las versiones 15 y posteriores de Teradata)

- Una cuenta de Google Cloud con un segmento de Cloud Storage para almacenar los datos

- Un conjunto de datos de BigQuery vacío para almacenar los resultados

- Permisos de lectura en el conjunto de datos para ver los resultados

- Recomendación: derechos de acceso de nivel de administrador a la base de datos de origen cuando se usa la herramienta de extracción para acceder a las tablas del sistema

Requisito: habilitar el registro

La herramienta dwh-migration-dumper extrae tres tipos de registros: registros de consultas, registros de utilidad y registros de uso de recursos. Para ver estadísticas más detalladas, debes habilitar el registro de los siguientes tipos de registros:

- Registros de consultas: extraídos de la vista

dbc.QryLogVy de la tabladbc.DBQLSqlTbl. Para habilitar el registro, especifica la opciónWITH SQL. - Registros de utilidad: extraídos de la tabla

dbc.DBQLUtilityTbl. Habilita el registro especificando la opciónWITH UTILITYINFO. - Registros de uso de recursos: extraídos de las tablas

dbc.ResUsageScpuydbc.ResUsageSpma. Habilita el registro RSS en estas dos tablas.

Ejecutar la herramienta dwh-migration-dumper

Descarga la herramienta dwh-migration-dumper.

Descarga el archivo SHA256SUMS.txt y ejecuta el siguiente comando para verificar que el archivo ZIP es correcto:

Bash

sha256sum --check SHA256SUMS.txt

Windows PowerShell

(Get-FileHash RELEASE_ZIP_FILENAME).Hash -eq ((Get-Content SHA256SUMS.txt) -Split " ")[0]

Sustituye RELEASE_ZIP_FILENAME por el nombre del archivo ZIP descargado de la versión de la herramienta de extracción de línea de comandos dwh-migration-dumper. Por ejemplo, dwh-migration-tools-v1.0.52.zip.

El resultado True confirma que la verificación de la suma de comprobación se ha realizado correctamente.

El resultado False indica que se ha producido un error de verificación. Asegúrate de que los archivos de suma de comprobación y ZIP se descarguen de la misma versión y se coloquen en el mismo directorio.

Para obtener información sobre cómo configurar y usar la herramienta de extracción, consulta el artículo Generar metadatos para la traducción y la evaluación.

Usa la herramienta de extracción para extraer los registros y los metadatos de tu almacén de datos de Teradata en dos archivos ZIP. Ejecuta los siguientes comandos en una máquina que tenga acceso al almacén de datos de origen para generar los archivos.

Genera el archivo ZIP de metadatos:

dwh-migration-dumper \ --connector teradata \ --database DATABASES \ --driver path/terajdbc4.jar \ --host HOST \ --assessment \ --user USER \ --password PASSWORD

Nota: La marca --database es opcional para el conector teradata. Si se omite, se extraerán los metadatos de todas las bases de datos. Esta marca solo es válida para el conector teradata

y no se puede usar con teradata-logs.

Genera el archivo ZIP que contiene los registros de consultas:

dwh-migration-dumper \ --connector teradata-logs \ --driver path/terajdbc4.jar \ --host HOST \ --assessment \ --user USER \ --password PASSWORD

Nota: La marca --database no se usa al extraer registros de consultas con el conector teradata-logs. Los registros de consultas siempre se extraen de todas las bases de datos.

Haz los cambios siguientes:

PATH: ruta absoluta o relativa al archivo JAR del controlador que se va a usar en esta conexión.VERSION: la versión de tu controladorHOST: la dirección del anfitriónUSER: nombre de usuario que se usará para la conexión a la base de datosDATABASES: (opcional) lista de nombres de bases de datos separados por comas que se van a extraer. Si no se proporciona, se extraerán todas las bases de datos.PASSWORD: (opcional) la contraseña que se usará para la conexión a la base de datos. Si se deja vacío, se le pedirá al usuario que introduzca su contraseña.

De forma predeterminada, los registros de consultas se extraen de la vista dbc.QryLogV y de la tabla dbc.DBQLSqlTbl. Si necesita extraer los registros de consultas de otra ubicación, puede especificar los nombres de las tablas o vistas mediante las marcas -Dteradata-logs.query-logs-table y -Dteradata-logs.sql-logs-table.

De forma predeterminada, los registros de la utilidad se extraen de la tabla

dbc.DBQLUtilityTbl. Si necesitas extraer los registros de utilidad de una ubicación alternativa, puedes especificar el nombre de la tabla con la marca -Dteradata-logs.utility-logs-table.

De forma predeterminada, los registros de uso de recursos se extraen de las tablas dbc.ResUsageScpu y dbc.ResUsageSpma. Si necesita extraer los registros de uso de recursos de una ubicación alternativa, puede especificar los nombres de las tablas mediante las marcas -Dteradata-logs.res-usage-scpu-table y -Dteradata-logs.res-usage-spma-table.

Por ejemplo:

Bash

dwh-migration-dumper \ --connector teradata-logs \ --driver path/terajdbc4.jar \ --host HOST \ --assessment \ --user USER \ --password PASSWORD \ -Dteradata-logs.query-logs-table=pdcrdata.QryLogV_hst \ -Dteradata-logs.sql-logs-table=pdcrdata.DBQLSqlTbl_hst \ -Dteradata-logs.log-date-column=LogDate \ -Dteradata-logs.utility-logs-table=pdcrdata.DBQLUtilityTbl_hst \ -Dteradata-logs.res-usage-scpu-table=pdcrdata.ResUsageScpu_hst \ -Dteradata-logs.res-usage-spma-table=pdcrdata.ResUsageSpma_hst

Windows PowerShell

dwh-migration-dumper ` --connector teradata-logs ` --driver path\terajdbc4.jar ` --host HOST ` --assessment ` --user USER ` --password PASSWORD ` "-Dteradata-logs.query-logs-table=pdcrdata.QryLogV_hst" ` "-Dteradata-logs.sql-logs-table=pdcrdata.DBQLSqlTbl_hst" ` "-Dteradata-logs.log-date-column=LogDate" ` "-Dteradata-logs.utility-logs-table=pdcrdata.DBQLUtilityTbl_hst" ` "-Dteradata-logs.res-usage-scpu-table=pdcrdata.ResUsageScpu_hst" ` "-Dteradata-logs.res-usage-spma-table=pdcrdata.ResUsageSpma_hst"

De forma predeterminada, la herramienta dwh-migration-dumper extrae los registros de consultas de los últimos siete días.

Google recomienda que proporcione al menos dos semanas de registros de consultas para poder ver estadísticas más detalladas. Puede especificar un intervalo de tiempo personalizado mediante las marcas --query-log-start y --query-log-end. Por ejemplo:

dwh-migration-dumper \ --connector teradata-logs \ --driver path/terajdbc4.jar \ --host HOST \ --assessment \ --user USER \ --password PASSWORD \ --query-log-start "2023-01-01 00:00:00" \ --query-log-end "2023-01-15 00:00:00"

También puedes generar varios archivos zip que contengan registros de consultas de diferentes periodos y proporcionarlos todos para que se evalúen.

Redshift

Requisitos

- Una máquina conectada a tu almacén de datos de Amazon Redshift de origen

- Una cuenta de Google Cloud con un segmento de Cloud Storage para almacenar los datos

- Un conjunto de datos de BigQuery vacío para almacenar los resultados

- Permisos de lectura en el conjunto de datos para ver los resultados

- Recomendación: acceso de superusuario a la base de datos al usar la herramienta de extracción para acceder a las tablas del sistema

Ejecutar la herramienta dwh-migration-dumper

Descarga la herramienta de extracción de línea de comandos dwh-migration-dumper.

Descarga el archivo SHA256SUMS.txt y ejecuta el siguiente comando para verificar que el archivo ZIP es correcto:

Bash

sha256sum --check SHA256SUMS.txt

Windows PowerShell

(Get-FileHash RELEASE_ZIP_FILENAME).Hash -eq ((Get-Content SHA256SUMS.txt) -Split " ")[0]

Sustituye RELEASE_ZIP_FILENAME por el nombre del archivo ZIP descargado de la versión de la herramienta de extracción de línea de comandos dwh-migration-dumper. Por ejemplo, dwh-migration-tools-v1.0.52.zip.

El resultado True confirma que la verificación de la suma de comprobación se ha realizado correctamente.

El resultado False indica que se ha producido un error de verificación. Asegúrate de que los archivos de suma de comprobación y ZIP se descarguen de la misma versión y se coloquen en el mismo directorio.

Para obtener información sobre cómo usar la herramienta dwh-migration-dumper, consulta la página Generar metadatos.

Utilice la herramienta dwh-migration-dumper para extraer los registros y los metadatos de su almacén de datos de Amazon Redshift en dos archivos ZIP.

Ejecuta los siguientes comandos en una máquina que tenga acceso al almacén de datos de origen para generar los archivos.

Genera el archivo ZIP de metadatos:

dwh-migration-dumper \ --connector redshift \ --database DATABASE \ --driver PATH/redshift-jdbc42-VERSION.jar \ --host host.region.redshift.amazonaws.com \ --assessment \ --user USER \ --iam-profile IAM_PROFILE_NAME

Genera el archivo ZIP que contiene los registros de consultas:

dwh-migration-dumper \ --connector redshift-raw-logs \ --database DATABASE \ --driver PATH/redshift-jdbc42-VERSION.jar \ --host host.region.redshift.amazonaws.com \ --assessment \ --user USER \ --iam-profile IAM_PROFILE_NAME

Haz los cambios siguientes:

DATABASE: el nombre de la base de datos a la que se va a conectarPATH: ruta absoluta o relativa al archivo JAR del controlador que se va a usar en esta conexión.VERSION: la versión de tu controladorUSER: nombre de usuario que se usará para la conexión a la base de datosIAM_PROFILE_NAME: el nombre del perfil de gestión de identidades y accesos de Amazon Redshift. Obligatorio para la autenticación de Amazon Redshift y para el acceso a la API de AWS. Para obtener la descripción de los clústeres de Amazon Redshift, usa la API de AWS.

De forma predeterminada, Amazon Redshift almacena entre tres y cinco días de registros de consultas.

De forma predeterminada, la herramienta dwh-migration-dumper extrae los registros de consultas de los últimos siete días.

Google recomienda que proporcione registros de consultas de al menos dos semanas para poder ver estadísticas más detalladas. Es posible que tengas que ejecutar la herramienta de extracción varias veces a lo largo de dos semanas para obtener los mejores resultados. Puedes especificar un intervalo personalizado con las marcas --query-log-start y --query-log-end.

Por ejemplo:

dwh-migration-dumper \ --connector redshift-raw-logs \ --database DATABASE \ --driver PATH/redshift-jdbc42-VERSION.jar \ --host host.region.redshift.amazonaws.com \ --assessment \ --user USER \ --iam-profile IAM_PROFILE_NAME \ --query-log-start "2023-01-01 00:00:00" \ --query-log-end "2023-01-02 00:00:00"

También puedes generar varios archivos zip que contengan registros de consultas de diferentes periodos y proporcionarlos todos para que se evalúen.

Redshift Serverless

Requisitos

- Una máquina conectada a tu almacén de datos de Amazon Redshift Serverless de origen

- Una cuenta de Google Cloud con un segmento de Cloud Storage para almacenar los datos

- Un conjunto de datos de BigQuery vacío para almacenar los resultados

- Permisos de lectura en el conjunto de datos para ver los resultados

- Recomendación: acceso de superusuario a la base de datos al usar la herramienta de extracción para acceder a las tablas del sistema

Ejecutar la herramienta dwh-migration-dumper

Descarga la herramienta de extracción de línea de comandos dwh-migration-dumper.

Para obtener más información sobre cómo usar la herramienta dwh-migration-dumper, consulta la página Generar metadatos.

Usa la herramienta dwh-migration-dumper para extraer los registros de uso y los metadatos de tu espacio de nombres sin servidor de Amazon Redshift en dos archivos ZIP. Ejecuta los siguientes comandos en una máquina con acceso al almacén de datos de origen para generar los archivos.

Genera el archivo ZIP de metadatos:

dwh-migration-dumper \ --connector redshift \ --database DATABASE \ --driver PATH/redshift-jdbc42-VERSION.jar \ --host host.region.redshift-serverless.amazonaws.com \ --assessment \ --user USER \ --iam-profile IAM_PROFILE_NAME

Genera el archivo ZIP que contiene los registros de consultas:

dwh-migration-dumper \ --connector redshift-serverless-logs \ --database DATABASE \ --driver PATH/redshift-jdbc42-VERSION.jar \ --host host.region.redshift-serverless.amazonaws.com \ --assessment \ --user USER \ --iam-profile IAM_PROFILE_NAME

Haz los cambios siguientes:

DATABASE: el nombre de la base de datos a la que se va a conectarPATH: ruta absoluta o relativa al archivo JAR del controlador que se va a usar en esta conexión.VERSION: la versión de tu controladorUSER: nombre de usuario que se usará para la conexión a la base de datosIAM_PROFILE_NAME: el nombre del perfil de gestión de identidades y accesos de Amazon Redshift. Obligatorio para la autenticación de Amazon Redshift y para el acceso a la API de AWS. Para obtener la descripción de los clústeres de Amazon Redshift, usa la API de AWS.

Amazon Redshift Serverless almacena los registros de uso durante siete días. Si se necesita un intervalo más amplio, Google recomienda extraer los datos varias veces durante un periodo más largo.

Snowflake

Requisitos

Para extraer metadatos y consultar registros de Snowflake, debes cumplir los siguientes requisitos:

- Una máquina que pueda conectarse a tus instancias de Snowflake.

- Una Google Cloud cuenta con un segmento de Cloud Storage para almacenar los datos.

- Un conjunto de datos de BigQuery vacío para almacenar los resultados. También puedes crear un conjunto de datos de BigQuery cuando crees el trabajo de evaluación mediante la interfaz de usuario de la consola de Google Cloud .

- Usuario de Snowflake con acceso

IMPORTED PRIVILEGESa la base de datosSnowflake. Te recomendamos que crees un usuarioSERVICEcon una autenticación basada en un par de claves. De esta forma, se proporciona un método seguro para acceder a la plataforma de datos de Snowflake sin necesidad de generar tokens de MFA.- Para crear un usuario de servicio, sigue la guía oficial de Snowflake. Deberá generar el par de claves RSA y asignar la clave pública al usuario de Snowflake.

- El usuario del servicio debe tener el rol

ACCOUNTADMINo tener un rol asignado con los privilegiosIMPORTED PRIVILEGESen la base de datosSnowflakepor un administrador de la cuenta. - Como alternativa a la autenticación con pares de claves, puedes usar la autenticación basada en contraseñas. Sin embargo, a partir de agosto del 2025, Snowflake exigirá la MFA a todos los usuarios que utilicen contraseñas. Para ello, debes aprobar la notificación push de MFA cuando utilices nuestra herramienta de extracción.

Ejecutar la herramienta dwh-migration-dumper

Descarga la herramienta de extracción de línea de comandos dwh-migration-dumper.

Descarga el archivo SHA256SUMS.txt y ejecuta el siguiente comando para verificar que el archivo ZIP es correcto:

Bash

sha256sum --check SHA256SUMS.txt

Windows PowerShell

(Get-FileHash RELEASE_ZIP_FILENAME).Hash -eq ((Get-Content SHA256SUMS.txt) -Split " ")[0]

Sustituye RELEASE_ZIP_FILENAME por el nombre del archivo ZIP descargado de la versión de la herramienta de extracción de línea de comandos dwh-migration-dumper. Por ejemplo, dwh-migration-tools-v1.0.52.zip.

El resultado True confirma que la verificación de la suma de comprobación se ha realizado correctamente.

El resultado False indica que se ha producido un error de verificación. Asegúrate de que los archivos de suma de comprobación y ZIP se descarguen de la misma versión y se coloquen en el mismo directorio.

Para obtener información sobre cómo usar la herramienta dwh-migration-dumper, consulta la página Generar metadatos.

Usa la herramienta dwh-migration-dumper para extraer registros y metadatos de tu almacén de datos de Snowflake en dos archivos ZIP. Ejecuta los siguientes comandos en una máquina con acceso al almacén de datos de origen para generar los archivos.

Genera el archivo ZIP de metadatos:

dwh-migration-dumper \ --connector snowflake \ --host HOST_NAME \ --user USER_NAME \ --role ROLE_NAME \ --warehouse WAREHOUSE \ --assessment \ --private-key-file PRIVATE_KEY_PATH \ --private-key-password PRIVATE_KEY_PASSWORD

Genera el archivo ZIP que contiene los registros de consultas:

dwh-migration-dumper \ --connector snowflake-logs \ --host HOST_NAME \ --user USER_NAME \ --role ROLE_NAME \ --warehouse WAREHOUSE \ --query-log-start STARTING_DATE \ --query-log-end ENDING_DATE \ --assessment \ --private-key-file PRIVATE_KEY_PATH \ --private-key-password PRIVATE_KEY_PASSWORD

Haz los cambios siguientes:

HOST_NAME: el nombre de host de tu instancia de Snowflake.USER_NAME: nombre de usuario que se usará para la conexión a la base de datos. El usuario debe tener los permisos de acceso que se detallan en la sección de requisitos.PRIVATE_KEY_PATH: la ruta a la clave privada RSA que se usa para la autenticación.PRIVATE_KEY_PASSWORD: (opcional) la contraseña que se usó al crear la clave privada RSA. Solo es obligatorio si la clave privada está cifrada.ROLE_NAME: (opcional) el rol de usuario al ejecutar la herramientadwh-migration-dumper. Por ejemplo,ACCOUNTADMIN.WAREHOUSE: el almacén que se usa para ejecutar las operaciones de volcado. Si tiene varios almacenes virtuales, puede especificar cualquiera de ellos para ejecutar esta consulta. Si ejecutas esta consulta con los permisos de acceso que se detallan en la sección de requisitos, se extraerán todos los artefactos del almacén de esta cuenta.STARTING_DATE: (opcional) se usa para indicar la fecha de inicio de un periodo de registros de consultas, escrita en el formatoYYYY-MM-DD.ENDING_DATE: (opcional) se usa para indicar la fecha de finalización de un periodo de registros de consultas, escrita en el formatoYYYY-MM-DD.

También puedes generar varios archivos zip que contengan registros de consultas de periodos que no se solapen y proporcionarlos todos para que se evalúen.

Oracle

Para solicitar comentarios o asistencia sobre esta función, envía un correo a bq-edw-migration-support@google.com.

Requisitos

Para extraer metadatos y consultar registros de Oracle, debes cumplir los siguientes requisitos:

- Tu base de datos Oracle debe tener la versión 11g R1 o una posterior.

- Una máquina que pueda conectarse a tus instancias de Oracle.

- Java 8 o una versión posterior.

- Una Google Cloud cuenta con un segmento de Cloud Storage para almacenar los datos.

- Un conjunto de datos de BigQuery vacío para almacenar los resultados. También puedes crear un conjunto de datos de BigQuery cuando crees el trabajo de evaluación mediante la interfaz de usuario de la consola de Google Cloud .

- Un usuario común de Oracle con privilegios SYSDBA.

Ejecutar la herramienta dwh-migration-dumper

Descarga la herramienta de extracción de línea de comandos dwh-migration-dumper.

Descarga el archivo SHA256SUMS.txt y ejecuta el siguiente comando para verificar que el archivo ZIP es correcto:

sha256sum --check SHA256SUMS.txt

Para obtener información sobre cómo usar la herramienta dwh-migration-dumper, consulta la página Generar metadatos.

Usa la herramienta dwh-migration-dumper para extraer metadatos y estadísticas de rendimiento en el archivo ZIP. De forma predeterminada, las estadísticas se extraen de Oracle AWR, que requiere Oracle Tuning and Diagnostics Pack. Si estos datos no están disponibles, dwh-migration-dumper usa STATSPACK en su lugar.

En las bases de datos multiinquilino, la herramienta dwh-migration-dumper debe ejecutarse en el contenedor raíz. Si lo ejecutas en una de las bases de datos conectables, faltarán estadísticas de rendimiento y metadatos sobre otras bases de datos conectables.

Genera el archivo ZIP de metadatos:

dwh-migration-dumper \ --connector oracle-stats \ --host HOST_NAME \ --port PORT \ --oracle-service SERVICE_NAME \ --assessment \ --driver JDBC_DRIVER_PATH \ --user USER_NAME \ --password

Haz los cambios siguientes:

HOST_NAME: el nombre de host de tu instancia de Oracle.PORT: número de puerto de conexión. El valor predeterminado es 1521.SERVICE_NAME: el nombre del servicio de Oracle que se va a usar para la conexión.JDBC_DRIVER_PATH: ruta absoluta o relativa al archivo JAR del controlador. Puedes descargar este archivo desde la página de descargas del controlador JDBC de Oracle. Debes seleccionar la versión del controlador que sea compatible con la versión de tu base de datos.USER_NAME: nombre del usuario que se usa para conectarse a tu instancia de Oracle. El usuario debe tener los permisos de acceso que se detallan en la sección de requisitos.

Hadoop/Cloudera

Para solicitar comentarios o asistencia sobre esta función, envía un correo a bq-edw-migration-support@google.com.

Requisitos

Para extraer metadatos de Cloudera, debe tener lo siguiente:

- Una máquina que pueda conectarse a la API de Cloudera Manager.

- Una Google Cloud cuenta con un segmento de Cloud Storage para almacenar los datos.

- Un conjunto de datos de BigQuery vacío para almacenar los resultados. También puede crear un conjunto de datos de BigQuery al crear el trabajo de evaluación.

Ejecutar la herramienta dwh-migration-dumper

Descarga la herramienta de extracción de línea de comandos

dwh-migration-dumper.Descarga el archivo

SHA256SUMS.txt.En tu entorno de línea de comandos, comprueba que el archivo ZIP sea correcto:

sha256sum --check SHA256SUMS.txt

Para obtener información sobre cómo usar la herramienta

dwh-migration-dumper, consulta el artículo Generar metadatos para la traducción y la evaluación.Usa la herramienta

dwh-migration-dumperpara extraer metadatos y estadísticas de rendimiento en el archivo ZIP:dwh-migration-dumper \ --connector cloudera-manager \ --user USER_NAME \ --password PASSWORD \ --url URL_PATH \ --yarn-application-types "APP_TYPES" \ --pagination-page-size PAGE_SIZE \ --start-date START_DATE \ --end-date END_DATE \ --assessment

Haz los cambios siguientes:

USER_NAME: el nombre del usuario que se conectará a tu instancia de Cloudera Manager.PASSWORD: la contraseña de tu instancia de Cloudera Manager.URL_PATH: la ruta de la URL de la API de Cloudera Manager. Por ejemplo,https://localhost:7183/api/v55/.APP_TYPES(opcional): los tipos de aplicaciones de YARN separados por comas que se han volcado del clúster. El valor predeterminado esMAPREDUCE,SPARK,Oozie Launcher.PAGE_SIZE(opcional): número de registros por respuesta de Cloudera. El valor predeterminado es1000.START_DATE(opcional): fecha de inicio del volcado del historial en formato ISO 8601. Por ejemplo,2025-05-29. El valor predeterminado es 90 días antes de la fecha actual.END_DATE(opcional): fecha de finalización del volcado del historial en formato ISO 8601. Por ejemplo,2025-05-30. El valor predeterminado es la fecha actual.

Usar Oozie en un clúster de Cloudera

Si usas Oozie en tu clúster de Cloudera, puedes volcar el historial de tareas de Oozie con el conector de Oozie. Puedes usar Oozie con la autenticación Kerberos o la autenticación básica.

Para la autenticación de Kerberos, ejecuta lo siguiente:

kinit dwh-migration-dumper \ --connector oozie \ --url URL_PATH \ --assessment

Haz los cambios siguientes:

URL_PATH(opcional): la ruta de la URL del servidor de Oozie. Si no especifica la ruta de la URL, se toma de la variable de entornoOOZIE_URL.

Para la autenticación básica, ejecuta lo siguiente:

dwh-migration-dumper \ --connector oozie \ --user USER_NAME \ --password PASSWORD \ --url URL_PATH \ --assessment

Haz los cambios siguientes:

USER_NAME: nombre del usuario de Oozie.PASSWORD: la contraseña del usuario.URL_PATH(opcional): la ruta de la URL del servidor de Oozie. Si no especifica la ruta de la URL, se toma de la variable de entornoOOZIE_URL.

Usar Airflow en un clúster de Cloudera

Si usas Airflow en tu clúster de Cloudera, puedes volcar el historial de DAGs con el conector de Airflow:

dwh-migration-dumper \ --connector airflow \ --user USER_NAME \ --password PASSWORD \ --url URL \ --driver "DRIVER_PATH" \ --start-date START_DATE \ --end-date END_DATE \ --assessment

Haz los cambios siguientes:

USER_NAME: nombre del usuario de AirflowPASSWORD: la contraseña del usuarioURL: la cadena JDBC de la base de datos de Airflow.DRIVER_PATH: la ruta al controlador JDBCSTART_DATE(opcional): fecha de inicio del volcado del historial en formato ISO 8601.END_DATE(opcional): fecha de finalización del volcado del historial en formato ISO 8601

Usar Hive en un clúster de Cloudera

Para usar el conector de Hive, consulta la pestaña Apache Hive.

Apache Hive

Requisitos

- Una máquina conectada a tu almacén de datos de Apache Hive de origen (la evaluación de la migración a BigQuery admite Hive en Tez y MapReduce, así como las versiones de Apache Hive entre la 2.2 y la 3.1, ambas incluidas)

- Una cuenta de Google Cloud con un segmento de Cloud Storage para almacenar los datos

- Un conjunto de datos de BigQuery vacío para almacenar los resultados

- Permisos de lectura en el conjunto de datos para ver los resultados

- Acceso a tu almacén de datos de Apache Hive de origen para configurar la extracción de registros de consultas

- Estadísticas actualizadas de tablas, particiones y columnas

La evaluación de la migración de BigQuery usa estadísticas de tablas, particiones y columnas para comprender mejor tu almacén de datos de Apache Hive y ofrecerte información detallada. Si el ajuste de configuración hive.stats.autogather está definido como false en tu almacén de datos de Apache Hive de origen, Google recomienda habilitarlo o actualizar las estadísticas manualmente antes de ejecutar la herramienta dwh-migration-dumper.

Ejecutar la herramienta dwh-migration-dumper

Descarga la herramienta de extracción de línea de comandos dwh-migration-dumper.

Descarga el archivo SHA256SUMS.txt y ejecuta el siguiente comando para verificar que el archivo ZIP es correcto:

Bash

sha256sum --check SHA256SUMS.txt

Windows PowerShell

(Get-FileHash RELEASE_ZIP_FILENAME).Hash -eq ((Get-Content SHA256SUMS.txt) -Split " ")[0]

Sustituye RELEASE_ZIP_FILENAME por el nombre del archivo ZIP descargado de la versión de la herramienta de extracción de línea de comandos dwh-migration-dumper. Por ejemplo, dwh-migration-tools-v1.0.52.zip.

El resultado True confirma que la verificación de la suma de comprobación se ha realizado correctamente.

El resultado False indica que se ha producido un error de verificación. Asegúrate de que los archivos de suma de comprobación y ZIP se descarguen de la misma versión y se coloquen en el mismo directorio.

Para obtener información sobre cómo usar la herramienta dwh-migration-dumper, consulta el artículo Generar metadatos para la traducción y la evaluación.

Usa la herramienta dwh-migration-dumper para generar metadatos de tu almacén de datos de Hive como archivo ZIP.

Sin autenticación

Para generar el archivo ZIP de metadatos, ejecuta el siguiente comando en una máquina que tenga acceso al almacén de datos de origen:

dwh-migration-dumper \ --connector hiveql \ --database DATABASES \ --host hive.cluster.host \ --port 9083 \ --assessment

Con la autenticación Kerberos

Para autenticarte en el metastore, inicia sesión como usuario que tenga acceso al metastore de Apache Hive y genera un ticket de Kerberos. A continuación, genera el archivo ZIP de metadatos con el siguiente comando:

JAVA_OPTS="-Djavax.security.auth.useSubjectCredsOnly=false" \ dwh-migration-dumper \ --connector hiveql \ --database DATABASES \ --host hive.cluster.host \ --port 9083 \ --hive-kerberos-url PRINCIPAL/HOST \ -Dhiveql.rpc.protection=hadoop.rpc.protection \ --assessment

Haz los cambios siguientes:

DATABASES: lista de nombres de bases de datos separados por comas que se van a extraer. Si no se proporciona, se extraerán todas las bases de datos.PRINCIPAL: el principal de Kerberos al que se emite el ticketHOST: el nombre de host de Kerberos al que se emite el ticket.hadoop.rpc.protection: la calidad de protección (QOP) del nivel de configuración de la capa de autenticación y seguridad simple (SASL), igual al valor del parámetrohadoop.rpc.protectiondel archivo/etc/hadoop/conf/core-site.xml, con uno de los siguientes valores:authenticationintegrityprivacy

Extraer registros de consultas con el hook de registro hadoop-migration-assessment

Para extraer los registros de consultas, sigue estos pasos:

- Suba el

hadoop-migration-assessmentgancho de registro. - Configura las propiedades del hook de registro.

- Verifica el hook de registro.

Subir el hook de registro hadoop-migration-assessment

Descarga el

hadoop-migration-assessmenthook de registro de extracción de registros de consultas que contiene el archivo JAR del hook de registro de Hive.Extrae el archivo JAR.

Si necesitas auditar la herramienta para asegurarte de que cumple los requisitos, revisa el código fuente del

hadoop-migration-assessmentrepositorio de GitHub del hook de registro y compila tu propio archivo binario.Copia el archivo JAR en la carpeta de bibliotecas auxiliares de todos los clústeres en los que quieras habilitar el registro de consultas. En función de tu proveedor, debes buscar la carpeta de biblioteca auxiliar en la configuración del clúster y transferir el archivo JAR a la carpeta de biblioteca auxiliar del clúster de Hive.

Configura las propiedades de configuración del hook de registro de

hadoop-migration-assessment. En función de tu proveedor de Hadoop, tendrás que usar la consola de la interfaz de usuario para editar la configuración del clúster. Modifica el archivo/etc/hive/conf/hive-site.xmlo aplica la configuración con el gestor de configuración.

Configurar propiedades

Si ya tiene otros valores para las siguientes claves de configuración, añada los ajustes con una coma (,). Para configurar el hook de registro de hadoop-migration-assessment, se necesitan los siguientes ajustes de configuración:

hive.exec.failure.hooks:com.google.cloud.bigquery.dwhassessment.hooks.MigrationAssessmentLoggingHookhive.exec.post.hooks:com.google.cloud.bigquery.dwhassessment.hooks.MigrationAssessmentLoggingHookhive.exec.pre.hooks:com.google.cloud.bigquery.dwhassessment.hooks.MigrationAssessmentLoggingHookhive.aux.jars.path: incluye la ruta al archivo JAR del hook de registro, por ejemplo,file://./HiveMigrationAssessmentQueryLogsHooks_deploy.jar dwhassessment.hook.base-directory: ruta a la carpeta de salida de los registros de consultas. Por ejemplo,hdfs://tmp/logs/.También puedes definir las siguientes configuraciones opcionales:

dwhassessment.hook.queue.capacity: capacidad de la cola de los hilos de registro de eventos de consulta. El valor predeterminado es64.dwhassessment.hook.rollover-interval: la frecuencia con la que se debe realizar la rotación del archivo. Por ejemplo,600s. El valor predeterminado es de 3600 segundos (1 hora).dwhassessment.hook.rollover-eligibility-check-interval: frecuencia con la que se activa en segundo plano la comprobación de si se cumplen los requisitos para la rotación de archivos. Por ejemplo,600s. El valor predeterminado es 600 segundos (10 minutos).

Verificar el hook de registro

Después de reiniciar el proceso de hive-server2, ejecuta una consulta de prueba y analiza los registros de depuración. Puede que veas el siguiente mensaje:

Logger successfully started, waiting for query events. Log directory is '[dwhassessment.hook.base-directory value]'; rollover interval is '60' minutes; rollover eligibility check is '10' minutes

El hook de registro crea una subcarpeta con particiones por fecha en la carpeta configurada. El archivo Avro con los eventos de consulta aparece en esa carpeta después del intervalo dwhassessment.hook.rollover-interval o de la finalización del proceso hive-server2. Puedes buscar mensajes similares en tus registros de depuración para ver el estado de la operación de rollover:

Updated rollover time for logger ID 'my_logger_id' to '2023-12-25T10:15:30'

Performed rollover check for logger ID 'my_logger_id'. Expected rollover time is '2023-12-25T10:15:30'

La renovación se produce en los intervalos especificados o cuando cambia el día. Cuando cambia la fecha, el gancho de registro también crea una subcarpeta para esa fecha.

Google recomienda que proporcione al menos dos semanas de registros de consultas para poder ver estadísticas más detalladas.

También puedes generar carpetas que contengan registros de consultas de diferentes clústeres de Hive y proporcionarlas todas para una sola evaluación.

Informatica

Para solicitar comentarios o asistencia sobre esta función, envía un correo a bq-edw-migration-support@google.com.

Requisitos

- Acceso al cliente de Repository Manager de Informatica PowerCenter

- Una Google Cloud cuenta con un segmento de Cloud Storage para almacenar los datos.

- Un conjunto de datos de BigQuery vacío para almacenar los resultados. También puedes crear un conjunto de datos de BigQuery cuando crees el trabajo de evaluación mediante la Google Cloud consola.

Requisito: exportar archivos de objeto

Puede usar la interfaz gráfica de usuario de Informatica PowerCenter Repository Manager para exportar sus archivos de objeto. Para obtener información, consulta Pasos para exportar objetos.

También puedes ejecutar el comando pmrep para exportar tus archivos de objeto siguiendo estos pasos:

- Ejecuta el comando

pmrep connectpara conectarte al repositorio:

pmrep connect -r `REPOSITORY_NAME` -d `DOMAIN_NAME` -n `USERNAME` -x `PASSWORD`

Haz los cambios siguientes:

REPOSITORY_NAME: nombre del repositorio al que quieres conectarteDOMAIN_NAME: nombre del dominio del repositorioUSERNAME: nombre de usuario para conectarse al repositorioPASSWORD: contraseña del nombre de usuario

- Una vez que te hayas conectado al repositorio, usa el comando

pmrep objectexportpara exportar los objetos necesarios:

pmrep objectexport -n `OBJECT_NAME` -o `OBJECT_TYPE` -f `FOLDER_NAME` -u `OUTPUT_FILE_NAME.xml`

Haz los cambios siguientes:

OBJECT_NAME: nombre de un objeto específico que se va a exportarOBJECT_TYPE: tipo de objeto del objeto especificadoFOLDER_NAME: nombre de la carpeta que contiene el objeto que se va a exportarOUTPUT_FILE_NAME: nombre del archivo XML que contendrá la información del objeto

Subir metadatos y registros de consultas a Cloud Storage

Una vez que hayas extraído los metadatos y los registros de consultas de tu almacén de datos, puedes subir los archivos a un segmento de Cloud Storage para continuar con la evaluación de la migración.

Teradata

Sube los metadatos y uno o varios archivos ZIP que contengan registros de consultas a tu segmento de Cloud Storage. Para obtener más información sobre cómo crear segmentos y subir archivos a Cloud Storage, consulta Crear segmentos y Subir objetos desde un sistema de archivos. El límite del tamaño total sin comprimir de todos los archivos del archivo ZIP de metadatos es de 50 GB.

Las entradas de todos los archivos ZIP que contienen registros de consultas se dividen en lo siguiente:

- Archivos del historial de consultas con el prefijo

query_history_. - Archivos de series temporales con los prefijos

utility_logs_,dbc.ResUsageScpu_ydbc.ResUsageSpma_.

El límite del tamaño total sin comprimir de todos los archivos del historial de consultas es de 5 TB. El límite del tamaño total sin comprimir de todos los archivos de serie temporal es de 1 TB.

Si los registros de consultas se archivan en otra base de datos, consulte la descripción de las marcas -Dteradata-logs.query-logs-table y -Dteradata-logs.sql-logs-table que se ha incluido anteriormente en esta sección, donde se explica cómo proporcionar una ubicación alternativa para los registros de consultas.

Redshift

Sube los metadatos y uno o varios archivos ZIP que contengan registros de consultas a tu segmento de Cloud Storage. Para obtener más información sobre cómo crear segmentos y subir archivos a Cloud Storage, consulta Crear segmentos y Subir objetos desde un sistema de archivos. El límite del tamaño total sin comprimir de todos los archivos del archivo ZIP de metadatos es de 50 GB.

Las entradas de todos los archivos ZIP que contienen registros de consultas se dividen en lo siguiente:

- Archivos del historial de consultas con los prefijos

querytext_yddltext_. - Archivos de series temporales con los prefijos

query_queue_info_,wlm_query_yquerymetrics_.

El límite del tamaño total sin comprimir de todos los archivos del historial de consultas es de 5 TB. El límite del tamaño total sin comprimir de todos los archivos de serie temporal es de 1 TB.

Redshift Serverless

Sube los metadatos y uno o varios archivos ZIP que contengan registros de consultas a tu segmento de Cloud Storage. Para obtener más información sobre cómo crear segmentos y subir archivos a Cloud Storage, consulta Crear segmentos y Subir objetos desde un sistema de archivos.

Snowflake

Sube los metadatos y los archivos ZIP que contengan los registros de consultas y los historiales de uso a tu segmento de Cloud Storage. Al subir estos archivos a Cloud Storage, se deben cumplir los siguientes requisitos:

- El tamaño total sin comprimir de todos los archivos del archivo ZIP de metadatos debe ser inferior a 50 GB.

- El archivo ZIP de metadatos y el archivo ZIP que contiene los registros de consultas deben subirse a una carpeta de Cloud Storage. Si tienes varios archivos ZIP que contienen registros de consultas que no se solapan, puedes subirlos todos.

- Debes subir todos los archivos a la misma carpeta de Cloud Storage.

- Debe subir todos los archivos ZIP de metadatos y registros de consultas exactamente como los genera la herramienta

dwh-migration-dumper. No los extraigas, combines ni modifiques de ninguna otra forma. - El tamaño total sin comprimir de todos los archivos del historial de consultas debe ser inferior a 5 TB.

Para obtener más información sobre cómo crear contenedores y subir archivos a Cloud Storage, consulta Crear contenedores y Subir objetos desde un sistema de archivos.

Oracle

Para solicitar comentarios o asistencia sobre esta función, envía un correo a bq-edw-migration-support@google.com.

Sube el archivo ZIP que contiene los metadatos y las estadísticas de rendimiento a un segmento de Cloud Storage. De forma predeterminada, el nombre del archivo ZIP es dwh-migration-oracle-stats.zip, pero puedes personalizarlo especificándolo en la marca --output. El límite del tamaño total sin comprimir de todos los archivos del archivo ZIP es de 50 GB.

Para obtener más información sobre cómo crear contenedores y subir archivos a Cloud Storage, consulta Crear contenedores y Subir objetos desde un sistema de archivos.

Hadoop/Cloudera

Para solicitar comentarios o asistencia sobre esta función, envía un correo a bq-edw-migration-support@google.com.

Sube el archivo ZIP que contiene los metadatos y las estadísticas de rendimiento a un segmento de Cloud Storage. De forma predeterminada, el nombre del archivo ZIP es dwh-migration-cloudera-manager-RUN_DATE.zip (por ejemplo, dwh-migration-cloudera-manager-20250312T145808.zip), pero puedes personalizarlo con la marca --output. El límite del tamaño total sin comprimir de todos los archivos del archivo ZIP es de 50 GB.

Para obtener más información sobre cómo crear contenedores y subir archivos a Cloud Storage, consulta Crear un contenedor y Subir objetos desde un sistema de archivos.

Apache Hive

Sube los metadatos y las carpetas que contengan registros de consultas de uno o varios clústeres de Hive a tu segmento de Cloud Storage. Para obtener más información sobre cómo crear contenedores y subir archivos a Cloud Storage, consulta Crear contenedores y Subir objetos desde un sistema de archivos.

El límite del tamaño total sin comprimir de todos los archivos del archivo ZIP de metadatos es de 50 GB.

Puedes usar el conector de Cloud Storage para copiar los registros de consultas directamente en la carpeta de Cloud Storage. Las carpetas que contienen subcarpetas con registros de consultas deben subirse a la misma carpeta de Cloud Storage en la que se sube el archivo ZIP de metadatos.

Las carpetas de registros de consultas tienen archivos de historial de consultas con el prefijo dwhassessment_. El límite del tamaño total sin comprimir de todos los archivos del historial de consultas es de 5 TB.

Informatica

Para solicitar comentarios o asistencia sobre esta función, envía un correo a bq-edw-migration-support@google.com.

Sube un archivo ZIP que contenga los objetos de tu repositorio XML de Informatica a un depósito de Cloud Storage. Este archivo ZIP también debe incluir un archivo compilerworks-metadata.yaml que contenga lo siguiente:

product: arguments: "ConnectorArguments{connector=informatica, assessment=true}"

El límite del tamaño total sin comprimir de todos los archivos del archivo ZIP es de 50 GB.

Para obtener más información sobre cómo crear contenedores y subir archivos a Cloud Storage, consulta Crear contenedores y Subir objetos desde un sistema de archivos.

Realizar una evaluación de migración a BigQuery

Sigue estos pasos para ejecutar la evaluación de la migración de BigQuery. En estos pasos se da por hecho que has subido los archivos de metadatos a un segmento de Cloud Storage, tal como se describe en la sección anterior.

Permisos obligatorios

Para habilitar BigQuery Migration Service, necesitas los siguientes permisos de gestión de identidades y accesos (IAM):

resourcemanager.projects.getresourcemanager.projects.updateserviceusage.services.enableserviceusage.services.get

Para acceder a BigQuery Migration Service y usarlo, debe tener los siguientes permisos en el proyecto:

bigquerymigration.workflows.createbigquerymigration.workflows.getbigquerymigration.workflows.listbigquerymigration.workflows.deletebigquerymigration.subtasks.getbigquerymigration.subtasks.list

Para ejecutar BigQuery Migration Service, necesitas los siguientes permisos adicionales.

Permiso para acceder a los segmentos de Cloud Storage de los archivos de entrada y salida:

storage.objects.geten el segmento de Cloud Storage de origenstorage.objects.listen el segmento de Cloud Storage de origenstorage.objects.createen el segmento de Cloud Storage de destinostorage.objects.deleteen el segmento de Cloud Storage de destinostorage.objects.updateen el segmento de Cloud Storage de destinostorage.buckets.getstorage.buckets.list

Permiso para leer y actualizar el conjunto de datos de BigQuery en el que BigQuery Migration Service escribe los resultados:

bigquery.datasets.updatebigquery.datasets.getbigquery.datasets.createbigquery.datasets.deletebigquery.jobs.createbigquery.jobs.deletebigquery.jobs.listbigquery.jobs.updatebigquery.tables.createbigquery.tables.getbigquery.tables.getDatabigquery.tables.listbigquery.tables.updateData

Para compartir el informe de Looker Studio con un usuario, debes concederle los siguientes roles:

roles/bigquery.dataViewerroles/bigquery.jobUser

Para personalizar este documento y usar tu propio proyecto y usuario en los comandos, edita estas variables:

PROJECT,

USER_EMAIL.

Crea un rol personalizado con los permisos necesarios para usar la evaluación de la migración de BigQuery:

gcloud iam roles create BQMSrole \ --project=PROJECT \ --title=BQMSrole \ --permissions=bigquerymigration.subtasks.get,bigquerymigration.subtasks.list,bigquerymigration.workflows.create,bigquerymigration.workflows.get,bigquerymigration.workflows.list,bigquerymigration.workflows.delete,resourcemanager.projects.update,resourcemanager.projects.get,serviceusage.services.enable,serviceusage.services.get,storage.objects.get,storage.objects.list,storage.objects.create,storage.objects.delete,storage.objects.update,bigquery.datasets.get,bigquery.datasets.update,bigquery.datasets.create,bigquery.datasets.delete,bigquery.tables.get,bigquery.tables.create,bigquery.tables.updateData,bigquery.tables.getData,bigquery.tables.list,bigquery.jobs.create,bigquery.jobs.update,bigquery.jobs.list,bigquery.jobs.delete,storage.buckets.list,storage.buckets.get

Asigna el rol personalizado BQMSrole a un usuario:

gcloud projects add-iam-policy-binding \ PROJECT \ --member=user:USER_EMAIL \ --role=projects/PROJECT/roles/BQMSrole

Concede los roles necesarios al usuario con el que quieras compartir el informe:

gcloud projects add-iam-policy-binding \ PROJECT \ --member=user:USER_EMAIL \ --role=roles/bigquery.dataViewer gcloud projects add-iam-policy-binding \ PROJECT \ --member=user:USER_EMAIL \ --role=roles/bigquery.jobUser

Ubicaciones admitidas

La función de evaluación de la migración de BigQuery se admite en dos tipos de ubicaciones:

Una región es un lugar geográfico específico, como Londres.

Una multirregión es una zona geográfica amplia, como Estados Unidos, que contiene dos o más regiones. Las ubicaciones multirregionales pueden proporcionar cuotas más grandes que las de una sola región.

Para obtener más información sobre las regiones y las zonas, consulta el artículo sobre geografía y regiones.

Regiones

En la siguiente tabla se indican las regiones de América en las que está disponible la evaluación de la migración de BigQuery.| Descripción de la región | Nombre de la región | Detalles |

|---|---|---|

| Columbus (Ohio) | us-east5 |

|

| Dallas | us-south1 |

|

| Iowa | us-central1 |

|

| Carolina del Sur | us-east1 |

|

| Norte de Virginia | us-east4 |

|

| Oregón | us-west1 |

|

| Los Ángeles | us-west2 |

|

| Salt Lake City | us-west3 |

| Descripción de la región | Nombre de la región | Detalles |

|---|---|---|

| Singapur | asia-southeast1 |

|

| Tokio | asia-northeast1 |

| Descripción de la región | Nombre de la región | Detalles |

|---|---|---|

| Bélgica | europe-west1 |

|

| Finlandia | europe-north1 |

|

| Fráncfort | europe-west3 |

|

| Londres | europe-west2 |

|

| Madrid | europe-southwest1 |

|

| Países Bajos | europe-west4 |

|

| París | europe-west9 |

|

| Turín | europe-west12 |

|

| Varsovia | europe-central2 |

|

| Zúrich | europe-west6 |

|

Multirregional

En la siguiente tabla se indican las multirregiones en las que está disponible la evaluación de la migración de BigQuery.| Descripción multirregional | Nombre multirregional |

|---|---|

| Centros de datos en los Estados miembros de la Unión Europea | EU |

| Centros de datos en Estados Unidos | US |

Antes de empezar

Antes de ejecutar la evaluación, debes habilitar la API BigQuery Migration y crear un conjunto de datos de BigQuery para almacenar los resultados de la evaluación.

Habilitar la API de migración de BigQuery

Habilita la API de migración de BigQuery de la siguiente manera:

En la Google Cloud consola, ve a la página API BigQuery Migration.

Haz clic en Enable (Habilitar).

Crear un conjunto de datos para los resultados de la evaluación

La evaluación de la migración a BigQuery escribe los resultados de la evaluación en tablas de BigQuery. Antes de empezar, crea un conjunto de datos para almacenar estas tablas. Cuando compartas el informe de Looker Studio, también debes dar permiso a los usuarios para leer este conjunto de datos. Para obtener más información, consulta el artículo Poner el informe a disposición de los usuarios.

Ejecutar la evaluación de la migración

Consola

En la Google Cloud consola, ve a la página BigQuery.

En el menú de navegación, haz clic en Evaluación.

Haz clic en Iniciar evaluación.

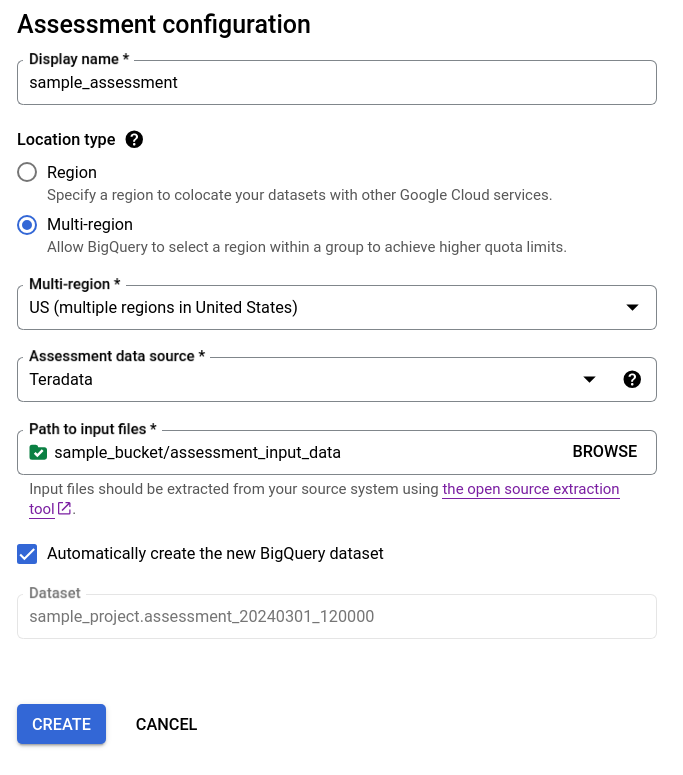

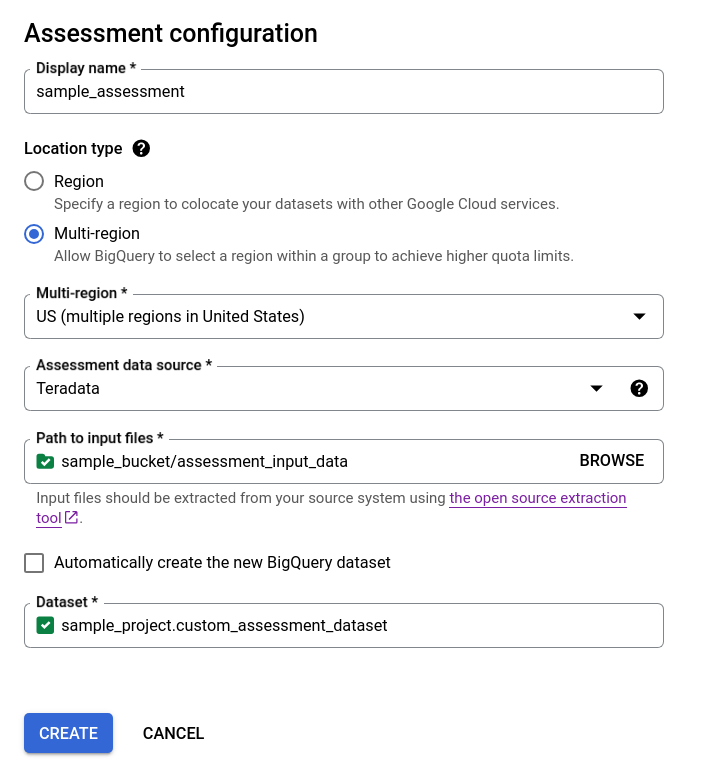

Rellena el cuadro de diálogo de configuración de la evaluación.

- En Nombre visible, introduce el nombre, que puede contener letras, números o guiones bajos. Este nombre se usa únicamente con fines de visualización y no tiene que ser único.

En la lista Ubicación de los datos, elige una ubicación para el trabajo de evaluación. La tarea de evaluación debe estar en la misma ubicación que el segmento de Cloud Storage de entrada de los archivos extraídos y el conjunto de datos de BigQuery de salida. Sin embargo, si el segmento de Cloud Storage o el conjunto de datos de BigQuery se encuentran en una multirregión, la tarea de evaluación debe estar en cualquiera de las regiones de esa multirregión.

Si la ubicación de la evaluación es una multirregión

USoEU, la ubicación del segmento de Cloud Storage y la del conjunto de datos de BigQuery deben estar en la misma multirregión o en la ubicación de esta multirregión. Para obtener más información sobre las restricciones de ubicación, consulta el artículo sobre las consideraciones sobre la ubicación de los datos de carga de BigQuery.En Fuente de datos de evaluación, elija su almacén de datos.

En Ruta a los archivos de entrada, introduce la ruta al segmento de Cloud Storage que contiene los archivos extraídos.

Para elegir cómo se almacenan los resultados de la evaluación, sigue uno de estos pasos:

- Deja marcada la casilla Crear automáticamente el nuevo conjunto de datos de BigQuery para que el conjunto de datos de BigQuery se cree automáticamente. El nombre del conjunto de datos se genera automáticamente.

- Desmarca la casilla Crear automáticamente el nuevo conjunto de datos de BigQuery y elige el conjunto de datos de BigQuery vacío que ya tengas con el formato

projectId.datasetIdo crea un nombre para el nuevo conjunto de datos. En esta opción, puede elegir el nombre del conjunto de datos de BigQuery.

Opción 1: generación automática de conjuntos de datos de BigQuery (opción predeterminada)

Opción 2: crear manualmente un conjunto de datos de BigQuery:

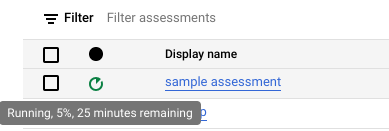

Haz clic en Crear. Puedes ver el estado del trabajo en la lista de trabajos de evaluación.

Mientras se realiza la evaluación, puede consultar su progreso y el tiempo estimado para completarla en la descripción emergente del icono de estado.

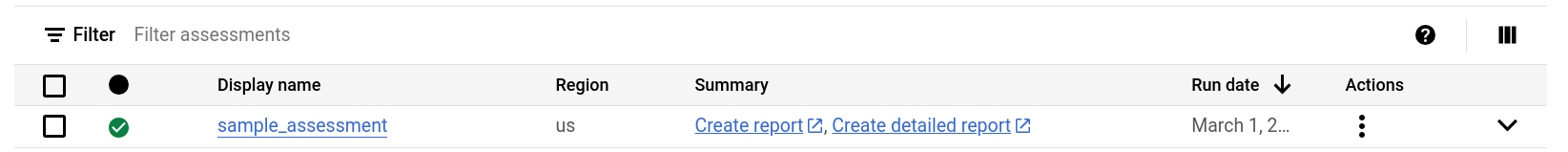

Mientras se lleva a cabo la evaluación, puede hacer clic en el enlace Ver informe de la lista de tareas de evaluación para ver el informe de evaluación con datos parciales en Looker Studio. El enlace Ver informe puede tardar en aparecer mientras se lleva a cabo la evaluación. El informe se abre en una pestaña nueva.

El informe se actualiza con los nuevos datos a medida que se procesan. Actualiza la pestaña con el informe o vuelve a hacer clic en Ver informe para ver el informe actualizado.

Cuando se haya completado la evaluación, haz clic en Ver informe para ver el informe de evaluación completo en Looker Studio. El informe se abre en una pestaña nueva.

API

Llama al método create con un flujo de trabajo definido.

A continuación, llama al método start para iniciar el flujo de trabajo de la evaluación.

La evaluación crea tablas en el conjunto de datos de BigQuery que has creado anteriormente. Puedes consultar estos metadatos para obtener información sobre las tablas y las consultas que se usan en tu almacén de datos. Para obtener información sobre los archivos de salida de la traducción, consulta Traductor de SQL por lotes.

Resultado de evaluación agregado que se puede compartir

En el caso de las evaluaciones de Amazon Redshift, Teradata y Snowflake, además del conjunto de datos de BigQuery creado anteriormente, el flujo de trabajo crea otro conjunto de datos ligero con el mismo nombre y el sufijo _shareableRedactedAggregate. Este conjunto de datos contiene datos muy agregados derivados del conjunto de datos de salida y no contiene información personal identificable (IPI).

Para buscar, inspeccionar y compartir de forma segura el conjunto de datos con otros usuarios, consulta Consultar las tablas de resultados de la evaluación de la migración.

Esta función está activada de forma predeterminada, pero puedes inhabilitarla mediante la API pública.

Detalles de la evaluación

Para ver la página de detalles de la evaluación, haz clic en el nombre visible de la lista de trabajos de evaluación.

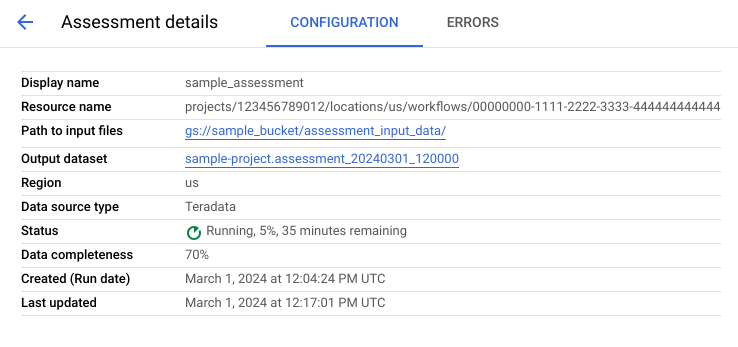

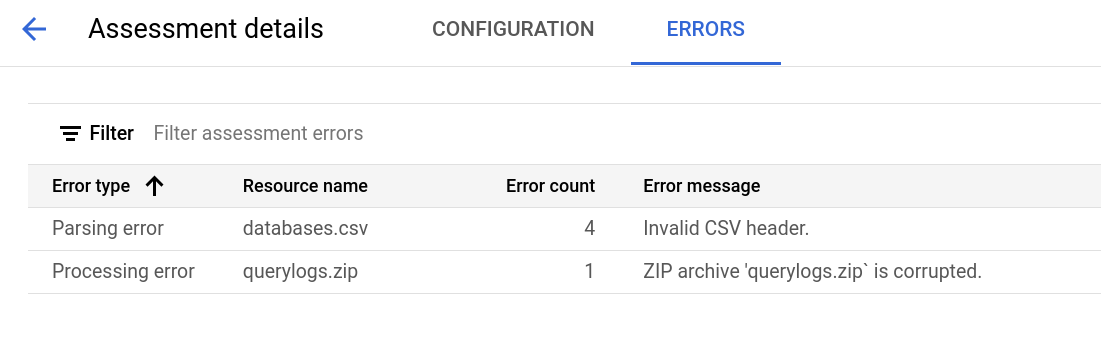

La página de detalles de la evaluación contiene la pestaña Configuración, donde puede ver más información sobre un trabajo de evaluación, y la pestaña Errores, donde puede consultar los errores que se hayan producido durante el procesamiento de la evaluación.

Consulta la pestaña Configuración para ver las propiedades de la evaluación.

Consulte la pestaña Errores para ver los errores que se han producido durante el procesamiento de la evaluación.

Revisar y compartir el informe de Looker Studio

Una vez que se haya completado la tarea de evaluación, puedes crear y compartir un informe de Looker Studio con los resultados.

Revisar el informe

Haga clic en el enlace Ver informe que aparece junto a la tarea de evaluación individual. El informe de Looker Studio se abre en una pestaña nueva en modo de vista previa. Puedes usar el modo de vista previa para revisar el contenido del informe antes de compartirlo.

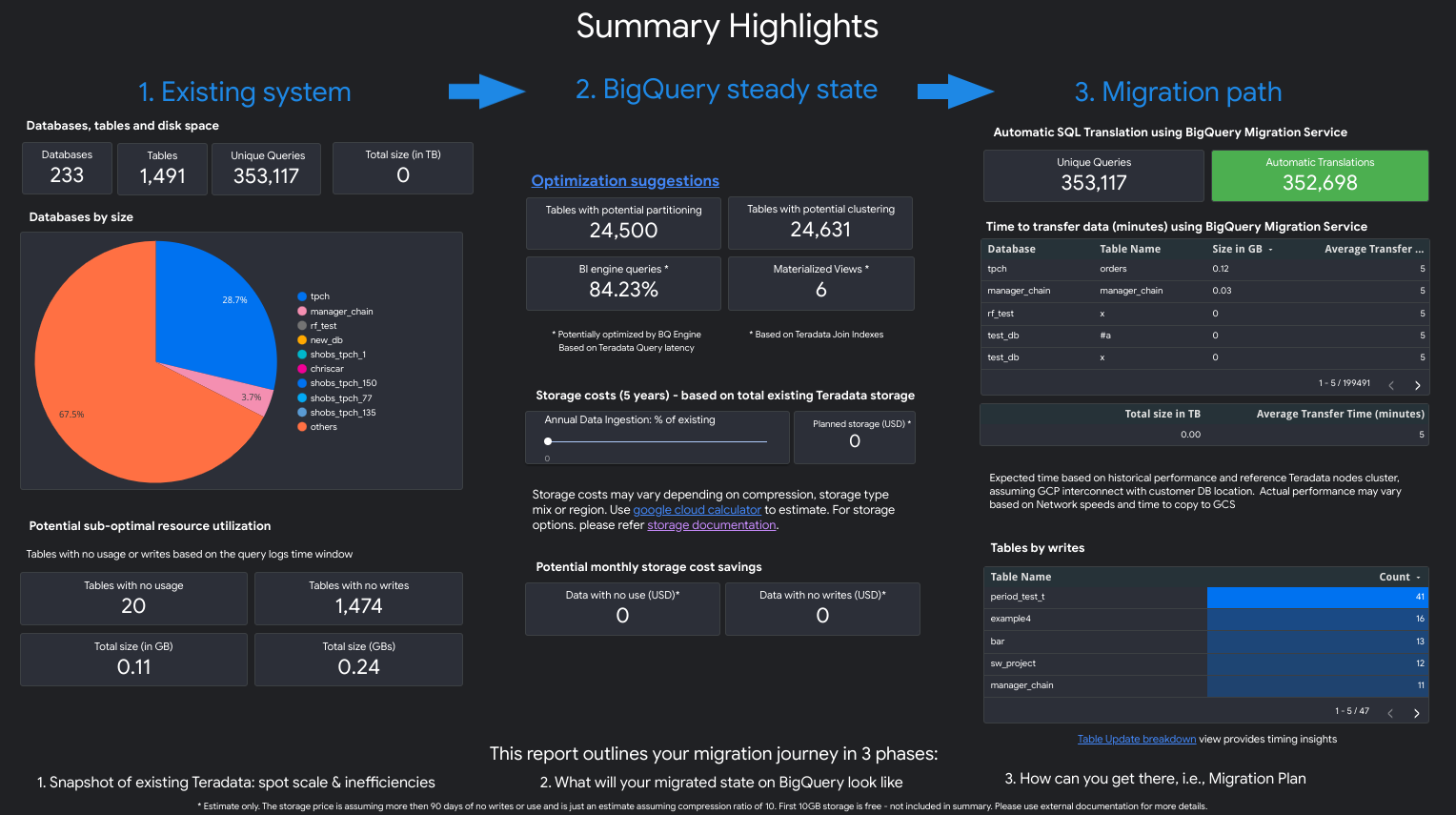

El informe es similar a la siguiente captura de pantalla:

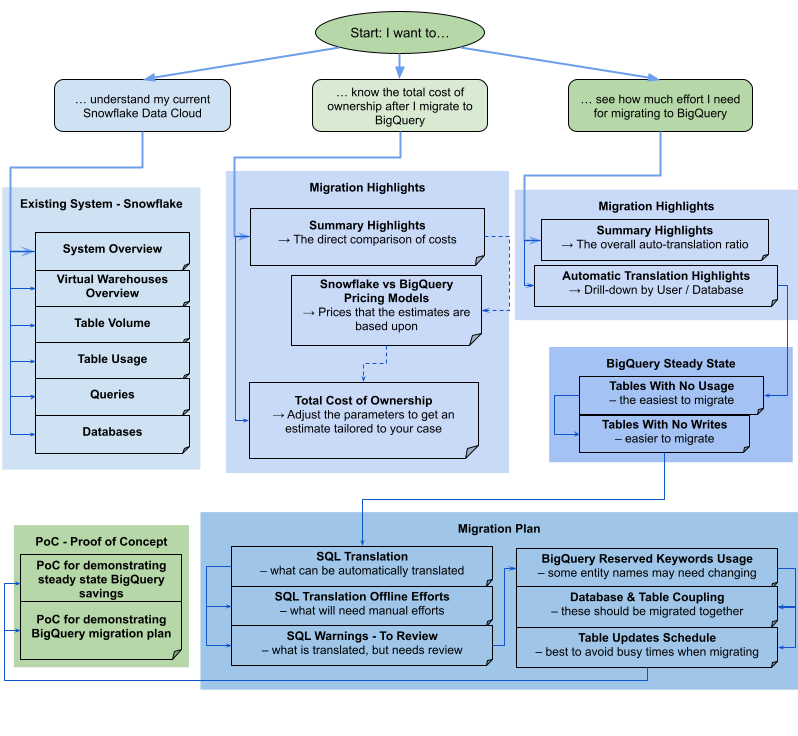

Para ver qué vistas contiene el informe, selecciona tu almacén de datos:

Teradata

El informe es una narración dividida en tres partes que va precedida de una página de resumen con los aspectos más destacados. Esta página incluye las siguientes secciones:

- Sistema actual. En esta sección se muestra una vista general del sistema y el uso de Teradata, incluido el número de bases de datos, esquemas y tablas, así como el tamaño total en TB. También muestra los esquemas por tamaño e indica si hay recursos que no se están utilizando de forma óptima (tablas sin escrituras o con pocas lecturas).

- Transformaciones de estado estable de BigQuery (sugerencias). En esta sección se muestra cómo será el sistema en BigQuery después de la migración. Incluye sugerencias para optimizar las cargas de trabajo en BigQuery (y evitar el desperdicio).

- Plan de migración. En esta sección se proporciona información sobre el esfuerzo de migración en sí, por ejemplo, cómo pasar del sistema actual al estado estable de BigQuery. En esta sección se incluye el número de consultas que se han traducido automáticamente y el tiempo estimado para mover cada tabla a BigQuery.

Los detalles de cada sección incluyen lo siguiente:

Sistema actual

- Cálculos y consultas

- Uso de CPU:

- Mapa de calor del uso medio de CPU por hora (vista del uso general de los recursos del sistema)

- Consultas por hora y día con uso de CPU

- Consultas por tipo (lectura/escritura) con uso de CPU

- Aplicaciones con uso de CPU

- Superposición del uso de CPU por horas con el rendimiento medio de las consultas por horas y el rendimiento medio de las aplicaciones por horas

- Consulta el histograma por tipo y duración de la consulta.

- Vista de detalles de las aplicaciones (aplicación, usuario, consultas únicas, desglose de informes frente a ETL)

- Uso de CPU:

- Información general sobre el almacenamiento

- Bases de datos por volumen, vistas y tasas de acceso

- Tablas con tasas de acceso por usuarios, consultas, escrituras y creaciones de tablas temporales

- Aplicaciones: tasas de acceso y direcciones IP

Transformaciones de estado estable de BigQuery (sugerencias)

- Índices de unión convertidos en vistas materializadas

- Agrupación en clústeres y partición de candidatos en función de los metadatos y el uso

- Consultas de baja latencia identificadas como candidatas para BigQuery BI Engine

- Columnas configuradas con valores predeterminados que usan la función de descripción de columna para almacenar valores predeterminados

- Los índices únicos de Teradata (para evitar que las filas tengan claves no únicas en una tabla) usan tablas de almacenamiento temporal y una instrucción

MERGEpara insertar solo registros únicos en las tablas de destino y, a continuación, descartar los duplicados. - Consultas y esquemas restantes traducidos tal cual

Plan de migración

- Vista detallada con consultas traducidas automáticamente

- Recuento del total de consultas con la posibilidad de filtrar por usuario, aplicación, tablas afectadas, tablas consultadas y tipo de consulta

- Contenedores de consultas con patrones similares agrupados y mostrados juntos para que el usuario pueda ver la filosofía de traducción por tipos de consulta.

- Consultas que requieren la intervención humana

- Consultas con infracciones de la estructura léxica de BigQuery

- Funciones y procedimientos definidos por el usuario

- Palabras clave reservadas de BigQuery

- Tablas programadas por escrituras y lecturas (para agruparlas y moverlas)

- Migración de datos con BigQuery Data Transfer Service: tiempo estimado de migración por tabla

La sección Sistema actual contiene las siguientes vistas:

- Descripción general del sistema

- La vista Resumen del sistema proporciona las métricas de volumen de alto nivel de los componentes clave del sistema durante un periodo específico. La cronología que se evalúa depende de los registros que haya analizado la evaluación de la migración de BigQuery. Esta vista te ofrece información rápida sobre la utilización del almacén de datos de origen, que puedes usar para planificar la migración.

- Volumen de la tabla

- La vista Volumen de tabla proporciona estadísticas sobre las tablas y bases de datos más grandes que ha encontrado la evaluación de la migración de BigQuery. Como las tablas grandes pueden tardar más en extraerse del sistema de almacén de datos de origen, esta vista puede ser útil para planificar y secuenciar la migración.

- Uso de tablas

- La vista Uso de tablas proporciona estadísticas sobre las tablas que se usan mucho en el sistema de almacén de datos de origen. Las tablas que se usan mucho pueden ayudarte a identificar las que tienen muchas dependencias y requieren una planificación adicional durante el proceso de migración.

- Aplicaciones

- Las vistas Uso de aplicaciones y Patrones de aplicaciones proporcionan estadísticas sobre las aplicaciones encontradas durante el procesamiento de los registros. Estas vistas permiten a los usuarios conocer el uso de aplicaciones específicas a lo largo del tiempo y el impacto en el uso de recursos. Durante una migración, es importante visualizar la ingestión y el consumo de datos para comprender mejor las dependencias del almacén de datos y analizar el impacto de mover varias aplicaciones dependientes a la vez. La tabla de direcciones IP puede ser útil para identificar la aplicación exacta que usa el almacén de datos a través de conexiones JDBC.

- Consultas

- La vista Consultas ofrece un desglose de los tipos de instrucciones SQL ejecutadas y estadísticas sobre su uso. Puedes usar el histograma de tipo de consulta y hora para identificar los periodos de baja utilización del sistema y las horas del día óptimas para transferir datos. También puede usar esta vista para identificar las consultas que se ejecutan con frecuencia y los usuarios que las invocan.

- Bases de datos

- La vista Bases de datos proporciona métricas sobre el tamaño, las tablas, las vistas y los procedimientos definidos en el sistema de almacén de datos de origen. Esta vista puede proporcionarte información valiosa sobre el volumen de objetos que tienes que migrar.

- Acoplamiento de bases de datos

- La vista Acoplamiento de bases de datos ofrece una vista general de las bases de datos y las tablas a las que se accede conjuntamente en una sola consulta. En esta vista se pueden ver las tablas y bases de datos a las que se hace referencia con frecuencia y lo que puedes usar para planificar la migración.

La sección Estado estable de BigQuery contiene las siguientes vistas:

- Tablas sin uso

- En la vista Tablas sin uso se muestran las tablas en las que la evaluación de la migración a BigQuery no ha encontrado ningún uso durante el periodo de los registros analizados. Si no se usa, puede que no sea necesario transferir esa tabla a BigQuery durante la migración o que los costes de almacenamiento de datos en BigQuery sean más bajos. Deberías validar la lista de tablas no utilizadas, ya que podrían tener un uso fuera del periodo de los registros, como una tabla que solo se usa una vez cada tres o seis meses.

- Tablas sin escrituras

- La vista Tablas sin escritura muestra las tablas en las que la evaluación de la migración de BigQuery no ha encontrado ninguna actualización durante el periodo de los registros analizados. La falta de escrituras puede indicar dónde puedes reducir los costes de almacenamiento en BigQuery.

- Consultas de baja latencia

- La vista Consultas de baja latencia muestra una distribución de los tiempos de ejecución de las consultas en función de los datos de registro analizados. Si el gráfico de distribución de la duración de las consultas muestra un gran número de consultas con un tiempo de ejecución inferior a 1 segundo, considera la posibilidad de habilitar BigQuery BI Engine para acelerar la inteligencia de negocio y otras cargas de trabajo de baja latencia.

- Vistas materializadas

- La vista materializada ofrece más sugerencias de optimización para mejorar el rendimiento en BigQuery.

- Clústeres y particiones

En la vista Particiones y clústeres se muestran las tablas que se beneficiarían de las particiones, los clústeres o ambos.

Las sugerencias de metadatos se obtienen analizando el esquema del almacén de datos de origen (como la partición y la clave principal de la tabla de origen) y buscando el equivalente más cercano en BigQuery para conseguir características de optimización similares.

Las sugerencias de carga de trabajo se obtienen analizando los registros de consultas de origen. La recomendación se determina analizando las cargas de trabajo, especialmente las cláusulas

WHEREoJOINde los registros de consultas analizados.- Recomendación de clustering

La vista Particiones muestra las tablas que pueden tener más de 10.000 particiones, en función de la definición de su restricción de partición. Estas tablas suelen ser buenas candidatas para la creación de clústeres de BigQuery, lo que permite crear particiones de tabla pormenorizadas.

- Restricciones únicas

La vista Restricciones únicas muestra tanto las tablas

SETcomo los índices únicos definidos en el almacén de datos de origen. En BigQuery, se recomienda usar tablas de almacenamiento temporal y una instrucciónMERGEpara insertar solo registros únicos en una tabla de destino. Utiliza el contenido de esta vista para determinar qué tablas debes ajustar en el proceso de extracción, transformación y carga durante la migración.- Valores predeterminados o restricciones de comprobación

En esta vista se muestran las tablas que usan restricciones de comprobación para definir los valores predeterminados de las columnas. En BigQuery, consulta Especificar valores predeterminados de las columnas.

La sección Ruta de migración del informe contiene las siguientes vistas:

- Traducción de SQL

- La vista Traducción de SQL muestra el número y los detalles de las consultas que se han convertido automáticamente mediante la evaluación de la migración de BigQuery y que no requieren intervención manual. La traducción automática de SQL suele alcanzar tasas de traducción altas si se proporcionan metadatos. Esta vista es interactiva y permite analizar las consultas habituales y cómo se traducen.

- Esfuerzo offline

- La vista Esfuerzo sin conexión muestra las áreas que requieren intervención manual, como UDFs específicas y posibles infracciones de la estructura léxica y la sintaxis de tablas o columnas.

- Palabras clave reservadas de BigQuery

- La vista Palabras clave reservadas de BigQuery muestra el uso detectado de palabras clave que tienen un significado especial en el lenguaje GoogleSQL y que no se pueden usar como identificadores a menos que estén entre comillas inversas (

`). - Programación de las actualizaciones de Tables

- La vista Programación de actualizaciones de tablas muestra cuándo y con qué frecuencia se actualizan las tablas para ayudarte a planificar cómo y cuándo moverlas.

- Migración de datos a BigQuery

- La vista Migración de datos a BigQuery muestra el proceso de migración con el tiempo estimado para migrar los datos mediante BigQuery Data Transfer Service. Para obtener más información, consulta la guía de BigQuery Data Transfer Service para Teradata.

La sección Apéndice contiene las siguientes vistas:

- Distinción entre mayúsculas y minúsculas

- La vista Sensibilidad a mayúsculas y minúsculas muestra las tablas del almacén de datos de origen que están configuradas para realizar comparaciones sin distinción entre mayúsculas y minúsculas. De forma predeterminada, las comparaciones de cadenas en BigQuery distinguen entre mayúsculas y minúsculas. Para obtener más información, consulta Colación.

Redshift

- Aspectos destacados de la migración

- La vista "Aspectos destacados de la migración" ofrece un resumen ejecutivo de las tres secciones del informe:

- El panel Sistema actual proporciona información sobre el número de bases de datos, esquemas y tablas, así como el tamaño total del sistema Redshift actual. También se muestran los esquemas por tamaño y el uso de recursos potencialmente no óptimo. Puede usar esta información para optimizar sus datos quitando, particionando o agrupando en clústeres sus tablas.

- El panel Estado estable de BigQuery proporciona información sobre el aspecto que tendrán tus datos después de la migración a BigQuery, incluido el número de consultas que se pueden traducir automáticamente con BigQuery Migration Service. En esta sección también se muestran los costes de almacenar los datos en BigQuery en función de la tasa de ingestión de datos anual, así como sugerencias de optimización para tablas, aprovisionamiento y espacio.

- El panel Ruta de migración proporciona información sobre el esfuerzo de migración. En cada tabla se muestra el tiempo estimado de migración, el número de filas y el tamaño.

La sección Sistema actual contiene las siguientes vistas:

- Consultas por tipo y programación

- La vista Consultas por tipo y programación clasifica tus consultas en ETL/Escritura e Informes/Agregación. Ver la combinación de consultas a lo largo del tiempo te ayuda a comprender tus patrones de uso, identificar la variabilidad y el posible aprovisionamiento excesivo que pueden afectar al coste y al rendimiento.

- Colas de consultas

- La vista Colas de consultas proporciona más detalles sobre la carga del sistema, como el volumen y la combinación de consultas, así como cualquier impacto en el rendimiento debido a las colas, como la insuficiencia de recursos.

- Consultas y escalado de WLM

- En la vista Consultas y escalado de WLM, se identifica el escalado de la simultaneidad como un coste adicional y una complejidad de configuración. Muestra cómo enruta tu sistema Redshift las consultas en función de las reglas que hayas especificado, así como el impacto en el rendimiento debido a las colas, el escalado de la simultaneidad y las consultas desalojadas.

- Poner en cola y esperar

- La vista Colas y tiempos de espera ofrece información más detallada sobre las colas y los tiempos de espera de las consultas a lo largo del tiempo.

- Clases y rendimiento de WLM

- La vista Clases y rendimiento de WLM ofrece una forma opcional de asignar tus reglas a BigQuery. Sin embargo, te recomendamos que dejes que BigQuery enrute tus consultas automáticamente.

- Estadísticas de volumen de consultas y tablas

- En la vista Estadísticas de volumen de consultas y tablas se muestran las consultas por tamaño, frecuencia y usuarios principales. De esta forma, puede categorizar las fuentes de carga del sistema y planificar cómo migrar sus cargas de trabajo.

- Bases de datos y esquemas

- La vista Bases de datos y esquemas proporciona métricas sobre el tamaño, las tablas, las vistas y los procedimientos definidos en el sistema de almacén de datos de origen. De esta forma, podrás hacerte una idea del volumen de objetos que se deben migrar.

- Volumen de la tabla

- La vista Volumen de tabla proporciona estadísticas sobre las tablas y las bases de datos más grandes, y muestra cómo se accede a ellas. Como las tablas grandes pueden tardar más en extraerse del sistema de almacén de datos de origen, esta vista te ayuda a planificar y secuenciar la migración.

- Uso de tablas

- La vista Uso de tablas proporciona estadísticas sobre las tablas que se usan mucho en el sistema de almacén de datos de origen. Las tablas que se usan mucho se pueden aprovechar para identificar las tablas que pueden tener muchas dependencias y que requieren una planificación adicional durante el proceso de migración.

- Importadores y exportadores

- La vista Importadores y exportadores proporciona información sobre los datos y los usuarios implicados en la importación de datos (mediante consultas

COPY) y la exportación de datos (mediante consultasUNLOAD). Esta vista ayuda a identificar la capa de almacenamiento provisional y los procesos relacionados con la ingesta y las exportaciones. - Utilización del clúster

- La vista Utilización del clúster proporciona información general sobre todos los clústeres disponibles y muestra la utilización de CPU de cada clúster. Esta vista puede ayudarte a entender la reserva de capacidad del sistema.

La sección Estado estable de BigQuery contiene las siguientes vistas:

- Agrupación en clústeres y particiones

En la vista Particiones y clústeres se muestran las tablas que se beneficiarían de las particiones, los clústeres o ambos.

Las sugerencias de metadatos se obtienen analizando el esquema del almacén de datos de origen (como las claves de ordenación y de distribución de la tabla de origen) y buscando el equivalente más parecido en BigQuery para conseguir características de optimización similares.

Las sugerencias de cargas de trabajo se obtienen analizando los registros de consultas de origen. La recomendación se determina analizando las cargas de trabajo, especialmente las cláusulas

WHEREoJOINde los registros de consultas analizados.En la parte inferior de la página, se muestra una instrucción de creación de tabla traducida con todas las optimizaciones proporcionadas. Todas las instrucciones DDL traducidas también se pueden extraer del conjunto de datos. Las instrucciones DDL traducidas se almacenan en la tabla

SchemaConversion, en la columnaCreateTableDDL.Las recomendaciones del informe solo se proporcionan para tablas de más de 1 GB, ya que las tablas pequeñas no se benefician de la creación de clústeres ni de particiones. Sin embargo, el DDL de todas las tablas (incluidas las que tienen un tamaño inferior a 1 GB) está disponible en la tabla

SchemaConversion.- Tablas sin uso

En la vista Tablas sin uso se muestran las tablas en las que la evaluación de la migración a BigQuery no ha identificado ningún uso durante el periodo de los registros analizados. Si no se usa, puede que no sea necesario transferir esa tabla a BigQuery durante la migración o que los costes de almacenamiento de datos en BigQuery sean más bajos (se facturan como almacenamiento a largo plazo). Le recomendamos que valide la lista de tablas sin usar, ya que podrían tener un uso fuera del periodo de los registros, como una tabla que solo se usa una vez cada tres o seis meses.

- Tablas sin escrituras

En la vista Tablas sin escrituras se muestran las tablas en las que la evaluación de la migración de BigQuery no ha identificado ninguna actualización durante el periodo de los registros analizados. Si no se realizan escrituras, puede que sea un indicio de que puedes reducir los costes de almacenamiento en BigQuery (que se facturan como almacenamiento a largo plazo).

- BigQuery BI Engine y vistas materializadas

BigQuery BI Engine y las vistas materializadas ofrecen más sugerencias de optimización para mejorar el rendimiento en BigQuery.

La sección Ruta de migración contiene las siguientes vistas:

- Traducción de SQL

- La vista Traducción de SQL muestra el número y los detalles de las consultas que se han convertido automáticamente mediante la evaluación de la migración de BigQuery y que no requieren intervención manual. La traducción automática de SQL suele alcanzar tasas de traducción altas si se proporcionan metadatos.

- Traducción de SQL sin conexión

- La vista "Esfuerzo de traducción de SQL sin conexión" muestra las áreas que requieren intervención manual, incluidas las funciones definidas por el usuario específicas y las consultas con posibles ambigüedades en la traducción.

- Compatibilidad con ALTER TABLE APPEND

- La vista Alter Table Append Support muestra detalles sobre las construcciones comunes de SQL de Redshift que no tienen una contraparte directa en BigQuery.

- Asistencia con el comando de copia

- La vista Compatibilidad con el comando de copia muestra detalles sobre las estructuras comunes de SQL de Redshift que no tienen una contraparte directa en BigQuery.

- Advertencias de SQL

- La vista Advertencias de SQL muestra las áreas que se han traducido correctamente, pero que requieren una revisión.

- Infracciones de la estructura léxica y la sintaxis

- La vista Infracciones de estructura léxica y sintaxis muestra los nombres de las columnas, las tablas, las funciones y los procedimientos que infringen la sintaxis de BigQuery.

- Palabras clave reservadas de BigQuery

- La vista Palabras clave reservadas de BigQuery muestra el uso detectado de palabras clave que tienen un significado especial en el lenguaje GoogleSQL y que no se pueden usar como identificadores a menos que estén entre comillas inversas (

`). - Acoplamiento de esquemas

- La vista Acoplamiento de esquemas ofrece una vista general de las bases de datos, los esquemas y las tablas a los que se accede conjuntamente en una sola consulta. Esta vista puede mostrar qué tablas, esquemas y bases de datos se referencian a menudo y qué puedes usar para planificar la migración.

- Programación de las actualizaciones de Tables

- La vista Programación de las actualizaciones de tablas muestra cuándo y con qué frecuencia se actualizan las tablas para ayudarte a planificar cómo y cuándo moverlas.

- Escala de la tabla

- La vista Escala de tabla muestra las tablas con más columnas.

- Migración de datos a BigQuery

- En la vista Migración de datos a BigQuery se describe el proceso de migración y el tiempo estimado para migrar los datos con BigQuery Migration Service Data Transfer Service. Para obtener más información, consulta la guía de BigQuery Data Transfer Service para Redshift.

- Resumen de la ejecución de la evaluación

El resumen de la ejecución de la evaluación contiene el grado de finalización del informe, el progreso de la evaluación en curso y el estado de los archivos procesados y los errores.

La integridad de los informes representa el porcentaje de datos procesados correctamente que se recomienda mostrar para obtener estadísticas significativas en el informe de evaluación. Si faltan datos de una sección concreta del informe, esta información se indica en la tabla Módulos de evaluación, en el indicador Integridad del informe.

La métrica Progreso indica el porcentaje de datos procesados hasta el momento, junto con la estimación del tiempo restante para procesar todos los datos. Una vez que se haya completado el procesamiento, no se mostrará la métrica de progreso.

Redshift Serverless

- Aspectos destacados de la migración

- En esta página de informe se muestra el resumen de las bases de datos de Amazon Redshift Serverless, incluido el tamaño y el número de tablas. Además, proporciona una estimación general del valor anual del contrato (VAC), que es el coste de computación y almacenamiento en BigQuery. La vista "Aspectos destacados de la migración" ofrece un resumen de las tres secciones del informe.

La sección Sistema actual tiene las siguientes vistas:

- Bases de datos y esquemas

- Proporciona un desglose del tamaño total de almacenamiento en GB de cada base de datos, esquema o tabla.

- Bases de datos y esquemas externos

- Proporciona un desglose del tamaño total de almacenamiento en GB de cada base de datos, esquema o tabla externa.

- Uso del sistema