Evaluación de la migración

La evaluación de la migración de BigQuery te permite planificar y revisar la migración de tu almacén de datos existente en BigQuery. Puedes ejecutar la evaluación de migración de BigQuery a fin de generar un informe para evaluar el costo de almacenamiento de tus datos en BigQuery, ver cómo BigQuery puede optimizar tu carga de trabajo existente en función del ahorro de costos y preparar un plan de migración en el que se describa el tiempo y el esfuerzo necesarios para completar la migración de tu almacén de datos a BigQuery.

En este documento, se describe cómo usar la evaluación de migración de BigQuery y las diferentes formas en que puedes revisar los resultados de la evaluación. Este documento está dirigido a usuarios que estén familiarizados con la consola deGoogle Cloud y el traductor de SQL por lotes.

Antes de comenzar

Para preparar y ejecutar una evaluación de migración de BigQuery, sigue estos pasos:

Extrae metadatos y registros de consultas de tu almacén de datos con la herramienta

dwh-migration-dumper.Sube tus registros de consultas y metadatos a tu bucket de Cloud Storage.

Opcional: Consulta los resultados de la evaluación para encontrar información detallada o específica de la evaluación.

Extrae metadatos y registros de consultas de tu almacén de datos

Se necesitan tanto los metadatos como los registros de consultas para preparar la evaluación con recomendaciones.

A fin de extraer los metadatos y los registros de consultas necesarios para ejecutar la evaluación, selecciona tu almacén de datos:

Teradata

Requisitos

- Una máquina conectada a tu almacén de datos de Teradata de origen (se admiten Teradata 15 y versiones posteriores)

- Una cuenta Google Cloud con un bucket de Cloud Storage para almacenar los datos

- Un conjunto de datos de BigQuery vacío para almacenar los resultados.

- Lee los permisos del conjunto de datos para ver los resultados

- Recomendado: derechos de acceso a nivel de administrador a la base de datos de origen cuando se usa la herramienta de extracción para acceder a tablas del sistema

Requisito: habilitar el registro

La herramienta dwh-migration-dumper extrae tres tipos de registros: registros de consulta, registros de utilidad y registros de uso de recursos. Debes habilitar el registro para los siguientes tipos de registros si deseas ver estadísticas más detalladas:

- Registros de consultas: Se extraen de la vista

dbc.QryLogVy de la tabladbc.DBQLSqlTbl. Especifica la opciónWITH SQLpara habilitar el registro. - Registros de utilidad: Se extraen de la tabla

dbc.DBQLUtilityTbl. Especifica la opciónWITH UTILITYINFOpara habilitar el registro. - Registros de uso de recursos: Se extraen de las tablas

dbc.ResUsageScpuydbc.ResUsageSpma. Habilita el registro de RSS para estas dos tablas.

Ejecuta la herramienta dwh-migration-dumper

Descargue la herramienta dwh-migration-dumper.

Descarga el archivo SHA256SUMS.txt y ejecuta el siguiente comando para verificar la precisión del archivo ZIP:

Bash

sha256sum --check SHA256SUMS.txt

WindowsPowerShell

(Get-FileHash RELEASE_ZIP_FILENAME).Hash -eq ((Get-Content SHA256SUMS.txt) -Split " ")[0]

Reemplaza RELEASE_ZIP_FILENAME por el nombre del archivo ZIP descargado de la versión de la herramienta de extracción de línea de comandos de dwh-migration-dumper, por ejemplo, dwh-migration-tools-v1.0.52.zip.

El resultado True confirma la verificación correcta de la suma de verificación.

El resultado False indica un error de verificación. Asegúrate de que los archivos de suma de comprobación y ZIP se descarguen de la misma versión de actualización y se coloquen en el mismo directorio.

Si deseas obtener detalles sobre cómo configurar y usar la herramienta de extracción, consulta Genera metadatos para la traducción y la evaluación.

Usa la herramienta de extracción para extraer registros y metadatos de tu almacén de datos de Teradata como dos archivos ZIP. Ejecuta los siguientes comandos en una máquina con acceso al almacén de datos de origen para generar los archivos.

Genera el archivo ZIP de metadatos:

dwh-migration-dumper \ --connector teradata \ --database DATABASES \ --driver path/terajdbc4.jar \ --host HOST \ --assessment \ --user USER \ --password PASSWORD

Nota: La marca --database es opcional para el conector teradata. Si se omite, se extraen los metadatos de todas las bases de datos. Esta marca solo es válida para el conector teradata y no se puede usar con teradata-logs.

Genera el archivo ZIP que contiene los registros de consultas:

dwh-migration-dumper \ --connector teradata-logs \ --driver path/terajdbc4.jar \ --host HOST \ --assessment \ --user USER \ --password PASSWORD

Nota: La marca --database no se usa cuando se extraen registros de búsqueda con el conector teradata-logs. Los registros de consultas siempre se extraen para todas las bases de datos.

Reemplaza lo siguiente:

PATH: Es la ruta absoluta o relativa al archivo JAR del controlador que se usará para esta conexión.VERSION: La versión de tu controladorHOST: la dirección del hostUSER: el nombre de usuario que se usará para la conexión de la base de datosDATABASES: (Opcional) Es la lista separada por comas de los nombres de las bases de datos que se extraerán. Si no se proporciona, se extraen todas las bases de datos.PASSWORD: (Opcional) Es la contraseña que se usará para la conexión de la base de datos. Si se deja vacía, se le solicita al usuario su contraseña.

De forma predeterminada, los registros de consultas se extraen de la vista dbc.QryLogV y de la tabla dbc.DBQLSqlTbl. Si necesitas extraer los registros de consultas de una ubicación alternativa, puedes especificar los nombres de las tablas o vistas mediante las marcas -Dteradata-logs.query-logs-table y -Dteradata-logs.sql-logs-table.

De forma predeterminada, los registros de utilidad se extraen de la tabla

dbc.DBQLUtilityTbl. Si necesitas extraer los registros de la utilidad de una

ubicación alternativa, puedes especificar el nombre de la tabla con la marca

-Dteradata-logs.utility-logs-table.

De forma predeterminada, los registros de uso de recursos se extraen de las tablas dbc.ResUsageScpu y dbc.ResUsageSpma. Si necesitas extraer los registros de uso de recursos de una ubicación alternativa, puedes especificar los nombres de las tablas con las marcas -Dteradata-logs.res-usage-scpu-table y -Dteradata-logs.res-usage-spma-table.

Por ejemplo:

Bash

dwh-migration-dumper \ --connector teradata-logs \ --driver path/terajdbc4.jar \ --host HOST \ --assessment \ --user USER \ --password PASSWORD \ -Dteradata-logs.query-logs-table=pdcrdata.QryLogV_hst \ -Dteradata-logs.sql-logs-table=pdcrdata.DBQLSqlTbl_hst \ -Dteradata-logs.log-date-column=LogDate \ -Dteradata-logs.utility-logs-table=pdcrdata.DBQLUtilityTbl_hst \ -Dteradata-logs.res-usage-scpu-table=pdcrdata.ResUsageScpu_hst \ -Dteradata-logs.res-usage-spma-table=pdcrdata.ResUsageSpma_hst

WindowsPowerShell

dwh-migration-dumper ` --connector teradata-logs ` --driver path\terajdbc4.jar ` --host HOST ` --assessment ` --user USER ` --password PASSWORD ` "-Dteradata-logs.query-logs-table=pdcrdata.QryLogV_hst" ` "-Dteradata-logs.sql-logs-table=pdcrdata.DBQLSqlTbl_hst" ` "-Dteradata-logs.log-date-column=LogDate" ` "-Dteradata-logs.utility-logs-table=pdcrdata.DBQLUtilityTbl_hst" ` "-Dteradata-logs.res-usage-scpu-table=pdcrdata.ResUsageScpu_hst" ` "-Dteradata-logs.res-usage-spma-table=pdcrdata.ResUsageSpma_hst"

De forma predeterminada, la herramienta dwh-migration-dumper extrae los últimos siete días de los registros de consulta.

Google recomienda que proporciones al menos dos semanas de registros de consultas para poder ver estadísticas más detalladas. Puedes especificar un intervalo de tiempo personalizado con las marcas --query-log-start y --query-log-end. Por ejemplo:

dwh-migration-dumper \ --connector teradata-logs \ --driver path/terajdbc4.jar \ --host HOST \ --assessment \ --user USER \ --password PASSWORD \ --query-log-start "2023-01-01 00:00:00" \ --query-log-end "2023-01-15 00:00:00"

También puedes generar varios archivos ZIP que contengan registros de consulta que abarquen diferentes períodos y proporcionarlos todos para su evaluación.

Redshift

Requisitos

- Una máquina conectada a tu almacén de datos de origen de Amazon Redshift

- Una cuenta Google Cloud con un bucket de Cloud Storage para almacenar los datos

- Un conjunto de datos de BigQuery vacío para almacenar los resultados.

- Lee los permisos del conjunto de datos para ver los resultados

- Recomendado: Acceso de superusuario a la base de datos cuando se usa la herramienta de extracción para acceder a tablas del sistema

Ejecuta la herramienta dwh-migration-dumper

Descarga la herramienta de extracción de línea de comandos de dwh-migration-dumper.

Descarga el archivo SHA256SUMS.txt y ejecuta el siguiente comando para verificar la precisión del archivo ZIP:

Bash

sha256sum --check SHA256SUMS.txt

WindowsPowerShell

(Get-FileHash RELEASE_ZIP_FILENAME).Hash -eq ((Get-Content SHA256SUMS.txt) -Split " ")[0]

Reemplaza RELEASE_ZIP_FILENAME por el nombre del archivo ZIP descargado de la versión de la herramienta de extracción de línea de comandos de dwh-migration-dumper, por ejemplo, dwh-migration-tools-v1.0.52.zip.

El resultado True confirma la verificación correcta de la suma de verificación.

El resultado False indica un error de verificación. Asegúrate de que los archivos de suma de comprobación y ZIP se descarguen de la misma versión de actualización y se coloquen en el mismo directorio.

Para obtener detalles sobre cómo usar la herramienta dwh-migration-dumper, consulta la página Genera metadatos.

Usa la herramienta dwh-migration-dumper para extraer registros y metadatos de tu almacén de datos de Amazon Redshift como dos archivos ZIP.

Ejecuta los siguientes comandos en una máquina con acceso al almacén de datos de origen para generar los archivos.

Genera el archivo ZIP de metadatos:

dwh-migration-dumper \ --connector redshift \ --database DATABASE \ --driver PATH/redshift-jdbc42-VERSION.jar \ --host host.region.redshift.amazonaws.com \ --assessment \ --user USER \ --iam-profile IAM_PROFILE_NAME

Genera el archivo ZIP que contiene los registros de consultas:

dwh-migration-dumper \ --connector redshift-raw-logs \ --database DATABASE \ --driver PATH/redshift-jdbc42-VERSION.jar \ --host host.region.redshift.amazonaws.com \ --assessment \ --user USER \ --iam-profile IAM_PROFILE_NAME

Reemplaza lo siguiente:

DATABASE: el nombre de la base de datos a la que te conectarás.PATH: Es la ruta absoluta o relativa al archivo JAR del controlador que se usará para esta conexión.VERSION: La versión de tu controladorUSER: el nombre de usuario que se usará para la conexión de la base de datosIAM_PROFILE_NAME: El nombre del perfil de IAM de Amazon Redshift. Se requiere para la autenticación de Amazon Redshift y para el acceso a la API de AWS. Para obtener la descripción de los clústeres de Amazon Redshift, usa la API de AWS.

De forma predeterminada, Amazon Redshift almacena de tres a cinco días de registros de consultas.

De forma predeterminada, la herramienta dwh-migration-dumper extrae los últimos siete días de los registros de consulta.

Google recomienda que proporciones al menos dos semanas de registros de consultas para poder ver estadísticas más detalladas. Es posible que debas ejecutar la herramienta de extracción varias veces durante dos semanas para obtener los mejores resultados. Puedes especificar un rango personalizado con las marcas --query-log-start y --query-log-end.

Por ejemplo:

dwh-migration-dumper \ --connector redshift-raw-logs \ --database DATABASE \ --driver PATH/redshift-jdbc42-VERSION.jar \ --host host.region.redshift.amazonaws.com \ --assessment \ --user USER \ --iam-profile IAM_PROFILE_NAME \ --query-log-start "2023-01-01 00:00:00" \ --query-log-end "2023-01-02 00:00:00"

También puedes generar varios archivos ZIP que contengan registros de consulta que abarquen diferentes períodos y proporcionarlos todos para su evaluación.

Redshift Serverless

Requisitos

- Una máquina conectada a tu almacén de datos de origen de Amazon Redshift Serverless

- Una cuenta Google Cloud con un bucket de Cloud Storage para almacenar los datos

- Un conjunto de datos de BigQuery vacío para almacenar los resultados.

- Lee los permisos del conjunto de datos para ver los resultados

- Recomendado: Acceso de superusuario a la base de datos cuando se usa la herramienta de extracción para acceder a tablas del sistema

Ejecuta la herramienta dwh-migration-dumper

Descarga la herramienta de extracción de línea de comandos de dwh-migration-dumper.

Para obtener detalles sobre cómo usar la herramienta dwh-migration-dumper, consulta la página Genera metadatos.

Usa la herramienta dwh-migration-dumper para extraer registros de uso y metadatos de tu espacio de nombres de Amazon Redshift Serverless como dos archivos ZIP. Ejecuta los siguientes comandos en una máquina con acceso al almacén de datos de origen para generar los archivos.

Genera el archivo ZIP de metadatos:

dwh-migration-dumper \ --connector redshift \ --database DATABASE \ --driver PATH/redshift-jdbc42-VERSION.jar \ --host host.region.redshift-serverless.amazonaws.com \ --assessment \ --user USER \ --iam-profile IAM_PROFILE_NAME

Genera el archivo ZIP que contiene los registros de consultas:

dwh-migration-dumper \ --connector redshift-serverless-logs \ --database DATABASE \ --driver PATH/redshift-jdbc42-VERSION.jar \ --host host.region.redshift-serverless.amazonaws.com \ --assessment \ --user USER \ --iam-profile IAM_PROFILE_NAME

Reemplaza lo siguiente:

DATABASE: el nombre de la base de datos a la que te conectarás.PATH: Es la ruta absoluta o relativa al archivo JAR del controlador que se usará para esta conexión.VERSION: La versión de tu controladorUSER: el nombre de usuario que se usará para la conexión de la base de datosIAM_PROFILE_NAME: El nombre del perfil de IAM de Amazon Redshift. Se requiere para la autenticación de Amazon Redshift y para el acceso a la API de AWS. Para obtener la descripción de los clústeres de Amazon Redshift, usa la API de AWS.

Amazon Redshift Serverless almacena los registros de uso durante siete días. Si se requiere un rango más amplio, Google recomienda extraer los datos varias veces durante un período más largo.

Snowflake

Requisitos

Debes cumplir con los siguientes requisitos para extraer metadatos y registros de consultas de Snowflake:

- Una máquina que se pueda conectar a tus instancias de Snowflake.

- Una cuenta de Google Cloud con un bucket de Cloud Storage para almacenar los datos.

- Un conjunto de datos de BigQuery vacío para almacenar los resultados. Como alternativa, puedes crear un conjunto de datos de BigQuery cuando creas el trabajo de evaluación con la Google Cloud IU de la consola.

- Usuario de Snowflake con acceso de

IMPORTED PRIVILEGESa la base de datosSnowflake. Te recomendamos que crees un usuarioSERVICEcon autenticación basada en un par de claves. Esto proporciona el método seguro para acceder a la plataforma de datos de Snowflake sin necesidad de generar tokens de MFA.- Para crear un usuario de servicio nuevo, sigue la guía oficial de Snowflake. Deberás generar el par de clave RSA y asignar la clave pública al usuario de Snowflake.

- El usuario del servicio debe tener el rol de

ACCOUNTADMINo un administrador de cuentas le debe otorgar un rol con los privilegios deIMPORTED PRIVILEGESen la base de datosSnowflake. - Como alternativa a la autenticación con par de claves, puedes usar la autenticación basada en contraseña. Sin embargo, a partir de agosto de 2025, Snowflake aplicará la MFA a todos los usuarios que utilicen contraseñas. Esto requiere que apruebes la notificación push de MFA cuando uses nuestra herramienta de extracción.

Ejecuta la herramienta dwh-migration-dumper

Descarga la herramienta de extracción de línea de comandos de dwh-migration-dumper.

Descarga el archivo SHA256SUMS.txt y ejecuta el siguiente comando para verificar la precisión del archivo ZIP:

Bash

sha256sum --check SHA256SUMS.txt

WindowsPowerShell

(Get-FileHash RELEASE_ZIP_FILENAME).Hash -eq ((Get-Content SHA256SUMS.txt) -Split " ")[0]

Reemplaza RELEASE_ZIP_FILENAME por el nombre del archivo ZIP descargado de la versión de la herramienta de extracción de línea de comandos de dwh-migration-dumper, por ejemplo, dwh-migration-tools-v1.0.52.zip.

El resultado True confirma la verificación correcta de la suma de verificación.

El resultado False indica un error de verificación. Asegúrate de que los archivos de suma de comprobación y ZIP se descarguen de la misma versión de actualización y se coloquen en el mismo directorio.

Para obtener detalles sobre cómo usar la herramienta dwh-migration-dumper, consulta la página Genera metadatos.

Usa la herramienta dwh-migration-dumper para extraer registros y metadatos del almacén de datos de Snowflake en dos archivos ZIP. Ejecuta los siguientes comandos en una máquina con acceso al almacén de datos de origen para generar los archivos.

Genera el archivo ZIP de metadatos:

dwh-migration-dumper \ --connector snowflake \ --host HOST_NAME \ --user USER_NAME \ --role ROLE_NAME \ --warehouse WAREHOUSE \ --assessment \ --private-key-file PRIVATE_KEY_PATH \ --private-key-password PRIVATE_KEY_PASSWORD

Genera el archivo ZIP que contiene los registros de consultas:

dwh-migration-dumper \ --connector snowflake-logs \ --host HOST_NAME \ --user USER_NAME \ --role ROLE_NAME \ --warehouse WAREHOUSE \ --query-log-start STARTING_DATE \ --query-log-end ENDING_DATE \ --assessment \ --private-key-file PRIVATE_KEY_PATH \ --private-key-password PRIVATE_KEY_PASSWORD

Reemplaza lo siguiente:

HOST_NAME: Es el nombre de host de tu instancia de Snowflake.USER_NAME: el nombre de usuario que se usará para la conexión a la base de datos, en la que el usuario debe tener los permisos de acceso que se detallan en la sección de requisitos.PRIVATE_KEY_PATH: Es la ruta de acceso a la clave privada RSA que se usa para la autenticación.PRIVATE_KEY_PASSWORD: (Opcional) Es la contraseña que se usó cuando se creó la clave privada RSA. Solo se requiere si la clave privada está encriptada.ROLE_NAME: (Opcional) el rol de usuario cuando se ejecuta la herramientadwh-migration-dumper, por ejemplo,ACCOUNTADMIN.WAREHOUSE: el almacén que se usa para realizar las operaciones de volcado. Si tienes varios almacenes virtuales, puedes especificar cualquier almacén para realizar esta consulta. La ejecución de esta consulta con los permisos de acceso detallados en la sección de requisitos extrae todos los artefactos del almacén de esta cuenta.STARTING_DATE: (Opcional) Se usa para indicar la fecha de inicio en un período de registros de consultas, escrito en el formatoYYYY-MM-DD.ENDING_DATE: (Opcional) se usa para indicar la fecha de finalización en un período de registros de consultas, escrito en el formatoYYYY-MM-DD.

También puedes generar varios archivos ZIP que contengan registros de consulta que abarquen diferentes períodos y proporcionarlos para su evaluación.

Oracle

Para solicitar comentarios o asistencia para esta función, envía un correo electrónico a bq-edw-migration-support@google.com.

Requisitos

Debes cumplir con los siguientes requisitos para extraer metadatos y registros de consultas de Oracle:

- Tu base de datos de Oracle debe ser la versión 11g R1 o una posterior.

- Una máquina que se pueda conectar a tus instancias de Oracle.

- Java 8 o una versión posterior

- Una cuenta de Google Cloud con un bucket de Cloud Storage para almacenar los datos.

- Un conjunto de datos de BigQuery vacío para almacenar los resultados. Como alternativa, puedes crear un conjunto de datos de BigQuery cuando creas el trabajo de evaluación con la Google Cloud IU de la consola.

- Un usuario común de Oracle con privilegios de SYSDBA

Ejecuta la herramienta dwh-migration-dumper

Descarga la herramienta de extracción de línea de comandos de dwh-migration-dumper.

Descarga el archivo SHA256SUMS.txt y ejecuta el siguiente comando para verificar la precisión del archivo ZIP:

sha256sum --check SHA256SUMS.txt

Para obtener detalles sobre cómo usar la herramienta dwh-migration-dumper, consulta la página Genera metadatos.

Usa la herramienta dwh-migration-dumper para extraer metadatos y estadísticas de rendimiento al archivo ZIP. De forma predeterminada, las estadísticas se extraen del AWR de Oracle, que requiere el paquete Oracle Tuning and Diagnostics. Si estos datos no están disponibles, dwh-migration-dumper usa STATSPACK en su lugar.

En el caso de las bases de datos de múltiples inquilinos, la herramienta dwh-migration-dumper se debe ejecutar en el contenedor raíz. Si lo ejecutas en una de las bases de datos conectables, faltarán estadísticas de rendimiento y metadatos sobre otras bases de datos conectables.

Genera el archivo ZIP de metadatos:

dwh-migration-dumper \ --connector oracle-stats \ --host HOST_NAME \ --port PORT \ --oracle-service SERVICE_NAME \ --assessment \ --driver JDBC_DRIVER_PATH \ --user USER_NAME \ --password

Reemplaza lo siguiente:

HOST_NAME: Es el nombre de host de tu instancia de Oracle.PORT: Es el número de puerto de la conexión. El valor predeterminado es 1521.SERVICE_NAME: Es el nombre del servicio de Oracle que se usará para la conexión.JDBC_DRIVER_PATH: Es la ruta de acceso absoluta o relativa al archivo JAR del controlador. Puedes descargar este archivo desde la página de descargas del controlador JDBC de Oracle. Debes seleccionar la versión del controlador que sea compatible con la versión de tu base de datos.USER_NAME: Es el nombre del usuario que se usa para conectarse a la instancia de Oracle. El usuario debe tener los permisos de acceso que se detallan en la sección de requisitos.

Hadoop / Cloudera

Para solicitar comentarios o asistencia para esta función, envía un correo electrónico a bq-edw-migration-support@google.com.

Requisitos

Debes tener lo siguiente para extraer metadatos de Cloudera:

- Una máquina que se pueda conectar a la API de Cloudera Manager

- Una cuenta de Google Cloud con un bucket de Cloud Storage para almacenar los datos.

- Un conjunto de datos de BigQuery vacío para almacenar los resultados. Como alternativa, puedes crear un conjunto de datos de BigQuery cuando crees el trabajo de evaluación.

Ejecuta la herramienta dwh-migration-dumper

Descarga la herramienta de extracción de línea de comandos de

dwh-migration-dumper.Descarga el archivo

SHA256SUMS.txt.En tu entorno de línea de comandos, verifica la precisión del archivo ZIP:

sha256sum --check SHA256SUMS.txt

Si deseas obtener detalles sobre cómo usar la herramienta

dwh-migration-dumper, consulta Genera metadatos para la traducción y la evaluación.Usa la herramienta

dwh-migration-dumperpara extraer metadatos y estadísticas de rendimiento en el archivo ZIP:dwh-migration-dumper \ --connector cloudera-manager \ --user USER_NAME \ --password PASSWORD \ --url URL_PATH \ --yarn-application-types "APP_TYPES" \ --pagination-page-size PAGE_SIZE \ --start-date START_DATE \ --end-date END_DATE \ --assessment

Reemplaza lo siguiente:

USER_NAME: Es el nombre del usuario que se conectará a tu instancia de Cloudera Manager.PASSWORD: Es la contraseña de tu instancia de Cloudera Manager.URL_PATH: Es la ruta de URL a la API de Cloudera Manager, por ejemplo,https://localhost:7183/api/v55/.APP_TYPES(opcional): Son los tipos de aplicaciones de YARN separados por comas que se vuelcan desde el clúster. El valor predeterminado esMAPREDUCE,SPARK,Oozie Launcher.PAGE_SIZE(opcional): Es la cantidad de registros por respuesta de Cloudera. El valor predeterminado es1000.START_DATE(opcional): Es la fecha de inicio de la volcado del historial en formato ISO 8601, por ejemplo,2025-05-29. El valor predeterminado es 90 días antes de la fecha actual.END_DATE(opcional): Es la fecha de finalización de la copia del historial en formato ISO 8601, por ejemplo,2025-05-30. El valor predeterminado es la fecha actual.

Usa Oozie en tu clúster de Cloudera

Si usas Oozie en tu clúster de Cloudera, puedes volcar el historial de trabajos de Oozie con el conector de Oozie. Puedes usar Oozie con la autenticación Kerberos o la autenticación básica.

Para la autenticación Kerberos, ejecuta lo siguiente:

kinit dwh-migration-dumper \ --connector oozie \ --url URL_PATH \ --assessment

Reemplaza lo siguiente:

URL_PATH(opcional): Es la ruta de URL del servidor de Oozie. Si no especificas la ruta de URL, se toma de la variable de entornoOOZIE_URL.

Para la autenticación básica, ejecuta lo siguiente:

dwh-migration-dumper \ --connector oozie \ --user USER_NAME \ --password PASSWORD \ --url URL_PATH \ --assessment

Reemplaza lo siguiente:

USER_NAME: Es el nombre del usuario de Oozie.PASSWORD: La contraseña del usuarioURL_PATH(opcional): Es la ruta de URL del servidor de Oozie. Si no especificas la ruta de URL, se toma de la variable de entornoOOZIE_URL.

Usa Airflow en tu clúster de Cloudera

Si usas Airflow en tu clúster de Cloudera, puedes volcar el historial de DAG con el conector de Airflow:

dwh-migration-dumper \ --connector airflow \ --user USER_NAME \ --password PASSWORD \ --url URL \ --driver "DRIVER_PATH" \ --start-date START_DATE \ --end-date END_DATE \ --assessment

Reemplaza lo siguiente:

USER_NAME: El nombre del usuario de AirflowPASSWORD: La contraseña del usuarioURL: Cadena de JDBC para la base de datos de AirflowDRIVER_PATH: Es la ruta de acceso al controlador JDBC.START_DATE(opcional): Es la fecha de inicio del volcado del historial en formato ISO 8601.END_DATE(opcional): Es la fecha de finalización de la volcado del historial en formato ISO 8601.

Usa Hive en tu clúster de Cloudera

Para usar el conector de Hive, consulta la pestaña Apache Hive.

Apache Hive

Requisitos

- Una máquina conectada a tu almacén de datos de origen de Apache Hive (la evaluación de migración de BigQuery admite Hive en Tez y MapReduce, y admite versiones de Apache Hive entre 2.2 y 3.1, inclusive)

- Una cuenta Google Cloud con un bucket de Cloud Storage para almacenar los datos

- Un conjunto de datos de BigQuery vacío para almacenar los resultados.

- Lee los permisos del conjunto de datos para ver los resultados

- Acceso a tu almacén de datos de origen de Apache Hive para configurar la extracción de registros de consultas

- Estadísticas de tablas, particiones y columnas actualizadas

La evaluación de migración de BigQuery usa tablas, particiones y estadísticas de columnas para comprender tu almacén de datos de Apache Hive mejor y proporcionar estadísticas detalladas. Si la configuración hive.stats.autogather se establece como false en tu almacén de datos de origen de Apache Hive, Google recomienda habilitarla o actualizar las estadísticas de forma manual antes de ejecutar la herramienta de dwh-migration-dumper.

Ejecuta la herramienta dwh-migration-dumper

Descarga la herramienta de extracción de línea de comandos de dwh-migration-dumper.

Descarga el archivo SHA256SUMS.txt y ejecuta el siguiente comando para verificar la precisión del archivo ZIP:

Bash

sha256sum --check SHA256SUMS.txt

WindowsPowerShell

(Get-FileHash RELEASE_ZIP_FILENAME).Hash -eq ((Get-Content SHA256SUMS.txt) -Split " ")[0]

Reemplaza RELEASE_ZIP_FILENAME por el nombre del archivo ZIP descargado de la versión de la herramienta de extracción de línea de comandos de dwh-migration-dumper, por ejemplo, dwh-migration-tools-v1.0.52.zip.

El resultado True confirma la verificación correcta de la suma de verificación.

El resultado False indica un error de verificación. Asegúrate de que los archivos de suma de comprobación y ZIP se descarguen de la misma versión de actualización y se coloquen en el mismo directorio.

Si deseas obtener detalles sobre cómo usar la herramienta dwh-migration-dumper, consulta Genera metadatos para la traducción y la evaluación.

Usa la herramienta dwh-migration-dumper para generar metadatos de tu almacén de datos de Hive como un archivo ZIP.

Sin autenticación

Para generar el archivo ZIP de metadatos, ejecuta el siguiente comando en una máquina que tenga acceso al almacén de datos de origen:

dwh-migration-dumper \ --connector hiveql \ --database DATABASES \ --host hive.cluster.host \ --port 9083 \ --assessment

Con autenticación de Kerberos

Para autenticarte en el almacén de metadatos, accede como un usuario que tenga acceso al almacén de metadatos de Apache Hive y genera un ticket de Kerberos. Luego, genera el archivo ZIP de metadatos con el siguiente comando:

JAVA_OPTS="-Djavax.security.auth.useSubjectCredsOnly=false" \ dwh-migration-dumper \ --connector hiveql \ --database DATABASES \ --host hive.cluster.host \ --port 9083 \ --hive-kerberos-url PRINCIPAL/HOST \ -Dhiveql.rpc.protection=hadoop.rpc.protection \ --assessment

Reemplaza lo siguiente:

DATABASES: Es la lista separada por comas de los nombres de las bases de datos que se extraerán. Si no se proporciona, se extraen todas las bases de datos.PRINCIPAL: Es el principal de Kerberos al que se emite el ticket.HOST: Es el nombre de host de Kerberos para el que se emite el ticket.hadoop.rpc.protection: Es la calidad de protección (QOP) del nivel de configuración de la capa de seguridad y autenticación simple (SASL), igual al valor del parámetrohadoop.rpc.protectiondentro del archivo/etc/hadoop/conf/core-site.xml, con uno de los siguientes valores:authenticationintegrityprivacy

Extrae registros de consultas con el hook de registro hadoop-migration-assessment

Para extraer registros de consultas, sigue estos pasos:

- Sube el hook de registro

hadoop-migration-assessment. - Configura las propiedades del hook de registro.

- Verifica el hook de registro.

Sube el hook de registro hadoop-migration-assessment

Descarga el hook de registro de extracción de registros de consulta

hadoop-migration-assessmentque contiene el archivo JAR del hook de registro de Hive.Extrae el archivo JAR.

Si necesitas auditar la herramienta para asegurarte de que cumpla con los requisitos de cumplimiento, revisa el código fuente del repositorio de GitHub del hook de registro

hadoop-migration-assessmenty compila tu propio objeto binario.Copia el archivo JAR en la carpeta de la biblioteca auxiliar en todos los clústeres en los que planeas habilitar el registro de consultas. Según tu proveedor, debes ubicar la carpeta de la biblioteca auxiliar en la configuración del clúster y transferir el archivo JAR a la carpeta de la biblioteca auxiliar en el clúster de Hive.

Establece las propiedades de configuración para el hook de registro

hadoop-migration-assessment. Según tu proveedor de Hadoop, debes usar la consola de IU para editar la configuración del clúster. Modifica el archivo/etc/hive/conf/hive-site.xmlo aplica la configuración con el administrador de configuración.

Configura propiedades

Si ya tienes otros valores para las siguientes claves de configuración, agrega la configuración mediante una coma (,). A fin de configurar el hook de registro hadoop-migration-assessment, se requiere la siguiente configuración:

hive.exec.failure.hooks:com.google.cloud.bigquery.dwhassessment.hooks.MigrationAssessmentLoggingHookhive.exec.post.hooks:com.google.cloud.bigquery.dwhassessment.hooks.MigrationAssessmentLoggingHookhive.exec.pre.hooks:com.google.cloud.bigquery.dwhassessment.hooks.MigrationAssessmentLoggingHookhive.aux.jars.path: incluye la ruta al archivo JAR de hook de registro, por ejemplo,file://./HiveMigrationAssessmentQueryLogsHooks_deploy.jar dwhassessment.hook.base-directory: Es la ruta de acceso a la carpeta de salida de los registros de consulta. Por ejemplo,hdfs://tmp/logs/También puedes establecer las siguientes configuraciones opcionales:

dwhassessment.hook.queue.capacity: la capacidad de cola para los subprocesos de registro de eventos de consulta. El valor predeterminado es64.dwhassessment.hook.rollover-interval: la frecuencia con la que se debe realizar la transferencia del archivo. Por ejemplo,600sEl valor predeterminado es 3,600 segundos (1 hora).dwhassessment.hook.rollover-eligibility-check-interval: la frecuencia con la que se activa la verificación de elegibilidad de transferencia de archivos en segundo plano. Por ejemplo,600sEl valor predeterminado es 600 segundos (10 minutos).

Verifica el hook de registro

Después de reiniciar el proceso hive-server2, ejecuta una consulta de prueba y analiza los registros de depuración. Puedes ver el siguiente mensaje:

Logger successfully started, waiting for query events. Log directory is '[dwhassessment.hook.base-directory value]'; rollover interval is '60' minutes; rollover eligibility check is '10' minutes

El hook de registro crea una subcarpeta particionada por fecha en la carpeta configurada. El archivo Avro con eventos de consulta aparece en esa carpeta después del intervalo dwhassessment.hook.rollover-interval o la finalización del proceso hive-server2. Puedes buscar mensajes similares en tus registros de depuración para ver el estado de la operación de desplazamiento:

Updated rollover time for logger ID 'my_logger_id' to '2023-12-25T10:15:30'

Performed rollover check for logger ID 'my_logger_id'. Expected rollover time is '2023-12-25T10:15:30'

El desplazamiento se produce en los intervalos especificados o cuando cambia el día. Cuando la fecha cambia, el hook de registro también crea una subcarpeta nueva para esa fecha.

Google recomienda que proporciones al menos dos semanas de registros de consultas para poder ver estadísticas más detalladas.

También puedes generar carpetas que contengan registros de consulta de diferentes clústeres de Hive y proporcionarlos a todos para una sola evaluación.

Informatica

Para solicitar comentarios o asistencia para esta función, envía un correo electrónico a bq-edw-migration-support@google.com.

Requisitos

- Acceso al cliente de Informatica PowerCenter Repository Manager

- Una cuenta de Google Cloud con un bucket de Cloud Storage para almacenar los datos.

- Un conjunto de datos de BigQuery vacío para almacenar los resultados. Como alternativa, puedes crear un conjunto de datos de BigQuery cuando creas el trabajo de evaluación con la Google Cloud consola.

Requisito: Exportar archivos de objeto

Puedes usar la GUI de Informatica PowerCenter Repository Manager para exportar tus archivos de objetos. Para obtener más información, consulta Pasos para exportar objetos.

Como alternativa, también puedes ejecutar el comando pmrep para exportar tus archivos de objeto con los siguientes pasos:

- Ejecuta el comando

pmrep connectpara conectarte al repositorio:

pmrep connect -r `REPOSITORY_NAME` -d `DOMAIN_NAME` -n `USERNAME` -x `PASSWORD`

Reemplaza lo siguiente:

REPOSITORY_NAME: Nombre del repositorio al que deseas conectarteDOMAIN_NAME: Nombre del dominio del repositorioUSERNAME: Nombre de usuario para conectarse al repositorioPASSWORD: Contraseña del nombre de usuario

- Una vez que te conectes al repositorio, usa el comando

pmrep objectexportpara exportar los objetos requeridos:

pmrep objectexport -n `OBJECT_NAME` -o `OBJECT_TYPE` -f `FOLDER_NAME` -u `OUTPUT_FILE_NAME.xml`

Reemplaza lo siguiente:

OBJECT_NAME: Nombre de un objeto específico para exportarOBJECT_TYPE: Tipo de objeto del objeto especificadoFOLDER_NAME: Nombre de la carpeta que contiene el objeto que se exportaráOUTPUT_FILE_NAME: Nombre del archivo XML que contendrá la información del objeto

Sube registros de consultas y de metadatos a Cloud Storage

Una vez que hayas extraído los metadatos y los registros de consultas de tu almacén de datos, puedes subir los archivos a un bucket de Cloud Storage para continuar con la evaluación de la migración.

Teradata

Sube los metadatos y uno o más archivos ZIP que contengan registros de consulta a tu bucket de Cloud Storage. Para obtener más información sobre la creación de buckets y la carga de archivos a Cloud Storage, consulta Crea buckets y Sube objetos desde un sistema de archivos. El límite para el tamaño total sin comprimir de todos los archivos dentro del archivo ZIP de metadatos es de 50 GB.

Las entradas en todos los archivos ZIP que contienen registros de consultas se dividen en lo siguiente:

- Archivos de historial de consultas con el prefijo

query_history_ - Archivos de series temporales con los prefijos

utility_logs_,dbc.ResUsageScpu_ydbc.ResUsageSpma_

El límite para el tamaño total sin comprimir de todos los archivos del historial de consultas es de 5 TB. El límite para el tamaño total sin comprimir de todos los archivos de series temporales es de 1 TB.

En caso de que los registros de consultas se archiven en una base de datos diferente, consulta la descripción de las marcas -Dteradata-logs.query-logs-tabley -Dteradata-logs.sql-logs-table antes en esta sección, en la que se explica cómo proporcionar una ubicación alternativa para los registros de consultas.

Redshift

Sube los metadatos y uno o más archivos ZIP que contengan registros de consulta a tu bucket de Cloud Storage. Para obtener más información sobre la creación de buckets y la carga de archivos a Cloud Storage, consulta Crea buckets y Sube objetos desde un sistema de archivos. El límite para el tamaño total sin comprimir de todos los archivos dentro del archivo ZIP de metadatos es de 50 GB.

Las entradas en todos los archivos ZIP que contienen registros de consultas se dividen en lo siguiente:

- Archivos de historial de consultas con los prefijos

querytext_yddltext_ - Archivos de series temporales con los prefijos

query_queue_info_,wlm_query_yquerymetrics_

El límite para el tamaño total sin comprimir de todos los archivos del historial de consultas es de 5 TB. El límite para el tamaño total sin comprimir de todos los archivos de series temporales es de 1 TB.

Redshift Serverless

Sube los metadatos y uno o más archivos ZIP que contengan registros de consulta a tu bucket de Cloud Storage. Para obtener más información sobre la creación de buckets y la carga de archivos a Cloud Storage, consulta Crea buckets y Sube objetos desde un sistema de archivos.

Snowflake

Sube los metadatos y los archivos ZIP que contienen registros de consulta y los historiales de uso a tu bucket de Cloud Storage. Cuando subas estos archivos a Cloud Storage, se deben cumplir los siguientes requisitos:

- El tamaño total sin comprimir de todos los archivos dentro del archivo ZIP de metadatos debe ser inferior a 50 GB.

- El archivo ZIP de metadatos y el archivo ZIP que contiene registros de consulta deben subirse a una carpeta de Cloud Storage. Si tienes varios archivos ZIP con registros de consultas no superpuestos, puedes subirlos todos.

- Debes subir todos los archivos a la misma carpeta de Cloud Storage.

- Debes subir todos los archivos ZIP de metadatos y registros de consultas exactamente como los genera la herramienta

dwh-migration-dumper. No los extraigas, combines ni modifiques de ningún modo. - El tamaño total sin comprimir de todos los archivos del historial de consultas debe ser inferior a 5 TB.

Para obtener más información sobre la creación de buckets y la carga de archivos a Cloud Storage, consulta Crea buckets y Sube objetos desde un sistema de archivos.

Oracle

Para solicitar comentarios o asistencia para esta función, envía un correo electrónico a bq-edw-migration-support@google.com.

Sube el archivo ZIP que contiene metadatos y estadísticas de rendimiento a un bucket de Cloud Storage. De forma predeterminada, el nombre del archivo ZIP es dwh-migration-oracle-stats.zip, pero puedes personalizarlo especificándolo en la marca --output. El límite para el tamaño total sin comprimir de todos los archivos dentro del archivo ZIP es de 50 GB.

Para obtener más información sobre la creación de buckets y la carga de archivos a Cloud Storage, consulta Crea buckets y Sube objetos desde un sistema de archivos.

Hadoop / Cloudera

Para solicitar comentarios o asistencia para esta función, envía un correo electrónico a bq-edw-migration-support@google.com.

Sube el archivo ZIP que contiene metadatos y estadísticas de rendimiento a un bucket de Cloud Storage. De forma predeterminada, el nombre del archivo ZIP es dwh-migration-cloudera-manager-RUN_DATE.zip (por ejemplo, dwh-migration-cloudera-manager-20250312T145808.zip), pero puedes personalizarlo con la marca --output. El límite para el tamaño total sin comprimir de todos los archivos dentro del archivo ZIP es de 50 GB.

Para obtener más información sobre la creación de buckets y la carga de archivos a Cloud Storage, consulta Crea un bucket y Sube objetos desde un sistema de archivos.

Apache Hive

Sube los metadatos y las carpetas que contienen registros de consultas de uno o varios clústeres de Hive a tu bucket de Cloud Storage. Para obtener más información sobre la creación de buckets y la carga de archivos a Cloud Storage, consulta Crea buckets y Sube objetos desde un sistema de archivos.

El límite para el tamaño total sin comprimir de todos los archivos dentro del archivo ZIP de metadatos es de 50 GB.

Puedes usar el conector de Cloud Storage para copiar registros de consultas directamente a la carpeta de Cloud Storage. Las carpetas que contienen subcarpetas con registros de consultas se deben subir a la misma carpeta de Cloud Storage, en la que se sube el archivo ZIP de metadatos.

Las carpetas de registros de consultas tienen archivos del historial de consultas con el prefijo dwhassessment_. El límite para el tamaño total sin comprimir de todos los archivos del historial de consultas es de 5 TB.

Informatica

Para solicitar comentarios o asistencia para esta función, envía un correo electrónico a bq-edw-migration-support@google.com.

Sube un archivo ZIP que contenga los objetos de tu repositorio XML de Informatica a un bucket de Cloud Storage. Este archivo ZIP también debe incluir un archivo compilerworks-metadata.yaml que contenga lo siguiente:

product: arguments: "ConnectorArguments{connector=informatica, assessment=true}"

El límite para el tamaño total sin comprimir de todos los archivos dentro del archivo ZIP es de 50 GB.

Para obtener más información sobre la creación de buckets y la carga de archivos a Cloud Storage, consulta Crea buckets y Sube objetos desde un sistema de archivos.

Ejecuta una evaluación de migración de BigQuery

Sigue estos pasos para ejecutar la evaluación de migración de BigQuery. En estos pasos, se supone que subiste los archivos de metadatos a un bucket de Cloud Storage, como se describe en la sección anterior.

Permisos necesarios

Para habilitar el Servicio de migración de BigQuery, necesitas los siguientes permisos de Identity and Access Management (IAM):

resourcemanager.projects.getresourcemanager.projects.updateserviceusage.services.enableserviceusage.services.get

Para acceder al Servicio de migración de BigQuery y usarlo, necesitas los siguientes permisos en el proyecto:

bigquerymigration.workflows.createbigquerymigration.workflows.getbigquerymigration.workflows.listbigquerymigration.workflows.deletebigquerymigration.subtasks.getbigquerymigration.subtasks.list

Para ejecutar el servicio de migración de BigQuery, necesitas los siguientes permisos adicionales.

Permiso para acceder a los buckets de Cloud Storage para archivos de entrada y salida, sigue estos pasos:

storage.objects.geten el bucket de origen de Cloud Storagestorage.objects.listen el bucket de origen de Cloud Storagestorage.objects.createen el bucket de destino de Cloud Storagestorage.objects.deleteen el bucket de destino de Cloud Storagestorage.objects.updateen el bucket de destino de Cloud Storagestorage.buckets.getstorage.buckets.list

Permiso para leer y actualizar el conjunto de datos de BigQuery en el que el Servicio de migración de BigQuery escribe los resultados:

bigquery.datasets.updatebigquery.datasets.getbigquery.datasets.createbigquery.datasets.deletebigquery.jobs.createbigquery.jobs.deletebigquery.jobs.listbigquery.jobs.updatebigquery.tables.createbigquery.tables.getbigquery.tables.getDatabigquery.tables.listbigquery.tables.updateData

Para compartir el informe de Looker Studio con un usuario, debes otorgarle los siguientes roles:

roles/bigquery.dataViewerroles/bigquery.jobUser

Si quieres personalizar este documento para usar tu propio proyecto y usuario en los comandos, edita estas variables:

PROJECT,

USER_EMAIL.

Crea un rol personalizado con los permisos necesarios para usar la evaluación de migración de BigQuery:

gcloud iam roles create BQMSrole \ --project=PROJECT \ --title=BQMSrole \ --permissions=bigquerymigration.subtasks.get,bigquerymigration.subtasks.list,bigquerymigration.workflows.create,bigquerymigration.workflows.get,bigquerymigration.workflows.list,bigquerymigration.workflows.delete,resourcemanager.projects.update,resourcemanager.projects.get,serviceusage.services.enable,serviceusage.services.get,storage.objects.get,storage.objects.list,storage.objects.create,storage.objects.delete,storage.objects.update,bigquery.datasets.get,bigquery.datasets.update,bigquery.datasets.create,bigquery.datasets.delete,bigquery.tables.get,bigquery.tables.create,bigquery.tables.updateData,bigquery.tables.getData,bigquery.tables.list,bigquery.jobs.create,bigquery.jobs.update,bigquery.jobs.list,bigquery.jobs.delete,storage.buckets.list,storage.buckets.get

Otórgale el rol personalizado BQMSrole a un usuario:

gcloud projects add-iam-policy-binding \ PROJECT \ --member=user:USER_EMAIL \ --role=projects/PROJECT/roles/BQMSrole

Otorga los roles necesarios a un usuario con el que deseas compartir el informe:

gcloud projects add-iam-policy-binding \ PROJECT \ --member=user:USER_EMAIL \ --role=roles/bigquery.dataViewer gcloud projects add-iam-policy-binding \ PROJECT \ --member=user:USER_EMAIL \ --role=roles/bigquery.jobUser

Ubicaciones admitidas

La función de evaluación de migración de BigQuery se admite en dos tipos de ubicaciones:

Una región es un lugar geográfico específico, como Londres.

Una multirregión es un área geográfica grande, como los Estados Unidos, que contiene dos o más regiones. Las ubicaciones multirregionales pueden proporcionar cuotas más grandes que las regiones individuales.

Para obtener más información sobre las regiones y zonas, consulta Geografía y regiones.

Regiones

En la siguiente tabla, se enumeran las regiones de América en las que está disponible la evaluación de la migración de BigQuery.| Descripción de la región | Nombre de la región | Detalles |

|---|---|---|

| Columbus, Ohio | us-east5 |

|

| Dallas | us-south1 |

|

| Iowa | us-central1 |

|

| Carolina del Sur | us-east1 |

|

| Virginia del Norte | us-east4 |

|

| Oregón | us-west1 |

|

| Los Ángeles | us-west2 |

|

| Salt Lake City | us-west3 |

| Descripción de la región | Nombre de la región | Detalles |

|---|---|---|

| Singapur | asia-southeast1 |

|

| Tokio | asia-northeast1 |

| Descripción de la región | Nombre de la región | Detalles |

|---|---|---|

| Bélgica | europe-west1 |

|

| Finlandia | europe-north1 |

|

| Fráncfort | europe-west3 |

|

| Londres | europe-west2 |

|

| Madrid | europe-southwest1 |

|

| Países Bajos | europe-west4 |

|

| París | europe-west9 |

|

| Turín | europe-west12 |

|

| Varsovia | europe-central2 |

|

| Zúrich | europe-west6 |

|

Multirregiones

En la siguiente tabla, se enumeran las multirregiones en las que está disponible la evaluación de migración de BigQuery.| Descripción de la multirregión | Nombre de la multirregión |

|---|---|

| Centros de datos dentro de los estados miembros de la Unión Europea | EU |

| Centros de datos en Estados Unidos | US |

Antes de comenzar

Antes de ejecutar la evaluación, debes habilitar la API de BigQuery Migration y crear un conjunto de datos de BigQuery para almacenar los resultados de la evaluación.

Habilita la API de BigQuery Migration

Habilita la API de migración de BigQuery de la siguiente manera:

En la consola de Google Cloud , ve a la página API de BigQuery Migration.

Haga clic en Habilitar.

Crea un conjunto de datos para los resultados de la evaluación

La evaluación de migración de BigQuery escribe los resultados de la evaluación en las tablas de BigQuery. Antes de comenzar, crea un conjunto de datos para conservar estas tablas. Cuando compartes el informe de Looker Studio, también debes otorgar permiso a los usuarios para leer este conjunto de datos. Para obtener más información, consulta Haz que el informe esté disponible para los usuarios.

Ejecuta la evaluación de la migración

Console

En la consola de Google Cloud , ve a la página BigQuery.

En el menú de navegación, haz clic en Assessment.

Haz clic en Iniciar evaluación.

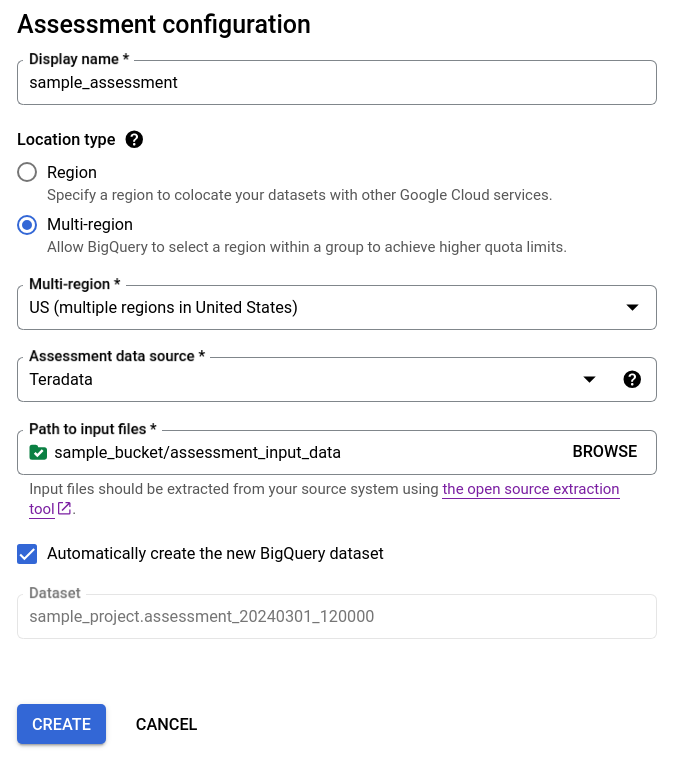

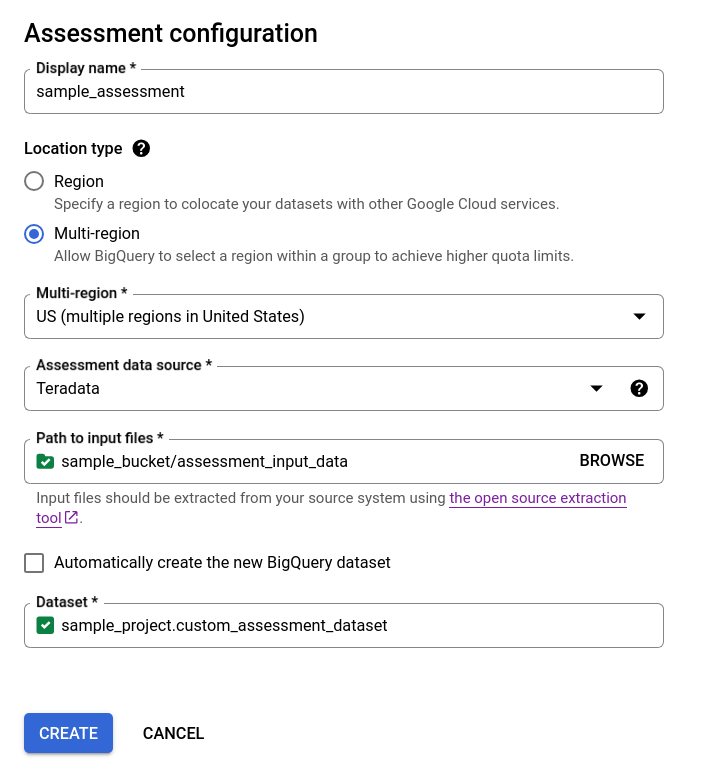

Completa el cuadro de diálogo de configuración de la evaluación.

- En Nombre visible, ingresa el nombre, que puede contener letras, números o guiones bajos. Este nombre solo se usa con fines de visualización y no tiene que ser único.

En la lista Ubicación de los datos, elige una ubicación para el trabajo de evaluación. El trabajo de evaluación debe estar ubicado en la misma ubicación que el bucket de Cloud Storage de entrada de los archivos extraídos y el conjunto de datos de BigQuery de salida. Sin embargo, si el bucket de Cloud Storage o el conjunto de datos de BigQuery se encuentran en una multirregión, el trabajo de evaluación debe estar en cualquiera de las regiones dentro de esta multirregión.

Si la ubicación de la evaluación es una multirregión

USoEU, la ubicación del bucket de Cloud Storage y la ubicación del conjunto de datos de BigQuery deben estar en la misma multirregión o en la ubicación dentro de esta multirregión. Para obtener más información sobre las restricciones de ubicación, consulta Consideraciones sobre la ubicación de los datos de carga de BigQuery.En Fuente de datos de la evaluación, elige tu almacén de datos.

En Ruta de acceso a los archivos de entrada, ingresa la ruta de acceso al bucket de Cloud Storage que contiene los archivos extraídos.

Para elegir cómo se almacenan los resultados de tu evaluación, haz una de las siguientes acciones:

- Mantén seleccionada la casilla de verificación Crea el conjunto de datos de BigQuery nuevo automáticamente para que el conjunto de datos de BigQuery se cree automáticamente. El nombre del conjunto de datos se genera automáticamente.

- Desmarca la casilla de verificación Crea el conjunto de datos de BigQuery nuevo automáticamente y elige el conjunto de datos de BigQuery vacío existente con el formato

projectId.datasetIdo crea un nombre de conjunto de datos nuevo. En esta opción, puedes elegir el nombre del conjunto de datos de BigQuery.

Opción 1: Generación automática del conjunto de datos de BigQuery (opción predeterminada)

Opción 2: Creación manual del conjunto de datos de BigQuery:

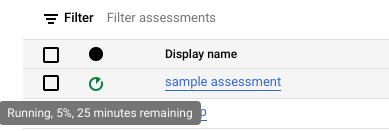

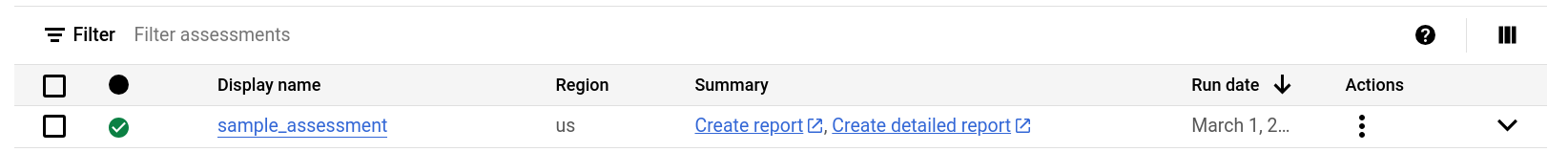

Haz clic en Crear. Puedes ver el estado del trabajo en la lista de trabajos de evaluación.

Mientras se ejecuta la evaluación, puedes verificar su progreso y el tiempo estimado para completarla en la sugerencia sobre herramientas del ícono de estado.

Mientras se ejecuta la evaluación, puedes hacer clic en el vínculo Ver informe en la lista de trabajos de evaluación para ver el informe de evaluación con datos parciales en Looker Studio. Es posible que el vínculo Ver informe tarde un poco en aparecer mientras se ejecuta la evaluación. El informe se abrirá en una pestaña nueva.

El informe se actualiza con datos nuevos a medida que se procesan. Actualiza la pestaña con el informe o vuelve a hacer clic en Ver informe para ver el informe actualizado.

Cuando se complete la evaluación, haz clic en Ver informe para ver el informe de evaluación completo en Looker Studio. El informe se abrirá en una pestaña nueva.

API

Llama al método create con un flujo de trabajo definido.

Luego, llama al método start para iniciar el flujo de trabajo de evaluación.

La evaluación crea tablas en el conjunto de datos de BigQuery que creaste antes. Puedes consultar estos metadatos para obtener información sobre las tablas y las consultas que se usan en tu almacén de datos existente. Para obtener información sobre los archivos de salida de la traducción, consulta Traductor de SQL por lotes.

Resultado agregado de la evaluación que se puede compartir

Para las evaluaciones de Amazon Redshift, Teradata y Snowflake, además del conjunto de datos de BigQuery creado anteriormente, el flujo de trabajo crea otro conjunto de datos ligero con el mismo nombre y el sufijo _shareableRedactedAggregate. Este conjunto de datos contiene datos altamente agregados que se derivan del conjunto de datos de salida y no contiene información de identificación personal (PII).

Para encontrar, inspeccionar y compartir de forma segura el conjunto de datos con otros usuarios, consulta Cómo consultar las tablas de resultados de la evaluación de la migración.

La función está activada de forma predeterminada, pero puedes inhabilitarla con la API pública.

Detalles de la evaluación

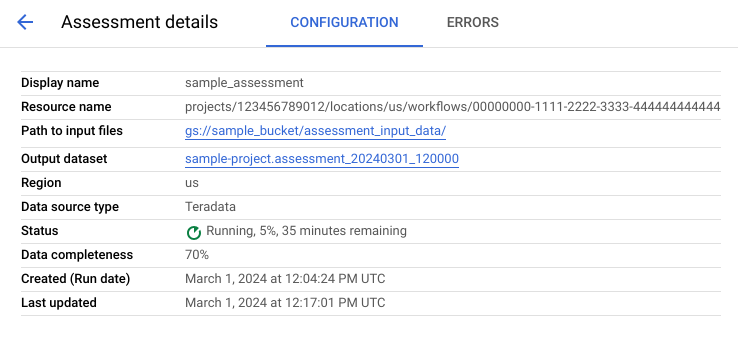

Para ver la página Detalles de la evaluación, haz clic en el nombre visible en la lista de trabajos de evaluación.

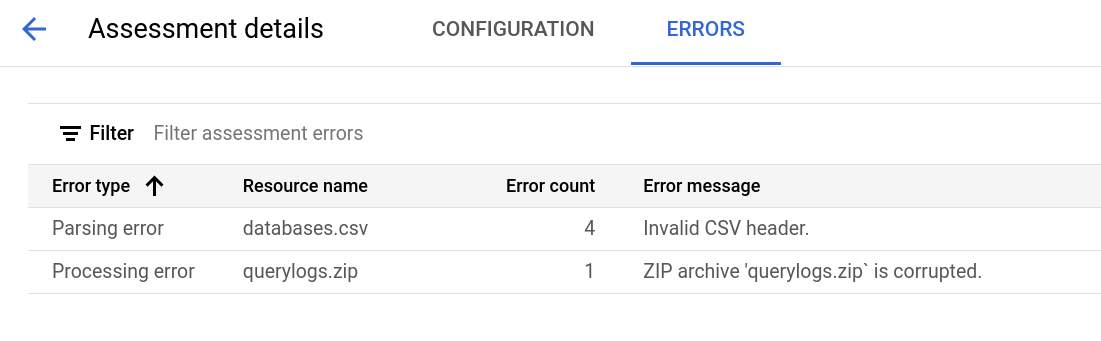

La página de detalles de la evaluación contiene la pestaña Configuración, en la que puedes ver más información sobre un trabajo de evaluación, y la pestaña Errores, en la que puedes revisar los errores que se produjeron durante el procesamiento de la evaluación.

Consulta la pestaña Configuración para ver las propiedades de la evaluación.

Consulta la pestaña Errores para ver los errores que se produjeron durante el procesamiento de la evaluación.

Revisa y comparte el informe de Looker Studio

Una vez que se completa la tarea de evaluación, puedes crear y compartir un informe de Looker Studio de los resultados.

Revisa el informe

Haz clic en el vínculo Ver informe que se encuentra junto a la tarea de evaluación individual. El informe de Looker Studio se abre en una pestaña nueva, en modo de vista previa. Puedes usar el modo de vista previa para revisar el contenido del informe antes de compartirlo.

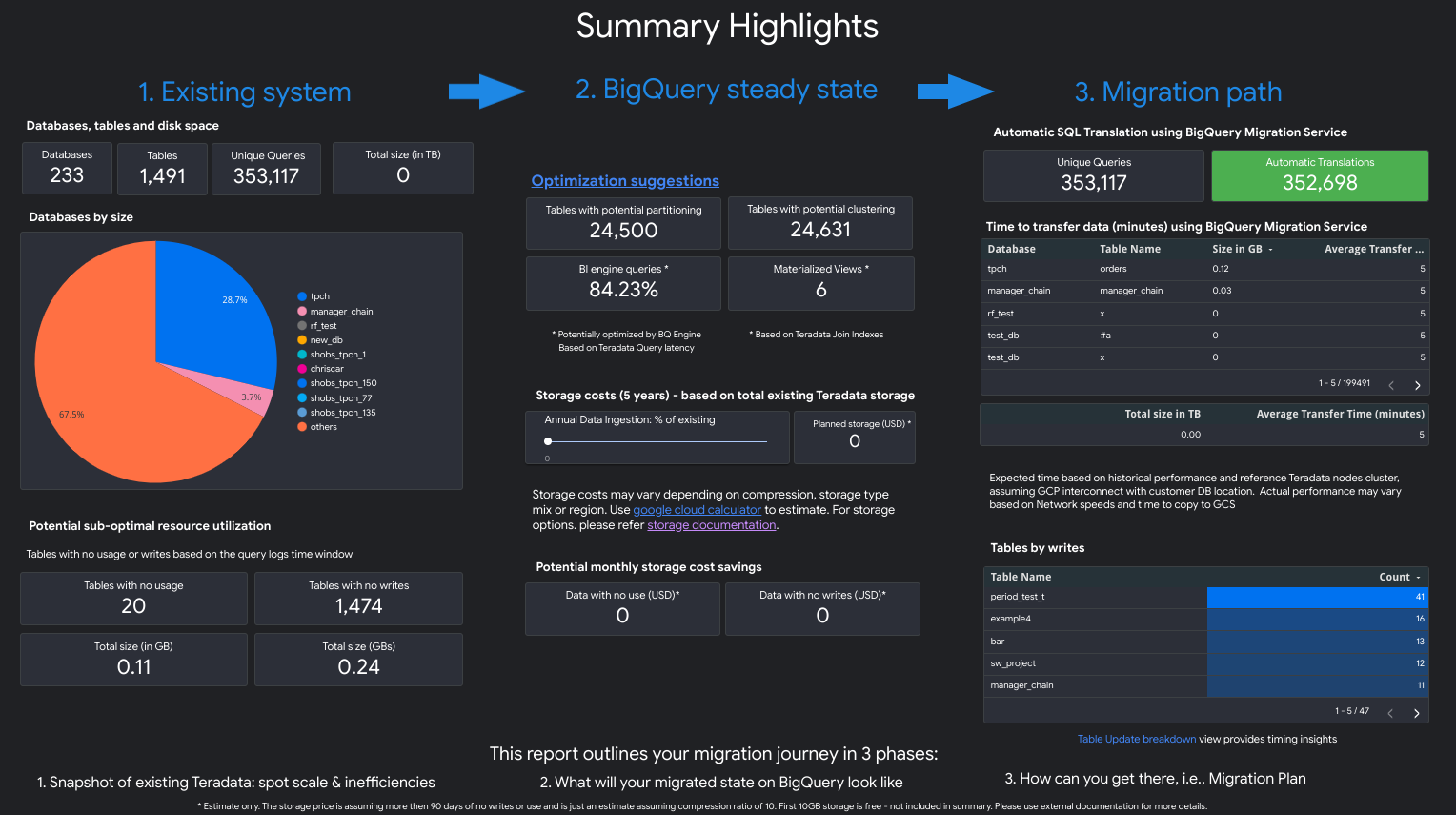

El informe es similar a la siguiente captura de pantalla:

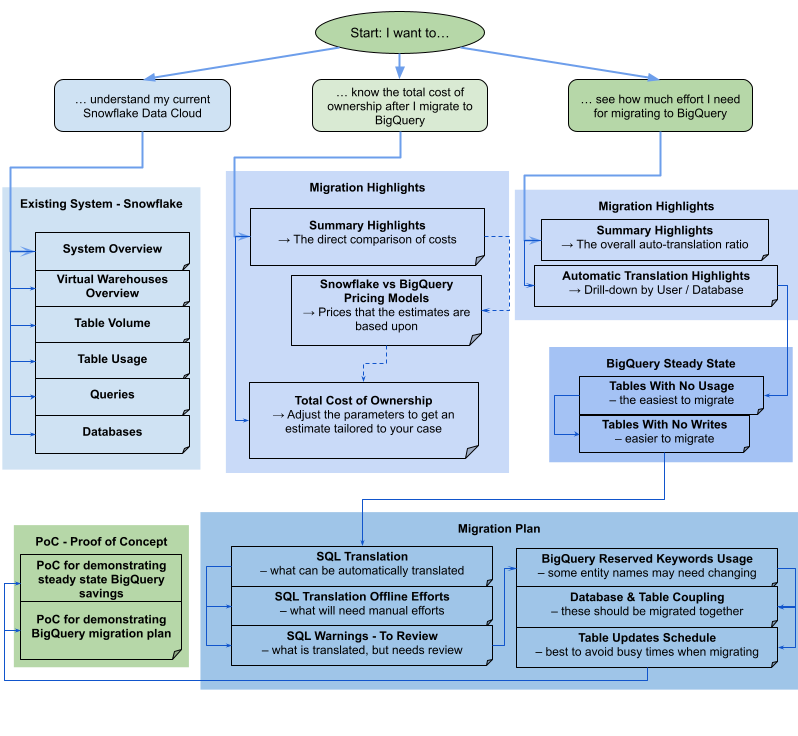

Para ver qué vistas se encuentran en el informe, selecciona tu almacén de datos:

Teradata

El informe es una narrativa de tres partes que está precedida por una página de puntos destacados de resumen. Esa página incluye las siguientes secciones:

- Sistema existente. En esta sección, se incluye una instantánea del sistema y el uso de Teradata existentes, incluida la cantidad de bases de datos, esquemas, tablas y el tamaño total en TB. También se enumeran los esquemas por tamaño y se apunta al posible uso de recursos deficientes (tablas sin escrituras o pocas lecturas).

- Transformaciones de estado estable de BigQuery (sugerencias). En esta sección, se muestra cómo se verá el sistema en BigQuery después de la migración. Incluye sugerencias para optimizar las cargas de trabajo en BigQuery (y evitar el desperdicio).

- Plan de migración. En esta sección, se proporciona información sobre el esfuerzo de migración en sí, por ejemplo, pasar del sistema existente al estado estable de BigQuery. En esta sección, se incluye el recuento de las consultas que se tradujeron automáticamente y el tiempo estimado para trasladar cada tabla a BigQuery.

Los detalles de cada sección incluyen lo siguiente:

Sistema existente

- Procesamiento y consultas

- Uso de CPU:

- Mapa de calor del uso promedio de CPU por hora (vista general del uso de recursos del sistema)

- Consultas por hora y día con uso de CPU

- Consultas por tipo (lectura/escritura) con uso de CPU

- Aplicaciones con uso de CPU

- Superposición del uso de CPU por hora con el rendimiento de consultas por hora promedio y el rendimiento promedio de las aplicaciones por hora

- Consulta histogramas por tipo y duración de las consultas

- Vista de detalles de las aplicaciones (app, usuario, consultas únicas, desglose de informes y ETL)

- Uso de CPU:

- Descripción general del almacenamiento

- Bases de datos por volumen, vistas y tasas de acceso

- Tablas con tasas de acceso de los usuarios, consultas, escrituras y creación de tablas temporales

- Aplicaciones: Tasas de acceso y direcciones IP

Transformaciones de estado estable de BigQuery (sugerencias)

- Los índices de unión se convirtieron en vistas materializadas

- Agrupación en clústeres y partición de candidatos según los metadatos y el uso

- Consultas de baja latencia identificadas como candidatas para BigQuery BI Engine

- Columnas configuradas con valores predeterminados que usan la función de descripción de la columna para almacenar valores predeterminados

- Los índices únicos en Teradata (para evitar filas con claves que no sean únicas en una tabla) usan tablas de etapa de pruebas y una instrucción

MERGEpara insertar solo registros únicos en las tablas de destino y, luego, descartar los duplicados. - Consultas restantes y esquema traducido tal como está

Plan de migración

- Vista detallada con consultas traducidas de forma automática

- Recuento de consultas totales con capacidad para filtrar por usuario, aplicación, tablas afectadas, tablas consultadas y tipo de consulta

- Buckets de consultas con patrones similares agrupados y se muestran juntos para que el usuario pueda ver la filosofía de traducción por tipos de consulta

- Consultas que requieren intervención humana

- Consultas con incumplimientos de estructura léxica de BigQuery

- Funciones y procedimientos definidos por el usuario

- Palabras clave reservadas de BigQuery

- Tablas programadas por escrituras y lecturas (para agruparlas a fin de moverlas)

- Migración de datos con el Servicio de transferencia de datos de BigQuery: Tiempo estimado de migración por tabla

La sección Sistema existente contiene las siguientes vistas:

- Descripción general del sistema

- La vista de descripción general del sistema proporciona las métricas de volumen de alto nivel de los componentes clave en el sistema existente durante un período específico. El cronograma que se evalúa depende de los registros que se analizaron en la evaluación de migración de BigQuery. Esta vista te brinda estadísticas rápidas sobre el uso del almacén de datos de origen, que puedes usar para la planificación de la migración.

- Volumen de tablas

- En la vista Volumen de tablas, se proporcionan estadísticas sobre las tablas y bases de datos más grandes que se encuentran en la evaluación de migración de BigQuery. Debido a que las tablas grandes pueden tardar más en extraerse del sistema de almacén de datos de origen, esta vista puede ser útil en la planificación y la secuencia de la migración.

- Uso de tablas

- En la vista Uso de tablas, se proporcionan estadísticas sobre qué tablas se usan mucho dentro del sistema de almacén de datos de origen. Las tablas muy usadas pueden ayudarte a comprender qué tablas pueden tener muchas dependencias y requieren una planificación adicional durante el proceso de migración.

- Aplicaciones

- En las vistas Uso de aplicaciones y Patrones de aplicaciones, se proporcionan estadísticas sobre las aplicaciones que se encontraron durante el procesamiento de los registros. Estas vistas permiten a los usuarios comprender el uso de aplicaciones específicas a lo largo del tiempo y el impacto en el uso de recursos. Durante una migración, es importante visualizar la transferencia y el consumo de datos para comprender mejor las dependencias del almacén de datos y analizar el impacto de mover varias aplicaciones dependientes juntas. La tabla Direcciones IP puede ser útil para identificar la aplicación exacta que usa el almacén de datos a través de conexiones de JDBC.

- Consultas

- La vista Consultas proporciona un desglose de los tipos de instrucciones de SQL ejecutadas y las estadísticas de su uso. Puedes usar el histograma de Tiempo y tipo de consulta para identificar los períodos bajos del uso del sistema y los momentos óptimos del día para transferir datos. También puedes usar esta vista para identificar las consultas que se ejecutan con frecuencia y los usuarios que invocan esas ejecuciones.

- Bases de datos

- La vista de bases de datos proporciona métricas sobre el tamaño, las tablas, las vistas y los procedimientos definidos en el sistema de almacén de datos de origen. Esta vista puede proporcionar estadísticas sobre el volumen de objetos que necesitas migrar.

- Acoplamiento de bases de datos

- La vista de acoplamiento de la base de datos proporciona una vista de alto nivel en las bases de datos y tablas a las que se accede en conjunto en una sola consulta. En esta vista, se puede mostrar a qué tablas y bases de datos se hace referencia con frecuencia y qué puedes usar para la planificación de la migración.

La sección Estado estable de BigQuery contiene las siguientes vistas:

- Tablas sin uso

- En la vista Tablas sin uso, se muestran las tablas en las que la evaluación de migración de BigQuery no pudo encontrar ningún uso durante el período de registros que se analizó. La falta de uso puede indicar que no necesitas transferir esa tabla a BigQuery durante la migración o que los costos de almacenamiento de datos en BigQuery pueden ser menores. Debes validar la lista de tablas sin usar, ya que podrían tener uso fuera del período de los registros, como una tabla que solo se usa una vez cada tres o seis meses.

- Tablas sin escritura

- En la vista Tablas sin escrituras, se muestran las tablas en las que la evaluación de migración de BigQuery no pudo encontrar ninguna actualización durante el período de registros que se analizó. La falta de escrituras puede indicar dónde se pueden reducir los costos de almacenamiento en BigQuery.

- Consultas de baja latencia

- La vista Consultas de baja latencia muestra una distribución de entornos de ejecución de consultas en función de los datos de registro analizados. Si el gráfico de distribución de la duración de la consulta muestra una gran cantidad de consultas con menos de 1 segundo en el entorno de ejecución, considera habilitar BigQuery BI Engine para acelerar la IE y otras cargas de trabajo de baja latencia.

- Vistas materializadas

- La vista materializada proporciona sugerencias de optimización adicionales para aumentar el rendimiento en BigQuery.

- Agrupamiento en clústeres y partición

En la vista Partitioning and Clustering, se muestran las tablas que se beneficiarían de la partición, el agrupamiento en clústeres o ambos.

Las sugerencias de metadatos se logran analizando el esquema del almacén de datos de origen (como la partición y la clave principal en la tabla de origen) y buscando el equivalente de BigQuery más cercano para lograr características de optimización similares.

Las sugerencias de cargas de trabajo se obtienen analizando los registros de consultas de origen. La recomendación se determina mediante el análisis de las cargas de trabajo, en especial las cláusulas

WHEREoJOINen los registros de consulta analizados.- Recomendación de agrupamiento en clústeres

En la vista Partición, se muestran las tablas que pueden tener más de 10,000 particiones, según su definición de restricción de partición. Estas tablas suelen ser buenas candidatas para el agrupamiento en clústeres de BigQuery, lo que permite particiones de tabla detalladas.

- Restricciones únicas

En la vista Restricciones únicas, se muestran las tablas

SETy los índices únicos definidos dentro del almacén de datos de origen. En BigQuery, se recomienda usar tablas de etapa de pruebas y una declaraciónMERGEpara insertar solo registros únicos en una tabla de destino. Usa el contenido de esta vista para determinar a qué tablas podrías tener que ajustar el ETL durante la migración.- Valores predeterminados/Restricciones de verificación

En esta vista, se muestran tablas que usan restricciones de verificación para establecer valores de columna predeterminados. En BigQuery, consulta Cómo especificar los valores predeterminados de la columna.

La sección Ruta de la migración del informe contiene las siguientes vistas:

- Traducción de SQL

- En la vista Traducción de SQL, se enumeran la cantidad y los detalles de las consultas que se convirtieron automáticamente con la evaluación de migración de BigQuery y que no requieren intervención manual. Por lo general, la traducción automática de SQL alcanza altas tasas de traducción si se proporcionan metadatos. Esta vista es interactiva y permite el análisis de consultas comunes y cómo se traducen.

- Esfuerzo sin conexión

- La vista Esfuerzo sin conexión captura las áreas que necesitan intervención manual, incluidas las UDF específicas y las posibles infracciones de sintaxis y estructura léxicas para las tablas o columnas.

- Palabras clave reservadas de BigQuery

- La vista Palabras clave reservadas de BigQuery muestra el uso detectado de palabras clave que tienen un significado especial en el lenguaje GoogleSQL y no se pueden usar como identificadores, a menos que estén encerrados entre caracteres de acento grave (

`). - Programa de actualizaciones de la tabla

- En la vista Programa de actualizaciones de tablas, se muestra cuándo y con qué frecuencia se actualizan las tablas para ayudarte a planificar cómo y cuándo moverlas.

- Migración de datos a BigQuery

- La vista Data Migration to BigQuery describe la ruta de migración con el tiempo esperado para migrar tus datos con el Servicio de transferencia de datos de BigQuery. Para obtener más información, consulta la guía del Servicio de transferencia de datos de BigQuery para Teradata.

La sección Apéndice contiene las siguientes vistas:

- Distinción de mayúsculas

- En la vista Distinción entre mayúsculas y minúsculas, se muestran las tablas del almacén de datos de origen que están configuradas para realizar comparaciones que no distinguen mayúsculas de minúsculas. De forma predeterminada, las comparaciones de cadenas en BigQuery distinguen mayúsculas de minúsculas. Para obtener más información, consulta Intercalación.

Redshift

- Aspectos destacados de la migración

- La vista Aspectos destacados de la migración proporciona un resumen ejecutivo de las tres secciones del informe:

- El panel Sistema existente proporciona información sobre la cantidad de bases de datos, esquemas y tablas, y el tamaño total del sistema de Redshift existente. También enumera los esquemas por tamaño y el posible uso de recursos deficientes. Puedes usar esta información para optimizar tus datos quitando, particionando o agrupando en clústeres tus tablas.

- En el panel Estado de Steady de BigQuery, se proporciona información sobre cómo se verán tus datos después de la migración en BigQuery, incluida la cantidad de consultas que se pueden traducir de forma automática mediante el servicio de migración de BigQuery. En esta sección, también se muestran los costos de almacenar tus datos en BigQuery según tu tasa anual de transferencia de datos, junto con sugerencias de optimización para tablas, aprovisionamiento y espacio.

- El panel Ruta de migración proporciona información sobre el esfuerzo de migración. Para cada tabla, se muestra el tiempo esperado de migración, la cantidad de filas y el tamaño.

La sección Sistema existente contiene las siguientes vistas:

- Consultas por tipo y programación

- En la vista Consultas por tipo y programación, se clasifican tus consultas en ETL/escritura y generación de informes/agregación. Ver tu combinación de consultas a lo largo del tiempo te ayuda a comprender tus patrones de uso existentes y a identificar la variabilidad y el posible aprovisionamiento excesivo que pueden afectar el costo y el rendimiento.

- Cola de consultas

- La vista de filas de espera de consultas proporciona detalles adicionales sobre la carga del sistema, incluidos el volumen y la combinación de consultas, y cualquier impacto en el rendimiento debido a las filas de espera, como recursos insuficientes.

- Consultas y ajuste de escala de WLM

- La vista Queries and WLM Scaling identifica el ajuste de la simultaneidad como un costo adicional y una complejidad de configuración. Muestra cómo tu sistema de Redshift enruta las consultas según las reglas que especificaste y los impactos en el rendimiento debido a las colas, el escalamiento de simultaneidad y las consultas expulsadas.

- Cola y espera

- La vista de filas y tiempos de espera ofrece una perspectiva más detallada de las filas y los tiempos de espera de las búsquedas a lo largo del tiempo.

- Clases y rendimiento de WLM

- La vista de clases y rendimiento de WLM proporciona una forma opcional de asignar las reglas a BigQuery. Sin embargo, te recomendamos que permitas que BigQuery enrute tus consultas automáticamente.

- Estadísticas de volumen de búsquedas y tablas

- En la vista de estadísticas de volumen de consultas y tablas, se enumeran las consultas por tamaño, frecuencia y usuarios principales. Esto te ayuda a categorizar las fuentes de carga en el sistema y a planificar cómo migrar tus cargas de trabajo.

- Bases de datos y esquemas

- La vista de bases de datos y esquemas proporciona métricas sobre el tamaño, las tablas, las vistas y los procedimientos definidos en el sistema de almacén de datos de origen. Esto proporciona estadísticas sobre el volumen de objetos que se deben migrar.

- Volumen de tablas

- En la vista Volumen de tablas, se proporcionan estadísticas sobre las tablas y bases de datos más grandes, y se muestra cómo se accede a ellas. Debido a que las tablas grandes pueden tardar más en extraerse del sistema de almacén de datos de origen, esta vista te ayuda con la planificación y la secuencia de la migración.

- Uso de tablas

- En la vista Uso de tablas, se proporcionan estadísticas sobre qué tablas se usan mucho dentro del sistema de almacén de datos de origen. Las tablas muy usadas pueden aprovecharse para comprender qué tablas pueden tener muchas dependencias y requieren una planificación adicional durante el proceso de migración.

- Importadores y exportadores

- La vista Importers & Exporters proporciona información sobre los datos y los usuarios involucrados en la importación de datos (con consultas

COPY) y la exportación de datos (con consultasUNLOAD). Esta vista ayuda a identificar la capa de transferencia y los procesos relacionados con la transferencia y las exportaciones. - Uso de clústeres

- La vista Cluster Utilization proporciona información general sobre todos los clústeres disponibles y muestra el uso de CPU de cada clúster. Esta vista puede ayudarte a comprender la reserva de capacidad del sistema.

La sección Estado estable de BigQuery contiene las siguientes vistas:

- Agrupamiento en clústeres y partición

En la vista Partitioning and Clustering, se muestran las tablas que se beneficiarían de la partición, el agrupamiento en clústeres o ambos.

Las sugerencias de metadatos se logran analizando el esquema del almacén de datos de origen (como la clave de ordenamiento y la clave de distribución en la tabla de origen) y buscando el equivalente de BigQuery más cercano para lograr características de optimización similares.

Las sugerencias de cargas de trabajo se obtienen analizando los registros de consultas de origen. La recomendación se determina mediante el análisis de las cargas de trabajo, en especial las cláusulas

WHEREoJOINen los registros de consulta analizados.En la parte inferior de la página, hay una declaración de creación de tabla traducida con todas las optimizaciones proporcionadas. Todas las sentencias DDL traducidas también se pueden extraer del conjunto de datos. Las sentencias DDL traducidas se almacenan en la tabla

SchemaConversionen la columnaCreateTableDDL.Las recomendaciones del informe solo se proporcionan para las tablas de más de 1 GB, ya que las tablas pequeñas no se benefician del agrupamiento en clústeres ni de la partición. Sin embargo, el DDL de todas las tablas (incluidas las tablas de menos de 1 GB) está disponible en la tabla

SchemaConversion.- Tablas sin uso

En la vista Tablas sin uso, se muestran las tablas en las que la evaluación de migración de BigQuery no identificó ningún uso durante el período de registros analizado. La falta de uso puede indicar que no necesitas transferir esa tabla a BigQuery durante la migración o que los costos de almacenamiento de datos en BigQuery pueden ser menores (se facturan como almacenamiento a largo plazo). Te recomendamos que valides la lista de tablas sin usar, ya que podrían tener uso fuera del período de los registros, como una tabla que solo se usa una vez cada tres o seis meses.

- Tablas sin escritura

En la vista Tablas sin escrituras, se muestran las tablas en las que la evaluación de migración de BigQuery no identificó ninguna actualización durante el período de registros analizado. La falta de escrituras puede indicar dónde se pueden reducir los costos de almacenamiento en BigQuery (que se facturan como almacenamiento a largo plazo).

- BigQuery BI Engine y vistas materializadas

BigQuery BI Engine y las vistas materializadas proporcionan sugerencias de optimización adicionales para aumentar el rendimiento en BigQuery.

La sección Ruta de la migración contiene las siguientes vistas:

- Traducción de SQL

- En la vista Traducción de SQL, se enumeran la cantidad y los detalles de las consultas que se convirtieron automáticamente con la evaluación de migración de BigQuery y que no requieren intervención manual. Por lo general, la traducción automática de SQL logra altas tasas de traducción si se proporcionan metadatos.

- Esfuerzo sin conexión de traducción de SQL

- La vista Esfuerzo sin conexión de traducción de SQL captura las áreas que necesitan intervención manual, incluidas las UDF específicas y las consultas con posibles ambigüedades de traducción.

- Compatibilidad con la operación de agregar a la tabla

- La vista Alter Table Append Support muestra detalles sobre las construcciones comunes de SQL de Redshift que no tienen un equivalente directo en BigQuery.

- Compatibilidad con el comando de copia

- La vista Copy Command Support muestra detalles sobre las construcciones comunes de SQL de Redshift que no tienen un equivalente directo en BigQuery.

- Advertencias de SQL

- La vista Advertencias de SQL captura áreas que se traducen correctamente, pero requieren una revisión.

- Incumplimientos de estructura léxica y sintaxis

- En la vista Lexical Structure & Syntax Violations, se muestran los nombres de las columnas, las tablas, las funciones y los procedimientos que incumplen la sintaxis de BigQuery.

- Palabras clave reservadas de BigQuery

- La vista Palabras clave reservadas de BigQuery muestra el uso detectado de palabras clave que tienen un significado especial en el lenguaje GoogleSQL y no se pueden usar como identificadores, a menos que estén encerrados entre caracteres de acento grave (

`). - Acoplamiento de esquemas

- La vista de acoplamiento del esquema proporciona una vista de alto nivel de las bases de datos, los esquemas y las tablas a los que se accede en conjunto en una sola consulta. En esta vista, se puede mostrar a qué tablas, esquemas y bases de datos se hace referencia con frecuencia y qué puedes usar para la planificación de la migración.

- Programa de actualizaciones de la tabla

- En la vista Programa de actualizaciones de tablas, se muestra cuándo y con qué frecuencia se actualizan las tablas para ayudarte a planificar cómo y cuándo moverlas.

- Escala de la tabla

- En la vista Table Scale, se enumeran las tablas con la mayor cantidad de columnas.

- Migración de datos a BigQuery

- La vista Migración de datos a BigQuery describe la ruta de migración con el tiempo esperado para migrar tus datos con el Servicio de migración de BigQuery o el Servicio de transferencia de datos. Para obtener más información, consulta la guía del Servicio de transferencia de datos de BigQuery para Redshift.

- Resumen de la ejecución de la evaluación

El resumen de ejecución de la evaluación contiene la integridad del informe, el progreso de la evaluación en curso y el estado de los archivos procesados y los errores.

La integridad del informe representa el porcentaje de datos procesados correctamente que se recomienda mostrar para obtener estadísticas significativas en el informe de evaluación. Si faltan los datos de una sección en particular del informe, esta información se muestra en la tabla Módulos de evaluación, debajo del indicador Integridad del informe.

La métrica de progreso indica el porcentaje de datos procesados hasta el momento, junto con la estimación del tiempo restante para procesar todos los datos. Una vez que se completa el procesamiento, no se muestra la métrica de progreso.

Redshift Serverless

- Aspectos destacados de la migración

- En esta página del informe, se muestra el resumen de las bases de datos existentes de Amazon Redshift Serverless, incluidos el tamaño y la cantidad de tablas. Además, proporciona la estimación de alto nivel del valor del contrato anual (ACV), que es el costo de procesamiento y almacenamiento en BigQuery. La vista Aspectos destacados de la migración proporciona un resumen ejecutivo de las tres secciones del informe.

La sección Sistema existente tiene las siguientes vistas:

- Bases de datos y esquemas

- Proporciona un desglose del tamaño total de almacenamiento en GB para cada base de datos, esquema o tabla.

- Bases de datos y esquemas externos