Tutorial ini menunjukkan cara mengimpor model Open Neural Network Exchange (ONNX) yang dilatih dengan scikit-learn. Anda mengimpor model ke set data BigQuery dan menggunakannya untuk membuat prediksi menggunakan kueri SQL.

ONNX menyediakan format seragam yang dirancang untuk merepresentasikan framework machine learning (ML) apa pun. Dengan dukungan ML BigQuery untuk ONNX, Anda dapat melakukan hal berikut:

- Melatih model menggunakan framework favorit Anda.

- Mengonversi model ke format model ONNX.

- Impor model ONNX ke BigQuery dan buat prediksi menggunakan BigQuery ML.

Tujuan

- Buat dan latih model menggunakan scikit-learn.

- Konversi model ke format ONNX menggunakan sklearn-onnx.

- Gunakan pernyataan

CREATE MODELuntuk mengimpor model ONNX ke BigQuery. - Gunakan fungsi

ML.PREDICTuntuk membuat prediksi dengan model ONNX yang diimpor.

Biaya

Dalam dokumen ini, Anda akan menggunakan komponen Google Cloudyang dapat ditagih berikut:

Untuk membuat perkiraan biaya berdasarkan proyeksi penggunaan Anda,

gunakan kalkulator harga.

Setelah menyelesaikan tugas yang dijelaskan dalam dokumen ini, Anda dapat menghindari penagihan berkelanjutan dengan menghapus resource yang Anda buat. Untuk mengetahui informasi selengkapnya, lihat Pembersihan.

Sebelum memulai

- Sign in to your Google Cloud account. If you're new to Google Cloud, create an account to evaluate how our products perform in real-world scenarios. New customers also get $300 in free credits to run, test, and deploy workloads.

-

In the Google Cloud console, on the project selector page, select or create a Google Cloud project.

-

In the Google Cloud console, on the project selector page, select or create a Google Cloud project.

-

Verify that billing is enabled for your Google Cloud project.

-

Enable the BigQuery and Cloud Storage APIs.

- Pastikan Anda memiliki izin yang diperlukan untuk melakukan tugas dalam dokumen ini.

- BigQuery Studio Admin (

roles/bigquery.studioAdmin) - Storage Object Creator (

roles/storage.objectCreator) -

In the Google Cloud console, go to the IAM page.

Go to IAM - Select the project.

-

In the Principal column, find all rows that identify you or a group that you're included in. To learn which groups you're included in, contact your administrator.

- For all rows that specify or include you, check the Role column to see whether the list of roles includes the required roles.

-

In the Google Cloud console, go to the IAM page.

Buka IAM - Pilih project.

- Klik Grant access.

-

Di kolom New principals, masukkan ID pengguna Anda. Biasanya berupa alamat email untuk Akun Google.

- Di daftar Select a role, pilih peran.

- Untuk memberikan peran tambahan, klik Tambahkan peran lain, lalu tambahkan setiap peran tambahan.

- Klik Simpan.

- Buat bucket Cloud Storage untuk menyimpan model.

- Upload model ONNX ke bucket Cloud Storage Anda.

Di konsol Google Cloud , buka halaman BigQuery.

Di panel Explorer, klik nama project Anda.

Klik View actions > Create dataset.

Di halaman Create dataset, lakukan hal berikut:

Untuk Dataset ID, masukkan

bqml_tutorial.Untuk Location type, pilih Multi-region, lalu pilih US (multiple regions in United States).

Jangan ubah setelan default yang tersisa, lalu klik Create dataset.

Buat set data bernama

bqml_tutorialdengan lokasi data yang ditetapkan keUSdan deskripsiBigQuery ML tutorial dataset:bq --location=US mk -d \ --description "BigQuery ML tutorial dataset." \ bqml_tutorial

Perintah ini menggunakan pintasan

-d, bukan flag--dataset. Jika Anda menghapus-ddan--dataset, perintah defaultnya adalah membuat set data.Pastikan set data telah dibuat:

bq lsDi konsol Google Cloud , buka halaman BigQuery Studio.

Di editor kueri, masukkan pernyataan

CREATE MODELberikut.CREATE OR REPLACE MODEL `bqml_tutorial.imported_onnx_model` OPTIONS (MODEL_TYPE='ONNX', MODEL_PATH='BUCKET_PATH')

Ganti

BUCKET_PATHdengan jalur ke model yang Anda upload ke Cloud Storage. Jika Anda menggunakan model sampel, gantiBUCKET_PATHdengan nilai berikut:gs://cloud-samples-data/bigquery/ml/onnx/pipeline_rf.onnx.Setelah operasi selesai, Anda akan melihat pesan yang mirip dengan berikut:

Successfully created model named imported_onnx_model.Model baru Anda akan muncul di panel Resources. Model ditunjukkan dengan ikon model:

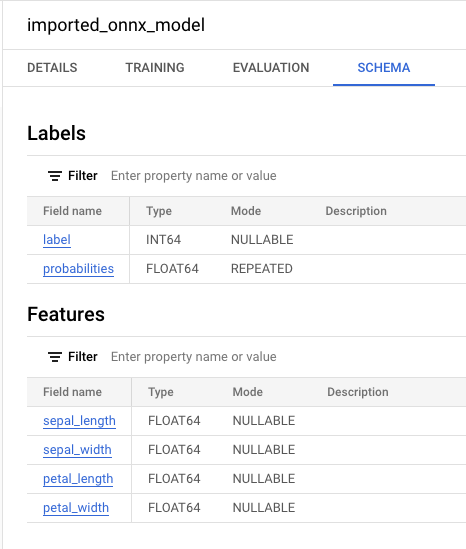

Jika Anda memilih model baru di panel Resources, informasi tentang model akan muncul di samping Query editor.

Jika Anda memilih model baru di panel Resources, informasi tentang model akan muncul di samping Query editor.

Impor model ONNX dari Cloud Storage dengan memasukkan pernyataan

CREATE MODELberikut.bq query --use_legacy_sql=false \ "CREATE OR REPLACE MODEL `bqml_tutorial.imported_onnx_model` OPTIONS (MODEL_TYPE='ONNX', MODEL_PATH='BUCKET_PATH')"

Ganti

BUCKET_PATHdengan jalur ke model yang Anda upload ke Cloud Storage. Jika Anda menggunakan model sampel, gantiBUCKET_PATHdengan nilai berikut:gs://cloud-samples-data/bigquery/ml/onnx/pipeline_rf.onnx.Setelah operasi selesai, Anda akan melihat pesan yang mirip dengan berikut:

Successfully created model named imported_onnx_model.Setelah mengimpor model, verifikasi bahwa model muncul di set data.

bq ls bqml_tutorial

Outputnya mirip dengan hal berikut ini:

tableId Type --------------------- ------- imported_onnx_model MODEL

sepal_lengthsepal_widthpetal_lengthpetal_widthBuka halaman BigQuery Studio.

Di editor kueri, masukkan kueri ini yang menggunakan fungsi

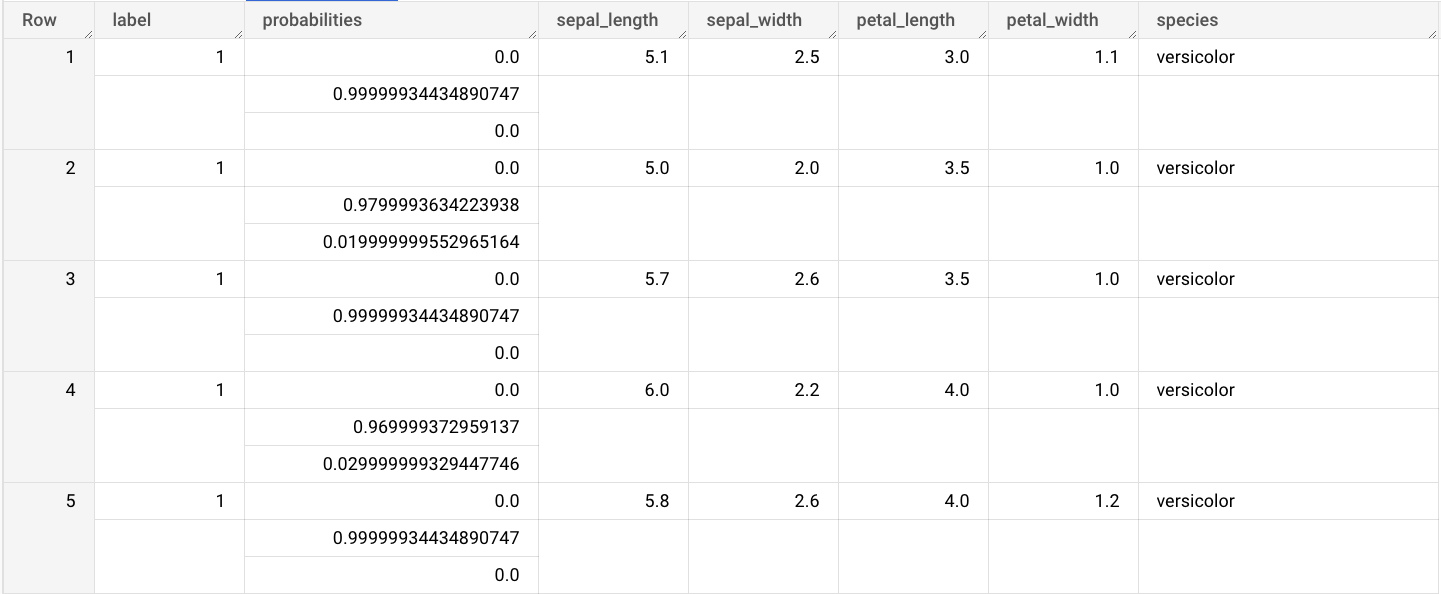

ML.PREDICT.SELECT * FROM ML.PREDICT(MODEL `bqml_tutorial.imported_onnx_model`, ( SELECT * FROM `bigquery-public-data.ml_datasets.iris` ) )

Hasil kuerinya mirip dengan berikut ini:

- In the Google Cloud console, go to the Manage resources page.

- In the project list, select the project that you want to delete, and then click Delete.

- In the dialog, type the project ID, and then click Shut down to delete the project.

- In the Google Cloud console, go to the Manage resources page.

- In the project list, select the project that you want to delete, and then click Delete.

- In the dialog, type the project ID, and then click Shut down to delete the project.

Opsional: Hapus set data.

- Untuk mengetahui informasi selengkapnya tentang cara mengimpor model ONNX, lihat

Pernyataan

CREATE MODELuntuk model ONNX. - Untuk informasi selengkapnya tentang alat konversi dan tutorial ONNX yang tersedia, lihat Mengonversi ke format ONNX.

- Untuk ringkasan BigQuery ML, lihat Pengantar BigQuery ML.

- Untuk mulai menggunakan BigQuery ML, lihat Membuat model machine learning di BigQuery ML.

Peran yang diperlukan

Jika membuat project baru, Anda adalah pemilik project, dan Anda diberi semua izin Identity and Access Management (IAM) yang diperlukan untuk menyelesaikan tutorial ini.

Jika Anda menggunakan project yang sudah ada, lakukan hal berikut.

Make sure that you have the following role or roles on the project:

Check for the roles

Grant the roles

Untuk mengetahui informasi selengkapnya tentang izin IAM di BigQuery, lihat Izin IAM.

Opsional: Melatih model dan mengonversinya ke format ONNX

Contoh kode berikut menunjukkan cara melatih model klasifikasi dengan scikit-learn dan cara mengonversi pipeline yang dihasilkan ke format ONNX. Tutorial

ini menggunakan contoh model bawaan yang disimpan di

gs://cloud-samples-data/bigquery/ml/onnx/pipeline_rf.onnx. Anda tidak harus

menyelesaikan langkah-langkah ini jika menggunakan model contoh.

Melatih model klasifikasi dengan scikit-learn

Gunakan contoh kode berikut untuk membuat dan melatih pipeline scikit-learn pada set data Iris. Untuk mengetahui petunjuk tentang cara menginstal dan menggunakan scikit-learn, lihat panduan penginstalan scikit-learn.

import numpy

from sklearn.datasets import load_iris

from sklearn.pipeline import Pipeline

from sklearn.preprocessing import StandardScaler

from sklearn.ensemble import RandomForestClassifier

data = load_iris()

X = data.data[:, :4]

y = data.target

ind = numpy.arange(X.shape[0])

numpy.random.shuffle(ind)

X = X[ind, :].copy()

y = y[ind].copy()

pipe = Pipeline([('scaler', StandardScaler()),

('clr', RandomForestClassifier())])

pipe.fit(X, y)

Mengonversi pipeline menjadi model ONNX

Gunakan contoh kode berikut di sklearn-onnx untuk mengonversi pipeline scikit-learn menjadi model ONNX yang diberi nama pipeline_rf.onnx.

from skl2onnx import convert_sklearn

from skl2onnx.common.data_types import FloatTensorType

# Disable zipmap as it is not supported in BigQuery ML.

options = {id(pipe): {'zipmap': False}}

# Define input features. scikit-learn does not store information about the

# training dataset. It is not always possible to retrieve the number of features

# or their types. That's why the function needs another argument called initial_types.

initial_types = [

('sepal_length', FloatTensorType([None, 1])),

('sepal_width', FloatTensorType([None, 1])),

('petal_length', FloatTensorType([None, 1])),

('petal_width', FloatTensorType([None, 1])),

]

# Convert the model.

model_onnx = convert_sklearn(

pipe, 'pipeline_rf', initial_types=initial_types, options=options

)

# And save.

with open('pipeline_rf.onnx', 'wb') as f:

f.write(model_onnx.SerializeToString())

Mengupload model ONNX ke Cloud Storage

Setelah menyimpan model, lakukan hal berikut:

Membuat set data

Buat set data BigQuery untuk menyimpan model ML Anda.

Konsol

bq

Untuk membuat set data baru, gunakan perintah bq mk dengan flag --location. Untuk daftar lengkap kemungkinan parameter, lihat referensi

perintah bq mk --dataset.

API

Panggil metode datasets.insert dengan resource set data yang ditentukan.

{ "datasetReference": { "datasetId": "bqml_tutorial" } }

BigQuery DataFrames

Sebelum mencoba contoh ini, ikuti petunjuk penyiapan BigQuery DataFrames di Panduan memulai BigQuery menggunakan BigQuery DataFrames. Untuk mengetahui informasi selengkapnya, lihat dokumentasi referensi BigQuery DataFrames.

Untuk melakukan autentikasi ke BigQuery, siapkan Kredensial Default Aplikasi. Untuk mengetahui informasi selengkapnya, lihat Menyiapkan ADC untuk lingkungan pengembangan lokal.

Mengimpor model ONNX ke BigQuery

Langkah-langkah berikut menunjukkan cara mengimpor model ONNX contoh dari

Cloud Storage menggunakan pernyataan CREATE MODEL.

Untuk mengimpor model ONNX ke set data Anda, pilih salah satu opsi berikut:

Konsol

bq

DataFrame BigQuery

Sebelum mencoba contoh ini, ikuti petunjuk penyiapan BigQuery DataFrames di Panduan memulai BigQuery menggunakan BigQuery DataFrames. Untuk mengetahui informasi selengkapnya, lihat dokumentasi referensi BigQuery DataFrames.

Untuk melakukan autentikasi ke BigQuery, siapkan Kredensial Default Aplikasi. Untuk mengetahui informasi selengkapnya, lihat Menyiapkan ADC untuk lingkungan pengembangan lokal.

Impor model menggunakan objek ONNXModel.

Untuk mengetahui informasi selengkapnya tentang cara mengimpor model ONNX ke BigQuery, termasuk persyaratan format dan penyimpanan, lihat Pernyataan CREATE MODEL untuk mengimpor model ONNX.

Membuat prediksi dengan model ONNX yang diimpor

Setelah mengimpor model ONNX, Anda menggunakan fungsi ML.PREDICT untuk membuat

prediksi dengan model.

Kueri dalam langkah-langkah berikut menggunakan imported_onnx_model untuk membuat prediksi menggunakan data input dari tabel iris dalam set data publik ml_datasets. Model ONNX mengharapkan empat nilai FLOAT sebagai input:

Input ini cocok dengan initial_types yang ditentukan saat Anda mengonversi model ke format ONNX.

Output mencakup kolom label dan probabilities, serta kolom dari tabel input. label merepresentasikan label class yang diprediksi.

probabilities adalah array probabilitas yang mewakili probabilitas untuk setiap class.

Untuk membuat prediksi dengan model TensorFlow yang diimpor, pilih salah satu opsi berikut:

Konsol

bq

Jalankan kueri yang menggunakan ML.PREDICT.

bq query --use_legacy_sql=false \ 'SELECT * FROM ML.PREDICT( MODEL `example_dataset.imported_onnx_model`, (SELECT * FROM `bigquery-public-data.ml_datasets.iris`))'

DataFrame BigQuery

Sebelum mencoba contoh ini, ikuti petunjuk penyiapan BigQuery DataFrames di Panduan memulai BigQuery menggunakan BigQuery DataFrames. Untuk mengetahui informasi selengkapnya, lihat dokumentasi referensi BigQuery DataFrames.

Untuk melakukan autentikasi ke BigQuery, siapkan Kredensial Default Aplikasi. Untuk mengetahui informasi selengkapnya, lihat Menyiapkan ADC untuk lingkungan pengembangan lokal.

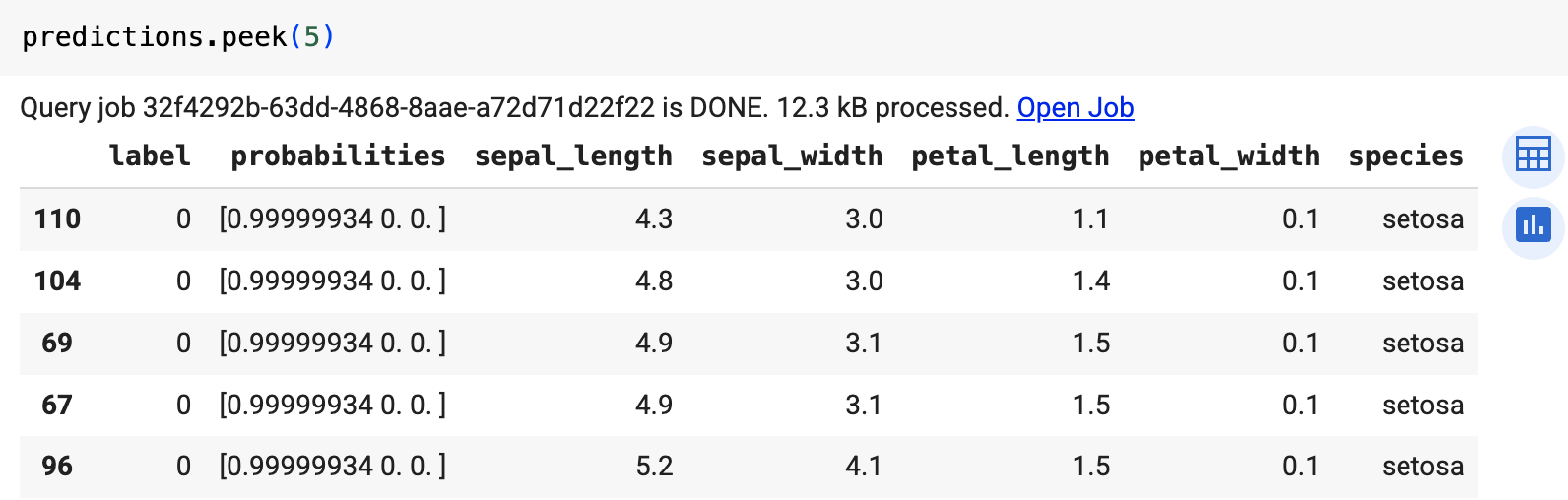

Gunakan fungsi predict untuk menjalankan model jarak jauh.

Hasilnya mirip dengan berikut ini:

Pembersihan

Agar tidak perlu membayar biaya pada akun Google Cloud Anda untuk resource yang digunakan dalam tutorial ini, hapus project yang berisi resource tersebut, atau simpan project dan hapus setiap resource.

Menghapus project

Konsol

gcloud

Menghapus resource satu per satu

Atau, untuk menghapus setiap resource yang digunakan dalam tutorial ini, lakukan langkah-langkah berikut: