Visão geral da IA generativa

Neste documento, descrevemos os recursos de inteligência artificial (IA) generativa compatíveis com o BigQuery ML. Com esses recursos, é possível realizar tarefas de IA no BigQuery ML usando modelos da Vertex AI pré-treinados e modelos integrados do BigQuery ML.

Veja a seguir algumas das tarefas disponíveis:

- Gerar texto

- Gerar dados estruturados

- Gerar valores de um tipo específico por linha

- Gerar embeddings

- Previsão de série temporal

Acesse um modelo da Vertex AI para executar uma dessas funções criando um modelo remoto no BigQuery ML que representa o endpoint do modelo da Vertex AI. Depois de criar um modelo remoto no modelo da Vertex AI que você quer usar, acesse os recursos desse modelo executando uma função do BigQuery ML no modelo remoto.

Com essa abordagem, é possível usar os recursos desses modelos da Vertex AI em consultas SQL para analisar dados do BigQuery.

Fluxo de trabalho

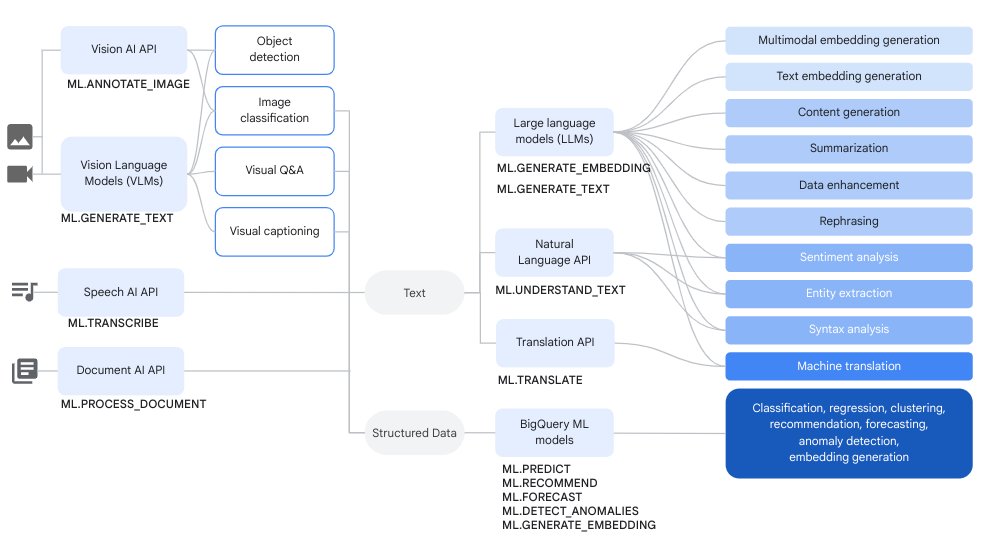

É possível usar modelos remotos em vez de modelos da Vertex AI e modelos remotos em vez de serviços do Cloud AI com as funções de ML do BigQuery para realizar tarefas complexas de análise de dados e IA generativa.

O diagrama a seguir mostra alguns fluxos de trabalho típicos em que é possível usar esses recursos juntos:

Gerar texto

A geração de texto é uma forma de IA generativa em que o texto é gerado com base em um comando ou na análise de dados. É possível gerar texto usando dados textuais e multimodais.

Confira alguns casos de uso comuns para geração de texto:

- Gerar conteúdo criativo.

- Gerando código.

- Gerar respostas de chat ou e-mail.

- Brainstorming, como sugerir caminhos para futuros produtos ou serviços.

- Personalização de conteúdo, como sugestões de produtos.

- Classificar dados aplicando um ou mais rótulos ao conteúdo para classificá-lo em categorias.

- Identificar os principais sentimentos expressos no conteúdo.

- Resumir as principais ideias ou impressões transmitidas pelo conteúdo.

- Identificar uma ou mais entidades em destaque em texto ou dados visuais.

- Traduzir o conteúdo de dados de texto ou áudio para outro idioma.

- Gerar texto que corresponda ao conteúdo verbal em dados de áudio.

- Legendar ou fazer perguntas e respostas sobre dados visuais.

O enriquecimento de dados é uma próxima etapa comum após a geração de texto, em que você enriquece insights da análise inicial combinando-os com dados adicionais. Por exemplo, você pode analisar imagens de móveis para gerar texto para uma coluna design_type, de modo que o SKU dos móveis tenha uma descrição associada, como mid-century modern ou farmhouse.

Modelos compatíveis

Para realizar tarefas de IA generativa, use modelos remotos no BigQuery ML para fazer referência a modelos implantados ou hospedados na Vertex AI. É possível criar os seguintes tipos de modelos remotos:

- Modelos remotos em qualquer um dos modelos do Gemini disponíveis de forma geral ou em pré-lançamento.

Modelos remotos em relação aos seguintes modelos de parceiros:

Como usar modelos de geração de texto

Depois de criar um modelo remoto, use a

função ML.GENERATE_TEXT

para interagir com ele:

Para modelos remotos baseados em modelos do Gemini, faça o seguinte:

Use a função

ML.GENERATE_TEXTpara gerar texto com base em um comando especificado em uma consulta ou extraído de uma coluna em uma tabela padrão. Ao especificar o comando em uma consulta, é possível fazer referência aos seguintes tipos de colunas de tabela:- Colunas

STRINGpara fornecer dados de texto. STRUCTcolunas que usam o formatoObjectRefpara fornecer dados não estruturados. Use a funçãoOBJ.GET_ACCESS_URLno comando para converter os valoresObjectRefemObjectRefRuntime.

- Colunas

Use a função

ML.GENERATE_TEXTpara analisar texto, imagem, áudio, vídeo ou PDF de uma tabela de objetos com um comando que você fornece como argumento de função.

Para todos os outros tipos de modelos remotos, use a função

ML.GENERATE_TEXTcom um comando fornecido em uma consulta ou de uma coluna em uma tabela padrão.

Use os tópicos a seguir para testar a geração de texto no BigQuery ML:

- Gerar texto usando um modelo do Gemini e a função

ML.GENERATE_TEXT. - Gerar texto usando um modelo Gemma e a função

ML.GENERATE_TEXT. - Analisar imagens com um modelo do Gemini.

- Gerar texto usando a função

ML.GENERATE_TEXTcom seus dados. - Ajustar um modelo usando seus dados.

Atributos de embasamento e segurança

É possível usar

embasamento

e

atributos de segurança

ao usar modelos do Gemini com a função ML.GENERATE_TEXT,

desde que você esteja usando uma tabela padrão para entrada. O embasamento permite que

Gemini usa informações adicionais da Internet para

gerar respostas mais específicas e factuais. Os atributos de segurança permitem que

Gemini filtram as respostas que retorna com base

que você especificar.

Ajuste supervisionado

Ao criar um modelo remoto que se refere a qualquer um dos modelos a seguir, é possível configurar o ajuste supervisionado ao mesmo tempo:

gemini-2.5-progemini-2.5-flash-litegemini-2.0-flash-001gemini-2.0-flash-lite-001

Toda inferência ocorre na Vertex AI. Os resultados são armazenados no BigQuery.

Capacidade de processamento provisionada da Vertex AI

Para

modelos do Gemini compatíveis,

use a

capacidade de processamento provisionada da Vertex AI

com a função ML.GENERATE_TEXT para oferecer alta capacidade de processamento consistente para

solicitações. Para mais informações, consulte

Usar a taxa de transferência provisionada da Vertex AI.

Gerar dados estruturados

A geração de dados estruturados é muito semelhante à geração de texto, mas você também pode formatar a resposta do modelo especificando um esquema SQL.

Para gerar dados estruturados, crie um modelo remoto em qualquer um dos modelos do Gemini disponíveis de forma geral ou em prévia. Em seguida, use a

função AI.GENERATE_TABLE

para interagir com esse modelo. Para criar dados estruturados, consulte

Gerar dados estruturados usando a função AI.GENERATE_TABLE.

É possível especificar

atributos de segurança

ao usar modelos do Gemini com a função AI.GENERATE_TABLE

para filtrar as respostas do modelo.

Gerar valores de um tipo específico por linha

É possível usar funções escalares de IA generativa com modelos do Gemini para analisar dados em tabelas padrão do BigQuery. Os dados incluem dados de texto e não estruturados de colunas que contêm valores ObjectRef.

Para cada linha na tabela, essas funções geram uma saída que contém um tipo específico.

As seguintes funções de IA estão disponíveis:

AI.GENERATE, que gera um valorSTRINGAI.GENERATE_BOOLAI.GENERATE_DOUBLEAI.GENERATE_INT

Ao usar a função AI.GENERATE com

modelos do Gemini compatíveis,

é possível usar a

capacidade de processamento provisionada da Vertex AI

para oferecer uma alta capacidade de processamento consistente para solicitações. Para mais informações, consulte

Usar a taxa de transferência provisionada da Vertex AI.

Gerar embeddings

Um embedding é um vetor numérico de alta dimensão que representa uma determinada entidade, como um texto ou um arquivo de áudio. A geração de incorporações permite capturar a semântica dos seus dados de uma forma que facilita o raciocínio e a comparação deles.

Confira alguns casos de uso comuns para a geração de embeddings:

- Usar a geração aumentada de recuperação (RAG) para aumentar as respostas do modelo às consultas do usuário referenciando dados adicionais de uma fonte confiável. A RAG oferece melhor acurácia factual e consistência de resposta, além de acesso a dados mais recentes que os dados de treinamento do modelo.

- Realizando a pesquisa multimodal. Por exemplo, usar a entrada de texto para pesquisar imagens.

- Realizar pesquisa semântica para encontrar itens semelhantes para recomendações, substituição e remoção de duplicação de registros.

- Como criar embeddings para usar com um modelo k-means para clustering.

Modelos compatíveis

Os seguintes modelos são compatíveis:

Para criar embeddings de texto, use os seguintes modelos da Vertex AI:

gemini-embedding-001(Pré-lançamento)text-embeddingtext-multilingual-embedding- Modelos abertos compatíveis (pré-lançamento)

Para criar embeddings multimodais, que incorporam textos, imagens e vídeos no mesmo espaço semântico, use o modelo

multimodalembeddingda Vertex AI.Para criar embeddings para dados estruturados de variáveis aleatórias independentes e identicamente distribuídas (IID), use um modelo de análise de componentes principais (PCA) ou de codificador automático do BigQuery ML.

Para criar embeddings para dados de usuários ou itens, use um modelo de fatoração de matriz do BigQuery ML.

Para uma incorporação de texto menor e leve, tente usar um modelo do TensorFlow pré-treinado, como NNLM, SWIVEL ou BERT.

Como usar modelos de geração de embeddings

Depois de criar o modelo, use a

função ML.GENERATE_EMBEDDING

para interagir com ele. Para todos os tipos de modelos com suporte, o ML.GENERATE_EMBEDDING

trabalha com dados estruturados em

tabelas padrão. Para modelos

de incorporação multimodais, ML.GENERATE_EMBEDDING também funciona com conteúdo visual

de colunas de tabelas padrão

que contêm valores ObjectRef ou de tabelas de objetos.

Para modelos remotos, toda a inferência ocorre na Vertex AI. Para outros tipos de modelo, toda a inferência ocorre no BigQuery. Os resultados são armazenados no BigQuery.

Use os tópicos a seguir para testar a geração de texto no BigQuery ML:

- Gerar embeddings de texto usando a função

ML.GENERATE_EMBEDDING - Gerar embeddings de imagens usando a função

ML.GENERATE_EMBEDDING - Gerar embeddings de vídeo usando a função

ML.GENERATE_EMBEDDING - Gerar e pesquisar embeddings multimodais

- Realizar pesquisa semântica e geração aumentada de recuperação

Previsão

A previsão é uma técnica que permite analisar dados históricos de série temporal para fazer uma previsão informada sobre tendências futuras. Você pode usar o modelo de série temporal TimesFM (prévia) integrado do BigQuery ML para fazer previsões sem precisar criar seu próprio modelo. O modelo TimesFM integrado funciona com a

função AI.FORECAST

para gerar previsões com base nos seus dados.

Locais

Os locais aceitos para modelos de geração e embedding de texto variam de acordo com o tipo e a versão do modelo que você usa. Para mais informações, consulte Locais. Ao contrário de outros modelos de IA generativa, o suporte a locais não se aplica ao modelo de série temporal TimesFM integrado. O modelo TimesFM está disponível em todas as regiões compatíveis com o BigQuery.

Preços

Você recebe cobranças pelos recursos de computação usados para executar consultas em modelos. Os modelos remotos fazem chamadas para modelos da Vertex AI. Portanto, as consultas feitas a eles também geram cobranças da Vertex AI.

Para mais informações, consulte os preços do BigQuery ML.

A seguir

- Para uma introdução à IA e ao ML no BigQuery, consulte Introdução à IA e ao ML no BigQuery.

- Para mais informações sobre como realizar inferência em modelos de machine learning, consulte Visão geral da inferência de modelos.

- Para mais informações sobre as instruções e funções SQL compatíveis com modelos de IA generativa, consulte Jornadas do usuário completas para modelos de IA generativa.