Régler un modèle à l'aide de vos données

Ce document explique comment créer un modèle distant BigQuery ML faisant référence à un modèle Vertex AI, puis comment configurer le modèle pour effectuer le réglage supervisé. Le modèle Vertex AI doit être l'un des suivants :

gemini-2.5-progemini-2.5-flash-litegemini-2.0-flash-001gemini-2.0-flash-lite-001

Après avoir créé le modèle distant, vous utilisez la fonction ML.EVALUATE pour évaluer le modèle et vérifier que ses performances conviennent à votre cas d'utilisation. Vous pouvez ensuite utiliser le modèle conjointement avec la fonction ML.GENERATE_TEXT pour analyser du texte dans une table BigQuery.

Pour en savoir plus, consultez Réglage supervisé de modèle pour l'API Gemini Vertex AI.

Rôles requis

Pour créer et évaluer un modèle ajusté, vous avez besoin des rôles IAM (Identity and Access Management) suivants :

- Créer et utiliser des ensembles de données, des tables et des modèles BigQuery : Éditeur de données BigQuery (

roles/bigquery.dataEditor) sur votre projet. Créer, déléguer et utiliser des connexions BigQuery : administrateur de connexion BigQuery (

roles/bigquery.connectionsAdmin) sur votre projet.Si vous n'avez pas configuré de connexion par défaut, vous pouvez en créer une et la définir lors de l'exécution de l'instruction

CREATE MODEL. Pour ce faire, vous devez disposer du rôle Administrateur BigQuery (roles/bigquery.admin) sur votre projet. Pour en savoir plus, consultez Configurer la connexion par défaut.Accordez des autorisations au compte de service de la connexion : Administrateur IAM du projet (

roles/resourcemanager.projectIamAdmin) sur le projet contenant le point de terminaison Vertex AI. Il s'agit du projet actuel pour les modèles distants que vous créez en spécifiant le nom du modèle comme point de terminaison. Il s'agit du projet identifié dans l'URL des modèles distants que vous créez en spécifiant une URL comme point de terminaison.Créer des jobs BigQuery : rôle Utilisateur de job BigQuery (

roles/bigquery.jobUser) sur votre projet.

Ces rôles prédéfinis contiennent les autorisations requises pour effectuer les tâches décrites dans ce document. Pour afficher les autorisations exactes requises, développez la section Autorisations requises :

Autorisations requises

- Créez un ensemble de données :

bigquery.datasets.create - Créer, déléguer et utiliser une connexion :

bigquery.connections.* - Définissez les autorisations du compte de service :

resourcemanager.projects.getIamPolicyetresourcemanager.projects.setIamPolicy - Créez un modèle et exécutez l'inférence :

bigquery.jobs.createbigquery.models.createbigquery.models.getDatabigquery.models.updateDatabigquery.models.updateMetadata

Vous pouvez également obtenir ces autorisations avec des rôles personnalisés ou d'autres rôles prédéfinis.

Avant de commencer

-

In the Google Cloud console, on the project selector page, select or create a Google Cloud project.

Roles required to select or create a project

- Select a project: Selecting a project doesn't require a specific IAM role—you can select any project that you've been granted a role on.

-

Create a project: To create a project, you need the Project Creator

(

roles/resourcemanager.projectCreator), which contains theresourcemanager.projects.createpermission. Learn how to grant roles.

-

Verify that billing is enabled for your Google Cloud project.

-

Enable the BigQuery, BigQuery Connection,Vertex AI, and Compute Engine APIs.

Roles required to enable APIs

To enable APIs, you need the Service Usage Admin IAM role (

roles/serviceusage.serviceUsageAdmin), which contains theserviceusage.services.enablepermission. Learn how to grant roles.

Créer un ensemble de données

Créez un ensemble de données BigQuery pour contenir vos ressources :

Console

Dans la console Google Cloud , accédez à la page BigQuery.

Dans le volet Explorateur, cliquez sur le nom de votre projet.

Cliquez sur Afficher les actions > Créer un ensemble de données.

Sur la page Créer un ensemble de données, procédez comme suit :

Pour ID de l'ensemble de données, saisissez un nom pour l'ensemble de données.

Dans Type d'emplacement, sélectionnez un emplacement pour l'ensemble de données.

Cliquez sur Créer un ensemble de données.

bq

Pour créer un ensemble de données, exécutez la commande

bq mken spécifiant l'option--location:bq --location=LOCATION mk -d DATASET_ID

Remplacez les éléments suivants :

LOCATION: emplacement de l'ensemble de données.DATASET_IDest l'ID de l'ensemble de données que vous créez.

Vérifiez que l'ensemble de données a été créé :

bq ls

Créer une connexion

Vous pouvez ignorer cette étape si vous avez configuré une connexion par défaut ou si vous disposez du rôle Administrateur BigQuery.

Créez une connexion de ressource cloud pour que le modèle distant puisse l'utiliser, et obtenez le compte de service de la connexion. Créez la connexion dans le même emplacement que l'ensemble de données que vous avez créé à l'étape précédente.

Sélectionnez l'une des options suivantes :

Console

Accédez à la page BigQuery.

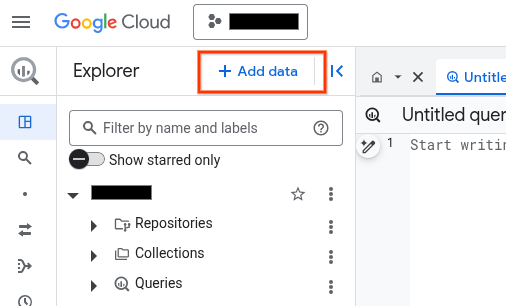

Dans le volet Explorateur, cliquez sur Ajouter des données :

La boîte de dialogue Ajouter des données s'ouvre.

Dans le panneau Filtrer par, dans la section Type de source de données, sélectionnez Applications métier.

Vous pouvez également saisir

Vertex AIdans le champ Rechercher des sources de données.Dans la section Sources de données recommandées, cliquez sur Vertex AI.

Cliquez sur la fiche de solution Modèles Vertex AI : fédération BigQuery.

Dans la liste Type de connexion, sélectionnez Modèles distants Vertex AI, fonctions distantes et BigLake (ressource Cloud).

Dans le champ ID de connexion, saisissez un nom pour votre connexion.

Cliquez sur Créer une connexion.

Cliquez sur Accéder à la connexion.

Dans le volet Informations de connexion, copiez l'ID du compte de service à utiliser à l'étape suivante.

bq

Dans un environnement de ligne de commande, créez une connexion :

bq mk --connection --location=REGION --project_id=PROJECT_ID \ --connection_type=CLOUD_RESOURCE CONNECTION_ID

Le paramètre

--project_idremplace le projet par défaut.Remplacez les éléments suivants :

REGION: votre région de connexionPROJECT_ID: ID de votre projet Google CloudCONNECTION_ID: ID de votre connexion

Lorsque vous créez une ressource de connexion, BigQuery crée un compte de service système unique et l'associe à la connexion.

Dépannage : Si vous obtenez l'erreur de connexion suivante, mettez à jour le Google Cloud SDK :

Flags parsing error: flag --connection_type=CLOUD_RESOURCE: value should be one of...

Récupérez et copiez l'ID du compte de service pour l'utiliser lors d'une prochaine étape :

bq show --connection PROJECT_ID.REGION.CONNECTION_ID

Le résultat ressemble à ce qui suit :

name properties 1234.REGION.CONNECTION_ID {"serviceAccountId": "connection-1234-9u56h9@gcp-sa-bigquery-condel.iam.gserviceaccount.com"}

Terraform

Utilisez la ressource google_bigquery_connection.

Pour vous authentifier auprès de BigQuery, configurez le service Identifiants par défaut de l'application. Pour en savoir plus, consultez la page Configurer l'authentification pour les bibliothèques clientes.

L'exemple suivant crée une connexion de ressources Cloud nommée my_cloud_resource_connection dans la région US :

Pour appliquer votre configuration Terraform dans un projet Google Cloud , suivez les procédures des sections suivantes.

Préparer Cloud Shell

- Lancez Cloud Shell.

-

Définissez le projet Google Cloud par défaut dans lequel vous souhaitez appliquer vos configurations Terraform.

Vous n'avez besoin d'exécuter cette commande qu'une seule fois par projet et vous pouvez l'exécuter dans n'importe quel répertoire.

export GOOGLE_CLOUD_PROJECT=PROJECT_ID

Les variables d'environnement sont remplacées si vous définissez des valeurs explicites dans le fichier de configuration Terraform.

Préparer le répertoire

Chaque fichier de configuration Terraform doit avoir son propre répertoire (également appelé module racine).

-

Dans Cloud Shell, créez un répertoire et un nouveau fichier dans ce répertoire. Le nom du fichier doit comporter l'extension

.tf, par exemplemain.tf. Dans ce tutoriel, le fichier est appelémain.tf.mkdir DIRECTORY && cd DIRECTORY && touch main.tf

-

Si vous suivez un tutoriel, vous pouvez copier l'exemple de code dans chaque section ou étape.

Copiez l'exemple de code dans le fichier

main.tfque vous venez de créer.Vous pouvez également copier le code depuis GitHub. Cela est recommandé lorsque l'extrait Terraform fait partie d'une solution de bout en bout.

- Examinez et modifiez les exemples de paramètres à appliquer à votre environnement.

- Enregistrez les modifications.

-

Initialisez Terraform. Cette opération n'est à effectuer qu'une seule fois par répertoire.

terraform init

Vous pouvez également utiliser la dernière version du fournisseur Google en incluant l'option

-upgrade:terraform init -upgrade

Appliquer les modifications

-

Examinez la configuration et vérifiez que les ressources que Terraform va créer ou mettre à jour correspondent à vos attentes :

terraform plan

Corrigez les modifications de la configuration si nécessaire.

-

Appliquez la configuration Terraform en exécutant la commande suivante et en saisissant

yeslorsque vous y êtes invité :terraform apply

Attendez que Terraform affiche le message "Apply completed!" (Application terminée).

- Ouvrez votre projet Google Cloud pour afficher les résultats. Dans la console Google Cloud , accédez à vos ressources dans l'interface utilisateur pour vous assurer que Terraform les a créées ou mises à jour.

Accorder l'accès au compte de service de la connexion

Attribuez le rôle d'agent de service Vertex AI au compte de service de la connexion.

Si vous envisagez de spécifier le point de terminaison en tant qu'URL lors de la création du modèle distant (par exemple, endpoint = 'https://us-central1-aiplatform.googleapis.com/v1/projects/myproject/locations/us-central1/publishers/google/models/gemini-2.0-flash'), accordez ce rôle dans le projet que vous spécifiez dans l'URL.

Si vous envisagez de spécifier le point de terminaison à l'aide du nom du modèle lors de la création du modèle distant (par exemple endpoint = 'gemini-2.0-flash'), accordez ce rôle dans le projet dans lequel vous prévoyez de créer le modèle distant.

L'attribution du rôle dans un autre projet génère l'erreur bqcx-1234567890-wxyz@gcp-sa-bigquery-condel.iam.gserviceaccount.com does not have the permission to access resource.

Pour accorder le rôle, procédez comme suit :

Console

Accédez à la page IAM et administration.

Cliquez sur Accorder l'accès.

Dans le champ Nouveaux comptes principaux, saisissez l'ID du compte de service que vous avez copié précédemment.

Cliquez sur Select a role (Sélectionner un rôle).

Dans le champ Filtre, saisissez

Vertex AI Service Agent, puis sélectionnez ce rôle.Cliquez sur Enregistrer.

gcloud

Exécutez la commande gcloud projects add-iam-policy-binding :

gcloud projects add-iam-policy-binding 'PROJECT_NUMBER' --member='serviceAccount:MEMBER' --role='roles/aiplatform.serviceAgent' --condition=None

Remplacez les éléments suivants :

PROJECT_NUMBER: votre numéro de projet.MEMBER: ID du compte de service que vous avez copié précédemment

Le compte de service associé à votre connexion est une instance de l'agent de service de délégation de connexion BigQuery. Vous pouvez donc lui attribuer un rôle d'agent de service.

Créer un modèle avec réglage supervisé

Dans la console Google Cloud , accédez à la page BigQuery.

Dans l'éditeur de requête, exécutez la requête suivante pour créer un modèle distant :

CREATE OR REPLACE MODEL `PROJECT_ID.DATASET_ID.MODEL_NAME` REMOTE WITH CONNECTION {DEFAULT | `PROJECT_ID.REGION.CONNECTION_ID`} OPTIONS ( ENDPOINT = 'ENDPOINT', MAX_ITERATIONS = MAX_ITERATIONS, LEARNING_RATE_MULTIPLIER = LEARNING_RATE_MULTIPLIER, DATA_SPLIT_METHOD = 'DATA_SPLIT_METHOD', DATA_SPLIT_EVAL_FRACTION = DATA_SPLIT_EVAL_FRACTION, DATA_SPLIT_COL = 'DATA_SPLIT_COL', EVALUATION_TASK = 'EVALUATION_TASK', PROMPT_COL = 'INPUT_PROMPT_COL', INPUT_LABEL_COLS = INPUT_LABEL_COLS) AS SELECT PROMPT_COLUMN, LABEL_COLUMN FROM `TABLE_PROJECT_ID.TABLE_DATASET.TABLE_NAME`;

Remplacez les éléments suivants :

PROJECT_ID: ID du projet dans lequel créer le modèleDATASET_ID: ID de l'ensemble de données pour contenir le modèle. Cet ensemble de données doit se trouver dans une région Vertex AI compatible.MODEL_NAME: nom du modèleREGION: région utilisée par la connexion.CONNECTION_ID: ID de votre connexion BigQuery. Cette connexion doit se trouver dans le même emplacement que l'ensemble de données que vous utilisez.Lorsque vous affichez les détails de la connexion dans la console Google Cloud , il s'agit de la valeur de la dernière section de l'ID de connexion complet affiché dans ID de connexion (par exemple,

projects/myproject/locations/connection_location/connections/myconnection).ENDPOINT: valeurSTRINGspécifiant le nom du modèle à utiliser.MAX_ITERATIONS: valeurINT64qui spécifie le nombre d'étapes à exécuter pour le réglage supervisé. La valeur deMAX_ITERATIONSdoit être comprise entre1et∞.Les modèles Gemini sont entraînés en utilisant des époques plutôt que des étapes. BigQuery ML convertit donc la valeur

MAX_ITERATIONSen époques. La valeur par défaut pourMAX_ITERATIONSest le nombre de lignes dans les données d'entrée, ce qui équivaut à une époque. Pour utiliser plusieurs époques, spécifiez un multiple du nombre de lignes de vos données d'entraînement. Par exemple, si vous disposez de 100 lignes de données d'entrée et que vous souhaitez utiliser deux époques, spécifiez200pour la valeur de l'argument. Si vous fournissez une valeur qui n'est pas un multiple du nombre de lignes dans les données d'entrée, BigQuery ML arrondit à l'époque la plus proche. Par exemple, si vous disposez de 100 lignes de données d'entrée et que vous spécifiez101pour la valeur deMAX_ITERATIONS, l'entraînement est effectué avec deux époques.Pour en savoir plus sur les paramètres utilisés pour régler les modèles Gemini, consultez Créer un job de réglage.

DATA_SPLIT_METHOD: valeurSTRINGspécifiant la méthode utilisée pour scinder les données d'entrée en ensembles d'entraînement et d'évaluation. Les options valides sont les suivantes :AUTO_SPLIT: BigQuery ML divise automatiquement les données. La manière dont les données sont réparties varie en fonction du nombre de lignes de la table d'entrée. Il s'agit de la valeur par défaut.RANDOM: les données sont randomisées avant d'être divisées en ensembles. Pour personnaliser la répartition des données, vous pouvez utiliser cette option avec l'optionDATA_SPLIT_EVAL_FRACTION.CUSTOM: les données sont réparties à l'aide de la colonne fournie dans l'optionDATA_SPLIT_COL. La valeurDATA_SPLIT_COLdoit correspondre au nom d'une colonne de typeBOOL. Les lignes dont la valeur est définie surTRUEouNULLsont utilisées en tant que données d'évaluation, tandis que les lignes dont la valeur est définie surFALSEsont utilisées en tant que données d'entraînement.SEQ: répartit les données à l'aide de la colonne fournie dans l'optionDATA_SPLIT_COL. La valeurDATA_SPLIT_COLdoit correspondre au nom d'une colonne de l'un des types suivants :NUMERICBIGNUMERICSTRINGTIMESTAMP

Les données sont triées de la plus petite à la plus grande en fonction de la colonne spécifiée.

Les n premières lignes sont utilisées en tant que données d'évaluation, où n est la valeur spécifiée pour

DATA_SPLIT_EVAL_FRACTION. Les lignes restantes sont utilisées en tant que données d'entraînement.NO_SPLIT: pas de répartition des données ; toutes les données d'entrée sont utilisées comme données d'entraînement.

Pour en savoir plus sur ces options de répartition des données, consultez la page

DATA_SPLIT_METHOD.DATA_SPLIT_EVAL_FRACTION: valeurFLOAT64spécifiant la fraction des données à utiliser en tant que données d'évaluation lors du réglage supervisé. La valeur doit être comprise dans la plage[0, 1.0]. La valeur par défaut est0.2.Utilisez cette option lorsque vous spécifiez

RANDOMouSEQcomme valeur pour l'optionDATA_SPLIT_METHOD. Pour personnaliser la répartition des données, vous pouvez utiliser l'optionDATA_SPLIT_METHODavec l'optionDATA_SPLIT_EVAL_FRACTION.DATA_SPLIT_COL: valeurSTRINGspécifiant le nom de la colonne à utiliser pour trier les données d'entrée dans l'ensemble d'entraînement ou d'évaluation. Utilisez-la lorsque vous spécifiezCUSTOMouSEQcomme valeur pour l'optionDATA_SPLIT_METHOD.EVALUATION_TASK: valeurSTRINGspécifiant le type de tâche que le modèle doit effectuer. Les options valides sont les suivantes :TEXT_GENERATIONCLASSIFICATIONSUMMARIZATIONQUESTION_ANSWERINGUNSPECIFIED

La valeur par défaut est

UNSPECIFIED.INPUT_PROMPT_COL: valeurSTRINGcontenant le nom de la colonne de requête de la table de données d'entraînement à utiliser lors du réglage supervisé. La valeur par défaut estprompt.INPUT_LABEL_COLS: valeurARRAY<<STRING>contenant le nom de la colonne d'étiquette de la table de données d'entraînement à utiliser dans le réglage supervisé. Vous ne pouvez spécifier qu'un seul élément dans le tableau. La valeur par défaut de cet attribut est un tableau vide. Ainsi,labeldevient la valeur par défaut de l'argumentLABEL_COLUMN.PROMPT_COLUMN: colonne de la table de données d'entraînement contenant la requête permettant d'évaluer le contenu de la colonneLABEL_COLUMN. Cette colonne doit être de typeSTRINGou castée versSTRING. Si vous spécifiez une valeur pour l'optionINPUT_PROMPT_COL, vous devez spécifier la même valeur pourPROMPT_COLUMN. Sinon, cette valeur doit êtreprompt. Si votre table ne comporte pas de colonneprompt, utilisez un alias pour spécifier une colonne de table existante. Par exemple,AS SELECT hint AS prompt, label FROM mydataset.mytable.LABEL_COLUMN: colonne de la table de données d'entraînement contenant les exemples avec lesquels entraîner le modèle. Cette colonne doit être de typeSTRINGou castée versSTRING. Si vous spécifiez une valeur pour l'optionINPUT_LABEL_COLS, vous devez spécifier la même valeur pourLABEL_COLUMN. Sinon, cette valeur doit êtrelabel. Si votre table ne comporte pas de colonnelabel, utilisez un alias pour spécifier une colonne de table existante. Par exemple,AS SELECT prompt, feature AS label FROM mydataset.mytable.TABLE_PROJECT_ID: ID du projet contenant la table de données d'entraînementTABLE_DATASET: nom de l'ensemble de données contenant la table de données d'entraînementTABLE_NAME: nom de la table contenant les données à utiliser pour entraîner le modèle

Évaluer le modèle réglé

Dans la console Google Cloud , accédez à la page BigQuery.

Dans l'éditeur de requête, exécutez la requête suivante pour évaluer le modèle réglé:

SELECT * FROM ML.EVALUATE( MODEL `PROJECT_ID.DATASET_ID.MODEL_NAME`, TABLE `TABLE_PROJECT_ID.TABLE_DATASET.TABLE_NAME`, STRUCT('TASK_TYPE' AS task_type, TOKENS AS max_output_tokens, TEMPERATURE AS temperature, TOP_K AS top_k, TOP_P AS top_p));

Remplacez les éléments suivants :

PROJECT_ID: ID du projet contenant le modèleDATASET_ID: ID de l'ensemble de données contenant le modèle.MODEL_NAME: nom du modèleTABLE_PROJECT_ID: ID du projet contenant la table de données d'évaluation.TABLE_DATASET: nom de l'ensemble de données contenant la table de données d'évaluationTABLE_NAME: nom de la table contenant les données d'évaluation.La table doit comporter une colonne dont le nom correspond au nom de la colonne de requête fournie lors de l'entraînement du modèle. Vous pouvez fournir cette valeur à l'aide de l'option

prompt_collors de l'entraînement du modèle. Siprompt_coln'est pas spécifié, la colonnepromptdans les données d'entraînement est utilisée. Une erreur est renvoyée s'il n'existe aucune colonne nomméeprompt.La table doit comporter une colonne dont le nom correspond au nom de la colonne d'étiquette fournie lors de l'entraînement du modèle. Vous pouvez fournir cette valeur à l'aide de l'option

input_label_colslors de l'entraînement du modèle. Siinput_label_colsn'est pas spécifié, la colonnelabeldans les données d'entraînement est utilisée. Une erreur est renvoyée s'il n'existe aucune colonne nomméelabel.TASK_TYPE: valeurSTRINGspécifiant le type de tâche pour lequel vous souhaitez évaluer le modèle. Les options valides sont les suivantes :TEXT_GENERATIONCLASSIFICATIONSUMMARIZATIONQUESTION_ANSWERINGUNSPECIFIED

TOKENS: valeurINT64qui définit le nombre maximal de jetons pouvant être générés dans la réponse. Cette valeur doit être comprise dans la plage[1,1024]. Spécifiez une valeur inférieure pour obtenir des réponses plus courtes et une valeur supérieure pour des réponses plus longues. La valeur par défaut est128.TEMPERATURE: valeurFLOAT64comprise dans la plage[0.0,1.0]qui contrôle le degré d'aléatoire dans la sélection des jetons. La valeur par défaut est0.Des valeurs inférieures pour

temperatureconviennent aux requêtes qui nécessitent une réponse plus déterministe et moins ouverte ou créative, tandis que des valeurs plus élevées pourtemperaturepeuvent entraîner des résultats plus diversifiés ou créative. Une valeur0pourtemperatureest déterministe, ce qui signifie que la réponse dont la probabilité est la plus élevée est toujours sélectionnée.TOP_K: valeurINT64comprise dans la plage[1,40]qui détermine le pool initial de jetons pris en compte par le modèle pour la sélection. Spécifiez une valeur inférieure pour les réponses moins aléatoires et une valeur plus élevée pour les réponses plus aléatoires. La valeur par défaut est40.TOP_P: une valeurFLOAT64comprise dans la plage[0.0,1.0]permet de déterminer quels jetons du pool déterminés parTOP_Ksont sélectionnés. Spécifiez une valeur inférieure pour les réponses moins aléatoires et une valeur plus élevée pour les réponses plus aléatoires. La valeur par défaut est0.95.

Générer du texte

Générez du texte à l'aide de la fonction ML.GENERATE_TEXT :

Colonne de requête

Générer du texte à l'aide d'une colonne de table pour fournir la requête.

SELECT * FROM ML.GENERATE_TEXT( MODEL `PROJECT_ID.DATASET_ID.MODEL_NAME`, TABLE PROJECT_ID.DATASET_ID.TABLE_NAME, STRUCT(TOKENS AS max_output_tokens, TEMPERATURE AS temperature, TOP_P AS top_p, FLATTEN_JSON AS flatten_json_output, STOP_SEQUENCES AS stop_sequences) );

Remplacez les éléments suivants :

PROJECT_ID: ID de votre projet.DATASET_ID: ID de l'ensemble de données contenant le modèle.MODEL_NAME: nom du modèleTABLE_NAME: nom de la table contenant la requête. Cette table doit comporter une colonne dont le nom correspond au nom de la colonne de caractéristiques dans le modèle réglé. Le nom de la colonne de caractéristiques dans le modèle peut être défini à l'aide de l'optionPROMPT_COLlors de la création du modèle. Sinon, le nom de la colonne de caractéristiques dans le modèle estpromptpar défaut. Vous pouvez également utiliser un alias pour utiliser une colonne portant un nom différent.TOKENS: valeurINT64qui définit le nombre maximal de jetons pouvant être générés dans la réponse. Cette valeur doit être comprise dans la plage[1,8192]. Spécifiez une valeur inférieure pour obtenir des réponses plus courtes et une valeur supérieure pour des réponses plus longues. La valeur par défaut est128.TEMPERATURE: valeurFLOAT64comprise dans la plage[0.0,1.0]qui contrôle le degré de randomisation dans la sélection des jetons. La valeur par défaut est0.Des valeurs inférieures pour

temperatureconviennent aux requêtes qui nécessitent une réponse plus déterministe et moins ouverte ou créative, tandis que des valeurs plus élevées pourtemperaturepeuvent entraîner des résultats plus diversifiés ou créative. Une valeur0pourtemperatureest déterministe, ce qui signifie que la réponse dont la probabilité est la plus élevée est toujours sélectionnée.TOP_P: une valeurFLOAT64comprise dans la plage[0.0,1.0]permet de déterminer la probabilité de sélection des jetons. Spécifiez une valeur inférieure pour obtenir des réponses moins aléatoires et une valeur supérieure pour des réponses plus aléatoires. La valeur par défaut est0.95.FLATTEN_JSON: valeurBOOLqui détermine si le texte généré et les attributs de sécurité doivent être renvoyés dans des colonnes distinctes. La valeur par défaut estFALSE.STOP_SEQUENCES: valeurARRAY<STRING>qui supprime les chaînes spécifiées si elles sont incluses dans les réponses du modèle. Les chaînes correspondent exactement, y compris la casse. La valeur par défaut est un tableau vide.GROUND_WITH_GOOGLE_SEARCH: valeurBOOLqui détermine si le modèle Vertex AI utilise l'ancrage avec la recherche Google lors de la génération de réponses. L'ancrage permet au modèle d'utiliser des informations supplémentaires provenant d'Internet lorsqu'il génère une réponse, afin de rendre les réponses plus spécifiques et factuelles. Lorsqueflatten_json_outputet ce champ sont tous deux définis surTrue, une colonneml_generate_text_grounding_resultsupplémentaire est incluse dans les résultats, fournissant ainsi les sources utilisées par le modèle pour collecter des informations supplémentaires. La valeur par défaut estFALSE.SAFETY_SETTINGS: valeurARRAY<STRUCT<STRING AS category, STRING AS threshold>>qui configure les seuils de sécurité du contenu pour filtrer les réponses. Le premier élément de la structure spécifie une catégorie de préjudice, et le second élément spécifie un seuil de blocage correspondant. Le modèle filtre les contenus qui ne respectent pas ces paramètres. Vous ne pouvez spécifier chaque catégorie qu'une seule fois. Par exemple, vous ne pouvez pas spécifier à la foisSTRUCT('HARM_CATEGORY_DANGEROUS_CONTENT' AS category, 'BLOCK_MEDIUM_AND_ABOVE' AS threshold)etSTRUCT('HARM_CATEGORY_DANGEROUS_CONTENT' AS category, 'BLOCK_ONLY_HIGH' AS threshold). S'il n'existe aucun paramètre de sécurité pour une catégorie donnée, le paramètre de sécuritéBLOCK_MEDIUM_AND_ABOVEest utilisé.Voici les catégories acceptées :

HARM_CATEGORY_HATE_SPEECHHARM_CATEGORY_DANGEROUS_CONTENTHARM_CATEGORY_HARASSMENTHARM_CATEGORY_SEXUALLY_EXPLICIT

Les seuils acceptés sont les suivants :

BLOCK_NONE(Limité)BLOCK_LOW_AND_ABOVEBLOCK_MEDIUM_AND_ABOVE(par défaut)BLOCK_ONLY_HIGHHARM_BLOCK_THRESHOLD_UNSPECIFIED

Pour en savoir plus, consultez les définitions de catégorie de sécurité et de seuil de blocage.

REQUEST_TYPE: valeurSTRINGspécifiant le type de requête d'inférence à envoyer au modèle Gemini. Le type de requête détermine le quota utilisé par la requête. Les valeurs valides sont les suivantes :DEDICATED: la fonctionML.GENERATE_TEXTn'utilise que le quota de débit provisionné. La fonctionML.GENERATE_TEXTrenvoie l'erreurProvisioned throughput is not purchased or is not activesi le quota de débit provisionné n'est pas disponible.SHARED: la fonctionML.GENERATE_TEXTn'utilise que le quota partagé dynamique (QPD), même si vous avez acheté un quota de débit provisionné.UNSPECIFIED: la fonctionML.GENERATE_TEXTutilise le quota comme suit :- Si vous n'avez pas acheté de quota de débit provisionné, la fonction

ML.GENERATE_TEXTutilise le quota de DSQ. - Si vous avez acheté un quota de débit provisionné, la fonction

ML.GENERATE_TEXTl'utilise en premier. Si les requêtes dépassent le quota de débit provisionné, le trafic excédentaire utilise le quota DSQ.

- Si vous n'avez pas acheté de quota de débit provisionné, la fonction

La valeur par défaut est

UNSPECIFIED.Pour en savoir plus, consultez Utiliser le débit provisionné Vertex AI.

L'exemple suivant montre une requête avec ces caractéristiques :

- Elle utilise la colonne

promptde la tablepromptspour la requête. - Elle renvoie une réponse courte et relativement probable.

- Elle renvoie le texte généré et les attributs de sécurité dans des colonnes distinctes.

SELECT * FROM ML.GENERATE_TEXT( MODEL `mydataset.mymodel`, TABLE mydataset.prompts, STRUCT( 0.4 AS temperature, 100 AS max_output_tokens, 0.5 AS top_p, TRUE AS flatten_json_output));

Requête à partir d'une recherche

Générer du texte à l'aide d'une recherche pour fournir la requête.

SELECT * FROM ML.GENERATE_TEXT( MODEL `PROJECT_ID.DATASET_ID.MODEL_NAME`, (PROMPT_QUERY), STRUCT(TOKENS AS max_output_tokens, TEMPERATURE AS temperature, TOP_P AS top_p, FLATTEN_JSON AS flatten_json_output, STOP_SEQUENCES AS stop_sequences) );

Remplacez les éléments suivants :

PROJECT_ID: ID de votre projet.DATASET_ID: ID de l'ensemble de données contenant le modèle.MODEL_NAME: nom du modèlePROMPT_QUERY: fournit les données de la requête.TOKENS: valeurINT64qui définit le nombre maximal de jetons pouvant être générés dans la réponse. Cette valeur doit être comprise dans la plage[1,8192]. Spécifiez une valeur inférieure pour obtenir des réponses plus courtes et une valeur supérieure pour des réponses plus longues. La valeur par défaut est128.TEMPERATURE: valeurFLOAT64comprise dans la plage[0.0,1.0]qui contrôle le degré de randomisation dans la sélection des jetons. La valeur par défaut est0.Des valeurs inférieures pour

temperatureconviennent aux requêtes qui nécessitent une réponse plus déterministe et moins ouverte ou créative, tandis que des valeurs plus élevées pourtemperaturepeuvent entraîner des résultats plus diversifiés ou créative. Une valeur0pourtemperatureest déterministe, ce qui signifie que la réponse dont la probabilité est la plus élevée est toujours sélectionnée.TOP_P: une valeurFLOAT64comprise dans la plage[0.0,1.0]permet de déterminer la probabilité de sélection des jetons. Spécifiez une valeur inférieure pour obtenir des réponses moins aléatoires et une valeur supérieure pour des réponses plus aléatoires. La valeur par défaut est0.95.FLATTEN_JSON: valeurBOOLqui détermine si le texte généré et les attributs de sécurité doivent être renvoyés dans des colonnes distinctes. La valeur par défaut estFALSE.STOP_SEQUENCES: valeurARRAY<STRING>qui supprime les chaînes spécifiées si elles sont incluses dans les réponses du modèle. Les chaînes correspondent exactement, y compris la casse. La valeur par défaut est un tableau vide.GROUND_WITH_GOOGLE_SEARCH: valeurBOOLqui détermine si le modèle Vertex AI utilise l'ancrage avec la recherche Google lors de la génération de réponses. L'ancrage permet au modèle d'utiliser des informations supplémentaires provenant d'Internet lorsqu'il génère une réponse, afin de rendre les réponses plus spécifiques et factuelles. Lorsqueflatten_json_outputet ce champ sont tous deux définis surTrue, une colonneml_generate_text_grounding_resultsupplémentaire est incluse dans les résultats, fournissant ainsi les sources utilisées par le modèle pour collecter des informations supplémentaires. La valeur par défaut estFALSE.SAFETY_SETTINGS: valeurARRAY<STRUCT<STRING AS category, STRING AS threshold>>qui configure les seuils de sécurité du contenu pour filtrer les réponses. Le premier élément de la structure spécifie une catégorie de préjudice, et le second élément spécifie un seuil de blocage correspondant. Le modèle filtre les contenus qui ne respectent pas ces paramètres. Vous ne pouvez spécifier chaque catégorie qu'une seule fois. Par exemple, vous ne pouvez pas spécifier à la foisSTRUCT('HARM_CATEGORY_DANGEROUS_CONTENT' AS category, 'BLOCK_MEDIUM_AND_ABOVE' AS threshold)etSTRUCT('HARM_CATEGORY_DANGEROUS_CONTENT' AS category, 'BLOCK_ONLY_HIGH' AS threshold). S'il n'existe aucun paramètre de sécurité pour une catégorie donnée, le paramètre de sécuritéBLOCK_MEDIUM_AND_ABOVEest utilisé.Voici les catégories acceptées :

HARM_CATEGORY_HATE_SPEECHHARM_CATEGORY_DANGEROUS_CONTENTHARM_CATEGORY_HARASSMENTHARM_CATEGORY_SEXUALLY_EXPLICIT

Les seuils acceptés sont les suivants :

BLOCK_NONE(Limité)BLOCK_LOW_AND_ABOVEBLOCK_MEDIUM_AND_ABOVE(par défaut)BLOCK_ONLY_HIGHHARM_BLOCK_THRESHOLD_UNSPECIFIED

Pour en savoir plus, consultez les définitions de catégorie de sécurité et de seuil de blocage.

REQUEST_TYPE: valeurSTRINGspécifiant le type de requête d'inférence à envoyer au modèle Gemini. Le type de requête détermine le quota utilisé par la requête. Les valeurs valides sont les suivantes :DEDICATED: la fonctionML.GENERATE_TEXTn'utilise que le quota de débit provisionné. La fonctionML.GENERATE_TEXTrenvoie l'erreurProvisioned throughput is not purchased or is not activesi le quota de débit provisionné n'est pas disponible.SHARED: la fonctionML.GENERATE_TEXTn'utilise que le quota partagé dynamique (QPD), même si vous avez acheté un quota de débit provisionné.UNSPECIFIED: la fonctionML.GENERATE_TEXTutilise le quota comme suit :- Si vous n'avez pas acheté de quota de débit provisionné, la fonction

ML.GENERATE_TEXTutilise le quota de DSQ. - Si vous avez acheté un quota de débit provisionné, la fonction

ML.GENERATE_TEXTl'utilise en premier. Si les requêtes dépassent le quota de débit provisionné, le trafic excédentaire utilise le quota DSQ.

- Si vous n'avez pas acheté de quota de débit provisionné, la fonction

La valeur par défaut est

UNSPECIFIED.Pour en savoir plus, consultez Utiliser le débit provisionné Vertex AI.

Exemple 1

L'exemple suivant montre une requête avec ces caractéristiques :

- Elle demande le résumé du texte dans la colonne

bodyde la tablearticles. - Elle renvoie une réponse relativement longue et plus probable.

- Elle renvoie le texte généré et les attributs de sécurité dans des colonnes distinctes.

SELECT * FROM ML.GENERATE_TEXT( MODEL `mydataset.mymodel`, ( SELECT CONCAT('Summarize this text', body) AS prompt FROM mydataset.articles ), STRUCT( 0.2 AS temperature, 650 AS max_output_tokens, 0.2 AS top_p, TRUE AS flatten_json_output));

Exemple 2

L'exemple suivant montre une requête avec ces caractéristiques :

- Elle utilise une requête pour créer les données de requête en concaténant les chaînes qui fournissent des préfixes de requête avec des colonnes de table.

- Elle renvoie une réponse courte et relativement probable.

- Elle ne renvoie pas le texte généré et les attributs de sécurité dans des colonnes distinctes.

SELECT * FROM ML.GENERATE_TEXT( MODEL `mydataset.mytuned_model`, ( SELECT CONCAT(question, 'Text:', description, 'Category') AS prompt FROM mydataset.input_table ), STRUCT( 0.4 AS temperature, 100 AS max_output_tokens, 0.5 AS top_p, FALSE AS flatten_json_output));