Dans ce tutoriel, vous allez créer une vue autorisée dans BigQuery qui sera utilisée par vos analystes de données. Les vues autorisées vous permettent de partager des résultats de requête avec des utilisateurs et des groupes particuliers sans leur donner accès aux données sources sous-jacentes. L'accès aux données sources est accordé à la vue, et non à un utilisateur ou un groupe. Vous pouvez également utiliser la requête SQL de la vue pour exclure des colonnes et des champs des résultats de la requête.

Une autre approche que l'utilisation d'une vue autorisée consiste à configurer des contrôles d'accès au niveau des colonnes sur les données sources, puis à accorder à vos utilisateurs l'accès à une vue qui interroge les données contrôlées. Pour en savoir plus sur les contrôles d'accès au niveau des colonnes, consultez Présentation du contrôle des accès au niveau des colonnes.

Si vous disposez de plusieurs vues autorisées qui accèdent au même ensemble de données source, vous pouvez autoriser l'ensemble de données contenant les vues au lieu d'autoriser une vue individuelle.

Créer un ensemble de données pour stocker vos données sources

Commencez par créer un ensemble de données pour y stocker les données sources.

Pour créer votre ensemble de données source, choisissez l'une des options suivantes :

Console

Accédez à la page BigQuery.

Dans le panneau de gauche, cliquez sur Explorer :

Si le volet de gauche n'apparaît pas, cliquez sur Développer le volet de gauche pour l'ouvrir.

Dans le volet Explorateur, à côté du projet dans lequel vous souhaitez créer l'ensemble de données, cliquez sur Afficher les actions > Créer un ensemble de données.

Sur la page Créer un ensemble de données, procédez comme suit :

Dans le champ ID de l'ensemble de données, saisissez

github_source_data.Dans le champ Type d'emplacement, vérifiez que Multirégional est sélectionné.

Pour Multirégional, sélectionnez US ou UE. Toutes les ressources que vous créez dans ce tutoriel doivent se trouver dans la même région multirégionale.

Cliquez sur Créer un ensemble de données.

SQL

Utilisez l'instruction LDD CREATE SCHEMA :

Dans la console Google Cloud , accédez à la page BigQuery.

Dans l'éditeur de requête, saisissez l'instruction suivante :

CREATE SCHEMA github_source_data;

Cliquez sur Exécuter.

Pour en savoir plus sur l'exécution des requêtes, consultez Exécuter une requête interactive.

Java

Avant d'essayer cet exemple, suivez les instructions de configuration pour Java du guide de démarrage rapide de BigQuery : Utiliser les bibliothèques clientes. Pour en savoir plus, consultez la documentation de référence de l'API BigQuery pour Java.

Pour vous authentifier auprès de BigQuery, configurez le service Identifiants par défaut de l'application. Pour en savoir plus, consultez la page Configurer l'authentification pour les bibliothèques clientes.

Python

Avant d'essayer cet exemple, suivez les instructions de configuration pour Python du guide de démarrage rapide de BigQuery : Utiliser les bibliothèques clientes. Pour en savoir plus, consultez la documentation de référence de l'API BigQuery pour Python.

Pour vous authentifier auprès de BigQuery, configurez le service Identifiants par défaut de l'application. Pour en savoir plus, consultez la page Configurer l'authentification pour les bibliothèques clientes.

Créer une table et charger vos données sources

Une fois l'ensemble de données source créé, remplissez une table en enregistrant les résultats d'une requête SQL dans une table de destination. La requête extrait des données de l'ensemble de données public GitHub.

Console

Accédez à la page BigQuery.

Dans Query editor (éditeur de requête), saisissez la requête suivante :

SELECT commit, author, committer, repo_name FROM `bigquery-public-data.github_repos.commits` LIMIT 1000;Cliquez sur Plus et sélectionnez Paramètres de requête.

Destination : sélectionnez Définir une table de destination pour les résultats de la requête.

Dans le champ Ensemble de données, saisissez

PROJECT_ID.github_source_data.Remplacez

PROJECT_IDpar l'ID du projet.Dans le champ ID de table, saisissez

github_contributors.Cliquez sur Enregistrer.

Cliquez sur Exécuter.

Une fois la requête terminée, dans le volet Explorateur, cliquez sur Ensembles de données, puis sur l'ensemble de données

github_source_data.Cliquez sur Vue d'ensemble > Tables, puis sur la table

github_contributors.Pour vérifier que les données ont bien été écrites dans la table, cliquez sur l'onglet Aperçu.

Java

Avant d'essayer cet exemple, suivez les instructions de configuration pour Java du guide de démarrage rapide de BigQuery : Utiliser les bibliothèques clientes. Pour en savoir plus, consultez la documentation de référence de l'API BigQuery pour Java.

Pour vous authentifier auprès de BigQuery, configurez le service Identifiants par défaut de l'application. Pour en savoir plus, consultez la page Configurer l'authentification pour les bibliothèques clientes.

Python

Avant d'essayer cet exemple, suivez les instructions de configuration pour Python du guide de démarrage rapide de BigQuery : Utiliser les bibliothèques clientes. Pour en savoir plus, consultez la documentation de référence de l'API BigQuery pour Python.

Pour vous authentifier auprès de BigQuery, configurez le service Identifiants par défaut de l'application. Pour en savoir plus, consultez la page Configurer l'authentification pour les bibliothèques clientes.

Créer un ensemble de données pour stocker votre vue autorisée

Après avoir créé votre ensemble de données source, vous allez créer un ensemble de données distinct pour stocker la vue autorisée que vous partagerez avec vos analystes de données. Plus tard, vous accorderez à la vue autorisée l'accès aux données de l'ensemble de données source. Vos analystes de données pourront accéder à la vue autorisée, mais pas aux données sources.

Les vues autorisées doivent être créées dans un ensemble de données différent de celui des données sources. De cette façon, les propriétaires de données peuvent autoriser les utilisateurs à accéder à la vue autorisée sans accorder simultanément l'accès aux données sous-jacentes. L'ensemble de données des données source et l'ensemble de données de la vue autorisée doivent se trouver dans le même emplacement régional.

Pour créer un ensemble de données dans lequel stocker votre vue, choisissez l'une des options suivantes :

Console

Accédez à la page BigQuery.

Dans le panneau de gauche, cliquez sur Explorer :

Dans le panneau Explorateur, sélectionnez le projet dans lequel vous souhaitez créer l'ensemble de données.

Développez l'option Afficher les actions, puis cliquez sur Créer un ensemble de données.

Sur la page Créer un ensemble de données, procédez comme suit :

Dans le champ ID de l'ensemble de données, saisissez

shared_views.Dans le champ Type d'emplacement, vérifiez que Multirégional est sélectionné.

Pour Multirégional, sélectionnez US ou UE. Toutes les ressources que vous créez dans ce tutoriel doivent se trouver dans la même région multirégionale.

Cliquez sur Créer un ensemble de données.

SQL

Utilisez l'instruction LDD CREATE SCHEMA :

Dans la console Google Cloud , accédez à la page BigQuery.

Dans l'éditeur de requête, saisissez l'instruction suivante :

CREATE SCHEMA shared_views;

Cliquez sur Exécuter.

Pour en savoir plus sur l'exécution des requêtes, consultez Exécuter une requête interactive.

Java

Avant d'essayer cet exemple, suivez les instructions de configuration pour Java du guide de démarrage rapide de BigQuery : Utiliser les bibliothèques clientes. Pour en savoir plus, consultez la documentation de référence de l'API BigQuery pour Java.

Pour vous authentifier auprès de BigQuery, configurez le service Identifiants par défaut de l'application. Pour en savoir plus, consultez la page Configurer l'authentification pour les bibliothèques clientes.

Python

Avant d'essayer cet exemple, suivez les instructions de configuration pour Python du guide de démarrage rapide de BigQuery : Utiliser les bibliothèques clientes. Pour en savoir plus, consultez la documentation de référence de l'API BigQuery pour Python.

Pour vous authentifier auprès de BigQuery, configurez le service Identifiants par défaut de l'application. Pour en savoir plus, consultez la page Configurer l'authentification pour les bibliothèques clientes.

Créer la vue autorisée dans le nouvel ensemble de données

Dans le nouvel ensemble de données, créez la vue que vous souhaitez autoriser. Il s'agit de la vue que vous partagerez avec vos analystes de données. Cette vue est créée à l'aide d'une requête SQL qui exclut les colonnes que les analystes de données ne doivent pas voir.

La table source github_contributors contient deux champs de type RECORD : author et committer. Pour ce tutoriel, votre vue autorisée exclut toutes les données de l'auteur, à l'exception de son nom, ainsi que toutes les données du validateur, à l'exception de son nom.

Pour créer cette vue dans le nouvel ensemble de données, choisissez l'une des options suivantes :

Console

Accédez à la page BigQuery.

Dans l'éditeur de requête, saisissez la requête suivante.

SELECT commit, author.name AS author, committer.name AS committer, repo_name FROM `PROJECT_ID.github_source_data.github_contributors`;

Remplacez

PROJECT_IDpar l'ID du projet.Cliquez sur Enregistrer > Enregistrer la vue.

Dans la boîte de dialogue Enregistrer la vue, procédez comme suit :

Pour le champ Projet, vérifiez que votre projet est sélectionné.

Dans le champ Ensemble de données, saisissez

shared_views.Pour Table, saisissez

github_analyst_view.Cliquez sur Enregistrer.

SQL

Utilisez l'instruction LDD CREATE VIEW :

Dans la console Google Cloud , accédez à la page BigQuery.

Dans l'éditeur de requête, saisissez l'instruction suivante :

CREATE VIEW shared_views.github_analyst_view AS ( SELECT commit, author.name AS author, committer.name AS committer, repo_name FROM `PROJECT_ID.github_source_data.github_contributors` );

Remplacez

PROJECT_IDpar l'ID du projet.Cliquez sur Exécuter.

Pour en savoir plus sur l'exécution des requêtes, consultez Exécuter une requête interactive.

Java

Avant d'essayer cet exemple, suivez les instructions de configuration pour Java du guide de démarrage rapide de BigQuery : Utiliser les bibliothèques clientes. Pour en savoir plus, consultez la documentation de référence de l'API BigQuery pour Java.

Pour vous authentifier auprès de BigQuery, configurez le service Identifiants par défaut de l'application. Pour en savoir plus, consultez la page Configurer l'authentification pour les bibliothèques clientes.

Python

Avant d'essayer cet exemple, suivez les instructions de configuration pour Python du guide de démarrage rapide de BigQuery : Utiliser les bibliothèques clientes. Pour en savoir plus, consultez la documentation de référence de l'API BigQuery pour Python.

Pour vous authentifier auprès de BigQuery, configurez le service Identifiants par défaut de l'application. Pour en savoir plus, consultez la page Configurer l'authentification pour les bibliothèques clientes.

Autoriser vos analystes de données à exécuter des tâches de requête

Pour interroger la vue, vos analystes de données doivent disposer de l'autorisation bigquery.jobs.create afin de pouvoir exécuter des tâches de requête. Ils doivent également avoir accès à la vue. Dans cette section, vous accordez le rôle bigquery.user à vos analystes de données. Le rôle bigquery.user inclut l'autorisation bigquery.jobs.create. Plus tard, vous accorderez à vos analystes de données l'autorisation d'accéder à la vue.

Pour attribuer au groupe d'analystes de données le rôle bigquery.user au niveau du projet, procédez comme suit :

Dans la console Google Cloud , accédez à la page IAM.

Assurez-vous que votre projet est sélectionné dans le sélecteur de projet.

Cliquez sur Accorder l'accès.

Dans la boîte de dialogue Accorder l'accès à, procédez comme suit :

Dans le champ Nouveaux comptes principaux, saisissez le groupe contenant vos analystes de données. Exemple :

data_analysts@example.comDans le champ Sélectionner un rôle, recherchez le rôle Utilisateur BigQuery et sélectionnez-le.

Cliquez sur Enregistrer.

Accorder à vos analystes de données l'autorisation d'interroger la vue autorisée

Pour que vos analystes de données puissent interroger la vue, ils doivent disposer du rôle bigquery.dataViewer au niveau de l'ensemble de données ou de la vue.

Si vous attribuez ce rôle au niveau de l'ensemble de données, vos analystes auront accès à toutes les tables et vues de l'ensemble de données. Étant donné que l'ensemble de données créé dans ce tutoriel ne contient qu'une seule vue autorisée, vous accordez l'accès au niveau de l'ensemble de données. Si vous disposez d'une collection de vues autorisées auxquelles vous devez accorder l'accès, envisagez d'utiliser un ensemble de données autorisé à la place.

Le rôle bigquery.user que vous avez précédemment accordé à vos analystes de données leur donne les autorisations requises pour créer des tâches de requête. Cependant, ils ne peuvent pas interroger la vue, sauf s'ils disposent également d'un accès bigquery.dataViewer à la vue autorisée ou à l'ensemble de données qui la contient.

Pour accorder à vos analystes de données l'accès bigquery.dataViewer à l'ensemble de données contenant la vue autorisée, procédez comme suit :

Console

Accédez à la page BigQuery.

Dans le panneau de gauche, cliquez sur Explorer :

Dans le volet Explorateur, cliquez sur Ensembles de données, puis sélectionnez l'ensemble de données

shared_viewspour ouvrir l'onglet Détails.Cliquez sur Partage > Autorisations.

Dans le volet Autorisations de partage, cliquez sur Ajouter un compte principal.

Dans Nouveaux comptes principaux, saisissez le groupe contenant vos analystes de données (par exemple,

data_analysts@example.com).Cliquez sur Sélectionner un rôle, puis sélectionnez BigQuery > Lecteur de données BigQuery.

Cliquez sur Enregistrer.

Cliquez sur Fermer.

Java

Avant d'essayer cet exemple, suivez les instructions de configuration pour Java du guide de démarrage rapide de BigQuery : Utiliser les bibliothèques clientes. Pour en savoir plus, consultez la documentation de référence de l'API BigQuery pour Java.

Pour vous authentifier auprès de BigQuery, configurez le service Identifiants par défaut de l'application. Pour en savoir plus, consultez la page Configurer l'authentification pour les bibliothèques clientes.

Python

Avant d'essayer cet exemple, suivez les instructions de configuration pour Python du guide de démarrage rapide de BigQuery : Utiliser les bibliothèques clientes. Pour en savoir plus, consultez la documentation de référence de l'API BigQuery pour Python.

Pour vous authentifier auprès de BigQuery, configurez le service Identifiants par défaut de l'application. Pour en savoir plus, consultez la page Configurer l'authentification pour les bibliothèques clientes.

Autoriser la vue à accéder à l'ensemble de données source

Une fois que vous avez créé des contrôles d'accès pour l'ensemble de données contenant la vue autorisée, vous accordez à la vue autorisée l'accès à l'ensemble de données source. Cette autorisation permet à la vue, mais pas à votre groupe d'analystes de données, d'accéder aux données sources.

Pour accorder à la vue autorisée l'accès aux données source, choisissez l'une des options suivantes :

Console

Accédez à la page BigQuery.

Dans le panneau de gauche, cliquez sur Explorer :

Dans le volet Explorateur, cliquez sur Ensembles de données, puis sélectionnez l'ensemble de données

github_source_datapour ouvrir l'onglet Détails.Cliquez sur Partage > Autoriser les vues.

Dans le volet Vues autorisées, saisissez

PROJECT_ID.shared_views.github_analyst_viewdans le champ Vue autorisée.Remplacez PROJECT_ID par l'ID du projet.

Cliquez sur Ajouter une autorisation.

Java

Avant d'essayer cet exemple, suivez les instructions de configuration pour Java du guide de démarrage rapide de BigQuery : Utiliser les bibliothèques clientes. Pour en savoir plus, consultez la documentation de référence de l'API BigQuery pour Java.

Pour vous authentifier auprès de BigQuery, configurez le service Identifiants par défaut de l'application. Pour en savoir plus, consultez la page Configurer l'authentification pour les bibliothèques clientes.

Python

Avant d'essayer cet exemple, suivez les instructions de configuration pour Python du guide de démarrage rapide de BigQuery : Utiliser les bibliothèques clientes. Pour en savoir plus, consultez la documentation de référence de l'API BigQuery pour Python.

Pour vous authentifier auprès de BigQuery, configurez le service Identifiants par défaut de l'application. Pour en savoir plus, consultez la page Configurer l'authentification pour les bibliothèques clientes.

Vérifier la configuration

Une fois la configuration effectuée, un membre de votre groupe d'analystes de données (par exemple, data_analysts) peut la vérifier en interrogeant la vue.

Pour valider la configuration, un analyste de données doit exécuter la requête suivante :

Accédez à la page BigQuery.

Dans l'éditeur de requête, saisissez l'instruction suivante :

SELECT * FROM `

PROJECT_ID.shared_views.github_analyst_view`;Remplacez

PROJECT_IDpar l'ID du projet.Cliquez sur Exécuter.

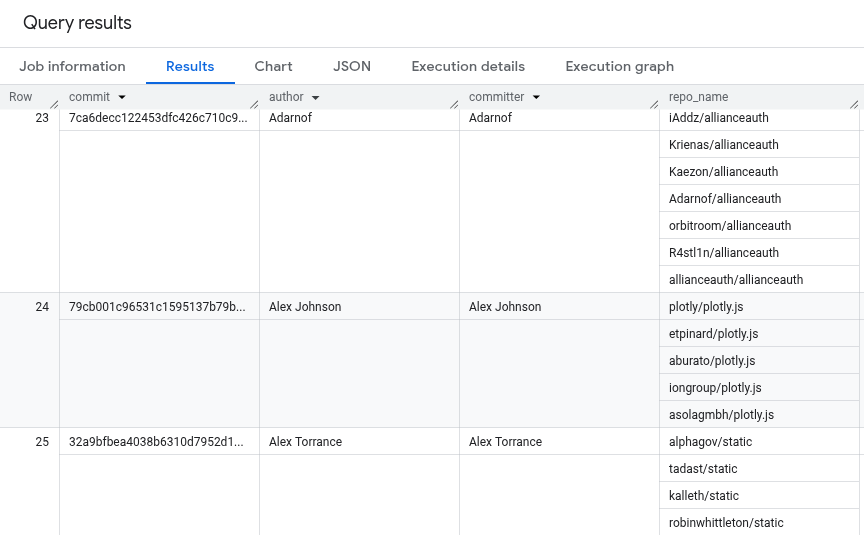

Les résultats de la requête sont semblables à ceux-ci. Seuls le nom de l'auteur et celui du commiteur sont visibles dans les résultats.

Pour en savoir plus sur l'exécution des requêtes, consultez Exécuter une requête interactive.

Code source complet

Voici le code source complet du tutoriel à titre de référence.

Java

Avant d'essayer cet exemple, suivez les instructions de configuration pour Java du guide de démarrage rapide de BigQuery : Utiliser les bibliothèques clientes. Pour en savoir plus, consultez la documentation de référence de l'API BigQuery pour Java.

Pour vous authentifier auprès de BigQuery, configurez le service Identifiants par défaut de l'application. Pour en savoir plus, consultez la page Configurer l'authentification pour les bibliothèques clientes.

Python

Avant d'essayer cet exemple, suivez les instructions de configuration pour Python du guide de démarrage rapide de BigQuery : Utiliser les bibliothèques clientes. Pour en savoir plus, consultez la documentation de référence de l'API BigQuery pour Python.

Pour vous authentifier auprès de BigQuery, configurez le service Identifiants par défaut de l'application. Pour en savoir plus, consultez la page Configurer l'authentification pour les bibliothèques clientes.