ロギングを行うには、Vertex AI SDK for Python を使用します。

サポートされている指標とパラメータ:

- サマリー指標

- 時系列指標

- パラメータ

- 分類指標

Vertex AI SDK for Python

注: オプションの resume パラメータを TRUE として指定すると、以前に開始した実行が再開されます。指定しない場合、resume はデフォルトで FALSE になり、新しい実行が作成されます。

次のサンプルでは、aiplatform 関数の init メソッドを使用します。

サマリー指標

サマリー指標は、時系列指標の隣に保存される単一の値のスカラー指標で、テスト実行の最終的なサマリーを表します。

ユースケースの一例として、構成でトレーニングの継続が許容されていても、候補モデルが前のステップから復元されたために早期停止が発生する場合があります。この場合、最新の時系列指標が復元されたモデルを表していないため、そのステップでモデルに対して計算された指標がサマリー指標として表示されます。この目的では、サマリー指標用の log_metrics API が使用されます。

Python

experiment_name: テストの名前を指定します。 Google Cloud コンソールでテストのリストを表示するには、セクション ナビゲーションで [テスト] を選択します。run_name: 実行名を指定します(start_runを参照)。metric: 指標の Key-Value ペア。例:{'learning_rate': 0.1}project: これらは Google Cloud コンソールの [ようこそ] ページで確認できます。location: 利用可能なロケーションの一覧をご覧ください。

時系列指標

時系列指標をログに記録するには、Vertex AI Experiments でバッキング Vertex AI TensorBoard インスタンスが必要になります。

時系列指標のロギングにバッキング Vertex AI TensorBoard リソースを割り当てる

log_time_series_metrics を介して記録された指標はすべて時系列指標として保存されます。Vertex AI TensorBoard は、時系列指標のバッキング ストアです。

experiment_tensorboard は、テストレベルとテスト実行レベルの両方で設定できます。実行レベルで experiment_tensorboard を設定すると、テストレベルの設定がオーバーライドされます。実行に experiment_tensorboard が設定されると、その実行の experiment_tensorboard は変更できません。

experiment_tensorboardをテストレベルで設定します。aiplatform.

init(experiment='my-experiment', experiment_tensorboard='projects/.../tensorboard/my-tb-resource')- 実行レベルで

experiment_tensorboardを設定します。注: テストレベルでオーバーライド設定を行います。aiplatform.

start_run(run_name='my-other-run', tensorboard='projects/.../.../other-resource') aiplatform.log_time_series_metrics(...)

Python

experiment_name: テストの名前を指定します。 Google Cloud コンソールでテストのリストを表示するには、セクション ナビゲーションで [テスト] を選択します。run_name: 実行名を指定します(start_runを参照)。metrics: キーが指標名で、値が指標値である辞書。step: 省略可。実行内のこのデータポイントのステップ インデックス。wall_time: 省略可。エンドユーザーがデータポイントを生成したときの実時間のタイムスタンプ。指定しなかった場合、wall_timeは time.time() の値に基づいて生成されます。project: これらは Google Cloud コンソールの [ようこそ] ページで確認できます。location: 利用可能なロケーションの一覧をご覧ください。

ステップと経過時間

log_time_series_metrics API には、step と walltime を渡すこともできます。

step: 省略可。実行内のこのデータポイントのステップ インデックス。指定しなかった場合、すでにロギングされているすべての時系列指標の中で最新のステップからの増分が使用されます。指定した指標キーのいずれかにステップが存在する場合、ステップが上書きされます。wall_time: 省略可。記録された指標のエポックからの経過秒数。指定しない場合のデフォルトは、Python のtime.timeです。

例:

aiplatform.log_time_series_metrics({"mse": 2500.00, "rmse": 50.00})

特定のステップをロギングする

aiplatform.log_time_series_metrics({"mse": 2500.00, "rmse": 50.00}, step=8)

wall_time を含める

aiplatform.log_time_series_metrics({"mse": 2500.00, "rmse": 50.00}, step=10)

パラメータ

パラメータは、実行を構成し、実行の動作を規制し、実行の結果に影響を与えるキー付きの入力値です。例としては、学習率、ドロップアウト率、トレーニングの手順の数などがあります。log_params メソッドを使用したログパラメータ。

Python

aiplatform.log_params({"learning_rate": 0.01, "n_estimators": 10})

experiment_name: テストの名前を指定します。 Google Cloud コンソールでテストのリストを表示するには、セクション ナビゲーションで [テスト] を選択します。run_name: 実行名を指定します(start_runを参照)。params: パラメータの Key-Value ペア。例:{'accuracy': 0.9}(log_paramsを参照)ようこそページ。location: 利用可能なロケーションの一覧をご覧ください。

分類指標

サマリー指標と時系列指標に加えて、混同行列と ROC 曲線がよく使用される指標です。これらは、log_classification_metrics API を使用して Vertex AI Experiments にロギングできます。

Python

experiment_name: テストの名前を指定します。 Google Cloud コンソールでテストのリストを表示するには、セクション ナビゲーションで [テスト] を選択します。run_name: 実行名を指定します(start_runを参照)。project: これらは Google Cloud コンソールの [ようこそ] ページで確認できます。location: 利用可能なロケーションの一覧をご覧ください。labels: 混同行列のラベル名のリスト。matrix が設定されている場合に設定する必要があります。matrix: 混同行列の値。labels が設定されている場合に設定する必要があります。fpr: ROC 曲線の偽陽性率のリスト。tpr または thresholds が設定されている場合に設定する必要があります。tpr: ROC 曲線の真陽性率のリスト。fpr または thresholds が設定されている場合に設定する必要があります。threshold: ROC 曲線のしきい値のリスト。fpr または tpr が設定されている場合に設定する必要があります。display_name: 分類指標アーティファクトのユーザー定義名。

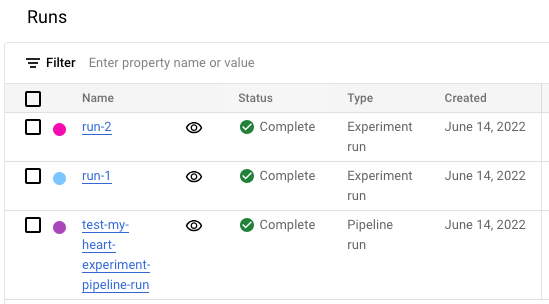

Google Cloud コンソールでテスト実行リストを表示する

- Google Cloud コンソールで [テスト] ページに移動します。

[テスト] に移動

テストのリストが表示されます。 - 確認するテストを選択します。

実行のリストが表示されます。

詳細については、実行の比較と分析をご覧ください。