Analizzare i PDF in una pipeline di Retrieval Augmented Generation

Questo tutorial ti guida nella procedura di creazione di una pipeline RAG (Retrieval-Augmented Generation) basata su contenuti PDF analizzati.

I file PDF, come i documenti finanziari, possono essere difficili da utilizzare nelle pipeline RAG a causa della loro struttura complessa e del mix di testo, cifre e tabelle. Questo tutorial mostra come utilizzare le funzionalità di BigQuery ML in combinazione con Layout Parser di Document AI per creare una pipeline RAG basata sulle informazioni chiave estratte da un file PDF.

In alternativa, puoi eseguire questo tutorial utilizzando un notebook Colab Enterprise.

Obiettivi

Questo tutorial spiega le seguenti attività:

- Creazione di un bucket Cloud Storage e caricamento di un file PDF di esempio.

- Creazione di una connessione di risorsa Cloud per connetterti a Cloud Storage e Vertex AI da BigQuery.

- Creazione di una tabella di oggetti sul file PDF per renderlo disponibile in BigQuery.

- Creazione di un processore Document AI che puoi utilizzare per analizzare il file PDF.

- Creazione di un modello remoto che ti consente di utilizzare l'API Document AI per accedere al processore di documenti da BigQuery.

- Utilizzando il modello remoto con la

funzione

ML.PROCESS_DOCUMENTper analizzare i contenuti del PDF in blocchi e poi scrivere questi contenuti in una tabella BigQuery. - Estrazione dei contenuti PDF dai dati JSON restituiti dalla funzione

ML.PROCESS_DOCUMENTe scrittura di questi contenuti in una tabella BigQuery. - Creazione di un

modello remoto

che ti consente di utilizzare il modello di generazione di incorporamenti

text-embedding-004di Vertex AI da BigQuery. - Utilizzando il modello remoto con la

funzione

ML.GENERATE_EMBEDDINGper generare embedding dai contenuti PDF analizzati e poi scriverli in una tabella BigQuery. Gli incorporamenti sono rappresentazioni numeriche dei contenuti PDF che ti consentono di eseguire la ricerca semantica e il recupero dei contenuti PDF. - Utilizzando la

funzione

VECTOR_SEARCHsugli incorporamenti per identificare contenuti PDF semanticamente simili. - Creazione di un modello remoto che ti consente di utilizzare un modello di generazione di testo Gemini da BigQuery.

- Esegui la generazione aumentata dal recupero (RAG) utilizzando il modello remoto

con la

funzione

ML.GENERATE_TEXTper generare testo, utilizzando i risultati della ricerca vettoriale per aumentare l'input del prompt e migliorare i risultati.

Costi

In questo documento vengono utilizzati i seguenti componenti fatturabili di Google Cloud:

- BigQuery: You incur costs for the data that you process in BigQuery.

- Vertex AI: You incur costs for calls to Vertex AI models.

- Document AI: You incur costs for calls to the Document AI API.

- Cloud Storage: You incur costs for object storage in Cloud Storage.

Per generare una stima dei costi in base all'utilizzo previsto,

utilizza il calcolatore prezzi.

Per ulteriori informazioni, consulta le seguenti pagine dei prezzi:

Prima di iniziare

-

In the Google Cloud console, on the project selector page, select or create a Google Cloud project.

Roles required to select or create a project

- Select a project: Selecting a project doesn't require a specific IAM role—you can select any project that you've been granted a role on.

-

Create a project: To create a project, you need the Project Creator

(

roles/resourcemanager.projectCreator), which contains theresourcemanager.projects.createpermission. Learn how to grant roles.

-

Verify that billing is enabled for your Google Cloud project.

-

Enable the BigQuery, BigQuery Connection, Vertex AI, Document AI, and Cloud Storage APIs.

Roles required to enable APIs

To enable APIs, you need the Service Usage Admin IAM role (

roles/serviceusage.serviceUsageAdmin), which contains theserviceusage.services.enablepermission. Learn how to grant roles.

Ruoli obbligatori

Per eseguire questo tutorial, devi disporre dei seguenti ruoli IAM (Identity and Access Management):

- Crea bucket e oggetti Cloud Storage: amministratore Storage

(

roles/storage.storageAdmin) - Crea un processore di documenti: Document AI Editor

(

roles/documentai.editor) - Crea e utilizza set di dati, connessioni e modelli BigQuery:

Amministratore BigQuery (

roles/bigquery.admin) - Concedi le autorizzazioni al account di servizio della connessione: Project IAM Admin

(

roles/resourcemanager.projectIamAdmin)

Questi ruoli predefiniti contengono le autorizzazioni necessarie per eseguire le attività descritte in questo documento. Per vedere quali sono esattamente le autorizzazioni richieste, espandi la sezione Autorizzazioni obbligatorie:

Autorizzazioni obbligatorie

- Crea un set di dati:

bigquery.datasets.create - Crea, delega e utilizza una connessione:

bigquery.connections.* - Imposta la connessione predefinita:

bigquery.config.* - Imposta le autorizzazioni del account di servizio:

resourcemanager.projects.getIamPolicyeresourcemanager.projects.setIamPolicy - Crea una tabella degli oggetti:

bigquery.tables.createebigquery.tables.update - Crea bucket e oggetti Cloud Storage:

storage.buckets.*estorage.objects.* - Crea un modello ed esegui l'inferenza:

bigquery.jobs.createbigquery.models.createbigquery.models.getDatabigquery.models.updateDatabigquery.models.updateMetadata

- Crea un processore di documenti:

documentai.processors.createdocumentai.processors.updatedocumentai.processors.delete

Potresti anche ottenere queste autorizzazioni con ruoli personalizzati o altri ruoli predefiniti.

Crea un set di dati

Crea un set di dati BigQuery per archiviare il tuo modello ML.

Console

Nella console Google Cloud , vai alla pagina BigQuery.

Nel riquadro Explorer, fai clic sul nome del progetto.

Fai clic su Visualizza azioni > Crea set di dati.

Nella pagina Crea set di dati:

In ID set di dati, inserisci

bqml_tutorial.Per Tipo di località, seleziona Multi-regione e poi Stati Uniti (più regioni negli Stati Uniti).

Lascia invariate le restanti impostazioni predefinite e fai clic su Crea set di dati.

bq

Per creare un nuovo set di dati, utilizza il

comando bq mk

con il flag --location. Per un elenco completo dei possibili parametri, consulta la

documentazione di riferimento del

comando bq mk --dataset.

Crea un set di dati denominato

bqml_tutorialcon la località dei dati impostata suUSe una descrizione diBigQuery ML tutorial dataset:bq --location=US mk -d \ --description "BigQuery ML tutorial dataset." \ bqml_tutorial

Anziché utilizzare il flag

--dataset, il comando utilizza la scorciatoia-d. Se ometti-de--dataset, il comando crea per impostazione predefinita un dataset.Verifica che il set di dati sia stato creato:

bq ls

API

Chiama il metodo datasets.insert con una risorsa dataset definita.

{ "datasetReference": { "datasetId": "bqml_tutorial" } }

BigQuery DataFrames

Prima di provare questo esempio, segui le istruzioni di configurazione di BigQuery DataFrames nella guida rapida di BigQuery che utilizza BigQuery DataFrames. Per ulteriori informazioni, consulta la documentazione di riferimento di BigQuery DataFrames.

Per eseguire l'autenticazione in BigQuery, configura le Credenziali predefinite dell'applicazione. Per maggiori informazioni, vedi Configurare ADC per un ambiente di sviluppo locale.

Crea una connessione

Crea una connessione risorsa Cloud e ottieni il account di servizio della connessione. Crea la connessione nella stessa posizione.

Puoi saltare questo passaggio se hai configurato una connessione predefinita o se disponi del ruolo Amministratore BigQuery.

Crea una connessione a una risorsa Cloud da utilizzare per il modello remoto e recupera il account di servizio della connessione. Crea la connessione nella stessa posizione del set di dati creato nel passaggio precedente.

Seleziona una delle seguenti opzioni:

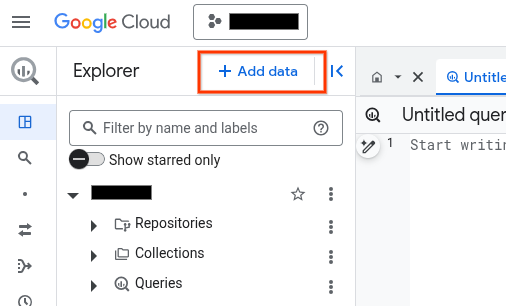

Console

Vai alla pagina BigQuery.

Nel riquadro Explorer, fai clic su Aggiungi dati:

Si apre la finestra di dialogo Aggiungi dati.

Nel riquadro Filtra per, nella sezione Tipo di origine dati, seleziona Applicazioni aziendali.

In alternativa, nel campo Cerca origini dati, puoi inserire

Vertex AI.Nella sezione Origini dati in evidenza, fai clic su Vertex AI.

Fai clic sulla scheda della soluzione Vertex AI Models: BigQuery Federation.

Nell'elenco Tipo di connessione, seleziona Modelli remoti di Vertex AI, funzioni remote, BigLake e Spanner (risorsa Cloud).

Nel campo ID connessione, inserisci un nome per la connessione.

Fai clic su Crea connessione.

Fai clic su Vai alla connessione.

Nel riquadro Informazioni sulla connessione, copia l'ID del account di servizio da utilizzare in un passaggio successivo.

bq

In un ambiente a riga di comando, crea una connessione:

bq mk --connection --location=REGION --project_id=PROJECT_ID \ --connection_type=CLOUD_RESOURCE CONNECTION_ID

Il parametro

--project_idsostituisce il progetto predefinito.Sostituisci quanto segue:

REGION: la tua regione di connessionePROJECT_ID: il tuo ID progetto Google CloudCONNECTION_ID: un ID per la tua connessione

Quando crei una risorsa di connessione, BigQuery crea un account di serviziot di sistema univoco e lo associa alla connessione.

Risoluzione dei problemi: se viene visualizzato il seguente errore di connessione, aggiorna Google Cloud SDK:

Flags parsing error: flag --connection_type=CLOUD_RESOURCE: value should be one of...

Recupera e copia l'ID account di servizio da utilizzare in un passaggio successivo:

bq show --connection PROJECT_ID.REGION.CONNECTION_ID

L'output è simile al seguente:

name properties 1234.REGION.CONNECTION_ID {"serviceAccountId": "connection-1234-9u56h9@gcp-sa-bigquery-condel.iam.gserviceaccount.com"}

Terraform

Utilizza la risorsa

google_bigquery_connection.

Per eseguire l'autenticazione in BigQuery, configura le credenziali predefinite dell'applicazione. Per saperne di più, vedi Configurare l'autenticazione per le librerie client.

L'esempio seguente crea una connessione di risorsa Cloud denominata

my_cloud_resource_connection nella regione US:

Per applicare la configurazione di Terraform in un progetto Google Cloud , completa i passaggi nelle sezioni seguenti.

Prepara Cloud Shell

- Avvia Cloud Shell.

-

Imposta il progetto Google Cloud predefinito in cui vuoi applicare le configurazioni Terraform.

Devi eseguire questo comando una sola volta per progetto e puoi eseguirlo in qualsiasi directory.

export GOOGLE_CLOUD_PROJECT=PROJECT_ID

Le variabili di ambiente vengono sostituite se imposti valori espliciti nel file di configurazione Terraform.

Prepara la directory

Ogni file di configurazione Terraform deve avere la propria directory (chiamata anche modulo radice).

-

In Cloud Shell, crea una directory e un nuovo file al suo interno. Il nome file deve avere l'estensione

.tf, ad esempiomain.tf. In questo tutorial, il file viene denominatomain.tf.mkdir DIRECTORY && cd DIRECTORY && touch main.tf

-

Se stai seguendo un tutorial, puoi copiare il codice campione in ogni sezione o passaggio.

Copia il codice campione nel

main.tfappena creato.(Facoltativo) Copia il codice da GitHub. Questa operazione è consigliata quando lo snippet Terraform fa parte di una soluzione end-to-end.

- Rivedi e modifica i parametri di esempio da applicare al tuo ambiente.

- Salva le modifiche.

-

Inizializza Terraform. Devi effettuare questa operazione una sola volta per directory.

terraform init

(Facoltativo) Per utilizzare l'ultima versione del provider Google, includi l'opzione

-upgrade:terraform init -upgrade

Applica le modifiche

-

Rivedi la configurazione e verifica che le risorse che Terraform creerà o

aggiornerà corrispondano alle tue aspettative:

terraform plan

Apporta le correzioni necessarie alla configurazione.

-

Applica la configurazione di Terraform eseguendo il comando seguente e inserendo

yesal prompt:terraform apply

Attendi che Terraform visualizzi il messaggio "Apply complete!".

- Apri il tuo Google Cloud progetto per visualizzare i risultati. Nella console Google Cloud , vai alle risorse nell'interfaccia utente per assicurarti che Terraform le abbia create o aggiornate.

Concedi l'accesso al service account

Seleziona una delle seguenti opzioni:

Console

Vai alla pagina IAM e amministrazione.

Fai clic su Concedi l'accesso.

Si apre la finestra di dialogo Aggiungi entità.

Nel campo Nuove entità, inserisci l'ID account di servizio che hai copiato in precedenza.

Nel campo Seleziona un ruolo, seleziona Document AI e poi Visualizzatore Document AI.

Fai clic su Aggiungi un altro ruolo.

Nel campo Seleziona un ruolo, seleziona Cloud Storage e poi Visualizzatore oggetti Storage.

Fai clic su Aggiungi un altro ruolo.

Nel campo Seleziona un ruolo, seleziona Vertex AI e poi Utente Vertex AI.

Fai clic su Salva.

gcloud

Utilizza il

comando gcloud projects add-iam-policy-binding:

gcloud projects add-iam-policy-binding 'PROJECT_NUMBER' --member='serviceAccount:MEMBER' --role='roles/documentai.viewer' --condition=None gcloud projects add-iam-policy-binding 'PROJECT_NUMBER' --member='serviceAccount:MEMBER' --role='roles/storage.objectViewer' --condition=None gcloud projects add-iam-policy-binding 'PROJECT_NUMBER' --member='serviceAccount:MEMBER' --role='roles/aiplatform.user' --condition=None

Sostituisci quanto segue:

PROJECT_NUMBER: il numero di progetto.MEMBER: l'ID account di servizio che hai copiato in precedenza.

Carica il PDF di esempio su Cloud Storage

Per caricare il PDF di esempio in Cloud Storage:

- Scarica il PDF di esempio

scf23.pdfall'indirizzo https://www.federalreserve.gov/publications/files/scf23.pdf e fai clic su Scarica . - Crea un bucket Cloud Storage.

- Carica il file

scf23.pdfnel bucket.

Creare una tabella degli oggetti

Crea una tabella degli oggetti sul file PDF in Cloud Storage:

Nella console Google Cloud , vai alla pagina BigQuery.

Nell'editor di query, esegui la seguente istruzione:

CREATE OR REPLACE EXTERNAL TABLE `bqml_tutorial.pdf` WITH CONNECTION `LOCATION.CONNECTION_ID` OPTIONS( object_metadata = 'SIMPLE', uris = ['gs://BUCKET/scf23.pdf']);

Sostituisci quanto segue:

LOCATION: la posizione della connessione.CONNECTION_ID: l'ID della tua connessione BigQuery.Quando visualizzi i dettagli della connessione nella console Google Cloud ,

CONNECTION_IDè il valore nell'ultima sezione dell'ID connessione completo visualizzato in ID connessione, ad esempioprojects/myproject/locations/connection_location/connections/myconnection.BUCKET: il bucket Cloud Storage contenente il filescf23.pdf. Il valore completo dell'opzioneuridovrebbe essere simile a['gs://mybucket/scf23.pdf'].

Crea un processore di documenti

Crea un processore di documenti

basato sul processore dell'analizzatore sintattico di layout

nella multi-regione us.

Crea il modello remoto per il processore di documenti

Crea un modello remoto per accedere al processore Document AI:

Nella console Google Cloud , vai alla pagina BigQuery.

Nell'editor di query, esegui la seguente istruzione:

CREATE OR REPLACE MODEL `bqml_tutorial.parser_model` REMOTE WITH CONNECTION `LOCATION.CONNECTION_ID` OPTIONS(remote_service_type = 'CLOUD_AI_DOCUMENT_V1', document_processor = 'PROCESSOR_ID');

Sostituisci quanto segue:

LOCATION: la posizione della connessione.CONNECTION_ID: l'ID della tua connessione BigQuery.Quando visualizzi i dettagli della connessione nella console Google Cloud ,

CONNECTION_IDè il valore nell'ultima sezione dell'ID connessione completo mostrato in ID connessione, ad esempioprojects/myproject/locations/connection_location/connections/myconnection.PROCESSOR_ID: l'ID del processore di documenti. Per trovare questo valore, visualizza i dettagli del processore e poi guarda la riga ID nella sezione Informazioni di base.

Analizza il file PDF in blocchi

Utilizza il processore di documenti con la funzione ML.PROCESS_DOCUMENT per analizzare il file PDF in blocchi e poi scrivere i contenuti in una tabella. La funzione

ML.PROCESS_DOCUMENT restituisce i blocchi PDF in formato JSON.

Nella console Google Cloud , vai alla pagina BigQuery.

Nell'editor di query, esegui la seguente istruzione:

CREATE or REPLACE TABLE

bqml_tutorial.chunked_pdfAS ( SELECT * FROM ML.PROCESS_DOCUMENT( MODELbqml_tutorial.parser_model, TABLEbqml_tutorial.pdf, PROCESS_OPTIONS => (JSON '{"layout_config": {"chunking_config": {"chunk_size": 250}}}') ) );

Analizzare i dati dei blocchi PDF in colonne separate

Estrai i contenuti e i metadati del PDF dai dati JSON restituiti dalla funzione ML.PROCESS_DOCUMENT, quindi scrivi i contenuti in una tabella:

Nella console Google Cloud , vai alla pagina BigQuery.

Nell'editor di query, esegui la seguente istruzione per analizzare il contenuto del PDF:

CREATE OR REPLACE TABLE

bqml_tutorial.parsed_pdfAS ( SELECT uri, JSON_EXTRACT_SCALAR(json , '$.chunkId') AS id, JSON_EXTRACT_SCALAR(json , '$.content') AS content, JSON_EXTRACT_SCALAR(json , '$.pageFooters[0].text') AS page_footers_text, JSON_EXTRACT_SCALAR(json , '$.pageSpan.pageStart') AS page_span_start, JSON_EXTRACT_SCALAR(json , '$.pageSpan.pageEnd') AS page_span_end FROMbqml_tutorial.chunked_pdf, UNNEST(JSON_EXTRACT_ARRAY(ml_process_document_result.chunkedDocument.chunks, '$')) json );Nell'editor di query, esegui la seguente istruzione per visualizzare un sottoinsieme dei contenuti PDF analizzati:

SELECT * FROM `bqml_tutorial.parsed_pdf` ORDER BY id LIMIT 5;

L'output è simile al seguente:

+-----------------------------------+------+------------------------------------------------------------------------------------------------------+-------------------+-----------------+---------------+ | uri | id | content | page_footers_text | page_span_start | page_span_end | +-----------------------------------+------+------------------------------------------------------------------------------------------------------+-------------------+-----------------+---------------+ | gs://mybucket/scf23.pdf | c1 | •BOARD OF OF FEDERAL GOVERN NOR RESERVE SYSTEM RESEARCH & ANALYSIS | NULL | 1 | 1 | | gs://mybucket/scf23.pdf | c10 | • In 2022, 20 percent of all families, 14 percent of families in the bottom half of the usual ... | NULL | 8 | 9 | | gs://mybucket/scf23.pdf | c100 | The SCF asks multiple questions intended to capture whether families are credit constrained, ... | NULL | 48 | 48 | | gs://mybucket/scf23.pdf | c101 | Bankruptcy behavior over the past five years is based on a series of retrospective questions ... | NULL | 48 | 48 | | gs://mybucket/scf23.pdf | c102 | # Percentiles of the Distributions of Income and Net Worth | NULL | 48 | 49 | +-----------------------------------+------+------------------------------------------------------------------------------------------------------+-------------------+-----------------+---------------+

Crea il modello remoto per la generazione di embedding

Crea un modello remoto che rappresenti un modello di generazione di text embedding Vertex AI ospitato:

Nella console Google Cloud , vai alla pagina BigQuery.

Nell'editor di query, esegui la seguente istruzione:

CREATE OR REPLACE MODEL `bqml_tutorial.embedding_model` REMOTE WITH CONNECTION `LOCATION.CONNECTION_ID` OPTIONS (ENDPOINT = 'text-embedding-005');

Sostituisci quanto segue:

LOCATION: la posizione della connessione.CONNECTION_ID: l'ID della tua connessione BigQuery.Quando visualizzi i dettagli della connessione nella console Google Cloud ,

CONNECTION_IDè il valore nell'ultima sezione dell'ID connessione completo visualizzato in ID connessione, ad esempioprojects/myproject/locations/connection_location/connections/myconnection.

Genera embedding

Genera incorporamenti per i contenuti PDF analizzati e poi scrivili in una tabella:

Nella console Google Cloud , vai alla pagina BigQuery.

Nell'editor di query, esegui la seguente istruzione:

CREATE OR REPLACE TABLE `bqml_tutorial.embeddings` AS SELECT * FROM ML.GENERATE_EMBEDDING( MODEL `bqml_tutorial.embedding_model`, TABLE `bqml_tutorial.parsed_pdf` );

Eseguire una ricerca vettoriale

Esegui una ricerca vettoriale sui contenuti PDF analizzati.

La seguente query prende l'input di testo, crea un incorporamento per questo input

utilizzando la funzione ML.GENERATE_EMBEDDING e poi utilizza la funzione VECTOR_SEARCH

per far corrispondere l'incorporamento dell'input con gli incorporamenti dei contenuti PDF più simili. I risultati sono i primi dieci blocchi PDF più simili

semanticamente all'input.

Vai alla pagina BigQuery.

Nell'editor di query, esegui la seguente istruzione SQL:

SELECT query.query, base.id AS pdf_chunk_id, base.content, distance FROM VECTOR_SEARCH( TABLE `bqml_tutorial.embeddings`, 'ml_generate_embedding_result', ( SELECT ml_generate_embedding_result, content AS query FROM ML.GENERATE_EMBEDDING( MODEL `bqml_tutorial.embedding_model`, ( SELECT 'Did the typical family net worth increase? If so, by how much?' AS content) ) ), top_k => 10, OPTIONS => '{"fraction_lists_to_search": 0.01}') ORDER BY distance DESC;

L'output è simile al seguente:

+-------------------------------------------------+--------------+------------------------------------------------------------------------------------------------------+---------------------+ | query | pdf_chunk_id | content | distance | +-------------------------------------------------+--------------+------------------------------------------------------------------------------------------------------+---------------------+ | Did the typical family net worth increase? ,... | c9 | ## Assets | 0.31113668174119469 | | | | | | | | | The homeownership rate increased slightly between 2019 and 2022, to 66.1 percent. For ... | | +-------------------------------------------------+--------------+------------------------------------------------------------------------------------------------------+---------------------+ | Did the typical family net worth increase? ,... | c50 | # Box 3. Net Housing Wealth and Housing Affordability | 0.30973592073929113 | | | | | | | | | For families that own their primary residence ... | | +-------------------------------------------------+--------------+------------------------------------------------------------------------------------------------------+---------------------+ | Did the typical family net worth increase? ,... | c50 | 3 In the 2019 SCF, a small portion of the data collection overlapped with early months of | 0.29270064592817646 | | | | the COVID- ... | | +-------------------------------------------------+--------------+------------------------------------------------------------------------------------------------------+---------------------+

Crea il modello remoto per la generazione di testo

Crea un modello remoto che rappresenti un modello di generazione di testo Vertex AI ospitato:

Nella console Google Cloud , vai alla pagina BigQuery.

Nell'editor di query, esegui la seguente istruzione:

CREATE OR REPLACE MODEL `bqml_tutorial.text_model` REMOTE WITH CONNECTION `LOCATION.CONNECTION_ID` OPTIONS (ENDPOINT = 'gemini-2.0-flash-001');

Sostituisci quanto segue:

LOCATION: la posizione della connessione.CONNECTION_ID: l'ID della tua connessione BigQuery.Quando visualizzi i dettagli della connessione nella console Google Cloud ,

CONNECTION_IDè il valore nell'ultima sezione dell'ID connessione completo mostrato in ID connessione, ad esempioprojects/myproject/locations/connection_location/connections/myconnection.

Generare testo arricchito dai risultati della ricerca vettoriale

Esegui una ricerca vettoriale sugli incorporamenti per identificare contenuti PDF semanticamente simili, quindi utilizza la funzione ML.GENERATE_TEXT con i risultati della ricerca vettoriale per migliorare l'input del prompt e i risultati della generazione di testo. In questo caso, la query utilizza le informazioni dei blocchi PDF per rispondere

a una domanda sulla variazione del patrimonio netto familiare nell'ultimo decennio.

Nella console Google Cloud , vai alla pagina BigQuery.

Nell'editor di query, esegui la seguente istruzione:

SELECT ml_generate_text_llm_result AS generated FROM ML.GENERATE_TEXT( MODEL `bqml_tutorial.text_model`, ( SELECT CONCAT( 'Did the typical family net worth change? How does this compare the SCF survey a decade earlier? Be concise and use the following context:', STRING_AGG(FORMAT("context: %s and reference: %s", base.content, base.uri), ',\n')) AS prompt, FROM VECTOR_SEARCH( TABLE `bqml_tutorial.embeddings`, 'ml_generate_embedding_result', ( SELECT ml_generate_embedding_result, content AS query FROM ML.GENERATE_EMBEDDING( MODEL `bqml_tutorial.embedding_model`, ( SELECT 'Did the typical family net worth change? How does this compare the SCF survey a decade earlier?' AS content ) ) ), top_k => 10, OPTIONS => '{"fraction_lists_to_search": 0.01}') ), STRUCT(512 AS max_output_tokens, TRUE AS flatten_json_output) );

L'output è simile al seguente:

+-------------------------------------------------------------------------------+ | generated | +-------------------------------------------------------------------------------+ | Between the 2019 and 2022 Survey of Consumer Finances (SCF), real median | | family net worth surged 37 percent to $192,900, and real mean net worth | | increased 23 percent to $1,063,700. This represents the largest three-year | | increase in median net worth in the history of the modern SCF, exceeding the | | next largest by more than double. In contrast, between 2010 and 2013, real | | median net worth decreased 2 percent, and real mean net worth remained | | unchanged. | +-------------------------------------------------------------------------------+

Esegui la pulizia

- In the Google Cloud console, go to the Manage resources page.

- In the project list, select the project that you want to delete, and then click Delete.

- In the dialog, type the project ID, and then click Shut down to delete the project.