Gestisci tabelle

Questo documento descrive come gestire le tabelle in BigQuery. Puoi gestire le tue tabelle BigQuery nei seguenti modi:

- Aggiorna le proprietà della tabella:

- Rinominare (copiare) una tabella

- Copiare una tabella

- Eliminare una tabella

Per informazioni su come ripristinare (o recuperare) una tabella eliminata, vedi Ripristinare le tabelle eliminate.

Per ulteriori informazioni sulla creazione e l'utilizzo delle tabelle, inclusi l'ottenimento di informazioni sulle tabelle, l'elenco delle tabelle e il controllo dell'accesso ai dati delle tabelle, consulta Creazione e utilizzo delle tabelle.

Prima di iniziare

Concedi i ruoli IAM (Identity and Access Management) che forniscono agli utenti le autorizzazioni necessarie per eseguire ogni attività descritta in questo documento. Le autorizzazioni richieste per eseguire un'attività (se presenti) sono elencate nella sezione "Autorizzazioni richieste" dell'attività.

Aggiornare le proprietà della tabella

Puoi aggiornare i seguenti elementi di una tabella:

Autorizzazioni obbligatorie

Per ottenere le autorizzazioni

necessarie per aggiornare le proprietà della tabella,

chiedi all'amministratore di concederti il

ruolo IAM Data Editor (roles/bigquery.dataEditor)

su una tabella.

Per saperne di più sulla concessione dei ruoli, consulta Gestisci l'accesso a progetti, cartelle e organizzazioni.

Questo ruolo predefinito contiene le autorizzazioni necessarie per aggiornare le proprietà delle tabelle. Per vedere quali sono esattamente le autorizzazioni richieste, espandi la sezione Autorizzazioni obbligatorie:

Autorizzazioni obbligatorie

Per aggiornare le proprietà della tabella sono necessarie le seguenti autorizzazioni:

-

bigquery.tables.update -

bigquery.tables.get

Potresti anche ottenere queste autorizzazioni con ruoli personalizzati o altri ruoli predefiniti.

Inoltre, se disponi dell'autorizzazione bigquery.datasets.create, puoi

aggiornare le proprietà delle tabelle dei set di dati che crei.

Aggiornare la descrizione di una tabella

Puoi aggiornare la descrizione di una tabella nei seguenti modi:

- Utilizzo della console Google Cloud .

- Utilizzo di un'istruzione

ALTER TABLEDDL (Data Definition Language). - Utilizzo del comando

bq updatedello strumento a riga di comando bq. - Chiamata del metodo API

tables.patch. - Utilizzo delle librerie client.

- Generazione di una descrizione con Gemini in BigQuery.

Per aggiornare la descrizione di una tabella:

Console

Non puoi aggiungere una descrizione quando crei una tabella utilizzando la consoleGoogle Cloud . Una volta creata la tabella, puoi aggiungere una descrizione nella pagina Dettagli.

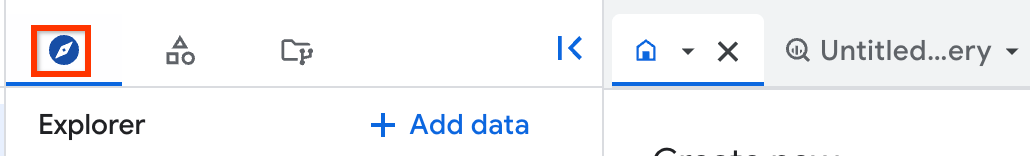

Nel riquadro a sinistra, fai clic su Explorer:

Se non vedi il riquadro a sinistra, fai clic su Espandi riquadro a sinistra per aprirlo.

Nel riquadro Explorer, espandi il progetto, fai clic su Set di dati e poi seleziona un set di dati.

Fai clic su Panoramica > Tabelle e poi seleziona una tabella.

Fai clic sulla scheda Dettagli e poi su Modifica dettagli.

Nella sezione Descrizione, aggiungi una nuova descrizione o modificane una esistente.

Fai clic su Salva.

SQL

Utilizza l'istruzione ALTER TABLE SET OPTIONS.

Il seguente esempio aggiorna la

descrizione di una tabella denominata mytable:

Nella console Google Cloud , vai alla pagina BigQuery.

Nell'editor di query, inserisci la seguente istruzione:

ALTER TABLE mydataset.mytable SET OPTIONS ( description = 'Description of mytable');

Fai clic su Esegui.

Per saperne di più su come eseguire le query, consulta Eseguire una query interattiva.

bq

-

In the Google Cloud console, activate Cloud Shell.

At the bottom of the Google Cloud console, a Cloud Shell session starts and displays a command-line prompt. Cloud Shell is a shell environment with the Google Cloud CLI already installed and with values already set for your current project. It can take a few seconds for the session to initialize.

Esegui il comando

bq updatecon il flag--description. Se stai aggiornando una tabella in un progetto diverso da quello predefinito, aggiungi l'ID progetto al nome del set di dati nel seguente formato:project_id:dataset.bq update \ --description "description" \ project_id:dataset.table

Sostituisci quanto segue:

description: il testo che descrive la tabella tra virgoletteproject_id: il tuo ID progettodataset: il nome del set di dati contenente la tabella che stai aggiornandotable: il nome della tabella che stai aggiornando

Esempi:

Per modificare la descrizione della tabella

mytablenel set di datimydatasetin "Description of mytable", inserisci questo comando. Il set di datimydatasetsi trova nel tuo progetto predefinito.bq update --description "Description of mytable" mydataset.mytable

Per modificare la descrizione della tabella

mytablenel set di datimydatasetin "Description of mytable", inserisci questo comando. Il set di datimydatasetsi trova nel progettomyotherproject, non nel tuo progetto predefinito.bq update \ --description "Description of mytable" \ myotherproject:mydataset.mytable

Nella console Google Cloud , vai alla pagina BigQuery.

Nel riquadro a sinistra, fai clic su Explorer:

Nel riquadro Explorer, espandi il progetto e il set di dati, quindi seleziona la tabella.

Nel riquadro dei dettagli, fai clic sulla scheda Schema.

Fai clic su Genera.

Gemini genera una descrizione della tabella e approfondimenti sulla tabella. L'inserimento delle informazioni richiede alcuni minuti. Puoi visualizzare gli approfondimenti generati nella scheda Approfondimenti della tabella.

Per modificare e salvare la descrizione della tabella generata:

Fai clic su Visualizza descrizioni delle colonne.

Vengono visualizzate la descrizione della tabella attuale e quella generata.

Nella sezione Descrizione tabella, fai clic su Salva nei dettagli.

Per sostituire la descrizione attuale con quella generata, fai clic su Copia descrizione suggerita.

Modifica la descrizione della tabella in base alle tue esigenze, quindi fai clic su Salva nei dettagli.

La descrizione della tabella viene aggiornata immediatamente.

Per chiudere il riquadro Anteprima descrizioni, fai clic su Chiudi.

API

Chiama il metodo tables.patch e utilizza la proprietà description nella risorsa tabella per aggiornare la descrizione della tabella. Poiché il metodo tables.update

sostituisce l'intera risorsa della tabella, è preferibile il metodo tables.patch.

Vai

Prima di provare questo esempio, segui le istruzioni di configurazione di Go nella guida rapida di BigQuery per l'utilizzo delle librerie client. Per saperne di più, consulta la documentazione di riferimento dell'API BigQuery Go.

Per eseguire l'autenticazione in BigQuery, configura le Credenziali predefinite dell'applicazione. Per saperne di più, vedi Configurare l'autenticazione per le librerie client.

Java

Prima di provare questo esempio, segui le istruzioni di configurazione di Java nella guida rapida di BigQuery per l'utilizzo delle librerie client. Per saperne di più, consulta la documentazione di riferimento dell'API BigQuery Java.

Per eseguire l'autenticazione in BigQuery, configura le Credenziali predefinite dell'applicazione. Per saperne di più, vedi Configurare l'autenticazione per le librerie client.

Python

Prima di provare questo esempio, segui le istruzioni di configurazione di Python nella guida rapida di BigQuery per l'utilizzo delle librerie client. Per saperne di più, consulta la documentazione di riferimento dell'API BigQuery Python.

Per eseguire l'autenticazione in BigQuery, configura le Credenziali predefinite dell'applicazione. Per saperne di più, vedi Configurare l'autenticazione per le librerie client.

Configura la proprietà Table.description e chiama Client.update_table() per inviare l'aggiornamento all'API.Gemini

Puoi generare una descrizione della tabella con Gemini in BigQuery utilizzando gli approfondimenti sui dati. Gli approfondimenti sui dati sono un modo automatico per esplorare, comprendere e curare i dati.

Per ulteriori informazioni sugli approfondimenti sui dati, inclusi i passaggi di configurazione, i ruoli IAM richiesti e le best practice per migliorare l'accuratezza degli approfondimenti generati, consulta Generare approfondimenti sui dati in BigQuery.

Aggiornare la data/ora di scadenza di una tabella

Puoi impostare un tempo di scadenza predefinito per le tabelle a livello di set di dati oppure puoi impostare il tempo di scadenza di una tabella al momento della creazione. Il tempo di scadenza di una tabella è spesso indicato come "durata" o TTL.

Quando una tabella scade, viene eliminata insieme a tutti i dati che contiene. Se necessario, puoi annullare l'eliminazione della tabella scaduta all'interno della finestra di Time Travel specificata per il set di dati. Per maggiori informazioni, consulta Ripristinare le tabelle eliminate.

Se imposti la scadenza al momento della creazione della tabella, la scadenza predefinita della tabella del set di dati viene ignorata. Se non imposti una scadenza predefinita della tabella a livello di set di dati e non imposti una scadenza della tabella al momento della creazione, la tabella non scade mai e devi eliminarla manualmente.

In qualsiasi momento dopo la creazione della tabella, puoi aggiornare la data di scadenza nei seguenti modi:

- Utilizzo della console Google Cloud .

- Utilizzo di un'istruzione

ALTER TABLEDDL (Data Definition Language). - Utilizzo del comando

bq updatedello strumento a riga di comando bq. - Chiamata del metodo API

tables.patch. - Utilizzo delle librerie client.

Per aggiornare la scadenza di una tabella:

Console

Non puoi aggiungere un'ora di scadenza quando crei una tabella utilizzando la consoleGoogle Cloud . Dopo aver creato una tabella, puoi aggiungere o aggiornare una scadenza della tabella nella pagina Dettagli tabella.

Nel riquadro a sinistra, fai clic su Explorer:

Nel riquadro Explorer, espandi il progetto, fai clic su Set di dati e poi seleziona un set di dati.

Fai clic su Panoramica > Tabelle e poi seleziona una tabella.

Fai clic sulla scheda Dettagli e poi su Modifica dettagli.

Per Ora di scadenza, seleziona Specifica data. Quindi seleziona la data di scadenza utilizzando il widget calendario.

Fai clic su Salva. L'ora di scadenza aggiornata viene visualizzata nella sezione Informazioni tabella.

SQL

Utilizza l'istruzione ALTER TABLE SET OPTIONS.

L'esempio seguente aggiorna

l'ora di scadenza di una tabella denominata mytable:

Nella console Google Cloud , vai alla pagina BigQuery.

Nell'editor di query, inserisci la seguente istruzione:

ALTER TABLE mydataset.mytable SET OPTIONS ( -- Sets table expiration to timestamp 2025-02-03 12:34:56 expiration_timestamp = TIMESTAMP '2025-02-03 12:34:56');

Fai clic su Esegui.

Per saperne di più su come eseguire le query, consulta Eseguire una query interattiva.

bq

-

In the Google Cloud console, activate Cloud Shell.

At the bottom of the Google Cloud console, a Cloud Shell session starts and displays a command-line prompt. Cloud Shell is a shell environment with the Google Cloud CLI already installed and with values already set for your current project. It can take a few seconds for the session to initialize.

Esegui il comando

bq updatecon il flag--expiration. Se stai aggiornando una tabella in un progetto diverso da quello predefinito, aggiungi l'ID progetto al nome del set di dati nel seguente formato:project_id:dataset.bq update \ --expiration integer \

project_id:dataset.tableSostituisci quanto segue:

integer: la durata predefinita (in secondi) della tabella. Il valore minimo è 3600 secondi (1 ora). La scadenza corrisponde all'ora corrente più il valore intero. Se specifichi0, la scadenza della tabella viene rimossa e la tabella non scade mai. Le tabelle senza scadenza devono essere eliminate manualmente.project_id: il tuo ID progetto.dataset: il nome del set di dati che contiene la tabella che stai aggiornando.table: il nome della tabella che stai aggiornando.

Esempi:

Per aggiornare il tempo di scadenza della tabella

mytablenel set di datimydataseta 5 giorni (432.000 secondi), inserisci il seguente comando. Il set di datimydatasetsi trova nel tuo progetto predefinito.bq update --expiration 432000 mydataset.mytable

Per aggiornare il tempo di scadenza della tabella

mytablenel set di datimydataseta 5 giorni (432.000 secondi), inserisci il seguente comando. Il set di datimydatasetsi trova nel progettomyotherproject, non nel tuo progetto predefinito.bq update --expiration 432000 myotherproject:mydataset.mytable

API

Chiama il metodo tables.patch e utilizza la proprietà expirationTime nella risorsa tabella per aggiornare la scadenza della tabella in millisecondi. Poiché il metodo tables.update

sostituisce l'intera risorsa della tabella, è preferibile il metodo tables.patch.

Vai

Prima di provare questo esempio, segui le istruzioni di configurazione di Go nella guida rapida di BigQuery per l'utilizzo delle librerie client. Per saperne di più, consulta la documentazione di riferimento dell'API BigQuery Go.

Per eseguire l'autenticazione in BigQuery, configura le Credenziali predefinite dell'applicazione. Per saperne di più, vedi Configurare l'autenticazione per le librerie client.

Java

Prima di provare questo esempio, segui le istruzioni di configurazione di Java nella guida rapida di BigQuery per l'utilizzo delle librerie client. Per saperne di più, consulta la documentazione di riferimento dell'API BigQuery Java.

Per eseguire l'autenticazione in BigQuery, configura le Credenziali predefinite dell'applicazione. Per saperne di più, vedi Configurare l'autenticazione per le librerie client.

Node.js

Prima di provare questo esempio, segui le istruzioni di configurazione di Node.js nella guida rapida di BigQuery per l'utilizzo delle librerie client. Per saperne di più, consulta la documentazione di riferimento dell'API BigQuery Node.js.

Per eseguire l'autenticazione in BigQuery, configura le Credenziali predefinite dell'applicazione. Per saperne di più, vedi Configurare l'autenticazione per le librerie client.

Python

Prima di provare questo esempio, segui le istruzioni di configurazione di Python nella guida rapida di BigQuery per l'utilizzo delle librerie client. Per saperne di più, consulta la documentazione di riferimento dell'API BigQuery Python.

Per eseguire l'autenticazione in BigQuery, configura le Credenziali predefinite dell'applicazione. Per saperne di più, vedi Configurare l'autenticazione per le librerie client.

Configura la proprietà Table.expires e chiama Client.update_table() per inviare l'aggiornamento all'API.Per aggiornare la scadenza predefinita della partizione del set di dati:

Java

Prima di provare questo esempio, segui le istruzioni di configurazione di Java nella guida rapida di BigQuery per l'utilizzo delle librerie client. Per saperne di più, consulta la documentazione di riferimento dell'API BigQuery Java.

Per eseguire l'autenticazione in BigQuery, configura le Credenziali predefinite dell'applicazione. Per saperne di più, vedi Configurare l'autenticazione per le librerie client.

Python

Prima di provare questo esempio, segui le istruzioni di configurazione di Python nella guida rapida di BigQuery per l'utilizzo delle librerie client. Per saperne di più, consulta la documentazione di riferimento dell'API BigQuery Python.

Per eseguire l'autenticazione in BigQuery, configura le Credenziali predefinite dell'applicazione. Per saperne di più, vedi Configurare l'autenticazione per le librerie client.

Aggiornare la modalità di arrotondamento di una tabella

Puoi aggiornare la

modalità di arrotondamento predefinita

di una tabella

utilizzando l'ALTER TABLE SET OPTIONSistruzione DDL.

L'esempio seguente aggiorna la modalità di arrotondamento predefinita per mytable a

ROUND_HALF_EVEN:

ALTER TABLE mydataset.mytable SET OPTIONS ( default_rounding_mode = "ROUND_HALF_EVEN");

Quando aggiungi un campo NUMERIC o BIGNUMERIC a una tabella e non specifichi

una modalità di arrotondamento, questa viene impostata automaticamente sulla modalità di arrotondamento predefinita della tabella. La modifica della modalità di arrotondamento predefinita di una tabella non altera la modalità di arrotondamento dei campi esistenti.

Aggiornare la definizione dello schema di una tabella

Per ulteriori informazioni sull'aggiornamento della definizione dello schema di una tabella, vedi Modifica degli schemi delle tabelle.

Rinominare una tabella

Puoi rinominare una tabella dopo la creazione utilizzando l'istruzione

ALTER TABLE RENAME TO.

Nell'esempio riportato sotto, mytable viene rinominato in mynewtable:

ALTER TABLE mydataset.mytable RENAME TO mynewtable;

Limitazioni relative alla ridenominazione delle tabelle

- Se vuoi rinominare una tabella in cui vengono trasmessi dati in streaming, devi interrompere lo streaming, eseguire il commit di tutti gli stream in attesa e attendere che BigQuery indichi che lo streaming non è in uso.

- Anche se in genere una tabella può essere rinominata 5 ore dopo l'ultima operazione di streaming, potrebbe essere necessario più tempo.

- Gli ACL e le policy di accesso alle righe esistenti vengono conservati, ma gli aggiornamenti degli ACL e delle policy di accesso alle righe apportati durante la ridenominazione della tabella non vengono conservati.

- Non puoi rinominare contemporaneamente una tabella ed eseguire un'istruzione DML su quella tabella.

- Se rinomini una tabella, vengono rimossi tutti gli attributi Data Catalog (ritirati) e gli aspetti di Dataplex Universal Catalog della tabella.

- Non puoi rinominare le tabelle esterne.

Copiare una tabella

Questa sezione descrive come creare una copia completa di una tabella. Per informazioni su altri tipi di copie di tabelle, vedi cloni di tabelle e snapshot delle tabelle.

Puoi copiare una tabella nei seguenti modi:

- Utilizza la console Google Cloud .

- Utilizza il comando

bq cp. - Utilizza un'istruzione DDL (Data Definition Language)

CREATE TABLE COPY. - Chiama il metodo API jobs.insert e configura un job

copy. - Utilizza le librerie client.

Limitazioni relative alla copia delle tabelle

I job di copia delle tabelle sono soggetti alle seguenti limitazioni:

- Non puoi interrompere un'operazione di copia della tabella dopo averla avviata. Un'operazione di copia della tabella viene eseguita in modo asincrono e non si interrompe anche se annulli il job. Ti vengono addebitati anche i costi per il trasferimento di dati per una copia della tabella tra regioni e per l'archiviazione nella regione di destinazione.

- Quando copi una tabella, il nome della tabella di destinazione deve rispettare le stesse convenzioni di denominazione di quando crei una tabella.

- Le copie delle tabelle sono soggette ai limiti di BigQuery per i job di copia.

- La Google Cloud console supporta la copia di una sola tabella alla volta. Non puoi sovrascrivere una tabella esistente nel set di dati di destinazione. La tabella deve avere un nome univoco nel set di dati di destinazione.

- La copia di più tabelle di origine in una tabella di destinazione non è supportata dalla console Google Cloud .

Quando copi più tabelle di origine in una tabella di destinazione utilizzando l'API, lo strumento a riga di comando bq o le librerie client, tutte le tabelle di origine devono avere schemi identici, inclusi partizionamento o clustering.

Alcuni aggiornamenti dello schema della tabella, come l'eliminazione o la ridenominazione delle colonne, possono far sì che le tabelle abbiano schemi apparentemente identici, ma rappresentazioni interne diverse. Ciò potrebbe causare l'esito negativo di un job di copia della tabella con l'errore

Maximum limit on diverging physical schemas reached. In questo caso, puoi utilizzare l'istruzioneCREATE TABLE LIKEper assicurarti che lo schema della tabella di origine corrisponda esattamente a quello della tabella di destinazione.Il tempo impiegato da BigQuery per copiare le tabelle può variare in modo significativo tra le diverse esecuzioni perché lo spazio di archiviazione sottostante viene gestito in modo dinamico.

Non puoi copiare e aggiungere una tabella di origine a una tabella di destinazione che ha più colonne della tabella di origine e le colonne aggiuntive hanno valori predefiniti. In alternativa, puoi eseguire

INSERT destination_table SELECT * FROM source_tableper copiare i dati.Se l'operazione di copia sovrascrive una tabella esistente, l'accesso a livello di tabella per la tabella esistente viene mantenuto. I tag della tabella di origine non vengono copiati nella tabella sovrascritta, mentre i tag della tabella esistente vengono conservati. Tuttavia, quando copi le tabelle tra regioni, i tag nella tabella esistente vengono rimossi.

Se l'operazione di copia crea una nuova tabella, l'accesso a livello di tabella per la nuova tabella è determinato dai criteri di accesso del set di dati in cui viene creata la nuova tabella. Inoltre, i tag vengono copiati dalla tabella di origine alla nuova tabella.

Quando copi più tabelle di origine in una tabella di destinazione, tutte le tabelle di origine devono avere tag identici.

Ruoli obbligatori

Per eseguire le attività descritte in questo documento, devi disporre delle seguenti autorizzazioni.

Ruoli per copiare tabelle e partizioni

Per ottenere le autorizzazioni

necessarie per copiare tabelle e partizioni,

chiedi all'amministratore di concederti il

ruolo IAM Data Editor (roles/bigquery.dataEditor)

nei set di dati di origine e di destinazione.

Per saperne di più sulla concessione dei ruoli, consulta Gestisci l'accesso a progetti, cartelle e organizzazioni.

Questo ruolo predefinito contiene le autorizzazioni necessarie per copiare tabelle e partizioni. Per vedere quali sono esattamente le autorizzazioni richieste, espandi la sezione Autorizzazioni obbligatorie:

Autorizzazioni obbligatorie

Per copiare tabelle e partizioni sono necessarie le seguenti autorizzazioni:

-

bigquery.tables.getDatasui set di dati di origine e destinazione -

bigquery.tables.getsui set di dati di origine e destinazione -

bigquery.tables.createnel set di dati di destinazione -

bigquery.tables.updatenel set di dati di destinazione

Potresti anche ottenere queste autorizzazioni con ruoli personalizzati o altri ruoli predefiniti.

Autorizzazione a eseguire un job di copia

Per ottenere l'autorizzazione necessaria per eseguire un job di copia, chiedi all'amministratore di concederti il ruolo IAM Job User (roles/bigquery.jobUser) sui set di dati di origine e di destinazione.

Per saperne di più sulla concessione dei ruoli, consulta Gestisci l'accesso a progetti, cartelle e organizzazioni.

Questo ruolo predefinito contiene l'autorizzazione

bigquery.jobs.create

necessaria per

eseguire un job di copia.

Potresti anche ottenere questa autorizzazione con ruoli personalizzati o altri ruoli predefiniti.

Copiare una singola tabella di origine

Puoi copiare una singola tabella nei seguenti modi:

- Utilizzo della console Google Cloud .

- Utilizzo del comando

bq cpdello strumento a riga di comando bq. - Utilizzo di un'istruzione

CREATE TABLE COPYDDL (Data Definition Language). - Chiamando il metodo API

jobs.insert, configurando un jobcopye specificando la proprietàsourceTable. - Utilizzo delle librerie client.

La console Google Cloud e l'istruzione CREATE TABLE COPY supportano solo

una tabella di origine e una tabella di

destinazione in un job di copia. Per copiare più file di origine

in una tabella di destinazione, devi utilizzare lo strumento a riga di comando bq o l'API.

Per copiare una singola tabella di origine:

Console

Nel riquadro a sinistra, fai clic su Explorer:

Nel riquadro Explorer, espandi il progetto, fai clic su Set di dati e poi seleziona un set di dati.

Fai clic su Panoramica > Tabelle e poi seleziona una tabella.

Nel riquadro dei dettagli, fai clic su Copia.

Nella finestra di dialogo Copia tabella, in Destinazione:

- In Progetto, scegli il progetto in cui verrà archiviata la tabella copiata.

- Per Set di dati, seleziona il set di dati in cui vuoi archiviare la tabella copiata. I set di dati di origine e di destinazione devono trovarsi nella stessa posizione.

- In Tabella, inserisci un nome per la nuova tabella. Il nome deve essere univoco nel set di dati di destinazione. Non puoi sovrascrivere una tabella esistente nel set di dati di destinazione utilizzando la console Google Cloud . Per ulteriori informazioni sui requisiti per i nomi delle tabelle, consulta Denominazione delle tabelle.

Fai clic su Copia per avviare il job di copia.

SQL

Utilizza l'istruzione

CREATE TABLE COPY

per copiare una tabella denominata

table1 in una nuova tabella denominata table1copy:

Nella console Google Cloud , vai alla pagina BigQuery.

Nell'editor di query, inserisci la seguente istruzione:

CREATE TABLE

myproject.mydataset.table1copyCOPYmyproject.mydataset.table1;Fai clic su Esegui.

Per saperne di più su come eseguire le query, consulta Eseguire una query interattiva.

bq

-

In the Google Cloud console, activate Cloud Shell.

At the bottom of the Google Cloud console, a Cloud Shell session starts and displays a command-line prompt. Cloud Shell is a shell environment with the Google Cloud CLI already installed and with values already set for your current project. It can take a few seconds for the session to initialize.

Esegui il comando

bq cp. I flag facoltativi possono essere utilizzati per controllare la disposizione di scrittura della tabella di destinazione:-ao--append_tableaggiunge i dati della tabella di origine a una tabella esistente nel set di dati di destinazione.-fo--forcesovrascrive una tabella esistente nel set di dati di destinazione e non ti chiede una conferma.-no--no_clobberrestituisce il seguente messaggio di errore se la tabella esiste nel set di dati di destinazione:Table 'project_id:dataset.table' already exists, skipping.Se-nnon è specificato, il comportamento predefinito è quello di chiederti di scegliere se sostituire la tabella di destinazione.--destination_kms_keyè la chiave Cloud KMS gestita dal cliente utilizzata per criptare la tabella di destinazione.

--destination_kms_keynon è dimostrato qui. Per saperne di più, consulta Proteggere i dati con le chiavi Cloud Key Management Service.Se il set di dati di origine o di destinazione si trova in un progetto diverso da quello predefinito, aggiungi l'ID progetto ai nomi dei set di dati nel seguente formato:

project_id:dataset.(Facoltativo) Fornisci il flag

--locatione imposta il valore sulla tua posizione.bq --location=location cp \ -a -f -n \

project_id:dataset.source_table\project_id:dataset.destination_tableSostituisci quanto segue:

location: il nome della tua sede. Il flag--locationè facoltativo. Ad esempio, se utilizzi BigQuery nella regione di Tokyo, puoi impostare il valore del flag suasia-northeast1. Puoi impostare un valore predefinito per la posizione utilizzando il file.bigqueryrc.project_id: il tuo ID progetto.dataset: il nome del set di dati di origine o di destinazione.source_table: la tabella che stai copiando.destination_table: il nome della tabella nel set di dati di destinazione.

Esempi:

Per copiare la tabella

mydataset.mytablenella tabellamydataset2.mytable2, inserisci il comando seguente. Entrambi i set di dati si trovano nel tuo progetto predefinito.bq cp mydataset.mytable mydataset2.mytable2

Per copiare la tabella

mydataset.mytablee sovrascrivere una tabella di destinazione con lo stesso nome, inserisci il seguente comando. Il set di dati di origine si trova nel tuo progetto predefinito. Il set di dati di destinazione si trova nel progettomyotherproject. La scorciatoia-fviene utilizzata per sovrascrivere la tabella di destinazione senza un prompt.bq cp -f \ mydataset.mytable \ myotherproject:myotherdataset.mytable

Per copiare la tabella

mydataset.mytablee restituire un errore se il set di dati di destinazione contiene una tabella con lo stesso nome, inserisci il seguente comando. Il set di dati di origine si trova nel tuo progetto predefinito. Il set di dati di destinazione si trova nel progettomyotherproject. La scorciatoia-nviene utilizzata per impedire la sovrascrittura di una tabella con lo stesso nome.bq cp -n \ mydataset.mytable \ myotherproject:myotherdataset.mytable

Per copiare la tabella

mydataset.mytablee aggiungere i dati a una tabella di destinazione con lo stesso nome, inserisci il seguente comando. Il set di dati di origine si trova nel tuo progetto predefinito. Il set di dati di destinazione si trova nel progettomyotherproject. La scorciatoia- aviene utilizzata per aggiungere dati alla tabella di destinazione.bq cp -a mydataset.mytable myotherproject:myotherdataset.mytable

API

Puoi copiare una tabella esistente tramite l'API chiamando il metodo

bigquery.jobs.insert e configurando un job copy. Specifica la tua posizione nella

proprietà location nella sezione jobReference della

risorsa job.

Devi specificare i seguenti valori nella configurazione del job:

"copy": {

"sourceTable": { // Required

"projectId": string, // Required

"datasetId": string, // Required

"tableId": string // Required

},

"destinationTable": { // Required

"projectId": string, // Required

"datasetId": string, // Required

"tableId": string // Required

},

"createDisposition": string, // Optional

"writeDisposition": string, // Optional

},

Dove sourceTable fornisce informazioni sulla tabella da

copiare, destinationTable fornisce informazioni sulla nuova

tabella, createDisposition specifica se creare la

tabella se non esiste e writeDisposition specifica

se sovrascrivere o aggiungere a una tabella esistente.

C#

Prima di provare questo esempio, segui le istruzioni di configurazione di C# nella guida rapida di BigQuery per l'utilizzo delle librerie client. Per saperne di più, consulta la documentazione di riferimento dell'API BigQuery C#.

Per eseguire l'autenticazione in BigQuery, configura le Credenziali predefinite dell'applicazione. Per saperne di più, vedi Configurare l'autenticazione per le librerie client.

Vai

Prima di provare questo esempio, segui le istruzioni di configurazione di Go nella guida rapida di BigQuery per l'utilizzo delle librerie client. Per saperne di più, consulta la documentazione di riferimento dell'API BigQuery Go.

Per eseguire l'autenticazione in BigQuery, configura le Credenziali predefinite dell'applicazione. Per saperne di più, vedi Configurare l'autenticazione per le librerie client.

Java

Prima di provare questo esempio, segui le istruzioni di configurazione di Java nella guida rapida di BigQuery per l'utilizzo delle librerie client. Per saperne di più, consulta la documentazione di riferimento dell'API BigQuery Java.

Per eseguire l'autenticazione in BigQuery, configura le Credenziali predefinite dell'applicazione. Per saperne di più, vedi Configurare l'autenticazione per le librerie client.

Node.js

Prima di provare questo esempio, segui le istruzioni di configurazione di Node.js nella guida rapida di BigQuery per l'utilizzo delle librerie client. Per saperne di più, consulta la documentazione di riferimento dell'API BigQuery Node.js.

Per eseguire l'autenticazione in BigQuery, configura le Credenziali predefinite dell'applicazione. Per saperne di più, vedi Configurare l'autenticazione per le librerie client.

PHP

Prima di provare questo esempio, segui le istruzioni di configurazione di PHP nella guida rapida di BigQuery per l'utilizzo delle librerie client. Per saperne di più, consulta la documentazione di riferimento dell'API BigQuery PHP.

Per eseguire l'autenticazione in BigQuery, configura le Credenziali predefinite dell'applicazione. Per saperne di più, vedi Configurare l'autenticazione per le librerie client.

Python

Prima di provare questo esempio, segui le istruzioni di configurazione di Python nella guida rapida di BigQuery per l'utilizzo delle librerie client. Per saperne di più, consulta la documentazione di riferimento dell'API BigQuery Python.

Per eseguire l'autenticazione in BigQuery, configura le Credenziali predefinite dell'applicazione. Per saperne di più, vedi Configurare l'autenticazione per le librerie client.

Copiare più tabelle di origine

Puoi copiare più tabelle di origine in una tabella di destinazione nei seguenti modi:

- Utilizzo del comando

bq cpdello strumento a riga di comando bq. - Chiamando il metodo

jobs.insert, configurando un jobcopye specificando la proprietàsourceTables. - Utilizzo delle librerie client.

Tutte le tabelle di origine devono avere schemi e tag identici ed è consentita una sola tabella di destinazione.

Le tabelle di origine devono essere specificate come elenco separato da virgole. Non puoi utilizzare caratteri jolly quando copi più tabelle di origine.

Per copiare più tabelle di origine, seleziona una delle seguenti opzioni:

bq

-

In the Google Cloud console, activate Cloud Shell.

At the bottom of the Google Cloud console, a Cloud Shell session starts and displays a command-line prompt. Cloud Shell is a shell environment with the Google Cloud CLI already installed and with values already set for your current project. It can take a few seconds for the session to initialize.

Esegui il comando

bq cpe includi più tabelle di origine come elenco separato da virgole. I flag facoltativi possono essere utilizzati per controllare la disposizione di scrittura della tabella di destinazione:-ao--append_tableaggiunge i dati delle tabelle di origine a una tabella esistente nel set di dati di destinazione.-fo--forcesovrascrive una tabella di destinazione esistente nel set di dati di destinazione e non ti chiede la conferma.-no--no_clobberrestituisce il seguente messaggio di errore se la tabella esiste nel set di dati di destinazione:Table 'project_id:dataset.table' already exists, skipping.Se-nnon è specificato, il comportamento predefinito è quello di chiederti se sostituire la tabella di destinazione.--destination_kms_keyè la chiave Cloud Key Management Service gestita dal cliente utilizzata per criptare la tabella di destinazione.

--destination_kms_keynon è dimostrato qui. Per saperne di più, consulta Proteggere i dati con le chiavi Cloud Key Management Service.Se il set di dati di origine o di destinazione si trova in un progetto diverso da quello predefinito, aggiungi l'ID progetto ai nomi dei set di dati nel seguente formato:

project_id:dataset.(Facoltativo) Fornisci il flag

--locatione imposta il valore sulla tua posizione.bq --location=location cp \ -a -f -n \

project_id:dataset.source_table,project_id:dataset.source_table\project_id:dataset.destination_tableSostituisci quanto segue:

location: il nome della tua sede. Il flag--locationè facoltativo. Ad esempio, se utilizzi BigQuery nella regione di Tokyo, puoi impostare il valore del flag suasia-northeast1. Puoi impostare un valore predefinito per la posizione utilizzando il file.bigqueryrc.project_id: il tuo ID progetto.dataset: il nome del set di dati di origine o di destinazione.source_table: la tabella che stai copiando.destination_table: il nome della tabella nel set di dati di destinazione.

Esempi:

Per copiare la tabella

mydataset.mytablee la tabellamydataset.mytable2nella tabellamydataset2.tablecopy, inserisci il comando seguente . Tutti i set di dati si trovano nel tuo progetto predefinito.bq cp \ mydataset.mytable,mydataset.mytable2 \ mydataset2.tablecopy

Per copiare la tabella

mydataset.mytablee la tabellamydataset.mytable2nella tabellamyotherdataset.mytablee per sovrascrivere una tabella di destinazione con lo stesso nome, inserisci il seguente comando. Il set di dati di destinazione si trova nel progettomyotherproject, non nel tuo progetto predefinito. La scorciatoia-fviene utilizzata per sovrascrivere la tabella di destinazione senza prompt.bq cp -f \ mydataset.mytable,mydataset.mytable2 \ myotherproject:myotherdataset.mytable

Per copiare la tabella

myproject:mydataset.mytablee la tabellamyproject:mydataset.mytable2e restituire un errore se il set di dati di destinazione contiene una tabella con lo stesso nome, inserisci il seguente comando. Il set di dati di destinazione si trova nel progettomyotherproject. La scorciatoia-nviene utilizzata per evitare di sovrascrivere una tabella con lo stesso nome.bq cp -n \ myproject:mydataset.mytable,myproject:mydataset.mytable2 \ myotherproject:myotherdataset.mytable

Per copiare la tabella

mydataset.mytablee la tabellamydataset.mytable2e per aggiungere i dati a una tabella di destinazione con lo stesso nome, inserisci il seguente comando. Il set di dati di origine si trova nel tuo progetto predefinito. Il set di dati di destinazione si trova nel progettomyotherproject. La scorciatoia-aviene utilizzata per aggiungere dati alla tabella di destinazione.bq cp -a \ mydataset.mytable,mydataset.mytable2 \ myotherproject:myotherdataset.mytable

API

Per copiare più tabelle utilizzando l'API, chiama il metodo jobs.insert, configura un job copy della tabella e specifica la proprietà sourceTables.

Specifica la tua regione nella proprietà location nella sezione

jobReference della risorsa job.

Vai

Prima di provare questo esempio, segui le istruzioni di configurazione di Go nella guida rapida di BigQuery per l'utilizzo delle librerie client. Per saperne di più, consulta la documentazione di riferimento dell'API BigQuery Go.

Per eseguire l'autenticazione in BigQuery, configura le Credenziali predefinite dell'applicazione. Per saperne di più, vedi Configurare l'autenticazione per le librerie client.

Java

Prima di provare questo esempio, segui le istruzioni di configurazione di Java nella guida rapida di BigQuery per l'utilizzo delle librerie client. Per saperne di più, consulta la documentazione di riferimento dell'API BigQuery Java.

Per eseguire l'autenticazione in BigQuery, configura le Credenziali predefinite dell'applicazione. Per saperne di più, vedi Configurare l'autenticazione per le librerie client.

Node.js

Prima di provare questo esempio, segui le istruzioni di configurazione di Node.js nella guida rapida di BigQuery per l'utilizzo delle librerie client. Per saperne di più, consulta la documentazione di riferimento dell'API BigQuery Node.js.

Per eseguire l'autenticazione in BigQuery, configura le Credenziali predefinite dell'applicazione. Per saperne di più, vedi Configurare l'autenticazione per le librerie client.

Python

Prima di provare questo esempio, segui le istruzioni di configurazione di Python nella guida rapida di BigQuery per l'utilizzo delle librerie client. Per saperne di più, consulta la documentazione di riferimento dell'API BigQuery Python.

Per eseguire l'autenticazione in BigQuery, configura le Credenziali predefinite dell'applicazione. Per saperne di più, vedi Configurare l'autenticazione per le librerie client.

Copia le tabelle tra regioni

Puoi copiare una tabella, uno snapshot della tabella o un clone della tabella da una regione BigQuery o da una regione multipla a un'altra. Ciò include tutte le tabelle a cui è stata applicata la crittografia Cloud KMS (CMEK) gestita dal cliente.

La copia di una tabella tra regioni comporta costi aggiuntivi per il trasferimento dei dati in base ai prezzi di BigQuery. Vengono addebitati costi aggiuntivi anche se annulli il job di copia della tabella tra regioni prima del completamento.

Per copiare una tabella tra regioni, seleziona una delle seguenti opzioni:

bq

-

In the Google Cloud console, activate Cloud Shell.

At the bottom of the Google Cloud console, a Cloud Shell session starts and displays a command-line prompt. Cloud Shell is a shell environment with the Google Cloud CLI already installed and with values already set for your current project. It can take a few seconds for the session to initialize.

Esegui il comando

bq cp:SOURCE_PROJECT: ID progetto di origine. Se il set di dati di origine si trova in un progetto diverso da quello predefinito, aggiungi l'ID progetto al nome del set di dati di origine.DESTINATION_PROJECT: ID progetto di destinazione. Se il set di dati di destinazione si trova in un progetto diverso da quello predefinito, aggiungi l'ID progetto al nome del set di dati di destinazione.SOURCE_DATASET: il nome del set di dati di origine.DESTINATION_DATASET: il nome del set di dati di destinazione.SOURCE_TABLE: la tabella che stai copiando.DESTINATION_TABLE: il nome della tabella nel set di dati di destinazione.

bq cp \ -f -n \SOURCE_PROJECT:SOURCE_DATASET.SOURCE_TABLE\DESTINATION_PROJECT:DESTINATION_DATASET.DESTINATION_TABLE

Sostituisci quanto segue:

Il seguente esempio è un comando che copia la tabella mydataset_us.mytable dalla multi-regione us alla tabella mydataset_eu.mytable2 nella multi-regione eu. Entrambi i set di dati si trovano nel progetto predefinito.

bq cp --sync=false mydataset_us.mytable mydataset_eu.mytable2

Per copiare una tabella tra regioni diverse in un set di dati di destinazione abilitato per CMEK, devi abilitare CMEK nella tabella con una chiave della regione della tabella. La CMEK nella tabella non deve essere la stessa CMEK utilizzata dal set di dati di destinazione. Il seguente esempio copia una tabella abilitata a CMEK in un set di dati di destinazione utilizzando il comando bq cp.

bq cp source-project-id:source-dataset-id.source-table-id destination-project-id:destination-dataset-id.destination-table-id

Al contrario, per copiare una tabella abilitata per CMEK tra regioni in un set di dati di destinazione, puoi abilitare CMEK nel set di dati di destinazione con una chiave della regione del set di dati di destinazione. Puoi anche utilizzare il flag destination_kms_keys nel comando bq cp, come mostrato nell'esempio seguente:

bq cp --destination_kms_key=projects/project_id/locations/eu/keyRings/eu_key/cryptoKeys/eu_region mydataset_us.mytable mydataset_eu.mytable2

API

Per copiare una tabella tra regioni utilizzando l'API, chiama il metodo jobs.insert e configura un job copy della tabella.

Specifica la tua regione nella proprietà location nella sezione

jobReference della risorsa job.

C#

Prima di provare questo esempio, segui le istruzioni di configurazione di C# nella guida rapida di BigQuery per l'utilizzo delle librerie client. Per saperne di più, consulta la documentazione di riferimento dell'API BigQuery C#.

Per eseguire l'autenticazione in BigQuery, configura le Credenziali predefinite dell'applicazione. Per saperne di più, vedi Configurare l'autenticazione per le librerie client.

Vai

Prima di provare questo esempio, segui le istruzioni di configurazione di Go nella guida rapida di BigQuery per l'utilizzo delle librerie client. Per saperne di più, consulta la documentazione di riferimento dell'API BigQuery Go.

Per eseguire l'autenticazione in BigQuery, configura le Credenziali predefinite dell'applicazione. Per saperne di più, vedi Configurare l'autenticazione per le librerie client.

Java

Prima di provare questo esempio, segui le istruzioni di configurazione di Java nella guida rapida di BigQuery per l'utilizzo delle librerie client. Per saperne di più, consulta la documentazione di riferimento dell'API BigQuery Java.

Per eseguire l'autenticazione in BigQuery, configura le Credenziali predefinite dell'applicazione. Per saperne di più, vedi Configurare l'autenticazione per le librerie client.

Node.js

Prima di provare questo esempio, segui le istruzioni di configurazione di Node.js nella guida rapida di BigQuery per l'utilizzo delle librerie client. Per saperne di più, consulta la documentazione di riferimento dell'API BigQuery Node.js.

Per eseguire l'autenticazione in BigQuery, configura le Credenziali predefinite dell'applicazione. Per saperne di più, vedi Configurare l'autenticazione per le librerie client.

PHP

Prima di provare questo esempio, segui le istruzioni di configurazione di PHP nella guida rapida di BigQuery per l'utilizzo delle librerie client. Per saperne di più, consulta la documentazione di riferimento dell'API BigQuery PHP.

Per eseguire l'autenticazione in BigQuery, configura le Credenziali predefinite dell'applicazione. Per saperne di più, vedi Configurare l'autenticazione per le librerie client.

Python

Prima di provare questo esempio, segui le istruzioni di configurazione di Python nella guida rapida di BigQuery per l'utilizzo delle librerie client. Per saperne di più, consulta la documentazione di riferimento dell'API BigQuery Python.

Per eseguire l'autenticazione in BigQuery, configura le Credenziali predefinite dell'applicazione. Per saperne di più, vedi Configurare l'autenticazione per le librerie client.

Limitazioni

La copia di una tabella tra regioni è soggetta alle seguenti limitazioni:

- Non puoi copiare una tabella utilizzando la console Google Cloud o l'istruzione

TABLE COPY DDL. - Non puoi copiare una tabella se contiene tag di policy.

- Non puoi copiare una tabella se la tabella di origine ha dimensioni superiori a 20 TiB fisici. Per le dimensioni fisiche della tabella di origine, consulta Ottenere informazioni sulle tabelle. Inoltre, la copia di tabelle di origine più grandi di 1 TiB fisico tra regioni potrebbe richiedere più tentativi per essere completata correttamente.

- Non puoi copiare i criteri IAM associati alle tabelle. Puoi applicare le stesse policy alla destinazione al termine della copia.

- Se l'operazione di copia sovrascrive una tabella esistente, i tag della tabella esistente vengono rimossi.

- Non puoi copiare più tabelle di origine in un'unica tabella di destinazione.

- Non puoi copiare le tabelle in modalità di accodamento.

- Le informazioni relative al viaggio nel tempo non vengono copiate nella regione di destinazione.

- Quando copi un clone o uno snapshot di una tabella in una nuova regione, viene creata una copia completa della tabella. Questa operazione comporta costi di archiviazione aggiuntivi.

Visualizzare l'utilizzo attuale della quota

Puoi visualizzare l'utilizzo corrente dei job di query, caricamento, estrazione o copia eseguendo

una query INFORMATION_SCHEMA per visualizzare i metadati dei job eseguiti in un

periodo di tempo specificato. Puoi confrontare l'utilizzo corrente con il limite di quota per determinare l'utilizzo della quota per un particolare tipo di job. La seguente query di esempio utilizza la vista INFORMATION_SCHEMA.JOBS per elencare il numero di job di query, caricamento, estrazione e copia per progetto:

SELECT sum(case when job_type="QUERY" then 1 else 0 end) as QRY_CNT, sum(case when job_type="LOAD" then 1 else 0 end) as LOAD_CNT, sum(case when job_type="EXTRACT" then 1 else 0 end) as EXT_CNT, sum(case when job_type="COPY" then 1 else 0 end) as CPY_CNT FROM `region-REGION_NAME`.INFORMATION_SCHEMA.JOBS_BY_PROJECT WHERE date(creation_time)= CURRENT_DATE()

Per visualizzare i limiti di quota per i job di copia, consulta Quote e limiti - Job di copia.

Eliminare le tabelle

Puoi eliminare una tabella nei seguenti modi:

- Utilizzo della console Google Cloud .

- Utilizzo di un'istruzione

DROP TABLEDDL (Data Definition Language). - Utilizzo dello strumento a riga di comando bq

bq rm. - Chiamata del metodo API

tables.delete. - Utilizzo delle librerie client.

Per eliminare tutte le tabelle nel set di dati, elimina il set di dati.

Quando elimini una tabella, vengono eliminati anche tutti i dati contenuti. Per eliminare automaticamente le tabelle dopo un periodo di tempo specificato, imposta la scadenza predefinita delle tabelle per il set di dati o imposta il tempo di scadenza quando crei la tabella.

Se elimini una tabella, vengono eliminate anche tutte le autorizzazioni associate. Quando ricrei una tabella eliminata, devi anche riconfigurare manualmente le autorizzazioni di accesso associate in precedenza.

Ruoli obbligatori

Per ottenere le autorizzazioni

necessarie per eliminare una tabella,

chiedi all'amministratore di concederti il ruolo IAM

Data Editor (roles/bigquery.dataEditor)

sul set di dati.

Per saperne di più sulla concessione dei ruoli, consulta Gestisci l'accesso a progetti, cartelle e organizzazioni.

Questo ruolo predefinito contiene le autorizzazioni necessarie per eliminare una tabella. Per vedere quali sono esattamente le autorizzazioni richieste, espandi la sezione Autorizzazioni obbligatorie:

Autorizzazioni obbligatorie

Per eliminare una tabella sono necessarie le seguenti autorizzazioni:

-

bigquery.tables.delete -

bigquery.tables.get

Potresti anche ottenere queste autorizzazioni con ruoli personalizzati o altri ruoli predefiniti.

Eliminazione di una tabella

Per eliminare una tabella:

Console

Nel riquadro a sinistra, fai clic su Explorer:

Nel riquadro Explorer, espandi il progetto, fai clic su Set di dati e poi seleziona un set di dati.

Fai clic su Panoramica > Tabelle e poi seleziona una tabella.

Nel riquadro dei dettagli, fai clic su Elimina.

Digita

"delete"nella finestra di dialogo, quindi fai clic su Elimina per confermare.

SQL

Utilizza l'istruzione DROP TABLE.

L'esempio seguente elimina una tabella denominata mytable:

Nella console Google Cloud , vai alla pagina BigQuery.

Nell'editor di query, inserisci la seguente istruzione:

DROP TABLE mydataset.mytable;

Fai clic su Esegui.

Per saperne di più su come eseguire le query, consulta Eseguire una query interattiva.

bq

-

In the Google Cloud console, activate Cloud Shell.

At the bottom of the Google Cloud console, a Cloud Shell session starts and displays a command-line prompt. Cloud Shell is a shell environment with the Google Cloud CLI already installed and with values already set for your current project. It can take a few seconds for the session to initialize.

Utilizza il comando

bq rmcon il flag--table(o la scorciatoia-t) per eliminare una tabella. Quando utilizzi lo strumento a riga di comando bq per rimuovere una tabella, devi confermare l'azione. Puoi utilizzare il flag--force(o la scorciatoia-f) per saltare la conferma.Se la tabella si trova in un set di dati in un progetto diverso da quello predefinito, aggiungi l'ID progetto al nome del set di dati nel seguente formato:

project_id:dataset.bq rm \ -f \ -t \ project_id:dataset.table

Sostituisci quanto segue:

project_id: il tuo ID progettodataset: il nome del set di dati che contiene la tabellatable: il nome della tabella che stai eliminando

Esempi:

Per eliminare la tabella

mytabledal set di datimydataset, inserisci il seguente comando. Il set di datimydatasetsi trova nel tuo progetto predefinito.bq rm -t mydataset.mytable

Per eliminare la tabella

mytabledal set di datimydataset, inserisci il seguente comando. Il set di datimydatasetsi trova nel progettomyotherproject, non nel tuo progetto predefinito.bq rm -t myotherproject:mydataset.mytable

Per eliminare la tabella

mytabledal set di datimydataset, inserisci il seguente comando. Il set di datimydatasetsi trova nel tuo progetto predefinito. Il comando utilizza la scorciatoia-fper ignorare la conferma.bq rm -f -t mydataset.mytable

API

Chiama il metodo API tables.delete e specifica la tabella da eliminare utilizzando il parametro tableId.

C#

Prima di provare questo esempio, segui le istruzioni di configurazione di C# nella guida rapida di BigQuery per l'utilizzo delle librerie client. Per saperne di più, consulta la documentazione di riferimento dell'API BigQuery C#.

Per eseguire l'autenticazione in BigQuery, configura le Credenziali predefinite dell'applicazione. Per saperne di più, vedi Configurare l'autenticazione per le librerie client.

Vai

Prima di provare questo esempio, segui le istruzioni di configurazione di Go nella guida rapida di BigQuery per l'utilizzo delle librerie client. Per saperne di più, consulta la documentazione di riferimento dell'API BigQuery Go.

Per eseguire l'autenticazione in BigQuery, configura le Credenziali predefinite dell'applicazione. Per saperne di più, vedi Configurare l'autenticazione per le librerie client.

Java

Prima di provare questo esempio, segui le istruzioni di configurazione di Java nella guida rapida di BigQuery per l'utilizzo delle librerie client. Per saperne di più, consulta la documentazione di riferimento dell'API BigQuery Java.

Per eseguire l'autenticazione in BigQuery, configura le Credenziali predefinite dell'applicazione. Per saperne di più, vedi Configurare l'autenticazione per le librerie client.

Node.js

Prima di provare questo esempio, segui le istruzioni di configurazione di Node.js nella guida rapida di BigQuery per l'utilizzo delle librerie client. Per saperne di più, consulta la documentazione di riferimento dell'API BigQuery Node.js.

Per eseguire l'autenticazione in BigQuery, configura le Credenziali predefinite dell'applicazione. Per saperne di più, vedi Configurare l'autenticazione per le librerie client.

PHP

Prima di provare questo esempio, segui le istruzioni di configurazione di PHP nella guida rapida di BigQuery per l'utilizzo delle librerie client. Per saperne di più, consulta la documentazione di riferimento dell'API BigQuery PHP.

Per eseguire l'autenticazione in BigQuery, configura le Credenziali predefinite dell'applicazione. Per saperne di più, vedi Configurare l'autenticazione per le librerie client.

Python

Prima di provare questo esempio, segui le istruzioni di configurazione di Python nella guida rapida di BigQuery per l'utilizzo delle librerie client. Per saperne di più, consulta la documentazione di riferimento dell'API BigQuery Python.

Per eseguire l'autenticazione in BigQuery, configura le Credenziali predefinite dell'applicazione. Per saperne di più, vedi Configurare l'autenticazione per le librerie client.

Ruby

Prima di provare questo esempio, segui le istruzioni di configurazione di Ruby nella guida rapida di BigQuery per l'utilizzo delle librerie client. Per saperne di più, consulta la documentazione di riferimento dell'API BigQuery Ruby.

Per eseguire l'autenticazione in BigQuery, configura le Credenziali predefinite dell'applicazione. Per saperne di più, vedi Configurare l'autenticazione per le librerie client.

Ripristinare tabelle eliminate

Per scoprire come ripristinare o recuperare le tabelle eliminate, consulta Ripristinare le tabelle eliminate.

Sicurezza delle tabelle

Per controllare l'accesso alle tabelle in BigQuery, vedi Controllare l'accesso alle risorse con IAM.

Passaggi successivi

- Per ulteriori informazioni sulla creazione e l'utilizzo delle tabelle, vedi Creazione e utilizzo delle tabelle.

- Per saperne di più sulla gestione dei dati, consulta Utilizzo dei dati delle tabelle.

- Per ulteriori informazioni sulla specifica degli schemi delle tabelle, vedi Specifica di uno schema.

- Per ulteriori informazioni sulla modifica degli schemi delle tabelle, vedi Modifica degli schemi delle tabelle.

- Per saperne di più sui set di dati, consulta Introduzione ai set di dati.

- Per saperne di più sulle viste, consulta Introduzione alle viste.