Menyesuaikan model menggunakan data Anda

Dokumen ini menunjukkan cara membuat model jarak jauh BigQuery ML yang merujuk ke model Vertex AI, lalu mengonfigurasi model untuk melakukan penyesuaian yang diawasi. Model Vertex AI harus berupa salah satu dari berikut ini:

gemini-2.5-progemini-2.5-flash-litegemini-2.0-flash-001gemini-2.0-flash-lite-001

Setelah membuat model jarak jauh, Anda menggunakan

fungsi ML.EVALUATE

untuk mengevaluasi model dan mengonfirmasi bahwa performa model sesuai dengan kasus penggunaan Anda. Kemudian, Anda dapat menggunakan model tersebut bersama dengan

fungsi ML.GENERATE_TEXT

untuk menganalisis teks dalam tabel BigQuery.

Untuk mengetahui informasi selengkapnya, lihat Penyesuaian yang diawasi model Vertex AI Gemini API.

Peran yang diperlukan

Untuk membuat dan mengevaluasi model yang di-tuning, Anda memerlukan peran Identity and Access Management (IAM) berikut:

- Membuat dan menggunakan set data, tabel, dan model BigQuery:

BigQuery Data Editor (

roles/bigquery.dataEditor) di project Anda. Membuat, mendelegasikan, dan menggunakan koneksi BigQuery: BigQuery Connections Admin (

roles/bigquery.connectionsAdmin) di project Anda.Jika Anda belum mengonfigurasi koneksi default, Anda dapat membuat dan menyetelnya sebagai bagian dari menjalankan pernyataan

CREATE MODEL. Untuk melakukannya, Anda harus memiliki peran Admin BigQuery (roles/bigquery.admin) di project Anda. Untuk mengetahui informasi selengkapnya, lihat Mengonfigurasi koneksi default.Memberikan izin ke akun layanan koneksi: Admin IAM Project (

roles/resourcemanager.projectIamAdmin) di project yang berisi endpoint Vertex AI. Ini adalah project saat ini untuk model jarak jauh yang Anda buat dengan menentukan nama model sebagai endpoint. Ini adalah project yang diidentifikasi dalam URL untuk model jarak jauh yang Anda buat dengan menentukan URL sebagai endpoint.Membuat tugas BigQuery: Pengguna Tugas BigQuery (

roles/bigquery.jobUser) di project Anda.

Peran yang telah ditetapkan ini berisi izin yang diperlukan untuk melakukan tugas dalam dokumen ini. Untuk melihat izin yang benar-benar diperlukan, luaskan bagian Izin yang diperlukan:

Izin yang diperlukan

- Buat set data:

bigquery.datasets.create - Membuat, mendelegasikan, dan menggunakan koneksi:

bigquery.connections.* - Tetapkan izin akun layanan:

resourcemanager.projects.getIamPolicydanresourcemanager.projects.setIamPolicy - Buat model dan jalankan inferensi:

bigquery.jobs.createbigquery.models.createbigquery.models.getDatabigquery.models.updateDatabigquery.models.updateMetadata

Anda mungkin juga bisa mendapatkan izin ini dengan peran khusus atau peran bawaan lainnya.

Sebelum memulai

-

In the Google Cloud console, on the project selector page, select or create a Google Cloud project.

Roles required to select or create a project

- Select a project: Selecting a project doesn't require a specific IAM role—you can select any project that you've been granted a role on.

-

Create a project: To create a project, you need the Project Creator

(

roles/resourcemanager.projectCreator), which contains theresourcemanager.projects.createpermission. Learn how to grant roles.

-

Verify that billing is enabled for your Google Cloud project.

-

Enable the BigQuery, BigQuery Connection,Vertex AI, and Compute Engine APIs.

Roles required to enable APIs

To enable APIs, you need the Service Usage Admin IAM role (

roles/serviceusage.serviceUsageAdmin), which contains theserviceusage.services.enablepermission. Learn how to grant roles.

Membuat set data

Buat set data BigQuery untuk memuat resource Anda:

Konsol

Di konsol Google Cloud , buka halaman BigQuery.

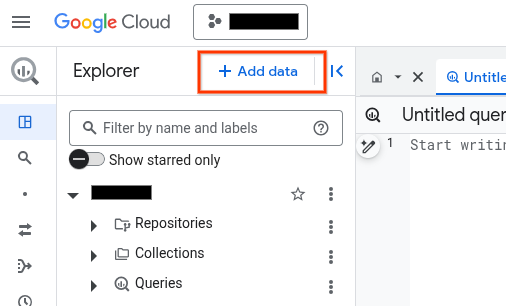

Di panel kiri, klik Explorer:

Jika Anda tidak melihat panel kiri, klik Luaskan panel kiri untuk membuka panel.

Di panel Explorer, klik nama project Anda.

Klik View actions > Create dataset.

Di halaman Create dataset, lakukan hal berikut:

Untuk ID Set Data, ketik nama untuk set data.

Untuk Jenis lokasi, pilih Region atau Multi-region.

- Jika Anda memilih Wilayah, pilih lokasi dari daftar Wilayah.

- Jika Anda memilih Multi-region, pilih US atau Eropa dari daftar Multi-region.

Klik Create dataset.

bq

Membuat koneksi

Anda dapat melewati langkah ini jika telah mengonfigurasi koneksi default, atau memiliki peran Admin BigQuery.

Buat koneksi resource Cloud untuk digunakan model jarak jauh, lalu dapatkan akun layanan koneksi. Buat koneksi di lokasi yang sama dengan set data yang Anda buat di langkah sebelumnya.

Pilih salah satu opsi berikut:

Konsol

Buka halaman BigQuery.

Di panel Penjelajah, klik Tambahkan data:

Dialog Tambahkan data akan terbuka.

Di panel Filter Menurut, di bagian Jenis Sumber Data, pilih Aplikasi Bisnis.

Atau, di kolom Telusuri sumber data, Anda dapat memasukkan

Vertex AI.Di bagian Sumber data unggulan, klik Vertex AI.

Klik kartu solusi Vertex AI Models: BigQuery Federation.

Dalam daftar Connection type, pilih Vertex AI remote models, remote functions, BigLake and Spanner (Cloud Resource).

Di kolom Connection ID, masukkan nama untuk koneksi Anda.

Klik Create connection.

Klik Go to connection.

Di panel Connection info, salin ID akun layanan untuk digunakan di langkah berikutnya.

bq

Di lingkungan command line, buat koneksi:

bq mk --connection --location=REGION --project_id=PROJECT_ID \ --connection_type=CLOUD_RESOURCE CONNECTION_ID

Parameter

--project_idakan mengganti project default.Ganti kode berikut:

REGION: region koneksi AndaPROJECT_ID: Google Cloud project ID AndaCONNECTION_ID: ID untuk koneksi Anda

Saat Anda membuat resource koneksi, BigQuery akan membuat akun layanan sistem unik dan mengaitkannya dengan koneksi.

Pemecahan masalah: Jika Anda mendapatkan error koneksi berikut, update Google Cloud SDK:

Flags parsing error: flag --connection_type=CLOUD_RESOURCE: value should be one of...

Ambil dan salin ID akun layanan untuk digunakan pada langkah berikutnya:

bq show --connection PROJECT_ID.REGION.CONNECTION_ID

Outputnya mirip dengan hal berikut ini:

name properties 1234.REGION.CONNECTION_ID {"serviceAccountId": "connection-1234-9u56h9@gcp-sa-bigquery-condel.iam.gserviceaccount.com"}

Terraform

Gunakan resource google_bigquery_connection.

Untuk melakukan autentikasi ke BigQuery, siapkan Kredensial Default Aplikasi. Untuk mengetahui informasi selengkapnya, lihat Menyiapkan autentikasi untuk library klien.

Contoh berikut membuat koneksi resource Cloud bernama

my_cloud_resource_connection di region US:

Untuk menerapkan konfigurasi Terraform di project Google Cloud , selesaikan langkah-langkah di bagian berikut.

Menyiapkan Cloud Shell

- Luncurkan Cloud Shell.

-

Tetapkan project Google Cloud default tempat Anda ingin menerapkan konfigurasi Terraform.

Anda hanya perlu menjalankan perintah ini sekali per project, dan dapat dijalankan di direktori mana pun.

export GOOGLE_CLOUD_PROJECT=PROJECT_ID

Variabel lingkungan akan diganti jika Anda menetapkan nilai eksplisit dalam file konfigurasi Terraform.

Menyiapkan direktori

Setiap file konfigurasi Terraform harus memiliki direktorinya sendiri (juga disebut modul root).

-

Di Cloud Shell, buat direktori dan file baru di dalam direktori tersebut. Nama file harus memiliki

ekstensi

.tf—misalnyamain.tf. Dalam tutorial ini, file ini disebut sebagaimain.tf.mkdir DIRECTORY && cd DIRECTORY && touch main.tf

-

Jika mengikuti tutorial, Anda dapat menyalin kode contoh di setiap bagian atau langkah.

Salin kode contoh ke dalam

main.tfyang baru dibuat.Atau, salin kode dari GitHub. Tindakan ini direkomendasikan jika cuplikan Terraform adalah bagian dari solusi menyeluruh.

- Tinjau dan ubah contoh parameter untuk diterapkan pada lingkungan Anda.

- Simpan perubahan Anda.

-

Lakukan inisialisasi Terraform. Anda hanya perlu melakukan ini sekali per direktori.

terraform init

Secara opsional, untuk menggunakan versi penyedia Google terbaru, sertakan opsi

-upgrade:terraform init -upgrade

Menerapkan perubahan

-

Tinjau konfigurasi dan pastikan resource yang akan dibuat atau

diupdate oleh Terraform sesuai yang Anda inginkan:

terraform plan

Koreksi konfigurasi jika diperlukan.

-

Terapkan konfigurasi Terraform dengan menjalankan perintah berikut dan memasukkan

yespada prompt:terraform apply

Tunggu hingga Terraform menampilkan pesan "Apply complete!".

- Buka Google Cloud project Anda untuk melihat hasilnya. Di konsol Google Cloud , buka resource Anda di UI untuk memastikan bahwa Terraform telah membuat atau mengupdatenya.

Memberikan akses ke akun layanan koneksi

Berikan peran Vertex AI Service Agent ke akun layanan koneksi.

Jika Anda berencana menentukan endpoint sebagai URL saat membuat model jarak jauh, misalnya endpoint = 'https://us-central1-aiplatform.googleapis.com/v1/projects/myproject/locations/us-central1/publishers/google/models/gemini-2.0-flash', berikan peran ini di project yang sama dengan yang Anda tentukan di URL.

Jika Anda berencana menentukan endpoint menggunakan nama model saat membuat model jarak jauh, misalnya endpoint = 'gemini-2.0-flash', berikan peran ini di project yang sama tempat Anda berencana membuat model jarak jauh.

Pemberian peran dalam project lain akan menyebabkan error

bqcx-1234567890-wxyz@gcp-sa-bigquery-condel.iam.gserviceaccount.com does not have the permission to access resource.

Untuk memberikan peran, ikuti langkah-langkah berikut:

Konsol

Buka halaman IAM & Admin.

Klik Berikan Akses.

Untuk New principals, masukkan ID akun layanan yang Anda salin sebelumnya.

Klik Pilih peran.

Di Filter, ketik

Vertex AI Service Agent, lalu pilih peran tersebut.Klik Simpan.

gcloud

Gunakan

perintah gcloud projects add-iam-policy-binding:

gcloud projects add-iam-policy-binding 'PROJECT_NUMBER' --member='serviceAccount:MEMBER' --role='roles/aiplatform.serviceAgent' --condition=None

Ganti kode berikut:

PROJECT_NUMBER: nomor project Anda.MEMBER: ID akun layanan yang Anda salin sebelumnya.

Akun layanan yang terkait dengan koneksi Anda adalah instance dari BigQuery Connection Delegation Service Agent, jadi Anda dapat menetapkan peran agen layanan ke akun tersebut.

Membuat model dengan penyesuaian yang diawasi

Di konsol Google Cloud , buka halaman BigQuery.

Di editor kueri, jalankan kueri berikut untuk membuat model jarak jauh:

CREATE OR REPLACE MODEL `PROJECT_ID.DATASET_ID.MODEL_NAME` REMOTE WITH CONNECTION {DEFAULT | `PROJECT_ID.REGION.CONNECTION_ID`} OPTIONS ( ENDPOINT = 'ENDPOINT', MAX_ITERATIONS = MAX_ITERATIONS, LEARNING_RATE_MULTIPLIER = LEARNING_RATE_MULTIPLIER, DATA_SPLIT_METHOD = 'DATA_SPLIT_METHOD', DATA_SPLIT_EVAL_FRACTION = DATA_SPLIT_EVAL_FRACTION, DATA_SPLIT_COL = 'DATA_SPLIT_COL', EVALUATION_TASK = 'EVALUATION_TASK', PROMPT_COL = 'INPUT_PROMPT_COL', INPUT_LABEL_COLS = INPUT_LABEL_COLS) AS SELECT PROMPT_COLUMN, LABEL_COLUMN FROM `TABLE_PROJECT_ID.TABLE_DATASET.TABLE_NAME`;

Ganti kode berikut:

PROJECT_ID: project ID project tempat model akan dibuat.DATASET_ID: ID set data yang akan berisi model. Set data ini harus berada di region Vertex AI yang didukung.MODEL_NAME: nama model.REGION: region yang digunakan oleh koneksi.CONNECTION_ID: ID koneksi BigQuery Anda. Koneksi ini harus berada di lokasi yang sama dengan set data yang Anda gunakan.Saat Anda melihat detail koneksi di konsol Google Cloud , ini adalah nilai di bagian terakhir ID koneksi yang sepenuhnya memenuhi syarat yang ditampilkan di ID Koneksi—misalnya,

projects/myproject/locations/connection_location/connections/myconnection.ENDPOINT: nilaiSTRINGyang menentukan nama model yang akan digunakan.MAX_ITERATIONS: nilaiINT64yang menentukan jumlah langkah yang akan dijalankan untuk penyesuaian yang diawasi. NilaiMAX_ITERATIONSharus berada di antara1dan∞.Model Gemini dilatih menggunakan epoch bukan langkah, sehingga BigQuery ML mengonversi nilai

MAX_ITERATIONSmenjadi epoch. Nilai default untukMAX_ITERATIONSadalah jumlah baris dalam data input, yang setara dengan satu epoch. Untuk menggunakan beberapa epoch, tentukan kelipatan jumlah baris dalam data pelatihan Anda. Misalnya, jika Anda memiliki 100 baris data input dan Anda ingin menggunakan dua epoch, tentukan200untuk nilai argumen. Jika Anda memberikan nilai yang bukan kelipatan jumlah baris dalam data input, BigQuery ML akan membulatkan ke epoch terdekat. Misalnya, jika Anda memiliki 100 baris data input dan Anda menentukan101untuk nilaiMAX_ITERATIONS, pelatihan dilakukan dengan dua iterasi pelatihan.Untuk mengetahui informasi selengkapnya tentang parameter yang digunakan untuk menyesuaikan model Gemini, lihat Membuat tugas penyesuaian.

DATA_SPLIT_METHOD: nilaiSTRINGyang menentukan metode yang digunakan untuk memisahkan data input ke dalam set pelatihan dan evaluasi. Opsi yang valid adalah sebagai berikut:AUTO_SPLIT: BigQuery ML secara otomatis membagi data. Cara data dibagi bervariasi bergantung pada jumlah baris dalam tabel input. Ini adalah nilai defaultnya.RANDOM: data diacak sebelum dibagi menjadi beberapa set. Untuk menyesuaikan pembagian data, Anda dapat menggunakan opsi ini dengan opsiDATA_SPLIT_EVAL_FRACTION.CUSTOM: data dibagi menggunakan kolom yang diberikan dalam opsiDATA_SPLIT_COL. NilaiDATA_SPLIT_COLharus berupa nama kolom berjenisBOOL. Baris dengan nilaiTRUEatauNULLdigunakan sebagai data evaluasi, dan baris dengan nilaiFALSEdigunakan sebagai data pelatihan.SEQ: memisahkan data menggunakan kolom yang diberikan dalam opsiDATA_SPLIT_COL. NilaiDATA_SPLIT_COLharus berupa nama kolom dari salah satu jenis berikut:NUMERICBIGNUMERICSTRINGTIMESTAMP

Data diurutkan dari yang terkecil hingga terbesar berdasarkan kolom yang ditentukan.

n baris pertama digunakan sebagai data evaluasi, dengan n adalah nilai yang ditentukan untuk

DATA_SPLIT_EVAL_FRACTION. Baris yang tersisa digunakan sebagai data pelatihan.NO_SPLIT: tidak ada pemisahan data; semua data input digunakan sebagai data pelatihan.

Untuk mengetahui informasi selengkapnya tentang opsi pemisahan data ini, lihat

DATA_SPLIT_METHOD.DATA_SPLIT_EVAL_FRACTION: nilaiFLOAT64yang menentukan bagian data yang akan digunakan sebagai data evaluasi saat melakukan penyesuaian terawasi. Harus berupa nilai dalam rentang[0, 1.0]. Nilai defaultnya adalah0.2.Gunakan opsi ini jika Anda menentukan

RANDOMatauSEQsebagai nilai untuk opsiDATA_SPLIT_METHOD. Untuk menyesuaikan pemisahan data, Anda dapat menggunakan opsiDATA_SPLIT_METHODdengan opsiDATA_SPLIT_EVAL_FRACTION.DATA_SPLIT_COL: nilaiSTRINGyang menentukan nama kolom yang akan digunakan untuk mengurutkan data input ke dalam set pelatihan atau evaluasi. Gunakan saat Anda menentukanCUSTOMatauSEQsebagai nilai untuk opsiDATA_SPLIT_METHOD.EVALUATION_TASK: nilaiSTRINGyang menentukan jenis tugas yang ingin Anda sesuaikan untuk dilakukan oleh model. Opsi yang valid adalah:TEXT_GENERATIONCLASSIFICATIONSUMMARIZATIONQUESTION_ANSWERINGUNSPECIFIED

Nilai defaultnya adalah

UNSPECIFIED.INPUT_PROMPT_COL: nilaiSTRINGyang berisi nama kolom perintah dalam tabel data pelatihan yang akan digunakan saat melakukan penyesuaian yang diawasi. Nilai defaultnya adalahprompt.INPUT_LABEL_COLS: nilaiARRAY<<STRING>yang berisi nama kolom label dalam tabel data pelatihan yang akan digunakan dalam penyesuaian yang diawasi. Anda hanya dapat menentukan satu elemen dalam array. Nilai defaultnya adalah array kosong. Hal ini menyebabkanlabelmenjadi nilai default argumenLABEL_COLUMN.PROMPT_COLUMN: kolom dalam tabel data pelatihan yang berisi perintah untuk mengevaluasi konten dalam kolomLABEL_COLUMN. Kolom ini harus berjenisSTRINGatau dikonversi keSTRING. Jika Anda menentukan nilai untuk opsiINPUT_PROMPT_COL, Anda harus menentukan nilai yang sama untukPROMPT_COLUMN. Jika tidak, nilai ini harusprompt. Jika tabel Anda tidak memiliki kolomprompt, gunakan alias untuk menentukan kolom tabel yang ada. Misalnya,AS SELECT hint AS prompt, label FROM mydataset.mytable.LABEL_COLUMN: kolom dalam tabel data pelatihan yang berisi contoh untuk melatih model. Kolom ini harus berjenisSTRINGatau dikonversi keSTRING. Jika Anda menentukan nilai untuk opsiINPUT_LABEL_COLS, Anda harus menentukan nilai yang sama untukLABEL_COLUMN. Jika tidak, nilai ini haruslabel. Jika tabel Anda tidak memiliki kolomlabel, gunakan alias untuk menentukan kolom tabel yang ada. Misalnya,AS SELECT prompt, feature AS label FROM mydataset.mytable.TABLE_PROJECT_ID: project ID dari project yang berisi tabel data pelatihan.TABLE_DATASET: nama set data yang berisi tabel data pelatihan.TABLE_NAME: nama tabel yang berisi data yang akan digunakan untuk melatih model.

Mengevaluasi model yang di-tune

Di konsol Google Cloud , buka halaman BigQuery.

Di editor kueri, jalankan kueri berikut untuk mengevaluasi model yang disesuaikan:

SELECT * FROM ML.EVALUATE( MODEL `PROJECT_ID.DATASET_ID.MODEL_NAME`, TABLE `TABLE_PROJECT_ID.TABLE_DATASET.TABLE_NAME`, STRUCT('TASK_TYPE' AS task_type, TOKENS AS max_output_tokens, TEMPERATURE AS temperature, TOP_K AS top_k, TOP_P AS top_p));

Ganti kode berikut:

PROJECT_ID: project ID project yang berisi model.DATASET_ID: ID set data yang berisi model.MODEL_NAME: nama model.TABLE_PROJECT_ID: project ID project yang berisi tabel data evaluasi.TABLE_DATASET: nama set data yang berisi tabel data evaluasi.TABLE_NAME: nama tabel yang berisi data evaluasi.Tabel harus memiliki kolom yang namanya cocok dengan nama kolom perintah yang diberikan selama pelatihan model. Anda dapat memberikan nilai ini menggunakan opsi

prompt_colselama pelatihan model. Jikaprompt_coltidak ditentukan, kolom bernamapromptdalam data pelatihan akan digunakan. Error akan ditampilkan jika tidak ada kolom bernamaprompt.Tabel harus memiliki kolom yang namanya cocok dengan nama kolom label yang diberikan selama pelatihan model. Anda dapat memberikan nilai ini menggunakan opsi

input_label_colsselama pelatihan model. Jikainput_label_colstidak ditentukan, kolom bernamalabeldalam data pelatihan akan digunakan. Error akan ditampilkan jika tidak ada kolom bernamalabel.TASK_TYPE: nilaiSTRINGyang menentukan jenis tugas yang ingin Anda gunakan untuk mengevaluasi model. Opsi yang valid adalah:TEXT_GENERATIONCLASSIFICATIONSUMMARIZATIONQUESTION_ANSWERINGUNSPECIFIED

TOKENS: nilaiINT64yang menetapkan jumlah maksimum token yang dapat dibuat dalam respons. Nilai ini harus dalam rentang[1,1024]. Tentukan nilai yang lebih rendah untuk respons yang lebih singkat dan nilai yang lebih tinggi untuk respons yang lebih panjang. Defaultnya adalah128.TEMPERATURE: nilaiFLOAT64dalam rentang[0.0,1.0]yang mengontrol tingkat keacakan dalam pemilihan token. Defaultnya adalah0.Nilai yang lebih rendah untuk

temperaturecocok untuk prompt yang memerlukan respons yang lebih deterministik dan kurang terbuka atau kreatif, sedangkan nilai yang lebih tinggi untuktemperaturedapat memberikan hasil yang lebih beragam atau kreatif. Nilai0untuktemperaturebersifat deterministik, yang berarti bahwa respons probabilitas tertinggi selalu dipilih.TOP_K: nilaiINT64dalam rentang[1,40]yang menentukan kumpulan awal token yang dipertimbangkan model untuk dipilih. Tentukan nilai yang lebih rendah untuk respons dengan tingkat keacakan lebih rendah, dan nilai yang lebih tinggi untuk respons dengan tingkat keacakan lebih tinggi Defaultnya adalah40.TOP_P: nilaiFLOAT64dalam rentang[0.0,1.0]membantu menentukan token mana dari kumpulan yang ditentukan olehTOP_Kyang dipilih. Tentukan nilai yang lebih rendah untuk respons dengan tingkat keacakan lebih rendah, dan nilai yang lebih tinggi untuk respons dengan tingkat keacakan lebih tinggi Defaultnya adalah0.95.

Buat teks

Buat teks dengan

fungsi ML.GENERATE_TEXT:

Kolom prompt

Buat teks dengan menggunakan kolom tabel untuk menyediakan prompt.

SELECT * FROM ML.GENERATE_TEXT( MODEL `PROJECT_ID.DATASET_ID.MODEL_NAME`, TABLE PROJECT_ID.DATASET_ID.TABLE_NAME, STRUCT(TOKENS AS max_output_tokens, TEMPERATURE AS temperature, TOP_P AS top_p, FLATTEN_JSON AS flatten_json_output, STOP_SEQUENCES AS stop_sequences) );

Ganti kode berikut:

PROJECT_ID: project ID Anda.DATASET_ID: ID set data yang berisi model.MODEL_NAME: nama model.TABLE_NAME: nama tabel yang berisi prompt. Tabel ini harus memiliki kolom yang namanya cocok dengan nama kolom fitur dalam model yang disesuaikan. Nama kolom fitur dalam model dapat ditetapkan menggunakan opsiPROMPT_COLsaat membuat model. Jika tidak, nama kolom fitur dalam model adalahpromptsecara default, atau Anda dapat menggunakan alias untuk menggunakan kolom dengan nama yang berbeda.TOKENS: nilaiINT64yang menetapkan jumlah maksimum token yang dapat dibuat dalam respons. Nilai ini harus dalam rentang[1,8192]. Tentukan nilai yang lebih rendah untuk respons yang lebih singkat dan nilai yang lebih tinggi untuk respons yang lebih panjang. Defaultnya adalah128.TEMPERATURE: nilaiFLOAT64dalam rentang[0.0,1.0]yang mengontrol tingkat keacakan dalam pemilihan token. Defaultnya adalah0.Nilai yang lebih rendah untuk

temperaturecocok untuk prompt yang memerlukan respons yang lebih deterministik dan kurang terbuka atau kreatif, sedangkan nilai yang lebih tinggi untuktemperaturedapat memberikan hasil yang lebih beragam atau kreatif. Nilai0untuktemperaturebersifat deterministik, yang berarti bahwa respons probabilitas tertinggi selalu dipilih.TOP_P: nilaiFLOAT64dalam rentang[0.0,1.0]membantu menentukan probabilitas token yang dipilih. Tentukan nilai yang lebih rendah untuk respons acak yang lebih sedikit dan nilai yang lebih tinggi untuk respons acak yang lebih banyak. Defaultnya adalah0.95.FLATTEN_JSON: nilaiBOOLyang menentukan apakah akan menampilkan teks yang dihasilkan dan atribut keamanan di kolom terpisah. Defaultnya adalahFALSE.STOP_SEQUENCES: nilaiARRAY<STRING>yang menghapus string tertentu jika disertakan dalam respons dari model. String dicocokkan persis, termasuk kapitalisasi. Defaultnya adalah array kosong.GROUND_WITH_GOOGLE_SEARCH: nilaiBOOLyang menentukan apakah model Vertex AI menggunakan Perujukan dengan Google Penelusuran saat membuat respons. Dengan perujukan, model dapat menggunakan informasi tambahan dari internet saat membuat respons, sehingga respons model menjadi lebih spesifik dan faktual. Jikaflatten_json_outputdan kolom ini disetel keTrue, kolomml_generate_text_grounding_resulttambahan akan disertakan dalam hasil, yang memberikan sumber yang digunakan model untuk mengumpulkan informasi tambahan. Defaultnya adalahFALSE.SAFETY_SETTINGS: nilaiARRAY<STRUCT<STRING AS category, STRING AS threshold>>yang mengonfigurasi nilai minimum keamanan konten untuk memfilter respons. Elemen pertama dalam struct menentukan kategori bahaya, dan elemen kedua dalam struct menentukan nilai minimum pemblokiran yang sesuai. Model memfilter konten yang melanggar setelan ini. Anda hanya dapat menentukan setiap kategori satu kali. Misalnya, Anda tidak dapat menentukanSTRUCT('HARM_CATEGORY_DANGEROUS_CONTENT' AS category, 'BLOCK_MEDIUM_AND_ABOVE' AS threshold)danSTRUCT('HARM_CATEGORY_DANGEROUS_CONTENT' AS category, 'BLOCK_ONLY_HIGH' AS threshold). Jika tidak ada setelan keamanan untuk kategori tertentu, setelan keamananBLOCK_MEDIUM_AND_ABOVEakan digunakan.Kategori yang didukung adalah sebagai berikut:

HARM_CATEGORY_HATE_SPEECHHARM_CATEGORY_DANGEROUS_CONTENTHARM_CATEGORY_HARASSMENTHARM_CATEGORY_SEXUALLY_EXPLICIT

Nilai minimum yang didukung adalah sebagai berikut:

BLOCK_NONE(Dibatasi)BLOCK_LOW_AND_ABOVEBLOCK_MEDIUM_AND_ABOVE(Default)BLOCK_ONLY_HIGHHARM_BLOCK_THRESHOLD_UNSPECIFIED

Untuk mengetahui informasi selengkapnya, lihat definisi kategori keamanan dan batas pemblokiran.

REQUEST_TYPE: nilaiSTRINGyang menentukan jenis permintaan inferensi yang akan dikirim ke model Gemini. Jenis permintaan menentukan kuota yang digunakan permintaan. Nilai yang valid adalah sebagai berikut:DEDICATED: FungsiML.GENERATE_TEXThanya menggunakan kuota Throughput yang Disediakan. FungsiML.GENERATE_TEXTmenampilkan errorProvisioned throughput is not purchased or is not activejika kuota Throughput yang Disediakan tidak tersedia.SHARED: FungsiML.GENERATE_TEXThanya menggunakan kuota bersama dinamis (DSQ), meskipun Anda telah membeli kuota Throughput yang Disediakan.UNSPECIFIED: FungsiML.GENERATE_TEXTmenggunakan kuota sebagai berikut:- Jika Anda belum membeli kuota Throughput yang Disediakan,

fungsi

ML.GENERATE_TEXTmenggunakan kuota DSQ. - Jika Anda telah membeli kuota Throughput yang Disediakan,

fungsi

ML.GENERATE_TEXTakan menggunakan kuota Throughput yang Disediakan terlebih dahulu. Jika permintaan melebihi kuota Throughput yang Disediakan, traffic overflow menggunakan kuota DSQ.

- Jika Anda belum membeli kuota Throughput yang Disediakan,

fungsi

Nilai defaultnya adalah

UNSPECIFIED.Untuk mengetahui informasi selengkapnya, lihat Menggunakan Throughput yang Disediakan Vertex AI.

Contoh berikut menunjukkan permintaan dengan karakteristik ini:

- Menggunakan kolom

promptdari tabelpromptsuntuk prompt. - Menampilkan respons singkat dan kemungkinannya sedang.

- Menampilkan teks yang dihasilkan dan atribut keamanan dalam kolom terpisah.

SELECT * FROM ML.GENERATE_TEXT( MODEL `mydataset.mymodel`, TABLE mydataset.prompts, STRUCT( 0.4 AS temperature, 100 AS max_output_tokens, 0.5 AS top_p, TRUE AS flatten_json_output));

Kueri prompt

Buat teks dengan menggunakan kueri untuk menyediakan prompt.

SELECT * FROM ML.GENERATE_TEXT( MODEL `PROJECT_ID.DATASET_ID.MODEL_NAME`, (PROMPT_QUERY), STRUCT(TOKENS AS max_output_tokens, TEMPERATURE AS temperature, TOP_P AS top_p, FLATTEN_JSON AS flatten_json_output, STOP_SEQUENCES AS stop_sequences) );

Ganti kode berikut:

PROJECT_ID: project ID Anda.DATASET_ID: ID set data yang berisi model.MODEL_NAME: nama model.PROMPT_QUERY: kueri yang menyediakan data prompt.TOKENS: nilaiINT64yang menetapkan jumlah maksimum token yang dapat dibuat dalam respons. Nilai ini harus dalam rentang[1,8192]. Tentukan nilai yang lebih rendah untuk respons yang lebih singkat dan nilai yang lebih tinggi untuk respons yang lebih panjang. Defaultnya adalah128.TEMPERATURE: nilaiFLOAT64dalam rentang[0.0,1.0]yang mengontrol tingkat keacakan dalam pemilihan token. Defaultnya adalah0.Nilai yang lebih rendah untuk

temperaturecocok untuk prompt yang memerlukan respons yang lebih deterministik dan kurang terbuka atau kreatif, sedangkan nilai yang lebih tinggi untuktemperaturedapat memberikan hasil yang lebih beragam atau kreatif. Nilai0untuktemperaturebersifat deterministik, yang berarti bahwa respons probabilitas tertinggi selalu dipilih.TOP_P: nilaiFLOAT64dalam rentang[0.0,1.0]membantu menentukan probabilitas token yang dipilih. Tentukan nilai yang lebih rendah untuk respons acak yang lebih sedikit dan nilai yang lebih tinggi untuk respons acak yang lebih banyak. Defaultnya adalah0.95.FLATTEN_JSON: nilaiBOOLyang menentukan apakah akan menampilkan teks yang dihasilkan dan atribut keamanan di kolom terpisah. Defaultnya adalahFALSE.STOP_SEQUENCES: nilaiARRAY<STRING>yang menghapus string tertentu jika disertakan dalam respons dari model. String dicocokkan persis, termasuk kapitalisasi. Defaultnya adalah array kosong.GROUND_WITH_GOOGLE_SEARCH: nilaiBOOLyang menentukan apakah model Vertex AI menggunakan Perujukan dengan Google Penelusuran saat membuat respons. Dengan perujukan, model dapat menggunakan informasi tambahan dari internet saat membuat respons, sehingga respons model menjadi lebih spesifik dan faktual. Jikaflatten_json_outputdan kolom ini disetel keTrue, kolomml_generate_text_grounding_resulttambahan akan disertakan dalam hasil, yang memberikan sumber yang digunakan model untuk mengumpulkan informasi tambahan. Defaultnya adalahFALSE.SAFETY_SETTINGS: nilaiARRAY<STRUCT<STRING AS category, STRING AS threshold>>yang mengonfigurasi nilai minimum keamanan konten untuk memfilter respons. Elemen pertama dalam struct menentukan kategori bahaya, dan elemen kedua dalam struct menentukan nilai minimum pemblokiran yang sesuai. Model memfilter konten yang melanggar setelan ini. Anda hanya dapat menentukan setiap kategori satu kali. Misalnya, Anda tidak dapat menentukanSTRUCT('HARM_CATEGORY_DANGEROUS_CONTENT' AS category, 'BLOCK_MEDIUM_AND_ABOVE' AS threshold)danSTRUCT('HARM_CATEGORY_DANGEROUS_CONTENT' AS category, 'BLOCK_ONLY_HIGH' AS threshold). Jika tidak ada setelan keamanan untuk kategori tertentu, setelan keamananBLOCK_MEDIUM_AND_ABOVEakan digunakan.Kategori yang didukung adalah sebagai berikut:

HARM_CATEGORY_HATE_SPEECHHARM_CATEGORY_DANGEROUS_CONTENTHARM_CATEGORY_HARASSMENTHARM_CATEGORY_SEXUALLY_EXPLICIT

Nilai minimum yang didukung adalah sebagai berikut:

BLOCK_NONE(Dibatasi)BLOCK_LOW_AND_ABOVEBLOCK_MEDIUM_AND_ABOVE(Default)BLOCK_ONLY_HIGHHARM_BLOCK_THRESHOLD_UNSPECIFIED

Untuk mengetahui informasi selengkapnya, lihat definisi kategori keamanan dan batas pemblokiran.

REQUEST_TYPE: nilaiSTRINGyang menentukan jenis permintaan inferensi yang akan dikirim ke model Gemini. Jenis permintaan menentukan kuota yang digunakan permintaan. Nilai yang valid adalah sebagai berikut:DEDICATED: FungsiML.GENERATE_TEXThanya menggunakan kuota Throughput yang Disediakan. FungsiML.GENERATE_TEXTmenampilkan errorProvisioned throughput is not purchased or is not activejika kuota Throughput yang Disediakan tidak tersedia.SHARED: FungsiML.GENERATE_TEXThanya menggunakan kuota bersama dinamis (DSQ), meskipun Anda telah membeli kuota Throughput yang Disediakan.UNSPECIFIED: FungsiML.GENERATE_TEXTmenggunakan kuota sebagai berikut:- Jika Anda belum membeli kuota Throughput yang Disediakan,

fungsi

ML.GENERATE_TEXTmenggunakan kuota DSQ. - Jika Anda telah membeli kuota Throughput yang Disediakan,

fungsi

ML.GENERATE_TEXTakan menggunakan kuota Throughput yang Disediakan terlebih dahulu. Jika permintaan melebihi kuota Throughput yang Disediakan, traffic overflow menggunakan kuota DSQ.

- Jika Anda belum membeli kuota Throughput yang Disediakan,

fungsi

Nilai defaultnya adalah

UNSPECIFIED.Untuk mengetahui informasi selengkapnya, lihat Menggunakan Throughput yang Disediakan Vertex AI.

Contoh 1

Contoh berikut menunjukkan permintaan dengan karakteristik ini:

- Meminta ringkasan teks di kolom

bodypada tabelarticles. - Menampilkan respons yang cukup panjang dan kemungkinannya lebih besar.

- Menampilkan teks yang dihasilkan dan atribut keamanan dalam kolom terpisah.

SELECT * FROM ML.GENERATE_TEXT( MODEL `mydataset.mymodel`, ( SELECT CONCAT('Summarize this text', body) AS prompt FROM mydataset.articles ), STRUCT( 0.2 AS temperature, 650 AS max_output_tokens, 0.2 AS top_p, TRUE AS flatten_json_output));

Contoh 2

Contoh berikut menunjukkan permintaan dengan karakteristik ini:

- Menggunakan kueri untuk membuat data prompt dengan menyambungkan string yang memberikan awalan prompt dengan kolom tabel.

- Menampilkan respons singkat dan kemungkinannya sedang.

- Tidak menampilkan teks yang dihasilkan dan atribut keamanan dalam kolom terpisah.

SELECT * FROM ML.GENERATE_TEXT( MODEL `mydataset.mytuned_model`, ( SELECT CONCAT(question, 'Text:', description, 'Category') AS prompt FROM mydataset.input_table ), STRUCT( 0.4 AS temperature, 100 AS max_output_tokens, 0.5 AS top_p, FALSE AS flatten_json_output));