Générer des embeddings de texte à l'aide de la fonction ML.GENERATE_EMBEDDING

Ce document explique comment créer un modèle distant BigQuery ML faisant référence à un modèle d'embedding. Vous utilisez ensuite ce modèle avec la fonction ML.GENERATE_EMBEDDING pour créer des embeddings de texte à l'aide des données d'une table standard BigQuery.

Les types de modèles à distance suivants sont acceptés :

- Modèles distants basés sur les modèles d'embedding Vertex AI.

- Modèles distants sur les modèles ouverts compatibles (preview).

Rôles requis

Pour créer un modèle à distance et utiliser la fonction ML.GENERATE_EMBEDDING, vous avez besoin des rôles IAM (Identity and Access Management) suivants :

- Créer et utiliser des ensembles de données, des tables et des modèles BigQuery : Éditeur de données BigQuery (

roles/bigquery.dataEditor) sur votre projet. Créer, déléguer et utiliser des connexions BigQuery : administrateur de connexion BigQuery (

roles/bigquery.connectionsAdmin) sur votre projet.Si vous n'avez pas configuré de connexion par défaut, vous pouvez en créer une et la définir lors de l'exécution de l'instruction

CREATE MODEL. Pour ce faire, vous devez disposer du rôle Administrateur BigQuery (roles/bigquery.admin) dans votre projet. Pour en savoir plus, consultez Configurer la connexion par défaut.Accordez des autorisations au compte de service de la connexion : Administrateur IAM du projet (

roles/resourcemanager.projectIamAdmin) sur le projet contenant le point de terminaison Vertex AI. Il s'agit du projet actuel pour les modèles distants que vous créez en spécifiant le nom du modèle comme point de terminaison. Il s'agit du projet identifié dans l'URL des modèles distants que vous créez en spécifiant une URL comme point de terminaison.Créer des jobs BigQuery : rôle Utilisateur de job BigQuery (

roles/bigquery.jobUser) sur votre projet.

Ces rôles prédéfinis contiennent les autorisations requises pour effectuer les tâches décrites dans ce document. Pour afficher les autorisations exactes requises, développez la section Autorisations requises :

Autorisations requises

- Créez un ensemble de données :

bigquery.datasets.create - Créer, déléguer et utiliser une connexion :

bigquery.connections.* - Définissez les autorisations du compte de service :

resourcemanager.projects.getIamPolicyetresourcemanager.projects.setIamPolicy. - Créez un modèle et exécutez l'inférence :

bigquery.jobs.createbigquery.models.createbigquery.models.getDatabigquery.models.updateDatabigquery.models.updateMetadata

- Interroger les données d'une table :

bigquery.tables.getData

Vous pouvez également obtenir ces autorisations avec des rôles personnalisés ou d'autres rôles prédéfinis.

Avant de commencer

-

In the Google Cloud console, on the project selector page, select or create a Google Cloud project.

-

Verify that billing is enabled for your Google Cloud project.

-

Enable the BigQuery, BigQuery Connection, and Vertex AI APIs.

Créer un ensemble de données

Créez un ensemble de données BigQuery pour contenir vos ressources :

Console

Dans la console Google Cloud , accédez à la page BigQuery.

Dans le volet Explorateur, cliquez sur le nom de votre projet.

Cliquez sur Afficher les actions > Créer un ensemble de données.

Sur la page Créer un ensemble de données, procédez comme suit :

Pour ID de l'ensemble de données, saisissez un nom pour l'ensemble de données.

Dans Type d'emplacement, sélectionnez un emplacement pour l'ensemble de données.

Cliquez sur Créer un ensemble de données.

bq

Pour créer un ensemble de données, exécutez la commande

bq mken spécifiant l'option--location:bq --location=LOCATION mk -d DATASET_ID

Remplacez les éléments suivants :

LOCATION: emplacement de l'ensemble de données.DATASET_IDest l'ID de l'ensemble de données que vous créez.

Vérifiez que l'ensemble de données a été créé :

bq ls

Créer une connexion

Vous pouvez ignorer cette étape si vous avez configuré une connexion par défaut ou si vous disposez du rôle Administrateur BigQuery.

Créez une connexion de ressource cloud pour que le modèle distant puisse l'utiliser, et obtenez le compte de service de la connexion. Créez la connexion dans le même emplacement que l'ensemble de données que vous avez créé à l'étape précédente.

Sélectionnez l'une des options suivantes :

Console

Accédez à la page BigQuery.

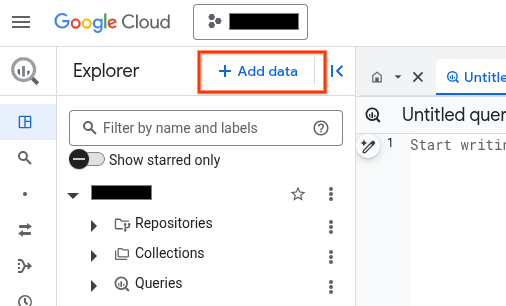

Dans le volet Explorateur, cliquez sur Ajouter des données :

La boîte de dialogue Ajouter des données s'ouvre.

Dans le panneau Filtrer par, dans la section Type de source de données, sélectionnez Applications métier.

Vous pouvez également saisir

Vertex AIdans le champ Rechercher des sources de données.Dans la section Sources de données recommandées, cliquez sur Vertex AI.

Cliquez sur la fiche solution Modèles Vertex AI : fédération BigQuery.

Dans la liste Type de connexion, sélectionnez Modèles distants Vertex AI, fonctions distantes et BigLake (ressource Cloud).

Dans le champ ID de connexion, saisissez un nom pour votre connexion.

Cliquez sur Créer une connexion.

Cliquez sur Accéder à la connexion.

Dans le volet Informations de connexion, copiez l'ID du compte de service à utiliser à l'étape suivante.

bq

Dans un environnement de ligne de commande, créez une connexion :

bq mk --connection --location=REGION --project_id=PROJECT_ID \ --connection_type=CLOUD_RESOURCE CONNECTION_ID

Le paramètre

--project_idremplace le projet par défaut.Remplacez les éléments suivants :

REGION: votre région de connexionPROJECT_ID: ID de votre projet Google CloudCONNECTION_ID: ID de votre connexion

Lorsque vous créez une ressource de connexion, BigQuery crée un compte de service système unique et l'associe à la connexion.

Dépannage : Si vous obtenez l'erreur de connexion suivante, mettez à jour le Google Cloud SDK :

Flags parsing error: flag --connection_type=CLOUD_RESOURCE: value should be one of...

Récupérez et copiez l'ID du compte de service pour l'utiliser lors d'une prochaine étape :

bq show --connection PROJECT_ID.REGION.CONNECTION_ID

Le résultat ressemble à ce qui suit :

name properties 1234.REGION.CONNECTION_ID {"serviceAccountId": "connection-1234-9u56h9@gcp-sa-bigquery-condel.iam.gserviceaccount.com"}

Terraform

Utilisez la ressource google_bigquery_connection.

Pour vous authentifier auprès de BigQuery, configurez le service Identifiants par défaut de l'application. Pour en savoir plus, consultez la page Configurer l'authentification pour les bibliothèques clientes.

L'exemple suivant crée une connexion de ressources Cloud nommée my_cloud_resource_connection dans la région US :

Pour appliquer votre configuration Terraform dans un projet Google Cloud , suivez les procédures des sections suivantes.

Préparer Cloud Shell

- Lancez Cloud Shell.

-

Définissez le projet Google Cloud par défaut dans lequel vous souhaitez appliquer vos configurations Terraform.

Vous n'avez besoin d'exécuter cette commande qu'une seule fois par projet et vous pouvez l'exécuter dans n'importe quel répertoire.

export GOOGLE_CLOUD_PROJECT=PROJECT_ID

Les variables d'environnement sont remplacées si vous définissez des valeurs explicites dans le fichier de configuration Terraform.

Préparer le répertoire

Chaque fichier de configuration Terraform doit avoir son propre répertoire (également appelé module racine).

-

Dans Cloud Shell, créez un répertoire et un nouveau fichier dans ce répertoire. Le nom du fichier doit comporter l'extension

.tf, par exemplemain.tf. Dans ce tutoriel, le fichier est appelémain.tf.mkdir DIRECTORY && cd DIRECTORY && touch main.tf

-

Si vous suivez un tutoriel, vous pouvez copier l'exemple de code dans chaque section ou étape.

Copiez l'exemple de code dans le fichier

main.tfque vous venez de créer.Vous pouvez également copier le code depuis GitHub. Cela est recommandé lorsque l'extrait Terraform fait partie d'une solution de bout en bout.

- Examinez et modifiez les exemples de paramètres à appliquer à votre environnement.

- Enregistrez les modifications.

-

Initialisez Terraform. Cette opération n'est à effectuer qu'une seule fois par répertoire.

terraform init

Vous pouvez également utiliser la dernière version du fournisseur Google en incluant l'option

-upgrade:terraform init -upgrade

Appliquer les modifications

-

Examinez la configuration et vérifiez que les ressources que Terraform va créer ou mettre à jour correspondent à vos attentes :

terraform plan

Corrigez les modifications de la configuration si nécessaire.

-

Appliquez la configuration Terraform en exécutant la commande suivante et en saisissant

yeslorsque vous y êtes invité :terraform apply

Attendez que Terraform affiche le message "Apply completed!" (Application terminée).

- Ouvrez votre projet Google Cloud pour afficher les résultats. Dans la console Google Cloud , accédez à vos ressources dans l'interface utilisateur pour vous assurer que Terraform les a créées ou mises à jour.

Accorder l'accès au compte de service

Attribuez le rôle d'utilisateur Vertex AI au compte de service de la connexion.

Si vous envisagez de spécifier le point de terminaison en tant qu'URL lors de la création du modèle distant (par exemple, endpoint = 'https://us-central1-aiplatform.googleapis.com/v1/projects/myproject/locations/us-central1/publishers/google/models/text-embedding-005'), accordez ce rôle dans le projet que vous spécifiez dans l'URL.

Si vous envisagez de spécifier le point de terminaison à l'aide du nom du modèle lors de la création du modèle distant (par exemple endpoint = 'text-embedding-005'), accordez ce rôle dans le projet dans lequel vous prévoyez de créer le modèle distant.

L'attribution du rôle dans un autre projet génère l'erreur bqcx-1234567890-wxyz@gcp-sa-bigquery-condel.iam.gserviceaccount.com does not have the permission to access resource.

Pour accorder le rôle, procédez comme suit :

Console

Accédez à la page IAM et administration.

Cliquez sur Accorder l'accès.

La boîte de dialogue Ajouter des comptes principaux s'ouvre.

Dans le champ Nouveaux comptes principaux, saisissez l'ID du compte de service que vous avez copié précédemment.

Dans le champ Sélectionner un rôle, sélectionnez Vertex AI, puis Utilisateur Vertex AI.

Cliquez sur Enregistrer.

gcloud

Exécutez la commande gcloud projects add-iam-policy-binding :

gcloud projects add-iam-policy-binding 'PROJECT_NUMBER' --member='serviceAccount:MEMBER' --role='roles/aiplatform.user' --condition=None

Remplacez les éléments suivants :

PROJECT_NUMBER: votre numéro de projetMEMBER: ID du compte de service que vous avez copié précédemment

Déployer un modèle ouvert

Si vous souhaitez utiliser un modèle ouvert compatible, vous devez d'abord le déployer sur Vertex AI. Pour en savoir plus, consultez Déployer des modèles ouverts.

Créer un modèle

Dans la console Google Cloud , accédez à la page BigQuery.

À l'aide de l'éditeur SQL, créez un modèle distant :

CREATE OR REPLACE MODEL `PROJECT_ID.DATASET_ID.MODEL_NAME` REMOTE WITH CONNECTION {DEFAULT | `PROJECT_ID.REGION.CONNECTION_ID`} OPTIONS (ENDPOINT = 'ENDPOINT');

Remplacez les éléments suivants :

PROJECT_ID: ID de votre projet.DATASET_ID: ID de l'ensemble de données pour contenir le modèle.MODEL_NAME: nom du modèleREGION: région utilisée par la connexion.CONNECTION_ID: ID de votre connexion BigQueryLorsque vous affichez les détails de la connexion dans la console Google Cloud , il s'agit de la valeur de la dernière section de l'ID de connexion complet affiché dans ID de connexion (par exemple,

projects/myproject/locations/connection_location/connections/myconnection).ENDPOINT: nom d'un modèle d'embedding à utiliser. Pour en savoir plus sur les versions et les alias de modèles Vertex AI, consultezENDPOINT. Pour en savoir plus sur les modèles ouverts, consultez la page Modèles ouverts compatibles.Le modèle Vertex AI que vous spécifiez doit être disponible dans l'emplacement où vous créez le modèle distant. Pour en savoir plus, consultez Emplacements.

Générer des embeddings textuels

Générez des embeddings de texte à l'aide de la fonction ML.GENERATE_EMBEDDING en utilisant les données textuelles d'une colonne de table ou d'une requête.

En règle générale, vous devez utiliser un modèle d'embedding de texte pour les cas d'utilisation exclusivement basés sur du texte, et un modèle d'embedding multimodal pour les cas d'utilisation de recherche multimodale, où les embeddings pour le texte et le contenu visuel sont générées dans le même espace sémantique.

Vertex AI Text

Générez des embeddings textuels à l'aide d'un modèle distant sur un modèle d'embedding textuel Vertex AI :

SELECT * FROM ML.GENERATE_EMBEDDING( MODEL `PROJECT_ID.DATASET_ID.MODEL_NAME`, {TABLE PROJECT_ID.DATASET_ID.TABLE_NAME | (CONTENT_QUERY)}, STRUCT(FLATTEN_JSON AS flatten_json_output, TASK_TYPE AS task_type, OUTPUT_DIMENSIONALITY AS output_dimensionality) );

Remplacez l'élément suivant :

PROJECT_ID: ID de votre projet.DATASET_ID: ID de l'ensemble de données contenant le modèle.MODEL_NAME: nom du modèle distant sur un modèle d'embedding.TABLE_NAME: nom de la table contenant le texte à intégrer. Cette table doit avoir une colonne nomméecontent. Vous pouvez également utiliser un alias pour utiliser une colonne portant un nom différent.CONTENT_QUERY: requête dont le résultat contient une colonneSTRINGappeléecontent.FLATTEN_JSON:BOOLqui indique s'il faut analyser l'embedding dans une colonne distincte. La valeur par défaut estTRUE.TASK_TYPE: littéral de typeSTRINGqui spécifie l'application en aval prévue pour aider le modèle à produire des embeddings de meilleure qualité.TASK_TYPEaccepte les valeurs suivantes :RETRIEVAL_QUERY: indique que le texte donné est une requête dans un contexte de recherche ou de récupération.RETRIEVAL_DOCUMENT: indique que le texte donné est un document dans un contexte de recherche ou de récupération.Lorsque vous utilisez ce type de tâche, il est utile d'inclure le titre du document dans l'instruction de requête afin d'améliorer la qualité des représentations vectorielles continues. Le titre du document doit se trouver dans une colonne nommée

titleou associée à un aliastitle, par exemple :SELECT * FROM ML.GENERATE_EMBEDDING( MODEL

mydataset.embedding_model, (SELECT abstract as content, header as title, publication_number FROMmydataset.publications), STRUCT(TRUE AS flatten_json_output, 'RETRIEVAL_DOCUMENT' as task_type) );Si vous spécifiez la colonne "title" dans la requête d'entrée, le champ

titledu corps de la requête envoyée au modèle est renseigné. Si vous spécifiez une valeurtitlelorsque vous utilisez un autre type de tâche, cette entrée est ignorée et n'a aucun effet sur les résultats d'embedding.SEMANTIC_SIMILARITY: indique que le texte donné sera utilisé pour la similarité textuelle sémantique (STS).CLASSIFICATION: indique que les embeddings seront utilisés pour la classification.CLUSTERING: indique que les embeddings seront utilisées pour le clustering.QUESTION_ANSWERING: indique que les embeddings seront utilisés pour répondre aux questions.FACT_VERIFICATION: indique que les embeddings seront utilisés pour la vérification de faits.CODE_RETRIEVAL_QUERY: indique que les embeddings seront utilisés pour la récupération de code.

OUTPUT_DIMENSIONALITY: valeurINT64qui spécifie le nombre de dimensions à utiliser lors de la génération d'embeddings. Par exemple, si vous spécifiez256 AS output_dimensionality, la colonne de sortieml_generate_embedding_resultva contenir 256 embeddings pour chaque valeur d'entrée.Pour les modèles distants de plus de

gemini-embedding-001, la valeurOUTPUT_DIMENSIONALITYdoit être comprise dans la plage[1, 3072]. La valeur par défaut est3072. Pour les modèles à distancetext-embeddingoutext-multilingual-embedding, la valeurOUTPUT_DIMENSIONALITYdoit être comprise dans la plage[1, 768]. La valeur par défaut est768.Si vous utilisez un modèle distant sur un modèle

text-embedding, la version du modèletext-embeddingdoit êtretext-embedding-004ou ultérieure. Si vous utilisez un modèle distant sur un modèletext-multilingual-embedding, la version du modèletext-multilingual-embeddingdoit êtretext-multilingual-embedding-002ou ultérieure.

Exemple : intégrer du texte dans un tableau

L'exemple suivant montre une requête d'intégration de la colonne content de la table text_data :

SELECT * FROM ML.GENERATE_EMBEDDING( MODEL `mydataset.embedding_model`, TABLE mydataset.text_data, STRUCT(TRUE AS flatten_json_output, 'CLASSIFICATION' AS task_type) );

Texte

Générez des embeddings textuels à l'aide d'un modèle distant sur un modèle d'embedding ouvert :

SELECT * FROM ML.GENERATE_EMBEDDING( MODEL `PROJECT_ID.DATASET_ID.MODEL_NAME`, {TABLE PROJECT_ID.DATASET_ID.TABLE_NAME | (CONTENT_QUERY)}, STRUCT(FLATTEN_JSON AS flatten_json_output) );

Remplacez l'élément suivant :

PROJECT_ID: ID de votre projet.DATASET_ID: ID de l'ensemble de données contenant le modèle.MODEL_NAME: nom du modèle distant sur un modèle d'embedding.TABLE_NAME: nom de la table contenant le texte à intégrer. Cette table doit avoir une colonne nomméecontent. Vous pouvez également utiliser un alias pour utiliser une colonne portant un nom différent.CONTENT_QUERY: requête dont le résultat contient une colonneSTRINGappeléecontent.FLATTEN_JSON:BOOLqui indique s'il faut analyser l'embedding dans une colonne distincte. La valeur par défaut estTRUE.

Vertex AI multimodal

Générez des embeddings textuels à l'aide d'un modèle distant sur un modèle d'embedding multimodal Vertex AI :

SELECT * FROM ML.GENERATE_EMBEDDING( MODEL `PROJECT_ID.DATASET_ID.MODEL_NAME`, {TABLE PROJECT_ID.DATASET_ID.TABLE_NAME | (CONTENT_QUERY)}, STRUCT(FLATTEN_JSON AS flatten_json_output, OUTPUT_DIMENSIONALITY AS output_dimensionality) );

Remplacez l'élément suivant :

PROJECT_ID: ID de votre projet.DATASET_ID: ID de l'ensemble de données contenant le modèle.MODEL_NAME: nom du modèle distant sur un modèlemultimodalembedding@001.TABLE_NAME: nom de la table contenant le texte à intégrer. Cette table doit avoir une colonne nomméecontent. Vous pouvez également utiliser un alias pour utiliser une colonne portant un nom différent.CONTENT_QUERY: requête dont le résultat contient une colonneSTRINGappeléecontent.FLATTEN_JSON:BOOLqui indique s'il faut analyser l'embedding dans une colonne distincte. La valeur par défaut estTRUE.OUTPUT_DIMENSIONALITY: valeurINT64qui spécifie le nombre de dimensions à utiliser lors de la génération d'embeddings. Les valeurs acceptables sont128,256,512et1408. La valeur par défaut est1408. Par exemple, si vous spécifiez256 AS output_dimensionality, la colonne de sortieml_generate_embedding_resultva contenir 256 embeddings pour chaque valeur d'entrée.

Exemple : utiliser des embeddings pour classer la similarité sémantique

L'exemple suivant intègre une collection d'avis sur des films et les classe par distance de cosinus à l'avis "Ce film était moyen" à l'aide de la fonction VECTOR_SEARCH.

Plus la distance est faible, plus la similarité sémantique est élevée.

Pour en savoir plus sur la recherche vectorielle et l'index vectoriel, consultez Présentation de la recherche vectorielle.

CREATE TEMPORARY TABLE movie_review_embeddings AS ( SELECT * FROM ML.GENERATE_EMBEDDING( MODEL `bqml_tutorial.embedding_model`, ( SELECT "This movie was fantastic" AS content UNION ALL SELECT "This was the best movie I've ever seen!!" AS content UNION ALL SELECT "This movie was just okay..." AS content UNION ALL SELECT "This movie was terrible." AS content ), STRUCT(TRUE AS flatten_json_output) ) ); WITH average_review_embedding AS ( SELECT ml_generate_embedding_result FROM ML.GENERATE_EMBEDDING( MODEL `bqml_tutorial.embedding_model`, (SELECT "This movie was average" AS content), STRUCT(TRUE AS flatten_json_output) ) ) SELECT base.content AS content, distance AS distance_to_average_review FROM VECTOR_SEARCH( TABLE movie_review_embeddings, "ml_generate_embedding_result", (SELECT ml_generate_embedding_result FROM average_review_embedding), distance_type=>"COSINE", top_k=>-1 ) ORDER BY distance_to_average_review;

Le résultat est le suivant :

+------------------------------------------+----------------------------+ | content | distance_to_average_review | +------------------------------------------+----------------------------+ | This movie was just okay... | 0.062789813467745592 | | This movie was fantastic | 0.18579561313064263 | | This movie was terrible. | 0.35707466240930985 | | This was the best movie I've ever seen!! | 0.41844932504542975 | +------------------------------------------+----------------------------+

Étapes suivantes

- Découvrez comment utiliser des embeddings de texte et d'image pour effectuer une recherche sémantique de texte à image.

- Découvrez comment utiliser les embeddings textuels pour la recherche sémantique et la génération augmentée par récupération (RAG).