Gere incorporações de texto com a função ML.GENERATE_EMBEDDING

Este documento mostra como criar um modelo remoto do BigQuery ML que faz referência a um modelo de incorporação. Em seguida, usa esse modelo com a função

ML.GENERATE_EMBEDDING

para criar incorporações de texto com dados de uma

tabela padrão do BigQuery.

São suportados os seguintes tipos de modelos remotos:

- Modelos remotos sobre modelos de incorporação do Vertex AI.

- Modelos remotos sobre modelos abertos suportados (Pré-visualização).

Funções necessárias

Para criar um modelo remoto e usar a função ML.GENERATE_EMBEDDING, precisa das seguintes funções de gestão de identidade e de acesso (IAM):

- Criar e usar conjuntos de dados, tabelas e modelos do BigQuery:

Editor de dados do BigQuery (

roles/bigquery.dataEditor) no seu projeto. Criar, delegar e usar associações do BigQuery: administrador de associações do BigQuery (

roles/bigquery.connectionsAdmin) no seu projeto.Se não tiver uma associação predefinida configurada, pode criar e definir uma como parte da execução da declaração

CREATE MODEL. Para tal, tem de ter a função de administrador do BigQuery (roles/bigquery.admin) no seu projeto. Para mais informações, consulte o artigo Configure a ligação predefinida.Conceda autorizações à conta de serviço da ligação: administrador de IAM do projeto (

roles/resourcemanager.projectIamAdmin) no projeto que contém o ponto final do Vertex AI. Este é o projeto atual para modelos remotos que cria especificando o nome do modelo como um ponto final. Este é o projeto identificado no URL para modelos remotos que cria especificando um URL como ponto final.Criar tarefas do BigQuery: utilizador de tarefas do BigQuery (

roles/bigquery.jobUser) no seu projeto.

Estas funções predefinidas contêm as autorizações necessárias para realizar as tarefas descritas neste documento. Para ver as autorizações exatas necessárias, expanda a secção Autorizações necessárias:

Autorizações necessárias

- Crie um conjunto de dados:

bigquery.datasets.create - Crie, delegue e use uma associação:

bigquery.connections.* - Defina as autorizações da conta de serviço:

resourcemanager.projects.getIamPolicyeresourcemanager.projects.setIamPolicy - Crie um modelo e execute a inferência:

bigquery.jobs.createbigquery.models.createbigquery.models.getDatabigquery.models.updateDatabigquery.models.updateMetadata

- Consultar dados de tabelas:

bigquery.tables.getData

Também pode conseguir estas autorizações com funções personalizadas ou outras funções predefinidas.

Antes de começar

-

In the Google Cloud console, on the project selector page, select or create a Google Cloud project.

Roles required to select or create a project

- Select a project: Selecting a project doesn't require a specific IAM role—you can select any project that you've been granted a role on.

-

Create a project: To create a project, you need the Project Creator

(

roles/resourcemanager.projectCreator), which contains theresourcemanager.projects.createpermission. Learn how to grant roles.

-

Verify that billing is enabled for your Google Cloud project.

-

Enable the BigQuery, BigQuery Connection, and Vertex AI APIs.

Roles required to enable APIs

To enable APIs, you need the Service Usage Admin IAM role (

roles/serviceusage.serviceUsageAdmin), which contains theserviceusage.services.enablepermission. Learn how to grant roles.

Crie um conjunto de dados

Crie um conjunto de dados do BigQuery para conter os seus recursos:

Consola

Na Google Cloud consola, aceda à página BigQuery.

No painel Explorador, clique no nome do projeto.

Clique em Ver ações > Criar conjunto de dados.

Na página Criar conjunto de dados, faça o seguinte:

Para ID do conjunto de dados, escreva um nome para o conjunto de dados.

Para Tipo de localização, selecione uma localização para o conjunto de dados.

Clique em Criar conjunto de dados.

bq

Para criar um novo conjunto de dados, use o comando

bq mkcom a flag--location:bq --location=LOCATION mk -d DATASET_ID

Substitua o seguinte:

LOCATION: a localização do conjunto de dados.DATASET_IDé o ID do conjunto de dados que está a criar.

Confirme que o conjunto de dados foi criado:

bq ls

Crie uma associação

Pode ignorar este passo se tiver uma associação predefinida configurada ou tiver a função de administrador do BigQuery.

Crie uma ligação de recursos da nuvem para o modelo remoto usar e obtenha a conta de serviço da ligação. Crie a associação na mesma localização que o conjunto de dados que criou no passo anterior.

Selecione uma das seguintes opções:

Consola

Aceda à página do BigQuery.

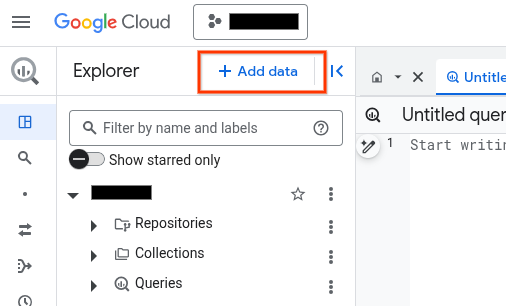

No painel Explorador, clique em Adicionar dados:

É apresentada a caixa de diálogo Adicionar dados.

No painel Filtrar por, na secção Tipo de origem de dados, selecione Aplicações empresariais.

Em alternativa, no campo Pesquisar origens de dados, pode introduzir

Vertex AI.Na secção Origens de dados em destaque, clique em Vertex AI.

Clique no cartão da solução Modelos da Vertex AI: federação do BigQuery.

Na lista Tipo de ligação, selecione Modelos remotos, funções remotas e BigLake (recurso da nuvem) da Vertex AI.

No campo ID da associação, introduza um nome para a associação.

Clique em Criar associação.

Clique em Aceder à associação.

No painel Informações de associação, copie o ID da conta de serviço para utilização num passo posterior.

bq

Num ambiente de linha de comandos, crie uma associação:

bq mk --connection --location=REGION --project_id=PROJECT_ID \ --connection_type=CLOUD_RESOURCE CONNECTION_ID

O parâmetro

--project_idsubstitui o projeto predefinido.Substitua o seguinte:

REGION: a sua região de ligaçãoPROJECT_ID: o ID do seu Google Cloud projetoCONNECTION_ID: um ID para a sua ligação

Quando cria um recurso de ligação, o BigQuery cria uma conta de serviço do sistema única e associa-a à ligação.

Resolução de problemas: se receber o seguinte erro de ligação, atualize o SDK do Google Cloud:

Flags parsing error: flag --connection_type=CLOUD_RESOURCE: value should be one of...

Obtenha e copie o ID da conta de serviço para utilização num passo posterior:

bq show --connection PROJECT_ID.REGION.CONNECTION_ID

O resultado é semelhante ao seguinte:

name properties 1234.REGION.CONNECTION_ID {"serviceAccountId": "connection-1234-9u56h9@gcp-sa-bigquery-condel.iam.gserviceaccount.com"}

Terraform

Use o recurso

google_bigquery_connection.

Para se autenticar no BigQuery, configure as Credenciais padrão da aplicação. Para mais informações, consulte o artigo Configure a autenticação para bibliotecas de cliente.

O exemplo seguinte cria uma associação de recursos da nuvem com o nome

my_cloud_resource_connection na região US:

Para aplicar a configuração do Terraform num Google Cloud projeto, conclua os passos nas secções seguintes.

Prepare o Cloud Shell

- Inicie o Cloud Shell.

-

Defina o Google Cloud projeto predefinido onde quer aplicar as suas configurações do Terraform.

Só tem de executar este comando uma vez por projeto e pode executá-lo em qualquer diretório.

export GOOGLE_CLOUD_PROJECT=PROJECT_ID

As variáveis de ambiente são substituídas se definir valores explícitos no ficheiro de configuração do Terraform.

Prepare o diretório

Cada ficheiro de configuração do Terraform tem de ter o seu próprio diretório (também denominado módulo raiz).

-

No Cloud Shell, crie um diretório e um novo ficheiro nesse diretório. O nome do ficheiro tem de ter a extensão

.tf, por exemplo,main.tf. Neste tutorial, o ficheiro é denominadomain.tf.mkdir DIRECTORY && cd DIRECTORY && touch main.tf

-

Se estiver a seguir um tutorial, pode copiar o código de exemplo em cada secção ou passo.

Copie o exemplo de código para o ficheiro

main.tfcriado recentemente.Opcionalmente, copie o código do GitHub. Isto é recomendado quando o fragmento do Terraform faz parte de uma solução completa.

- Reveja e modifique os parâmetros de exemplo para aplicar ao seu ambiente.

- Guarde as alterações.

-

Inicialize o Terraform. Só tem de fazer isto uma vez por diretório.

terraform init

Opcionalmente, para usar a versão mais recente do fornecedor Google, inclua a opção

-upgrade:terraform init -upgrade

Aplique as alterações

-

Reveja a configuração e verifique se os recursos que o Terraform vai criar ou

atualizar correspondem às suas expetativas:

terraform plan

Faça as correções necessárias à configuração.

-

Aplique a configuração do Terraform executando o seguinte comando e introduzindo

yesno comando:terraform apply

Aguarde até que o Terraform apresente a mensagem "Apply complete!" (Aplicação concluída!).

- Abra o seu Google Cloud projeto para ver os resultados. Na Google Cloud consola, navegue para os seus recursos na IU para se certificar de que o Terraform os criou ou atualizou.

Conceda acesso à conta de serviço

Conceda à conta de serviço da ligação a função de utilizador do Vertex AI.

Se planeia especificar o ponto final como um URL quando criar o modelo remoto,

por exemplo

endpoint = 'https://us-central1-aiplatform.googleapis.com/v1/projects/myproject/locations/us-central1/publishers/google/models/text-embedding-005',

conceda esta função no mesmo projeto que especificar no URL.

Se planear especificar o ponto final através do nome do modelo quando criar o modelo remoto, por exemplo, endpoint = 'text-embedding-005', conceda esta função no mesmo projeto onde planeia criar o modelo remoto.

A concessão da função num projeto diferente resulta no erro

bqcx-1234567890-wxyz@gcp-sa-bigquery-condel.iam.gserviceaccount.com does not have the permission to access resource.

Para conceder a função, siga estes passos:

Consola

Aceda à página IAM e administrador.

Clique em Conceder acesso.

É apresentada a caixa de diálogo Adicionar responsáveis.

No campo Novos membros, introduza o ID da conta de serviço que copiou anteriormente.

No campo Selecionar uma função, selecione Vertex AI e, de seguida, selecione Utilizador da Vertex AI.

Clique em Guardar.

gcloud

Use o comando

gcloud projects add-iam-policy-binding:

gcloud projects add-iam-policy-binding 'PROJECT_NUMBER' --member='serviceAccount:MEMBER' --role='roles/aiplatform.user' --condition=None

Substitua o seguinte:

PROJECT_NUMBER: o número do seu projetoMEMBER: o ID da conta de serviço que copiou anteriormente

Implemente um modelo aberto

Se quiser usar um modelo aberto suportado, tem de implementar primeiro esse modelo no Vertex AI. Para mais informações sobre como o fazer, consulte o artigo Implemente modelos abertos.

Criar um modelo

Na Google Cloud consola, aceda à página BigQuery.

Usando o editor de SQL, crie um modelo remoto:

CREATE OR REPLACE MODEL `PROJECT_ID.DATASET_ID.MODEL_NAME` REMOTE WITH CONNECTION {DEFAULT | `PROJECT_ID.REGION.CONNECTION_ID`} OPTIONS (ENDPOINT = 'ENDPOINT');

Substitua o seguinte:

PROJECT_ID: o ID do seu projetoDATASET_ID: o ID do conjunto de dados que vai conter o modeloMODEL_NAME: o nome do modeloREGION: a região usada pela ligação.CONNECTION_ID: o ID da sua ligação ao BigQueryQuando vê os detalhes da associação na consola Google Cloud , este é o valor na última secção do ID da associação totalmente qualificado que é apresentado em ID da associação, por exemplo

projects/myproject/locations/connection_location/connections/myconnectionENDPOINT: o nome de um modelo de incorporação a usar. Para mais informações sobre as versões e os alias dos modelos do Vertex AI, consulte o artigoENDPOINT. Para mais informações sobre modelos abertos, consulte os modelos abertos suportados.O modelo do Vertex AI que especificar tem de estar disponível na localização onde está a criar o modelo remoto. Para mais informações, consulte o artigo Localizações.

Gere incorporações de texto

Gere incorporações de texto com a função ML.GENERATE_EMBEDDING usando dados de texto de uma coluna de tabela ou uma consulta.

Normalmente, usaria um modelo de incorporação de texto para exemplos de utilização apenas de texto e um modelo de incorporação multimodal para exemplos de utilização de pesquisa intermodal, em que as incorporações de texto e conteúdo visual são geradas no mesmo espaço semântico.

Vertex AI text

Gere incorporações de texto usando um modelo remoto através de um modelo de incorporação de texto do Vertex AI:

SELECT * FROM ML.GENERATE_EMBEDDING( MODEL `PROJECT_ID.DATASET_ID.MODEL_NAME`, {TABLE PROJECT_ID.DATASET_ID.TABLE_NAME | (CONTENT_QUERY)}, STRUCT(FLATTEN_JSON AS flatten_json_output, TASK_TYPE AS task_type, OUTPUT_DIMENSIONALITY AS output_dimensionality) );

Substitua o seguinte:

PROJECT_ID: o ID do seu projeto.DATASET_ID: o ID do conjunto de dados que contém o modelo.MODEL_NAME: o nome do modelo remoto sobre um modelo de incorporação.TABLE_NAME: o nome da tabela que contém o texto a incorporar. Esta tabela tem de ter uma coluna com o nomecontentou pode usar um alias para usar uma coluna com um nome diferente.CONTENT_QUERY: uma consulta cujo resultado contém uma colunaSTRINGdenominadacontent.FLATTEN_JSON: um valorBOOLque indica se a incorporação deve ser analisada numa coluna separada. O valor predefinido éTRUE.TASK_TYPE: um literalSTRINGque especifica a aplicação a jusante pretendida para ajudar o modelo a produzir incorporações de melhor qualidade.TASK_TYPEaceita os seguintes valores:RETRIEVAL_QUERY: especifica que o texto fornecido é uma consulta numa definição de pesquisa ou obtenção.RETRIEVAL_DOCUMENT: especifica que o texto fornecido é um documento numa definição de pesquisa ou obtenção.Quando usar este tipo de tarefa, é útil incluir o título do documento na declaração de consulta para melhorar a qualidade da incorporação. O título do documento tem de estar numa coluna com o nome

titleou com o aliastitle, por exemplo:SELECT * FROM ML.GENERATE_EMBEDDING( MODEL

mydataset.embedding_model, (SELECT abstract as content, header as title, publication_number FROMmydataset.publications), STRUCT(TRUE AS flatten_json_output, 'RETRIEVAL_DOCUMENT' as task_type) );A especificação da coluna de título na consulta de entrada preenche o campo

titledo corpo do pedido enviado para o modelo. Se especificar um valortitlequando usar qualquer outro tipo de tarefa, essa entrada é ignorada e não tem qualquer efeito nos resultados da incorporação.SEMANTIC_SIMILARITY: especifica que o texto fornecido vai ser usado para a similaridade textual semântica (STS).CLASSIFICATION: especifica que as incorporações vão ser usadas para a classificação.CLUSTERING: especifica que as incorporações vão ser usadas para o agrupamento.QUESTION_ANSWERING: especifica que as incorporações vão ser usadas para responder a perguntas.FACT_VERIFICATION: especifica que as incorporações vão ser usadas para a validação de factos.CODE_RETRIEVAL_QUERY: especifica que as incorporações vão ser usadas para obtenção de código.

OUTPUT_DIMENSIONALITY: um valorINT64que especifica o número de dimensões a usar ao gerar incorporações. Por exemplo, se especificar256 AS output_dimensionality, a coluna de saídaml_generate_embedding_resultcontém 256 incorporações para cada valor de entrada.Para modelos remotos com mais de

gemini-embedding-001modelos, o valorOUTPUT_DIMENSIONALITYtem de estar no intervalo[1, 3072]. O valor predefinido é3072. Para modelos remotos com mais detext-embeddingoutext-multilingual-embedding, o valorOUTPUT_DIMENSIONALITYtem de estar no intervalo[1, 768]. O valor predefinido é768.Se estiver a usar um modelo remoto num modelo

text-embedding, a versão do modelotext-embeddingtem de sertext-embedding-004ou posterior. Se estiver a usar um modelo remoto através de um modelotext-multilingual-embedding, a versão do modelotext-multilingual-embeddingtem de sertext-multilingual-embedding-002ou posterior.

Exemplo: incorporar texto numa tabela

O exemplo seguinte mostra um pedido para incorporar a coluna content da tabela text_data:

SELECT * FROM ML.GENERATE_EMBEDDING( MODEL `mydataset.embedding_model`, TABLE mydataset.text_data, STRUCT(TRUE AS flatten_json_output, 'CLASSIFICATION' AS task_type) );

Texto livre

Gere incorporações de texto usando um modelo remoto através de um modelo de incorporação aberto:

SELECT * FROM ML.GENERATE_EMBEDDING( MODEL `PROJECT_ID.DATASET_ID.MODEL_NAME`, {TABLE PROJECT_ID.DATASET_ID.TABLE_NAME | (CONTENT_QUERY)}, STRUCT(FLATTEN_JSON AS flatten_json_output) );

Substitua o seguinte:

PROJECT_ID: o ID do seu projeto.DATASET_ID: o ID do conjunto de dados que contém o modelo.MODEL_NAME: o nome do modelo remoto sobre um modelo de incorporação.TABLE_NAME: o nome da tabela que contém o texto a incorporar. Esta tabela tem de ter uma coluna com o nomecontentou pode usar um alias para usar uma coluna com um nome diferente.CONTENT_QUERY: uma consulta cujo resultado contém uma colunaSTRINGdenominadacontent.FLATTEN_JSON: um valorBOOLque indica se deve analisar a incorporação numa coluna separada. O valor predefinido éTRUE.

Vertex AI multimodal

Gere incorporações de texto usando um modelo remoto através de um modelo de incorporação multimodal do Vertex AI:

SELECT * FROM ML.GENERATE_EMBEDDING( MODEL `PROJECT_ID.DATASET_ID.MODEL_NAME`, {TABLE PROJECT_ID.DATASET_ID.TABLE_NAME | (CONTENT_QUERY)}, STRUCT(FLATTEN_JSON AS flatten_json_output, OUTPUT_DIMENSIONALITY AS output_dimensionality) );

Substitua o seguinte:

PROJECT_ID: o ID do seu projeto.DATASET_ID: o ID do conjunto de dados que contém o modelo.MODEL_NAME: o nome do modelo remoto sobre um modelomultimodalembedding@001.TABLE_NAME: o nome da tabela que contém o texto a incorporar. Esta tabela tem de ter uma coluna com o nomecontentou pode usar um alias para usar uma coluna com um nome diferente.CONTENT_QUERY: uma consulta cujo resultado contém uma colunaSTRINGdenominadacontent.FLATTEN_JSON: umBOOLque indica se a incorporação deve ser analisada numa coluna separada. O valor predefinido éTRUE.OUTPUT_DIMENSIONALITY: um valorINT64que especifica o número de dimensões a usar ao gerar incorporações. Os valores válidos são128,256,512e1408. O valor predefinido é1408. Por exemplo, se especificar256 AS output_dimensionality, a coluna de saídaml_generate_embedding_resultcontém 256 incorporações para cada valor de entrada.

Exemplo: use incorporações para classificar a semelhança semântica

O exemplo seguinte incorpora uma coleção de críticas de filmes e ordena-as pela distância de cossenos da crítica "Este filme foi mediano" através da função VECTOR_SEARCH.

Uma distância mais pequena indica uma maior semelhança semântica.

Para mais informações sobre a pesquisa vetorial e o índice vetorial, consulte o artigo Introdução à pesquisa vetorial.

CREATE TEMPORARY TABLE movie_review_embeddings AS ( SELECT * FROM ML.GENERATE_EMBEDDING( MODEL `bqml_tutorial.embedding_model`, ( SELECT "This movie was fantastic" AS content UNION ALL SELECT "This was the best movie I've ever seen!!" AS content UNION ALL SELECT "This movie was just okay..." AS content UNION ALL SELECT "This movie was terrible." AS content ), STRUCT(TRUE AS flatten_json_output) ) ); WITH average_review_embedding AS ( SELECT ml_generate_embedding_result FROM ML.GENERATE_EMBEDDING( MODEL `bqml_tutorial.embedding_model`, (SELECT "This movie was average" AS content), STRUCT(TRUE AS flatten_json_output) ) ) SELECT base.content AS content, distance AS distance_to_average_review FROM VECTOR_SEARCH( TABLE movie_review_embeddings, "ml_generate_embedding_result", (SELECT ml_generate_embedding_result FROM average_review_embedding), distance_type=>"COSINE", top_k=>-1 ) ORDER BY distance_to_average_review;

O resultado é o seguinte:

+------------------------------------------+----------------------------+ | content | distance_to_average_review | +------------------------------------------+----------------------------+ | This movie was just okay... | 0.062789813467745592 | | This movie was fantastic | 0.18579561313064263 | | This movie was terrible. | 0.35707466240930985 | | This was the best movie I've ever seen!! | 0.41844932504542975 | +------------------------------------------+----------------------------+

O que se segue?

- Saiba como usar incorporações de texto e imagens para realizar uma pesquisa semântica de texto para imagem.

- Saiba como usar incorporações de texto para pesquisa semântica e geração aumentada de recuperação (RAG).