En este tutorial, registrarás un endpoint de Vertex AI como modelo remoto en BigQuery. A continuación, usa la función ML.PREDICT para hacer predicciones con el modelo remoto.

Puedes usar modelos remotos cuando un modelo sea demasiado grande para importarlo a BigQuery. También son útiles cuando quieres tener un único punto de inferencia para los casos prácticos online, por lotes y por microlotes.

Importar el modelo al registro de modelos de Vertex AI

En este tutorial, usarás un modelo de TensorFlow preentrenado que está disponible en Cloud Storage en gs://cloud-samples-data/bigquery/ml/remote_model_tutorial/. El segmento de Cloud Storage se encuentra en la ubicación multirregional US.

El modelo es un modelo de TensorFlow llamado saved_model.pb. Se trata de un modelo de análisis de sentimiento personalizado que se ha creado perfeccionando un modelo BERT con reseñas de películas de IMDb en texto sin formato. El modelo usa texto de las reseñas de películas y devuelve puntuaciones de sentimiento entre cero y uno. Cuando importas el modelo en Model Registry, usas un contenedor de TensorFlow precompilado.

Sigue estos pasos para importar el modelo.

En la Google Cloud consola, ve a la página Registro de modelos de Vertex AI.

Haz clic en Importar.

En Paso 1: Nombre y región, haz lo siguiente:

Selecciona Importar como modelo nuevo.

En Nombre, escribe

bert_sentiment.En Descripción, escriba

BQML tutorial model.En Región, selecciona

us-central1. Debes elegir una región de EE. UU. porque el segmento de Cloud Storage está en la ubicación multirregionalUS.Haz clic en Continuar.

En el paso 2: Configuración del modelo, haga lo siguiente:

Selecciona Importar artefactos del modelo a un contenedor predefinido nuevo.

En la sección Configuración del contenedor precompilado, haga lo siguiente:

En Framework del modelo, elige TensorFlow.

En Versión del framework del modelo, elija 2.15.

En Tipo de acelerador, elige GPU.

En Ubicación del artefacto del modelo, introduce

gs://cloud-samples-data/bigquery/ml/remote_model_tutorial/.Deja los valores predeterminados de todas las opciones restantes y haz clic en Importar.

Una vez que se haya completado la importación, el modelo aparecerá en la página Registro de modelos.

Desplegar el modelo en un endpoint de Vertex AI

Sigue estos pasos para implementar el modelo en un endpoint.

En la consola, ve a la página Registro de modelos de Vertex AI. Google Cloud

En la columna Nombre, haga clic en

bert_sentiment.Haz clic en la pestaña Implementar y probar.

Haz clic en Implementar en endpoint.

En el paso 1, Define tu endpoint, haz lo siguiente:

Haz clic en Crear endpoint.

En Endpoint name (Nombre del endpoint), introduce

bert sentiment endpoint.Deja los valores predeterminados restantes y haz clic en Continuar.

En el paso dos, Configuración del modelo, haga lo siguiente:

En la sección Configuración de los recursos de computación, en Número mínimo de nodos de computación, introduce

1. Es el número de nodos que deben estar disponibles para el modelo en todo momento.En la sección Opciones avanzadas de escalado, en Tipo de máquina, elige Estándar (n1-standard-2). Como has elegido GPU como tipo de acelerador al importar el modelo, después de elegir el tipo de máquina, el tipo y el número de aceleradores se definen automáticamente.

Deja los valores predeterminados restantes y haz clic en Desplegar.

Cuando el modelo se despliega en el endpoint, el estado cambia a

Active.Copia el ID de endpoint numérico de la columna ID y el valor de la columna Región. Los necesitarás más adelante.

Crear conjunto de datos

Crea un conjunto de datos de BigQuery para almacenar tu modelo de aprendizaje automático.

Consola

En la Google Cloud consola, ve a la página BigQuery.

En el panel Explorador, haz clic en el nombre de tu proyecto.

Haga clic en Ver acciones > Crear conjunto de datos.

En la página Crear conjunto de datos, haz lo siguiente:

En ID del conjunto de datos, introduce

bqml_tutorial.En Tipo de ubicación, selecciona Multirregión y, a continuación, EE. UU. (varias regiones de Estados Unidos).

Deje el resto de los ajustes predeterminados como están y haga clic en Crear conjunto de datos.

bq

Para crear un conjunto de datos, usa el comando

bq mk

con la marca --location. Para ver una lista completa de los parámetros posibles, consulta la referencia del comando bq mk --dataset.

Crea un conjunto de datos llamado

bqml_tutorialcon la ubicación de los datos definida comoUSy la descripciónBigQuery ML tutorial dataset:bq --location=US mk -d \ --description "BigQuery ML tutorial dataset." \ bqml_tutorial

En lugar de usar la marca

--dataset, el comando usa el acceso directo-d. Si omite-dy--dataset, el comando creará un conjunto de datos de forma predeterminada.Confirma que se ha creado el conjunto de datos:

bq ls

API

Llama al método datasets.insert con un recurso de conjunto de datos definido.

{ "datasetReference": { "datasetId": "bqml_tutorial" } }

BigQuery DataFrames

Antes de probar este ejemplo, sigue las instrucciones de configuración de BigQuery DataFrames que se indican en la guía de inicio rápido de BigQuery con BigQuery DataFrames. Para obtener más información, consulta la documentación de referencia de los DataFrames de BigQuery.

Para autenticarte en BigQuery, configura las credenciales predeterminadas de la aplicación. Para obtener más información, consulta Configurar ADC en un entorno de desarrollo local.

Crear una conexión de recursos de Cloud de BigQuery

Debes tener una conexión de recursos de Cloud para conectarte a un endpoint de Vertex AI.

Consola

Ve a la página BigQuery.

En el panel de la izquierda, haz clic en Explorador:

Si no ves el panel de la izquierda, haz clic en Ampliar panel de la izquierda para abrirlo.

En el panel Explorador, haz clic en Añadir datos.

Se abrirá el cuadro de diálogo Añadir datos.

En el panel Filtrar por, en la sección Tipo de fuente de datos, selecciona Bases de datos.

También puede introducir

Vertex AIen el campo Buscar fuentes de datos.En la sección Fuentes de datos destacadas, haga clic en Vertex AI.

Haz clic en la tarjeta de solución Modelos de Vertex AI: federación de BigQuery.

En la lista Tipo de conexión, selecciona Modelos remotos de Vertex AI, funciones remotas y BigLake (recurso de Cloud).

En el campo ID de conexión, introduce

bqml_tutorial.Comprueba que esté seleccionada la opción Multirregión (EE. UU.).

Haga clic en Crear conexión.

En la parte inferior de la ventana, haz clic en Ir a la conexión. También puedes hacer clic en Conexiones en el panel Explorador y, a continuación, en

us.bqml_tutorial.En el panel Información de conexión, copia el ID de la cuenta de servicio. Necesitarás este ID cuando configures los permisos de la conexión. Cuando creas un recurso de conexión, BigQuery crea una cuenta de servicio del sistema única y la asocia a la conexión.

bq

Para crear una conexión, sigue estos pasos:

bq mk --connection --location=US --project_id=PROJECT_ID \ --connection_type=CLOUD_RESOURCE bqml_tutorial

Sustituye

PROJECT_IDpor elGoogle Cloud ID de tu proyecto. El parámetro--project_idanula el proyecto predeterminado.Cuando creas un recurso de conexión, BigQuery crea una cuenta de servicio del sistema única y la asocia a la conexión.

Solución de problemas: si aparece el siguiente error de conexión, actualiza el SDK de Google Cloud:

Flags parsing error: flag --connection_type=CLOUD_RESOURCE: value should be one of...

Obtén y copia el ID de la cuenta de servicio para usarlo en un paso posterior:

bq show --connection PROJECT_ID.us.bqml_tutorial

El resultado debería ser similar al siguiente:

name properties 1234.REGION.CONNECTION_ID {"serviceAccountId": "connection-1234-9u56h9@gcp-sa-bigquery-condel.iam.gserviceaccount.com"}

Configurar el acceso a la conexión

Asigna el rol Usuario de Vertex AI a la cuenta de servicio de la conexión de recursos de Cloud. Debes conceder este rol en el mismo proyecto en el que has creado el endpoint del modelo remoto.

Para conceder el rol, sigue estos pasos:

Ve a la página IAM y administración.

Haz clic en Conceder acceso.

En el campo Nuevos principales, introduce el ID de cuenta de servicio de la conexión de recursos de Cloud que has copiado anteriormente.

En el campo Selecciona un rol, elige Vertex AI y, a continuación, selecciona Usuario de Vertex AI.

Haz clic en Guardar.

Crear un modelo remoto de BigQuery ML

Para crear un modelo remoto de BigQuery ML, debes usar la instrucción CREATE MODEL

con la cláusula REMOTE WITH CONNECTION. Para obtener más información sobre la instrucción CREATE MODEL, consulte Instrucción CREATE MODEL para modelos remotos sobre modelos personalizados.

Crea el modelo en la ubicación US multirregional. En un conjunto de datos multirregional de BigQuery (US, EU), solo puedes crear un modelo remoto que se conecte a un endpoint implementado en una región que esté en la misma ubicación multirregional (US, EU).

Cuando crees el modelo remoto, necesitarás el ID del endpoint que se generó al desplegar el modelo en Vertex AI. Además, los nombres y los tipos de los campos de entrada y salida deben ser exactamente los mismos que los de entrada y salida del modelo de Vertex AI. En este ejemplo, la entrada es un texto STRING y la salida es un ARRAY de tipo FLOAT64.

Consola

En la Google Cloud consola, ve a la página BigQuery.

En Crear nuevo, haz clic en Consulta de SQL.

En el editor de consultas, introduce esta instrucción

CREATE MODELy, a continuación, haz clic en Ejecutar:CREATE OR REPLACE MODEL `PROJECT_ID.bqml_tutorial.bert_sentiment` INPUT (text STRING) OUTPUT(scores ARRAY<FLOAT64>) REMOTE WITH CONNECTION `PROJECT_ID.us.bqml_tutorial` OPTIONS(ENDPOINT = 'https://us-central1-aiplatform.googleapis.com/v1/projects/PROJECT_ID/locations/us-central1/endpoints/ENDPOINT_ID')

Haz los cambios siguientes:

- PROJECT_ID: el nombre de tu proyecto.

- ENDPOINT_ID: el ID de endpoint que has copiado anteriormente.

Cuando la operación se haya completado, verás un mensaje similar a este:

Successfully created model named bert_sentiment.El nuevo modelo aparecerá en el panel Recursos. Los modelos se indican con el icono de modelo:

.

.Si seleccionas el nuevo modelo en el panel Recursos, la información sobre el modelo aparecerá debajo del Editor de consultas.

bq

Crea el modelo remoto introduciendo la siguiente

CREATE MODELdeclaración:bq query --use_legacy_sql=false \ "CREATE OR REPLACE MODEL `PROJECT_ID.bqml_tutorial.bert_sentiment` INPUT (text STRING) OUTPUT(scores ARRAY<FLOAT64>) REMOTE WITH CONNECTION `PROJECT_ID.us.bqml_tutorial` OPTIONS(ENDPOINT = 'https://us-central1-aiplatform.googleapis.com/v1/projects/PROJECT_ID/locations/us-central1/endpoints/ENDPOINT_ID')"

Haz los cambios siguientes:

- PROJECT_ID: el nombre de tu proyecto.

- ENDPOINT_ID: el ID de endpoint que has copiado anteriormente.

Después de crear el modelo, comprueba que aparece en el conjunto de datos:

bq ls -m bqml_tutorial

El resultado debería ser similar al siguiente:

Id Model Type Labels Creation Time ---------------- ------------ -------- ----------------- bert_sentiment 28 Jan 17:39:43

Obtener predicciones con ML.PREDICT

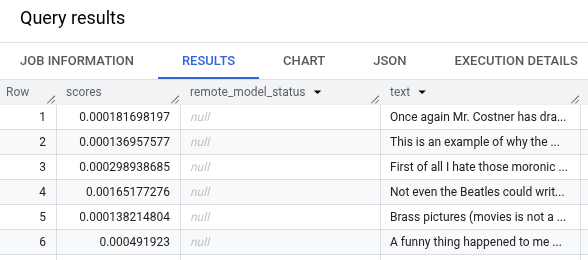

Usa la función ML.PREDICT para obtener predicciones de sentimiento del modelo remoto. La entrada es una columna de texto (review) que contiene reseñas de películas de la tabla bigquery-public-data.imdb.reviews.

En este ejemplo, se seleccionan 10.000 registros y se envían para obtener una predicción. El modelo remoto tiene un tamaño de lote predeterminado de 128 instancias para las solicitudes.

Consola

En la Google Cloud consola, ve a la página BigQuery.

En la sección Crear nuevo, haz clic en Consulta de SQL.

En el editor de consultas, introduce esta consulta que usa la función

ML.PREDICTy, a continuación, haz clic en Ejecutar.SELECT * FROM ML.PREDICT ( MODEL `PROJECT_ID.bqml_tutorial.bert_sentiment`, ( SELECT review as text FROM `bigquery-public-data.imdb.reviews` LIMIT 10000 ) )

Los resultados de la consulta deberían ser similares a los siguientes:

bq

Introduce este comando para ejecutar la consulta que usa ML.PREDICT.

bq query --use_legacy_sql=false \ 'SELECT * FROM ML.PREDICT ( MODEL `PROJECT_ID.bqml_tutorial.bert_sentiment`, ( SELECT review as text FROM `bigquery-public-data.imdb.reviews` LIMIT 10000 ) )'