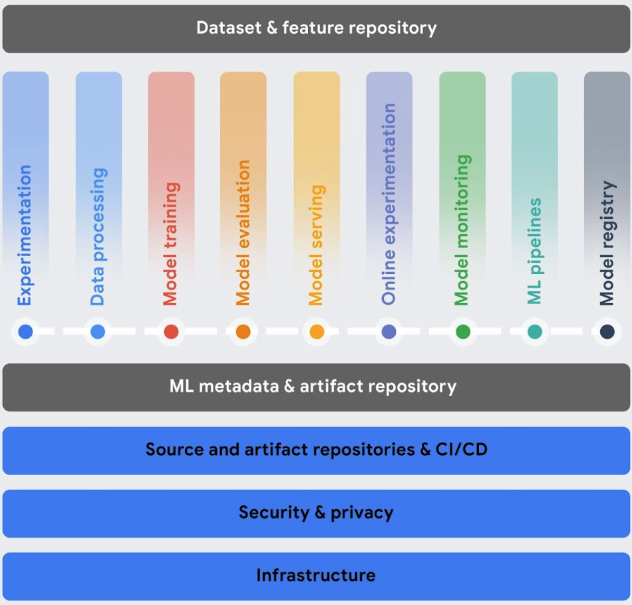

Cette section décrit les services Vertex AI qui vous aident à implémenter des opérations de machine learning (MLOps) dans le cadre de votre workflow de machine learning (ML).

Une fois vos modèles déployés, ils doivent suivre le changement des données dans l'environnement pour optimiser leurs performances et rester pertinents. Le MLOps est un ensemble de pratiques qui améliore la stabilité et la fiabilité de vos systèmes de ML.

Les outils MLOps de Vertex AI facilitent la collaboration entre les équipes d'IA et l'amélioration de vos modèles grâce à une surveillance prédictive, des alertes, des diagnostics et des explications exploitables. Tous les outils sont modulaires. Vous pouvez donc les intégrer dans vos systèmes existants si nécessaire.

Pour en savoir plus sur le MLOps, consultez la page Pipelines de livraison continue et d'automatisation dans le machine learning et le Guide des professionnels du MLOps.

Orchestrer des workflows : entraîner et diffuser manuellement vos modèles peut être chronophages et sources d'erreurs, en particulier si vous devez répéter les processus plusieurs fois.

- Vertex AI Pipelines vous permet d'automatiser, de surveiller et de gérer vos workflows de ML.

Suivre les métadonnées utilisées dans votre système de ML : en data science, il est important de suivre les paramètres, les artefacts et les métriques utilisés dans votre workflow de ML, en particulier lorsque vous répétez le workflow plusieurs fois.

- Vertex ML Metadata vous permet d'enregistrer les métadonnées, les paramètres et les artefacts utilisés dans votre système de ML. Vous pouvez ensuite interroger ces métadonnées pour analyser, déboguer et auditer les performances de votre système de ML ou des artefacts qu'il produit.

Identifier le meilleur modèle pour un cas d'utilisation : lorsque vous essayez de nouveaux algorithmes d'entraînement, vous devez savoir quel modèle entraîné fonctionne le mieux.

Vertex AI Experiments vous permet de suivre et d'analyser différents architectures de modèles, hyperparamètres et environnements d'entraînement pour identifier le meilleur modèle pour votre cas d'utilisation.

Vertex AI TensorBoard vous permet de suivre, de visualiser et de comparer les expériences de ML pour mesurer les performances de vos modèles.

Gérer les versions de modèles : l'ajout de modèles à un dépôt central vous permet de suivre les versions des modèles.

- Vertex AI Model Registry vous offre un aperçu de vos modèles afin de mieux organiser, suivre et entraîner les nouvelles versions. Depuis Model Registry, vous pouvez évaluer et déployer des modèles sur un point de terminaison, créer des inférences par lot, et afficher des informations sur des modèles spécifiques et des versions de modèle.

Gérer les caractéristiques : lorsque vous réutilisez des caractéristiques de ML parmi plusieurs équipes, vous avez besoin d'un moyen rapide et efficace de les partager et de les diffuser.

- Vertex AI Feature Store fournit un dépôt centralisé pour l'organisation, le stockage et la publication des caractéristiques de ML. En utilisant un magasin de caractéristiques central, votre organisation peut réutiliser des caractéristiques de ML à grande échelle et accélérer le développement et le déploiement de nouvelles applications de ML.

Surveiller la qualité du modèle : un modèle déployé en production fonctionne mieux sur les données d'entrée d'inférence semblables aux données d'entraînement. Lorsque les données d'entrée s'écartent des données utilisées pour entraîner le modèle, les performances du modèle peuvent se dégrader, même si le modèle lui-même n'a pas changé.

- Vertex AI Model Monitoring surveille les écarts entraînement/diffusion et les dérives d'inférence, et vous envoie des alertes lorsque les données d'inférence entrantes sont trop éloignées de la référence d'entraînement. Vous pouvez utiliser les alertes et les distributions de caractéristiques pour déterminer si vous devez réentraîner votre modèle.

Faire évoluer des applications d'IA et Python : Ray est un framework Open Source qui permet de faire évoluer des applications d'IA et Python. Ray fournit l'infrastructure nécessaire pour les opérations de calculs distribuées et de traitement en parallèle pour votre workflow de machine learning (ML).

- Ray sur Vertex AI est conçu pour vous permettre d'utiliser le même code Ray Open Source pour écrire des programmes et développer des applications sur Vertex AI avec un minimum de modifications. Vous pouvez ensuite utiliser les intégrations de Vertex AI avec d'autres services Google Cloud , tels que Vertex AI Inference et BigQuery, dans votre workflow de machine learning (ML).