Per la registrazione, utilizza l'SDK Vertex AI per Python.

Metriche e parametri supportati:

- metriche di riepilogo

- metriche delle serie temporali

- parameters

- metriche di classificazione

SDK Vertex AI per Python

Nota: quando il parametro facoltativo resume è specificato come TRUE,

l'esecuzione avviata in precedenza riprende. Se non specificato, resume è impostato

su FALSE e viene creata una nuova esecuzione.

L'esempio seguente utilizza il metodo

init

dalle funzioni aiplatform.

Metriche di riepilogo

Le metriche di riepilogo sono metriche scalari a valore singolo memorizzate accanto alle metriche delle serie temporali e rappresentano un riepilogo finale di un'esecuzione dell'esperimento.

Un caso d'uso di esempio è l'interruzione anticipata, in cui una configurazione di tolleranza consente l'addestramento continuo, ma il modello candidato viene ripristinato da un passaggio precedente e le metriche calcolate per il modello in quel passaggio vengono rappresentate come una metrica di riepilogo perché la metrica della serie temporale più recente non è rappresentativa del modello ripristinato. A questo scopo viene utilizzata l'API log_metrics per le metriche di riepilogo.

Python

experiment_name: fornisci un nome per l'esperimento. Puoi trovare l'elenco degli esperimenti nella console Google Cloud selezionando Esperimenti nel menu di navigazione della sezione.run_name: specifica un nome di esecuzione (vedistart_run).metric: coppie chiave-valore delle metriche. Ad esempio:{'learning_rate': 0.1}project: . Puoi trovarli nella pagina Benvenuto della console Google Cloud .location: vedi Elenco delle località disponibili

Metriche delle serie temporali

Per registrare le metriche delle serie temporali, Vertex AI Experiments richiede un'istanza Vertex AI TensorBoard di supporto.

Assegna la risorsa Vertex AI TensorBoard di supporto per la registrazione delle metriche delle serie temporali.

Tutte le metriche registrate tramite

log_time_series_metrics

vengono archiviate come

metriche delle serie temporali.

Vertex AI TensorBoard è l'archivio di metriche delle serie temporali di supporto.

Il experiment_tensorboard può essere impostato sia a livello di esperimento che di esecuzione dell'esperimento. L'impostazione

di experiment_tensorboard a livello di esecuzione

sostituisce l'impostazione a livello di esperimento. Una volta impostato il

experiment_tensorboard in una corsa, il experiment_tensorboard della corsa non può essere modificato.

- Imposta

experiment_tensorboarda livello di esperimento:aiplatform.

init(experiment='my-experiment', experiment_tensorboard='projects/.../tensorboard/my-tb-resource') - Imposta

experiment_tensorboarda livello di esecuzione: Nota: sostituisce l'impostazione a livello di esperimento.aiplatform.

start_run(run_name='my-other-run', tensorboard='projects/.../.../other-resource') aiplatform.log_time_series_metrics(...)

Python

experiment_name: fornisci il nome dell'esperimento. Puoi trovare l'elenco degli esperimenti nella console Google Cloud selezionando Esperimenti nella barra di navigazione della sezione.run_name: specifica un nome di esecuzione (vedistart_run).metrics: Dizionario in cui le chiavi sono i nomi delle metriche e i valori sono i valori delle metriche.step: (Facoltativo) Indice del passo di questo punto dati all'interno della corsa.wall_time: (Facoltativo) Timestamp dell'orologio a muro in cui questo punto dati viene generato dall'utente finale. Se non viene fornito,wall_timeviene generato in base al valore di time.time()project: . Puoi trovarli nella pagina Benvenuto della console Google Cloud .location: vedi Elenco delle località disponibili

Passo e tempo totale di esecuzione

L'API log_time_series_metrics accetta facoltativamente step

e walltime.

step: (Facoltativo) Indice del passo di questo punto dati all'interno della corsa. Se non viene fornito, viene utilizzato un incremento rispetto all'ultimo passaggio tra tutte le metriche delle serie temporali già registrate. Se il passaggio esiste per una delle chiavi di metrica fornite, viene sovrascritto.wall_time: (Facoltativo) I secondi dopo l'epoca della metrica registrata. Se non viene fornito, il valore predefinito ètime.timedi Python.

Ad esempio:

aiplatform.log_time_series_metrics({"mse": 2500.00, "rmse": 50.00})

Registrare un passaggio specifico

aiplatform.log_time_series_metrics({"mse": 2500.00, "rmse": 50.00}, step=8)

Includi wall_time

aiplatform.log_time_series_metrics({"mse": 2500.00, "rmse": 50.00}, step=10)

Parametri

I parametri sono valori di input con chiave che configurano un'esecuzione, ne regolano il comportamento e influiscono sui risultati. Alcuni esempi sono il tasso di apprendimento, il tasso di dropout e il numero di passaggi di addestramento. Registra i parametri utilizzando il metodo log_params.

Python

aiplatform.log_params({"learning_rate": 0.01, "n_estimators": 10})

experiment_name: fornisci un nome per l'esperimento. Puoi trovare l'elenco degli esperimenti nella console Google Cloud selezionando Esperimenti nella barra di navigazione della sezione.run_name: specifica un nome di esecuzione (vedistart_run).params: coppie chiave-valore dei parametri Ad esempio:{'accuracy': 0.9}(vedilog_params). Pagina welcome.location: vedi Elenco delle località disponibili

Metriche di classificazione

Oltre alle metriche di riepilogo e alle metriche delle serie temporali, le matrici di confusione e le curve ROC sono metriche di uso comune. Possono essere registrati in Vertex AI Experiments utilizzando l'API

log_classification_metrics.

Python

experiment_name: fornisci un nome per l'esperimento. Puoi trovare l'elenco degli esperimenti nella console Google Cloud selezionando Esperimenti nel menu di navigazione della sezione.run_name: Specifica un nome di esecuzione (vedistart_run).project: . Puoi trovarli nella pagina Benvenuto della console Google Cloud .location: consulta l'elenco delle località disponibili.labels: Elenco dei nomi delle etichette per la matrice di confusione. Deve essere impostato se è impostato "matrix".matrix: valori per la matrice di confusione. Deve essere impostato se è impostato "labels".fpr: Elenco delle percentuali di falsi positivi per la curva ROC. Deve essere impostato se sono impostati "tpr" o "thresholds".tpr: Elenco delle percentuali di veri positivi per la curva ROC. Deve essere impostato se sono impostati "fpr" o "thresholds".threshold: Elenco delle soglie per la curva ROC. Deve essere impostato se è impostato "fpr" o "tpr".display_name: Il nome definito dall'utente per l'artefatto della metrica di classificazione.

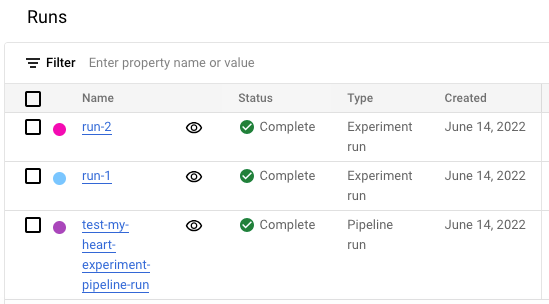

Visualizzare l'elenco delle esecuzioni degli esperimenti nella console Google Cloud

- Nella console Google Cloud , vai alla pagina Esperimenti.

Vai a Esperimenti

Viene visualizzato un elenco di esperimenti. - Seleziona l'esperimento che vuoi controllare.

Viene visualizzato un elenco di corse.

Per maggiori dettagli, vedi Confrontare e analizzare le corse.