En esta página, se explica cómo entregar predicciones de tu modelo de clasificación de imágenes y ver estas predicciones en una aplicación web.

En este instructivo, se incluyen las siguientes páginas:Entrena un modelo de clasificación de imágenes personalizada.

Entrega predicciones desde un modelo de clasificación de imágenes personalizadas.

En cada página, se supone que ya realizaste las instrucciones de las páginas anteriores del instructivo.

En el resto de este documento, se supone que usas el mismo entorno de Cloud Shell que creaste cuando sigues la primera página de este instructivo. Si tu sesión original de Cloud Shell ya no está abierta, puedes volver al entorno de la siguiente manera:-

In the Google Cloud console, activate Cloud Shell.

-

En la sesión de Cloud Shell, ejecuta el siguiente comando:

cd hello-custom-sample

En la consola de Google Cloud , en la sección Vertex AI, ve a la página Modelos.

Busca la fila del modelo que entrenaste en el paso anterior de este instructivo,

hello_custom, y haz clic en el nombre del modelo para abrir la página de detalles del modelo.En la pestaña Implementar y probar, haz clic en Implementar en el extremo para abrir el panel Implementar en el extremo.

En el paso Definir el extremo, agrega información básica para el extremo:

Selecciona Crear extremo nuevo.

En el campo Nombre del extremo, ingresa

hello_custom.En la sección Configuración del modelo, asegúrate de ver el nombre del modelo, que además se llama

hello_custom. Especifica la siguiente configuración del modelo:En el campo División del tráfico, ingresa

100. Vertex AI admite la división del tráfico de un extremo en varios modelos, pero en este instructivo no se usa esa función.En el campo Cantidad mínima de nodos de procesamiento, ingresa

1.En la lista desplegable Tipo de máquina, selecciona n1-standard-2 de la sección Estándar.

Haz clic en Listo.

En la sección Registro, asegúrate de que ambos tipos de registro de predicción estén habilitados.

Haz clic en Continuar.

En el paso Detalles del extremo, confirma que el extremo se implementará en

us-central1 (Iowa).No selecciones la casilla de verificación Usar una clave de encriptación administrada por el cliente (CMEK). En este instructivo, no se usa CMEK.

Haz clic en Implementar para crear el extremo y, luego, implementa el modelo en el extremo.

Puedes configurar una función de Cloud Run para recibir solicitudes sin autenticar. Además, las funciones se ejecutan mediante una cuenta de servicio con la función de editor de forma predeterminada, que incluye el permiso

aiplatform.endpoints.predictnecesario para obtener predicciones de tu extremo de Vertex AI.Esta función también realiza un procesamiento previo útil en las solicitudes. El extremo de Vertex AI espera solicitudes de predicción en el formato de la primera capa del grafo de TensorFlow Keras entrenado: un tensor de números de punto flotante normalizados con dimensiones fijas. La función toma la URL de una imagen como entrada y la procesa previamente en este formato antes de solicitar una predicción del extremo de Vertex AI.

En la consola Google Cloud , en la sección Vertex AI, ve a la página Extremos.

Busca la fila del extremo que creaste en la sección anterior, llamada

hello_custom. En esta fila, haz clic en Solicitud de muestra para abrir el panel Solicitud de muestra.En el panel Solicitud de muestra, busca la línea de código de shell que coincide con el siguiente patrón:

ENDPOINT_ID="ENDPOINT_ID"

ENDPOINT_ID es un número que identifica este extremo en particular.

Copia esta línea de código y ejecútala en tu sesión de Cloud Shell para definir la variable

ENDPOINT_ID.Ejecuta el siguiente comando en tu sesión de Cloud Shell para implementar la función de Cloud Run:

gcloud functions deploy classify_flower \ --region=us-central1 \ --source=function \ --runtime=python37 \ --memory=2048MB \ --trigger-http \ --allow-unauthenticated \ --set-env-vars=ENDPOINT_ID=${ENDPOINT_ID}Configura algunas variables de shell para los comandos en los siguientes pasos a fin de poder usarlas:

PROJECT_ID=PROJECT_ID BUCKET_NAME=BUCKET_NAMEReemplaza lo siguiente:

- PROJECT_ID: Tu Google Cloud ID del proyecto.

- BUCKET_NAME: El nombre del bucket de Cloud Storage que creaste cuando sigues la primera página de este instructivo.

Edita la app para proporcionarle la URL de activación de tu función de Cloud Run:

echo "export const CLOUD_FUNCTION_URL = 'https://us-central1-${PROJECT_ID}.cloudfunctions.net/classify_flower';" \ > webapp/function-url.jsSube el directorio

webappa tu bucket de Cloud Storage:gcloud storage cp webapp gs://${BUCKET_NAME}/ --recursiveHaz que los archivos de la aplicación web que acabas de subir legibles de forma pública:

gcloud storage objects update gs://${BUCKET_NAME}/webapp/** --add-acl-grant=entity=allUsers,role=READERAhora puedes navegar a la siguiente URL para abrir la aplicación web y obtener predicciones:

https://storage.googleapis.com/BUCKET_NAME/webapp/index.html

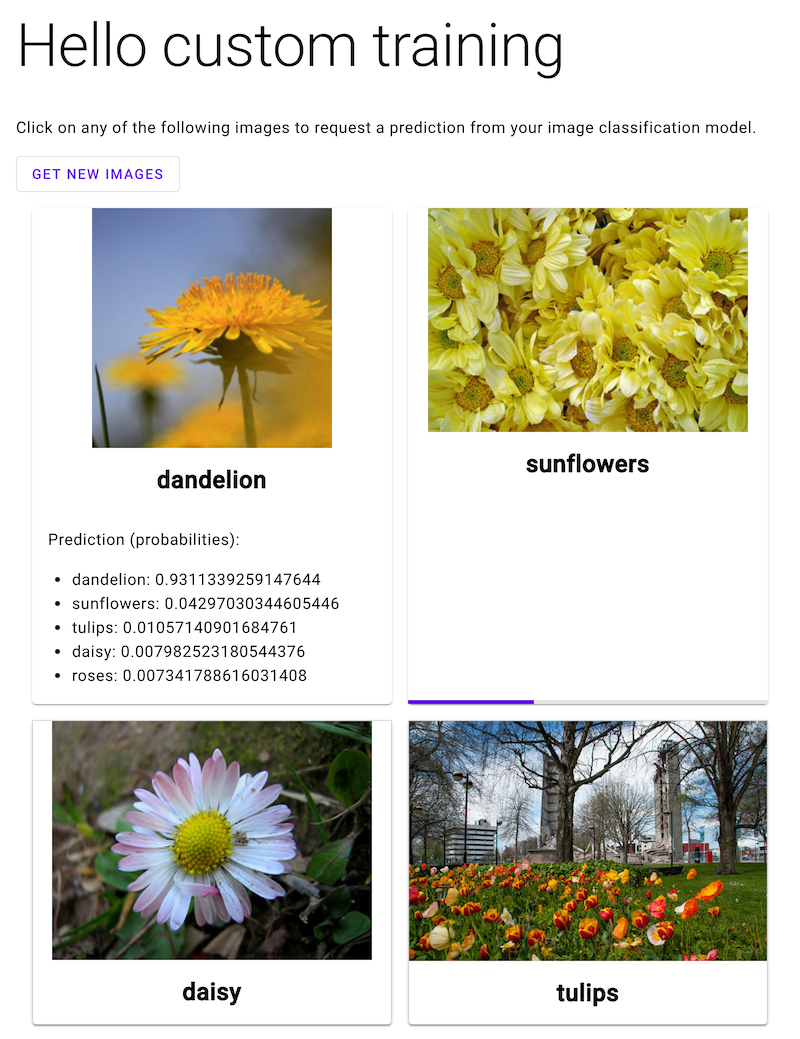

Abre la aplicación web y haz clic en una imagen de una flores para ver la clasificación de tu modelo de AA del tipo de flores. La app web presenta la predicción como una lista de tipos de flores y la probabilidad de que la imagen contiene cada tipo de flores.

Crear un extremo

Para obtener predicciones en línea del modelo de AA que entrenaste cuando seguiste la página anterior de este instructivo, crea un extremo de Vertex AI. Los extremos entregan predicciones en línea de uno o más modelos.

Después de unos minutos, aparecerá junto al extremo nuevo en la tabla Extremos. Al mismo tiempo, también recibirás un correo electrónico que indica que creaste el extremo y que implementaste tu modelo en el extremo.

Implementa una función de Cloud Run

Puedes obtener predicciones desde el extremo de Vertex AI que acabas de crear mediante el envío de solicitudes a la interfaz de la API de REST de Vertex AI. Sin embargo, solo los principales con el permiso aiplatform.endpoints.predict pueden enviar solicitudes de predicción en línea. No puedes hacer que el extremo sea público para que nadie envíe solicitudes, por ejemplo, a través de una aplicación web.

En esta sección, implementa código en funciones de Cloud Run para administrar las solicitudes sin autenticar. El código de muestra que descargaste cuando leiste la primera página de este instructivo contiene el código de esta función de Cloud Run en el directorio function/. De manera opcional, ejecuta el siguiente comando para explorar el código de funciones de Cloud Run:

less function/main.py

Implementa la función tiene los siguientes fines:

Para implementar la función de Cloud Run, haz lo siguiente:

Implementa una aplicación web para enviar solicitudes de predicción

Por último, aloja una aplicación web estática en Cloud Storage para obtener predicciones de tu modelo de AA entrenado. La aplicación web envía solicitudes a tu función de Cloud Run, que las procesa con anterioridad y obtiene predicciones del extremo de Vertex AI.

El directorio webapp del código de muestra que descargaste contiene una aplicación web de muestra. En tu sesión de Cloud Shell, ejecuta los siguientes comandos para preparar e implementar la aplicación web:

En la siguiente captura de pantalla, la aplicación web ya tiene una predicción y está en proceso de enviar otra solicitud de predicción.

¿Qué sigue?

Sigue las indicaciones de la última página del instructivo para limpiar los recursos que creaste.