Gunakan konsol Google Cloud untuk memeriksa performa model Anda. Menganalisis error pengujian untuk meningkatkan kualitas model secara berulang dengan memperbaiki masalah data.

Tutorial ini meliputi beberapa halaman:

Mengevaluasi dan menganalisis performa model.

Setiap halaman mengasumsikan bahwa Anda telah menjalankan petunjuk dari halaman tutorial sebelumnya.

1. Memahami hasil evaluasi model AutoML

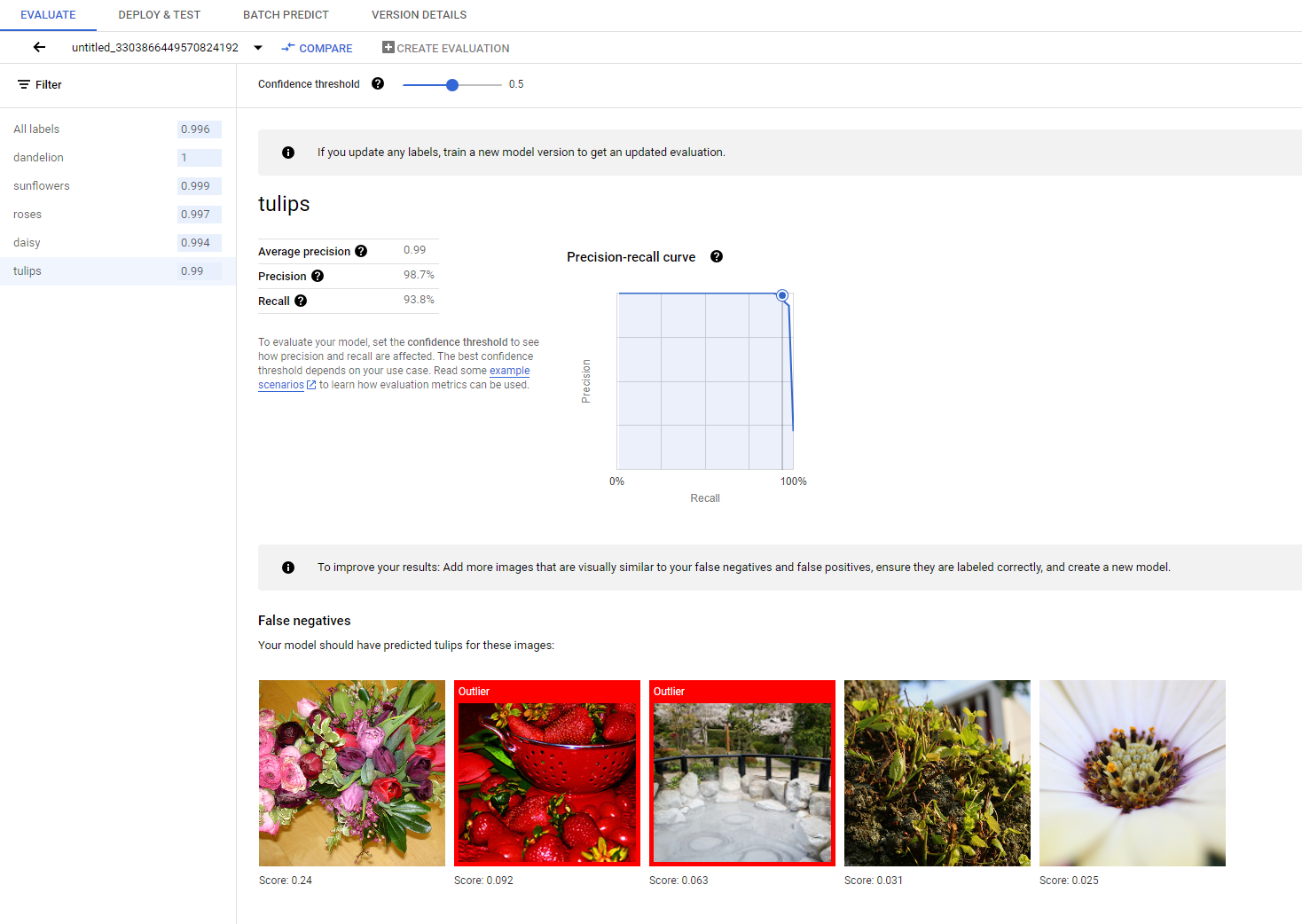

Setelah pelatihan selesai, model Anda akan otomatis dievaluasi terhadap pemisahan data pengujian. Hasil evaluasi terkait ditampilkan dengan mengklik nama model dari halaman Model Registry atau halaman Dataset.

Dari halaman tersebut, Anda dapat menemukan metrik untuk mengukur performa model.

Anda dapat menemukan pengantar yang lebih mendetail tentang berbagai metrik evaluasi di bagian Mengevaluasi, menguji, dan men-deploy model.

2. Menganalisis hasil pengujian

Jika Anda ingin terus meningkatkan performa model, langkah pertama adalah sering kali memeriksa kasus error dan menyelidiki potensi penyebabnya. Halaman evaluasi setiap class menampilkan gambar uji mendetail dari class tertentu yang dikategorikan sebagai negatif palsu, positif palsu, dan positif benar. Definisi setiap kategori dapat ditemukan di bagian Mengevaluasi, menguji, dan men-deploy model Anda.

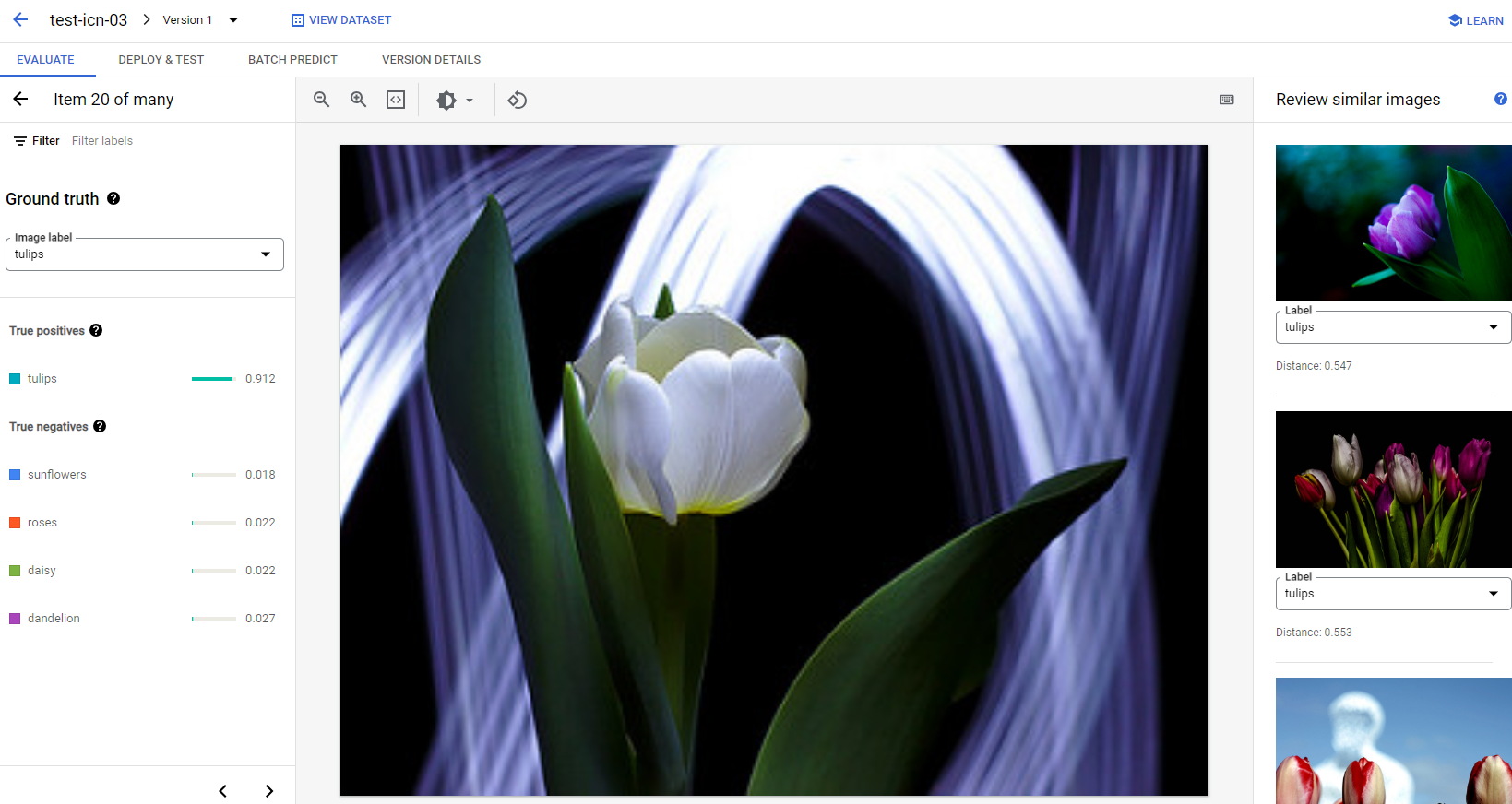

Untuk setiap gambar dalam setiap kategori, Anda dapat memeriksa detail prediksi lebih lanjut dengan mengklik gambar tersebut dan mengakses hasil analisis mendetail. Anda akan melihat panel Tinjau gambar serupa di sisi kanan halaman, tempat contoh terdekat dari set pelatihan ditampilkan dengan jarak yang diukur di ruang fitur.

Ada dua jenis masalah data yang mungkin perlu Anda perhatikan:

Inkonsistensi label. Jika sampel yang mirip secara visual dari set pelatihan memiliki label yang berbeda dengan sampel pengujian, mungkin saja salah satunya salah, atau perbedaan kecil memerlukan lebih banyak data untuk dipelajari oleh model. atau bahwa label class saat ini tidak cukup akurat untuk mendeskripsikan sampel yang diberikan. Meninjau gambar yang serupa dapat membantu Anda mendapatkan informasi label yang akurat dengan memperbaiki kasus error atau mengecualikan sampel yang bermasalah dari set pengujian. Anda dapat mengubah label gambar pengujian atau gambar pelatihan dengan mudah di panel Tinjau gambar serupa di halaman yang sama.

Pencilan. Jika sampel pengujian ditandai sebagai pencilan, mungkin saja tidak ada sampel yang mirip secara visual dalam set pelatihan untuk membantu melatih model. Meninjau gambar serupa dari set pelatihan dapat membantu Anda mengidentifikasi sampel ini dan menambahkan gambar serupa ke dalam set pelatihan untuk lebih meningkatkan performa model pada kasus ini.

Langkah selanjutnya

Jika Anda puas dengan performa model, ikuti halaman berikutnya dalam tutorial ini untuk men-deploy model AutoML terlatih ke endpoint dan mengirimkan gambar ke model untuk prediksi. Atau, jika Anda melakukan koreksi pada data, latih model baru menggunakan tutorial Melatih model klasifikasi gambar AutoML.