Auf dieser Seite erfahren Sie, wie Sie Ihre AutoML-Klassifizierungs- und Regressionsmodelle bewerten.

Vertex AI bietet Messwerte für die Modellbewertung, damit Sie die Leistung Ihrer Modelle bewerten können, z. B. die Precision- und Recall-Messwerte. Vertex AI berechnet Bewertungsmesswerte mithilfe des Test-Datasets.

Hinweise

Bevor Sie Ihr Modell bewerten können, müssen Sie es trainieren.

Verwendung von Modellbewertungsmesswerten

Modellbewertungsmesswerte liefern quantitative Messungen der Leistung Ihres Modells im Test-Dataset. Wie diese Messwerte interpretiert und verwendet werden sollten, hängt von Ihren geschäftlichen Anforderungen und dem Problem ab, für dessen Lösung das Modell trainiert wurde. Sie haben z. B. eine geringere Toleranz für falsch positive Ergebnisse als für falsch negative, oder andersherum. Diese Fragen haben Einfluss darauf, welche Messwerte für Sie besonders wichtig sind.

Bewertungsmesswerte abrufen

Sie können zusammengefasste Bewertungsmesswerte für Ihr Modell und, für einige Ziele, Bewertungsmesswerte für eine bestimmte Klasse oder ein bestimmtes Label abrufen. Bewertungsmesswerte für eine bestimmte Klasse oder ein bestimmtes Label werden auch als Bewertungssegment bezeichnet. Im Folgenden wird beschrieben, wie Sie mit der Google Cloud Console oder der API zusammengefasste Bewertungsmesswerte und Bewertungssegmente abrufen können.

Google Cloud Console

Rufen Sie in der Google Cloud Console im Bereich „Vertex AI“ die Seite Modelle auf.

Wählen Sie im Drop-down-Menü Region die Region aus, in der sich Ihr Modell befindet.

Klicken Sie in der Liste der Modelle auf Ihr Modell, um den Tab Bewerten des Modells zu öffnen.

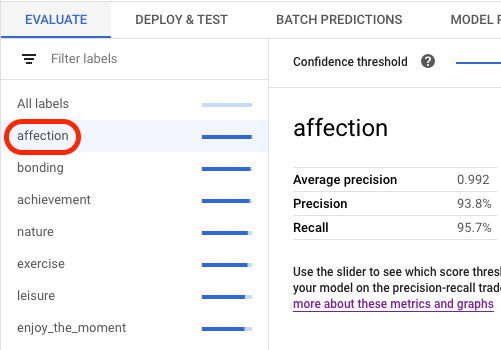

Auf dem Tab Bewerten werden die zusammengefassten Bewertungsmesswerte des Modells angezeigt, zum Beispiel die durchschnittliche Precision und den Recall.

Wenn das Modellziel Bewertungssegmente enthält, wird in der Console eine Liste mit Labels angezeigt. Sie können auf ein Label klicken, um Bewertungsmesswerte für dieses Label anzusehen, wie im folgenden Beispiel gezeigt:

API

API-Anfragen zum Abrufen von Bewertungsmesswerten sind für jeden Datentyp und jedes Ziel identisch, aber die Ausgaben unterscheiden sich. Die folgenden Beispiele zeigen dieselbe Anfrage, aber unterschiedliche Antworten.

Zusammengefasste Modellbewertungsmesswerte abrufen

Die Gesamtbewertungsmesswerte für das Modell liefern Informationen über das Modell als Ganzes. Wenn Sie Informationen zu einem bestimmten Segment abrufen möchten, listen Sie die Modellbewertungssegmente auf.

Verwenden Sie die Methode projects.locations.models.evaluations.get, um zusammengefasste Modellbewertungsmesswerte anzusehen.

Wählen Sie unten den Tab für Ihr Ziel aus:

Klassifizierung

Vertex AI gibt ein Array von Konfidenzmesswerten zurück. Jedes Element zeigt Bewertungsmesswerte mit einem anderen confidenceThreshold-Wert an (beginnend von 0 bis maximal 1). Durch die Anzeige verschiedener Grenzwerte können Sie feststellen, wie sich der Grenzwert auf andere Messwerte wie Precision und Recall auswirkt.

Wählen Sie einen Tab für Ihre Sprache oder Umgebung aus:

REST

Ersetzen Sie dabei folgende Werte für die Anfragedaten:

- LOCATION: Region, in der Ihr Modell gespeichert ist

- PROJECT: Ihre Projekt-ID.

- MODEL_ID: Die ID der Modellressource.

- PROJECT_NUMBER: Die automatisch generierte Projektnummer Ihres Projekts.

- EVALUATION_ID: ID für die Modellbewertung (wird in der Antwort angezeigt)

HTTP-Methode und URL:

GET https://LOCATION-aiplatform.googleapis.com/v1/projects/PROJECT/locations/LOCATION/models/MODEL_ID/evaluations

Senden Sie die Anfrage mithilfe einer der folgenden Optionen:

curl

Führen Sie folgenden Befehl aus:

curl -X GET \

-H "Authorization: Bearer $(gcloud auth print-access-token)" \

"https://LOCATION-aiplatform.googleapis.com/v1/projects/PROJECT/locations/LOCATION/models/MODEL_ID/evaluations"

PowerShell

Führen Sie folgenden Befehl aus:

$cred = gcloud auth print-access-token

$headers = @{ "Authorization" = "Bearer $cred" }

Invoke-WebRequest `

-Method GET `

-Headers $headers `

-Uri "https://LOCATION-aiplatform.googleapis.com/v1/projects/PROJECT/locations/LOCATION/models/MODEL_ID/evaluations" | Select-Object -Expand Content

Sie sollten eine JSON-Antwort ähnlich wie diese erhalten:

Java

Bevor Sie dieses Beispiel anwenden, folgen Sie den Java-Einrichtungsschritten in der Vertex AI-Kurzanleitung zur Verwendung von Clientbibliotheken. Weitere Informationen finden Sie in der Referenzdokumentation zur Vertex AI Java API.

Richten Sie zur Authentifizierung bei Vertex AI Standardanmeldedaten für Anwendungen ein. Weitere Informationen finden Sie unter Authentifizierung für eine lokale Entwicklungsumgebung einrichten.

Node.js

Bevor Sie dieses Beispiel anwenden, folgen Sie den Node.js-Einrichtungsschritten in der Vertex AI-Kurzanleitung zur Verwendung von Clientbibliotheken. Weitere Informationen finden Sie in der Referenzdokumentation zur Vertex AI Node.js API.

Richten Sie zur Authentifizierung bei Vertex AI Standardanmeldedaten für Anwendungen ein. Weitere Informationen finden Sie unter Authentifizierung für eine lokale Entwicklungsumgebung einrichten.

Python

Informationen zur Installation des Vertex AI SDK for Python finden Sie unter Vertex AI SDK for Python installieren. Weitere Informationen finden Sie in der Python-API-Referenzdokumentation.

Regression

Wählen Sie einen Tab für Ihre Sprache oder Umgebung aus:

REST

Ersetzen Sie dabei folgende Werte für die Anfragedaten:

- LOCATION: Region, in der Ihr Modell gespeichert ist

- PROJECT: .

- MODEL_ID: Die ID der Modellressource.

- PROJECT_NUMBER: Die automatisch generierte Projektnummer Ihres Projekts.

- EVALUATION_ID: ID für die Modellbewertung (wird in der Antwort angezeigt)

HTTP-Methode und URL:

GET https://LOCATION-aiplatform.googleapis.com/v1/projects/PROJECT/locations/LOCATION/models/MODEL_ID/evaluations

Senden Sie die Anfrage mithilfe einer der folgenden Optionen:

curl

Führen Sie folgenden Befehl aus:

curl -X GET \

-H "Authorization: Bearer $(gcloud auth print-access-token)" \

"https://LOCATION-aiplatform.googleapis.com/v1/projects/PROJECT/locations/LOCATION/models/MODEL_ID/evaluations"

PowerShell

Führen Sie folgenden Befehl aus:

$cred = gcloud auth print-access-token

$headers = @{ "Authorization" = "Bearer $cred" }

Invoke-WebRequest `

-Method GET `

-Headers $headers `

-Uri "https://LOCATION-aiplatform.googleapis.com/v1/projects/PROJECT/locations/LOCATION/models/MODEL_ID/evaluations" | Select-Object -Expand Content

Sie sollten eine JSON-Antwort ähnlich wie diese erhalten:

Java

Bevor Sie dieses Beispiel anwenden, folgen Sie den Java-Einrichtungsschritten in der Vertex AI-Kurzanleitung zur Verwendung von Clientbibliotheken. Weitere Informationen finden Sie in der Referenzdokumentation zur Vertex AI Java API.

Richten Sie zur Authentifizierung bei Vertex AI Standardanmeldedaten für Anwendungen ein. Weitere Informationen finden Sie unter Authentifizierung für eine lokale Entwicklungsumgebung einrichten.

Node.js

Bevor Sie dieses Beispiel anwenden, folgen Sie den Node.js-Einrichtungsschritten in der Vertex AI-Kurzanleitung zur Verwendung von Clientbibliotheken. Weitere Informationen finden Sie in der Referenzdokumentation zur Vertex AI Node.js API.

Richten Sie zur Authentifizierung bei Vertex AI Standardanmeldedaten für Anwendungen ein. Weitere Informationen finden Sie unter Authentifizierung für eine lokale Entwicklungsumgebung einrichten.

Python

Informationen zur Installation des Vertex AI SDK for Python finden Sie unter Vertex AI SDK for Python installieren. Weitere Informationen finden Sie in der Python-API-Referenzdokumentation.

Alle Bewertungssegmente auflisten (nur Klassifizierungsmodelle)

Die Methode projects.locations.models.evaluations.slices.list listet alle Bewertungssegmente für Ihr Modell auf. Sie müssen die Bewertungs-ID des Modells haben, die Sie beim Aufrufen der zusammengefassten Bewertungsmesswerte erhalten.

Mit Modellbewertungssegmenten können Sie die Leistung des Modells bei einem bestimmten Label ermitteln. Das Feld value gibt an, für welches Label die Messwerte gelten.

Vertex AI gibt ein Array von Konfidenzmesswerten zurück. Jedes Element zeigt Bewertungsmesswerte mit einem anderen confidenceThreshold-Wert an (beginnend von 0 bis maximal 1). Durch die Anzeige verschiedener Grenzwerte können Sie feststellen, wie sich der Grenzwert auf andere Messwerte wie Precision und Recall auswirkt.

REST

Ersetzen Sie dabei folgende Werte für die Anfragedaten:

- LOCATION: Region, in der sich das Modell befindet. Beispiel:

us-central1. - PROJECT: .

- MODEL_ID: ID Ihres Modells.

- EVALUATION_ID: ID der Modellbewertung, die die Bewertungssegmente enthält, die aufgelistet werden sollen.

HTTP-Methode und URL:

GET https://LOCATION-aiplatform.googleapis.com/v1/projects/PROJECT/locations/LOCATION/models/MODEL_ID/evaluations/EVALUATION_ID/slices

Senden Sie die Anfrage mithilfe einer der folgenden Optionen:

curl

Führen Sie folgenden Befehl aus:

curl -X GET \

-H "Authorization: Bearer $(gcloud auth print-access-token)" \

"https://LOCATION-aiplatform.googleapis.com/v1/projects/PROJECT/locations/LOCATION/models/MODEL_ID/evaluations/EVALUATION_ID/slices"

PowerShell

Führen Sie folgenden Befehl aus:

$cred = gcloud auth print-access-token

$headers = @{ "Authorization" = "Bearer $cred" }

Invoke-WebRequest `

-Method GET `

-Headers $headers `

-Uri "https://LOCATION-aiplatform.googleapis.com/v1/projects/PROJECT/locations/LOCATION/models/MODEL_ID/evaluations/EVALUATION_ID/slices" | Select-Object -Expand Content

Sie sollten eine JSON-Antwort ähnlich wie diese erhalten:

Java

Bevor Sie dieses Beispiel anwenden, folgen Sie den Java-Einrichtungsschritten in der Vertex AI-Kurzanleitung zur Verwendung von Clientbibliotheken. Weitere Informationen finden Sie in der Referenzdokumentation zur Vertex AI Java API.

Richten Sie zur Authentifizierung bei Vertex AI Standardanmeldedaten für Anwendungen ein. Weitere Informationen finden Sie unter Authentifizierung für eine lokale Entwicklungsumgebung einrichten.

Node.js

Bevor Sie dieses Beispiel anwenden, folgen Sie den Node.js-Einrichtungsschritten in der Vertex AI-Kurzanleitung zur Verwendung von Clientbibliotheken. Weitere Informationen finden Sie in der Referenzdokumentation zur Vertex AI Node.js API.

Richten Sie zur Authentifizierung bei Vertex AI Standardanmeldedaten für Anwendungen ein. Weitere Informationen finden Sie unter Authentifizierung für eine lokale Entwicklungsumgebung einrichten.

Python

Informationen zur Installation des Vertex AI SDK for Python finden Sie unter Vertex AI SDK for Python installieren. Weitere Informationen finden Sie in der Python-API-Referenzdokumentation.

Messwerte für ein einzelnes Segment abrufen

Verwenden Sie die Methode projects.locations.models.evaluations.slices.get, um Bewertungsmesswerte für ein einzelnes Segment aufzurufen. Sie benötigen die Segment-ID, die Sie erhalten, wenn Sie alle Segmente auflisten. Das folgende Beispiel gilt für alle Datentypen und Ziele.

REST

Ersetzen Sie dabei folgende Werte für die Anfragedaten:

- LOCATION: Region, in der sich das Modell befindet. Beispiel: us-central1.

- PROJECT: .

- MODEL_ID: ID Ihres Modells.

- EVALUATION_ID: ID der Modellbewertung, die das abzurufende Bewertungssegment enthält.

- SLICE_ID: ID eines abzurufenden Bewertungssegments.

- PROJECT_NUMBER: Die automatisch generierte Projektnummer Ihres Projekts.

- EVALUATION_METRIC_SCHEMA_FILE_NAME: Der Name einer Schemadatei, die die Bewertungsmesswerte definiert, die zurückgegeben werden sollen, z. B.

classification_metrics_1.0.0.

HTTP-Methode und URL:

GET https://LOCATION-aiplatform.googleapis.com/v1/projects/PROJECT/locations/LOCATION/models/MODEL_ID/evaluations/EVALUATION_ID/slices/SLICE_ID

Senden Sie die Anfrage mithilfe einer der folgenden Optionen:

curl

Führen Sie folgenden Befehl aus:

curl -X GET \

-H "Authorization: Bearer $(gcloud auth print-access-token)" \

"https://LOCATION-aiplatform.googleapis.com/v1/projects/PROJECT/locations/LOCATION/models/MODEL_ID/evaluations/EVALUATION_ID/slices/SLICE_ID"

PowerShell

Führen Sie folgenden Befehl aus:

$cred = gcloud auth print-access-token

$headers = @{ "Authorization" = "Bearer $cred" }

Invoke-WebRequest `

-Method GET `

-Headers $headers `

-Uri "https://LOCATION-aiplatform.googleapis.com/v1/projects/PROJECT/locations/LOCATION/models/MODEL_ID/evaluations/EVALUATION_ID/slices/SLICE_ID" | Select-Object -Expand Content

Sie sollten eine JSON-Antwort ähnlich wie diese erhalten:

Java

Bevor Sie dieses Beispiel anwenden, folgen Sie den Java-Einrichtungsschritten in der Vertex AI-Kurzanleitung zur Verwendung von Clientbibliotheken. Weitere Informationen finden Sie in der Referenzdokumentation zur Vertex AI Java API.

Richten Sie zur Authentifizierung bei Vertex AI Standardanmeldedaten für Anwendungen ein. Weitere Informationen finden Sie unter Authentifizierung für eine lokale Entwicklungsumgebung einrichten.

Node.js

Bevor Sie dieses Beispiel anwenden, folgen Sie den Node.js-Einrichtungsschritten in der Vertex AI-Kurzanleitung zur Verwendung von Clientbibliotheken. Weitere Informationen finden Sie in der Referenzdokumentation zur Vertex AI Node.js API.

Richten Sie zur Authentifizierung bei Vertex AI Standardanmeldedaten für Anwendungen ein. Weitere Informationen finden Sie unter Authentifizierung für eine lokale Entwicklungsumgebung einrichten.

Python

Informationen zur Installation des Vertex AI SDK for Python finden Sie unter Vertex AI SDK for Python installieren. Weitere Informationen finden Sie in der Python-API-Referenzdokumentation.

Modellbewertungsmesswerte

Vertex AI gibt verschiedene Bewertungsmesswerte zurück, z. B. die Genauigkeit (precision), die Trefferquote (recall) und die Konfidenzgrenzwerte. Die von Vertex AI zurückgegebenen Messwerte hängen vom Ziel des Modells ab. Vertex AI beispielsweise unterschiedliche Bewertungsmesswerte für ein Bildklassifizierungsmodell im Vergleich zu einem Bildobjekterkennungsmodell.

Eine Schemadatei bestimmt, welche Bewertungsmesswerte Vertex AI für jedes Ziel bereitstellt.

Sie können Schemadateien unter dem folgenden Cloud Storage-Speicherort ansehen und herunterladen:

gs://google-cloud-aiplatform/schema/modelevaluation/

Die Bewertungsmesswerte sind:

Klassifizierung

- AuPRC: Der Bereich unter der Precision-/Recall-Kurve (Area Under the Precision/Recall Curve, AuPRC), auch als durchschnittliche Precision bezeichnet. Dieser Wert reicht von null bis eins, wobei ein höherer Wert auf ein Modell von höherer Qualität verweist.

- AuROC: Die Fläche unter der Grenzwertoptimierungskurve (Receiver Operating Characteristic Curve, ROC).. Dieser Wert reicht von null bis eins, wobei ein höherer Wert auf ein Modell von höherer Qualität verweist.

- Logarithmischer Verlust: Die Kreuzentropie zwischen den Modellinferenzen und den Zielwerten. Dieser Wert reicht von null bis unendlich, wobei ein niedrigerer Wert auf ein Modell von höherer Qualität hinweist.

- Konfidenzgrenzwert: Ein Konfidenzwert, der bestimmt, welche Inferenz zurückgegeben werden. Ein Modell gibt Vorhersagen mit diesem Wert oder höher zurück. Ein höherer Konfidenzgrenzwert erhöht die Precision, verringert aber den Recall. Vertex AI gibt Konfidenzmesswerte mit unterschiedlichen Grenzwerten zurück, um festzustellen, wie sich der Grenzwert auf die Precision und den Recall auswirkt.

- Trefferquote: Der Anteil an Vorhersagen mit dieser Klasse, die das Modell korrekt vorhergesagt hat. Wird als Rate richtig positiver Ergebnisse bezeichnet.

- Rückruf bei 1: Die Trefferquote unter alleiniger Berücksichtigung des Labels, das für jedes Beispiel den höchsten Inferenzwert hat, der nicht unter dem Konfidenzwert liegt.

- Präzision: Der Anteil an Klassifizierungsvorhersagen des Modells, die richtig waren.

- Genauigkeit bei 1: Die Genauigkeit, wenn nur das Label mit dem höchsten Inferenzwert und nicht der Konfidenzwert für jedes Beispiel berücksichtigt wird.

- F1-Wert: der harmonische Mittelwert von Precision und Recall. F1 ist ein nützlicher Messwert, wenn Sie ein Gleichgewicht zwischen Precision und Recall anstreben und die Klassenverteilung ungleichmäßig ist

- F1-Wert bei 1: Der harmonische Mittelwert von Trefferquote bei 1 und Genauigkeit bei 1.

- Anzahl echt negativer Ergebnisse: Die Häufigkeit, mit der ein Modell eine negative Klasse richtig vorhergesagt hat.

- Anzahl echt positiver Ergebnisse: Die Häufigkeit, mit der ein Modell eine positive Klasse richtig vorhergesagt hat.

- Anzahl falsch negativer Ergebnisse: Die Häufigkeit, mit der ein Modell eine negative Klasse falsch vorhergesagt hat.

- Anzahl falsch positiver Ergebnisse: Die Häufigkeit, mit der ein Modell eine positive Klasse falsch vorhergesagt hat.

- Rate falsch positiver Ergebnisse: Der Anteil falsch vorhergesagter Ergebnisse aus allen vorhergesagten Ergebnissen.

- Rate falsch positiver Ergebnisse bei 1: Die Rate falsch positiver Ergebnisse, wenn nur das Label mit dem höchsten Inferenzwert und nicht der Konfidenzwert für jedes Beispiel berücksichtigt wird.

- Wahrheitsmatrix: Eine Wahrheitsmatrix gibt an, wie oft ein Modell ein Ergebnis korrekt vorhergesagt hat. Bei falsch vorhergesagten Ergebnissen zeigt die Matrix, was das Modell stattdessen vorhergesagt hat. Die Wahrheitsmatrix hilft Ihnen zu verstehen, wo Ihr Modell zwei Ergebnisse „vermischt“.

- Modell-Featureattributionen: In Vertex AI sehen Sie, wie stark sich jedes Feature auf ein Modell auswirkt. Die Werte werden für jedes Feature als Prozentsatz angegeben. Je höher der Prozentsatz, desto stärker wirkt sich das Feature auf das Modelltraining aus. Prüfen Sie diese Informationen, damit alle wichtigen Features für Ihr Daten- und Geschäftsproblem sinnvoll sind. Weitere Informationen finden Sie unter Feature-Attributionen für Klassifizierung und Regression.

Regression

- MAE: Der mittlere absolute Fehler (Mean Absolute Error) ist die durchschnittliche absolute Differenz zwischen den Zielwerten und den vorhergesagten Werten. Dieser Messwert reicht von null bis unendlich. Ein niedrigerer Wert gibt ein höheres Qualitätsmodell an.

- RMSE: Der RMSE (Root Mean Squared Error) ist der Durchschnitt der Differenz zum Quadrat zwischen dem Zielwert und den tatsächlichen Werten. RMSE reagiert empfindlicher auf Ausreißer als MAE. Wenn Sie also große Fehler befürchten, ist es möglicherweise sinnvoller, RMSE als Messwert für die Auswertung zu nutzen. Ähnlich wie bei MAE zeigt ein kleinerer Wert ein Modell mit höherer Qualität an (0 steht für einen perfekten Prädiktor).

- RMSLE: Dieser Messwert der Wurzel des mittleren quadratischen logarithmischen Fehlers ähnelt RMSE, verwendet jedoch den natürlichen Logarithmus der vorhergesagten und tatsächlichen Werte plus 1. RMSLE bestraft eine Unterinferenz stärker als eine Überinferenz. Er kann auch ein guter Messwert sein, wenn Sie nicht möchten, dass Unterschiede bei großen Inferenzwerten stärker als bei kleinen Inferenzwerten bestraft werden. Dieser Messwert reicht von null bis unendlich. Ein niedrigerer Wert gibt ein Modell mit höherer Qualität an. Der RMSLE-Bewertungsmesswert wird nur zurückgegeben, wenn alle Label- und Vorhersagewerte nicht negativ sind.

- r^2: r-Quadrat ist das Quadrat des Pearson-Korrelationskoeffizienten zwischen den Labels und vorhergesagten Werten. Dieser Messwert liegt zwischen null und eins. Ein höherer Wert bedeutet eine bessere Anpassung an die Regressionslinie.

-

MAPE: Der mittlere absolute prozentuale Fehler (Mean Absolute Percentage Error) ist die durchschnittliche absolute prozentuale Differenz zwischen den Labels und den vorhergesagten Werten. Dieser Messwert liegt zwischen null und unendlich. Ein niedrigerer Wert gibt ein höheres Qualitätsmodell an.

MAPE wird nicht angezeigt, wenn die Zielspalte Nullwerte enthält. In diesem Fall ist MAPE nicht definiert. - Modell-Featureattributionen: In Vertex AI sehen Sie, wie stark sich jedes Feature auf ein Modell auswirkt. Die Werte werden für jedes Feature als Prozentsatz angegeben. Je höher der Prozentsatz, desto stärker wirkt sich das Feature auf das Modelltraining aus. Prüfen Sie diese Informationen, damit alle wichtigen Funktionen für Ihr Daten- und Geschäftsproblem sinnvoll sind. Weitere Informationen finden Sie unter Feature-Attributionen für Klassifizierung und Regression.

Nächste Schritte

Sobald Sie bereit sind, Vorhersagen mit Ihrem Klassifizierungs- oder Regressionsmodell zu treffen, haben Sie zwei Möglichkeiten:

Sie können auch regelmäßiger Leser eines Blogs oder einer URL