Introdução

Nesta página, apresentamos uma breve visão geral conceitual dos métodos de atribuição de recursos disponíveis com a Vertex AI. Para uma discussão técnica detalhada, consulte nosso artigo sobre o AI Explanations.

A importância global do recurso (atribuições de recursos do modelo) mostra como cada recurso afeta um modelo. Os valores são uma porcentagem para cada atributo: quanto maior a porcentagem, mais impacto o atributo teve no treinamento do modelo. Para ver a importância global do recurso para seu modelo, examine as métricas de avaliação.

As atribuições de recursos locais para modelos de série temporal indicam quanto cada recurso nos dados contribuiu para o resultado previsto. Use essas informações para verificar se o modelo se comporta conforme o esperado, reconhecer o viés nos modelos e conseguir ideias de maneiras para melhorar o modelo e os dados de treinamento. Ao solicitar inferências, você recebe os valores previstos conforme apropriado para seu modelo. Quando você solicita explicações, recebe as inferências junto com as informações de atribuição de recursos.

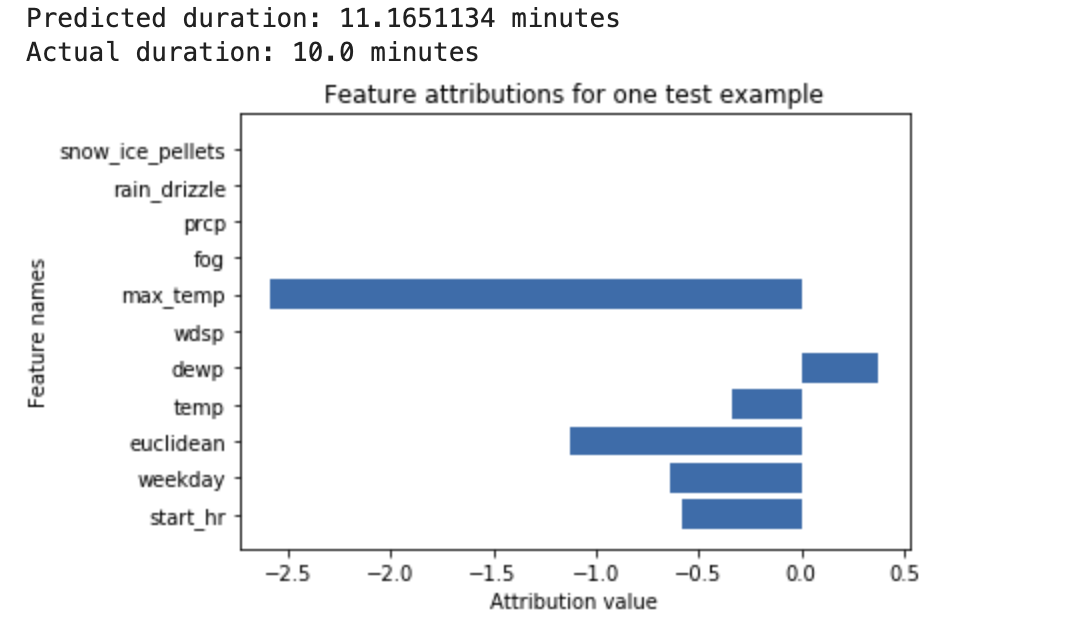

Veja o exemplo a seguir: uma rede neural profunda é treinada para prever a duração de um passeio de bicicleta, com base em dados meteorológicos e em dados anteriores de compartilhamento de viagens. Se você solicitar apenas inferências desse modelo, as durações previstas de passeios de bicicleta serão calculadas em minutos. Se você solicitar explicações, receberá a previsão da duração do passeio de bicicleta, além de uma pontuação de atribuição para cada recurso na sua solicitação de explicações. As pontuações de atribuição mostram quanto o recurso afetou a mudança no valor de inferência, em relação ao valor de referência especificado. Escolha um valor de referência significativo que faça sentido para seu modelo. Nesse caso, a duração média do passeio de bicicleta.

É possível traçar as pontuações de atribuição de recursos para ver quais recursos contribuíram mais para a inferência resultante:

Gere e consulte atribuições de recursos locais ao executar um job de inferência on-line ou de inferência em lote.

Vantagens

Se você inspecionar instâncias específicas e também agregar atribuições de recursos em todo o conjunto de dados de treinamento, poderá ter insights mais detalhados sobre o funcionamento do modelo. Considere as seguintes vantagens:

Depuração de modelos: as atribuições de recursos podem ajudar a detectar problemas nos dados que as técnicas padrão de avaliação de modelos geralmente não detectam.

Otimização de modelos: é possível identificar e remover recursos que são menos importantes, o que pode resultar em modelos mais eficientes.

Limitações conceituais

Considere as seguintes limitações de atribuições de recursos:

As atribuições de recursos, incluindo a importância do recurso local do AutoML, são específicas para inferências individuais. Inspecionar as atribuições de recursos para uma inferência individual pode oferecer insights bons, mas o insight pode não ser generalizado para toda a classe dessa instância individual ou para todo o modelo.

Para conseguir insights mais gerais para modelos do AutoML, consulte a importância do recurso do modelo. Para receber insights mais gerais para outros modelos, agregue atribuições em subconjuntos ao seu conjunto de dados ou em todo o conjunto de dados.

Cada atribuição mostra apenas quanto o recurso afetou a inferência para esse exemplo específico. Uma única concessão pode não refletir o comportamento geral do modelo. Para entender o comportamento aproximado do modelo em um conjunto de dados completo, inclua concessões em todo o conjunto.

Embora as atribuições de recursos possam ajudar com a depuração do modelo, nem sempre indicam claramente se um problema surge no modelo ou nos dados em que o modelo é treinado. Use seu bom senso e diagnostique problemas comuns de dados para reduzir o espaço de causas possíveis.

As atribuições dependem totalmente do modelo e dos dados usados no treinamento. Elas informam apenas os padrões que o modelo encontrou nos dados e não detectam relações fundamentais neles. A presença ou ausência de uma atribuição forte em um certo atributo não significa que há relação entre esse atributo e o destino. A concessão apenas mostra se o modelo está usando o atributo nas inferências.

Só as concessões não informam se o modelo é justo, imparcial ou de qualidade. Avalie cuidadosamente seus dados de treinamento e as métricas de avaliação, além das atribuições.

Para mais informações sobre limitações, consulte o artigo sobre o AI Explanations.

Como aprimorar as concessões de atributos

Os fatores a seguir têm o maior impacto nas concessões de atributos:

- Os métodos de concessão são similares ao valor de Shapley. É possível aumentar a precisão da aproximação aumentando o número de caminhos para o método Sampled Shapley. Isso pode mudar bastante as concessões.

- As atribuições expressam apenas o quanto o atributo afetou a mudança no valor de inferência, em relação ao valor de referência. Escolha um valor de referência significativo, relevante para a pergunta que você está fazendo sobre o modelo. Os valores de concessão e a interpretação deles podem mudar bastante quando você alterna os valores de referência.

Algoritmo

A Vertex AI fornece atribuições de recursos usando o Shapley Values, um algoritmo de teoria de jogos cooperativos que atribui crédito a cada jogador em um resultado específico. Aplicado a modelos de machine learning, cada recurso do modelo é tratado como um "jogador" no jogo, e o crédito é atribuído em proporção ao resultado de uma inferência específica. Em modelos de dados estruturados, a Vertex AI usa uma aproximação de amostragem de valores exatos de Shapley chamada Sampled Shapley.

Para informações detalhadas sobre o funcionamento do método Sampled Shapley, leia o artigo Como limitar o erro de estimativa da aproximação de valor do Sampled Shapley.

A seguir

Os seguintes recursos oferecem materiais educacionais úteis:

- Aprendizado de máquina interpretável: valores de Shapley (em inglês)

- Introdução aos valores de Shapley (em inglês)