En las arquitecturas de VPC compartida, la red del proyecto del host se comparte con el proyecto de servicio. Hasta hace poco, esto impedía separar estos proyectos en diferentes perímetros. Con la introducción de reglas de entrada y salida basadas en direcciones IP privadas, los proyectos host y de servicio ahora pueden residir en perímetros independientes y, al mismo tiempo, mantener un acceso controlado mediante estas reglas.

Arquitectura de referencia

En la política de servicio se usan los siguientes atributos:

- Perímetros de los Controles de Servicio de VPC

- Direcciones IP privadas de Access Context Manager

- Reglas de entrada y salida

En el componente de red, esta arquitectura usa un punto final de Private Service Connect para acceder a las APIs de Google.

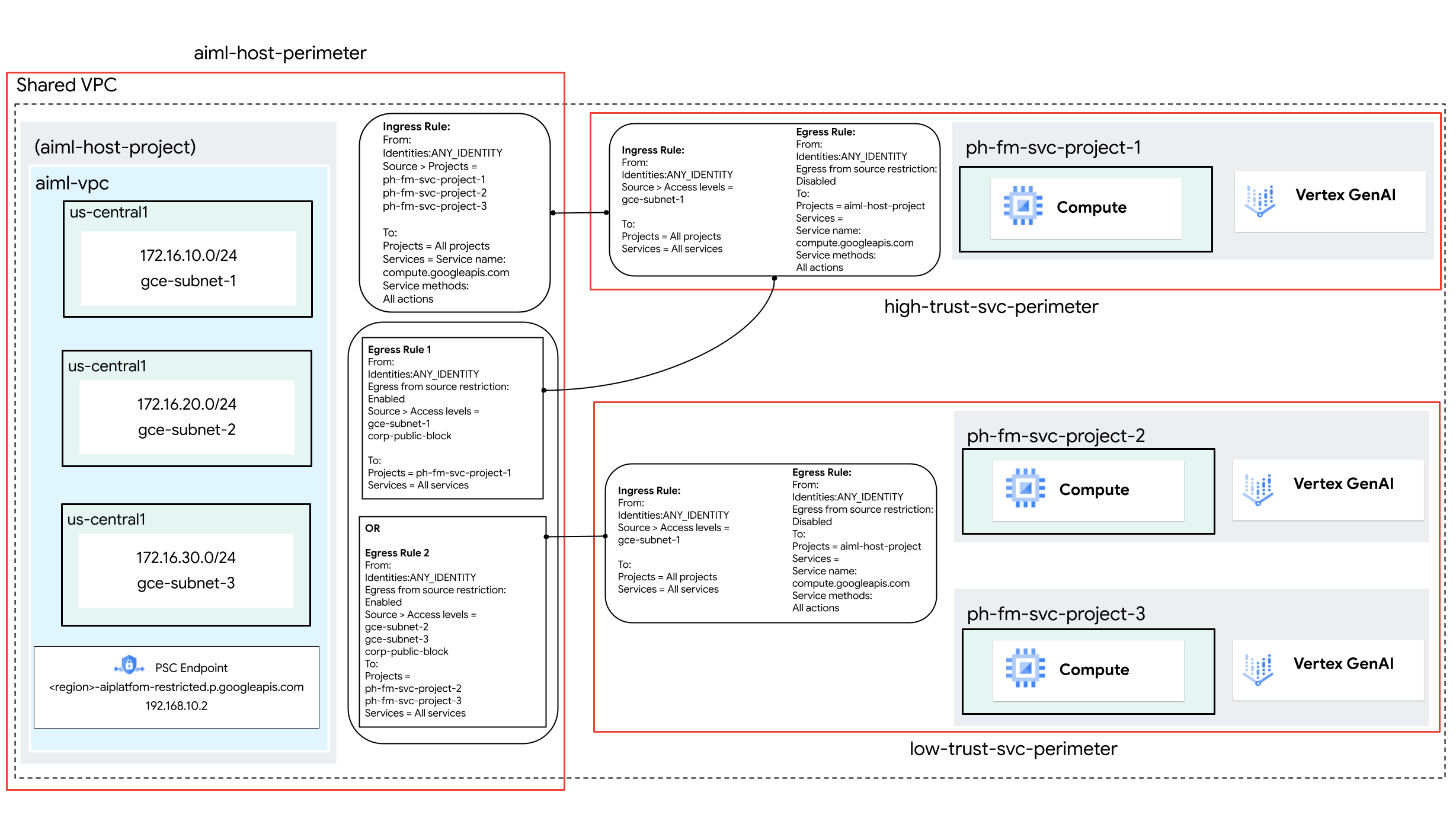

En esta arquitectura de referencia, se usan reglas de entrada y salida, así como direcciones IP privadas, para controlar el acceso entre las instancias de Compute Engine y la API de Vertex AI en los siguientes perímetros de servicio y proyectos:

| Perímetro | Proyectos dentro del perímetro |

|---|---|

aiml-host-perimeter |

aiml-host-project |

high-trust-svc-perimeter |

ph-fm-svc-project-1 |

low-trust-svc-perimeter |

ph-fm-svc-project-2, ph-fm-svc-project-3 |

El acceso a la API Vertex AI desde las instancias de Compute Engine de cada proyecto de servicio se controla mediante reglas de entrada y salida de Controles de Servicio de VPC. Estas reglas usan niveles de acceso de Access Context Manager configurados con direcciones IP privadas para permitir que las subredes compartidas con cada proyecto de servicio accedan a sus respectivos perímetros.

Opcional: Crear un nivel de acceso para el tráfico público de la organización

Si tus usuarios finales necesitan acceder a Vertex AI a través de la Google Cloud consola, sigue las instrucciones de esta sección para crear un nivel de acceso que se pueda usar en Controles de Servicio de VPC. Sin embargo, si el acceso a las APIs es estrictamente programático desde fuentes privadas (como on-premise con Acceso privado a Google para on-premise o Cloud Workstations), no se requiere el nivel de acceso.

En esta arquitectura de referencia, usamos un intervalo CIDR, corp-public-block, para permitir que el tráfico de los empleados de la organización acceda a la consolaGoogle Cloud .

Administrador de contextos de acceso permite a los administradores de la organización definir controles de acceso pormenorizados y basados en atributos para los recursos de Google Cloud. Google Cloud

Los niveles de acceso describen los requisitos que deben cumplir las solicitudes para que se acepten. Estos son algunos ejemplos:

- Tipo de dispositivo y sistema operativo (requiere una licencia de Chrome Enterprise Premium)

- Dirección IP

- Ubicaciones geográficas

- Identidad de usuario

Si es la primera vez que la organización usa el Administrador de contextos de acceso, sus administradores deben definir una política de acceso, que es un contenedor de niveles de acceso y perímetros de servicio. Para ello, sigue estos pasos:

- En el selector de proyectos situado en la parte superior de la Google Cloud consola, haz clic en la pestaña Todos y, a continuación, selecciona tu organización.

- Para crear un nivel de acceso básico, sigue las instrucciones de la página Crear un nivel de acceso básico. Especifica las siguientes opciones:

- En Crear condiciones en, elige Modo básico.

- En el campo Título del nivel de acceso, introduce

corp-public-block. - En la sección Condiciones, en la opción Si se cumple la condición, devolver, elige TRUE.

- En Subredes de IP, elija IP pública.

- En el intervalo de direcciones IP, especifica el intervalo CIDR externo que requiere acceso al perímetro de Controles de Servicio de VPC.

Crear el perímetro de servicio de Controles de Servicio de VPC

Cuando crea un perímetro de servicio, una de las formas de permitir el acceso a los servicios protegidos desde fuera del perímetro es creando niveles de acceso (en nuestro ejemplo, mediante direcciones IP). En esta arquitectura de referencia, se crean varios perímetros de servicio que usan reglas de entrada y salida para controlar el acceso a la API de Vertex AI y la comunicación de la API de Compute Engine de la siguiente manera:

- La subred de los recursos de computación que pertenecen al proyecto de servicio

ph-fm-svc-project-1tiene acceso a la API Vertex AI y a la API Compute Engine enph-fm-svc-project-1desdeaiml-host-project. - Se permite el acceso a la API Vertex AI y a la API Compute Engine en los proyectos

ph-fm-svc-project-2yph-fm-svc-project-3desdeaiml-host-projecta la subred de los recursos de computación que pertenecen a los proyectos de servicioph-fm-svc-project-2yph-fm-svc-project-3.

Cada proyecto de servicio tiene acceso a la API Compute Engine del proyecto host (porque se producen flujos bidireccionales entre el proyecto host y los proyectos de servicio cuando se crean recursos de computación en un proyecto de servicio determinado).

En esta arquitectura de referencia, se crea un nivel de acceso para cada subred con el fin de usar reglas de entrada y salida para permitir los flujos necesarios entre el perímetro del proyecto host y el perímetro de cada proyecto de servicio.

Crear nivel de acceso gce-subnet-1

- En el selector de proyectos situado en la parte superior de la Google Cloud consola, haz clic en la pestaña Todos y, a continuación, selecciona tu organización.

- Para crear un nivel de acceso básico, sigue las instrucciones de la página Crear un nivel de acceso básico. Especifica las siguientes opciones:

- En Crear condiciones en, elige Modo básico.

- En el campo Título del nivel de acceso, introduce

gce-subnet-1. - En la sección Condiciones, en la opción Si se cumple la condición, devolver, elige TRUE.

- En Subredes de IP, elige IP privada.

- Selecciona Redes de VPC, identifica tu proyecto y selecciona el nombre de la VPC.

- En Subredes de IPs, selecciona el intervalo de CIDR que representa la subred que el proyecto host ha compartido con

ph-fm-svc-project-1.

Crear nivel de acceso gce-subnet-2

- En el selector de proyectos situado en la parte superior de la Google Cloud consola, haz clic en la pestaña Todos y, a continuación, selecciona tu organización.

- Para crear un nivel de acceso básico, sigue las instrucciones de la página Crear un nivel de acceso básico. Especifica las siguientes opciones:

- En Crear condiciones en, elige Modo básico.

- En el campo Título del nivel de acceso, introduce

gce-subnet-2. - En la sección Condiciones, en la opción Si se cumple la condición, devolver, elige TRUE.

- En Subredes de IP, elige IP privada.

- Selecciona Redes de VPC, identifica tu proyecto y selecciona el nombre de la VPC.

- En Subredes de IPs, selecciona el intervalo de CIDR que representa la subred que el proyecto host ha compartido con

ph-fm-svc-project-2.

Crear nivel de acceso gce-subnet-3

- En el selector de proyectos situado en la parte superior de la Google Cloud consola, haz clic en la pestaña Todos y, a continuación, selecciona tu organización.

- Para crear un nivel de acceso básico, sigue las instrucciones de la página Crear un nivel de acceso básico. Especifica las siguientes opciones:

- En Crear condiciones en, elige Modo básico.

- En el campo Título del nivel de acceso, introduce

gce-subnet-3. - En la sección Condiciones, en la opción Si se cumple la condición, devolver, elige TRUE.

- En Subredes de IP, elige IP privada.

- Selecciona Redes de VPC, identifica tu proyecto y selecciona el nombre de la VPC.

- En Subredes de IPs, selecciona el intervalo de CIDR que representa la subred que el proyecto host ha compartido con

ph-fm-svc-project-3.

Pasos de configuración de aiml-host-perimeter

Selecciona el tipo de configuración del nuevo perímetro

En esta sección, crearás un perímetro de servicio de Controles de Servicio de VPC (aiml-host-perimeter) en modo de ejecución de prueba.

En el modo de ejecución de prueba, el perímetro registra las infracciones como si se aplicaran los perímetros, pero no impide el acceso a los servicios restringidos. Te recomendamos que uses el modo de prueba antes de cambiar al modo obligatorio.

En el menú de navegación de la consola, haga clic en Seguridad y, a continuación, en Controles de servicio de VPC. Google Cloud

Si se te solicita, selecciona tu organización, carpeta o proyecto.

En la página Controles de Servicio de VPC, haga clic en Modo de ejecución de prueba.

Haga clic en Nuevo perímetro.

En la pestaña Nuevo perímetro de servicio de VPC, en el cuadro Nombre del perímetro, escribe un nombre para el perímetro (por ejemplo,

aiml-host-perimeter).El nombre de un perímetro puede tener una longitud máxima de 50 caracteres, debe empezar por una letra y solo puede contener letras latinas ASCII (

a-zyA-Z), números (0-9) y guiones bajos (_). El nombre del perímetro distingue entre mayúsculas y minúsculas, y debe ser único en una política de acceso.Acepta la configuración predeterminada del perímetro.

Selecciona los recursos que quieras proteger

- Haz clic en Recursos que proteger.

- Para añadir proyectos o redes de VPC que quieras proteger dentro del perímetro, haz lo siguiente:

- Haz clic en Añadir recursos.

- Para añadir proyectos al perímetro, en el panel Añadir recursos, haz clic en Añadir proyecto.

- Selecciona el proyecto que quieras añadir (en este caso,

aiml-host-project). - Haz clic en Añadir recursos seleccionados. Los proyectos añadidos aparecen en la sección Proyectos.

- Selecciona el proyecto que quieras añadir (en este caso,

Selecciona los servicios restringidos

En esta arquitectura de referencia, el ámbito de las APIs restringidas es limitado, por lo que solo se habilitan las APIs necesarias para Vertex AI. Sin embargo, como práctica recomendada, te aconsejamos que restrinjas todos los servicios cuando crees un perímetro para reducir el riesgo de filtración de datos de los servicios de Google Cloud .

Para seleccionar los servicios que quieres proteger dentro del perímetro, sigue estos pasos:

- Haz clic en Servicios restringidos.

- En el panel Servicios restringidos, haz clic en Añadir servicios.

- En el cuadro de diálogo Especificar servicios que restringir, selecciona la API de Compute Engine.

- Haz clic en Añadir API de Compute Engine.

Opcional: Selecciona los servicios accesibles de VPC

El ajuste Servicios accesibles de la VPC limita el conjunto de servicios a los que se puede acceder desde los endpoints de red que se encuentran dentro de tu perímetro de servicio. En esta arquitectura de referencia, vamos a mantener el ajuste predeterminado Todos los servicios.

Opcional: Selecciona el nivel de acceso

Si has creado un nivel de acceso CIDR corporativo en una sección anterior, haz lo siguiente para permitir el acceso a recursos protegidos desde fuera del perímetro:

- Haz clic en Niveles de acceso.

Haz clic en el cuadro Elegir nivel de acceso.

También puedes añadir niveles de acceso después de crear un perímetro.

Selecciona la casilla correspondiente al nivel de acceso. En esta arquitectura de referencia, es

corp-public-block.

Configurar la política de entrada

La comunicación bidireccional se produce entre un proyecto del host y un proyecto de servicio cuando se crean recursos de computación en un proyecto de servicio determinado, ya que el proyecto del host es el propietario de la red de VPC que contiene la subred compartida con el proyecto de servicio. En esta sección, configurará una regla de entrada que permita que los tres proyectos de servicio accedan a los recursos de computación del proyecto host para estos flujos.

- En el menú de la izquierda, haz clic en Política de entrada.

- Haz clic en Añadir regla.

- En el panel Regla de entrada, haz lo siguiente:

- En Atributos FROM, seleccione los siguientes atributos FROM del cliente de la API:

- Identidad: cualquier identidad

- Fuente: proyectos (

ph-fm-svc-project-1,ph-fm-svc-project-2,ph-fm-svc-project-3)

- En Atributos TO, selecciona los siguientes atributos TO de los servicios y recursos de Google Cloud

:

- Proyecto: todos los proyectos

- Servicios: servicios seleccionados

- Servicios seleccionados: API de Compute Engine

- Métodos: todos los métodos

- En Atributos FROM, seleccione los siguientes atributos FROM del cliente de la API:

Configurar la política de salida

En esta sección, configurará dos reglas de salida.

Primera regla de salida

Como el proyecto del host es el propietario de la subred compartida con ph-fm-svc-project-1, se necesita una regla de salida para permitir que esa subred acceda al perímetro de ph-fm-svc-project-1 desde el perímetro del proyecto del host. El nivel de acceso corporativo permite la comunicación bidireccional necesaria para crear instancias de cálculo cuando un usuario final crea recursos de cálculo en un proyecto de servicio mediante el nivel de acceso configurado.

- En el menú de la izquierda, haz clic en Política de salida.

- Haz clic en Añadir regla.

- En el panel Regla de salida, haz lo siguiente:

- En Atributos FROM, seleccione los siguientes atributos FROM del cliente de la API:

- Identidad: cualquier identidad

- Selecciona Habilitar fuentes de salida del nivel de acceso.

- Niveles de acceso

corp-public-blockygce-subnet-1.

- En Atributos TO, selecciona los siguientes atributos TO de los servicios y recursos de Google Cloud

:

- Proyecto: proyectos seleccionados

- Añadir proyecto:

ph-fm-svc-project-1 - Servicios: todos los servicios

- En Atributos FROM, seleccione los siguientes atributos FROM del cliente de la API:

Segunda regla de salida

Como el proyecto del host es el propietario de las subredes compartidas con ph-fm-svc-project-2 y ph-fm-svc-project-3, se necesita una regla de salida para permitir que esas subredes accedan al perímetro de los proyectos de servicio desde el perímetro del proyecto del host.

El nivel de acceso de empresa permite la comunicación bidireccional necesaria para crear instancias de Compute cuando un usuario final crea recursos de computación en un proyecto de servicio mediante el nivel de acceso configurado.

- En el menú de la izquierda, haz clic en Política de salida.

- Haz clic en Añadir regla.

- En el panel Regla de salida, haz lo siguiente:

- En Atributos FROM, seleccione los siguientes atributos FROM del cliente de la API:

- Identidad: cualquier identidad

- Selecciona Habilitar fuentes de salida del nivel de acceso.

- Niveles de acceso

corp-public-block,gce-subnet-2ygce-subnet-3.

- En Atributos TO, selecciona los siguientes atributos TO de los servicios y recursos de Google Cloud

:

- Proyecto: proyectos seleccionados

- Añadir proyecto:

ph-fm-svc-project-2,ph-fm-svc-project-3 - Servicios: todos los servicios

- En Atributos FROM, seleccione los siguientes atributos FROM del cliente de la API:

Crear el perímetro

Una vez que hayas completado los pasos de configuración anteriores, crea el perímetro haciendo clic en Crear perímetro.

Pasos de configuración de high-trust-svc-perimeter

Selecciona el tipo de configuración del nuevo perímetro

En el menú de navegación de la consola, haga clic en Seguridad y, a continuación, en Controles de servicio de VPC. Google Cloud

Si se te solicita, selecciona tu organización, carpeta o proyecto.

En la página Controles de Servicio de VPC, haga clic en Modo de ejecución de prueba.

Haga clic en Nuevo perímetro.

En la pestaña Nuevo perímetro de servicio de VPC, en el cuadro Nombre del perímetro, escribe un nombre para el perímetro (por ejemplo,

high-trust-svc-perimeter).El nombre de un perímetro puede tener una longitud máxima de 50 caracteres, debe empezar por una letra y solo puede contener letras latinas ASCII (

a-zyA-Z), números (0-9) y guiones bajos (_). El nombre del perímetro distingue entre mayúsculas y minúsculas, y debe ser único en una política de acceso.Acepta la configuración predeterminada del perímetro.

Selecciona los recursos que quieras proteger

- Haz clic en Recursos que proteger.

- Para añadir proyectos o redes de VPC que quieras proteger dentro del perímetro, haz lo siguiente:

- Haz clic en Añadir recursos.

- Para añadir proyectos al perímetro, en el panel Añadir recursos, haz clic en Añadir proyecto.

- Selecciona el proyecto que quieras añadir (en este caso,

ph-fm-svc-project-1). - Haz clic en Añadir recursos seleccionados. Los proyectos añadidos aparecen en la sección Proyectos.

- Selecciona el proyecto que quieras añadir (en este caso,

Selecciona los servicios restringidos

En esta arquitectura de referencia, el ámbito de las APIs restringidas es limitado, lo que permite usar solo las APIs necesarias para Gemini. Sin embargo, como práctica recomendada, te aconsejamos que restrinjas todos los servicios cuando crees un perímetro para reducir el riesgo de filtración de datos de los servicios de Google Cloud .

Para seleccionar los servicios que quieres proteger dentro del perímetro, sigue estos pasos:

- Haz clic en Servicios restringidos.

- En el panel Servicios restringidos, haz clic en Añadir servicios.

- En el cuadro de diálogo Especificar servicios que restringir, selecciona la API de Compute Engine.

- Haz clic en Añadir API de Compute Engine.

- En el panel Servicios restringidos, haz clic en Añadir servicios.

- En el cuadro de diálogo Especificar servicios que se van a restringir, selecciona la API de Vertex AI.

- Haz clic en Add Vertex AI API (Añadir API de Vertex AI).

Opcional: Selecciona los servicios accesibles de VPC

El ajuste Servicios accesibles de la VPC limita el conjunto de servicios a los que se puede acceder desde los endpoints de red que se encuentran dentro de tu perímetro de servicio. En esta arquitectura de referencia, vamos a mantener el ajuste predeterminado Todos los servicios.

Opcional: Selecciona el nivel de acceso

Si has creado un nivel de acceso CIDR corporativo en una sección anterior, haz lo siguiente para permitir el acceso a recursos protegidos desde fuera del perímetro:

- Haz clic en Niveles de acceso.

Haz clic en el cuadro Elegir nivel de acceso.

También puedes añadir niveles de acceso después de crear un perímetro.

Selecciona la casilla correspondiente al nivel de acceso. En esta arquitectura de referencia, es

corp-public-block.

Configurar la política de entrada

Como el proyecto del host es el propietario de la subred compartida con ph-fm-svc-project-1, se necesita una regla de entrada para permitir que esa subred acceda al perímetro de ph-fm-svc-project-1 desde el proyecto del host. De esta forma, las instancias de computación de ph-fm-svc-project-1 pueden acceder al servicio gestionado en ph-fm-svc-project-1.

- En el menú de la izquierda, haz clic en Política de entrada.

- Haz clic en Añadir regla.

- En el panel Regla de entrada, haz lo siguiente:

- En Atributos FROM, seleccione los siguientes atributos FROM del cliente de la API:

- Identidad: cualquier identidad

- Fuente: nivel de acceso

- Nivel de acceso:

gce-subnet-1

- En Atributos TO, selecciona los siguientes atributos TO de los servicios y recursos de Google Cloud

:

- Proyecto: todos los proyectos

- Servicios: todos los servicios

- En Atributos FROM, seleccione los siguientes atributos FROM del cliente de la API:

Configurar la política de salida

Como el proyecto del host es el propietario de la subred compartida con ph-fm-svc-project-1, se necesita una regla de salida para permitir la comunicación bidireccional que se produce entre el proyecto de servicio y su proyecto del host cuando se crean recursos de computación en el proyecto de servicio.

- En el menú de la izquierda, haz clic en Política de salida.

- Haz clic en Añadir regla.

- En el panel Regla de salida, haz lo siguiente:

- En Atributos FROM, seleccione los siguientes atributos FROM del cliente de la API:

- Identidad: cualquier identidad

- En Atributos TO, selecciona los siguientes atributos TO de los servicios y recursos de Google Cloud

:

- Proyecto: proyectos seleccionados

- Añadir proyecto:

aiml-host-project - Servicios: servicios seleccionados

- Servicios seleccionados: API de Compute Engine

- Métodos: todos los métodos

- En Atributos FROM, seleccione los siguientes atributos FROM del cliente de la API:

Crear el perímetro

Una vez que hayas completado los pasos de configuración anteriores, crea el perímetro haciendo clic en Crear perímetro.

Pasos de configuración de low-trust-svc-perimeter

Selecciona el tipo de configuración del nuevo perímetro

En el menú de navegación de la consola, haga clic en Seguridad y, a continuación, en Controles de servicio de VPC. Google Cloud

Si se te solicita, selecciona tu organización, carpeta o proyecto.

En la página Controles de Servicio de VPC, haga clic en Modo de ejecución de prueba.

Haga clic en Nuevo perímetro.

En la pestaña Nuevo perímetro de servicio de VPC, en el cuadro Nombre del perímetro, escribe un nombre para el perímetro (por ejemplo,

low-trust-svc-perimeter).El nombre de un perímetro puede tener una longitud máxima de 50 caracteres, debe empezar por una letra y solo puede contener letras latinas ASCII (

a-zyA-Z), números (0-9) y guiones bajos (_). El nombre del perímetro distingue entre mayúsculas y minúsculas, y debe ser único en una política de acceso.Acepta la configuración predeterminada del perímetro.

Selecciona los recursos que quieras proteger

- Haz clic en Recursos que proteger.

- Para añadir proyectos o redes de VPC que quieras proteger dentro del perímetro, haz lo siguiente:

- Haz clic en Añadir recursos.

- Para añadir proyectos al perímetro, en el panel Añadir recursos, haz clic en Añadir proyecto.

- Selecciona el proyecto que quieras añadir. En esta arquitectura de referencia, elige lo siguiente:

ph-fm-svc-project-2ph-fm-svc-project-3

- Haz clic en Añadir recursos seleccionados. Los proyectos añadidos aparecen en la sección Proyectos.

- Selecciona el proyecto que quieras añadir. En esta arquitectura de referencia, elige lo siguiente:

Selecciona los servicios restringidos

En esta arquitectura de referencia, el ámbito de las APIs restringidas es limitado, lo que permite usar solo las APIs necesarias para Gemini. Sin embargo, como práctica recomendada, te aconsejamos que restrinjas todos los servicios cuando crees un perímetro para reducir el riesgo de filtración de datos de los servicios de Google Cloud .

Para seleccionar los servicios que quieres proteger dentro del perímetro, sigue estos pasos:

- Haz clic en Servicios restringidos.

- En el panel Servicios restringidos, haz clic en Añadir servicios.

- En el cuadro de diálogo Especificar servicios que restringir, selecciona la API de Compute Engine.

- Haz clic en Añadir API de Compute Engine.

- En el panel Servicios restringidos, haz clic en Añadir servicios.

- En el cuadro de diálogo Especificar servicios que se van a restringir, selecciona la API de Vertex AI.

- Haz clic en Add Vertex AI API (Añadir API de Vertex AI).

Opcional: Selecciona los servicios accesibles de VPC

El ajuste Servicios accesibles de la VPC limita el conjunto de servicios a los que se puede acceder desde los endpoints de red que se encuentran dentro de tu perímetro de servicio. En esta arquitectura de referencia, vamos a mantener el ajuste predeterminado Todos los servicios.

Opcional: Selecciona el nivel de acceso

Si has creado un nivel de acceso CIDR corporativo en una sección anterior, haz lo siguiente para permitir el acceso a recursos protegidos desde fuera del perímetro:

- Haz clic en Niveles de acceso.

Haz clic en el cuadro Elegir nivel de acceso.

También puedes añadir niveles de acceso después de crear un perímetro.

Selecciona la casilla correspondiente al nivel de acceso. En esta arquitectura de referencia, es

corp-public-block.

Configurar la política de entrada

Como el proyecto del host es el propietario de la subred compartida con ph-fm-svc-project-2 y ph-fm-svc-project-3, se necesita una regla de entrada para conceder a esas subredes acceso al perímetro del proyecto de servicio desde el proyecto del host. De esta forma, las instancias de computación de estos proyectos de servicio pueden acceder al servicio gestionado en ph-fm-svc-project-2 y ph-fm-svc-project-3.

- En el menú de la izquierda, haz clic en Política de entrada.

- Haz clic en Añadir regla.

- En el panel Regla de entrada, haz lo siguiente:

- En Atributos FROM, seleccione los siguientes atributos FROM del cliente de la API:

- Identidad: cualquier identidad

- Fuente: nivel de acceso

- Nivel de acceso:

gce-subnet-2,gce-subnet-3

- En Atributos TO, selecciona los siguientes atributos TO de los servicios y recursos de Google Cloud

:

- Proyecto: todos los proyectos

- Servicios: todos los servicios

- En Atributos FROM, seleccione los siguientes atributos FROM del cliente de la API:

Configurar la política de salida

Como el proyecto del host es el propietario de la subred compartida con ph-fm-svc-project-2

y ph-fm-svc-project-3, se necesita una regla de salida para permitir la comunicación bidireccional que se produce entre los proyectos de servicio y su proyecto del host cuando se crean recursos de computación en los proyectos de servicio.

- En el menú de la izquierda, haz clic en Política de salida.

- Haz clic en Añadir regla.

- En el panel Regla de salida, haz lo siguiente:

- En Atributos FROM, seleccione los siguientes atributos FROM del cliente de la API:

- Identidad: cualquier identidad

- En Atributos TO, selecciona los siguientes atributos TO de los servicios y recursos de Google Cloud

:

- Proyecto: proyectos seleccionados

- Añadir proyecto:

aiml-host-project - Servicios: servicios seleccionados

- Servicios seleccionados: API de Compute Engine

- Métodos: todos los métodos

- En Atributos FROM, seleccione los siguientes atributos FROM del cliente de la API:

Crear el perímetro

Una vez que hayas completado los pasos de configuración anteriores, crea el perímetro haciendo clic en Crear perímetro.

Configurar la red

Usar un punto final de Private Service Connect para acceder a las APIs de Google

Private Service Connect para acceder a las APIs de Google es una alternativa a usar Acceso privado de Google o los nombres de dominio públicos de las APIs de Google. En este caso, el productor es Google.

Con Private Service Connect, puedes hacer lo siguiente:

- Crea una o varias direcciones IP internas para acceder a las APIs de Google en diferentes casos prácticos.

- Dirige tu tráfico local a direcciones IP y regiones específicas al acceder a las APIs de Google.

- Crea un nombre DNS de endpoint personalizado que se usará para resolver las APIs de Google.

En la arquitectura de referencia, se implementa un endpoint de API de Google de Private Service Connect llamado restricted con la dirección IP 192.168.10.2. Este endpoint tiene como destino los Controles de Servicio de VPC y se usa como IP virtual (VIP) para acceder a los servicios restringidos configurados en el perímetro de Controles de Servicio de VPC. El endpoint de Private Service Connect se implementa en el proyecto host,

aiml-host-project.

Acceder a Gemini Pro desde instancias de Compute Engine

Cuando creas un endpoint de Private Service Connect, el Directorio de servicios crea registros DNS en una p.googleapis.comzona privada.

Los registros apuntan a la dirección IP del endpoint y usan el formato SERVICE-ENDPOINT.p.googleapis.com, que equivale al nombre de dominio completo que se usa para acceder a la API de Vertex AI: LOCATION-aiplatform-restricted.p.googleapis.com.

Validar la configuración de red

En las instancias de Compute Engine implementadas en los proyectos de servicio, se usa el siguiente procedimiento para actualizar la API de Vertex AI de forma que use el nombre de dominio completo personalizado y realice la validación.

Inicializa las variables de entorno de Python de la siguiente manera:

PROJECT_ID="ph-fm-svc-project-1" LOCATION_ID="us-central1" API_ENDPOINT="us-central1-aiplatform-restricted.p.googleapis.com" MODEL_ID="gemini-2.0-flash-exp" GENERATE_CONTENT_API="streamGenerateContent"Con un editor de texto, crea un archivo

request.jsonque contenga el siguiente JSON:{ "contents": [ { "role": "user", "parts": [ { "text": "what weight more 1kg feathers vs 1kg stones" } ] } ], "generationConfig": { "temperature": 1, "maxOutputTokens": 8192, "topP": 0.95, "seed": 0 }, "safetySettings": [ { "category": "HARM_CATEGORY_HATE_SPEECH", "threshold": "OFF" }, { "category": "HARM_CATEGORY_DANGEROUS_CONTENT", "threshold": "OFF" }, { "category": "HARM_CATEGORY_SEXUALLY_EXPLICIT", "threshold": "OFF" }, { "category": "HARM_CATEGORY_HARASSMENT", "threshold": "OFF" } ] }Haz la siguiente solicitud cURL a la API de Gemini de Vertex AI:

curl \ -X POST \ -H "Content-Type: application/json" \ -H "Authorization: Bearer $(gcloud auth print-access-token)" \ "https://${API_ENDPOINT}/v1/projects/${PROJECT_ID}/locations/${LOCATION_ID}/publishers/google/models/${MODEL_ID}:${GENERATE_CONTENT_API}" -d '@request.json'

Validar el perímetro en el modo de ejecución de prueba

En esta arquitectura de referencia, el perímetro de servicio se configura en el modo de prueba, lo que te permite probar el efecto de la política de acceso sin que se aplique. Esto significa que puedes ver cómo afectarían tus políticas a tu entorno si estuvieran activas, pero sin el riesgo de interrumpir el tráfico legítimo.

Para saber cómo validar tu perímetro en el modo de ejecución de prueba, consulta el vídeo de YouTube Registros de ejecución de prueba de Controles de Servicio de VPC.

Una vez que hayas validado tu perímetro en el modo de prueba, cámbialo al modo obligatorio.