Comparar e analisar execuções

Mantenha tudo organizado com as coleções

Salve e categorize o conteúdo com base nas suas preferências.

É possível usar o SDK da Vertex AI para Python para ver dados de execuções de Experimentos da Vertex AI e comparar as execuções.

O console Google Cloud fornece uma visualização dos dados associados a essas execuções.

Acessar dados de execuções do experimento

Essas amostras envolvem receber métricas de execução, parâmetros de execução, métricas de série de tempo de execução, artefatos e métricas de classificação para uma execução de experiência específica.

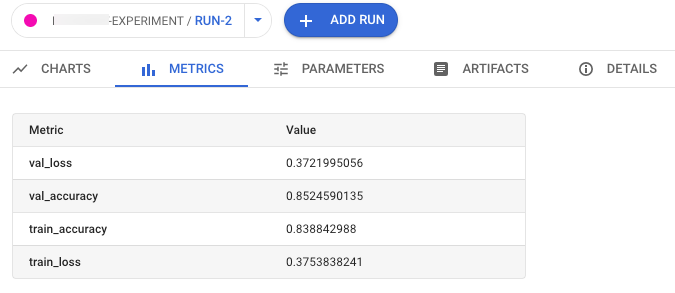

Métricas de resumo

run_name: especifique o nome de execução apropriado para esta sessão.experiment: o nome ou a instância do experimento.

Para ver a lista de experimentos no Google Cloud console, selecione

Experimentos no painel de navegação.project: . É possível encontrá-los na página de boas-vindas do console Google Cloud .location: Consulte a Lista de locais disponíveis.

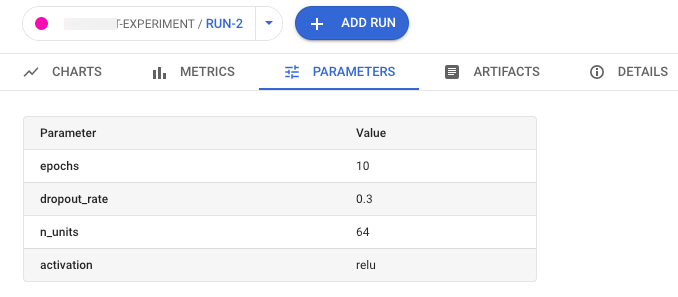

Parâmetros

run_name: especifique o nome de execução apropriado para esta sessão.experiment: o nome ou a instância do experimento.

Para ver a lista de experimentos no Google Cloud console, selecione

Experimentos no painel de navegação.project: . É possível encontrá-los na página de boas-vindas do console Google Cloud .location: Consulte a Lista de locais disponíveis.

Métricas de série temporal

run_name: especifique o nome de execução apropriado para esta sessão.experiment: o nome ou a instância do experimento.

Para ver a lista de experimentos no Google Cloud console, selecione

Experimentos no painel de navegação.project: . É possível encontrá-los na página de boas-vindas do console Google Cloud .location: Consulte a Lista de locais disponíveis.

Artefatos

run_name: especifique o nome de execução apropriado para esta sessão.experiment: o nome ou a instância do experimento.

Para ver a lista de experimentos no Google Cloud console, selecione

Experimentos no painel de navegação.project: . É possível encontrá-los na página de boas-vindas do console Google Cloud .location: Consulte a Lista de locais disponíveis.

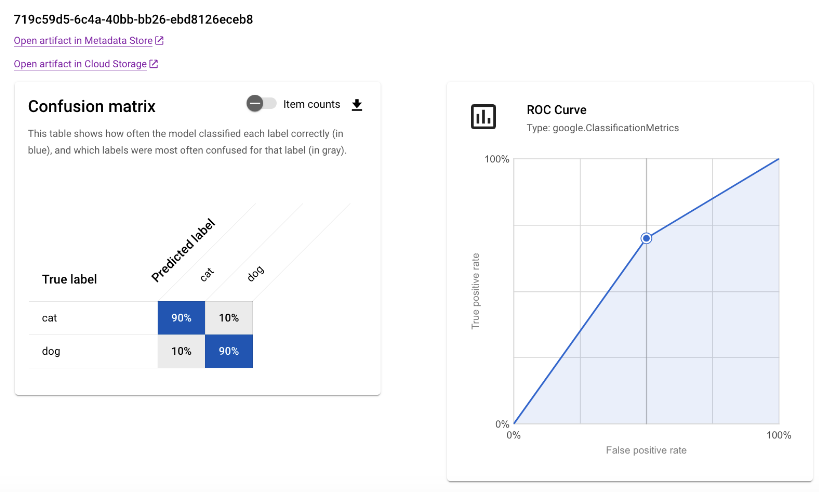

Métricas de classificação

run_name: especifique o nome de execução apropriado para esta sessão.experiment: o nome ou a instância do experimento.

Para ver a lista de experimentos no Google Cloud console, selecione

Experimentos no painel de navegação.project: . É possível encontrá-los na página de boas-vindas do console Google Cloud .location: Consulte a Lista de locais disponíveis.

Comparar execuções

Usando o SDK da Vertex AI para Python, é possível recuperar os dados associados ao seu experimento. Os dados das execuções do experimento são retornados em um DataFrame.

Comparar execuções

Os dados das execuções do experimento são retornados em um DataFrame.

experiment_name: fornece um nome para o experimento.

Para ver a lista de experimentos no

console Google Cloud , selecione Experimentos no painel de navegação.project: . Esses IDs estão na página de boas-vindas do console Google Cloud .location: Consulte a Lista de locais disponíveis.

Google Cloud console

Use o console Google Cloud para ver detalhes das suas execuções de experimentos e compará-las entre si.

Ver dados de execução do experimento

- No console do Google Cloud , acesse a página Experimentos.

Acessar os Experimentos.

Uma lista de experimentos associados a um projeto será exibida.

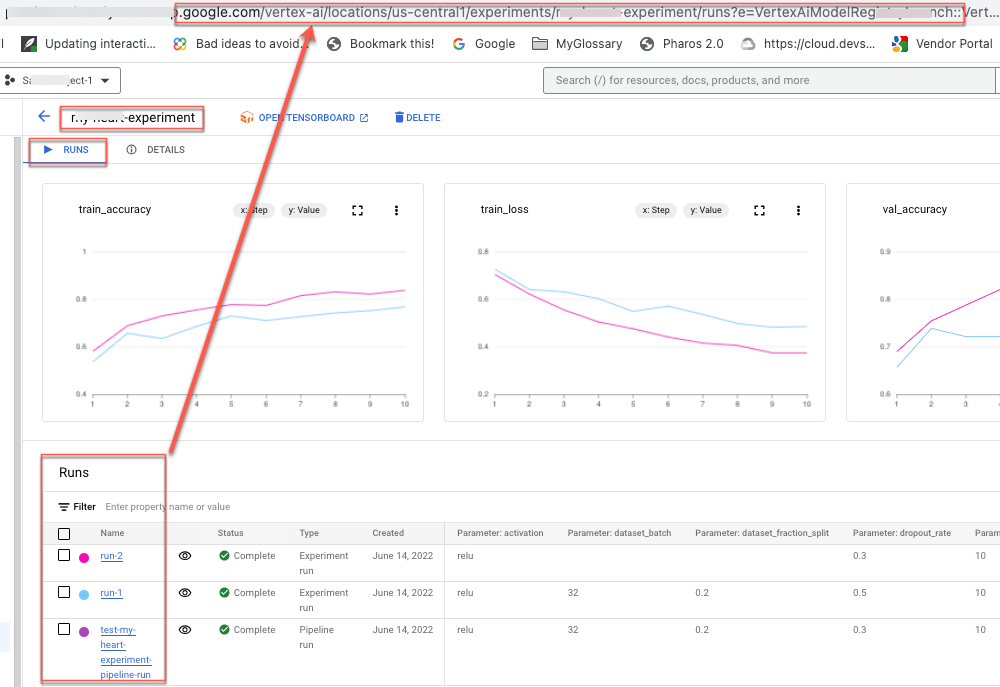

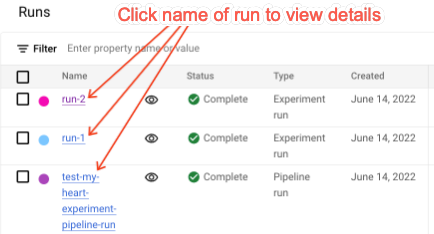

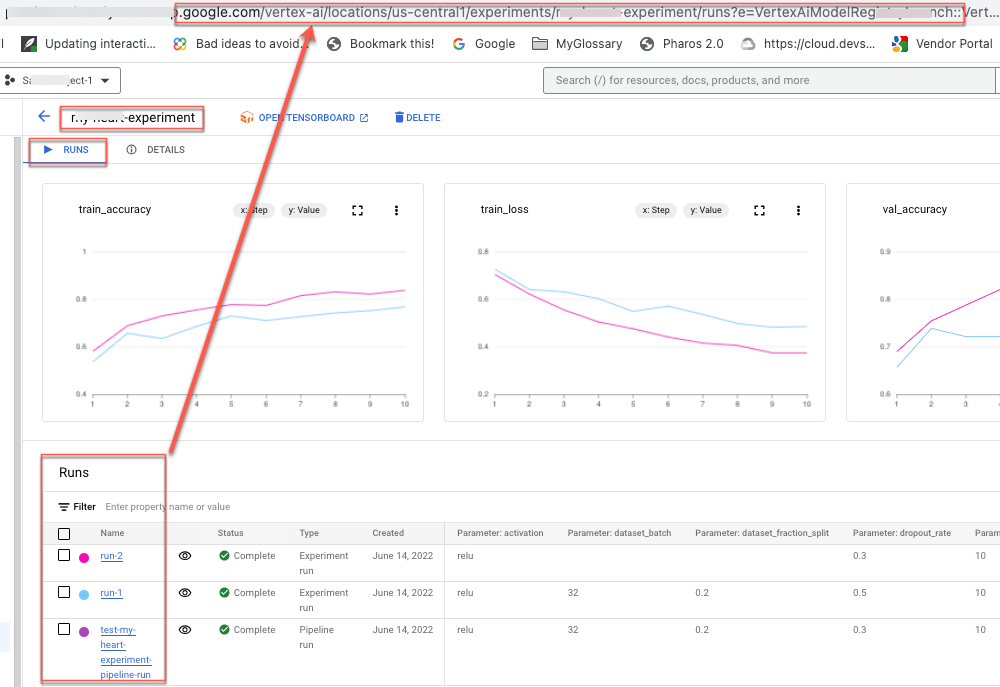

- Selecione o experimento que contém a execução que você quer verificar.

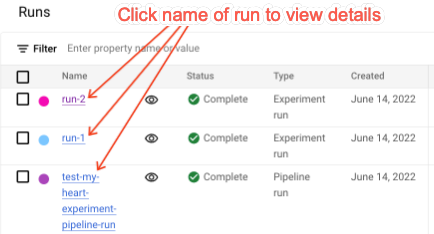

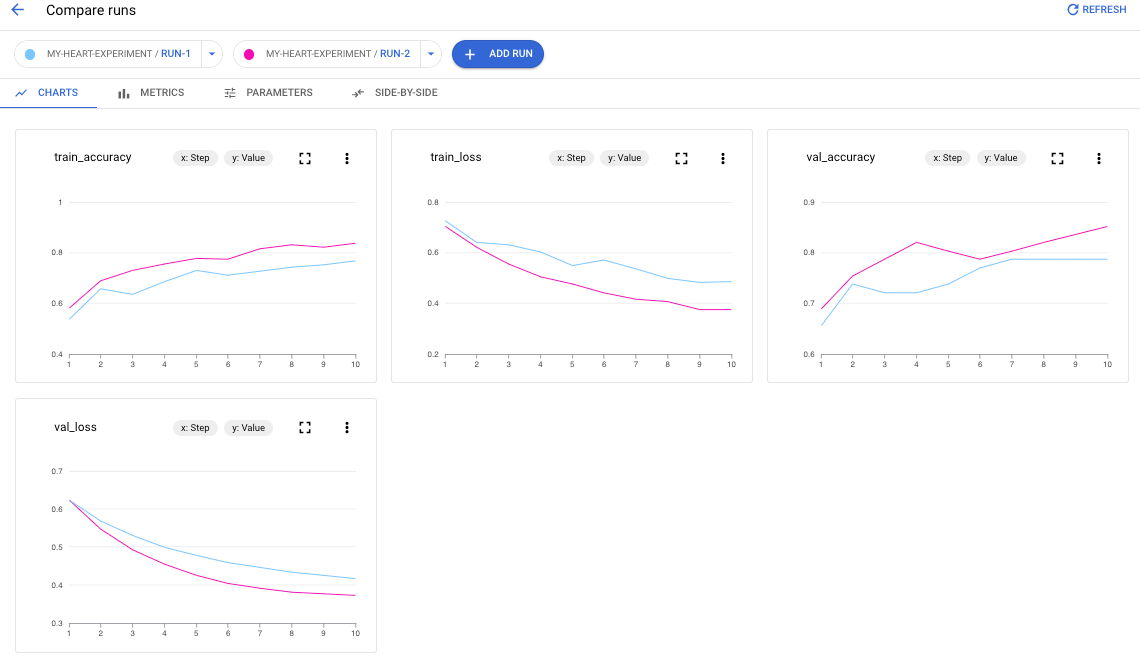

Uma lista de execuções, gráficos de dados de série temporal e uma tabela de dados de métricas e parâmetros são exibidos. Nesse caso, três execuções são selecionadas, mas apenas duas linhas aparecem nos gráficos de dados de série temporal.

Não há terceira linha porque a terceira execução do experimento não contém dados de séries temporais para exibir.

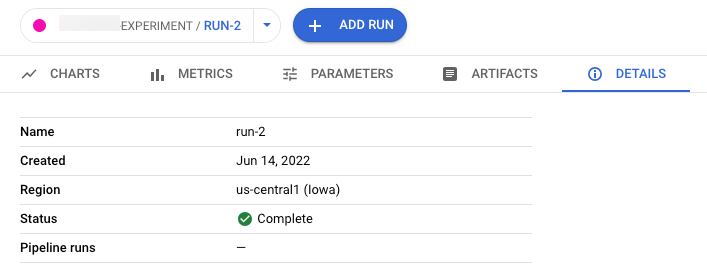

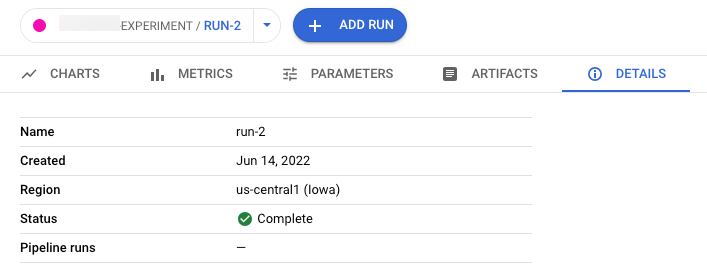

- Clique no nome da execução para acessar a página de detalhes.

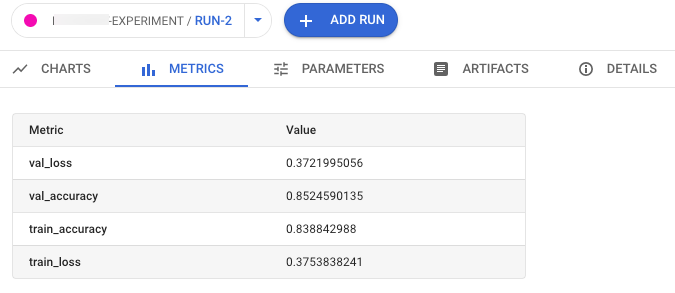

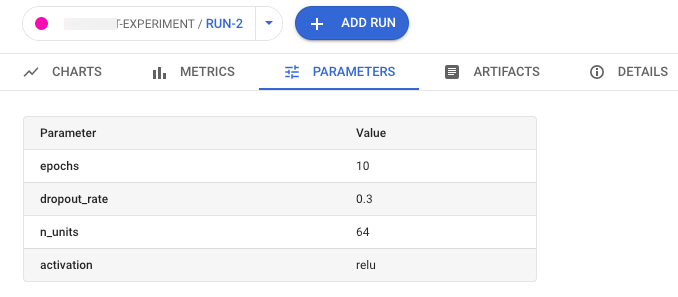

Os gráficos de dados da barra de navegação e da série temporal são exibidos.

- Para visualizar métricas, parâmetros, artefatos e detalhes da execução selecionada, clique nos respectivos botões na barra de navegação.

- Métricas

- Parâmetros

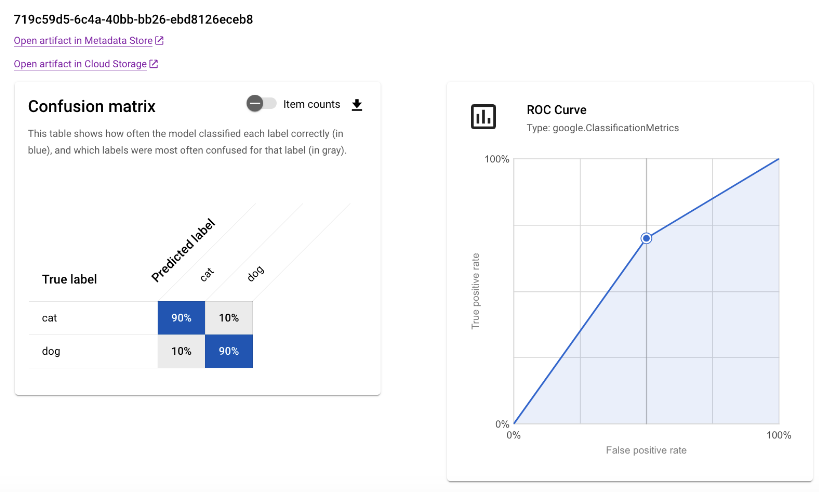

- Artefatos

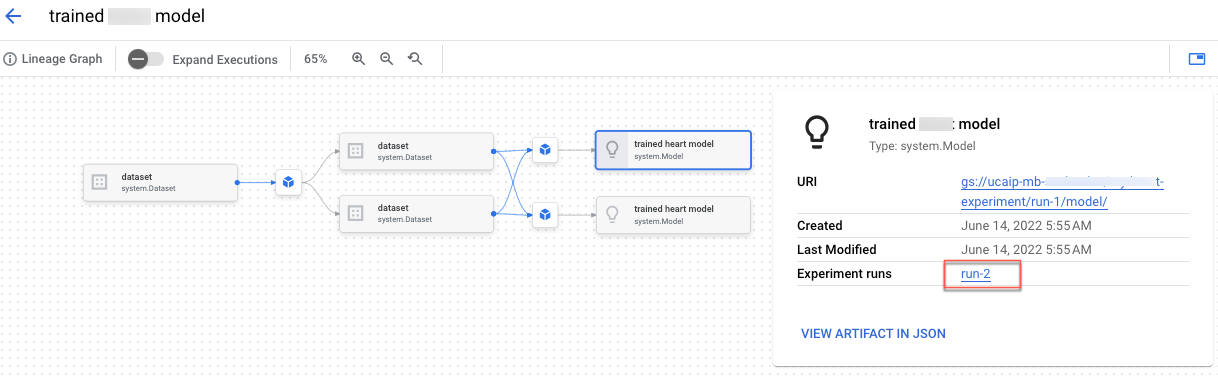

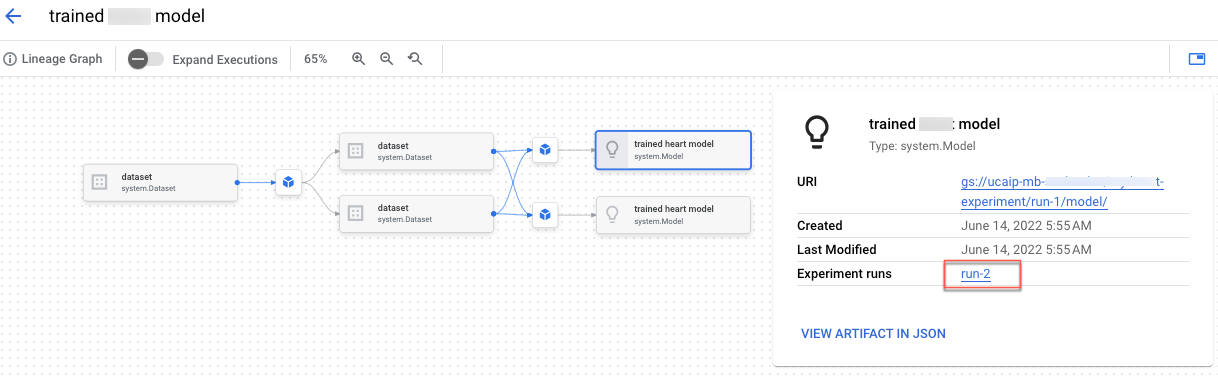

Para ver a linhagem do artefato, clique no link Abrir artefato no armazenamento de metadados. O gráfico de linhagem associado à execução é exibido.

- Detalhes

Para compartilhar os dados com outras pessoas, use os URLs associados às vistas. Por exemplo, compartilhe a lista de execuções associadas a uma experiência:

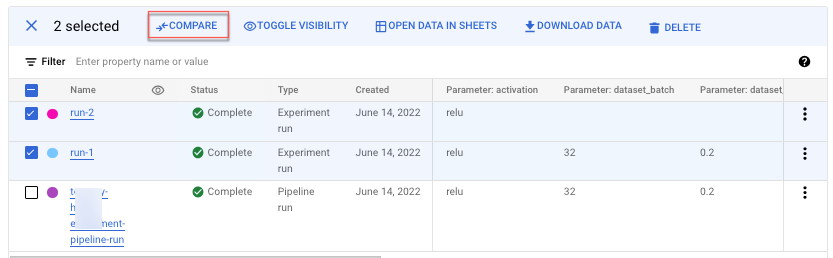

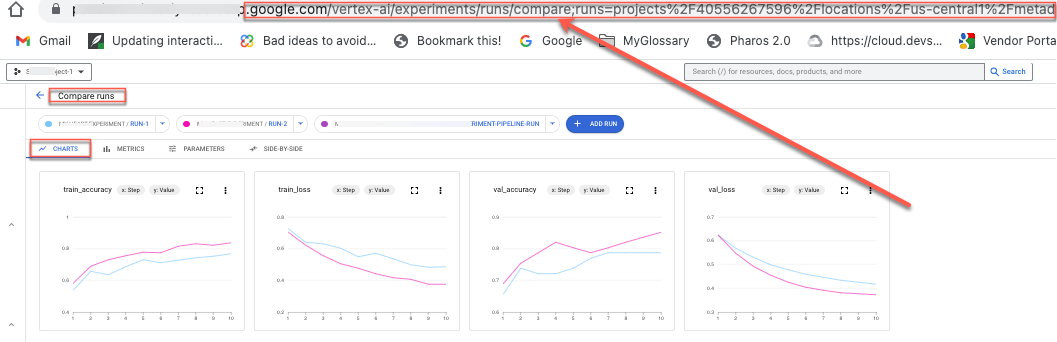

Comparar execuções de experimentos

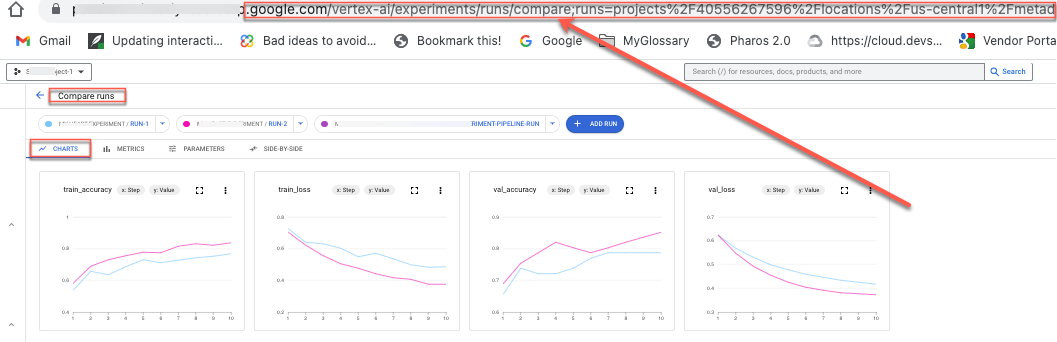

Você pode selecionar execuções para comparar dentro de uma experiência e entre as experiências.

- No console do Google Cloud , acesse a página Experimentos.

Acessar os Experimentos.

Uma lista de experimentos será exibida.

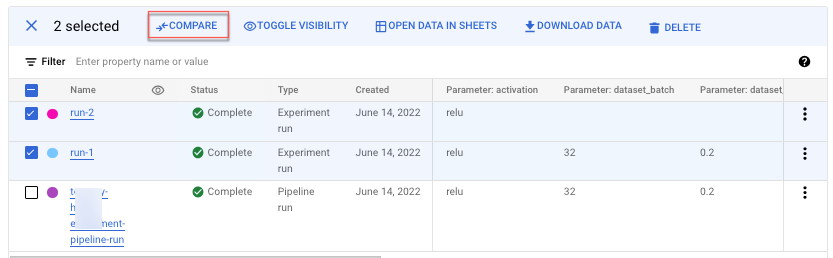

- Selecione o experimento que contém a execução que você quer comparar. Uma lista de execuções será exibida.

- Selecione as execuções que você quer comparar. Clique em Comparar.

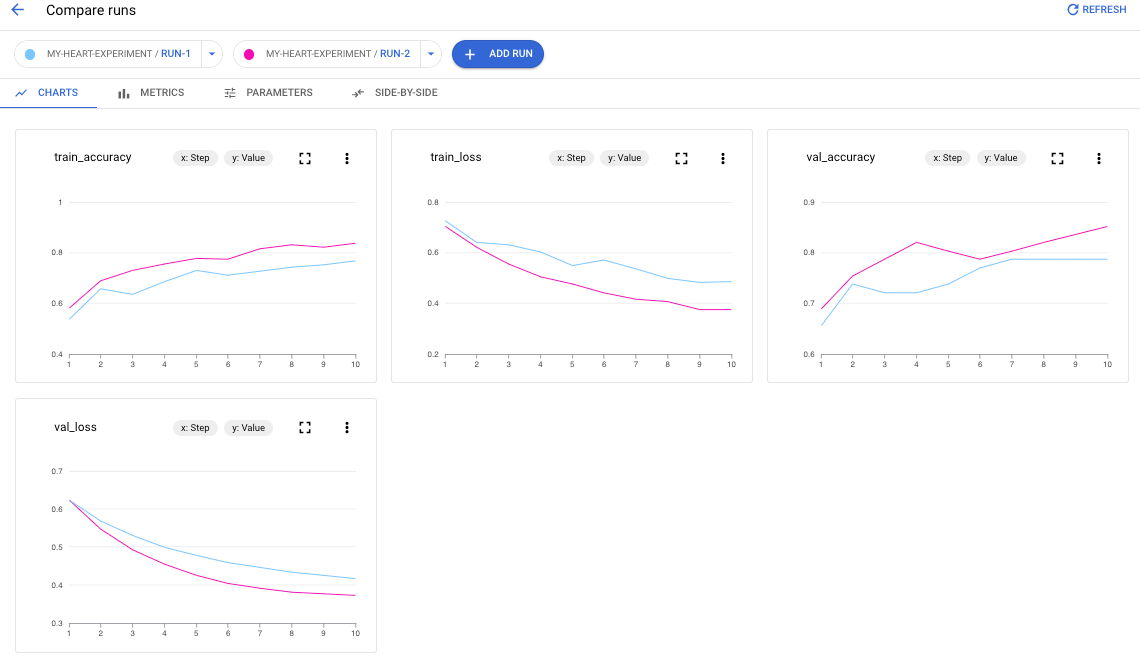

Por padrão, os gráficos são exibidos com a comparação das métricas de série temporal das execuções selecionadas do experimento.

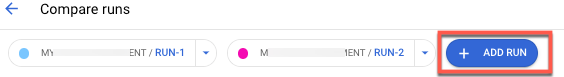

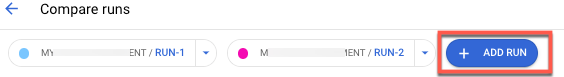

- Para adicionar execuções a partir de qualquer experimento no seu projeto, clique em Adicionar execução.

Para compartilhar os dados com outras pessoas, use os URLs associados às vistas. Por exemplo, compartilhe a visualização de comparação de dados de métricas de série temporal:

Consulte Criar e gerenciar execuções de experimentos para saber como atualizar o status de uma execução.

A seguir

Exceto em caso de indicação contrária, o conteúdo desta página é licenciado de acordo com a Licença de atribuição 4.0 do Creative Commons, e as amostras de código são licenciadas de acordo com a Licença Apache 2.0. Para mais detalhes, consulte as políticas do site do Google Developers. Java é uma marca registrada da Oracle e/ou afiliadas.

Última atualização 2025-09-10 UTC.

[[["Fácil de entender","easyToUnderstand","thumb-up"],["Meu problema foi resolvido","solvedMyProblem","thumb-up"],["Outro","otherUp","thumb-up"]],[["Difícil de entender","hardToUnderstand","thumb-down"],["Informações incorretas ou exemplo de código","incorrectInformationOrSampleCode","thumb-down"],["Não contém as informações/amostras de que eu preciso","missingTheInformationSamplesINeed","thumb-down"],["Problema na tradução","translationIssue","thumb-down"],["Outro","otherDown","thumb-down"]],["Última atualização 2025-09-10 UTC."],[],[],null,["# Compare and analyze runs\n\nYou can use the Vertex AI SDK for Python to view Vertex AI Experiments\nruns data and compare the runs.\n\n- [Get runs data](/vertex-ai/docs/experiments/compare-analyze-runs#api-analyze-runs)\n- [Compare runs](/vertex-ai/docs/experiments/compare-analyze-runs#api-compare-runs)\n\nThe Google Cloud console provides a visualization of the data\nassociated with these runs.\n\n- [View experiment run data](/vertex-ai/docs/experiments/compare-analyze-runs#view-experiment-run-data)\n- [Compare experiment runs](/vertex-ai/docs/experiments/compare-analyze-runs#compare-experiment-runs)\n\nGet experiment runs data\n------------------------\n\nThese samples involve getting run metrics, run parameters, runtime series\nmetrics, artifacts, and classification metrics for a particular experiment run. \n\n### Summary metrics\n\n### Python\n\n from typing import Dict, Union\n\n from google.cloud import aiplatform\n\n\n def get_experiment_run_metrics_sample(\n run_name: str,\n experiment: Union[str, aiplatform.Experiment],\n project: str,\n location: str,\n ) -\u003e Dict[str, Union[float, int]]:\n experiment_run = aiplatform.ExperimentRun(\n run_name=run_name, experiment=experiment, project=project, location=location\n )\n\n return experiment_run.get_metrics()\n\n- `run_name`: Specify the appropriate run name for this session.\n- `experiment`: The name or instance of this experiment. You can find your list of experiments in the Google Cloud console by selecting **Experiments** in the section nav.\n- `project`: . You can find these in the Google Cloud console [welcome](https://console.cloud.google.com/welcome) page.\n- `location`: See [List of available locations](/vertex-ai/docs/general/locations).\n\n### Parameters\n\n### Python\n\n from typing import Dict, Union\n\n from google.cloud import aiplatform\n\n\n def get_experiment_run_params_sample(\n run_name: str,\n experiment: Union[str, aiplatform.Experiment],\n project: str,\n location: str,\n ) -\u003e Dict[str, Union[float, int, str]]:\n experiment_run = aiplatform.ExperimentRun(\n run_name=run_name, experiment=experiment, project=project, location=location\n )\n\n return experiment_run.get_params()\n\n- `run_name`: Specify the appropriate run name for this session.\n- `experiment`: The name or instance of this experiment. You can find your list of experiments in the Google Cloud console by selecting **Experiments** in the section nav.\n- `project`: . You can find these in the Google Cloud console [welcome](https://console.cloud.google.com/welcome) page.\n- `location`: See [List of available locations](/vertex-ai/docs/general/locations).\n\n### Time series metrics\n\n### Python\n\n from typing import Union\n\n from google.cloud import aiplatform\n\n\n def get_experiment_run_time_series_metric_data_frame_sample(\n run_name: str,\n experiment: Union[str, aiplatform.Experiment],\n project: str,\n location: str,\n ) -\u003e \"pd.DataFrame\": # noqa: F821\n experiment_run = aiplatform.ExperimentRun(\n run_name=run_name, experiment=experiment, project=project, location=location\n )\n\n return experiment_run.get_time_series_data_frame()\n\n- `run_name`: Specify the appropriate run name for this session.\n- `experiment`: The name or instance of this experiment. You can find your list of experiments in the Google Cloud console by selecting **Experiments** in the section nav.\n- `project`: . You can find these in the Google Cloud console [welcome](https://console.cloud.google.com/welcome) page.\n- `location`: See [List of available locations](/vertex-ai/docs/general/locations).\n\n### Artifacts\n\n### Python\n\n from typing import List, Union\n\n from google.cloud import aiplatform\n from google.cloud.aiplatform.metadata import artifact\n\n\n def get_experiment_run_artifacts_sample(\n run_name: str,\n experiment: Union[str, aiplatform.Experiment],\n project: str,\n location: str,\n ) -\u003e List[artifact.Artifact]:\n experiment_run = aiplatform.ExperimentRun(\n run_name=run_name,\n experiment=experiment,\n project=project,\n location=location,\n )\n\n return experiment_run.get_artifacts()\n\n- `run_name`: Specify the appropriate run name for this session.\n- `experiment`: The name or instance of this experiment. You can find your list of experiments in the Google Cloud console by selecting **Experiments** in the section nav.\n- `project`: . You can find these in the Google Cloud console [welcome](https://console.cloud.google.com/welcome) page.\n- `location`: See [List of available locations](/vertex-ai/docs/general/locations).\n\n### Classification metrics\n\n### Python\n\n from typing import Dict, List, Union\n\n from google.cloud import aiplatform\n\n\n def get_experiment_run_classification_metrics_sample(\n run_name: str,\n experiment: Union[str, aiplatform.Experiment],\n project: str,\n location: str,\n ) -\u003e List[Dict[str, Union[str, List]]]:\n experiment_run = aiplatform.ExperimentRun(\n run_name=run_name, experiment=experiment, project=project, location=location\n )\n\n return experiment_run.get_classification_metrics()\n\n- `run_name`: Specify the appropriate run name for this session.\n- `experiment`: The name or instance of this experiment. You can find your list of experiments in the Google Cloud console by selecting **Experiments** in the section nav.\n- `project`: . You can find these in the Google Cloud console [welcome](https://console.cloud.google.com/welcome) page.\n- `location`: See [List of available locations](/vertex-ai/docs/general/locations).\n\nCompare runs\n------------\n\nUsing the Vertex AI SDK for Python, you can retrieve the data associated with\nyour experiment. The data for the experiment runs is returned in a DataFrame. \n\n### Compare runs\n\n\nThe data for the experiment runs is returned in a DataFrame.\n\n### Python\n\n from google.cloud import aiplatform\n\n\n def get_experiments_data_frame_sample(\n experiment: str,\n project: str,\n location: str,\n ):\n aiplatform.init(experiment=experiment, project=project, location=location)\n\n experiments_df = aiplatform.get_experiment_df()\n\n return experiments_df\n\n- `experiment_name`: Provide a name for the experiment. You can find your list of experiments in the Google Cloud console by selecting **Experiments** in the section nav.\n- `project`: . You can find these IDs in the Google Cloud console [welcome](https://console.cloud.google.com/welcome) page.\n- `location`: See [List of available locations](/vertex-ai/docs/general/locations).\n\nGoogle Cloud console\n--------------------\n\nUse the Google Cloud console to view details of your\n\nand compare the experiment runs to each other.\n\n### View experiment run data\n\n1. In the Google Cloud console, go to the **Experiments** page. \n [Go to Experiments](https://console.cloud.google.com/vertex-ai/experiments). \n A list of experiments associated with a project appears.\n2. Select the experiment containing the run that you want to check. \n A list of runs, timeseries data charts, and a metrics and parameters data table appear. Notice, in this case, three runs are selected, but only two lines appear in the timeseries data charts. There is no third line because the third experiment run does not have any timeseries data to display. \n\n3. Click the name of the run to navigate to its details page. \n\n The navigation bar and timeseries data charts appear. \n4. To view metrics, parameters, artifacts, and details for your selected run, click the respective buttons in the navigation bar.\n - Metrics \n - Parameters \n - Artifacts \n\n To view artifact lineage, click the **Open artifact in Metadata Store** link. The lineage graph associated with the run appears. \n - Details \n\nTo share the data with others, use the URLs associated with the views. For example, share\nthe list of experiment runs associated with an experiment:\n\n### Compare experiment runs\n\nYou can select runs to compare both within an experiment and across experiments.\n\n1. In the Google Cloud console, go to the **Experiments** page. \n [Go to Experiments](https://console.cloud.google.com/vertex-ai/experiments). \n A list of experiments appears.\n2. Select the experiment containing the runs that you want to compare. A list of runs appears.\n3. Select the experiment runs that you want to compare. Click **Compare** . \n\n By default, charts appear comparing timeseries metrics of the selected experiment runs.\n4. To add additional runs from any experiment in your project, click **Add run** .\n\nTo share the data with others, use the URLs associated with the views. For example, share\nthe comparison view of timeseries metrics data:\n\n\nSee [Create and manage experiment runs](/vertex-ai/docs/experiments/create-manage-exp-run)\nfor how to update the status of a run.\n\nWhat's next\n-----------\n\n- [Track executions and artifacts](/vertex-ai/docs/experiments/track-executions-artifacts)"]]