Mit dem Vertex AI SDK für Python können Sie die Ausführungsdaten von Vertex AI Experiments aufrufen und die Ausführungen vergleichen.

Die Google Cloud Console bietet eine Visualisierung der Daten, die mit diesen Ausführungen verknüpft sind.

Daten der Testausführungen abrufen

Diese Beispiele umfassen Ausführungsmesswerte, Ausführungsparameter, Laufzeitserien, Artefakte und Klassifizierungsmesswerte für eine bestimmte Testausführung.

Zusammenfassende Messwerte

Python

run_name: Geben Sie den entsprechenden Ausführungsnamen für diese Sitzung an.experiment: Der Name oder die Instanz dieses Tests. Sie können die Liste der Tests in der Google Cloud Console aufrufen. Wählen Sie dazu im Bereich „Navigation“ die Option Tests aus.project: . Sie finden sie auf der Google Cloud Console-Begrüßungsseite.location: Siehe Liste der verfügbaren Standorte.

Parameter

Python

run_name: Geben Sie den entsprechenden Ausführungsnamen für diese Sitzung an.experiment: Der Name oder die Instanz dieses Tests. Sie können die Liste der Tests in der Google Cloud Console aufrufen. Wählen Sie dazu im Bereich „Navigation“ die Option Tests aus.project: . Sie finden sie auf der Google Cloud Console-Begrüßungsseite.location: Siehe Liste der verfügbaren Standorte.

Zeitachsenmesswerte

Python

run_name: Geben Sie den entsprechenden Ausführungsnamen für diese Sitzung an.experiment: Der Name oder die Instanz dieses Tests. Sie können die Liste der Tests in der Google Cloud Console aufrufen. Wählen Sie dazu im Bereich „Navigation“ die Option Tests aus.project: . Sie finden sie auf der Google Cloud Console-Begrüßungsseite.location: Siehe Liste der verfügbaren Standorte.

Artefakte

Python

run_name: Geben Sie den entsprechenden Ausführungsnamen für diese Sitzung an.experiment: Der Name oder die Instanz dieses Tests. Sie können die Liste der Tests in der Google Cloud Console aufrufen. Wählen Sie dazu im Bereich „Navigation“ die Option Tests aus.project: . Sie finden sie auf der Google Cloud Console-Begrüßungsseite.location: Siehe Liste der verfügbaren Standorte.

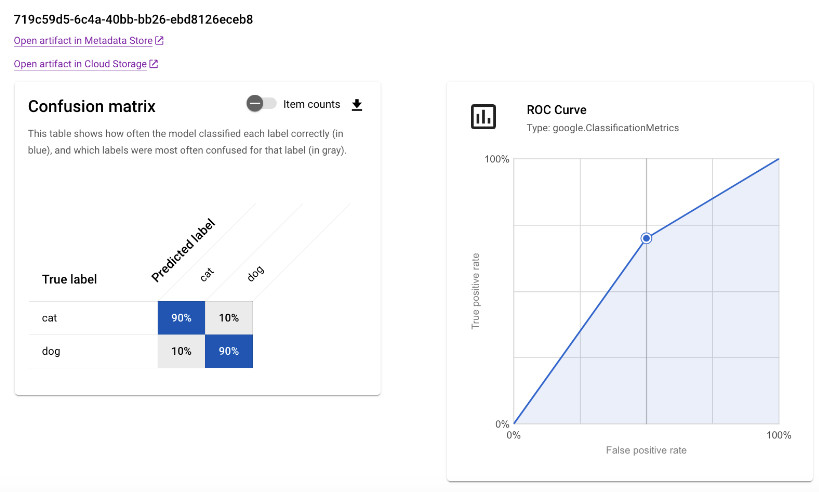

Klassifizierungsmesswerte

Python

run_name: Geben Sie den entsprechenden Ausführungsnamen für diese Sitzung an.experiment: Der Name oder die Instanz dieses Tests. Sie können die Liste der Tests in der Google Cloud Console aufrufen. Wählen Sie dazu im Bereich „Navigation“ die Option Tests aus.project: . Sie finden sie auf der Google Cloud Console-Begrüßungsseite.location: Siehe Liste der verfügbaren Standorte.

Ausführungen vergleichen

Mit dem Vertex AI SDK für Python können Sie die mit Ihrem Test verknüpften Daten abrufen. Die Daten für die Testausführungen werden in einem DataFrame zurückgegeben.

Ausführungen vergleichen

Die Daten für die Testausführungen werden in einem DataFrame zurückgegeben.

Python

experiment_name: Geben Sie einen Namen für den Test ein. Sie können die Liste der Tests in der Google Cloud Console aufrufen. Wählen Sie dazu im Bereich „Navigation“ die Option Tests aus.project: . Sie finden diese IDs auf der Begrüßungsseite der Google Cloud Console.location: Siehe Liste der verfügbaren Standorte.

Google Cloud console

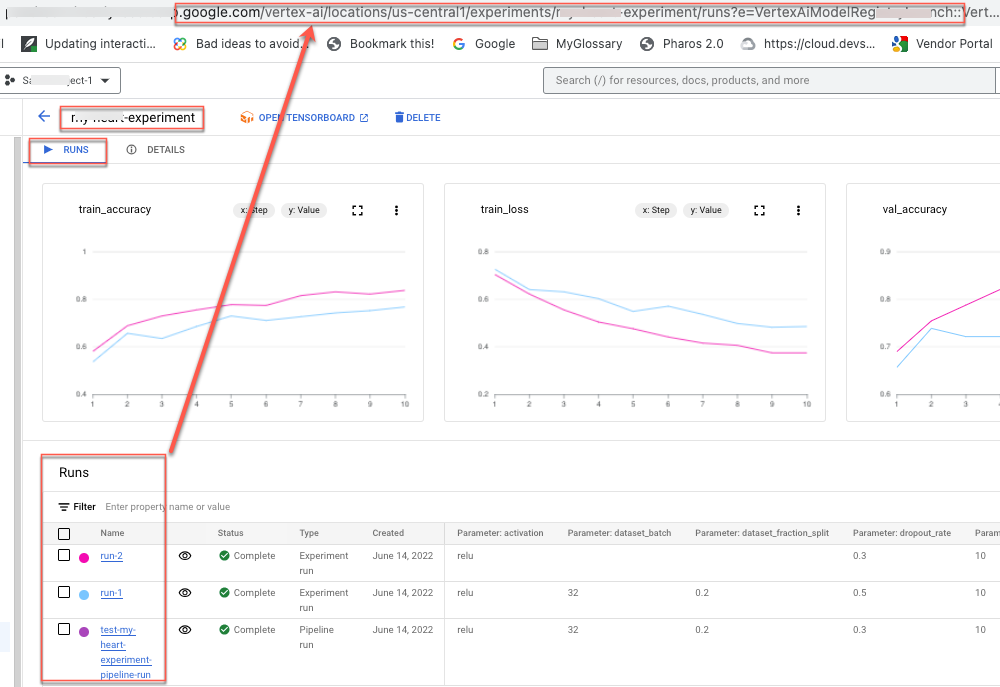

Verwenden Sie die Google Cloud Console, um Details zu Ihren Testausführungen aufzurufen und die Testausführungen miteinander zu vergleichen.

Daten der Testausführung aufrufen

- Rufen Sie in der Google Cloud Console die Seite Tests auf.

Zu Tests.

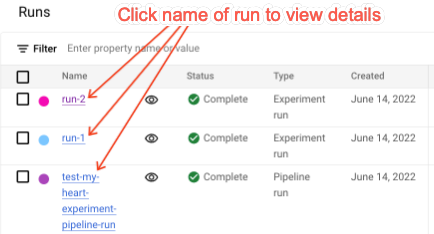

Eine Liste der mit einem Projekt verknüpften Tests wird angezeigt. - Wählen Sie den Test mit der Ausführung aus, die Sie prüfen möchten.

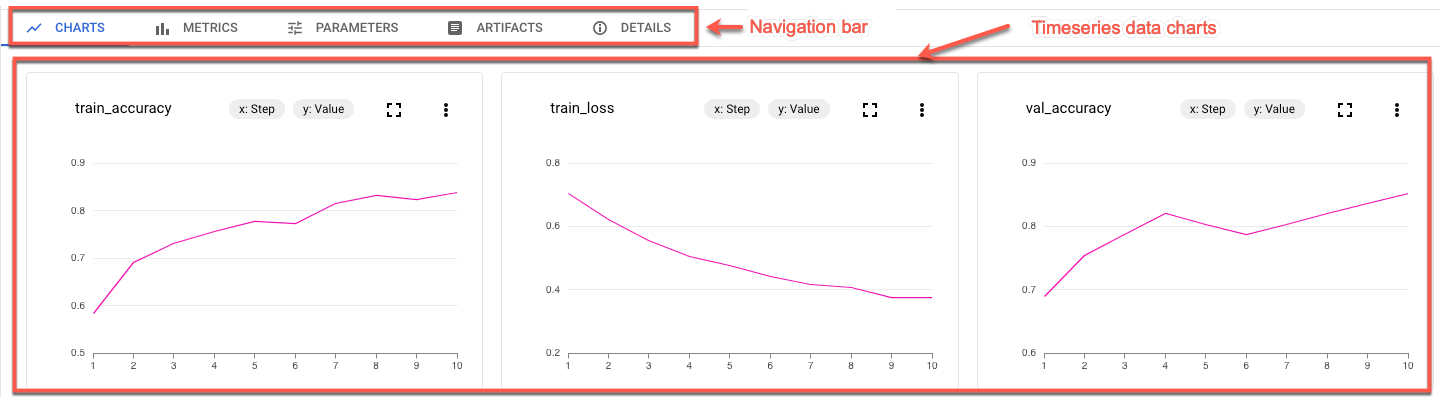

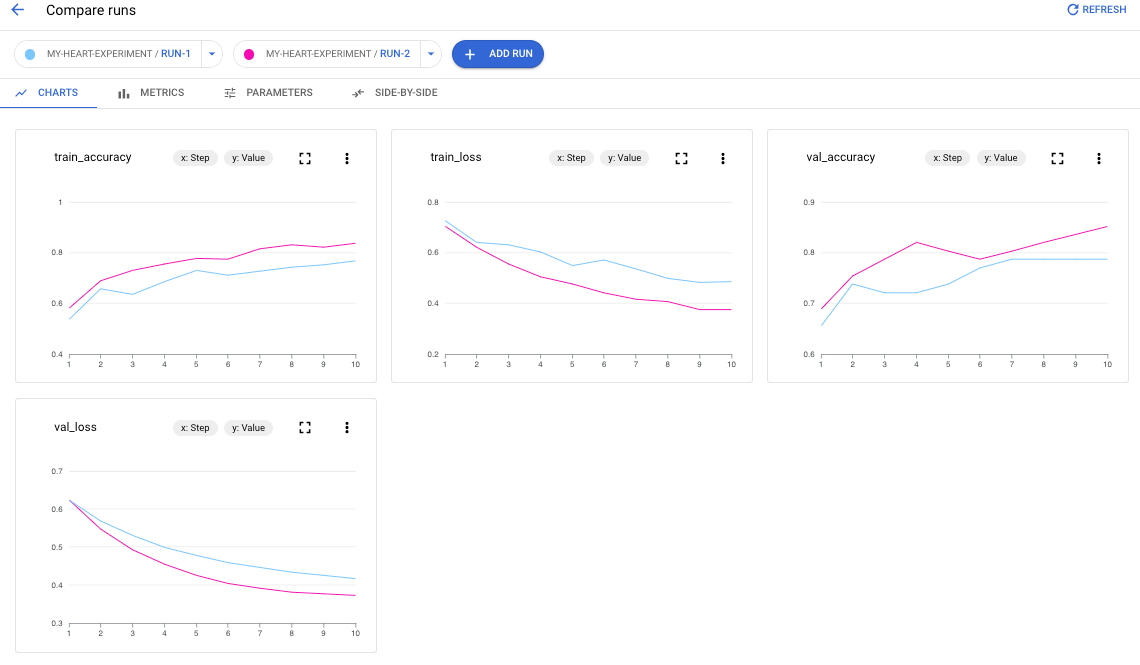

Eine Liste der Ausführungen, Zeitachsendaten-Diagramme sowie eine Tabelle der Messwerte und Datenparameter werden angezeigt. Beachten Sie, dass in diesem Fall drei Ausführungen ausgewählt werden, aber nur zwei Linien in den Zeitachsendaten-Diagrammen angezeigt werden. Es gibt keine dritte Linie, da der dritte Testlauf keine Zeitachsendaten enthält, die angezeigt werden können.

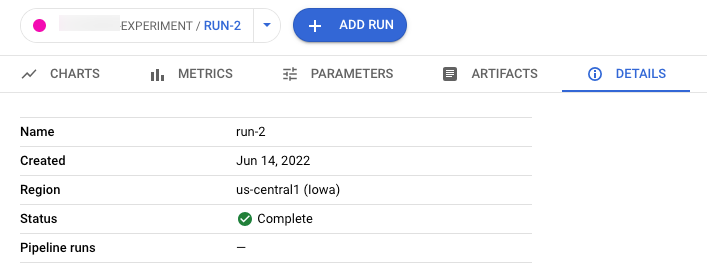

- Klicken Sie auf den Namen der Ausführung, um zur zugehörigen Detailseite zu wechseln.

Die Navigationsleisten und Zeitachsendiagramme werden angezeigt.

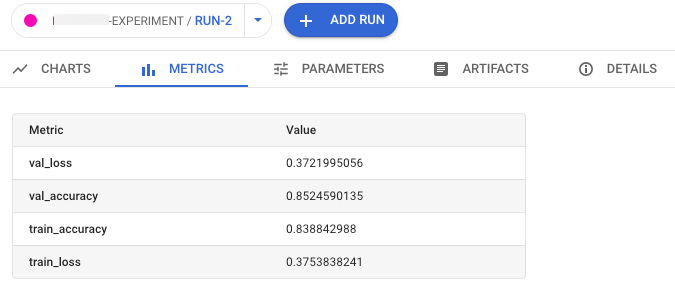

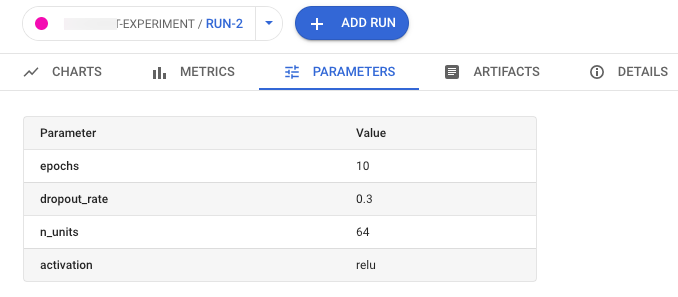

- Klicken Sie auf die entsprechenden Schaltflächen in der Navigationsleiste, um Messwerte, Parameter, Artefakte und Details für die ausgewählte Ausführung aufzurufen.

- Messwerte

- Parameter

- Artefakte

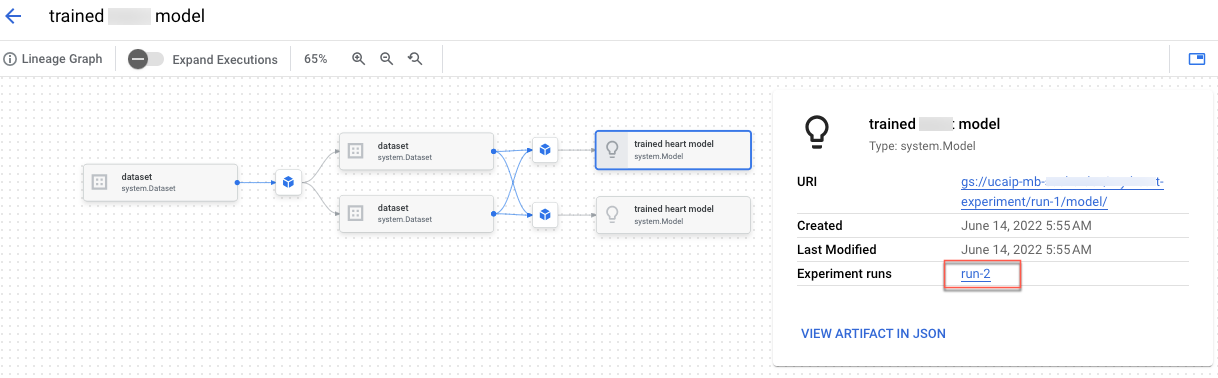

Klicken Sie auf den Link Artefakt im Metadatenspeicher öffnen, um das Herkunftsdiagramm des Artefakts aufzurufen. Das mit der Ausführung verknüpfte Herkunftsdiagramm angezeigt.

- Details

- Messwerte

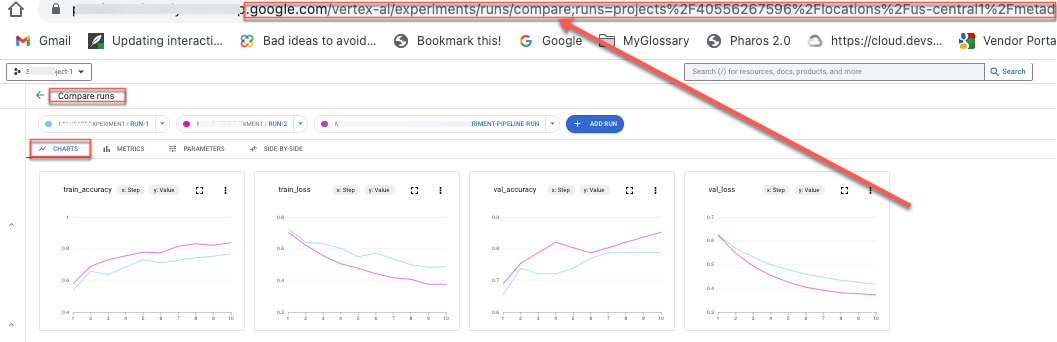

Verwenden Sie die URLs, die mit den Ansichten verknüpft sind, um die Daten für andere freizugeben. Geben Sie beispielsweise die Liste der mit einem Test verknüpften Testausführungen frei:

Testausführungen vergleichen

Sie können Ausführungen auswählen, um sie sowohl innerhalb eines Tests als auch über mehrere Tests hinweg zu vergleichen.

- Rufen Sie in der Google Cloud Console die Seite Tests auf.

Zu Tests.

Eine Liste der Tests wird angezeigt. - Wählen Sie den Test mit den Ausführungen aus, die Sie vergleichen möchten. Es wird eine Liste der Ausführungen angezeigt.

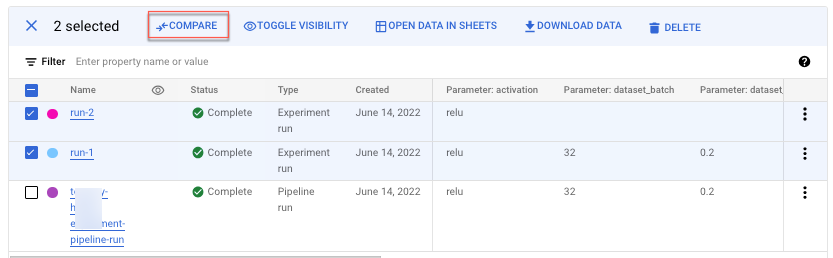

- Wählen Sie die Testausführungen aus, die Sie miteinander vergleichen möchten. Klicken Sie auf Vergleichen.

Standardmäßig werden Diagramme angezeigt, in denen Zeitreihenmesswerte der ausgewählten Testläufe verglichen werden.

- Klicken Sie auf Ausführung hinzufügen, um weitere Ausführungen aus einem beliebigen Test in Ihrem Projekt hinzuzufügen.

Verwenden Sie die URLs, die mit den Ansichten verknüpft sind, um die Daten für andere freizugeben. Teilen Sie beispielsweise die Vergleichsansicht von Zeitreihen-Messwertdaten:

Informationen zum Aktualisieren des Ausführungsstatus finden Sie unter Testausführungen erstellen und verwalten.