Anda dapat menggunakan Google Cloud konsol atau Vertex AI SDK untuk Python guna menambahkan operasi pipeline ke eksperimen atau operasi eksperimen.

Google Cloud console

Gunakan petunjuk berikut untuk menjalankan pipeline ML dan mengaitkan pipeline tersebut dengan suatu eksperimen dan, secara opsional, operasi eksperimen menggunakan konsol Google Cloud . Operasi eksperimen hanya dapat dibuat melalui Vertex AI SDK untuk Python (lihat Membuat dan mengelola operasi eksperimen).- Di konsol Google Cloud , di bagian Vertex AI, buka

halaman Pipelines.

Buka Pipelines - Di menu drop-down Region, pilih region tempat Anda ingin membuat pipeline yang akan dijalankan.

- Klik Create run untuk membuka panel Create pipeline run.

- Tentukan detail Run berikut.

- Di kolom File, klik Choose untuk membuka pemilih file. Buka file JSON pipeline yang dikompilasi yang ingin Anda jalankan, pilih pipeline, lalu klik Open.

- Pipeline name secara default ditetapkan ke nama yang Anda tentukan dalam definisi pipeline. Atau, tentukan Pipeline name yang berbeda.

- Tentukan Run name untuk mengidentifikasi operasi pipeline ini secara unik.

- Untuk menentukan bahwa operasi pipeline ini menggunakan akun layanan kustom, kunci enkripsi yang dikelola pelanggan, atau jaringan VPC yang di-peering, klik Advanced options (Opsional).

Gunakan petunjuk berikut untuk mengonfigurasi opsi lanjutan seperti akun layanan khusus.- Untuk menentukan akun layanan, pilih akun layanan dari menu drop-down Service account.

Jika Anda tidak menentukan akun layanan, Vertex AI Pipelines akan menjalankan pipeline Anda menggunakan akun layanan Compute Engine default.

Pelajari lebih lanjut cara mengonfigurasi akun layanan untuk digunakan dengan Vertex AI Pipelines. - Untuk menggunakan kunci enkripsi yang dikelola pelanggan (CMEK), pilih Use a customer-managed encryption key. Menu drop-down Select a customer-managed key akan muncul. Di menu drop-down Select a customer-managed key, pilih kunci yang ingin Anda gunakan.

- Untuk menggunakan jaringan VPC yang di-peering dalam operasi pipeline ini, masukkan nama jaringan VPC di kotak Peered VPC network.

- Untuk menentukan akun layanan, pilih akun layanan dari menu drop-down Service account.

- Klik Continue.

Lokasi Cloud Storage dan panel Pipeline parameters akan muncul. - Wajib: Masukkan direktori output Cloud Storage, misalnya: gs://location_of_directory.

- Opsional: Tentukan parameter yang ingin Anda gunakan untuk operasi pipeline ini.

- Klik Submit untuk membuat operasi pipeline.

- Setelah dikirimkan, Pipeline akan muncul di tabel konsol Google Cloud Pipeline.

- Di baris yang terkait dengan pipeline Anda, klik View more > Add to Experiment

- Pilih Eksperimen yang ada atau buat Eksperimen baru.

- Opsional: Jika eksperimen yang dijalankan terkait dengan Eksperimen, eksperimen tersebut muncul di menu drop-down. Pilih operasi Eksperimen yang ada.

- Klik Simpan.

Membandingkan operasi pipeline dengan eksperimen yang dijalankan menggunakan Google Cloud konsol

- Di konsol Google Cloud , buka halaman Experiments.

Buka Eksperimen.

Daftar eksperimen akan muncul di halaman Experiments. - Pilih eksperimen yang ingin Anda tambahkan operasi pipeline.

Daftar operasi akan muncul. - Pilih operasi yang ingin dibandingkan, lalu klik Compare

- Klik tombol Add run. Daftar operasi akan muncul

- Pilih operasi pipeline yang ingin Anda tambahkan. Operasi ditambahkan.

Vertex AI SDK for Python {:#sdk-add-pipeline-run}

Contoh berikut menggunakan PipelineJob API.

Mengaitkan operasi pipeline dengan eksperimen

Contoh ini menunjukkan cara mengaitkan operasi pipeline dengan eksperimen. Jika ingin membandingkan operasi Pipeline, Anda harus mengaitkan operasi pipeline ke eksperimen. Lihat

init

di dokumentasi referensi Vertex AI SDK untuk Python.

Python

experiment_name: Berikan nama untuk eksperimen Anda. Anda dapat menemukan daftar eksperimen di konsol Google Cloud dengan memilih Experiments di navigasi bagian.pipeline_job_display_name: Nama yang ditentukan pengguna untuk Pipeline ini.template_path: Jalur file PipelineJob atau PipelineSpec JSON atau YAML. Ini dapat berupa jalur lokal atau Cloud Storage URI. Contoh: "gs://project.name"pipeline_root: Root output pipeline. Setelan defaultnya adalah bucket staging.parameter_values: Pemetaan dari nama parameter runtime ke nilainya yang mengontrol operasi pipeline.project: . Anda dapat menemukan ID ini di halaman sambutan Google Cloud console.location: Lihat Daftar lokasi yang tersedia.

Mengaitkan operasi pipeline dengan operasi eksperimen

Contoh yang disediakan mencakup mengaitkan operasi pipeline dengan operasi eksperimen.

Kasus penggunaan:

- Saat melakukan pelatihan model lokal, lalu menjalankan evaluasi pada model tersebut (evaluasi dilakukan dengan menggunakan pipeline). Dalam hal ini, tulis metrik eval dari operasi pipeline ke ExperimentRun

- Saat menjalankan kembali pipeline yang sama beberapa kali. Misalnya, jika Anda mengubah parameter input, atau jika satu komponen gagal dan Anda perlu menjalankannya lagi.

Saat mengaitkan operasi pipeline dengan operasi eksperimen, parameter dan metrik tidak akan muncul secara otomatis dan perlu dicatat ke dalam log secara manual menggunakan API logging.

Catatan: Jika parameter resume opsional ditentukan sebagai TRUE, operasi yang dimulai sebelumnya akan dilanjutkan. Jika tidak ditentukan, resume ditetapkan secara default ke FALSE dan operasi baru akan dibuat.

Lihat init, start_run, dan log di dokumentasi referensi Vertex AI SDK untuk Python.

Python

experiment_name: Berikan nama untuk eksperimen Anda. Anda dapat menemukan daftar eksperimen di konsol Google Cloud dengan memilih Experiments di navigasi bagian.run_name: Tentukan nama operasi.pipeline_job: PipelineJob Vertex AIproject: . Anda dapat menemukannya di halaman sambutan konsol Google Cloud .location: Lihat Daftar lokasi yang tersedia

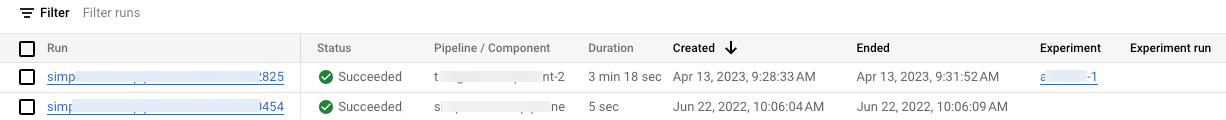

Melihat daftar operasi pipeline di konsol Google Cloud

Di konsol Google Cloud , di bagian Vertex AI, buka halaman Pipelines.

Periksa untuk memastikan Anda berada dalam project yang benar.

Daftar eksperimen dan operasi yang terkait dengan operasi pipeline project Anda akan muncul di kolom Experiment dan Experiment run.

Codelab

Mengoptimalkan Eksperimen: Mengelola Eksperimen Machine Learning dengan Vertex AI

Codelab ini melibatkan penggunaan Vertex AI untuk membangun pipeline yang melatih Model Keras kustom di TensorFlow. Eksperimen Vertex AI digunakan untuk melacak dan membandingkan operasi eksperimen guna mengidentifikasi kombinasi hyperparameter yang menghasilkan performa terbaik.