Vertex Explainable AI ofrece funciones de visualización integradas para tus datos de imagen. Puedes configurar visualizaciones para modelos de clasificación de imágenes de AutoML.

Cuando solicitas una explicación sobre un modelo de clasificación de imágenes, obtienes la clase predicha junto con una superposición de la imagen que muestra qué píxeles (degradados integrados) o regiones (degradados integrados o XRAI) han contribuido a la predicción.

En las siguientes imágenes se muestran visualizaciones en una imagen de un husky. La visualización de la izquierda usa el método de gradientes integrados y destaca las áreas de atribución positiva. La visualización de la derecha usa un método XRAI con un gradiente de color que indica las áreas de menor (azul) y mayor (amarillo) influencia a la hora de hacer una predicción positiva.

El tipo de datos con el que trabajes puede influir en si usas un enfoque de gradientes integrados o de XRAI para visualizar tus explicaciones.

- XRAI suele funcionar mejor con imágenes naturales y ofrece un mejor resumen de alto nivel de las estadísticas, como mostrar que la atribución positiva está relacionada con la forma de la cara de un perro.

- Los gradientes integrados (IG) suelen proporcionar detalles a nivel de píxel y son útiles para descubrir atribuciones más granulares.

Consulta más información sobre los métodos de atribución en la página de descripción general de Vertex Explainable AI.

Primeros pasos

Configura la visualización cuando entrenes un modelo de AutoML que admita Vertex Explainable AI y habilites las explicaciones al desplegar el modelo.

Opciones de visualización

Los ajustes predeterminados y recomendados dependen del método de atribución (degradados integrados o XRAI). En la siguiente lista se describen las opciones de configuración y cómo puede usarlas. Para ver una lista completa de opciones, consulta la referencia de la API del mensaje Visualization.

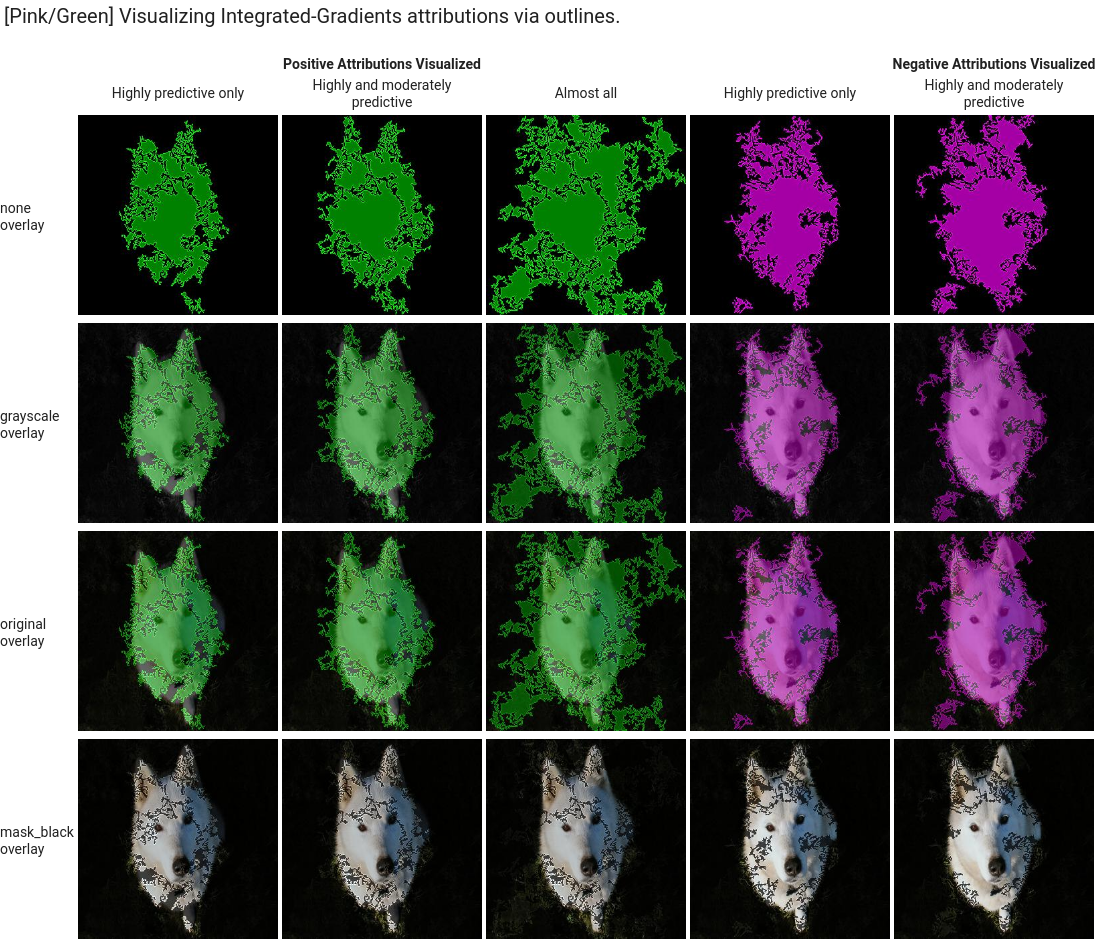

type: el tipo de visualización usado:OUTLINESoPIXELS. Solo debes especificar este campo si usas gradientes integrados. No puedes especificarlo si usas XRAI.En el caso de los gradientes integrados, el campo tiene el valor predeterminado

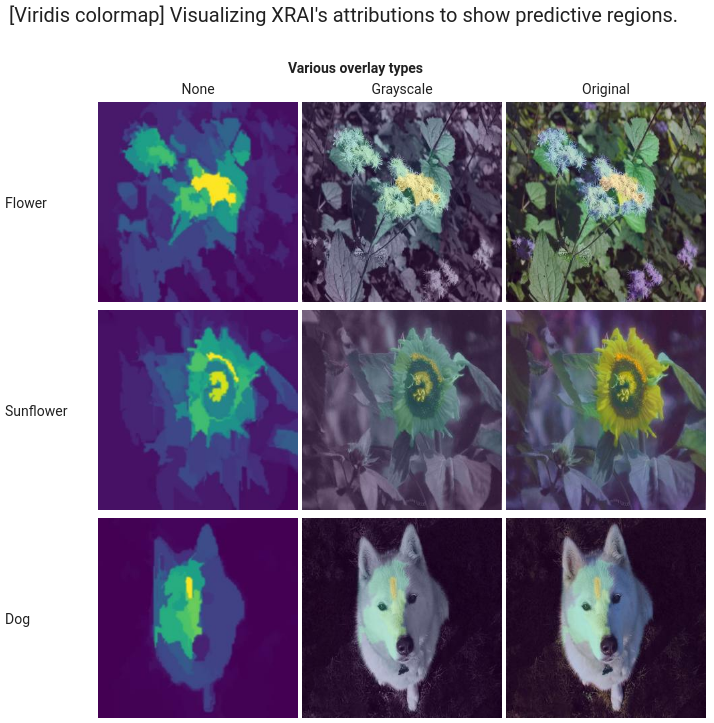

OUTLINES, que muestra las regiones de atribución. Para mostrar la atribución por píxel, asigna el valorPIXELSal campo.polarity: la direccionalidad de las atribuciones destacadas.positiveestá activada de forma predeterminada, lo que destaca las áreas con las atribuciones positivas más altas. Esto significa destacar los píxeles que han influido más en la predicción positiva del modelo. Si se asigna el valornegativea la polaridad, se resaltan las áreas que llevan al modelo a no predecir la clase positiva. Usar una polaridad negativa puede ser útil para depurar el modelo identificando regiones de falsos negativos. También puedes definir la polaridad enboth, que muestra las atribuciones positivas y negativas.clip_percent_upperbound: excluye las atribuciones por encima del percentil especificado de las áreas destacadas. Usar los parámetros de recorte juntos puede ser útil para filtrar el ruido y facilitar la identificación de las áreas con una atribución sólida.clip_percent_lowerbound: excluye las atribuciones por debajo del percentil especificado de las áreas resaltadas.color_map: el esquema de colores que se usa en las áreas destacadas. El valor predeterminado espink_greenpara los gradientes integrados, que muestra las atribuciones positivas en verde y las negativas en rosa. En las visualizaciones de XRAI, el mapa de colores es un gradiente. El valor predeterminado de XRAI esviridis, que destaca las regiones más influyentes en amarillo y las menos influyentes en azul.Para ver una lista completa de los valores posibles, consulta la referencia de la API del mensaje

Visualization.overlay_type: cómo se muestra la imagen original en la visualización. Ajustar la superposición puede ayudar a aumentar la claridad visual si la imagen original dificulta la visualización.Para ver una lista completa de los valores posibles, consulta la referencia de la API del mensaje

Visualization.

Configuraciones de ejemplo

Para empezar, aquí tienes algunas configuraciones de Visualization de ejemplo que puedes usar como punto de partida, así como imágenes que muestran una serie de ajustes aplicados.

Degradados integrados

En el caso de los degradados integrados, es posible que tengas que ajustar los valores de recorte si las áreas de atribución tienen demasiado ruido.

visualization: {

"type": "OUTLINES",

"polarity": "positive",

"clip_percent_lowerbound": 70,

"clip_percent_upperbound": 99.9,

"color_map": "pink_green",

"overlay_type": "grayscale"

}

A continuación, se muestran dos visualizaciones que usan los tipos outlines y pixels. Las columnas "Solo altamente predictivas", "Moderadamente predictivas" y "Casi todas" son ejemplos de recorte en diferentes niveles que pueden ayudarte a centrar la visualización.

![]()

XRAI

En el caso de las visualizaciones de XRAI, te recomendamos que empieces sin valores de recorte para XRAI, ya que la superposición usa un gradiente para mostrar las zonas de atribución alta y baja.

visualization: {

"clip_percent_lowerbound": 0,

"clip_percent_upperbound": 100,

"color_map": "viridis",

"overlay_type": "grayscale"

}

La siguiente imagen es una visualización de XRAI que usa el mapa de colores viridis predeterminado y una serie de tipos de superposición. Las zonas amarillas indican las regiones más influyentes que han contribuido positivamente a la predicción.

Siguientes pasos

- Consulta Obtener explicaciones para obtener predicciones con explicaciones de tu modelo.

- Para obtener información sobre cómo mejorar los resultados de Vertex Explainable AI en los modelos de clasificación de imágenes de AutoML, consulta el artículo Mejorar las explicaciones.