Puedes usar el SDK de Vertex AI para Python a fin de ver los datos de ejecución de Experimentos de Vertex AI y comparar las ejecuciones.

La consola de Google Cloud proporciona una visualización de los datos asociados con estas ejecuciones.

Obtén datos de ejecuciones del experimento

Estos ejemplos implican obtener métricas de ejecución, parámetros de ejecución, métricas de serie del entorno de ejecución, artefactos y métricas de clasificación para una ejecución de experimento en particular.

Métricas de resumen

Python

run_name: Especifica el nombre de ejecución adecuado para esta sesión.experiment: El nombre o la instancia de este experimento. Para encontrar tu lista de experimentos en la Google Cloud consola, selecciona Experimentos en la barra de navegación de secciones.project: . Puedes encontrarlos en la página de Google Cloud bienvenida de la consola.location: Consulta Lista de ubicaciones disponibles.

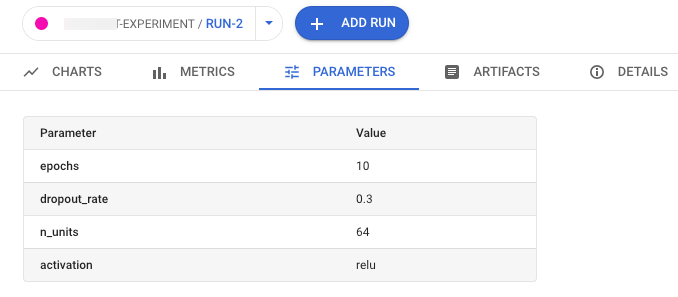

Parámetros

Python

run_name: Especifica el nombre de ejecución adecuado para esta sesión.experiment: El nombre o la instancia de este experimento. Para encontrar tu lista de experimentos en la Google Cloud consola, selecciona Experimentos en la barra de navegación de secciones.project: . Puedes encontrarlos en la página de Google Cloud bienvenida de la consola.location: Consulta Lista de ubicaciones disponibles.

Métricas de series temporales

Python

run_name: Especifica el nombre de ejecución adecuado para esta sesión.experiment: El nombre o la instancia de este experimento. Para encontrar tu lista de experimentos en la Google Cloud consola, selecciona Experimentos en la barra de navegación de secciones.project: . Puedes encontrarlos en la página de Google Cloud bienvenida de la consola.location: Consulta Lista de ubicaciones disponibles.

Artefactos

Python

run_name: Especifica el nombre de ejecución adecuado para esta sesión.experiment: El nombre o la instancia de este experimento. Para encontrar tu lista de experimentos en la Google Cloud consola, selecciona Experimentos en la barra de navegación de secciones.project: . Puedes encontrarlos en la página de Google Cloud bienvenida de la consola.location: Consulta Lista de ubicaciones disponibles.

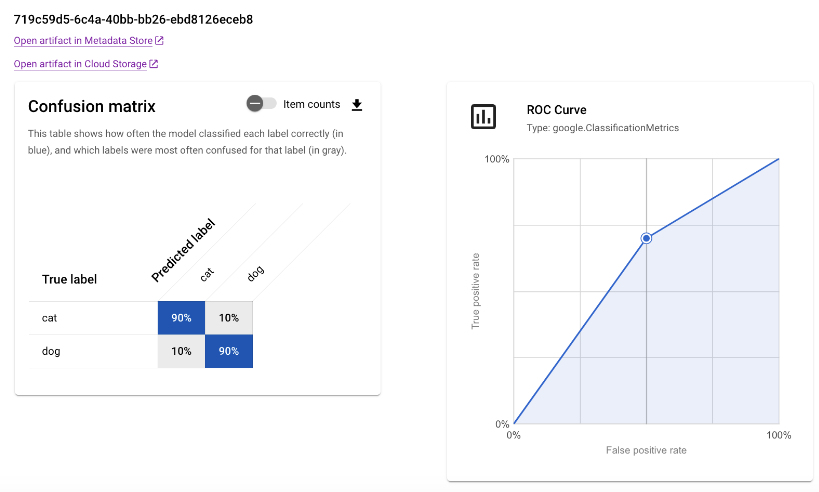

Métricas de clasificación

Python

run_name: Especifica el nombre de ejecución adecuado para esta sesión.experiment: El nombre o la instancia de este experimento. Para encontrar tu lista de experimentos en la Google Cloud consola, selecciona Experimentos en la barra de navegación de secciones.project: . Puedes encontrarlos en la página de Google Cloud bienvenida de la consola.location: Consulta Lista de ubicaciones disponibles.

Compare runs

Si usas el SDK de Vertex AI para Python, puedes recuperar los datos asociados a tu experimento. Los datos de las ejecuciones del experimento se muestran en un DataFrame.

Compare runs

Los datos de las ejecuciones del experimento se muestran en un DataFrame.

Python

experiment_name: Proporciona un nombre para el experimento. Para encontrar tu lista de experimentos en la Google Cloud consola, selecciona Experimentos en la barra de navegación de secciones.project: . Puedes encontrar estos IDs en la página de bienvenida de la consola de Google Cloud .location: Consulta Lista de ubicaciones disponibles.

Google Cloud console

Usa la Google Cloud consola para ver los detalles de las ejecuciones de experimentos y compararlas.

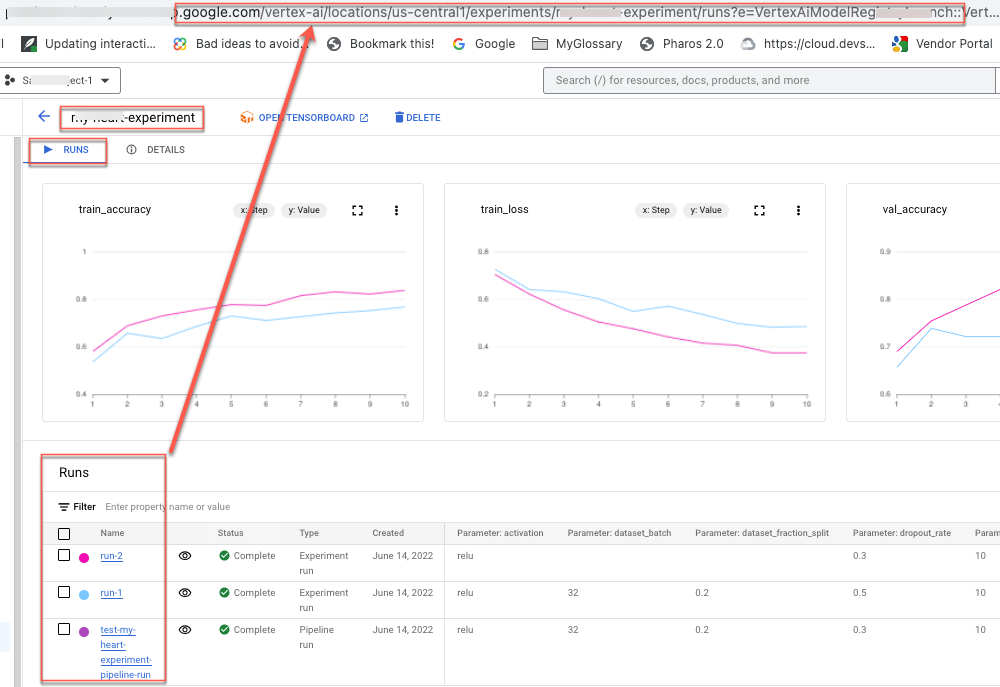

Visualiza datos de ejecución de experimento

- En la consola de Google Cloud , ve a la página Experiments.

Ir a Experimentos

Aparecerá una lista de experimentos asociados con un proyecto. - Selecciona el experimento que contiene la ejecución que deseas verificar.

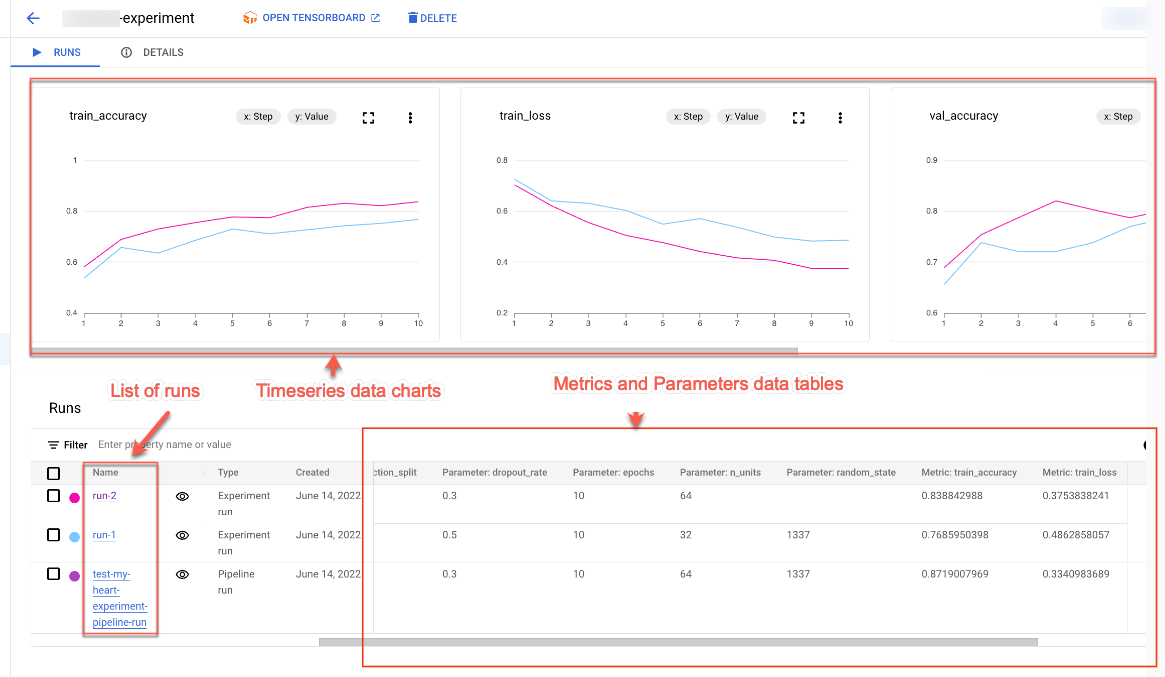

Aparecerá una lista de ejecuciones, gráficos de datos de series temporales y una tabla de datos de métricas y parámetros. Ten en cuenta que, en este caso, se seleccionan tres ejecuciones, pero solo aparecen dos líneas en los gráficos de datos de series temporales. No hay tercera línea porque la tercera ejecución del experimento no tiene datos de series temporales para mostrar.

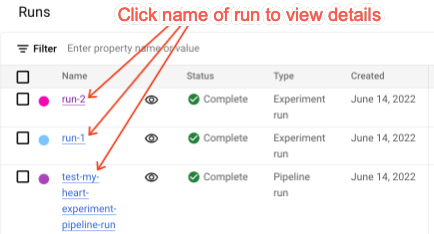

- Haz clic en el nombre de la ejecución para navegar a la página de detalles correspondiente.

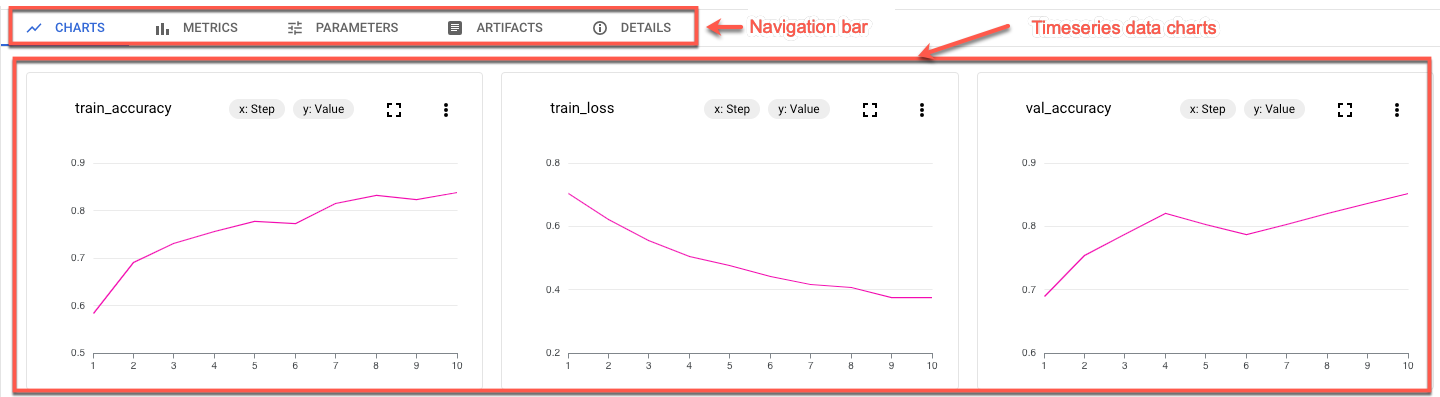

Aparecerán la barra de navegación y los gráficos de datos de series temporales.

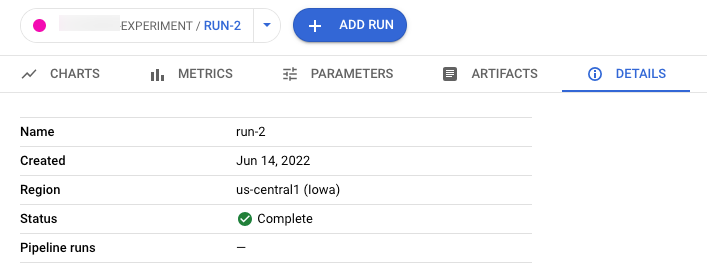

- Para ver las métricas, los parámetros, los artefactos y los detalles de la ejecución seleccionada, haz clic en los botones correspondientes en la barra de navegación.

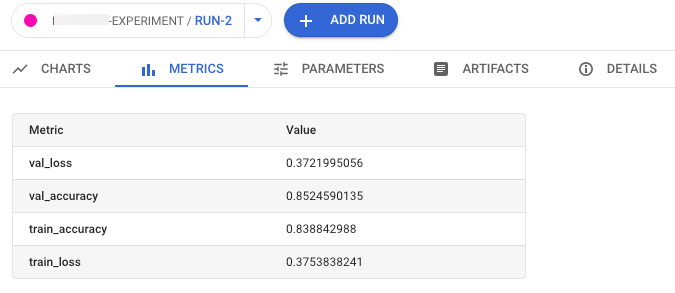

- Métricas

- Parámetros

- Artefactos

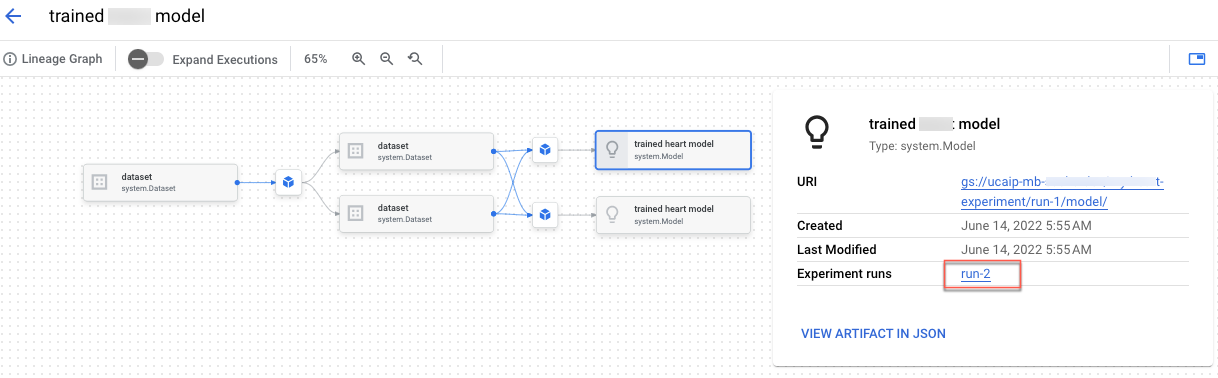

Para ver el linaje de los artefactos, haz clic en el vínculo Abrir artefacto en el almacén de metadatos. Aparecerá el grafo de linaje asociado con la ejecución.

- Detalles

- Métricas

Para compartir los datos con otras personas, usa las URLs asociadas con las vistas. Por ejemplo, comparte la lista de ejecuciones de experimentos asociadas con un experimento:

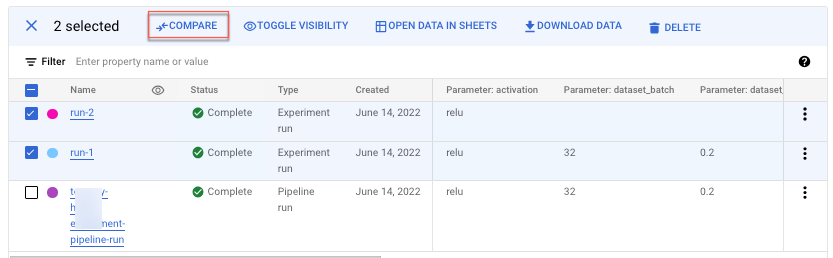

Compara las ejecuciones de experimentos

Puedes seleccionar las ejecuciones que deseas comparar en un experimento y entre experimentos.

- En la consola de Google Cloud , ve a la página Experiments.

Ir a Experimentos

Aparecerá una lista de experimentos. - Selecciona el experimento que contiene la ejecución que deseas comparar. Aparecerá una lista de ejecuciones.

- Selecciona las ejecuciones del experimento que deseas comparar. Haz clic en Comparar.

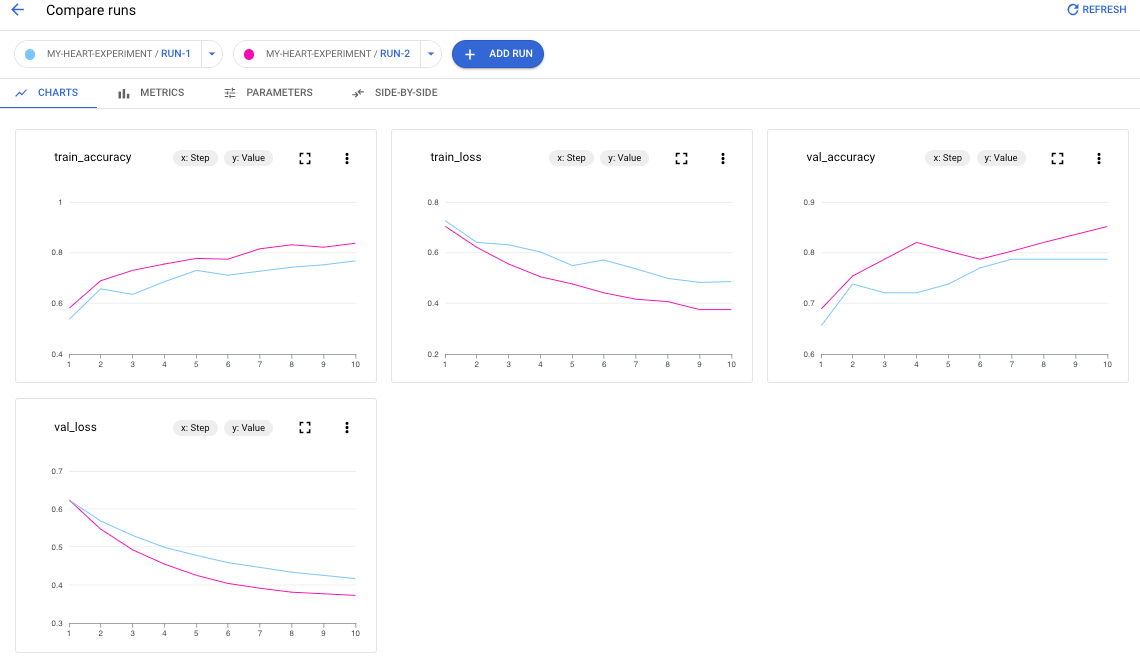

De forma predeterminada, los gráficos aparecen comparando las métricas de series temporales de las ejecuciones de experimentos seleccionadas.

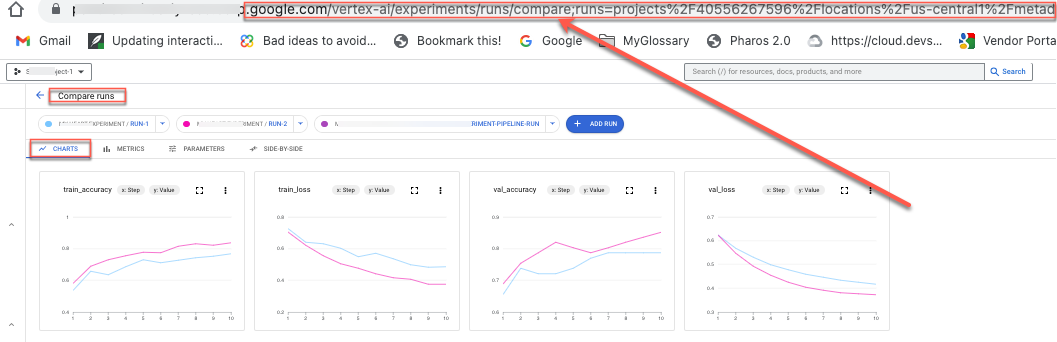

- Para agregar ejecuciones adicionales de cualquier experimento a tu proyecto, haz clic en Agregar ejecución.

Para compartir los datos con otras personas, usa las URLs asociadas con las vistas. Por ejemplo, comparte la vista de comparación de los datos de métricas de series temporales:

Consulta Crea y administra ejecuciones de experimentos para obtener información sobre cómo actualizar el estado de una ejecución.