É possível usar o console do Google Cloud ou o SDK da Vertex AI para Python para adicionar uma execução de pipeline a um experimento ou a uma execução de experimento.

Google Cloud console

Use as instruções a seguir para executar um pipeline de ML e associá-lo a um experimento e, opcionalmente, a uma execução de experimento usando o console Google Cloud . As execuções de experimentos só podem ser criadas com o SDK da Vertex AI para Python. Consulte Criar e gerenciar execuções de experimentos.- No console Google Cloud , na seção "Vertex AI", acesse

a página Pipelines.

Acessar "Pipelines" - Na lista suspensa Região, selecione a região em que você quer criar uma execução do pipeline.

- Clique em Criar execução para abrir o painel Criar execução do pipeline.

- Especifique os seguintes detalhes da execução.

- No campo Arquivo, clique em Selecionar para abrir o seletor de arquivos. Navegue até o arquivo JSON compilado do pipeline que você quer executar, selecione o pipeline e clique em Abrir.

- Por padrão, o Nome do pipeline usa o nome especificado na definição do pipeline. Opcionalmente, especifique um Nome de pipeline diferente.

- Especifique um Nome de execução para identificar exclusivamente essa execução de pipeline.

- Para especificar que essa execução do pipeline usa uma conta de serviço personalizada, uma

chave de criptografia gerenciada pelo cliente ou uma rede VPC com peering, clique em

Opções avançadas. (opcional)

Use as instruções a seguir para configurar opções avançadas, como uma conta de serviço personalizada.- Para especificar uma conta de serviço, selecione uma na

lista suspensa da Conta de serviço.

O Vertex Pipelines executa o pipeline usando a conta de serviço padrão do Compute Engine, caso nenhuma conta de serviço seja especificada.

Saiba mais sobre Como configurar uma conta de serviço para uso com o Vertex AI Pipelines. - Para usar uma chave de criptografia gerenciada pelo cliente (CMEK, na sigla em inglês), selecione Usar uma chave de criptografia gerenciada pelo cliente. A lista suspensa Selecione uma chave gerenciada pelo cliente é exibida. Na lista suspensa Selecione uma chave gerenciada pelo cliente, selecione a chave que você quer usar.

- Para usar uma rede VPC com peering nesta execução do pipeline, insira o nome da rede VPC na caixa Rede VPC com peering.

- Para especificar uma conta de serviço, selecione uma na

lista suspensa da Conta de serviço.

- Clique em Continuar.

O local Cloud Storage e o painel Parâmetros de pipeline são exibidos. - Obrigatório: insira o diretório de saída do Cloud Storage, por exemplo: gs://location_of_directory.

- Opcional: especifique os parâmetros que você quer usar para a execução deste pipeline.

- Clique em Enviar para criar a execução do pipeline.

- Depois que o pipeline for enviado, ele vai aparecer na tabela do console Google Cloud dele.

- Na linha associada ao seu pipeline, clique em Ver mais > Adicionar ao experimento

- Selecione um orçamento atual ou crie um novo.

- Opcional: se as execuções do experimento estiverem associadas a ele, elas serão exibidas na lista suspensa. Selecione uma execução do experimento.

- Clique em Salvar.

Comparar uma execução de pipeline com execuções de experimentos usando o console Google Cloud

- No console do Google Cloud , acesse a página Experimentos.

Acessar os Experimentos.

Uma lista de experimentos aparece na página Experimentos. - Selecione o experimento em que você quer adicionar a execução de pipeline.

Uma lista de execuções será exibida. - Selecione as execuções que você quer comparar e clique em Comparar

. - Clique no botão Adicionar execução. Uma lista de execuções será exibida.

- Selecione a execução de pipeline que você quer adicionar. A execução é adicionada.

SDK da Vertex AI para Python {:#sdk-add-pipeline-run}

As amostras a seguir usam a API PipelineJob.

Associar o pipeline executado a um experimento

Este exemplo mostra como associar uma execução de pipeline a um experimento. Para comparar

as execuções de pipeline, associe suas execuções de pipeline a um experimento. Consulte

init

na documentação de referência do SDK da Vertex AI para Python.

Python

experiment_name: dê um nome para o experimento. Para ver a lista de experimentos no Google Cloud console, selecione Experimentos no painel de navegação.pipeline_job_display_name: o nome definido pelo usuário deste pipeline.template_path: o caminho do arquivo JSON ou YAML do PipelineJob ou PipelineSpec. Pode ser um caminho local ou um URI do Cloud Storage. Exemplo: "gs://project.name"pipeline_root: a raiz das saídas do pipeline. O padrão é ser um bucket de preparo.parameter_values: o mapeamento dos nomes de parâmetros de ambiente de execução para os valores que controlam a execução do pipeline.project: . Esses IDs estão na página de boas-vindas do console Google Cloud .location: Consulte a Lista de locais disponíveis.

Executar o pipeline associado à execução do experimento

O exemplo fornecido inclui a associação de uma execução de pipeline a uma execução de experimento.

Casos de uso:

- Ao fazer o treinamento de modelo local e, em seguida, executar a avaliação nesse modelo. A avaliação é feita por um pipeline. Nesse caso, convém gravar as métricas de avaliação da execução do pipeline em um ExperimentRun

- Ao executar novamente o mesmo pipeline várias vezes. Por exemplo, se você alterar os parâmetros de entrada ou um componente falhar e você precisar executá-lo novamente.

Ao associar uma execução de pipeline a uma execução do experimento, os parâmetros e as métricas não são exibidos automaticamente e precisam ser registrados manualmente usando as APIs de geração de registros.

Observação: quando o parâmetro resume opcional é especificado como TRUE, a execução iniciada anteriormente é retomada. Quando não especificado, resume assume como padrão FALSE e uma nova execução é criada.

Consulte

init,

start_run e

log

na documentação de referência do SDK do Vertex AI para Python.

Python

experiment_name: dê um nome para o experimento. Para ver a lista de experimentos no Google Cloud console, selecione Experimentos no painel de navegação.run_name: especifica um nome para execução.pipeline_job: um PipelineJob da Vertex AIproject: . É possível encontrá-los na página de boas-vindas do console Google Cloud .location: consulte a Lista de locais disponíveis.

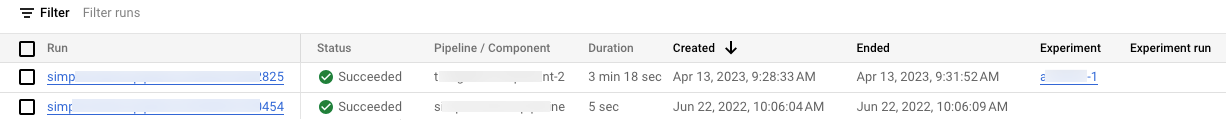

Conferir a lista de execuções de pipeline no console Google Cloud

No console do Google Cloud , na seção "Vertex AI", acesse a página Pipelines.

Verifique se você está no projeto correto.

Uma lista de experimentos e execuções associados às execuções de pipeline do projeto aparece nas colunas Experimento e Execução de experimento, respectivamente.

Codelab

Aproveite ao máximo a experimentação: gerencie experimentos de machine learning com a Vertex AI

Este codelab envolve o uso da Vertex AI para criar um pipeline que treina um modelo personalizado do Keras no TensorFlow. Os experimentos da Vertex AI são usados para rastrear e comparar execuções de experimento a fim de identificar qual combinação de hiperparâmetros resulta no melhor desempenho.