SSD Lokal dirancang untuk kasus penggunaan penyimpanan sementara, seperti cache atau ruang pemrosesan scratch. Karena SSD Lokal terletak di mesin fisik tempat VM Anda berjalan, SSD hanya dapat dibuat selama proses pembuatan VM. SSD Lokal tidak dapat digunakan sebagai perangkat booting.

Untuk seri mesin generasi ketiga dan yang lebih baru, sejumlah disk SSD Lokal ditambahkan ke VM saat Anda membuatnya. Satu-satunya cara untuk menambahkan penyimpanan SSD Lokal ke VM ini adalah:

- Untuk C4, C4D, C3, dan C3D, penyimpanan SSD Lokal hanya tersedia dengan

jenis mesin tertentu, seperti

c3-standard-88-lssd. - Untuk seri mesin Z3, A4, A4X, A3, dan A2 Ultra, setiap jenis mesin dilengkapi dengan penyimpanan SSD Lokal.

Untuk jenis mesin M3 serta generasi pertama dan kedua, Anda harus menentukan disk SSD Lokal saat membuat VM.

Setelah membuat disk SSD Lokal, Anda harus memformat dan memasang perangkat sebelum dapat menggunakannya.

Untuk mengetahui informasi tentang jumlah penyimpanan SSD Lokal yang tersedia dengan berbagai jenis mesin, dan jumlah disk SSD Lokal yang dapat Anda pasang ke VM, lihat Memilih jumlah SSD Lokal yang valid.

Sebelum memulai

- Tinjau Batasan SSD Lokal sebelum menggunakan SSD Lokal.

- Tinjau skenario persistensi data untuk disk SSD Lokal.

- Jika Anda menambahkan SSD Lokal ke instance virtual machine (VM) yang memiliki GPU yang terpasang, lihat Ketersediaan SSD Lokal berdasarkan region dan zona GPU.

-

Jika Anda belum melakukannya, siapkan autentikasi.

Autentikasi memverifikasi identitas Anda untuk mengakses Google Cloud layanan dan API. Untuk menjalankan

kode atau sampel dari lingkungan pengembangan lokal, Anda dapat melakukan autentikasi ke

Compute Engine dengan memilih salah satu opsi berikut:

Select the tab for how you plan to use the samples on this page:

Console

When you use the Google Cloud console to access Google Cloud services and APIs, you don't need to set up authentication.

gcloud

-

Menginstal Google Cloud CLI. Setelah penginstalan, lakukan inisialisasi Google Cloud CLI dengan menjalankan perintah berikut:

gcloud initJika Anda menggunakan penyedia identitas (IdP) eksternal, Anda harus login ke gcloud CLI dengan identitas gabungan Anda terlebih dahulu.

- Set a default region and zone.

Terraform

Untuk menggunakan contoh Terraform di halaman ini dalam lingkungan pengembangan lokal, instal dan lakukan inisialisasi gcloud CLI, lalu siapkan Kredensial Default Aplikasi dengan kredensial pengguna Anda.

Menginstal Google Cloud CLI.

Jika Anda menggunakan penyedia identitas (IdP) eksternal, Anda harus login ke gcloud CLI dengan identitas gabungan Anda terlebih dahulu.

If you're using a local shell, then create local authentication credentials for your user account:

gcloud auth application-default login

You don't need to do this if you're using Cloud Shell.

If an authentication error is returned, and you are using an external identity provider (IdP), confirm that you have signed in to the gcloud CLI with your federated identity.

Untuk informasi selengkapnya, lihat Set up authentication for a local development environment.

Go

Untuk menggunakan contoh Go di halaman ini dalam lingkungan pengembangan lokal, instal dan lakukan inisialisasi gcloud CLI, lalu siapkan Kredensial Default Aplikasi dengan kredensial pengguna Anda.

Menginstal Google Cloud CLI.

Jika Anda menggunakan penyedia identitas (IdP) eksternal, Anda harus login ke gcloud CLI dengan identitas gabungan Anda terlebih dahulu.

If you're using a local shell, then create local authentication credentials for your user account:

gcloud auth application-default login

You don't need to do this if you're using Cloud Shell.

If an authentication error is returned, and you are using an external identity provider (IdP), confirm that you have signed in to the gcloud CLI with your federated identity.

Untuk informasi selengkapnya, lihat Set up authentication for a local development environment.

Java

Untuk menggunakan contoh Java di halaman ini dalam lingkungan pengembangan lokal, instal dan lakukan inisialisasi gcloud CLI, lalu siapkan Kredensial Default Aplikasi dengan kredensial pengguna Anda.

Menginstal Google Cloud CLI.

Jika Anda menggunakan penyedia identitas (IdP) eksternal, Anda harus login ke gcloud CLI dengan identitas gabungan Anda terlebih dahulu.

If you're using a local shell, then create local authentication credentials for your user account:

gcloud auth application-default login

You don't need to do this if you're using Cloud Shell.

If an authentication error is returned, and you are using an external identity provider (IdP), confirm that you have signed in to the gcloud CLI with your federated identity.

Untuk informasi selengkapnya, lihat Set up authentication for a local development environment.

Python

Untuk menggunakan contoh Python di halaman ini dalam lingkungan pengembangan lokal, instal dan lakukan inisialisasi gcloud CLI, lalu siapkan Kredensial Default Aplikasi dengan kredensial pengguna Anda.

Menginstal Google Cloud CLI.

Jika Anda menggunakan penyedia identitas (IdP) eksternal, Anda harus login ke gcloud CLI dengan identitas gabungan Anda terlebih dahulu.

If you're using a local shell, then create local authentication credentials for your user account:

gcloud auth application-default login

You don't need to do this if you're using Cloud Shell.

If an authentication error is returned, and you are using an external identity provider (IdP), confirm that you have signed in to the gcloud CLI with your federated identity.

Untuk informasi selengkapnya, lihat Set up authentication for a local development environment.

REST

Untuk menggunakan contoh REST API di halaman ini dalam lingkungan pengembangan lokal, Anda menggunakan kredensial yang Anda berikan ke gcloud CLI.

Menginstal Google Cloud CLI.

Jika Anda menggunakan penyedia identitas (IdP) eksternal, Anda harus login ke gcloud CLI dengan identitas gabungan Anda terlebih dahulu.

Untuk mengetahui informasi selengkapnya, lihat Melakukan autentikasi untuk menggunakan REST dalam dokumentasi autentikasi Google Cloud .

Membuat VM dengan SSD Lokal

Anda dapat membuat VM dengan penyimpanan disk SSD Lokal menggunakan Google Cloud console, gcloud CLI, atau Compute Engine API.

Konsol

Buka halaman Create an instance.

Tentukan nama, region, dan zona untuk VM Anda. Secara opsional, tambahkan tag atau label.

Di bagian Konfigurasi mesin, pilih kelompok mesin yang berisi jenis mesin target Anda.

Pilih seri dari daftar Seri, lalu pilih jenis mesin.

- Untuk C4, C4D, C3, dan C3D, pilih jenis mesin yang diakhiri dengan

-lssd. - Untuk Z3, A4, A4X, A3, dan A2 Ultra, setiap jenis mesin dilengkapi dengan penyimpanan SSD Lokal.

- Untuk seri mesin M3, atau generasi pertama dan kedua, setelah memilih

jenis mesin, lakukan langkah berikut:

- Luaskan bagian Advanced options.

- Perluas Disk, klik Tambahkan SSD Lokal, dan lakukan hal berikut:

- Di halaman Konfigurasi SSD Lokal, pilih jenis antarmuka disk.

- Pilih jumlah disk yang Anda inginkan dari daftar Kapasitas disk.

- Klik Simpan.

- Untuk C4, C4D, C3, dan C3D, pilih jenis mesin yang diakhiri dengan

Lanjutkan dengan proses pembuatan VM.

Setelah membuat VM dengan disk SSD Lokal, Anda harus memformat dan memasang setiap perangkat sebelum dapat menggunakan disk.

gcloud

Untuk seri mesin Z3, A4, A4X, A3, dan A2 Ultra, guna membuat VM dengan disk SSD Lokal yang terpasang, buat VM yang menggunakan salah satu jenis mesin yang tersedia untuk seri tersebut dengan mengikuti petunjuk untuk membuat instance.

Untuk seri mesin C4, C4D, C3, dan C3D, guna membuat VM dengan disk SSD Lokal yang terpasang, ikuti petunjuk untuk membuat instance, tetapi tentukan jenis instance yang menyertakan disk SSD Lokal (

-lssd).Misalnya, Anda dapat membuat VM C3 dengan dua partisi SSD Lokal yang menggunakan antarmuka disk NVMe sebagai berikut:

gcloud compute instances create example-c3-instance \ --zone ZONE \ --machine-type c3-standard-8-lssd \ --image-project IMAGE_PROJECT \ --image-family IMAGE_FAMILY

Untuk seri mesin M3 dan generasi pertama serta kedua, guna membuat VM dengan disk SSD Lokal yang terpasang, ikuti petunjuk untuk membuat instance, tetapi gunakan flag

--local-ssduntuk membuat dan memasang disk SSD Lokal. Untuk membuat beberapa disk SSD Lokal, tambahkan lebih banyak flag--local-ssd. Secara opsional, Anda juga dapat menetapkan nilai untuk antarmuka dan nama perangkat untuk setiap flag--local-ssd.Misalnya, Anda dapat membuat VM M3 dengan empat disk SSD Lokal dan menentukan jenis antarmuka disk sebagai berikut:

gcloud compute instances create VM_NAME \ --machine-type m3-ultramem-64 \ --zone ZONE \ --local-ssd interface=INTERFACE_TYPE,device-name=DEVICE-NAME \ --local-ssd interface=INTERFACE_TYPE,device-name=DEVICE-NAME \ --local-ssd interface=INTERFACE_TYPE,device-name=DEVICE-NAME \ --local-ssd interface=INTERFACE_TYPE \ --image-project IMAGE_PROJECT \ --image-family IMAGE_FAMILY

Ganti kode berikut:

- VM_NAME: nama untuk VM baru

- ZONE: zona tempat VM dibuat. Flag ini bersifat

opsional jika Anda telah mengonfigurasi properti

compute/zonegcloud CLI atau variabel lingkunganCLOUDSDK_COMPUTE_ZONE. - INTERFACE_TYPE: jenis antarmuka disk yang ingin

Anda gunakan untuk perangkat SSD Lokal. Tentukan

nvmejika membuat VM M3 atau jika image boot disk Anda memiliki driver NVMe yang dioptimalkan. Tentukanscsiuntuk gambar lainnya. - DEVICE-NAME: Opsional: Nama yang menunjukkan nama disk yang akan digunakan dalam sistem operasi tamu link simbolis (symlink).

- IMAGE_FAMILY: salah satu kelompok image yang tersedia yang ingin Anda instal pada boot disk

- IMAGE_PROJECT: project image yang mencakup kelompok gambar tersebut

Jika perlu, Anda dapat memasang SSD Lokal ke VM generasi pertama atau kedua menggunakan kombinasi

nvmedanscsiuntuk partisi yang berbeda. Performa untuk perangkatnvmebergantung pada boot disk image untuk instance Anda. VM generasi ketiga hanya mendukung antarmuka disk NVMe.Setelah membuat VM dengan SSD Lokal, Anda harus memformat dan memasang setiap perangkat sebelum dapat menggunakannya.

Terraform

Untuk membuat VM dengan disk SSD Lokal yang terpasang, Anda dapat menggunakan resource

google_compute_instance.Untuk mempelajari cara menerapkan atau menghapus konfigurasi Terraform, lihat Perintah dasar Terraform.

Untuk membuat kode Terraform, Anda dapat menggunakan komponen Kode yang setara di konsol Google Cloud .- Di konsol Google Cloud , buka halaman VM instances.

- Klik Create instance.

- Tentukan parameter yang Anda inginkan.

- Di bagian atas atau bawah halaman, klik Kode yang setara, lalu klik tab Terraform untuk melihat kode Terraform.

Go

Go

Sebelum mencoba contoh ini, ikuti petunjuk penyiapan Go di panduan memulai Compute Engine menggunakan library klien. Untuk informasi selengkapnya, lihat dokumentasi referensi API Go Compute Engine.

Untuk melakukan autentikasi ke Compute Engine, siapkan Kredensial Default Aplikasi. Untuk mengetahui informasi selengkapnya, lihat Menyiapkan autentikasi untuk lingkungan pengembangan lokal.

Java

Java

Sebelum mencoba contoh ini, ikuti petunjuk penyiapan Java di panduan memulai Compute Engine menggunakan library klien. Untuk informasi selengkapnya, lihat dokumentasi referensi API Java Compute Engine.

Untuk melakukan autentikasi ke Compute Engine, siapkan Kredensial Default Aplikasi. Untuk mengetahui informasi selengkapnya, lihat Menyiapkan autentikasi untuk lingkungan pengembangan lokal.

Python

Python

Sebelum mencoba contoh ini, ikuti petunjuk penyiapan Python di panduan memulai Compute Engine menggunakan library klien. Untuk informasi selengkapnya, lihat dokumentasi referensi API Python Compute Engine.

Untuk melakukan autentikasi ke Compute Engine, siapkan Kredensial Default Aplikasi. Untuk mengetahui informasi selengkapnya, lihat Menyiapkan autentikasi untuk lingkungan pengembangan lokal.

REST

Gunakan

instances.insert methoduntuk membuat VM dari kelompok image atau dari versi image sistem operasi tertentu.- Untuk seri mesin Z3, A4, A4X, A3, dan A2 Ultra, guna membuat VM dengan disk SSD Lokal yang terpasang, buat VM yang menggunakan salah satu jenis mesin yang tersedia untuk seri tersebut.

Untuk seri mesin C4, C4D, C3, dan C3D, guna membuat VM dengan disk SSD Lokal yang terpasang, tentukan jenis instance yang mencakup disk SSD Lokal (

-lssd).Berikut adalah contoh payload permintaan yang membuat VM C3 dengan boot disk Ubuntu dan dua disk SSD Lokal:

{ "machineType":"zones/us-central1-c/machineTypes/c3-standard-8-lssd", "name":"c3-with-local-ssd", "disks":[ { "type":"PERSISTENT", "initializeParams":{ "sourceImage":"projects/ubuntu-os-cloud/global/images/family/ubuntu-2204-lts" }, "boot":true } ], "networkInterfaces":[ { "network":"global/networks/default" } ] }Untuk seri mesin M3 serta generasi pertama dan kedua, guna membuat VM dengan disk SSD Lokal yang terpasang, Anda dapat menambahkan perangkat SSD Lokal selama pembuatan VM menggunakan properti

initializeParams. Anda juga harus menyediakan properti berikut:diskType: Tetapkan ke SSD LokalautoDelete: Tetapkan ke truetype: Tetapkan keSCRATCH

Properti berikut tidak dapat digunakan dengan perangkat SSD Lokal:

diskName- Properti

sourceImage diskSizeGb

Berikut adalah contoh payload permintaan yang membuat VM M3 dengan boot disk dan empat disk SSD Lokal:

{ "machineType":"zones/us-central1-f/machineTypes/m3-ultramem-64", "name":"local-ssd-instance", "disks":[ { "type":"PERSISTENT", "initializeParams":{ "sourceImage":"projects/ubuntu-os-cloud/global/images/family/ubuntu-2204-lts" }, "boot":true }, { "type":"SCRATCH", "initializeParams":{ "diskType":"zones/us-central1-f/diskTypes/local-ssd" }, "autoDelete":true, "interface": "NVME" }, { "type":"SCRATCH", "initializeParams":{ "diskType":"zones/us-central1-f/diskTypes/local-ssd" }, "autoDelete":true, "interface": "NVME" }, { "type":"SCRATCH", "initializeParams":{ "diskType":"zones/us-central1-f/diskTypes/local-ssd" }, "autoDelete":true, "interface": "NVME" }, { "type":"SCRATCH", "initializeParams":{ "diskType":"zones/us-central1-f/diskTypes/local-ssd" }, "autoDelete":true, "interface": "NVME" }, ], "networkInterfaces":[ { "network":"global/networks/default" } ] }

Setelah membuat disk SSD Lokal, Anda harus memformat dan memasang setiap perangkat sebelum dapat menggunakannya.

Untuk mengetahui informasi selengkapnya tentang cara membuat instance menggunakan REST, lihat Compute Engine API.

Memformat dan memasang perangkat SSD Lokal

Anda dapat memformat dan memasang setiap disk SSD Lokal satu per satu, atau Anda dapat menggabungkan beberapa disk SSD Lokal ke dalam satu volume logis.

Memformat dan memasang partisi SSD Lokal satu per satu

Cara termudah untuk menghubungkan SSD Lokal ke instance Anda adalah dengan memformat dan memasang setiap perangkat dengan satu partisi. Atau, Anda dapat menggabungkan beberapa partisi menjadi satu volume logis.

Instance Linux

Format dan pasang SSD Lokal baru di instance Linux Anda. Anda dapat menggunakan format partisi dan konfigurasi apa pun yang diperlukan. Untuk contoh ini, buat satu partisi

ext4.Buka halaman Instance VM.

Klik tombol SSH di samping instance yang memiliki SSD Lokal baru yang terpasang. Browser akan membuka koneksi terminal ke instance.

Di terminal, gunakan perintah

finduntuk mengidentifikasi SSD Lokal yang ingin Anda pasang.$ find /dev/ | grep google-local-nvme-ssdSSD Lokal dalam mode SCSI memiliki nama standar seperti

google-local-ssd-0. SSD Lokal dalam mode NVMe memiliki nama sepertigoogle-local-nvme-ssd-0, seperti yang ditunjukkan dalam output berikut:$ find /dev/ | grep google-local-nvme-ssd /dev/disk/by-id/google-local-nvme-ssd-0

Memformat SSD Lokal dengan sistem file ext4. Perintah ini menghapus semua data yang sudah ada dari SSD Lokal.

$ sudo mkfs.ext4 -F /dev/disk/by-id/[SSD_NAME]Ganti

[SSD_NAME]dengan ID SSD Lokal yang ingin Anda format. Misalnya, tentukangoogle-local-nvme-ssd-0untuk memformat SSD Lokal NVMe pertama pada instance.Gunakan perintah

mkdiruntuk membuat direktori tempat Anda dapat memasang perangkat.$ sudo mkdir -p /mnt/disks/[MNT_DIR]Ganti

[MNT_DIR]dengan jalur direktori tempat Anda ingin memasang disk SSD Lokal.Pasang SSD Lokal ke VM.

$ sudo mount /dev/disk/by-id/[SSD_NAME] /mnt/disks/[MNT_DIR]Ganti kode berikut:

[SSD_NAME]: ID SSD Lokal yang ingin Anda pasang.[MNT_DIR]: direktori tempat Anda ingin memasang SSD Lokal.

Konfigurasi akses baca dan tulis ke perangkat. Untuk contoh ini, berikan akses tulis ke perangkat untuk semua pengguna.

$ sudo chmod a+w /mnt/disks/[MNT_DIR]Ganti

[MNT_DIR]dengan direktori tempat Anda memasang SSD Lokal.

Jika ingin, Anda dapat menambahkan SSD Lokal ke file

/etc/fstabagar perangkat otomatis dipasang kembali saat instance dimulai ulang. Entri ini tidak menyimpan data di SSD Lokal Anda jika instance berhenti. Lihat Persistensi data SSD Lokal untuk mengetahui detail selengkapnya.Saat menentukan file

/etc/fstabentri, pastikan untuk menyertakan opsinofailsehingga instance dapat terus melakukan booting meskipun SSD Lokal tidak ada. Misalnya, jika Anda mengambil snapshot boot disk dan membuat instance baru tanpa memasang disk SSD Lokal, instance dapat melanjutkan proses startup dan tidak dijeda tanpa batas.Buat entri

/etc/fstab. Gunakan perintahblkiduntuk menemukan UUID sistem file pada perangkat dan edit file/etc/fstabuntuk menyertakan UUID tersebut dengan opsi pemasangan. Anda dapat menyelesaikan langkah ini dengan satu perintah.Misalnya, untuk SSD Lokal dalam mode NVMe, gunakan perintah berikut:

$ echo UUID=`sudo blkid -s UUID -o value /dev/disk/by-id/google-local-nvme-ssd-0` /mnt/disks/[MNT_DIR] ext4 discard,defaults,nofail 0 2 | sudo tee -a /etc/fstabUntuk SSD Lokal dalam mode non-NVMe seperti SCSI, gunakan perintah berikut:

$ echo UUID=`sudo blkid -s UUID -o value /dev/disk/by-id/google-local-ssd-0` /mnt/disks/[MNT_DIR] ext4 discard,defaults,nofail 0 2 | sudo tee -a /etc/fstabGanti

[MNT_DIR]dengan direktori tempat Anda memasang SSD Lokal.Gunakan perintah

catuntuk memverifikasi bahwa entri/etc/fstabAnda sudah benar:$ cat /etc/fstab

Jika Anda membuat snapshot dari boot disk instance ini dan menggunakannya untuk membuat instance terpisah yang tidak memiliki SSD Lokal, edit file

/etc/fstabdan hapus entri untuk SSD Lokal ini. Meskipun opsinofailditerapkan, pastikan file/etc/fstabtetap sinkron dengan partisi yang terpasang ke instance Anda dan hapus entri ini sebelum Anda membuat snapshot boot disk.Instance Windows

Gunakan alat Pengelolaan Disk Windows untuk memformat dan memasang SSD Lokal di instance Windows.

Hubungkan ke instance melalui RDP. Untuk contoh ini, buka halaman Instance VM, lalu klik tombol RDP di samping instance yang memasang SSD Lokal. Setelah Anda memasukkan nama pengguna dan sandi, jendela akan terbuka dengan antarmuka desktop untuk server Anda.

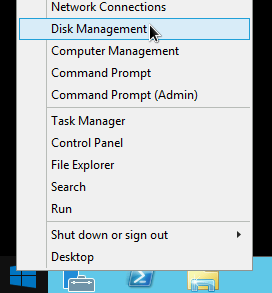

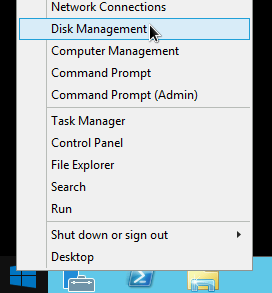

Klik kanan tombol Start Windows dan pilih Pengelolaan Disk.

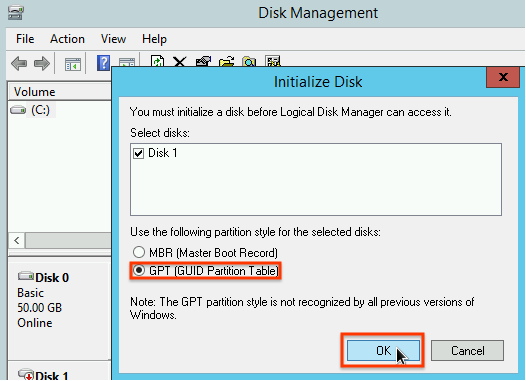

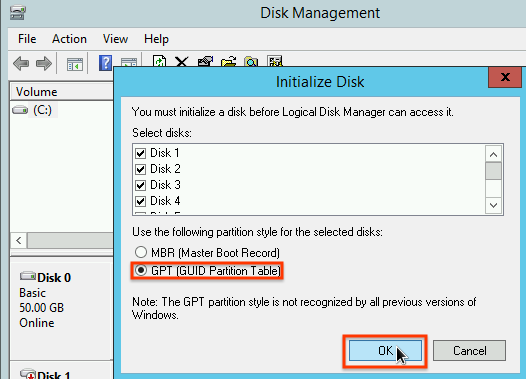

Jika Anda belum melakukan inisialisasi SSD Lokal sebelumnya, alat ini akan meminta Anda memilih skema partisi untuk partisi baru. Pilih GPT dan klik OKE.

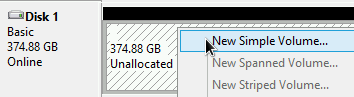

Setelah SSD Lokal diinisialisasi, klik kanan ruang disk yang tidak teralokasi, lalu pilih Volume Sederhana Baru.

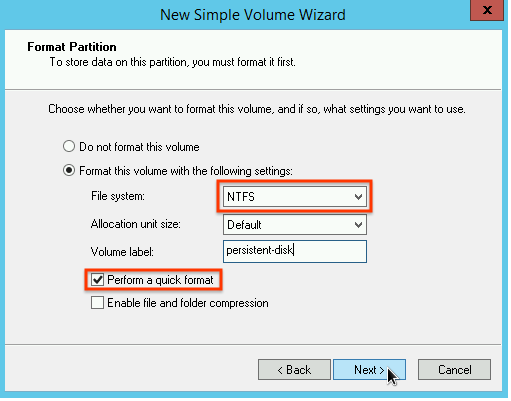

Ikuti petunjuk di Wizard Volume Sederhana Baru untuk mengonfigurasi volume baru. Anda dapat menggunakan format partisi apa pun yang disukai, tetapi untuk contoh ini, pilih

NTFS. Selain itu, centang Lakukan format cepat untuk mempercepat proses pemformatan.

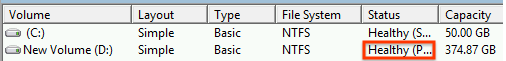

Setelah Anda menyelesaikan wizard dan volume selesai memformat, periksa SSD Lokal baru untuk memastikannya memiliki status

Healthy.

Selesai! Sekarang, Anda dapat menulis file ke SSD Lokal.

Memformat dan memasang beberapa partisi SSD Lokal ke dalam satu volume logis

Tidak seperti SSD persisten, SSD Lokal memiliki kapasitas tetap 375 GB untuk setiap perangkat yang Anda pasang ke instance. Jika ingin menggabungkan beberapa partisi SSD Lokal menjadi satu volume logis, Anda harus menentukan sendiri pengelolaan volume di seluruh partisi ini.

Instance Linux

Gunakan

mdadmuntuk membuat array RAID 0. Contoh ini memformat array dengan satu sistem fileext4, tetapi Anda dapat menerapkan sistem file apa pun yang Anda inginkan.Buka halaman Instance VM.

Klik tombol SSH di samping instance yang memiliki SSD Lokal baru yang terpasang. Browser akan membuka koneksi terminal ke instance.

Di terminal, instal alat

mdadm. Proses penginstalan untukmdadmmenyertakan perintah pengguna yang menghentikan skrip, jadi jalankan proses ini secara manual.Debian dan Ubuntu:

$ sudo apt update && sudo apt install mdadm --no-install-recommendsCentOS dan RHEL:

$ sudo yum install mdadm -ySLES dan openSUSE:

$ sudo zypper install -y mdadmGunakan perintah

finduntuk mengidentifikasi semua SSD Lokal yang ingin Anda pasang bersama.Untuk contoh ini, instance memiliki delapan partisi SSD Lokal dalam mode NVMe:

$ find /dev/ | grep google-local-nvme-ssd /dev/disk/by-id/google-local-nvme-ssd-7 /dev/disk/by-id/google-local-nvme-ssd-6 /dev/disk/by-id/google-local-nvme-ssd-5 /dev/disk/by-id/google-local-nvme-ssd-4 /dev/disk/by-id/google-local-nvme-ssd-3 /dev/disk/by-id/google-local-nvme-ssd-2 /dev/disk/by-id/google-local-nvme-ssd-1 /dev/disk/by-id/google-local-nvme-ssd-0

findtidak menjamin pengurutan. Tidak masalah jika perangkat tercantum dalam urutan yang berbeda selama jumlah baris output sesuai dengan jumlah partisi SSD yang diharapkan. SSD Lokal dalam mode SCSI memiliki nama standar sepertigoogle-local-ssd. SSD Lokal dalam mode NVMe memiliki nama sepertigoogle-local-nvme-ssd.Gunakan

mdadmuntuk menggabungkan beberapa perangkat SSD Lokal ke dalam satu array bernama/dev/md0. Contoh ini menggabungkan delapan perangkat SSD Lokal dalam mode NVMe. Untuk perangkat SSD Lokal dalam mode SCSI, tentukan nama yang Anda peroleh dari perintahfind:$ sudo mdadm --create /dev/md0 --level=0 --raid-devices=8 \ /dev/disk/by-id/google-local-nvme-ssd-0 \ /dev/disk/by-id/google-local-nvme-ssd-1 \ /dev/disk/by-id/google-local-nvme-ssd-2 \ /dev/disk/by-id/google-local-nvme-ssd-3 \ /dev/disk/by-id/google-local-nvme-ssd-4 \ /dev/disk/by-id/google-local-nvme-ssd-5 \ /dev/disk/by-id/google-local-nvme-ssd-6 \ /dev/disk/by-id/google-local-nvme-ssd-7 mdadm: Defaulting to version 1.2 metadata mdadm: array /dev/md0 started.

Anda dapat mengonfirmasi detail array dengan

mdadm --detail. Menambahkan flag--prefer=by-idakan mencantumkan perangkat yang menggunakan jalur/dev/disk/by-id.sudo mdadm --detail --prefer=by-id /dev/md0

Output akan terlihat seperti berikut untuk setiap perangkat dalam array.

... Number Major Minor RaidDevice State 0 259 0 0 active sync /dev/disk/by-id/google-local-nvme-ssd-0 ...Format array

/dev/md0lengkap dengan sistem file ext4.$ sudo mkfs.ext4 -F /dev/md0Buat direktori tempat Anda dapat memasang

/dev/md0. Untuk contoh ini, buat direktori/mnt/disks/ssd-array:$ sudo mkdir -p /mnt/disks/[MNT_DIR]Ganti

[MNT_DIR]dengan direktori tempat Anda ingin memasang array SSD Lokal.Pasang array

/dev/md0ke direktori/mnt/disks/ssd-array:$ sudo mount /dev/md0 /mnt/disks/[MNT_DIR]Ganti

[MNT_DIR]dengan direktori tempat Anda ingin memasang array SSD Lokal.Konfigurasi akses baca dan tulis ke perangkat. Untuk contoh ini, berikan akses tulis ke perangkat untuk semua pengguna.

$ sudo chmod a+w /mnt/disks/[MNT_DIR]Ganti

[MNT_DIR]dengan direktori tempat Anda memasang array SSD Lokal.

Jika ingin, Anda dapat menambahkan SSD Lokal ke file

/etc/fstabagar perangkat otomatis dipasang kembali saat instance dimulai ulang. Entri ini tidak menyimpan data di SSD Lokal Anda jika instance berhenti. Lihat Persistensi data SSD Lokal untuk mengetahui detailnya.Saat menentukan file

/etc/fstabentri, pastikan untuk menyertakan opsinofailsehingga instance dapat terus melakukan booting meskipun SSD Lokal tidak ada. Misalnya, jika Anda mengambil snapshot boot disk dan membuat instance baru tanpa memasang SSD Lokal, instance dapat melanjutkan proses startup dan tidak dijeda tanpa batas.Buat entri

/etc/fstab. Gunakan perintahblkiduntuk menemukan UUID sistem file pada perangkat dan edit file/etc/fstabuntuk menyertakan UUID tersebut dengan opsi pemasangan. Tentukan opsinofailuntuk mengizinkan sistem melakukan booting meskipun SSD Lokal tidak tersedia. Anda dapat menyelesaikan langkah ini dengan satu perintah. Misalnya:$ echo UUID=`sudo blkid -s UUID -o value /dev/md0` /mnt/disks/[MNT_DIR] ext4 discard,defaults,nofail 0 2 | sudo tee -a /etc/fstabGanti

[MNT_DIR]dengan direktori tempat Anda memasang array SSD Lokal.Jika menggunakan nama perangkat seperti

/dev/md0dalam file/etc/fstab, bukan UUID, Anda harus mengedit file/etc/mdadm/mdadm.confuntuk memastikan array disusun ulang secara otomatis saat booting. Untuk melakukannya, selesaikan dua langkah berikut:- Pastikan array disk dipindai dan disusun ulang secara otomatis saat booting.

$ sudo mdadm --detail --scan | sudo tee -a /etc/mdadm/mdadm.conf - Perbarui

initramfssehingga array akan tersedia selama proses boot awal.$ sudo update-initramfs -u

- Pastikan array disk dipindai dan disusun ulang secara otomatis saat booting.

Gunakan perintah

catuntuk memverifikasi bahwa entri/etc/fstabAnda sudah benar:$ cat /etc/fstab

Jika Anda membuat snapshot dari boot disk instance ini dan menggunakannya untuk membuat instance terpisah yang tidak memiliki SSD Lokal, edit file

/etc/fstabdan hapus entri untuk array SSD Lokal ini. Meskipun opsinofailditerapkan, pastikan file/etc/fstabtetap sinkron dengan partisi yang terpasang ke instance Anda dan hapus entri ini sebelum Anda membuat snapshot boot disk.Instance Windows

Gunakan alat Pengelolaan Disk Windows untuk memformat dan memasang array SSD Lokal pada instance Windows.

Hubungkan ke instance melalui RDP. Untuk contoh ini, buka halaman Instance VM, lalu klik tombol RDP di samping instance yang memasang SSD Lokal. Setelah Anda memasukkan nama pengguna dan sandi, jendela akan terbuka dengan antarmuka desktop untuk server Anda.

Klik kanan tombol Start Windows dan pilih Pengelolaan Disk.

Jika Anda belum melakukan inisialisasi SSD Lokal sebelumnya, alat ini akan meminta Anda memilih skema partisi untuk partisi baru. Pilih GPT dan klik OKE.

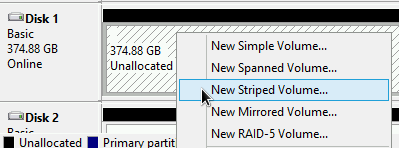

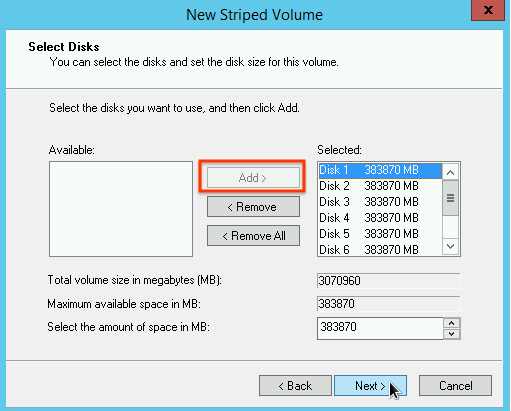

Setelah SSD Lokal diinisialisasi, klik kanan ruang disk yang tidak teralokasi, lalu pilih New Striped Volume.

Pilih partisi SSD Lokal yang ingin Anda sertakan dalam array striped. Untuk contoh ini, pilih semua partisi untuk menggabungkannya ke dalam satu perangkat SSD Lokal.

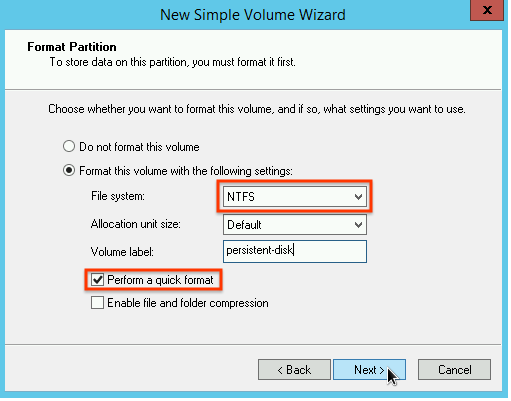

Ikuti petunjuk di Wizard Volume Striped Baru untuk mengonfigurasi volume baru. Anda dapat menggunakan format partisi apa pun yang disukai, tetapi untuk contoh ini, pilih

NTFS. Selain itu, centang Lakukan format cepat untuk mempercepat proses pemformatan.

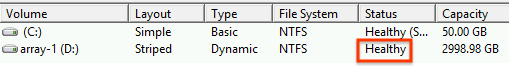

Setelah Anda menyelesaikan wizard dan volume selesai memformat, periksa SSD Lokal baru untuk memastikannya memiliki status

Healthy.

Sekarang, Anda dapat menulis file ke SSD Lokal.

Langkah berikutnya

- Pelajari nama perangkat untuk VM lebih lanjut.

- Pelajari cara membuat tolok ukur performa untuk disk SSD Lokal

Kecuali dinyatakan lain, konten di halaman ini dilisensikan berdasarkan Lisensi Creative Commons Attribution 4.0, sedangkan contoh kode dilisensikan berdasarkan Lisensi Apache 2.0. Untuk mengetahui informasi selengkapnya, lihat Kebijakan Situs Google Developers. Java adalah merek dagang terdaftar dari Oracle dan/atau afiliasinya.

Terakhir diperbarui pada 2025-10-02 UTC.

-