Introdução

Este guia para principiantes apresenta o AutoML. Para compreender as principais diferenças entre o AutoML e a preparação personalizada, consulte o artigo Escolher um método de preparação.

Imagine:

- Trabalha no departamento de marketing de um retalhista digital.

- Está a trabalhar num projeto de arquitetura que identifica tipos de edifícios.

- A sua empresa tem um formulário de contacto no respetivo Website.

A organização manual de imagens e tabelas é tediosa e demorada. Ensinar um computador a identificar e denunciar automaticamente o conteúdo.

Imagem

Trabalha com uma comissão de preservação arquitetónica que está a tentar identificar bairros com um estilo arquitetónico consistente na sua cidade. Tem centenas de milhares de fotos rápidas de casas para analisar. No entanto, é um processo tedioso e propenso a erros quando

tenta categorizar todas estas imagens manualmente. Um estagiário etiquetou algumas centenas há alguns meses, mas mais ninguém analisou os dados. Seria muito útil se pudesse ensinar o seu computador a fazer esta revisão por si!

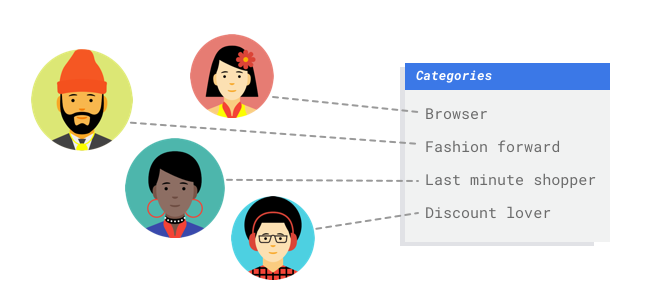

Tabular

Trabalha no departamento de marketing de um retalhista digital. A sua equipa e o anunciante estão a criar um programa de email personalizado com base em personagens fictícias de clientes. Criou as personas e os emails de marketing estão prontos. Agora, tem de criar um sistema que agrupe os clientes em cada persona com base nas preferências de retalho e no comportamento de gastos, mesmo quando são novos clientes. Para maximizar a interação dos clientes, também quer prever os respetivos hábitos de gastos para poder otimizar o momento de envio dos emails.

Uma vez que é um retalhista digital, tem dados sobre os seus clientes e as compras que fizeram. Mas e os novos clientes? As abordagens tradicionais podem calcular estes valores para clientes existentes com longos históricos de compras, mas não funcionam bem com clientes com poucos dados do histórico. E se pudesse criar um sistema para prever estes valores e aumentar a velocidade com que oferece programas de marketing personalizados a todos os seus clientes?

Felizmente, a aprendizagem automática e o Vertex AI estão bem posicionados para resolver estes problemas.

Este guia explica como funciona o Vertex AI para conjuntos de dados e modelos do AutoML, e ilustra os tipos de problemas que o Vertex AI resolve.

Uma nota sobre a imparcialidade

A Google está empenhada em progredir na implementação de práticas de IA responsável. Para o conseguir, os nossos produtos de ML, incluindo o AutoML, são concebidos com base em princípios essenciais, como a imparcialidade e a aprendizagem automática centrada no ser humano. Para mais informações sobre as práticas recomendadas para mitigar a parcialidade ao criar o seu próprio sistema de ML, consulte o guia de ML inclusivo – AutoML

Por que motivo o Vertex AI é a ferramenta certa para este problema?

A programação clássica requer que o programador especifique instruções passo a passo para um computador seguir. Existe tanta variação na cor, no ângulo, na resolução e na iluminação que é necessário programar demasiadas regras para indicar a uma máquina como tomar a decisão correta. É difícil imaginar por onde começar. Em alternativa, os comentários dos clientes usam um vocabulário e uma estrutura amplos e variados, e são demasiado diversos para um conjunto simples de regras captar. Se tentar criar filtros manuais, vai perceber rapidamente que não consegue categorizar a maioria dos comentários dos clientes. Precisa de um sistema que possa generalizar para uma grande variedade de comentários. Num cenário em que uma sequência de regras específicas está associada a uma expansão exponencial, precisa de um sistema que possa aprender com exemplos.

Felizmente, a aprendizagem automática resolve estes problemas.

Como funciona o Vertex AI?

O Vertex AI envolve tarefas de aprendizagem supervisionada para alcançar um resultado escolhido. As especificidades do algoritmo e dos métodos de preparação mudam com base no tipo de dados e no exemplo de utilização. Existem muitas subcategorias diferentes de aprendizagem automática, que resolvem problemas diferentes e funcionam dentro de restrições diferentes.

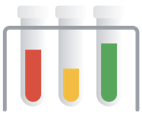

Imagem

Prepara, testa e valida o modelo de aprendizagem automática com imagens de exemplo que são anotadas com etiquetas para classificação ou anotadas com etiquetas e caixas de limite para deteção de objetos. Através da aprendizagem supervisionada, pode preparar um modelo para reconhecer os padrões e o conteúdo que lhe interessam nas imagens.

Tabular

Prepara um modelo de aprendizagem automática com dados de exemplo. O Vertex AI

usa dados tabulares (estruturados) para preparar um modelo de aprendizagem automática para fazer

inferências sobre novos dados. Uma coluna do seu conjunto de dados, denominada destino, é o que o modelo vai aprender a prever. Algumas das outras colunas de dados são entradas (denominadas caraterísticas) a partir das quais o modelo vai aprender padrões. Pode

usar as mesmas caraterísticas de entrada para criar vários tipos de modelos apenas alterando

a coluna de destino e as opções de preparação. No exemplo de email marketing, isto significa que pode criar modelos com as mesmas caraterísticas de entrada, mas com inferências de destino diferentes. Um modelo pode prever o perfil fictício de um cliente (um alvo categórico), outro modelo pode prever os respetivos gastos mensais (um alvo numérico) e outro pode prever a procura diária dos seus produtos para os próximos três meses (série de alvos numéricos).

Fluxo de trabalho do Vertex AI

O Vertex AI usa um fluxo de trabalho de aprendizagem automática padrão:

- Reúna os seus dados: determine os dados de que precisa para preparar e testar o modelo com base no resultado que quer alcançar.

- Prepare os dados: certifique-se de que os dados estão formatados e etiquetados corretamente.

- Preparação: defina parâmetros e crie o seu modelo.

- Avalie: reveja as métricas do modelo.

- Implemente e preveja: disponibilize o seu modelo para utilização.

Preparação de dados

Mas antes de começar a recolher os seus dados, pense no problema que está a tentar resolver. Isto informa os seus requisitos de dados.

Avalie o seu exemplo de utilização

Comece pelo seu problema: que resultado quer alcançar?

Imagem

Ao criar o conjunto de dados, comece sempre pelo exemplo de utilização. Pode começar com as seguintes perguntas:

- Qual é o resultado que está a tentar alcançar?

- Que tipos de categorias ou objetos teria de reconhecer para alcançar este resultado?

- É possível para os humanos reconhecerem essas categorias? Embora o Vertex AI possa processar uma magnitude maior de categorias do que os humanos conseguem lembrar-se e atribuir em qualquer altura, se um humano não conseguir reconhecer uma categoria específica, o Vertex AI também terá dificuldades.

- Que tipos de exemplos refletiriam melhor o tipo e o intervalo de dados que o seu sistema vai ver e tentar classificar?

Tabular

Que tipo de dados é a coluna de destino? A que quantidade de dados tem acesso? Com base nas suas respostas, o Vertex AI cria o modelo necessário para resolver o seu exemplo de utilização:

- Um modelo de classificação binária prevê um resultado binário (uma de duas classes). Use isto para perguntas de sim ou não, por exemplo, para prever se um cliente compraria uma subscrição (ou não). Tudo o resto sendo igual, um problema de classificação binária requer menos dados do que outros tipos de modelos.

- Um modelo de classificação multiclasse prevê uma classe a partir de três ou mais classes discretas. Use esta opção para categorizar itens. Para o exemplo de retalho, é recomendável criar um modelo de classificação de várias classes para segmentar os clientes em diferentes perfis fictícios.

- Um modelo de previsão prevê uma sequência de valores. Por exemplo, como retalhista, pode querer prever a procura diária dos seus produtos para os próximos 3 meses, de modo a poder armazenar adequadamente os inventários de produtos com antecedência.

- Um modelo de regressão prevê um valor contínuo. No exemplo do setor de retalho, quer criar um modelo de regressão para prever quanto um cliente vai gastar no próximo mês.

Reúna os seus dados

Depois de estabelecer o seu exemplo de utilização, recolha os dados que lhe permitem criar o modelo pretendido.

Imagem

Depois de determinar os dados de que precisa, tem de encontrar uma forma de os obter. Pode começar por considerar todos os dados que a sua organização recolhe. Pode verificar que já está a recolher os dados relevantes de que precisa para preparar um modelo. Caso não tenha esses dados,

pode obtê-los manualmente ou externalizá-los para um fornecedor externo.

Depois de determinar os dados de que precisa, tem de encontrar uma forma de os obter. Pode começar por considerar todos os dados que a sua organização recolhe. Pode verificar que já está a recolher os dados relevantes de que precisa para preparar um modelo. Caso não tenha esses dados,

pode obtê-los manualmente ou externalizá-los para um fornecedor externo.

Inclua exemplos etiquetados suficientes em cada categoria

O mínimo exigido pela Vertex AI Training é de 100 exemplos de imagens por categoria/etiqueta para classificação.

A probabilidade de reconhecer com êxito uma etiqueta aumenta com o número de exemplos de alta qualidade para cada uma. Em geral, quanto mais dados etiquetados conseguir fornecer ao processo de preparação, melhor será o seu modelo. Segmente, pelo menos, 1000 exemplos por etiqueta.

O mínimo exigido pela Vertex AI Training é de 100 exemplos de imagens por categoria/etiqueta para classificação.

A probabilidade de reconhecer com êxito uma etiqueta aumenta com o número de exemplos de alta qualidade para cada uma. Em geral, quanto mais dados etiquetados conseguir fornecer ao processo de preparação, melhor será o seu modelo. Segmente, pelo menos, 1000 exemplos por etiqueta.

Distribuir exemplos igualmente entre categorias

É importante captar quantidades aproximadamente semelhantes de exemplos de preparação para cada categoria. Mesmo que tenha uma grande quantidade de dados para uma etiqueta, é melhor ter uma distribuição igual para cada etiqueta. Para ver o motivo, imagine que 80% das imagens que usa para criar o seu modelo são fotos de casas unifamiliares de estilo moderno. Com uma distribuição tão desequilibrada de etiquetas, é muito provável que o seu modelo aprenda que é seguro dizer-lhe sempre que uma foto é de uma casa unifamiliar moderna, em vez de arriscar e tentar prever uma etiqueta muito menos comum.

É como escrever um teste de escolha múltipla em que quase todas as respostas corretas são "C". Em breve, o participante do teste experiente vai perceber que pode responder "C" sempre sem sequer olhar para a pergunta.

Compreendemos que nem sempre é possível obter um número aproximadamente igual de exemplos para cada etiqueta. Pode ser mais difícil encontrar exemplos imparciais de alta qualidade para algumas categorias. Nessas circunstâncias, pode seguir esta regra geral: a etiqueta com o menor número de exemplos deve ter, pelo menos, 10% dos exemplos da etiqueta com o maior número de exemplos. Assim, se a etiqueta maior tiver 10 000 exemplos, a etiqueta mais pequena deve ter, pelo menos, 1000 exemplos.

Capture a variação no âmbito do problema

Por motivos semelhantes, tente garantir que os seus dados captam a variedade e a diversidade do seu espaço de problemas. Quanto mais ampla for a seleção que o processo de preparação do modelo tiver acesso, mais facilmente

vai generalizar para novos exemplos. Por exemplo, se estiver a tentar classificar fotos de eletrónica de consumo em categorias, quanto maior for a variedade de eletrónica de consumo a que o modelo é exposto na preparação, maior é a probabilidade de conseguir distinguir entre um novo modelo de tablet, telemóvel ou portátil, mesmo que nunca tenha visto esse modelo específico antes.

Faça a correspondência dos dados com o resultado pretendido para o seu modelo

Encontrar imagens visualmente semelhantes àquilo sobre o qual planeia fazer inferências. Se estiver a tentar classificar imagens de casas que foram todas tiradas em tempo de inverno com neve, provavelmente não vai obter um bom desempenho de um modelo preparado apenas com imagens de casas tiradas em tempo de sol, mesmo que as tenha etiquetado com as classes nas quais tem interesse, uma vez que a iluminação e o cenário podem ser suficientemente diferentes para afetar o desempenho. Idealmente, os exemplos de preparação são dados do mundo real

extraídos do mesmo conjunto de dados que planeia usar para classificar com o modelo.

Tabular

Depois de estabelecer o seu exemplo de utilização, tem de recolher dados para preparar o modelo.

A obtenção e a preparação de dados são passos essenciais para criar um modelo de aprendizagem automática.

Os dados que tem disponíveis determinam o tipo de problemas que pode resolver. Quantos dados tem disponíveis? Os seus dados são relevantes para as perguntas às quais está a tentar responder? Ao

recolher os seus dados, tenha em atenção as seguintes considerações importantes.

Depois de estabelecer o seu exemplo de utilização, tem de recolher dados para preparar o modelo.

A obtenção e a preparação de dados são passos essenciais para criar um modelo de aprendizagem automática.

Os dados que tem disponíveis determinam o tipo de problemas que pode resolver. Quantos dados tem disponíveis? Os seus dados são relevantes para as perguntas às quais está a tentar responder? Ao

recolher os seus dados, tenha em atenção as seguintes considerações importantes.

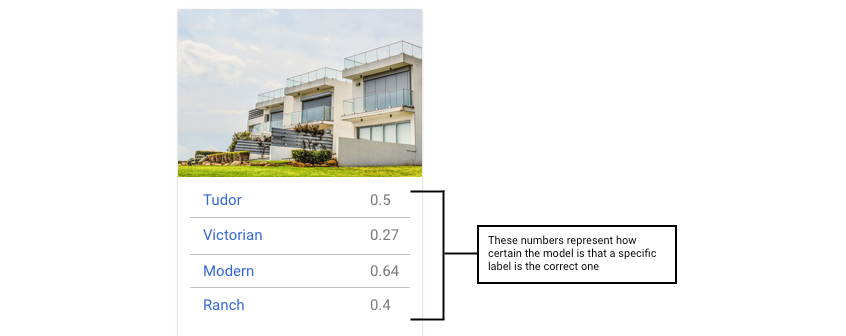

Selecione funcionalidades relevantes

Uma funcionalidade é um atributo de entrada usado para a preparação de modelos. As funcionalidades são a forma como o seu modelo identifica padrões para fazer inferências, pelo que têm de ser relevantes para o seu problema. Por exemplo, para criar um modelo que preveja se uma transação de cartão de crédito é fraudulenta ou não, tem de criar um conjunto de dados que contenha detalhes da transação, como o comprador, o vendedor, o valor, a data e a hora, e os artigos comprados. Outras funcionalidades úteis podem ser informações históricas sobre o comprador e o vendedor, e a frequência com que o artigo comprado esteve envolvido em fraudes. Que outras funcionalidades podem ser relevantes?

Considere o exemplo de utilização de marketing por email de retalho da introdução. Seguem-se algumas colunas de atributos que pode precisar:

- Lista de artigos comprados (incluindo marcas, categorias, preços e descontos)

- Número de artigos comprados (último dia, semana, mês, ano)

- Soma do dinheiro gasto (último dia, semana, mês, ano)

- Para cada artigo, número total vendido por dia

- Para cada item, total em stock por dia

- Quer esteja a apresentar uma promoção para um dia específico

- Perfil demográfico conhecido do comprador

Inclua dados suficientes

Em geral, quanto mais exemplos de preparação tiver, melhor será o resultado. A quantidade de dados de exemplo necessários também varia consoante a complexidade do problema que está a tentar resolver. Não

precisa de tantos dados para ter um modelo de classificação binária preciso em comparação com um modelo de várias classes

porque é menos complicado prever uma classe a partir de duas do que de muitas.

Em geral, quanto mais exemplos de preparação tiver, melhor será o resultado. A quantidade de dados de exemplo necessários também varia consoante a complexidade do problema que está a tentar resolver. Não

precisa de tantos dados para ter um modelo de classificação binária preciso em comparação com um modelo de várias classes

porque é menos complicado prever uma classe a partir de duas do que de muitas.

Não existe uma fórmula perfeita, mas existem mínimos recomendados de dados de exemplo:

- Problema de classificação: 50 linhas x o número de funcionalidades

- Problema de previsão:

- 5000 linhas x o número de funcionalidades

- 10 valores únicos na coluna do identificador da série cronológica x o número de caraterísticas

- Problema de regressão: 200 vezes o número de caraterísticas

Variação de captura

O conjunto de dados deve captar a diversidade do seu espaço de problemas. Quanto mais diversos forem os exemplos que um modelo vê durante a preparação, mais facilmente consegue generalizar para exemplos novos ou menos comuns. Imagine que o seu modelo de retalho foi preparado apenas com dados de compras do inverno. Seria capaz de prever com êxito as preferências de vestuário de verão ou os comportamentos de compra?

Prepare os seus dados

Imagem

Depois de decidir qual é a opção mais adequada para si (uma divisão manual ou a predefinição), pode adicionar dados no

Vertex AI através de um dos seguintes métodos:

Depois de decidir qual é a opção mais adequada para si (uma divisão manual ou a predefinição), pode adicionar dados no

Vertex AI através de um dos seguintes métodos:

- Pode importar dados do seu computador ou do Cloud Storage num formato disponível (CSV ou JSON Lines) com as etiquetas (e caixas delimitadoras, se necessário) incorporadas. Para mais informações sobre o formato do ficheiro de importação, consulte o artigo Prepare os dados de treino. Se quiser dividir o conjunto de dados manualmente, pode especificar as divisões no ficheiro de importação CSV ou JSON Lines.

- Se os seus dados não tiverem sido anotados, pode carregar imagens não etiquetadas e usar a consola para aplicar anotações. Google Cloud Pode gerir estas anotações em vários conjuntos de anotações para o mesmo conjunto de imagens. Por exemplo, para um único conjunto de imagens, pode ter um conjunto de anotações com informações de caixa de limite e etiqueta para fazer a deteção de objetos, e também ter outro conjunto de anotações apenas com anotações de etiquetas para classificação.

Tabular

Depois de identificar os dados disponíveis, tem de se certificar de que estão prontos para a preparação.

Se os seus dados forem tendenciosos ou contiverem valores em falta ou erróneos, isto afeta a qualidade do modelo. Tenha em atenção o seguinte antes de começar a preparar o modelo.

Saiba mais.

Depois de identificar os dados disponíveis, tem de se certificar de que estão prontos para a preparação.

Se os seus dados forem tendenciosos ou contiverem valores em falta ou erróneos, isto afeta a qualidade do modelo. Tenha em atenção o seguinte antes de começar a preparar o modelo.

Saiba mais.

Impeça a fuga de dados e a discrepância entre a preparação e a publicação

A fuga de dados ocorre quando usa funcionalidades de entrada durante a preparação que "deixam escapar" informações sobre o destino que está a tentar prever e que não estão disponíveis quando o modelo é realmente publicado. Isto pode ser detetado quando uma funcionalidade altamente correlacionada com a coluna de destino é incluída como uma das funcionalidades de entrada. Por exemplo, se estiver a criar um modelo para prever se um cliente vai inscrever-se numa subscrição no próximo mês e uma das funcionalidades de entrada for um pagamento de subscrição futuro desse cliente. Isto pode levar a um forte desempenho do modelo durante os testes, mas não quando implementado em produção, uma vez que as informações de pagamento de subscrições futuras não estão disponíveis no momento da publicação.

A discrepância entre a preparação e a publicação ocorre quando as funcionalidades de entrada usadas durante a preparação são diferentes das fornecidas ao modelo no momento da publicação, o que resulta numa má qualidade do modelo em produção. Por exemplo, criar um modelo para prever as temperaturas de hora em hora, mas prepará-lo com dados que apenas contêm as temperaturas semanais. Outro exemplo: fornecer sempre as notas de um aluno nos dados de preparação quando prevê a desistência do aluno, mas não fornecer estas informações no momento da publicação.

Compreender os seus dados de preparação é importante para evitar a fuga de dados e a divergência entre a preparação e a publicação:

- Antes de usar quaisquer dados, certifique-se de que sabe o que significam e se deve ou não usá-los como uma funcionalidade

- Verifique a correlação no separador Treinar. As correlações elevadas devem ser sinalizadas para revisão.

- Divergência entre preparação e publicação: certifique-se de que só fornece funcionalidades de entrada ao modelo que estão disponíveis exatamente da mesma forma no momento da publicação.

Limpe dados em falta, incompletos e inconsistentes

É comum ter valores em falta e incorretos nos seus dados de exemplo. Dedique tempo a rever e, quando possível, melhorar a qualidade dos seus dados antes de os usar para preparação. Quanto mais valores em falta, menos úteis serão os seus dados para preparar um modelo de aprendizagem automática.

- Verifique se existem valores em falta nos dados e corrija-os, se possível, ou deixe o valor em branco se a coluna estiver definida como anulável. O Vertex AI pode processar valores em falta, mas é mais provável que obtenha resultados ideais se todos os valores estiverem disponíveis.

- Para a previsão, verifique se o intervalo entre as linhas de dados de preparação é consistente. O Vertex AI pode imputar valores em falta, mas é mais provável que obtenha resultados ideais se todas as linhas estiverem disponíveis.

- Limpe os seus dados corrigindo ou eliminando erros ou ruído nos dados. Torne os seus dados consistentes: Reveja a ortografia, as abreviaturas e a formatação.

Analise os seus dados após a importação

O Vertex AI oferece uma vista geral do seu conjunto de dados após a importação. Reveja o conjunto de dados importado para se certificar de que cada coluna tem o tipo de variável correto. O Vertex AI deteta automaticamente o tipo de variável com base nos valores das colunas, mas é melhor rever cada um. Também deve rever a capacidade de aceitar valores nulos de cada coluna, que determina se uma coluna pode ter valores em falta ou NULL.

Prepare o modelo

Imagem

Considere como a Vertex AI usa o seu conjunto de dados na criação de um modelo personalizado

O seu conjunto de dados contém conjuntos de preparação, validação e testes. Se não especificar as divisões

(consulte Prepare os seus dados), o Vertex AI usa automaticamente 80% das suas imagens para a preparação,

10% para a validação e 10% para os testes.

Conjunto de preparação

A grande maioria dos seus dados deve estar no conjunto de preparação. Estes são os dados que o modelo "vê" durante o treino: são usados para aprender os parâmetros do modelo, nomeadamente os pesos das ligações entre os nós da rede neural.

A grande maioria dos seus dados deve estar no conjunto de preparação. Estes são os dados que o modelo "vê" durante o treino: são usados para aprender os parâmetros do modelo, nomeadamente os pesos das ligações entre os nós da rede neural.

Conjunto de validação

O conjunto de validação, por vezes também denominado conjunto "dev", também é usado durante o processo de preparação.

Depois de a estrutura de aprendizagem do modelo incorporar dados de preparação durante cada iteração do processo de preparação, usa o desempenho do modelo no conjunto de validação para ajustar os hiperparâmetros do modelo, que são variáveis que especificam a estrutura do modelo. Se tentou usar o conjunto de preparação para ajustar os hiperparâmetros, é muito provável que o modelo acabe por se concentrar demasiado nos dados de preparação e tenha dificuldade em generalizar para exemplos que não correspondam exatamente aos dados de preparação.

A utilização de um conjunto de dados algo novo para aperfeiçoar a estrutura do modelo significa que o modelo vai generalizar melhor.

O conjunto de validação, por vezes também denominado conjunto "dev", também é usado durante o processo de preparação.

Depois de a estrutura de aprendizagem do modelo incorporar dados de preparação durante cada iteração do processo de preparação, usa o desempenho do modelo no conjunto de validação para ajustar os hiperparâmetros do modelo, que são variáveis que especificam a estrutura do modelo. Se tentou usar o conjunto de preparação para ajustar os hiperparâmetros, é muito provável que o modelo acabe por se concentrar demasiado nos dados de preparação e tenha dificuldade em generalizar para exemplos que não correspondam exatamente aos dados de preparação.

A utilização de um conjunto de dados algo novo para aperfeiçoar a estrutura do modelo significa que o modelo vai generalizar melhor.

Conjunto de testes

O conjunto de testes não está envolvido no processo de preparação. Assim que o modelo concluir a preparação, usamos o conjunto de testes como um desafio totalmente novo para o modelo. O desempenho do modelo no conjunto de testes destina-se a dar-lhe uma ideia bastante precisa de como o modelo vai funcionar com dados reais.

O conjunto de testes não está envolvido no processo de preparação. Assim que o modelo concluir a preparação, usamos o conjunto de testes como um desafio totalmente novo para o modelo. O desempenho do modelo no conjunto de testes destina-se a dar-lhe uma ideia bastante precisa de como o modelo vai funcionar com dados reais.

Divisão manual

Também pode dividir o conjunto de dados manualmente. A divisão manual dos dados é uma boa opção quando

quer exercer mais controlo sobre o processo ou se existirem exemplos específicos que tenha

a certeza de que quer incluir numa determinada parte do ciclo de vida da preparação do modelo.

Também pode dividir o conjunto de dados manualmente. A divisão manual dos dados é uma boa opção quando

quer exercer mais controlo sobre o processo ou se existirem exemplos específicos que tenha

a certeza de que quer incluir numa determinada parte do ciclo de vida da preparação do modelo.

Tabular

Depois de importar o conjunto de dados, o passo seguinte é preparar um modelo. O Vertex AI gera um modelo de aprendizagem automática fiável com as predefinições de preparação, mas pode querer ajustar alguns dos parâmetros com base no seu exemplo de utilização.

Tente selecionar o maior número possível de colunas de funcionalidades para a preparação, mas reveja cada uma para se certificar de que é adequada para a preparação. Tenha em atenção o seguinte para a seleção de funcionalidades:

- Não selecione colunas de atributos que criem ruído, como colunas de identificadores atribuídos aleatoriamente com um valor único para cada linha.

- Certifique-se de que compreende cada coluna de caraterísticas e os respetivos valores.

- Se estiver a criar vários modelos a partir de um conjunto de dados, remova as colunas de destino que não fazem parte do problema de inferência atual.

- Recorde os princípios de equidade: está a preparar o seu modelo com uma funcionalidade que possa levar a uma tomada de decisões tendenciosa ou injusta para grupos marginalizados?

Como o Vertex AI usa o seu conjunto de dados

O seu conjunto de dados é dividido em conjuntos de preparação, validação e testes. A divisão predefinida que o Vertex AI aplica depende do tipo de modelo que está a preparar. Também pode especificar as divisões (divisões manuais) se

for necessário. Para mais informações, consulte o artigo Acerca das divisões de dados para modelos do AutoML.

Conjunto de preparação

A grande maioria dos seus dados deve estar no conjunto de preparação. Estes são os dados que o modelo "vê" durante o treino: são usados para aprender os parâmetros do modelo, nomeadamente os pesos das ligações entre os nós da rede neural.

A grande maioria dos seus dados deve estar no conjunto de preparação. Estes são os dados que o modelo "vê" durante o treino: são usados para aprender os parâmetros do modelo, nomeadamente os pesos das ligações entre os nós da rede neural.

Conjunto de validação

O conjunto de validação, por vezes também denominado conjunto "dev", também é usado durante o processo de preparação.

Depois de a estrutura de aprendizagem do modelo incorporar dados de preparação durante cada iteração do processo de preparação, usa o desempenho do modelo no conjunto de validação para ajustar os hiperparâmetros do modelo, que são variáveis que especificam a estrutura do modelo. Se tentou usar o conjunto de preparação para ajustar os hiperparâmetros, é muito provável que o modelo acabe por se concentrar demasiado nos dados de preparação e tenha dificuldade em generalizar para exemplos que não correspondam exatamente aos dados de preparação.

A utilização de um conjunto de dados algo novo para aperfeiçoar a estrutura do modelo significa que o modelo vai generalizar melhor.

O conjunto de validação, por vezes também denominado conjunto "dev", também é usado durante o processo de preparação.

Depois de a estrutura de aprendizagem do modelo incorporar dados de preparação durante cada iteração do processo de preparação, usa o desempenho do modelo no conjunto de validação para ajustar os hiperparâmetros do modelo, que são variáveis que especificam a estrutura do modelo. Se tentou usar o conjunto de preparação para ajustar os hiperparâmetros, é muito provável que o modelo acabe por se concentrar demasiado nos dados de preparação e tenha dificuldade em generalizar para exemplos que não correspondam exatamente aos dados de preparação.

A utilização de um conjunto de dados algo novo para aperfeiçoar a estrutura do modelo significa que o modelo vai generalizar melhor.

Conjunto de testes

O conjunto de testes não está envolvido no processo de preparação. Depois de o modelo concluir a preparação, o Vertex AI usa o conjunto de testes como um desafio totalmente novo para o modelo.

O desempenho do seu modelo no conjunto de testes destina-se a dar-lhe uma ideia bastante boa de como

o seu modelo vai funcionar com dados reais.

O conjunto de testes não está envolvido no processo de preparação. Depois de o modelo concluir a preparação, o Vertex AI usa o conjunto de testes como um desafio totalmente novo para o modelo.

O desempenho do seu modelo no conjunto de testes destina-se a dar-lhe uma ideia bastante boa de como

o seu modelo vai funcionar com dados reais.

Avalie, teste e implemente o seu modelo

Avalie o modelo

Imagem

Depois de o modelo ser preparado, recebe um resumo do desempenho do modelo. Clique em avaliar ou ver avaliação completa para ver uma análise detalhada.

A depuração de um modelo está mais relacionada com a depuração dos dados do que do próprio modelo. Se, em qualquer altura, o seu modelo começar a agir de forma inesperada enquanto avalia o respetivo desempenho antes e depois da implementação em produção, deve voltar atrás e verificar os seus dados para ver onde podem ser melhorados.

A depuração de um modelo está mais relacionada com a depuração dos dados do que do próprio modelo. Se, em qualquer altura, o seu modelo começar a agir de forma inesperada enquanto avalia o respetivo desempenho antes e depois da implementação em produção, deve voltar atrás e verificar os seus dados para ver onde podem ser melhorados.

Que tipos de análises posso fazer no Vertex AI?

Na secção de avaliação do Vertex AI, pode avaliar o desempenho do seu modelo personalizado usando o resultado do modelo em exemplos de teste e métricas de aprendizagem automática comuns. Nesta secção, vamos abordar o significado de cada um destes conceitos.

- O resultado do modelo

- O limite da pontuação

- Verdadeiros positivos, verdadeiros negativos, falsos positivos e falsos negativos

- Precisão e revocação

- Curvas de precisão/revocação

- Precisão média

Como posso interpretar o resultado do modelo?

O Vertex AI extrai exemplos dos seus dados de teste para apresentar desafios totalmente novos ao seu modelo. Para cada exemplo, o modelo produz uma série de números que comunicam a intensidade com que

associa cada etiqueta a esse exemplo. Se o número for elevado, o modelo tem uma elevada confiança de que a etiqueta deve ser aplicada a esse documento.

O que é o limite da pontuação?

Podemos converter estas probabilidades em valores binários "ativado"/"desativado" definindo um limite de pontuação.

O limite da pontuação refere-se ao nível de confiança que o modelo tem de ter para atribuir uma categoria a um item de teste. O controlo de deslize do limite da pontuação na Google Cloud consola é uma ferramenta visual para testar

o efeito de diferentes limites para todas as categorias e categorias individuais no seu conjunto de dados.

Se o limite da pontuação for baixo, o modelo classifica mais imagens, mas corre o risco de

classificar incorretamente algumas imagens no processo. Se o limite da pontuação for elevado, o modelo classifica

menos imagens, mas tem um risco menor de classificar incorretamente as imagens. Pode ajustar os limites por categoria na consola para experimentar. Google Cloud No entanto, quando usar o modelo em produção, tem de aplicar os limites que considerou ideais.

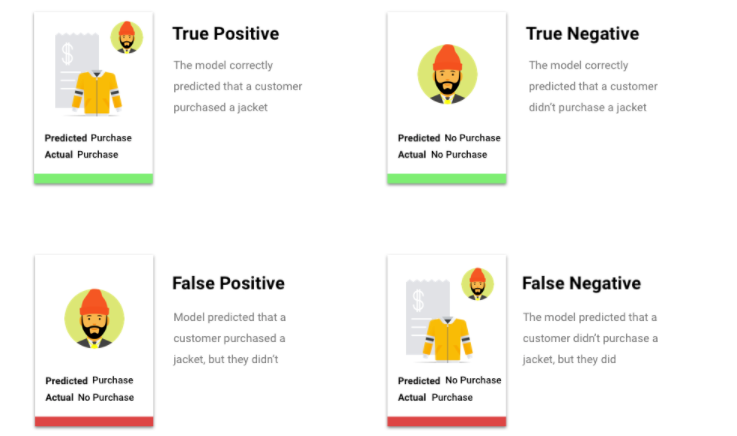

O que são verdadeiros positivos, verdadeiros negativos, falsos positivos e falsos negativos?

Após aplicar o limite mínimo da pontuação, as inferências feitas pelo seu modelo vão enquadrar-se numa das

quatro categorias seguintes:

Os limites mínimos que considerou ideais.

Podemos usar estas categorias para calcular a precisão e a capacidade de memorização, métricas que nos ajudam a avaliar a eficácia do nosso modelo.

O que são a precisão e a revocação?

A precisão e a revocação ajudam-nos a compreender o desempenho do nosso modelo na captura de informações e a quantidade de informações que

está a omitir. A precisão indica-nos, de todos os exemplos de teste aos quais foi atribuída uma etiqueta, quantos deveriam realmente ter sido categorizados com essa etiqueta. A revocação indica-nos, de todos os exemplos de teste que deveriam ter tido o marcador atribuído, quantos tiveram efetivamente o marcador atribuído.

Devo otimizar para precisão ou revocação?

Consoante o exemplo de utilização, pode querer otimizar a precisão ou a capacidade de memorização. Considere os dois exemplos de utilização seguintes quando decidir que abordagem é mais adequada para si.

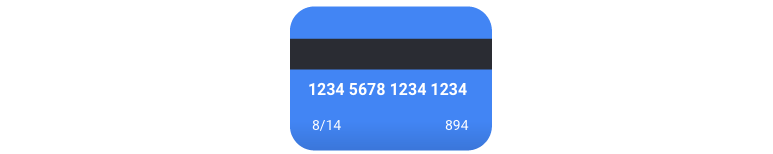

Exemplo de utilização: privacidade nas imagens

Suponhamos que quer criar um sistema que detete automaticamente informações confidenciais e as esbata.

Neste caso, os falsos positivos seriam coisas que não precisam de ser esbatidas e que são esbatidas,

o que pode ser irritante, mas não prejudicial.

Os falsos negativos, neste caso, seriam elementos que precisam de ser esbatidos e que não são esbatidos, como um cartão de crédito, o que pode levar ao roubo de identidade.

Neste caso, é recomendável otimizar em função da capacidade de memorização. Esta métrica mede, para todas as inferências feitas, a quantidade de dados que estão a ser excluídos. Um modelo de elevada capacidade de memorização tem probabilidade de etiquetar exemplos marginalmente relevantes. Isto é útil para casos em que a sua categoria tem poucos dados de preparação.

Exemplo de utilização: pesquisa de fotos de banco de imagens

Suponhamos que quer criar um sistema que encontre a melhor foto de banco de imagens para uma determinada palavra-chave.

Um falso positivo, neste caso, seria devolver uma imagem irrelevante. Uma vez que o seu produto se orgulha de devolver apenas as imagens com a melhor correspondência, isto seria uma falha grave.

Um falso negativo, neste caso, seria não devolver uma imagem relevante para uma pesquisa de palavras-chave. Uma vez que muitos termos de pesquisa têm milhares de fotos que são uma forte potencial correspondência, isto não é um problema.

Neste caso, é recomendável otimizar em função da precisão. Esta métrica mede, para todas as inferências feitas, a sua precisão. É provável que um modelo de alta precisão etiquete apenas os exemplos mais relevantes, o que é útil para casos em que a sua classe é comum nos dados de preparação.

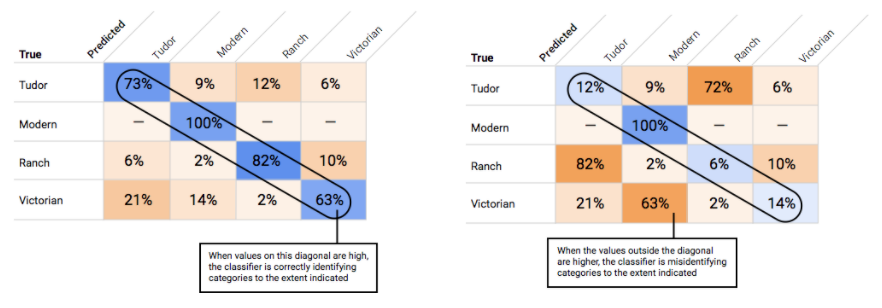

Como posso usar a matriz de confusão?

Como interpreto as curvas de precisão-recolha?

A ferramenta de limite da classificação permite-lhe explorar como o limite da classificação escolhido afeta

a precisão e a capacidade de memorização. À medida que arrasta o controlo de deslize na barra do limite da pontuação, pode ver onde esse limite se situa na curva de compromisso entre precisão e recall, bem como a forma como esse limite afeta a precisão e o recall individualmente (para modelos de várias classes, nestes gráficos, a precisão e o recall significam que a única etiqueta usada para calcular as métricas de precisão e recall é a etiqueta com a pontuação mais alta no conjunto de etiquetas que devolvemos). Isto pode ajudar a encontrar um bom equilíbrio entre falsos positivos e falsos negativos.

Depois de escolher um limite que pareça aceitável para o seu modelo como um todo, clique nas etiquetas individuais e veja onde esse limite se enquadra na respetiva curva de precisão-recall por etiqueta. Em alguns casos, pode significar que recebe muitas inferências incorretas para algumas etiquetas, o que pode ajudar a decidir escolher um limite por classe personalizado para essas etiquetas. Por exemplo, suponhamos que analisa o conjunto de dados de casas e repara que um limite de 0,5 tem uma precisão e uma capacidade de memorização razoáveis para todos os tipos de imagens, exceto "Tudor", talvez porque seja uma categoria muito geral. Para essa categoria, vê muitos falsos positivos. Nesse caso, pode decidir usar um limite de 0,8 apenas para "Tudor" quando chamar o classificador para inferências.

O que é a precisão média?

Uma métrica útil para a precisão do modelo é a área abaixo da curva de precisão-revocação. Mede o desempenho do seu modelo em todos os limites de pontuação. Na Vertex AI, esta métrica é denominada Precisão média. Quanto mais próximo de 1,0 for esta pontuação, melhor é o desempenho do seu modelo no conjunto de testes. Um modelo que adivinhe aleatoriamente para cada etiqueta teria uma precisão média de cerca de 0,5.

Tabular

Após a preparação do modelo, recebe um resumo do respetivo desempenho. As métricas de avaliação do modelo baseiam-se no desempenho do modelo em comparação com uma fatia do seu conjunto de dados (o conjunto de dados de teste). Existem algumas métricas e conceitos importantes a considerar quando determinar se o seu modelo está pronto para ser usado com dados reais.

Após a preparação do modelo, recebe um resumo do respetivo desempenho. As métricas de avaliação do modelo baseiam-se no desempenho do modelo em comparação com uma fatia do seu conjunto de dados (o conjunto de dados de teste). Existem algumas métricas e conceitos importantes a considerar quando determinar se o seu modelo está pronto para ser usado com dados reais.

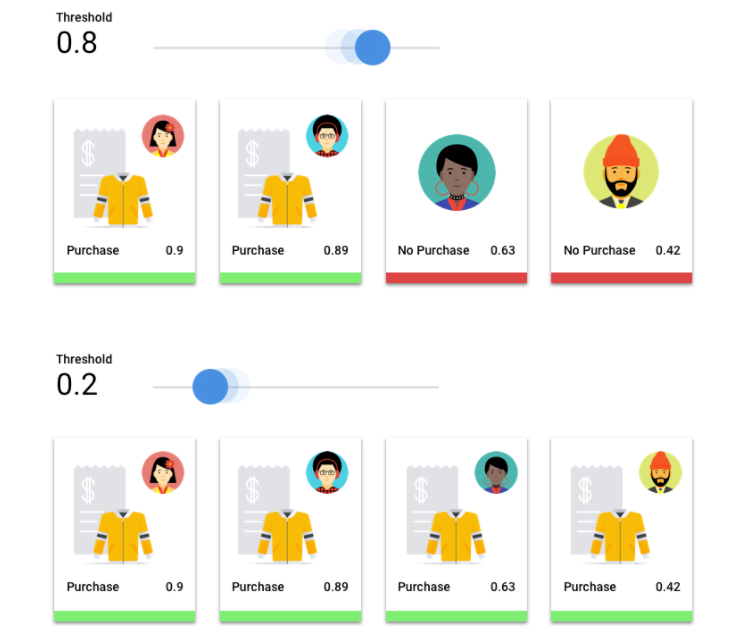

Métricas de classificação

Limite da pontuação

Considere um modelo de aprendizagem automática que preveja se um cliente vai comprar um casaco no próximo ano. Qual a certeza que o modelo tem de ter antes de prever que um determinado cliente vai comprar um casaco? Nos modelos de classificação, é atribuída uma pontuação de confiança a cada inferência, ou seja, uma avaliação numérica da certeza do modelo de que a classe prevista está correta. O limite do resultado é o número que determina quando um determinado resultado é convertido numa decisão sim ou não, ou seja, o valor no qual o seu modelo diz "sim, este resultado de confiança é suficientemente elevado para concluir que este cliente vai comprar um casaco no próximo ano.

Se o limite da pontuação for baixo, o modelo corre o risco de classificação incorreta. Por esse motivo, o limite da pontuação deve basear-se num determinado exemplo de utilização.

Resultados da inferência

Depois de aplicar o limite da pontuação, as inferências feitas pelo seu modelo vão enquadrar-se numa de quatro categorias. Para compreender estas categorias, imagine novamente um modelo de classificação binária de casacos. Neste exemplo, a classe positiva (o que o modelo está a tentar prever) é que o cliente vai comprar um casaco no próximo ano.

- Verdadeiro positivo: o modelo prevê corretamente a classe positiva. O modelo previu corretamente que um cliente comprou um casaco.

- Falso positivo: o modelo prevê incorretamente a classe positiva. O modelo previu que um cliente comprou um casaco, mas não o fez.

- Negativo verdadeiro: o modelo prevê corretamente a classe negativa. O modelo previu corretamente que um cliente não comprou um casaco.

- Falso negativo: o modelo prevê incorretamente uma classe negativa. O modelo previu que um cliente não comprou um casaco, mas comprou.

Precisão e revocação

As métricas de precisão e recall ajudam a compreender o desempenho do seu modelo na captura de informações e o que está a omitir. Saiba mais sobre a precisão e a revocação.

- A precisão é a fração das inferências positivas que estavam corretas. De todas as inferências de uma compra de cliente, que fração foram compras reais?

- A recolha é a fração de linhas com esta etiqueta que o modelo previu corretamente. De todas as compras de clientes que poderiam ter sido identificadas, qual foi a fração que o foi?

Consoante o exemplo de utilização, pode ter de otimizar a precisão ou a capacidade de memorização.

Outras métricas de classificação

- AUC PR: a área abaixo da curva de precisão-revocação (PR). Este valor varia entre zero e um, em que um valor mais elevado indica um modelo de qualidade superior.

- AUC ROC: a área abaixo da curva de caraterísticas de funcionamento do recetor (ROC). Este intervalo varia de zero a um, em que um valor mais elevado indica um modelo de maior qualidade.

- Precisão: a fração de inferências de classificação produzidas pelo modelo que estavam corretas.

- Perda logarítmica: a entropia cruzada entre as inferências do modelo e os valores de destino. Este intervalo varia de zero ao infinito, em que um valor mais baixo indica um modelo de qualidade superior.

- Pontuação de F1: o meio harmónico de precisão e revocação. A pontuação F1 é uma métrica útil se estiver à procura de um equilíbrio entre a precisão e a capacidade de identificação, e existir uma distribuição desigual das classes.

Métricas de previsão e regressão

Depois de criar o modelo, o Vertex AI disponibiliza várias métricas padrão para revisão. Não existe uma resposta perfeita sobre como avaliar o seu modelo. Considere as métricas de avaliação no contexto do seu tipo de problema e o que quer alcançar com o seu modelo. A seguinte lista é uma vista geral de algumas métricas que o Vertex AI pode fornecer.

Erro absoluto médio (MAE)

O EAM é a diferença absoluta média entre os valores de destino e previstos. Mede a magnitude média dos erros, ou seja, a diferença entre um valor previsto e um valor real num conjunto de inferências. Além disso, como usa valores absolutos, o EAM não considera a direção da relação nem indica um desempenho inferior ou superior. Ao avaliar o EMA, um valor mais pequeno indica um modelo de qualidade superior (0 representa um preditor perfeito).

Raiz do erro quadrático médio (RMSE)

O RMSE é a raiz quadrada da diferença média elevada ao quadrado entre os valores alvo e previstos. O RMSE é mais sensível a valores atípicos do que o MAE, por isso, se tiver preocupações com erros grandes, o RMSE pode ser uma métrica mais útil para avaliar. Semelhante ao EMA, um valor mais pequeno indica um modelo de qualidade superior (0 representa um preditor perfeito).

Raiz do erro logarítmico quadrático médio (RMSLE)

O RMSLE é o RMSE na escala logarítmica. O RMSLE é mais sensível a erros relativos do que a erros absolutos e preocupa-se mais com o desempenho inferior do que com o desempenho superior.

Quantil observado (apenas para previsões)

Para um determinado quantil alvo, o quantil observado mostra a fração real de valores observados abaixo dos valores de inferência do quantil especificado. O quantil observado mostra a distância ou a proximidade do modelo em relação ao quantil de destino. Uma diferença menor entre os dois valores indica um modelo de qualidade superior.

Perda de pinball em escala (apenas para previsão)

Mede a qualidade de um modelo num determinado quantil alvo. Um número mais baixo indica um modelo de qualidade superior. Pode comparar a métrica de perda de pinball escalada em diferentes quantis para determinar a precisão relativa do seu modelo entre esses diferentes quantis.

Teste o seu modelo

Imagem

A Vertex AI usa automaticamente 10% dos seus dados (ou, se escolheu a divisão de dados, a percentagem que optou por usar) para testar o modelo, e a página "Avaliar" indica o desempenho do modelo nesses dados de teste. No entanto, caso queira verificar a confiança do seu modelo, existem algumas formas de o fazer. A forma mais fácil é carregar algumas imagens na página "Implementar e testar" e ver as etiquetas que o modelo escolhe para os seus exemplos. Esperamos que isto corresponda às suas expetativas. Experimente alguns exemplos de cada tipo de imagem que espera receber.

Se preferir usar o modelo nos seus próprios testes automatizados, a página "Implementar e testar" também indica como fazer chamadas para o modelo por programação.

Tabular

A avaliação das métricas do modelo é a principal forma de determinar se o modelo está pronto para implementação, mas também pode testá-lo com novos dados. Carregue novos dados para ver se as inferências do modelo correspondem às suas expetativas. Com base nas métricas de avaliação ou nos testes com novos dados, pode ter de continuar a melhorar o desempenho do seu modelo.

Implemente o modelo

Imagem

Quando estiver satisfeito com o desempenho do modelo, é altura de o usar. Talvez isso signifique uma utilização à escala de produção ou, quem sabe, um pedido de inferência único. Consoante o seu exemplo de utilização, pode usar o modelo de diferentes formas.

Inferência em lote

A inferência em lote é útil para fazer muitos pedidos de inferência em simultâneo. A inferência em lote é assíncrona, o que significa que o modelo aguarda até processar todos os pedidos de inferência antes de devolver um ficheiro JSON Lines com valores de inferência.

Inferência online

Implemente o seu modelo para o disponibilizar para pedidos de inferência através de uma API REST. A inferência online é síncrona (em tempo real), o que significa que devolve rapidamente um resultado de inferência, mas só aceita um pedido de inferência por chamada da API. A inferência online é útil se o seu modelo fizer parte de uma aplicação e partes do seu sistema dependerem de um tempo de processamento de inferência rápido.

Tabular

Quando estiver satisfeito com o desempenho do modelo, é altura de o usar. Talvez isso signifique uma utilização à escala de produção ou talvez seja um pedido de inferência único. Consoante o seu exemplo de utilização, pode usar o modelo de diferentes formas.

Inferência em lote

A inferência em lote é útil para fazer muitos pedidos de inferência em simultâneo. A inferência em lote é assíncrona, o que significa que o modelo aguarda até processar todos os pedidos de inferência antes de devolver um ficheiro CSV ou uma tabela do BigQuery com valores de inferência.

Inferência online

Implemente o seu modelo para o disponibilizar para pedidos de inferência através de uma API REST. A inferência online é síncrona (em tempo real), o que significa que devolve rapidamente uma inferência, mas só aceita um pedido de inferência por chamada da API. A inferência online é útil se o seu modelo fizer parte de uma aplicação e partes do seu sistema dependerem de um tempo de processamento rápido da inferência.

Limpar

Para ajudar a evitar cobranças indesejadas, anule a implementação do modelo quando não estiver a ser usado.

Quando terminar de usar o modelo, elimine os recursos que criou para evitar incorrer em encargos indesejados na sua conta.