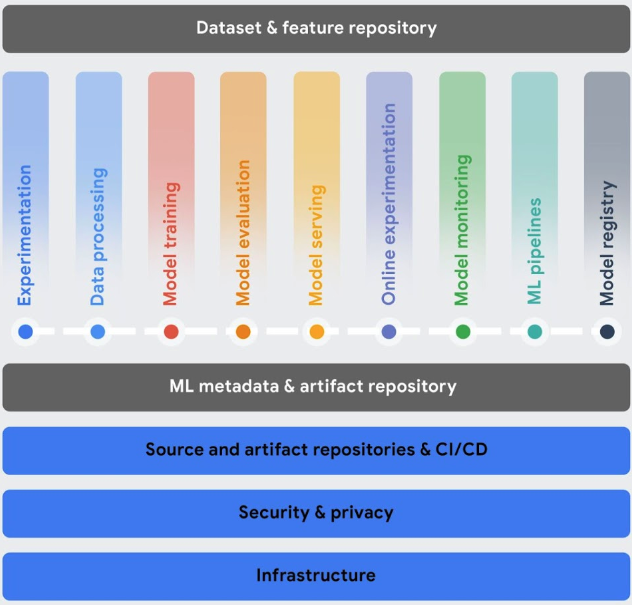

Esta secção descreve os serviços do Vertex AI que ajudam a implementar operações de aprendizagem automática (MLOps) com o seu fluxo de trabalho de aprendizagem automática (ML).

Após a implementação, os modelos têm de acompanhar as alterações aos dados do ambiente para terem um desempenho ideal e permanecerem relevantes. O MLOps é um conjunto de práticas que melhora a estabilidade e a fiabilidade dos seus sistemas de ML.

As ferramentas de MLOps da Vertex AI ajudam a colaborar com equipas de IA e a melhorar os seus modelos através da monitorização, dos alertas, do diagnóstico e das explicações acionáveis de modelos preditivos. Todas as ferramentas são modulares, pelo que pode integrá-las nos seus sistemas existentes conforme necessário.

Para mais informações sobre MLOps, consulte os artigos Fornecimento contínuo e pipelines de automatização na aprendizagem automática e o Guia prático para MLOps.

Orquestre fluxos de trabalho: a preparação e a publicação manuais dos seus modelos podem ser morosas e propensas a erros, especialmente se precisar de repetir os processos muitas vezes.

- O Vertex AI Pipelines ajuda a automatizar, monitorizar e reger os seus fluxos de trabalho de ML.

Acompanhe os metadados usados no seu sistema de AA: na ciência de dados, é importante acompanhar os parâmetros, os artefactos e as métricas usados no seu fluxo de trabalho de AA, especialmente quando repete o fluxo de trabalho várias vezes.

- O Vertex ML Metadata permite-lhe registar os metadados, parâmetros e artefactos usados no seu sistema de ML. Em seguida, pode consultar esses metadados para ajudar a analisar, depurar e auditar o desempenho do seu sistema de ML ou dos artefactos que produz.

Identifique o melhor modelo para um exemplo de utilização: quando experimenta novos algoritmos de preparação, tem de saber qual o modelo preparado que tem o melhor desempenho.

A Vertex AI Experiments permite-lhe acompanhar e analisar diferentes arquiteturas de modelos, hiperparâmetros e ambientes de preparação para identificar o melhor modelo para o seu exemplo de utilização.

O Vertex AI TensorBoard ajuda a monitorizar, visualizar e comparar experiências de ML para medir o desempenho dos seus modelos.

Gerir versões de modelos: adicionar modelos a um repositório central ajuda a monitorizar as versões dos modelos.

- O Registo de modelos do Vertex AI oferece uma vista geral dos seus modelos para que possa organizar, monitorizar e preparar novas versões de forma mais eficaz. No Model Registry, pode avaliar modelos, implementá-los num ponto final, criar inferências em lote e ver detalhes sobre modelos e versões de modelos específicos.

Gerir funcionalidades: quando reutiliza funcionalidades de ML em várias equipas, precisa de uma forma rápida e eficiente de partilhar e publicar as funcionalidades.

- O Vertex AI Feature Store oferece um repositório centralizado para organizar, armazenar e apresentar funcionalidades de ML. A utilização de um repositório de funcionalidades central permite a uma organização reutilizar funcionalidades de AA à escala e aumentar a velocidade de desenvolvimento e implementação de novas aplicações de AA.

Monitorize a qualidade do modelo: um modelo implementado em produção tem o melhor desempenho em dados de entrada de inferência semelhantes aos dados de preparação. Quando os dados de entrada se desviam dos dados usados para preparar o modelo, o desempenho do modelo pode deteriorar-se, mesmo que o modelo em si não tenha sido alterado.

- O Vertex AI Model Monitoring monitoriza os modelos quanto à discrepância entre a preparação e a apresentação, bem como a variação da inferência, e envia-lhe alertas quando os dados de inferência recebidos se desviam demasiado da base de referência da preparação. Pode usar os alertas e as distribuições de funcionalidades para avaliar se precisa de voltar a formar o seu modelo.

Dimensione as aplicações de IA e Python: o Ray é uma framework de código aberto para dimensionar aplicações de IA e Python. O Ray fornece a infraestrutura para realizar computação distribuída e processamento paralelo para o seu fluxo de trabalho de aprendizagem automática (AA).

- O Ray no Vertex AI foi concebido para que possa usar o mesmo código Ray de código aberto para escrever programas e desenvolver aplicações no Vertex AI com alterações mínimas. Em seguida, pode usar as integrações do Vertex AI com outros Google Cloud serviços, como o Vertex AI Inference e o BigQuery, como parte do seu fluxo de trabalho de aprendizagem automática (ML).