このページでは、Spanner 以外のデータベースからエクスポートした Avro ファイルを準備し、それらのファイルを Spanner にインポートする方法について説明します。これらの手順には、GoogleSQL 言語データベースと PostgreSQL 言語データベースの両方の情報が含まれています。以前にエクスポートした Spanner データベースをインポートする場合は、Spanner Avro ファイルをインポートするをご覧ください。

このプロセスでは Dataflow が使用され、一連の Avro ファイルと、宛先テーブルと各テーブルにデータを入力する Avro ファイルを指定する JSON マニフェスト ファイルを含む Cloud Storage バケットからデータがインポートされます。

始める前に

Spanner データベースをインポートするには、最初に、Spanner、Cloud Storage、Compute Engine、Dataflow API を有効にする必要があります。

Roles required to enable APIs

To enable APIs, you need the Service Usage Admin IAM

role (roles/serviceusage.serviceUsageAdmin), which

contains the serviceusage.services.enable permission. Learn how to grant

roles.

また、十分な割り当てと必須の IAM 権限も必要です。

割り当て要件

インポート ジョブの割り当て要件は次のとおりです。

- Spanner: インポートするデータの量をサポートできるだけの十分なコンピューティング容量が必要です。データベースをインポートするために追加のコンピューティング容量は必要ありませんが、ジョブが妥当な時間内に終了するようにコンピューティング容量を追加する必要がある場合があります。詳細については、ジョブを最適化するをご覧ください。

- Cloud Storage: インポートするには、以前にエクスポートしたファイルが格納されているバケットが必要です。バケットのサイズを設定する必要はありません。

- Dataflow: インポート ジョブは、他の Dataflow ジョブと同じ CPU、ディスク使用量、IP アドレスの Compute Engine の割り当てに従います。

Compute Engine: インポート ジョブを実行する前に、Dataflow によって使用される Compute Engine の初期割り当てを設定する必要があります。これらの割り当ては、Dataflow でジョブに使用できる最大リソース数を表します。推奨の開始値は次のとおりです。

- CPU: 200

- 使用中の IP アドレス: 200

- 標準永続ディスク: 50 TB

通常、他の調整は必要ありません。Dataflow では自動スケーリングが提供されているため、インポート中に実際に使用したリソースに対してのみ料金を支払います。ジョブでより多くのリソースが使用される可能性がある場合、Dataflow UI に警告アイコンが表示されます。警告アイコンが表示されてもジョブは完了します。

必要なロール

データベースのエクスポートに必要な権限を取得するには、Dataflow ワーカーのサービス アカウントに対して次の IAM ロールを付与するよう管理者に依頼します。

- Cloud Spanner 閲覧者(

roles/spanner.viewer) - Dataflow ワーカー(

roles/dataflow.worker) -

ストレージ管理者(

roles/storage.admin) - Spanner データベース読み取り(

roles/spanner.databaseReader) - データベース管理者(

roles/spanner.databaseAdmin)

Spanner 以外のデータベースから Avro ファイルにデータをエクスポートする

インポート プロセスでは、Cloud Storage バケット内の Avro ファイルからデータを取り込みます。任意のソースからデータを Avro 形式でエクスポートできます。これにはさまざまな方法があります。

Spanner 以外のデータベースから Avro ファイルにデータをエクスポートする手順は次のとおりです。

データをエクスポートするときは、次の点に留意してください。

- 任意の Avro プリミティブ型と配列複合型を使用してエクスポートできます。

Avro ファイルの各列には、次の列型のいずれかを使用する必要があります。

ARRAYBOOLBYTES*DOUBLEFLOATINTLONG†STRING‡

* タイプ

BYTESの列が SpannerNUMERICのインポートに使用されます。詳細については、次の推奨されるマッピングのセクションをご覧ください。†,‡ タイムスタンプを格納する

LONGまたはタイムスタンプを格納するSTRINGを SpannerTIMESTAMPとしてインポートできます。詳細については、次の推奨されるマッピングのセクションをご覧ください。Avro ファイルをエクスポートする際に、メタデータを含めたり生成したりする必要はありません。

ファイルについて特定の命名規則に沿う必要はありません。

ファイルを Cloud Storage に直接エクスポートしない場合は、Avro ファイルを Cloud Storage バケットにアップロードする必要があります。詳細な手順については、Cloud Storage にオブジェクトをアップロードするをご覧ください。

Spanner 以外のデータベースから Spanner に Avro ファイルをインポートする

Spanner 以外のデータベースから Spanner に Avro ファイルをインポートするには、次の手順に沿って行います。

- ターゲット テーブルを作成し、Spanner データベースのスキーマを定義します。

- Cloud Storage バケットに

spanner-export.jsonファイルを作成します。 - gcloud CLI を使用して Dataflow インポート ジョブを実行します。

ステップ 1: Spanner データベースのスキーマを作成する

インポートを実行する前に、Spanner でターゲット テーブルを作成し、そのスキーマを定義する必要があります。

Avro ファイルの各列に対し適切な列型を使用するスキーマを作成する必要があります。

推奨されるマッピング

GoogleSQL

| Avro の列型 | Spanner の列型 |

|---|---|

ARRAY |

ARRAY |

BOOL |

BOOL |

BYTES |

|

DOUBLE |

FLOAT64 |

FLOAT |

FLOAT64 |

INT |

INT64 |

LONG |

|

STRING |

|

PostgreSQL

| Avro の列型 | Spanner の列型 |

|---|---|

ARRAY |

ARRAY |

BOOL |

BOOLEAN |

BYTES |

|

DOUBLE |

DOUBLE PRECISION |

FLOAT |

DOUBLE PRECISION |

INT |

BIGINT |

LONG |

|

STRING |

|

ステップ 2: spanner-export.json ファイルを作成する

Cloud Storage バケットに spanner-export.json という名前のファイルを作成する必要もあります。このファイルには、データベース ダイアレクトが指定され、各テーブルの名前とデータファイルの場所を示す tables 配列が含まれています。

ファイルの内容は次の形式を取ります。

{ "tables": [ { "name": "TABLE1", "dataFiles": [ "RELATIVE/PATH/TO/TABLE1_FILE1", "RELATIVE/PATH/TO/TABLE1_FILE2" ] }, { "name": "TABLE2", "dataFiles": ["RELATIVE/PATH/TO/TABLE2_FILE1"] } ], "dialect":"DATABASE_DIALECT" }

ここで、DATABASE_DIALECT = {GOOGLE_STANDARD_SQL | POSTGRESQL}

言語要素を省略すると、言語はデフォルトで GOOGLE_STANDARD_SQL になります。

ステップ 3: gcloud CLI を使用して Dataflow インポート ジョブを実行する

インポート ジョブを開始するには、Google Cloud CLI を使用して、Avro to Spanner テンプレートでジョブを実行する手順を行います。

インポート ジョブを開始したら、 Google Cloud コンソールでジョブの詳細を確認できます。

インポート ジョブが完了したら、必要なセカンダリ インデックスと外部キーを追加します。

インポート ジョブのリージョンの選択

Cloud Storage バケットのロケーションに基づいて、別のリージョンを選択する場合があります。アウトバウンド データ転送料金が発生しないようにするには、Cloud Storage バケットのロケーションと一致するリージョンを選択します。

Cloud Storage バケットのロケーションがリージョンである場合、リージョンが利用可能であれば、インポート ジョブに同じリージョンを選択することで、無料のネットワーク使用量を利用できます。

Cloud Storage バケットのロケーションがデュアルリージョンである場合、いずれかのリージョンが使用可能であるならば、インポート ジョブにデュアルリージョンを構成する 2 つのリージョンのいずれかを選択して、無料のネットワーク使用量を利用できます。

- 併置リージョンがインポート ジョブで利用できない場合、または Cloud Storage バケットのロケーションがマルチリージョンである場合は、アウトバウンド データ転送料金が適用されます。データ転送料金が最も低いリージョンを選択するには、Cloud Storage のデータ転送の料金をご覧ください。

Dataflow UI でのジョブの表示またはトラブルシューティング

インポート ジョブの開始後、 Google Cloud コンソールの Dataflow セクションで、ジョブの詳細(ログなど)を表示できます。

Dataflow ジョブの詳細を表示する

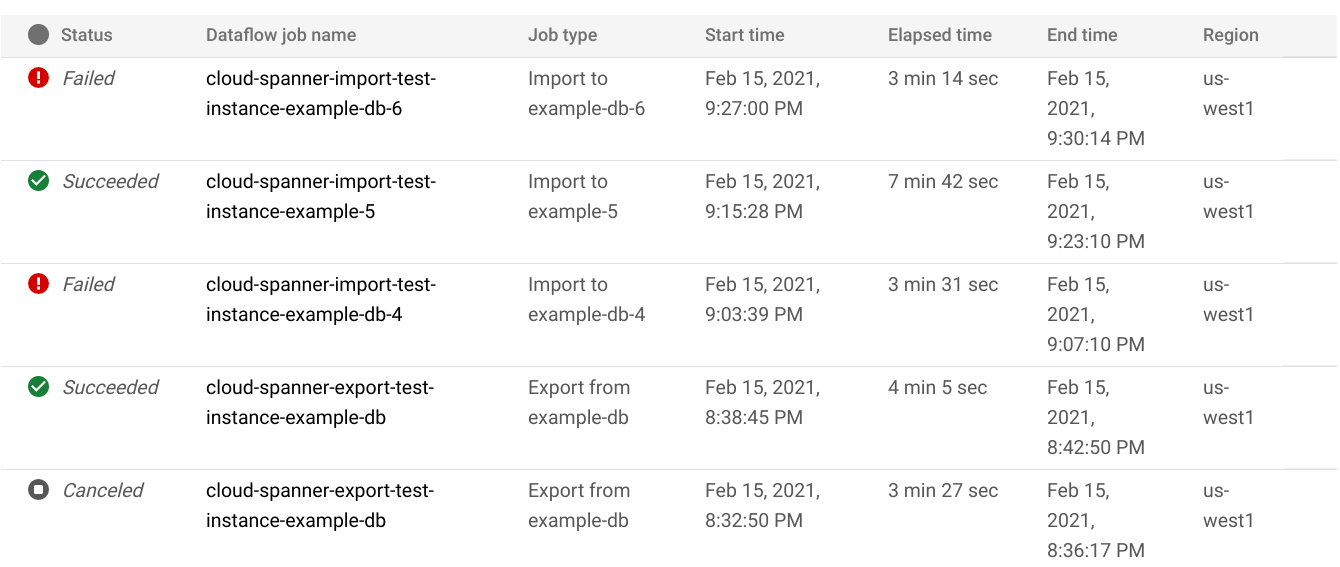

現在実行中のジョブを含む過去 1 週間以内のインポートまたはエクスポート ジョブの詳細を表示するには、次の操作を行います。

- データベースの [データベースの概要] ページに移動します。

- 左ペインのメニュー項目 [インポート / エクスポート] をクリックします。データベースの [インポート / エクスポート] ページに、最近のジョブのリストが表示されます。

データベースの [インポート / エクスポート] ページで、[Dataflow ジョブ名] 列のジョブ名をクリックします。

Google Cloud コンソールに Dataflow ジョブの詳細が表示されます。

1 週間以上前に実行したジョブを表示するには:

Google Cloud コンソールの Dataflow ジョブページに移動します。

リスト内でジョブを見つけ、その名前をクリックします。

Google Cloud コンソールに Dataflow ジョブの詳細が表示されます。

ジョブの Dataflow ログを表示する

Dataflow ジョブのログを表示するには、ジョブの詳細ページに移動し、ジョブ名の右側にある [ログ] をクリックします。

ジョブが失敗した場合は、ログでエラーを探します。エラーがある場合、エラー数が [ログ] の横に表示されます。

![[ログ] ボタンの横のエラー数の例](https://cloud.google.com/static/spanner/docs/images/dataflow_error_count.png?hl=ja)

ジョブエラーを表示するには:

[ログ] の横のエラー数をクリックします。

Google Cloud コンソールにジョブのログが表示されます。エラーを表示するには、スクロールが必要な場合があります。

エラーアイコン

が表示されているエントリを見つけます。

が表示されているエントリを見つけます。個別のログエントリをクリックして、その内容を展開します。

Dataflow ジョブのトラブルシューティングの詳細については、パイプラインをトラブルシューティングするをご覧ください。

失敗したインポート ジョブをトラブルシューティングする

ジョブログに次のエラーが表示された場合、

com.google.cloud.spanner.SpannerException: NOT_FOUND: Session not found --or-- com.google.cloud.spanner.SpannerException: DEADLINE_EXCEEDED: Deadline expired before operation could complete.

Google Cloud コンソールで Spanner データベースの [モニタリング] タブで、99% の書き込みレイテンシを確認します。高い値(数秒)が表示されている場合は、インスタンスが過負荷状態になっており、書き込みがタイムアウトになって失敗します。

レイテンシが高くなる原因の 1 つは、多すぎるワーカーを使用して Dataflow ジョブが実行しているため、Spanner インスタンスに負荷がかかりすぎることです。

Dataflow ワーカーの数の上限を指定するには、 Google Cloud コンソールの Spanner データベースのインスタンスの詳細ページにある [インポート / エクスポート] タブを使用する代わりに、Dataflow の Cloud Storage Avro to Spanner テンプレートを使用してインポートを開始し、以下のようにワーカーの最大数を指定する必要があります。コンソール

Dataflow コンソールを使用している場合、[最大ワーカー数] パラメータは、[テンプレートからジョブを作成] ページの [オプションのパラメータ] セクションにあります。

gcloud

gcloud dataflow jobs run コマンドを実行し、max-workers 引数を指定します。例:

gcloud dataflow jobs run my-import-job \

--gcs-location='gs://dataflow-templates/latest/GCS_Avro_to_Cloud_Spanner' \

--region=us-central1 \

--parameters='instanceId=test-instance,databaseId=example-db,inputDir=gs://my-gcs-bucket' \

--max-workers=10 \

--network=network-123

ネットワーク エラーのトラブルシューティング

Spanner データベースをエクスポートすると、次のエラーが発生することがあります。

Workflow failed. Causes: Error: Message: Invalid value for field 'resource.properties.networkInterfaces[0].subnetwork': ''. Network interface must specify a subnet if the network resource is in custom subnet mode. HTTP Code: 400

このエラーは、Dataflow ジョブと同じプロジェクトで default という名前の自動モード VPC ネットワークを使用する予定であると Spanner が想定しているために発生します。プロジェクト内にデフォルトの VPC ネットワークがない場合や、VPC ネットワークがカスタムモードの VPC ネットワークにある場合は、Dataflow ジョブを作成し、代替のネットワークまたはサブネットワークを指定する必要があります。

実行速度が遅いインポート ジョブを最適化する

初期設定の提案に従っている場合は、通常、他の調整は必要ありません。ジョブの実行速度が遅い場合は、その他の最適化を試すことができます。

ジョブとデータのロケーションの最適化: Spanner インスタンスと Cloud Storage バケットが配置されている同じリージョン内で Dataflow ジョブを実行します。

十分な Dataflow リソースの確保: 関連する Compute Engine の割り当てによって Dataflow ジョブのリソースが制限されている場合、 Google Cloud コンソールのジョブの Dataflow ページに警告アイコン

とログメッセージが表示されます。

とログメッセージが表示されます。

この場合、CPU、使用中の IP アドレス、標準永続ディスクの割り当てを増やすと、ジョブの実行時間が短くなる可能性がありますが、Compute Engine の追加料金が発生する場合があります。

Spanner の CPU 使用率の確認: インスタンスの CPU 使用率が 65% を超えている場合は、そのインスタンスのコンピューティング容量を増やすことができます。容量を追加すると Spanner のリソースが増加し、ジョブの実行速度は速くなりますが、Spanner の追加料金が発生します。

インポート ジョブのパフォーマンスに影響する要素

インポート ジョブを完了するためにかかる時間には、いくつかの要素が影響します。

Spanner データベースのサイズ: 処理するデータ量が増加すると、必要となる時間とリソースも多くなります。

Spanner データベース スキーマ: 次のものを含む。

- テーブルの数

- 行のサイズ

- セカンダリ インデックスの数

- 外部キーの数

- 変更ストリームの数

データのロケーション: データは、Dataflow を使用して Spanner と Cloud Storage の間で転送されます。3 つのコンポーネントがすべて同じリージョン内にあることが理想的です。コンポーネントが同じリージョン内にない場合は、リージョン間のデータの移動によってジョブは遅くなります。

Dataflow ワーカーの数: パフォーマンスの向上には、最適な Dataflow ワーカーが必要です。自動スケーリングを使用することにより、Dataflow では、処理する必要がある作業量に応じてジョブのワーカー数が選択されます。ただし、ワーカーの数は CPU、使用中の IP アドレス、標準永続ディスクの割り当てによって制限されます。割り当ての上限に達すると、Dataflow UI に警告アイコンが表示されます。この状況では、進捗は遅くなりますがジョブは完了します。インポートするデータの量が多い場合は、自動スケーリングによって Spanner が過負荷状態になり、エラーが発生する可能性があります。

Spanner に対する既存の負荷: インポート ジョブを実行すると、Spanner インスタンスに対する CPU 負荷が大幅に上昇します。インスタンスに既存の負荷がかなりある場合、このジョブの実行速度はさらに遅くなります。

Spanner のコンピューティング容量: インスタンスの CPU 使用率が 65% を超えると、ジョブの実行速度はさらに低下します。

インポート パフォーマンスの向上のためにワーカーを調整する

Spanner のインポート ジョブを開始する際は、良好なパフォーマンスを実現するために、Dataflow ワーカーを最適な値に設定する必要があります。過剰な数のワーカーが存在すると Spanner が過負荷状態になり、ワーカー数が過剰に少ない場合はインポートのパフォーマンスが低下します。

ワーカーの最大数はデータサイズに大きく依存しますが、Spanner の CPU 使用率の合計は 70~90% が理想的です。これにより、Spanner の効率性とエラーのないジョブ完了のバランスが良好になります。

大部分のスキーマとシナリオでその使用率の目標を達成するには、ワーカー vCPU の最大数を Spanner ノードの数の 4〜6 倍にすることをおすすめします。

たとえば、n1-standard-2 ワーカーを使用する 10 ノードの Spanner インスタンスの場合、最大ワーカー数を 25 に設定し、50 個の vCPU を割り当てます。