Sie können die integrierte Testfunktion verwenden, um Fehler zu erkennen und Regressionen zu verhindern. Zum Testen des Agents können Sie mit dem Simulator mit dem Agent interagieren und die Unterhaltung als Testfall speichern.

Wenn Sie einen Testfall speichern, werden Intent-Übereinstimmungen, Playbook-Aktionen, aktivierte Abläufe und aktivierte Seiten, die während der Unterhaltung aufgetreten sind, als Testfallerwartungen gespeichert. Wenn Sie den Testfall später ausführen, nachdem Sie Änderungen an Ihrem Agenten vorgenommen haben, werden diese Erwartungen bestätigt. Sie können diese Erwartungen auch bearbeiten, wenn Sie Testfälle erstellen oder bearbeiten.

Testlauf erstellen

So erstellen Sie mit dem Simulator einen Testfall:

- Öffnen Sie den Simulator.

- Sprechen Sie mit dem Kundenservicemitarbeiter.

- Klicken Sie über dem Simulator auf die Schaltfläche Testfall erstellen.

- Der Bereich „Testfall-Editor“ wird geöffnet. Geben Sie den Anzeigenamen des Testfalls ein und bearbeiten Sie die Erwartungen nach Bedarf.

- Klicken Sie über dem Simulator auf die Schaltfläche Testfall speichern.

Testfälle ausführen

So führen Sie einen einzelnen Testfall aus:

- Klicken Sie im linken Navigationsbereich auf Testfälle.

- Wählen Sie den Testfall aus, den Sie ausführen möchten.

- Klicken Sie auf Ausführen.

- Die Ergebnisse des Testfallverlaufs werden angezeigt.

So führen Sie mehrere Testfälle aus:

- Klicken Sie im linken Navigationsbereich auf Testfälle.

- Wählen Sie die Testfälle aus, die Sie ausführen möchten, indem Sie die Kästchen links anklicken.

- Klicken Sie auf Auswahl ausführen.

- Für jeden Testfall werden die Ergebnisse der letzten Testausführung angezeigt.

Testfall bearbeiten

Beim Bearbeiten eines Testfalls können Sie die Nachricht des Endnutzers oder die Antwort des Kundenservicemitarbeiters nicht bearbeiten. Sie können jedoch Folgendes ändern:

- Erwartungen hinzufügen

- Erwartungen löschen

- Erwartungen aktualisieren

So bearbeiten Sie einen Testfall:

- Klicken Sie im linken Navigationsbereich auf Testfälle.

- Wählen Sie den Testfall aus, den Sie bearbeiten möchten.

- Klicken Sie über der Zusammenfassung des Testfalls auf die Schaltfläche Bearbeiten.

- Sie können den Bereich Erwartungen auf Unterhaltungsebene maximieren, um Erwartungen zu bearbeiten, die für die gesamte Unterhaltung gelten.

- Für jede Unterhaltungsrunde werden die Nachricht des Endnutzers, die Antwort des Kundenservicemitarbeiters und die Erwartungen für die Runde angezeigt. Sie können die Nachrichten nicht bearbeiten, aber die Erwartungen auf Kurvenebene.

Testläufe löschen

So löschen Sie Testfälle:

- Klicken Sie im linken Navigationsbereich auf Testfälle.

- Wählen Sie die Testfälle aus, die Sie löschen möchten, indem Sie die Kästchen links anklicken.

- Klicken Sie auf Ausgewählte Testfälle löschen.

Erwartungen

Wenn Sie Erwartungen für einen Testfall angeben, können Sie Erwartungen auf Konversationsebene oder Erwartungen auf Satzebene angeben.

Erwartungen auf Konversationsebene gelten für die gesamte Unterhaltung. Sie können die folgenden Arten von Erwartungen angeben:

- Toolnutzung

- Aufruf des Workflows

- Playbook-Aufruf

Erwartungen auf Gesprächsebene gelten nur für einen bestimmten Gesprächsschritt. Sie können die folgenden Arten von Erwartungen angeben:

- Antwort des Kundenservicemitarbeiters

- Stromlauf

- Aktuelle Absicht

- Aktuelle Seite

- Toolnutzung

- Aufruf des Workflows

- Playbook-Aufruf

Legacy-Testfälle

Sie kön en die integrierte Testfunktion verwenden, um Fehler zu erkennen und Regressionen zu verhindern. Zum Testen des Agents erstellen Sie mit dem Simulator Testfälle, um goldene Testfälle zu definieren, und führen dann Testfälle nach Bedarf aus. Eine Testausführung prüft, ob die Agent-Antworten für Endnutzereingaben, die im Testfall definiert sind, nicht geändert wurden.

In folgender Anleitung wird die Verwendung der Konsole beschrieben. Sie finden die gleichen Funktionen jedoch auch in der API.

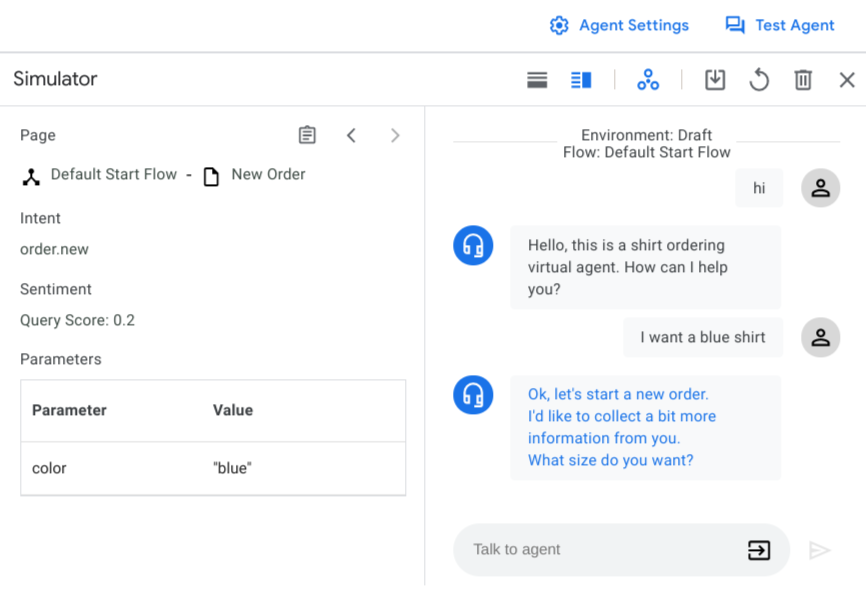

Simulator-Einstellungen

Wenn Sie den Simulator zum ersten Mal öffnen, müssen Sie eine Agent-Umgebung oder Ablaufversionen und einen aktiven Ablauf auswählen. In den meisten Fällen sollten Sie die Entwurfsumgebung und den Standardstartablauf verwenden.

Sie können Webhook-Aufrufe auch jederzeit mit der Webhook-Schaltfläche aktivieren oder deaktivieren. Die Deaktivierung von Webhooks ist beim Definieren von Testfällen hilfreich.

Simulatoreingabe

Bei der Interaktion mit dem Simulator stellen Sie die Endnutzereingabe als Text bereit. Drücken Sie dann die Eingabetaste oder klicken Sie auf die Schaltfläche "Send" . Zusätzlich zu reinem Text können Sie mithilfe des -Selektors alternative Eingabetypen auswählen:

- Parameter: Fügen Sie einen Parameterwert ein. Sie können neue Parameter angeben oder für vorhandene Parameter voreingestellte Werte angeben.

- Ereignis: Rufen Sie ein Ereignis auf.

- DTMF: Senden von Zweiton-Mehrfrequenzsignalisierung-Eingaben (Touch-Tone) für Telefonie-Interaktionen.

Testlauf erstellen

So erstellen Sie eine Unterhaltung:

- Öffnen Sie die Dialogflow CX Console.

- Wählen Sie Ihr Projekt aus.

- Wählen Sie den Agent aus.

- Klicken Sie auf Test-Agent, um den Simulator zu öffnen.

- Chatten Sie mit dem Agent, um eine Unterhaltung zu erstellen, die die Funktionen beinhaltet, die Sie testen möchten. Prüfen Sie für jede Runde die richtigen Werte für den ausgelösten Intent, die Agent-Antwort, die aktive Seite und die Sitzungsparameter.

So speichern Sie eine Unterhaltung als Testfall:

- Klicken Sie auf die -Schaltfläche „Speichern“.

- Geben Sie einen Anzeigenamen für den Testfall ein. Jeder Testfall muss einen eindeutigen Anzeigenamen haben.

- Geben Sie optional einen Tag-Namen an. Mit Tags können Sie Ihre Testfälle organisieren. Alle Tags müssen mit einem "#" beginnen.

- Geben Sie optional einen Hinweis an, der den Zweck des Testfalls beschreibt.

- Wählen Sie optional Parameter aus, die Sie im Testfall verfolgen möchten. Es wird eine Liste mit vorgeschlagenen Parametern bereitgestellt. Sie können auch andere zu verfolgende Parameter eingeben. Wenn Sie Tracking-Parameter auswählen, wird die Parameter-Assertion beim Ausführen des Testfalls überprüft. Weitere Informationen zur Parameter-Assertion finden Sie im Abschnitt Testfälle ausführen.

- Klicken Sie auf Speichern, um den Testfall zu speichern.

Testfälle ausführen

Klicken Sie auf dem Tab Verwalten auf Testfälle, um alle Testfälle für einen Agent aufzurufen. Die Tabelle mit den Testfällen enthält den Testnamen, die Tags, die letzte Testzeit und -umgebung sowie das neueste Testergebnis.

So führen Sie Testfälle aus:

- Wählen Sie die Testfälle aus, die Sie ausführen möchten, und klicken Sie auf Ausführen. Alternativ können Sie auf Alle Testfälle ausführen klicken.

- Wählen Sie die Umgebung aus, für die Sie die Testfälle ausführen möchten.

- Die Tests werden ausgeführt. Sie können den Status in der Warteschlange der Aufgaben sehen. Das Testergebnisse wird nach Abschluss aktualisiert.

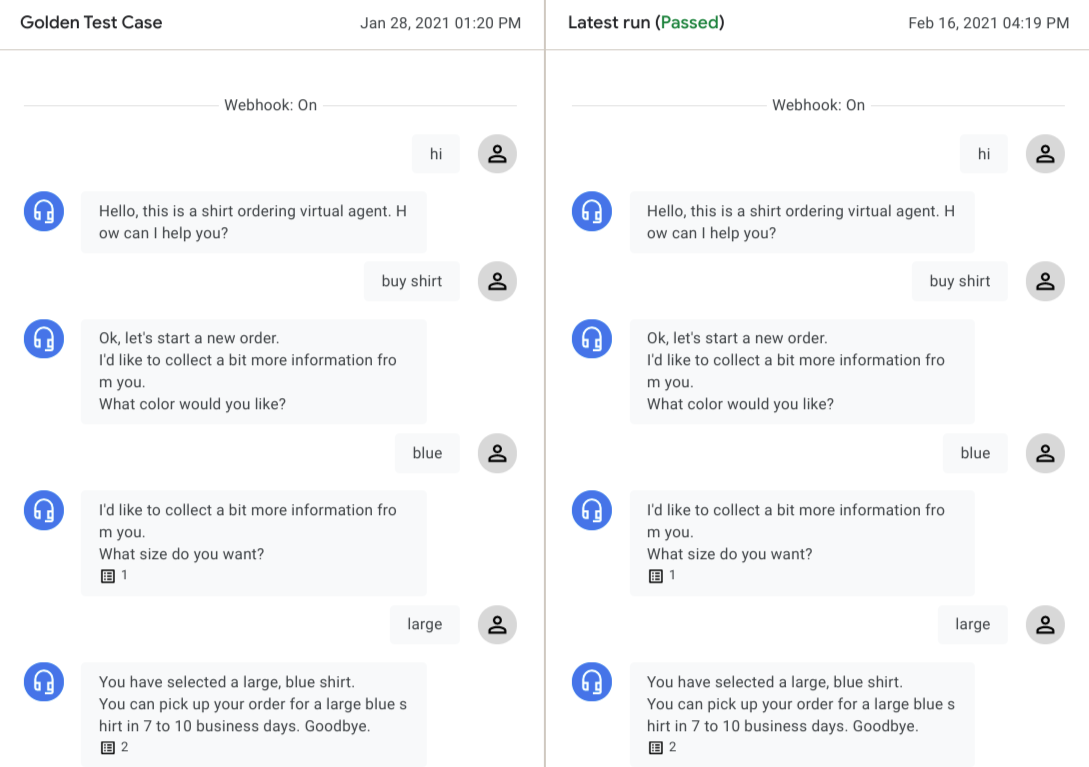

Klicken Sie auf den Testfall, um das Testdetailergebnis anzuzeigen. Der goldene Testfall und die neuesten Ausführungsunterhaltungen werden nebeneinander angezeigt.

Sie können auf die Konversationsrunde eines Agents klicken, um die entsprechenden Details aufzurufen. Die Test-Engine prüft folgende Arten von Daten, um das Testergebnis auszuwerten:

Agent-Dialog:

Für jede Konversationsrunde wird der Agent-Dialog vom "Golden" mit dem letzten Durchlauf verglichen. Wenn es einen Unterschied gibt, wird eine Warnung angezeigt. Diese Unterschiede verhindern nicht, dass ein Test bestanden wird, da der Agent-Dialog häufig für denselben Agent-Status variiert.

Übereinstimmender Intent:

Die übereinstimmende Intent muss in jeder Runde der gleiche sein, damit ein Test bestanden wird.

Aktuelle Seite:

Die aktive Seite muss für jede Testrunde gleich sein, damit ein Test bestanden wird.

Sitzungsparameter:

Wenn Sie beim Erstellen des Testfalls Tracking-Parameter hinzugefügt haben, prüft die Test-Engine die entsprechenden Sitzungsparameter und lässt den Test fehlschlagen, wenn Parameter fehlen/unerwartet sind oder Parameterwerte nicht übereinstimmen.

In einigen Situationen kann ein Testfall einen erwarteten Fehler aufgrund eines aktualisierten Agents haben. Wenn die Unterhaltung in der letzten Ausführung die erwarteten Änderungen widerspiegelt, können Sie auf Als golden speichern klicken, um den goldenen Testfall zu überschreiben.

Testfälle bearbeiten

Zur Bearbeitung eines Testfalls wählen Sie den Testfall aus der Tabelle Testfälle aus und klicken dann auf das Bearbeitungssymbol neben dem Namen des Testfalls. Das Dialogfeld Testfälle aktualisieren wird angezeigt.

Klicken Sie zum Bearbeiten der Metadaten und Einstellungen für den Testfall auf den Tab Einstellungen.

Sie können die Felder Testfallname, Tags und Hinweis bearbeiten oder neue Tracking-Parameter hinzufügen.

Klicken Sie auf Speichern.

Klicken Sie zum Bearbeiten der Nutzereingabe für den Testfall auf den Tab Nutzereingabe.

Nutzereingaben im JSON-Format hinzufügen, entfernen oder bearbeiten.

Klicken Sie auf Bestätigen. Ein automatischer Testlauf beginnt und die aktualisierte Unterhaltung wird nach Abschluss des Testlaufs angezeigt.

Klicken Sie auf Speichern, um den ursprünglichen goldenen Testfall zu überschreiben, oder auf Speichern unter, um einen neuen Testfall mit den Änderungen zu erstellen.

Testabdeckung ansehen

Um einen Bericht zur Testabdeckung für alle Testfälle aufzurufen klicken Sie auf Abdeckung.

Die Seite Abdeckung enthält die folgenden Tabs:

Die Übergangsabdeckung wird für alle Zunstands-Handler (ohne Routengruppen) mit einem Übergangsziel festgelegt, das vom Testfall ausgeführt wird. Der Quellablauf/die Quellseite und der Übergangszielablauf/die Übergangszielseite sind in der Tabelle aufgeführt.

Die Intent-Abdeckung wird für alle Intents bestimmt, die dem Testfall entsprechen.

Die Abdeckung von Routengruppen wird für alle Routengruppen bestimmt, die dem Testfall entsprechen.

Testläufe importieren und exportieren

So exportieren Sie Testfälle:

- Wählen Sie Testfälle aus und klicken Sie auf Exportieren oder auf Alle Testfälle exportieren.

- Klicken Sie auf Als lokale Datei herunterladen oder geben Sie einen Cloud Storage-Bucket-URI an und klicken Sie auf Nach Google Cloud Storage exportieren.

Beim Importieren von Testfällen werden in Conversational Agents (Dialogflow CX) immer neue Testfälle für den Ziel-Agenten erstellt und vorhandene Testfälle werden nicht überschrieben. So importieren Sie Testfälle:

- Klicken Sie auf Importieren.

- Wählen Sie eine lokale Datei aus oder geben Sie einen Cloud Storage-Bucket-URI an.