Com registros e métricas, é possível monitorar seus serviços e resolver problemas de desempenho. É possível conferir registros e métricas dos serviços da Vertex AI usando os recursos de monitoramento e geração de registros do Google Distributed Cloud (GDC) isolado. Também é possível criar consultas para monitorar métricas específicas da Vertex AI.

Nesta página, descrevemos como consultar e visualizar registros e métricas dos serviços da Vertex AI no a instância de monitoramento do Distributed Cloud.

Esta página também contém exemplos de consultas que podem ser usadas para monitorar a plataforma e os serviços da Vertex AI, como reconhecimento óptico de caracteres (OCR), Speech-to-Text e Vertex AI Translation. Para mais informações sobre soluções de registro e monitoramento no Distributed Cloud, consulte Monitorar métricas e registros.

Antes de começar

Para receber as permissões necessárias para visualizar registros e métricas da

Vertex AI, peça ao administrador do IAM do projeto para conceder a você a função

Leitor do Grafana do projeto (project-grafana-viewer) no namespace

do projeto.

Para mais informações sobre esse papel, consulte Preparar permissões do IAM.

Visualizar registros e métricas em painéis

É possível conferir métricas e registros da Vertex AI em painéis. Por exemplo, é possível criar uma consulta para ver como a Vertex AI afeta o uso da CPU.

Siga estas etapas para conferir os registros e as métricas da Vertex AI em painéis:

No menu de navegação, clique em Vertex AI > APIs pré-treinadas.

Na página APIs pré-treinadas, verifique se a API Vertex AI do serviço que você quer monitorar está ativada.

Clique em Monitorar serviços no Grafana para abrir a página inicial do Grafana.

No menu de navegação da página inicial, clique em Análise Análise para abrir a página Análise.

No menu da página Analisar, selecione uma das seguintes fontes de dados:

- Registros operacionais: recupere registros operacionais.

- Registros de auditoria: recupera registros de auditoria.

- Prometheus: recupere métricas.

Se quiser mostrar métricas, insira uma consulta usando expressões da PromQL (linguagem de consulta do Prometheus).

Se quiser mostrar registros, insira uma consulta usando expressões da LogQL (linguagem de consulta de registros).

A página mostra as métricas ou os registros que correspondem à sua consulta.

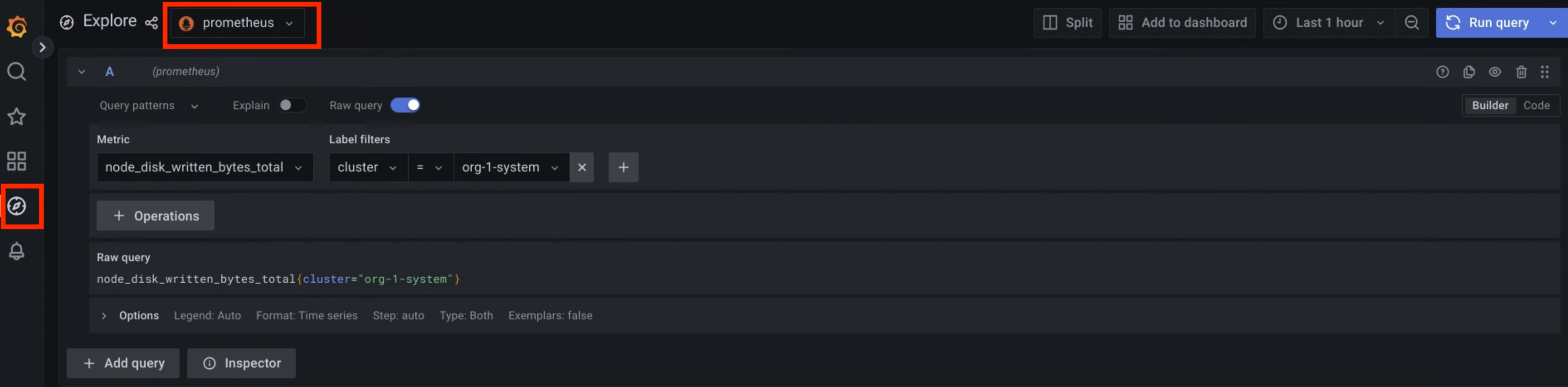

Figura 1. Opção de menu no Grafana para consultar métricas.

Na Figura 1, a opção Prometheus mostra a interface que permite criar consultas para recuperar métricas.

Amostras de consultas

A tabela a seguir contém exemplos de consultas para monitorar a plataforma Vertex AI no seu ambiente:

| Plataforma Vertex AI | |||

|---|---|---|---|

| Fonte de dados | Descrição | Componente | Consulta |

| Métricas | Porcentagem de uso da CPU do contêiner | Operador de nível 1 | rate(container_cpu_usage_seconds_total{namespace="ai-system",container="l1operator"}[30s]) * 100 |

| Operador de nível 2 | rate(container_cpu_usage_seconds_total{namespace="ai-system",container="l2operator"}[30s]) * 100 |

||

| Uso da memória em MB do contêiner | Operador de nível 1 | container_memory_usage_bytes{namespace="ai-system",container="l1operator"} * 1e-6 |

|

| Operador de nível 2 | container_memory_usage_bytes{namespace="ai-system",container="l2operator"} * 1e-6 |

||

| Registros operacionais | Registros do operador de L1 | Operador de nível 1 | {service_name="vai-l1operator"} |

| Registros do operador L2 | Operador de nível 2 | {service_name="vai-l2operator"} |

|

| Registros de auditoria | Registros de auditoria do front-end da plataforma | Front-end do plug-in da Web da Vertex AI. | {service_name="istio"} |~ upstream_cluster:.*(vai-web-plugin-frontend) |

| Registros de auditoria do back-end da plataforma | Back-end do plug-in da Web da Vertex AI | {service_name="istio"} |~ upstream_cluster:.*(vai-web-plugin-backend) |

|

A tabela a seguir contém exemplos de consultas para monitorar serviços da API Vertex AI, como OCR, Speech-to-Text e Vertex AI Translation, no seu ambiente:

| Serviços da Vertex AI | |||

|---|---|---|---|

| Fonte de dados | Descrição | Serviço | Consulta |

| Métricas | O efeito de uma API pré-treinada no uso da CPU . |

OCR | rate(container_cpu_usage_seconds_total{namespace="g-vai-ocr-sie",container="CONTAINER_NAME"}[30s]) * 100 CONTAINER_NAME values: vision-extractor | vision-frontend | vision-vms-ocr |

| Speech-to-Text | rate(container_cpu_usage_seconds_total{namespace="g-vai-speech-sie",container="CONTAINER_NAME"}[30s]) * 100 |

||

| Vertex AI Translation | rate(container_cpu_usage_seconds_total{namespace="g-vai-translation-sie",container="CONTAINER_NAME"}[30s]) * 100 CONTAINER_NAME values: translation-aligner | translation-frontend | translation-prediction |

||

Use o rótulo de filtro destination_service para receber a taxa de erros nos últimos 60 minutos. |

OCR | rate(istio_requests_total{destination_service=~".*g-vai-ocr-sie.svc.cluster.local",response_code=~"[4-5][0-9][0-9]"}[60m]) |

|

| Speech-to-Text | rate(istio_requests_total{destination_service=~".*g-vai-speech-sie.svc.cluster.local",response_code=~"[4-5][0-9][0-9]"}[60m]) |

||

| Vertex AI Translation | rate(istio_requests_total{destination_service=~".*g-vai-translation-sie.svc.cluster.local",response_code=~"[4-5][0-9][0-9]"}[60m]) |

||

| Registros operacionais | Registros operacionais dos serviços da Vertex AI |

OCR | {namespace="g-vai-ocr-sie"} |

| Speech-to-Text | {namespace="g-vai-speech-sie"} |

||

| Vertex AI Translation | {namespace="g-vai-translation-sie"} |

||

| Registros de auditoria | Registros de auditoria dos serviços da Vertex AI | OCR | {service_name="istio"} |= "vision-frontend-server" |

| Speech-to-Text | {service_name="istio"} |= "speech-frontend-server" |

||

| Vertex AI Translation | {service_name="istio"} |= "translation-frontend-server" |

||