目標

このチュートリアルでは、Dataproc Jupyter および Anaconda コンポーネントを新しいクラスタにインストールしてから、Dataproc コンポーネント ゲートウェイを使用してローカル ブラウザからクラスタで実行されている Jupyter ノートブック UI に接続する方法を説明します。

費用

このドキュメントでは、Google Cloud の次の課金対象のコンポーネントを使用します。

料金計算ツールを使うと、予想使用量に基づいて費用の見積もりを生成できます。

始める前に

Google Cloud Platform プロジェクトと Cloud Storage バケットをまだ作成していない場合は作成します。

プロジェクトの設定

- Sign in to your Google Cloud account. If you're new to Google Cloud, create an account to evaluate how our products perform in real-world scenarios. New customers also get $300 in free credits to run, test, and deploy workloads.

-

Google Cloud Console の [プロジェクト セレクタ] ページで、Google Cloud プロジェクトを選択または作成します。

-

Dataproc, Compute Engine, and Cloud Storage API を有効にします。

- Google Cloud CLI をインストールします。

-

gcloud CLI を初期化するには:

gcloud init

-

Google Cloud Console の [プロジェクト セレクタ] ページで、Google Cloud プロジェクトを選択または作成します。

-

Dataproc, Compute Engine, and Cloud Storage API を有効にします。

- Google Cloud CLI をインストールします。

-

gcloud CLI を初期化するには:

gcloud init

このチュートリアルで作成するノートブックを格納するプロジェクトに Cloud Storage バケットを作成する。

- Google Cloud コンソールで、Cloud Storage の [バケット] ページに移動します。

- [バケットを作成] をクリックします。

- [バケットの作成] ページでユーザーのバケット情報を入力します。次のステップに進むには、[続行] をクリックします。

- [作成] をクリックします。 ノートブックは Cloud Storage の

gs://bucket-name/notebooks/jupyterに保存されます。

クラスタを作成して Jupyter コンポーネントをインストールする

インストール済みの Jupyter コンポーネントでクラスタを作成します。

Jupyter と JupyterLab の UI を開く

Google Cloud コンソールで Google Cloud コンソール コンポーネント ゲートウェイのリンクをクリックして、クラスタのマスターノードで実行されている Jupyter ノートブックまたは JupyterLab UI を開きます。

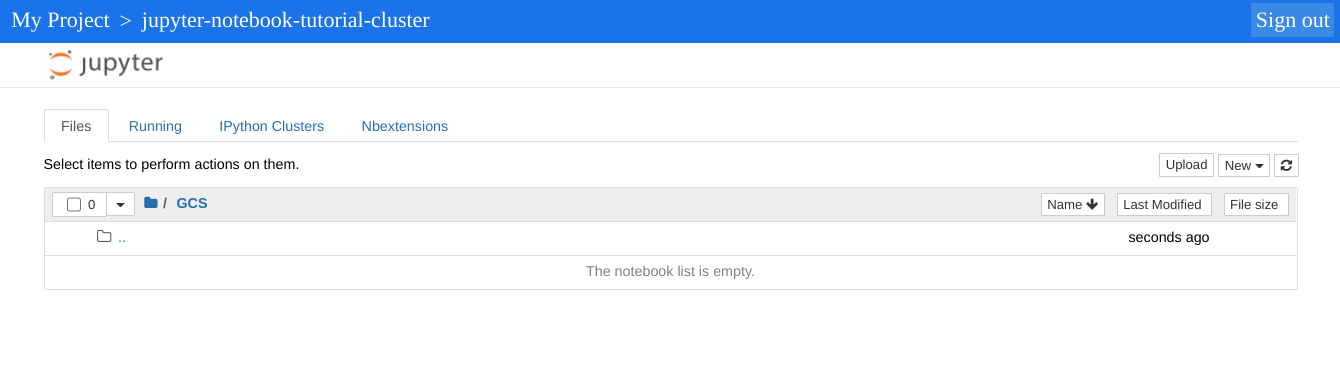

Jupyter インスタンスに表示される最上位ディレクトリは、Cloud Storage バケットとローカル ファイル システムの内容を表示できる仮想ディレクトリです。Cloud Storage の [GCS] リンクをクリックするか、クラスタ内のマスターノードのローカル ファイルシステムの [ローカル ディスク] をクリックして、いずれかのロケーションを選択できます。

- [GCS] リンクをクリックします。Jupyter ノートブックのウェブ UI には、このチュートリアルで作成したノートブックを含め、Cloud Storage バケットに保存されているノートブックが表示されます。

クリーンアップ

チュートリアルが終了したら、作成したリソースをクリーンアップして、割り当ての使用を停止し、課金されないようにできます。次のセクションで、リソースを削除または無効にする方法を説明します。

プロジェクトの削除

課金をなくす最も簡単な方法は、チュートリアル用に作成したプロジェクトを削除することです。

プロジェクトを削除するには:

- Google Cloud コンソールで、[リソースの管理] ページに移動します。

- プロジェクト リストで、削除するプロジェクトを選択し、[削除] をクリックします。

- ダイアログでプロジェクト ID を入力し、[シャットダウン] をクリックしてプロジェクトを削除します。

クラスタの削除

- クラスタを削除するには:

gcloud dataproc clusters delete cluster-name \ --region=${REGION}

バケットの削除

- バケットに保存されているノートブックを含め、始める前にの手順 2 で作成した Cloud Storage バケットを削除するには:

gsutil -m rm -r gs://${BUCKET_NAME}