In diesem Dokument verwenden Sie die folgenden kostenpflichtigen Komponenten von Google Cloud:

- Dataproc

- Compute Engine

- Cloud Scheduler

Mit dem Preisrechner können Sie eine Kostenschätzung für Ihre voraussichtliche Nutzung vornehmen.

Hinweise

Projekt einrichten

- Sign in to your Google Cloud account. If you're new to Google Cloud, create an account to evaluate how our products perform in real-world scenarios. New customers also get $300 in free credits to run, test, and deploy workloads.

-

In the Google Cloud console, on the project selector page, select or create a Google Cloud project.

Roles required to select or create a project

- Select a project: Selecting a project doesn't require a specific IAM role—you can select any project that you've been granted a role on.

-

Create a project: To create a project, you need the Project Creator

(

roles/resourcemanager.projectCreator), which contains theresourcemanager.projects.createpermission. Learn how to grant roles.

-

Verify that billing is enabled for your Google Cloud project.

-

Enable the Dataproc, Compute Engine, and Cloud Scheduler APIs.

Roles required to enable APIs

To enable APIs, you need the Service Usage Admin IAM role (

roles/serviceusage.serviceUsageAdmin), which contains theserviceusage.services.enablepermission. Learn how to grant roles. -

Install the Google Cloud CLI.

-

Wenn Sie einen externen Identitätsanbieter (IdP) verwenden, müssen Sie sich zuerst mit Ihrer föderierten Identität in der gcloud CLI anmelden.

-

Führen Sie folgenden Befehl aus, um die gcloud CLI zu initialisieren:

gcloud init -

In the Google Cloud console, on the project selector page, select or create a Google Cloud project.

Roles required to select or create a project

- Select a project: Selecting a project doesn't require a specific IAM role—you can select any project that you've been granted a role on.

-

Create a project: To create a project, you need the Project Creator

(

roles/resourcemanager.projectCreator), which contains theresourcemanager.projects.createpermission. Learn how to grant roles.

-

Verify that billing is enabled for your Google Cloud project.

-

Enable the Dataproc, Compute Engine, and Cloud Scheduler APIs.

Roles required to enable APIs

To enable APIs, you need the Service Usage Admin IAM role (

roles/serviceusage.serviceUsageAdmin), which contains theserviceusage.services.enablepermission. Learn how to grant roles. -

Install the Google Cloud CLI.

-

Wenn Sie einen externen Identitätsanbieter (IdP) verwenden, müssen Sie sich zuerst mit Ihrer föderierten Identität in der gcloud CLI anmelden.

-

Führen Sie folgenden Befehl aus, um die gcloud CLI zu initialisieren:

gcloud init - Öffnen Sie in der Google Cloud Console die Seite IAM & Verwaltung → Rollen.

- Klicken Sie auf ROLLE ERSTELLEN, um die Seite Rolle erstellen zu öffnen.

- Füllen Sie die Felder "Titel", "Beschreibung", "ID" und "Startphase" aus. Vorschlag: Verwenden Sie "Dataproc-Workflow-Vorlage erstellen" als Rollentitel.

- Klicken Sie auf

- Berechtigungen hinzufügen.

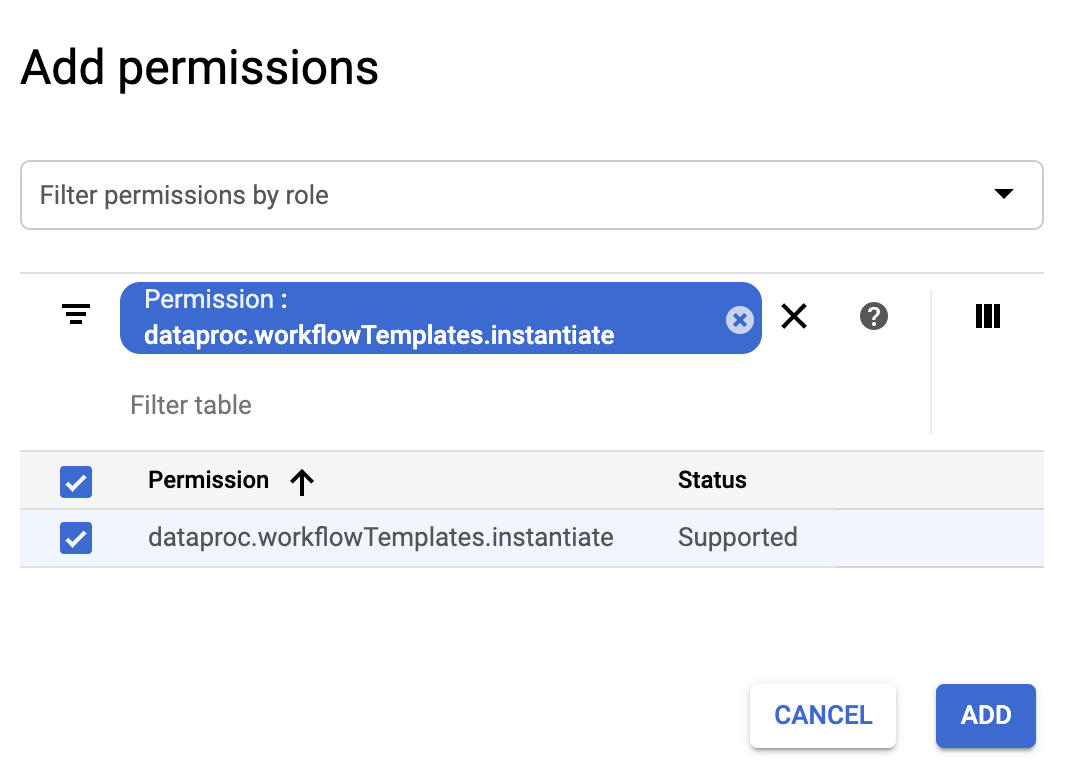

- Klicken Sie im Formular Berechtigungen hinzufügen auf Filter und wählen Sie dann „Berechtigung“ aus. Schließen Sie den Filter ab, um "Berechtigung: dataproc.workflowTemplates.instantiate" zu lesen.

- Klicken Sie auf das Kästchen links neben der aufgeführten Berechtigung und dann auf Hinzufügen.

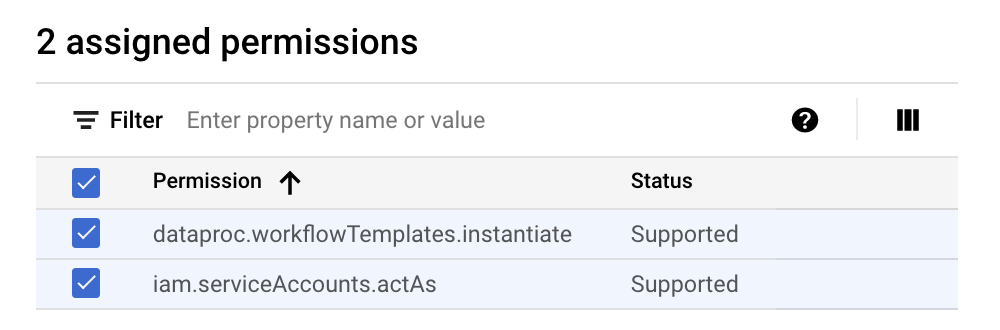

- Klicken Sie auf der Seite "Rolle erstellen" noch einmal auf PERMISSIONS HINZUFÜGEN, um die vorherigen Unterschritte zu wiederholen und der benutzerdefinierten Rolle die Berechtigung "iam.serviceAccounts.actAs" hinzuzufügen. Auf der Seite Rolle erstellen werden jetzt zwei Berechtigungen aufgeführt.

- Klicken Sie auf der Seite Benutzerdefinierte Rolle auf ERSTELLEN.

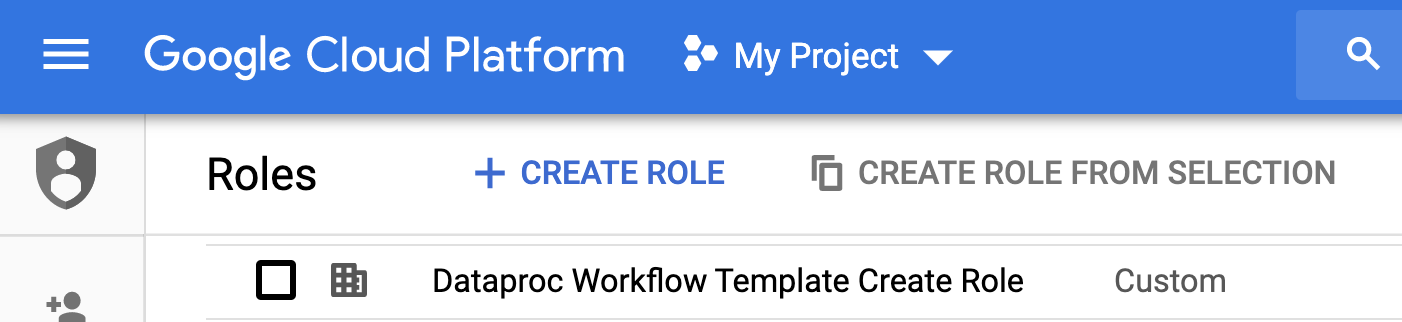

Die benutzerdefinierte Rolle wird auf der Seite Rollen aufgeführt.

Rufen Sie in der Google Cloud Console die Seite Dienstkonten auf.

Wählen Sie Ihr Projekt aus.

Klicken Sie auf Dienstkonto erstellen.

Geben Sie im Feld Name des Dienstkontos den Namen

workflow-schedulerein. Die Google Cloud Console füllt das Feld Dienstkonto-ID anhand dieses Namens aus.Optional: Im Feld Beschreibung des Dienstkontos können Sie eine entsprechende Beschreibung eingeben.

Klicken Sie auf Erstellen und fortfahren.

Klicken Sie auf das Feld Rolle auswählen und wählen Sie die benutzerdefinierte Rolle Dataproc Workflow Template Create aus, die Sie im vorherigen Schritt erstellt haben.

Klicken Sie auf Weiter.

Geben Sie im Feld Rolle "Dienstkontoadministrator" die E-Mail-Adresse Ihres Google-Kontos ein.

Klicken Sie auf Fertig, um das Erstellen des Dienstkontos abzuschließen.

- Die Befehle geben die Region "us-central1" an. Sie können eine andere Region angeben oder das Flag

--regionlöschen, wenn Sie zuvorgcloud config set compute/regionausgeführt haben, um das Regionsattribut festzulegen. - Die Sequenz "--" (Bindestrich-Bindestrich-Leerzeichen) im Befehl

add-jobübergibt das Argument1000an den SparkPi-Job, der die Anzahl der Stichproben angibt, die zur Schätzung des Werts von Pi verwendet werden. - Erstellen Sie die Workflow-Vorlage.

gcloud dataproc workflow-templates create sparkpi \ --region=us-central1

- Fügen Sie der Workflow-Vorlage den Spark-Job hinzu. Die Schritt-ID "compute" ist erforderlich und identifiziert den hinzugefügten SparkPi-Job.

gcloud dataproc workflow-templates add-job spark \ --workflow-template=sparkpi \ --step-id=compute \ --class=org.apache.spark.examples.SparkPi \ --jars=file:///usr/lib/spark/examples/jars/spark-examples.jar \ --region=us-central1 \ -- 1000

- Führen Sie den Workflow mit einem verwalteten Einzelknoten aus. Dataproc erstellt den Cluster, führt den Workflow aus und löscht den Cluster, wenn der Workflow abgeschlossen ist.

gcloud dataproc workflow-templates set-managed-cluster sparkpi \ --cluster-name=sparkpi \ --single-node \ --region=us-central1

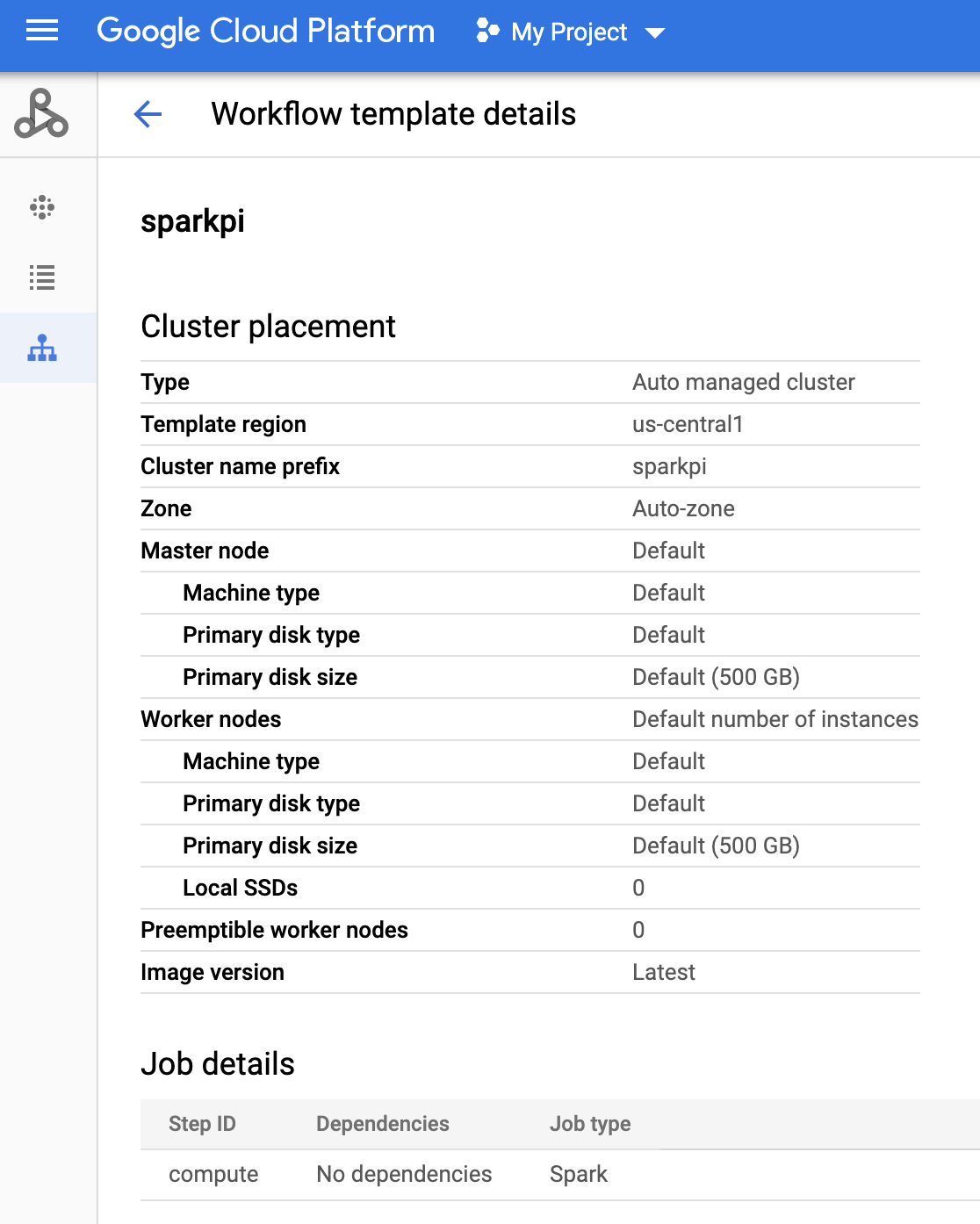

- Klicken Sie in der Google Cloud Console auf der Dataproc-Seite Workflows auf den Namen

sparkpi, um die Seite Workflow-Vorlagendetails zu öffnen. Bestätigen Sie die Attribute der SparkPi-Vorlage.

Öffnen Sie die Seite Cloud Scheduler in derGoogle Cloud -Konsole. Sie müssen möglicherweise Ihr Projekt auswählen, um die Seite zu öffnen. Klicken Sie auf Job ERSTELLEN.

Geben Sie die folgenden Jobinformationen ein oder wählen Sie diese aus:

- Region auswählen: "us-central" oder eine andere Region, in der Sie Ihre Workflow-Vorlage erstellt haben

- Name: "sparkpi"

- Häufigkeit: Mit "* * * * *" wird jede Minute ausgewählt. "0 9 * * 1" wählt jeden Montag um 9 Uhr aus. Weitere Informationen zu anderen unix-cron-Werten finden Sie unter Jobzeitplan definieren. Hinweis:Sie können auf die Schaltfläche JETZT AUSFÜHREN in den Cloud Scheduler-Jobs in der Google Cloud Console klicken, um den Job auszuführen und zu testen, unabhängig von der Häufigkeit, die Sie für den Job eingestellt haben.

- Zeitzone: Wählen Sie Ihre timezone aus. Geben Sie "USA" ein, um die US-Zeitzonen aufzulisten.

- Ziel: „HTTP“

- URL: Fügen Sie nach dem Einfügen von your-project-id die folgende URL ein. Ersetzen Sie "us-central1", wenn Sie Ihre Workflow-Vorlage in einer anderen Region erstellt haben. Diese URL ruft die Dataproc API

workflowTemplates.instantiateauf, um Ihre Sparkpi-Workflow-Vorlage auszuführen.https://dataproc.googleapis.com/v1/projects/your-project-id/regions/us-central1/workflowTemplates/sparkpi:instantiate?alt=json

- HTTP-Methode:

- "POST"

- Text: "{}"

- Auth-Header:

- "Add OAuth token"

- Dienstkonto: Fügen Sie den service account address des Dienstkontos ein, das Sie für diese Anleitung erstellt haben.

Sie können die folgende Kontoadresse nach dem Einfügen von your-project-id verwenden:

workflow-scheduler@your-project-id.iam.gserviceaccount.com

- Bereich: Sie können dieses Element ignorieren.

- Klicken Sie auf ERSTELLEN.

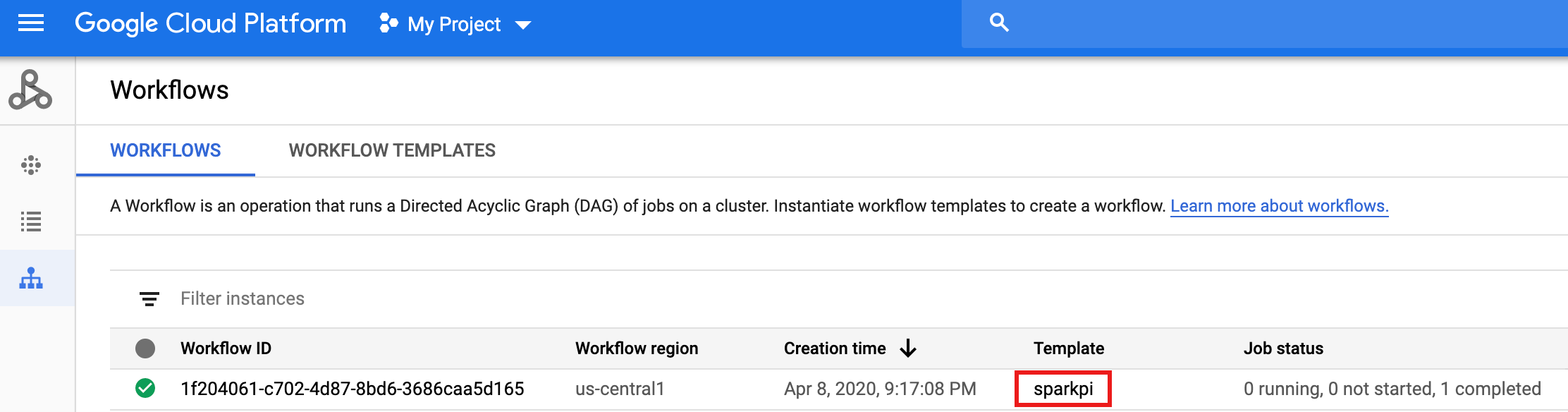

Klicken Sie in der Jobzeile

sparkpiauf der Seite Cloud Scheduler-Jobs auf JETZT AUSFÜHREN.Warten Sie einige Minuten und öffnen Sie dann die Dataproc-Seite Workflows, um zu prüfen, ob der SparkPi-Workflow abgeschlossen ist.

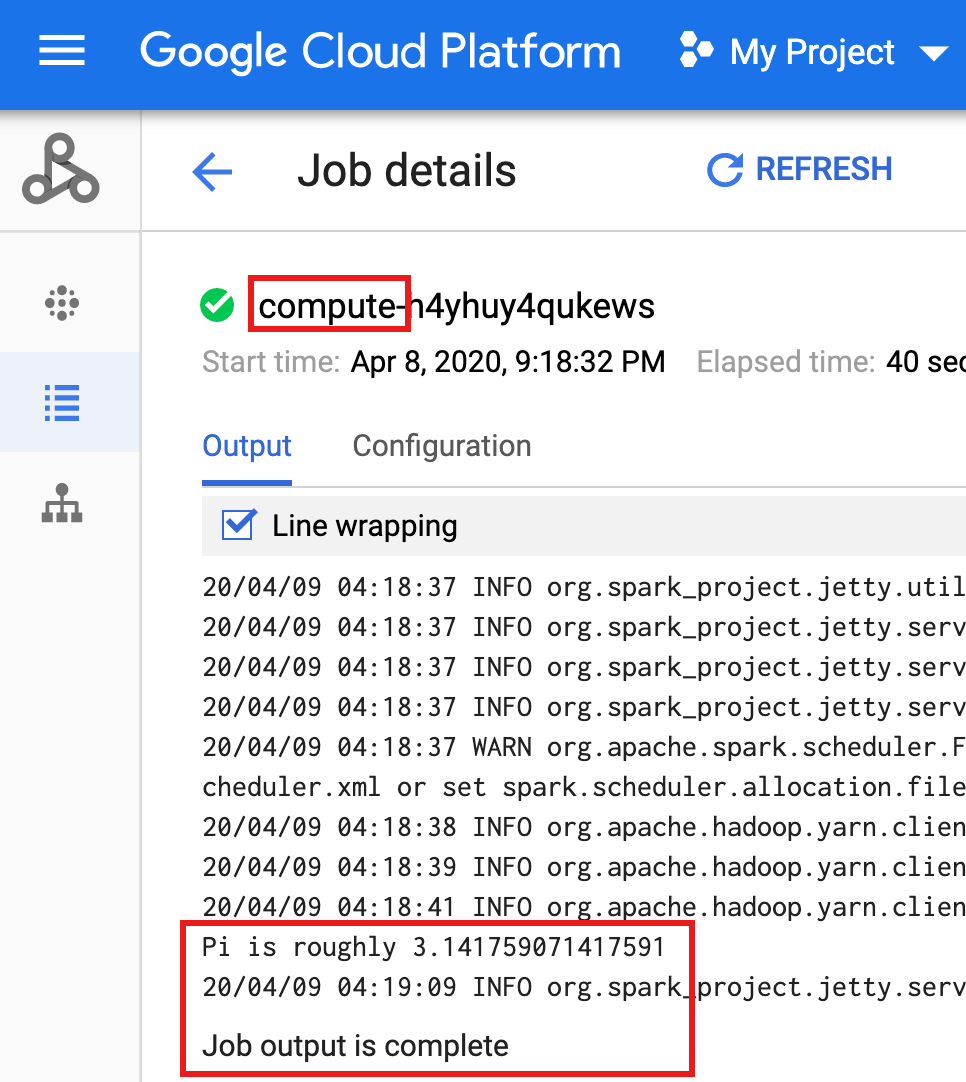

Nachdem der Workflow den verwalteten Cluster gelöscht hat, bleiben die Jobdetails in der Google Cloud Console erhalten. Klicken Sie auf den

compute...-Job, der auf der Dataproc-Seite Jobs aufgeführt ist, um Details zum Workflow-Job anzuzeigen.

- In the Google Cloud console, go to the Manage resources page.

- In the project list, select the project that you want to delete, and then click Delete.

- In the dialog, type the project ID, and then click Shut down to delete the project.

- Weitere Informationen finden Sie unter Übersicht über Dataproc-Workflow-Vorlagen.

- Weitere Informationen finden Sie unter Lösungen für die Workflow-Planung.

Benutzerdefinierte Rolle erstellen

Dienstkonto erstellen

Workflow-Vorlage erstellen

Kopieren Sie die unten aufgeführten Befehle und führen Sie sie in einem lokalen Terminalfenster oder in Cloud Shell aus, um eine Workflow-Vorlage zu erstellen und zu definieren.

Hinweise:

Cloud Scheduler-Job erstellen

Geplanten Workflow-Job testen

Bereinigen

Der Workflow in dieser Anleitung löscht den verwalteten Cluster, wenn der Workflow abgeschlossen ist. Wenn Sie den Workflow beibehalten, können Sie den Workflow noch einmal ausführen und es fallen keine Gebühren an. Sie können andere in dieser Anleitung erstellte Ressourcen löschen, um wiederkehrende Kosten zu vermeiden.

Projekt löschen

Workflow-Vorlage löschen

gcloud dataproc workflow-templates delete sparkpi \ --region=us-central1

Cloud Scheduler-Job löschen

Öffnen Sie in der Google Cloud -Konsole die Seite Cloud Scheduler Jobs, klicken Sie auf das Kästchen links neben der Funktion sparkpi und klicken Sie auf LÖSCHEN.

Dienstkonto löschen

Öffnen Sie in der Google Cloud Console die Seite IAM & Verwaltung → Dienstkonten, klicken Sie auf das Kästchen links neben dem Dienstkonto workflow-scheduler... und klicken Sie auf LÖSCHEN.