Google Kubernetes Engine (GKE)

L'évolution de Kubernetes : principes de base pour les créateurs de plates-formes

Mettez vos conteneurs en mode Autopilot et exécutez de façon sécurisée vos charges de travail d'entreprise à grande échelle, quel que soit votre niveau d'expertise opérationnelle sur Kubernetes.

Bénéficiez d'un cluster zonal ou Autopilot sans frais par mois. De plus, les nouveaux clients bénéficient de 300 $ de crédits offerts pour essayer GKE.

Fonctionnalités

Gestion simplifiée des clusters et meilleure efficacité des ressources

GKE Autopilot est un mode de fonctionnement dans lequel Google gère votre infrastructure de nœuds, le scaling, la sécurité et les fonctionnalités préconfigurées. Grâce au dimensionnement automatique de la capacité et à la tarification par pod, vous pouvez éviter le surprovisionnement, les coûts excessifs et la sous-utilisation. La plate-forme de calcul optimisée pour les conteneurs d'Autopilot vous permet d'obtenir des ressources de calcul évolutives verticalement et horizontalement en temps quasi réel. Vous bénéficiez ainsi de la capacité nécessaire au moment où vous en avez besoin, au meilleur prix et avec les meilleures performances.

Plate-forme prête pour la production pour les charges de travail d'IA agentive et les modèles d'IA générative

Avec la prise en charge de clusters de 65 000 nœuds, l'intégration à AI Hypercomputer et la compatibilité avec les GPU et les TPU, GKE facilite l'exécution des charges de travail de ML, HPC et autres auxquelles sont appliqués des accélérateurs matériels spécialisés.

Les fonctionnalités d'inférence de GKE, associées aux techniques d'équilibrage de charge et de scaling adaptées à l'IA générative, permettent de réduire les coûts de diffusion de plus de 30 % et la latence de queue de 60 %, et d'augmenter le débit jusqu'à 40 % par rapport à d'autres offres Kubernetes gérées et Open Source.

Conception sécurisée

GKE offre une sécurité à grande échelle grâce à des bonnes pratiques intégrées, une infrastructure conforme et des alertes en temps réel. Vous pouvez ainsi atténuer rapidement et efficacement les menaces de sécurité et les problèmes de conformité dans une vue unifiée.

GKE est géré par l'équipe de sécurité Google, qui compte plus de 750 spécialistes. Sa stratégie de sécurité intégrée inclut l'application de correctifs et le renforcement, l'isolation et la segmentation, les nœuds Confidential GKE Node, la gestion de l'authentification et des accès, ainsi que des intégrations avec Cloud Logging et Cloud Monitoring.

De plus, avec GKE Sandbox, vous pouvez ajouter une seconde ligne de défense entre les charges de travail conteneurisées sur GKE et augmenter leur niveau de sécurité.

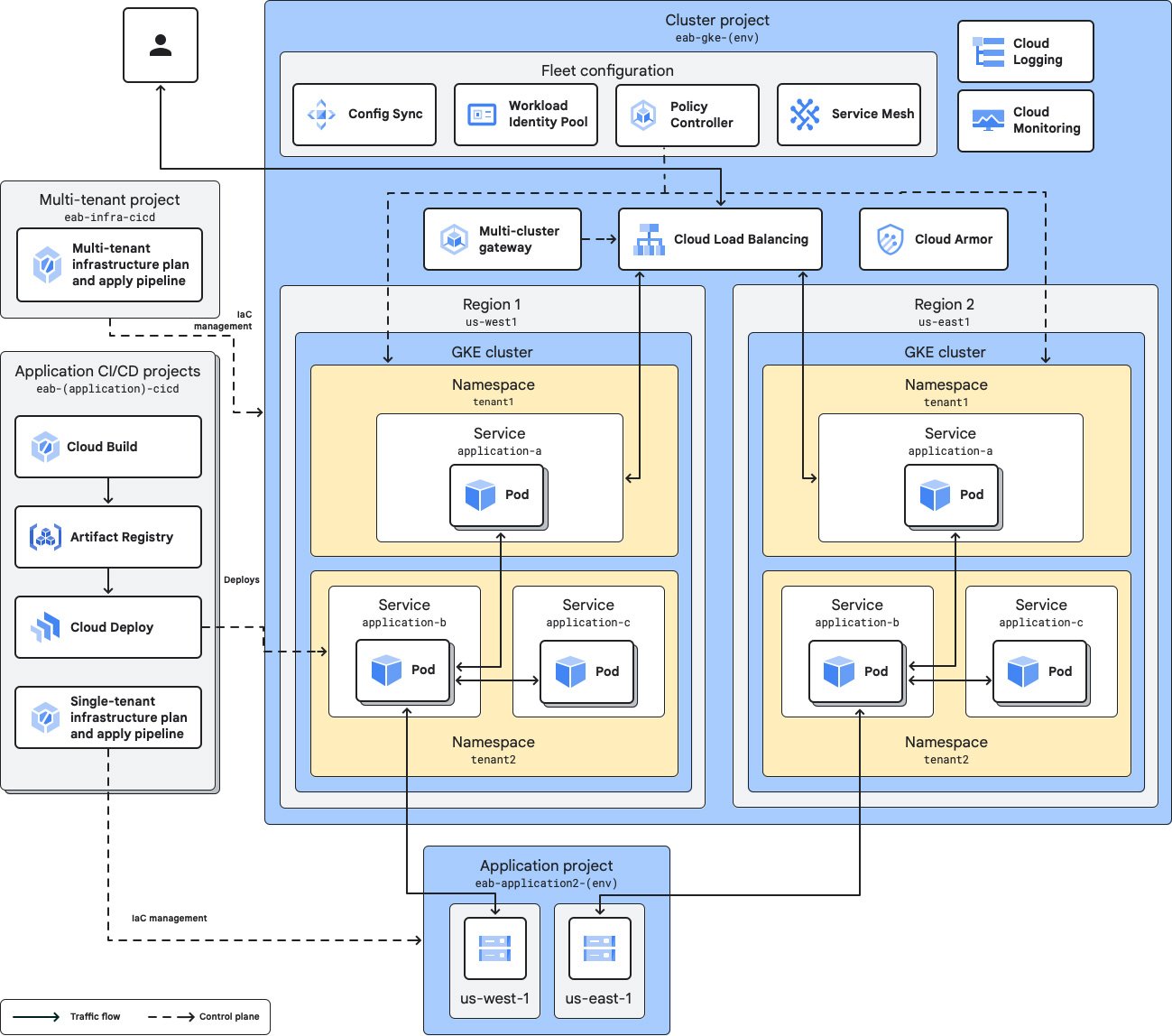

Gestion de plusieurs équipes et de plusieurs clusters

Les parcs et les équipes permettent d'organiser les clusters et les charges de travail, et d'attribuer facilement des ressources à plusieurs équipes afin d'améliorer la rapidité d'exécution et de déléguer la propriété de ces ressources. Les niveaux d'accès d'équipe vous permettent de définir des sous-ensembles de ressources de parc par équipe, chaque niveau d'accès étant associé à un ou plusieurs clusters membres du parc.

Vous pouvez choisir d'utiliser plusieurs clusters pour dissocier les services entre divers environnements, niveaux, paramètres régionaux, équipes ou fournisseurs d'infrastructure. Les parcs s'efforcent de faciliter la gestion de plusieurs clusters.

Portabilité des charges de travail avec compatibilité multicloud

GKE est conforme au programme Certified Kubernetes et adopte des normes ouvertes pour permettre aux clients d'exécuter leurs applications, sans les modifier, sur des investissements matériels sur site existants ou dans le cloud public.

Les clusters associés à GKE vous permettent d'enregistrer ou d'associer n'importe quel cluster Kubernetes conforme que vous avez créé vous-même dans l'environnement de gestion GKE. L'association d'un cluster vous permet de le gérer et de le contrôler avec GKE, ainsi que d'accéder à des fonctionnalités supplémentaires telles que Config Sync, Cloud Service Mesh et les parcs.

Fonctionnement

Dans chaque cluster GKE, GKE gère le cycle de vie du plan de contrôle Kubernetes, de la création à la suppression du cluster. Avec Autopilot activé, GKE peut également gérer vos nœuds, y compris le provisionnement, le scaling et la planification automatisés. Vous pouvez aussi choisir de gérer vous-même les nœuds pour plus de contrôle.

Dans chaque cluster GKE, GKE gère le cycle de vie du plan de contrôle Kubernetes, de la création à la suppression du cluster. Avec Autopilot activé, GKE peut également gérer vos nœuds, y compris le provisionnement, le scaling et la planification automatisés. Vous pouvez aussi choisir de gérer vous-même les nœuds pour plus de contrôle.

Utilisations courantes

Créez des plates-formes pour toutes vos charges de travail

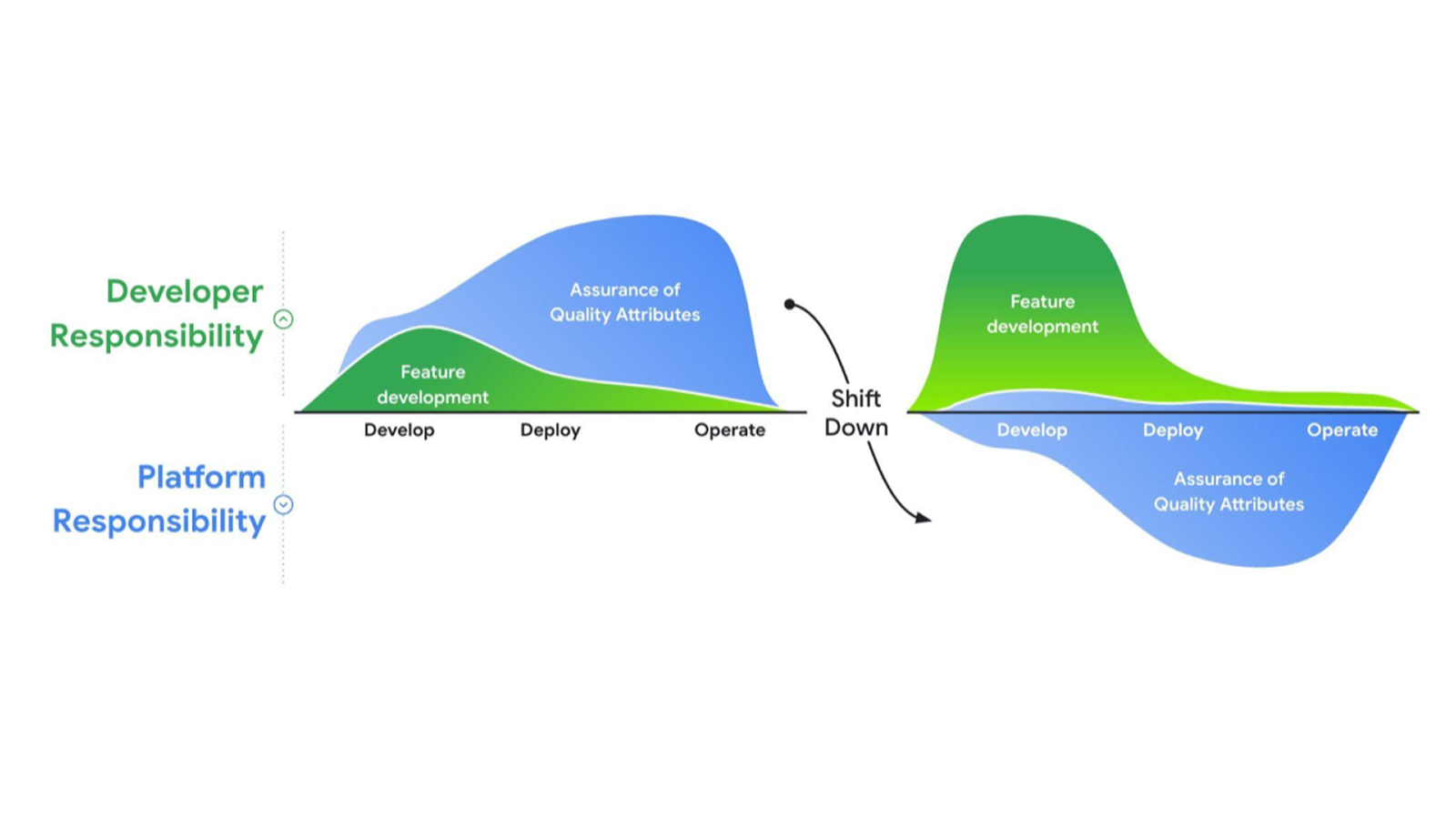

Créer une plate-forme pour les développeurs professionnels afin de déployer les applications de manière rapide et fiable

Créer une plate-forme pour les développeurs professionnels afin de déployer les applications de manière rapide et fiable

Google Cloud propose une suite complète de services et d'environnements d'exécution gérés qui servent de composants de base pour votre plate-forme. Vous pouvez ainsi trouver la combinaison de services adaptée à vos cas d'utilisation. Grâce à son intégration étroite à l'écosystème Google Cloud, à son évolutivité inégalée et à sa stratégie de sécurité intégrée, GKE constitue une base idéale pour votre plate-forme.

Qu'est-ce que l'ingénierie de plate-forme ?

Tutoriels, guides de démarrage rapide et ateliers

Créer une plate-forme pour les développeurs professionnels afin de déployer les applications de manière rapide et fiable

Créer une plate-forme pour les développeurs professionnels afin de déployer les applications de manière rapide et fiable

Google Cloud propose une suite complète de services et d'environnements d'exécution gérés qui servent de composants de base pour votre plate-forme. Vous pouvez ainsi trouver la combinaison de services adaptée à vos cas d'utilisation. Grâce à son intégration étroite à l'écosystème Google Cloud, à son évolutivité inégalée et à sa stratégie de sécurité intégrée, GKE constitue une base idéale pour votre plate-forme.

Ressources de formation

Qu'est-ce que l'ingénierie de plate-forme ?

Entraîner, diffuser et faire évoluer des modèles d'IA générative

Déployer l'inférence de l'IA générative avec GKE

Déployer l'inférence de l'IA générative avec GKE

GKE fournit non seulement une plate-forme pour l'IA, mais il simplifie et automatise également les opérations Kubernetes grâce à l'IA. Avec une capacité pouvant atteindre 65 000 nœuds et l'intégration d'AI Hypercomputer, vous pouvez entraîner et faire évoluer vos plus grands modèles d'IA générative sur GKE.

De plus, les fonctionnalités d'inférence de GKE adaptées à l'IA générative permettent de réduire jusqu'à 30 % les coûts de diffusion, jusqu'à 60 % la latence de queue et d'augmenter le débit jusqu'à 40 % par rapport à Kubernetes OSS.

Tutoriels, guides de démarrage rapide et ateliers

Déployer l'inférence de l'IA générative avec GKE

Déployer l'inférence de l'IA générative avec GKE

GKE fournit non seulement une plate-forme pour l'IA, mais il simplifie et automatise également les opérations Kubernetes grâce à l'IA. Avec une capacité pouvant atteindre 65 000 nœuds et l'intégration d'AI Hypercomputer, vous pouvez entraîner et faire évoluer vos plus grands modèles d'IA générative sur GKE.

De plus, les fonctionnalités d'inférence de GKE adaptées à l'IA générative permettent de réduire jusqu'à 30 % les coûts de diffusion, jusqu'à 60 % la latence de queue et d'augmenter le débit jusqu'à 40 % par rapport à Kubernetes OSS.

Orchestration multi-agent

Déployer et orchestrer des applications multi-agents

Déployer et orchestrer des applications multi-agents

L'IA agentive se concentre sur l'orchestration et l'exécution d'agents utilisant des LLM comme "cerveau" pour effectuer des actions à l'aide d'outils.

GKE est la plate-forme ouverte de référence pour prendre en charge les agents et orchestrer vos ressources de calcul. Vous pouvez ainsi adopter la nouvelle génération de charges de travail d'IA agentive.

Tutoriels, guides de démarrage rapide et ateliers

Déployer et orchestrer des applications multi-agents

Déployer et orchestrer des applications multi-agents

L'IA agentive se concentre sur l'orchestration et l'exécution d'agents utilisant des LLM comme "cerveau" pour effectuer des actions à l'aide d'outils.

GKE est la plate-forme ouverte de référence pour prendre en charge les agents et orchestrer vos ressources de calcul. Vous pouvez ainsi adopter la nouvelle génération de charges de travail d'IA agentive.

Tarification

| Fonctionnement des tarifs de GKE | Une fois les crédits offerts utilisés, le coût total est basé sur le mode de fonctionnement du cluster, les frais de gestion du cluster et les frais applicables au transfert de données entrantes. | |

|---|---|---|

| Service | Description | Prix (USD) |

Version gratuite | La version gratuite de GKE fournit 74,40 $ de crédits mensuels par compte de facturation, appliqués aux clusters zonaux et Autopilot. | Gratuit |

Frais de gestion des clusters | Inclut la gestion entièrement automatisée du cycle de vie des clusters, l'autoscaling des pods et des clusters, la visibilité des coûts, l'optimisation automatisée des coûts d'infrastructure et des fonctionnalités de gestion de plusieurs clusters, sans frais supplémentaires. | 0,10 $ par cluster et par heure |

Calcul | Lorsque vous utilisez Autopilot, vous ne payez que pour les ressources de processeur, de mémoire et de calcul provisionnées pour vos pods. Pour les pools de nœuds et les classes de calcul qui n'utilisent pas Autopilot, les instances Compute Engine sous-jacentes des nœuds vous sont facturées jusqu'à ce que les nœuds soient supprimés. | Consultez les tarifs de Compute Engine. |

Apprenez-en davantage sur les tarifs de GKE. Afficher le détail des tarifs

Fonctionnement des tarifs de GKE

Une fois les crédits offerts utilisés, le coût total est basé sur le mode de fonctionnement du cluster, les frais de gestion du cluster et les frais applicables au transfert de données entrantes.

La version gratuite de GKE fournit 74,40 $ de crédits mensuels par compte de facturation, appliqués aux clusters zonaux et Autopilot.

Gratuit

Frais de gestion des clusters

Inclut la gestion entièrement automatisée du cycle de vie des clusters, l'autoscaling des pods et des clusters, la visibilité des coûts, l'optimisation automatisée des coûts d'infrastructure et des fonctionnalités de gestion de plusieurs clusters, sans frais supplémentaires.

0,10 $

par cluster et par heure

Lorsque vous utilisez Autopilot, vous ne payez que pour les ressources de processeur, de mémoire et de calcul provisionnées pour vos pods.

Pour les pools de nœuds et les classes de calcul qui n'utilisent pas Autopilot, les instances Compute Engine sous-jacentes des nœuds vous sont facturées jusqu'à ce que les nœuds soient supprimés.

Consultez les tarifs de Compute Engine.

Apprenez-en davantage sur les tarifs de GKE. Afficher le détail des tarifs

Cas d'utilisation métier

Inspirez-vous de nos clients GKE

Signify utilise GKE depuis plus de 10 ans

Grâce à GKE, la plate-forme Philips Hue a pu faire évoluer son infrastructure afin de répondre à une augmentation de 1 150 % des transactions et des commandes au cours de la dernière décennie.

Innover avec l'IA sur GKE

Moloco, fournisseur de services publicitaires optimisés par l'IA, entraîne ses modèles 10 fois plus vite avec les TPU sur GKE.

Avec les TPU sur GKE, HubX réduit la latence jusqu'à 66 %, ce qui améliore l'expérience utilisateur et augmente les taux de conversion.

LiveX AI réduit son coût total de possession de plus de 50 %, son délai de mise sur le marché de 25 % et ses coûts opérationnels de 66 % grâce à GKE Autopilot.