Dataproc

透過 Google Dataproc 執行代管的 Apache Spark 和 Hadoop

透過代管服務,更輕鬆執行最嚴苛的 Spark 和開放原始碼工作負載;運用 Gemini,以更聰明的方式工作;利用 Lightning Engine,加快工作速度。

Apache Spark 是 Apache Software Foundation 的商標。

功能

領先業界的效能

Lightning Engine 可加速處理最嚴苛的 Spark 工作。我們的新一代引擎採用代管最佳化功能,可將效能提升 4.3 倍以上,進而減少 TCO 和手動調整作業。現已推出 Dataproc 適用的預先發布版。

AI 輔助開發與運作

運用 Gemini 加快整個工作流程。取得 AI 輔助功能,編寫 PySpark 程式碼並偵錯,還能使用 Gemini Cloud Assist 自動分析失敗或執行緩慢的工作,找出根本原因,大幅縮短疑難排解時間。

可搭配企業級 AI/機器學習技術使用

建構及運作整個機器學習生命週期。透過 NVIDIA RAPIDS™ 支援的 GPU 和預先設定的機器學習執行階段,加快模型訓練和推論速度。接著與更廣泛的 Google Cloud AI 生態系統整合,透過 Vertex AI Pipelines 自動化調度管理端對端 MLOps。

強大的湖倉整合功能

可直接連線至開放式湖倉架構。直接從 BigQuery 處理資料、使用 Vertex AI Pipelines 自動調度管理 MLOps,並透過 BigLake 和 Dataplex Universal Catalog 統一管理開放資料。

無可比擬的控管與自訂功能

您可以根據確切需求調整每個 Dataproc 叢集。您可以使用 Python、Scala 或 Java 開發,從多種機型中選擇,使用初始化動作安裝自訂軟體,並自備容器映像檔,確保最大可攜性。

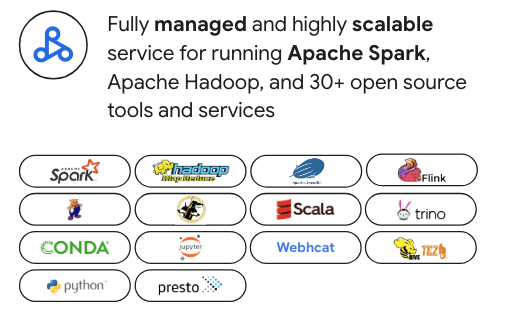

專為現代開放原始碼資料堆疊而打造

不必受制於特定廠商。Dataproc 專為 Apache Spark 最佳化,但同時支援超過 30 開放原始碼工具,例如 Apache Hadoop、Flink、Trino 和 Presto。可與 Airflow 等熱門自動調度管理工具完美整合,並透過 Kubernetes 和 Docker 擴充,提供最大的彈性。

企業級安全性

與您的安全防護機制完美整合。在 Spark 叢集上,您可以運用 IAM 設定精細的權限、使用 VPC Service Controls 確保網路安全,並透過 Kerberos 進行嚴格的驗證。

常見用途

資料工程

建構並自動調度管理複雜、長期執行的 Spark ETL 管道,享有企業級的可靠性和擴充能力。您可以運用自動調度資源等強大功能,在成本和效能之間取得最佳平衡,並使用工作流程範本,自動化和管理最重要的正式環境等級工作,從頭到尾一手包辦。

學習資源

資料工程

建構並自動調度管理複雜、長期執行的 Spark ETL 管道,享有企業級的可靠性和擴充能力。您可以運用自動調度資源等強大功能,在成本和效能之間取得最佳平衡,並使用工作流程範本,自動化和管理最重要的正式環境等級工作,從頭到尾一手包辦。

大規模資料科學

為資料科學團隊提供強大的自訂 Spark 叢集環境,用於大規模模型訓練和批次推論。有了預先設定的機器學習執行階段和 GPU 支援,您可以加速整個機器學習生命週期,並與 Vertex AI 整合,建構及運作端對端 MLOps 管道。

學習資源

大規模資料科學

為資料科學團隊提供強大的自訂 Spark 叢集環境,用於大規模模型訓練和批次推論。有了預先設定的機器學習執行階段和 GPU 支援,您可以加速整個機器學習生命週期,並與 Vertex AI 整合,建構及運作端對端 MLOps 管道。

定價

| Dataproc 代管叢集 | Dataproc 採用即付即用計價模式,提供自動調度資源功能和先占 VM,因此能實現最佳成本效益。 |

|---|---|

重要元件 |

|

範例 | 如果叢集有 6 個節點 (1 個主要節點和 5 個 worker),每個節點有 4 個 CPU,則執行叢集 2 小時所需的費用為 $0.48 美元。Dataproc 費用 = vCPU 數量 * 小時數 * Dataproc 定價 = 24 * 2 * $0.01 美元 = $0.48 美元 |

Dataproc 代管叢集

Dataproc 採用即付即用計價模式,提供自動調度資源功能和先占 VM,因此能實現最佳成本效益。

重要元件

- Compute Engine 執行個體 (vCPU、記憶體)

- Dataproc 服務費 (每個 vCPU 時數)

- 永久磁碟

範例

如果叢集有 6 個節點 (1 個主要節點和 5 個 worker),每個節點有 4 個 CPU,則執行叢集 2 小時所需的費用為 $0.48 美元。Dataproc 費用 = vCPU 數量 * 小時數 * Dataproc 定價 = 24 * 2 * $0.01 美元 = $0.48 美元

企業案例

建構 Google Dataproc 的業務應用案例

Google Cloud Dataproc 和 Serverless Spark 與其他替代解決方案的經濟效益比較

瞭解與地端部署和其他雲端解決方案相比,Dataproc 如何大幅降低 TCO,並創造業務價值。

在報表中:

瞭解與其他雲端式 Spark 替代方案相比,Dataproc 和 Serverless for Apache Spark 如何省下 18% 到 60% 的費用。

瞭解 Google Cloud Serverless for Apache Spark 如何提供比其他無伺服器 Spark 產品高出 21% 至 55% 的成本效益。

瞭解 Dataproc 和 Google Cloud Serverless for Apache Spark 如何簡化 Spark 部署作業,並降低營運複雜度。

常見問題

我該選擇 Dataproc 還是 Google Cloud Serverless for Apache Spark?

如果需要細微控管叢集環境、遷移現有的 Hadoop/Spark 工作負載,或需要具備多種開放原始碼工具的永久叢集,Dataproc 是理想選擇。歡迎點選以下連結,詳細瞭解管理模型、理想工作負載和成本結構的差異。

除了 Spark 和 Hadoop,還能使用其他工具嗎?

是,Dataproc 是整合式平台,適用於現代開放原始碼資料堆疊。Dataproc 支援超過 30 個元件,讓您在單一代管服務下,執行專用叢集來使用串流處理工具 (如 Flink) 或互動式 SQL 工具 (如 Trino)。

我對叢集環境的掌控程度為何?

您擁有高度掌控權。Dataproc 可讓您自訂機型、磁碟大小和網路設定。您也可以使用初始化動作安裝自訂軟體、自備容器映像檔,並運用 Spot VM 降低成本。