Dataproc

Apache Spark e Hadoop gerenciados com o Google Dataproc

Execute suas cargas de trabalho mais exigentes do Spark e de código aberto de maneira mais fácil com um serviço gerenciado, mais inteligente com o Gemini e mais rápida com o Lightning Engine.

Apache Spark é uma marca registrada da Apache Software Foundation.

Recursos

Desempenho líder do setor

Acelere seus jobs do Spark mais exigentes com o Lightning Engine. Nosso mecanismo de última geração oferece um desempenho 4,3 vezes mais rápido com otimização gerenciada, reduzindo o TCO e o ajuste manual. Disponível agora em pré-lançamento para o Dataproc.

Desenvolvimento e operações com tecnologia de IA

Acelere todo seu fluxo de trabalho com o Gemini. Receba assistência com tecnologia de IA para escrever e depurar códigos PySpark e use o Gemini Cloud Assist para ter análises automatizadas de causa raiz para jobs com falha ou lentos, reduzindo drasticamente o tempo de solução de problemas\

Pronto para IA/ML empresarial

Crie e operacionalize todo o seu ciclo de vida de machine learning. Acelere o treinamento e a inferência de modelos com suporte a GPU, tecnologia NVIDIA RAPIDS™ e ML Runtimes pré-configurados. Em seguida, integre-se ao ecossistema de IA do Google Cloud para orquestrar MLOps de ponta a ponta com o Vertex AI Pipelines.

Integrações avançadas de lakehouse

Conecte-se de maneira nativa a uma arquitetura de data lakehouse aberto. Processe dados diretamente do BigQuery, organize o MLOps com o Vertex AI Pipelines e unifique a governança dos seus dados abertos com o BigLake e o Catálogo universal do Dataplex.

Controle e personalização incomparáveis

Adapte cada cluster do Dataproc às suas necessidades exatas. Desenvolva em Python, Scala ou Java, escolha entre uma ampla variedade de tipos de máquinas, use ações de inicialização para instalar software personalizado e traga suas próprias imagens de contêiner para máxima portabilidade.

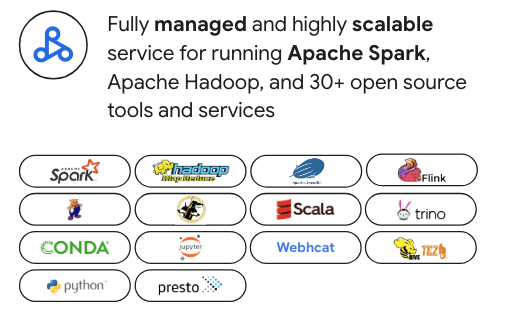

Criado para a pilha de dados de código aberto moderna

Sem dependência de fornecedores. Embora o Dataproc seja otimizado para o Apache Spark, ele oferece suporte a mais de 30 ferramentas de código aberto, como Apache Hadoop, Flink, Trino e Presto. Ele se integra perfeitamente a orquestradores conhecidos, como o Airflow, e pode ser estendido com o Kubernetes e o Docker para máxima flexibilidade.

Segurança de nível empresarial

Integração perfeita com sua postura de segurança. Use o IAM para permissões granulares, o VPC Service Controls para segurança de rede e o Kerberos para autenticação forte no seu cluster do Spark.

Usos comuns

Migração para a nuvem

Faça lift-and-shift de cargas de trabalho do Apache Hadoop e do Spark no local com facilidade. Ele também é o caminho ideal para migrar de um "Spark faça você mesmo" autogerenciado para um serviço totalmente gerenciado. O suporte do Dataproc a uma ampla variedade de versões do Spark, incluindo a versão legada 2.x, simplifica a migração ao reduzir a necessidade de refatoração imediata do código. Isso permite que você aproveite as habilidades de código aberto da sua equipe para uma migração mais rápida para a nuvem.

Recursos de aprendizagem

Migração para a nuvem

Faça lift-and-shift de cargas de trabalho do Apache Hadoop e do Spark no local com facilidade. Ele também é o caminho ideal para migrar de um "Spark faça você mesmo" autogerenciado para um serviço totalmente gerenciado. O suporte do Dataproc a uma ampla variedade de versões do Spark, incluindo a versão legada 2.x, simplifica a migração ao reduzir a necessidade de refatoração imediata do código. Isso permite que você aproveite as habilidades de código aberto da sua equipe para uma migração mais rápida para a nuvem.

Modernização do lakehouse

Use o Dataproc como o mecanismo de processamento de código aberto e poderoso para seu data lakehouse moderno. Processe dados em formatos abertos como o Apache Iceberg diretamente do seu data lake, eliminando silos de dados e movimentação de dados cara. Integre-se perfeitamente ao BigQuery e ao Catálogo universal do Dataplex para ter uma plataforma de governança e análise multimecanismo verdadeiramente unificada.

Recursos de aprendizagem

Modernização do lakehouse

Use o Dataproc como o mecanismo de processamento de código aberto e poderoso para seu data lakehouse moderno. Processe dados em formatos abertos como o Apache Iceberg diretamente do seu data lake, eliminando silos de dados e movimentação de dados cara. Integre-se perfeitamente ao BigQuery e ao Catálogo universal do Dataplex para ter uma plataforma de governança e análise multimecanismo verdadeiramente unificada.

Engenharia de dados

Crie e orquestre pipelines ETL do Spark complexos e de longa duração com confiabilidade e escala de nível empresarial. Aproveite recursos avançados como o escalonamento automático para otimizar o custo e a performance e use modelos de fluxo de trabalho para automatizar e gerenciar seus jobs mais críticos e de nível de produção de ponta a ponta.

Recursos de aprendizagem

Engenharia de dados

Crie e orquestre pipelines ETL do Spark complexos e de longa duração com confiabilidade e escala de nível empresarial. Aproveite recursos avançados como o escalonamento automático para otimizar o custo e a performance e use modelos de fluxo de trabalho para automatizar e gerenciar seus jobs mais críticos e de nível de produção de ponta a ponta.

Ciência de dados em grande escala

Ofereça às equipes de ciência de dados ambientes de cluster do Spark poderosos e personalizáveis para treinamento de modelos em grande escala e inferência em lote. Com os ambientes de execução de ML pré-configurados e o suporte a GPU, você acelera todo o ciclo de vida de ML e se integra à Vertex AI para criar e operacionalizar pipelines de MLOps de ponta a ponta.

Recursos de aprendizagem

Ciência de dados em grande escala

Ofereça às equipes de ciência de dados ambientes de cluster do Spark poderosos e personalizáveis para treinamento de modelos em grande escala e inferência em lote. Com os ambientes de execução de ML pré-configurados e o suporte a GPU, você acelera todo o ciclo de vida de ML e se integra à Vertex AI para criar e operacionalizar pipelines de MLOps de ponta a ponta.

Mecanismos de análise de OSS flexíveis

Vá além do Spark e do Hadoop sem adicionar sobrecarga operacional. Implante clusters dedicados com o Trino para SQL interativo, o Flink para processamento de streaming avançado ou outros mecanismos especializados de código aberto. O Dataproc fornece um plano de controle unificado para gerenciar esse ecossistema diversificado com a simplicidade de um serviço gerenciado.

Recursos de aprendizagem

Mecanismos de análise de OSS flexíveis

Vá além do Spark e do Hadoop sem adicionar sobrecarga operacional. Implante clusters dedicados com o Trino para SQL interativo, o Flink para processamento de streaming avançado ou outros mecanismos especializados de código aberto. O Dataproc fornece um plano de controle unificado para gerenciar esse ecossistema diversificado com a simplicidade de um serviço gerenciado.

Preços

| Clusters gerenciados do Dataproc | O Dataproc oferece preços de pagamento por uso. Otimize custos com escalonamento automático e VMs preemptivas. |

|---|---|

Principais componentes |

|

Exemplo | Um cluster com 6 nós (1 principal + 5 workers) de 4 CPUs, cada um executado por 2 horas, custaria US$ 0,48. Cobrança do Dataproc = Nº de vCPUs * horas * preço do Dataproc = 24 * 2 * US$ 0,01 = US $0,48 |

Clusters gerenciados do Dataproc

O Dataproc oferece preços de pagamento por uso. Otimize custos com escalonamento automático e VMs preemptivas.

Principais componentes

- Instâncias do Compute Engine (vCPU, memória)

- Taxa de serviço do Dataproc (por vCPU-hora)

- Discos permanentes

Exemplo

Um cluster com 6 nós (1 principal + 5 workers) de 4 CPUs, cada um executado por 2 horas, custaria US$ 0,48. Cobrança do Dataproc = Nº de vCPUs * horas * preço do Dataproc = 24 * 2 * US$ 0,01 = US $0,48

Caso de negócios

Crie seu caso de negócios para o Google Dataproc

Os benefícios econômicos do Google Cloud Dataproc e do Serverless Spark em comparação com soluções alternativas

Saiba como o Dataproc oferece economias significativas de TCO e valor comercial em comparação com soluções no local e outras soluções de nuvem.

Conteúdo relacionado

No relatório:

Descubra como o Dataproc e o Serverless para Apache Spark podem proporcionar uma economia de 18% a 60% em comparação com outras alternativas do Spark baseadas na nuvem.

Descubra como o Google Cloud Serverless para Apache Spark pode oferecer uma relação preço-performance de 21% a 55% melhor do que outras ofertas de Spark sem servidor.

Saiba como o Dataproc e o Google Cloud Serverless para Apache Spark simplificam as implantações do Spark e ajudam a reduzir a complexidade operacional.

Perguntas frequentes

Quando devo escolher o Dataproc em vez do Google Cloud Serverless para Apache Spark?

Escolha o Dataproc quando precisar de controle detalhado sobre o ambiente do cluster, estiver migrando cargas de trabalho do Hadoop/Spark ou precisar de um cluster persistente com um conjunto diversificado de ferramentas de código aberto. Para uma análise detalhada das diferenças nos modelos de gerenciamento, cargas de trabalho ideais e estruturas de custos.

Posso usar mais do que apenas o Spark e o Hadoop?

Sim. O Dataproc é uma plataforma unificada para a pilha de dados moderna de código aberto. Ele oferece suporte a mais de 30 componentes, permitindo que você execute clusters dedicados para ferramentas como Flink para processamento de stream ou Trino para SQL interativo, tudo em um único serviço gerenciado.

Quanto controle eu tenho sobre o ambiente do cluster?

Você tem um alto grau de controle. O Dataproc permite personalizar tipos de máquinas, tamanhos de disco e configurações de rede. Você também pode usar ações de inicialização para instalar software personalizado, trazer suas próprias imagens de contêiner e aproveitar as VMs spot para otimizar os custos.