Esta página descreve como preparar os arquivos Avro que você exportou do em bancos de dados que não são do Spanner e importar esses arquivos para o Spanner. Se você quiser importar um banco de dados do Spanner que já foi exportado, consulte Importar arquivos Avro do Spanner.

O processo usa o Dataflow. Ele importa dados de um bucket do Cloud Storage que contém um conjunto de arquivos Avro e um arquivo de manifesto JSON que especifica as tabelas de destino e os arquivos Avro que preenchem cada tabela.

Antes de começar

Para importar um banco de dados do Spanner, primeiro ative as APIs Spanner, Cloud Storage, Compute Engine e Dataflow:

É preciso também ter cota suficiente e as permissões obrigatórias do IAM.

Requisitos de cota

Os requisitos de cota para jobs de importação são os seguintes:

- Spanner: é preciso ter capacidade de computação suficiente para aceitar a quantidade de dados que você está importando. Nenhuma capacidade de computação extra é necessária para importar um banco de dados, mas talvez seja necessário adicionar mais capacidade de computação para que o job seja concluído em um período razoável. Consulte Otimizar jobs para mais detalhes.

- Cloud Storage: para importar, é preciso ter um bucket contendo os arquivos exportados anteriormente. Não é necessário definir um tamanho para o bucket.

- Dataflow: os jobs de importação estão sujeitos às mesmas cotas do Compute Engine para endereço IP, uso da CPU e do disco aplicadas a outros jobs do Dataflow.

Compute Engine: antes de executar um job de importação, é necessário configurar cotas iniciais para o Compute Engine, que serão usadas pelo Dataflow. Essas cotas representam o número máximo de recursos que você permite que o Dataflow use para seu job. Os valores iniciais recomendados são:

- CPUs: 200

- Endereços IP em uso: 200

- Disco permanente padrão: 50 TB

Geralmente, não é necessário fazer nenhum outro ajuste. O Dataflow fornece escalonamento automático para que você pague apenas pelos recursos efetivamente utilizados durante a importação. Se seu job puder usar mais recursos, a IU do Dataflow exibirá um ícone de aviso. O job será concluído, mesmo que um ícone de aviso seja exibido.

Funções exigidas

Para ter as permissões necessárias para exportar um banco de dados, peça ao administrador para conceder a você os seguintes papéis do IAM na conta de serviço do worker do Dataflow:

-

Leitor do Cloud Spanner (

roles/spanner.viewer) -

Worker do Dataflow (

roles/dataflow.worker) -

Administrador de armazenamento (

roles/storage.admin) -

Leitor de banco de dados do Spanner (

roles/spanner.databaseReader) -

Administrador de banco de dados (

roles/spanner.databaseAdmin)

Exportar dados de um banco de dados que não seja do Spanner para arquivos Avro

O processo de importação traz dados de arquivos Avro localizados em um bucket do Cloud Storage. É possível exportar dados no formato Avro de qualquer fonte e usar qualquer método disponível para fazer isso.

Para exportar dados de um banco de dados que não seja do Spanner para arquivos Avro, siga estas etapas: estas etapas:

Tenha isto em mente ao exportar seus dados:

- É possível exportar usando qualquer um dos tipos primitivos do Avro, bem como o tipo complexo de matriz.

Cada coluna nos seus arquivos Avro precisa usar um dos seguintes tipos de colunas:

ARRAYBOOLBYTES*DOUBLEFLOATINTLONG†STRING‡

* Uma coluna do tipo

BYTESé usada para importar um SpannerNUMERIC; ver a seção de mapeamentos recomendados a seguir para mais detalhes.†,‡ Você pode importar um

LONGarmazenando um carimbo de data/hora ou umSTRINGarmazenando um carimbo de data/hora comoTIMESTAMPdo Spanner. consulte o seguinte mapeamentos recomendados para mais detalhes.Não é necessário incluir ou gerar metadados ao exportar os arquivos Avro.

Não é necessário seguir nenhuma convenção de nomenclatura específica para seus arquivos.

Se você não exportar seus arquivos diretamente para o Cloud Storage, é necessário fazer o upload dos arquivos Avro para um bucket do Cloud Storage. Para obter Para instruções, consulte Fazer upload de objetos para o Cloud Storage.

Importar arquivos Avro de bancos de dados que não são do Spanner para o Spanner

Para importar arquivos Avro de um banco de dados que não seja do Spanner para o Spanner, faça o seguinte: siga estas etapas:

- Crie tabelas de destino e defina o esquema para seu banco de dados do Spanner.

- Crie um arquivo

spanner-export.jsonno bucket do Cloud Storage. - Execute um job de importação do Dataflow usando a CLI gcloud.

Etapa 1: criar o esquema do banco de dados do Spanner

Antes de executar a importação, é necessário criar a tabela de destino no Spanner e definir o esquema dele.

É necessário criar um esquema que use o tipo de coluna apropriado para cada coluna nos arquivos Avro.

Mapeamentos recomendados

GoogleSQL

| Tipo de coluna Avro | Tipo de coluna Spanner |

|---|---|

ARRAY |

ARRAY |

BOOL |

BOOL |

BYTES |

|

DOUBLE |

FLOAT64 |

FLOAT |

FLOAT64 |

INT |

INT64 |

LONG |

|

STRING |

|

PostgreSQL

| Tipo de coluna Avro | Tipo de coluna Spanner |

|---|---|

ARRAY |

ARRAY |

BOOL |

BOOLEAN |

BYTES |

|

DOUBLE |

DOUBLE PRECISION |

FLOAT |

DOUBLE PRECISION |

INT |

BIGINT |

LONG |

|

STRING |

|

Etapa 2: criar um arquivo spanner-export.json

Também é possível criar um arquivo chamado spanner-export.json no bucket do Cloud Storage. Esse arquivo especifica o dialeto do banco de dados e

contém uma matriz tables que lista

o nome e a localização dos arquivos de dados de cada tabela.

Os conteúdos do arquivo têm o seguinte formato:

{

"tables": [

{

"name": "TABLE1",

"dataFiles": [

"RELATIVE/PATH/TO/TABLE1_FILE1",

"RELATIVE/PATH/TO/TABLE1_FILE2"

]

},

{

"name": "TABLE2",

"dataFiles": ["RELATIVE/PATH/TO/TABLE2_FILE1"]

}

],

"dialect":"DATABASE_DIALECT"

}

Em que DATABASE_DIALECT = {GOOGLE_STANDARD_SQL | POSTGRESQL}

Se o elemento de dialeto for omitido, o padrão será GOOGLE_STANDARD_SQL.

Etapa 3: executar um job de importação do Dataflow usando a CLI gcloud

Para iniciar o job de importação, siga as instruções de uso da Google Cloud CLI para executar um job com o modelo Avro para Spanner.

Depois de iniciar um job de importação, é possível ver detalhes sobre ele no no console do Google Cloud.

Após a conclusão do job de importação, adicione as chaves estrangeiras e os índices secundários necessários.

Escolha uma região para o job de importação

Convém escolher uma região diferente com base no local do seu bucket do Cloud Storage. Para evitar taxas de transferência de dados de saída, escolha uma região que corresponde ao local do bucket do Cloud Storage.

Se o local do bucket do Cloud Storage for uma região, podem aproveitar o uso gratuito da rede escolhendo o mesma região para o job de importação, supondo que essa região esteja disponível.

Se o local do bucket do Cloud Storage for birregional, você pode aproveitar o uso gratuito da rede escolhendo uma das duas regiões que compõem a região birregional do job de importação; supondo que uma das regiões esteja disponível.

Se uma região colocalizada não estiver disponível para seu job de importação ou se seu O local do bucket do Cloud Storage é um local multirregional, tarifas de transferência de dados de saída se aplicam. Consulte o Cloud Storage os preços de transferência de dados para escolher uma região que incorre no menores cobranças de transferência de dados.

Visualizar ou solucionar problemas de jobs na IU do Dataflow

Depois de iniciar um job de importação, é possível visualizar detalhes do job, incluindo: registros, na seção "Dataflow" do console do Google Cloud.

Conferir os detalhes do job do Dataflow

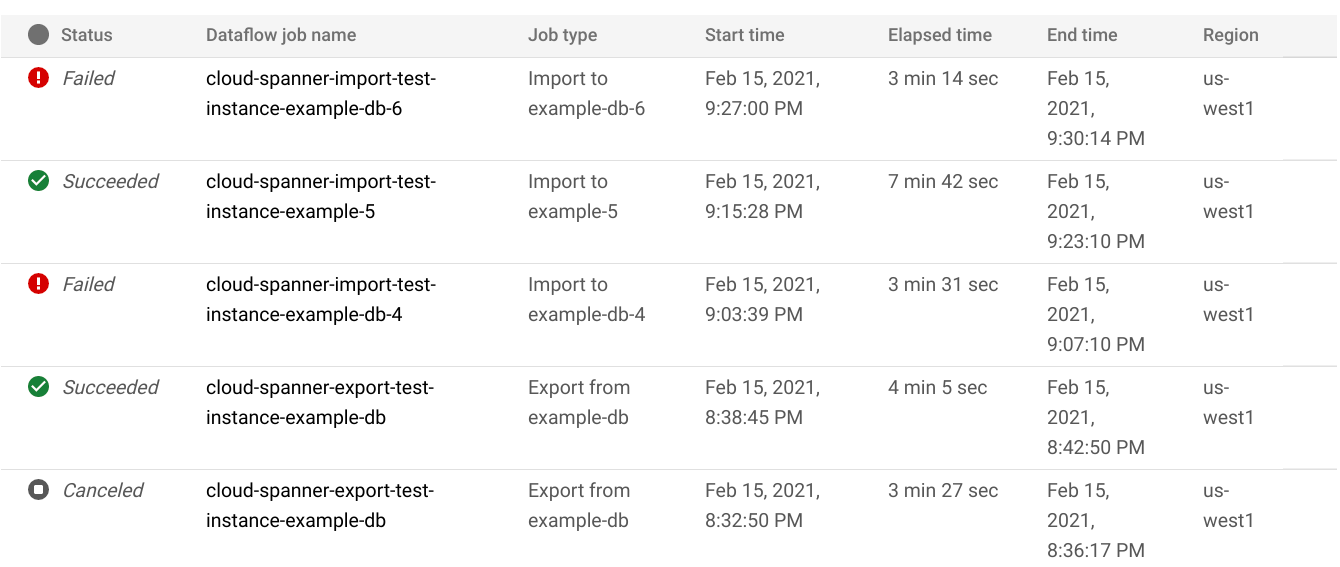

Para ver os detalhes de qualquer job de importação/exportação executado na última semana, incluindo os jobs em execução no momento:

- Navegue até a página Detalhes do banco de dados.

- Clique no item de menu do painel esquerdo Importar/Exportar. A página Importar/Exportar do banco de dados exibe uma lista de jobs recentes.

Na página Importar/Exportar do banco de dados, clique no nome do job na coluna Nome do job do Dataflow:

O console do Google Cloud mostra detalhes do job do Dataflow.

Para visualizar um job executado há mais de uma semana, siga estas etapas:

Acesse a página de jobs do Dataflow no console do Google Cloud.

Encontre seu job na lista e clique no nome dele.

O console do Google Cloud exibe detalhes da API Dataflow trabalho.

Conferir os registros do Dataflow para seu job

Para visualizar os registros de um job do Dataflow, navegue até a página de detalhes do job, conforme descrito acima. Em seguida, clique em Registros, à direita do nome do job.

Se um job falhar, procure erros nos registros. Se houver erros, a contagem de erros será exibida ao lado de Registros:

Para ver os erros do job, siga estas etapas:

Clique na contagem de erros, ao lado de Registros.

O console do Google Cloud exibe os registros do job. Pode ser necessário rolar para visualizar os erros.

Localize entradas com o ícone de erro

.

.Clique em uma entrada de registro individual para expandir seu conteúdo.

Para mais informações sobre como solucionar problemas de jobs do Dataflow, consulte Solucionar problemas do pipeline.

Resolver problemas de jobs de importação

Se você vir os seguintes erros nos registros do job:

com.google.cloud.spanner.SpannerException: NOT_FOUND: Session not found --or-- com.google.cloud.spanner.SpannerException: DEADLINE_EXCEEDED: Deadline expired before operation could complete.

Consulte a 99% de latência de gravação no guia Monitoramento do banco de dados do Spanner, console do Google Cloud. Se estiver exibindo valores altos (vários segundos), isso indicará que a instância está sobrecarregada, fazendo com que as gravações expirem e falhem.

Uma causa da alta latência é que o job do Dataflow está sendo executado usando muitos workers, colocando muita carga na instância do Spanner.

Para especificar um limite para o número de workers do Dataflow, em vez de usar o método Guia "Importar/Exportar" na página de detalhes da instância do Spanner no console do Google Cloud, inicie o usando o Dataflow Modelo do Cloud Storage Avro para Cloud Spanner e especificar o número máximo de workers, conforme descrito abaixo:Se você estiver usando o console do Dataflow, o parâmetro Workers máximos estará localizado na seção Parâmetros opcionais da página Criar job a partir do modelo.

Se você estiver usando o gcloud, especifique o argumento

max-workers. Exemplo:gcloud dataflow jobs run my-import-job \ --gcs-location='gs://dataflow-templates/latest/GCS_Avro_to_Cloud_Spanner' \ --region=us-central1 \ --parameters='instanceId=test-instance,databaseId=example-db,inputDir=gs://my-gcs-bucket' \ --max-workers=10

Otimizar jobs de importação de execução lenta

Se as sugestões das configurações iniciais forem seguidas, geralmente não será necessário fazer nenhum outro ajuste. Se o job estiver sendo executado lentamente, é possível tentar outras otimizações:

Otimize o local do job e dos dados: execute o job do Dataflow na mesma região em que a instância do Spanner e do bucket do Cloud Storage estão localizados.

Garanta recursos suficientes do Dataflow: se as cotas relevantes do Compute Engine limitarem os recursos do job do Dataflow, a página do Dataflow referente a esse job no console do Google Cloud vai mostrar um ícone de aviso

e mensagens de registro:

e mensagens de registro:

Nessa situação, é possível reduzir o ambiente de execução do job aumentando as cotas (em inglês) para CPUs, endereços IP em uso e disco permanente padrão. Porém, isso pode resultar em mais cobranças do Compute Engine.

Verifique a utilização da CPU do Spanner: se você perceber que a utilização da CPU para a instância é superior a 65%, é possível aumentar a capacidade de computação nessa instância. A capacidade aumenta Os recursos do Spanner e o job devem acelerar, mas você incorre em mais Cobranças do Spanner.

Fatores que afetam o desempenho do job de importação

Vários fatores influenciam o tempo necessário para concluir um job de importação.

Tamanho do banco de dados do Spanner: o processamento de mais dados leva mais tempo e exige mais recursos.

Esquema do banco de dados do Spanner, incluindo:

- O número de tabelas

- o tamanho das linhas;

- O número de índices secundários

- O número de chaves estrangeiras

- O número de fluxo de alterações

Local dos dados: os dados são transferidos entre o Spanner e o Cloud Storage usando o Dataflow. O ideal é que os três componentes estejam localizados na mesma região. Se não estiverem, a movimentação dos dados pelas regiões prejudica a velocidade de execução do job.

Número de workers do Dataflow: o número ideal de workers do Dataflow é necessário para um bom desempenho. Ao usar o escalonamento automático, o Dataflow escolhe o número de workers para o job, dependendo da quantidade de trabalho que precisa ser feita. O número de workers, no entanto, será limitado pelas cotas para CPUs, endereços IP em uso e disco permanente padrão. A IU do Dataflow exibirá um ícone de aviso caso encontre limites de cotas. Nessa situação, o progresso será mais lento, mas ainda assim o job será concluído. O escalonamento automático pode sobrecarregar o Spanner, levando a erros quando há uma uma grande quantidade de dados para importar.

Carga atual no Spanner: um job de importação adiciona carga de CPU significativa em uma instância do Spanner. Se a instância já tiver uma carga atual substancial, a execução do job será mais lenta.

Quantidade da capacidade de computação do Spanner: se a utilização da CPU para a instância for maior que 65%, o job será executado mais lentamente.

Ajustar workers para ter um bom desempenho de importação

Ao iniciar um job de importação do Spanner, os workers do Dataflow precisam ser definidos como um valor ideal para um bom desempenho. Muitos workers sobrecarregam o Spanner, e poucos workers resultam em um desempenho de importação incrível.

O número máximo de workers depende muito do tamanho dos dados. mas o ideal é que o uso total da CPU do Spanner fique entre 70% a 90%. Isso oferece um bom equilíbrio entre o Spanner e o eficiência e conclusão de jobs sem erros.

Para atingir essa meta de utilização na maioria dos esquemas e cenários, recomendamos um número máximo de vCPUs de trabalho entre 4 e 6 vezes o número de nós do Spanner.

Por exemplo, para uma instância do Spanner de 10 nós, usando workers n1-standard-2, defina o máximo de workers como 25, fornecendo 50 vCPUs.