Cette page explique comment exporter des bases de données Spanner à l'aide de la consoleGoogle Cloud .

Pour exporter une base de données Spanner à l'aide de l'API REST ou de la Google Cloud CLI, suivez les étapes de la section Avant de commencer sur cette page, puis consultez les instructions détaillées de Spanner vers Cloud Storage au format Avro dans la documentation Dataflow. Le processus d'exportation utilise Dataflow et écrit les données dans un dossier d'un bucket Cloud Storage. Le dossier résultant contient un ensemble de fichiers Avro et de fichiers manifestes JSON.

Avant de commencer

Pour exporter une base de données Spanner, vous devez d'abord activer les API Spanner, Cloud Storage, Compute Engine et Dataflow :

Roles required to enable APIs

To enable APIs, you need the Service Usage Admin IAM

role (roles/serviceusage.serviceUsageAdmin), which

contains the serviceusage.services.enable permission. Learn how to grant

roles.

Vous devez également disposer d'un quota suffisant, ainsi que des autorisations IAM requises.

Exigences en matière de quota

Voici les exigences de quota concernant les tâches d'exportation :

- Spanner : aucune capacité de calcul supplémentaire n'est requise pour exporter une base de données, mais il peut s'avérer nécessaire d'ajouter de la capacité de calcul pour que la tâche se termine dans un délai raisonnable. Pour en savoir plus, consultez Optimiser les tâches.

- Cloud Storage : pour effectuer des exportations, vous devez créer un bucket pour vos fichiers exportés, si ce n'est pas déjà fait. Vous pouvez créer un bucket dans la console Google Cloud , soit sur la page Cloud Storage, soit lors de la création de votre exportation sur la page Spanner. Il n'est pas nécessaire de spécifier une taille pour ce bucket.

- Dataflow : les tâches d'exportation sont soumises aux mêmes exigences que les autres tâches Dataflow en ce qui concerne les quotas Compute Engine, aussi bien pour l'utilisation de processeurs et d'espace disque que pour le nombre d'adresses IP.

Compute Engine : avant d'exécuter une tâche d'exportation, vous devez définir les quotas initiaux Compute Engine utilisés par Dataflow. Ces quotas représentent le nombre maximal de ressources que vous permettez à Dataflow d'utiliser pour votre tâche. Les valeurs de départ recommandées sont les suivantes :

- Processeurs : 200

- Adresses IP en cours d'utilisation : 200

- Disque persistant standard : 50 To

En règle générale, vous n'avez pas d'autres réglages à effectuer. Dataflow gère l'autoscaling de sorte que vous n'ayez à payer que pour les ressources effectivement utilisées lors de l'exportation. S'il apparaît que votre tâche pourrait utiliser davantage de ressources, l'interface utilisateur de Dataflow affiche une icône d'avertissement, mais cela n'empêche normalement pas la tâche d'aboutir.

Rôles requis

Pour obtenir les autorisations nécessaires pour exporter une base de données, demandez à votre administrateur de vous accorder les rôles IAM suivants sur le compte de service de l'utilisateur Dataflow :

-

Lecteur Cloud Spanner (

roles/spanner.viewer) -

Nœud de calcul Dataflow (

roles/dataflow.worker) -

Administrateur de l'espace de stockage (

roles/storage.admin) -

Lecteur de bases de données Spanner (

roles/spanner.databaseReader) -

Administrateur de base de données (

roles/spanner.databaseAdmin)

Pour utiliser les ressources de calcul indépendantes de Spanner Data Boost lors d'une exportation, vous avez également besoin de l'autorisation IAM spanner.databases.useDataBoost. Pour en savoir plus, consultez la présentation de Data Boost.

Exporter une base de données

Une fois que vous avez satisfait aux exigences de quota et IAM décrites précédemment, vous pouvez exporter une base de données Spanner existante.

Pour exporter votre base de données Spanner vers un bucket Cloud Storage, procédez comme suit :

Accédez à la page Instances de Spanner.

Cliquez sur le nom de l'instance contenant votre base de données.

Cliquez sur l'élément de menu Importer/Exporter dans le volet de gauche, puis sur le bouton Exporter.

Sous Sélectionner l'emplacement de stockage de votre exportation, cliquez sur Parcourir.

Si vous ne possédez pas déjà de bucket Cloud Storage pour votre exportation :

- Cliquez sur Nouveau bucket

.

. - Saisissez un nom pour ce bucket. Les noms de buckets doivent être uniques dans Cloud Storage.

- Sélectionnez une classe de stockage et un emplacement par défaut, puis cliquez sur Créer.

- Cliquez sur le bucket pour le sélectionner.

Si vous disposez déjà d'un bucket, sélectionnez-le dans la liste initiale ou cliquez sur Rechercher

pour filtrer la liste, puis cliquez sur votre bucket pour le sélectionner.

pour filtrer la liste, puis cliquez sur votre bucket pour le sélectionner.- Cliquez sur Nouveau bucket

Cliquez sur Sélectionner.

Sélectionnez la base de données à exporter dans le menu déroulant Sélectionner une base de données à exporter.

Facultatif : Pour exporter votre base de données à un moment antérieur, cochez la case correspondante, puis saisissez un code temporel.

Sélectionnez une région dans le menu déroulant Choisir une région pour la tâche d'exportation.

Facultatif : Pour chiffrer l'état du pipeline Dataflow avec une clé de chiffrement gérée par le client :

- Cliquez sur Afficher les options de chiffrement.

- Sélectionnez Utiliser une clé de chiffrement gérée par le client (CMEK).

- Sélectionnez votre clé dans la liste déroulante.

Cette option n'affecte pas le chiffrement au niveau du bucket Cloud Storage de destination. Pour activer CMEK pour votre bucket Cloud Storage, consultez Utiliser CMEK avec Cloud Storage.

Facultatif : Pour exporter des données à l'aide de Spanner Data Boost, cochez la case Utiliser Spanner Data Boost. Pour en savoir plus, consultez la présentation de Data Boost.

Cochez la case située sous Confirmer les frais pour accepter la facturation de frais supplémentaires en plus des frais relatifs à vos instances Spanner existantes.

Cliquez sur Exporter.

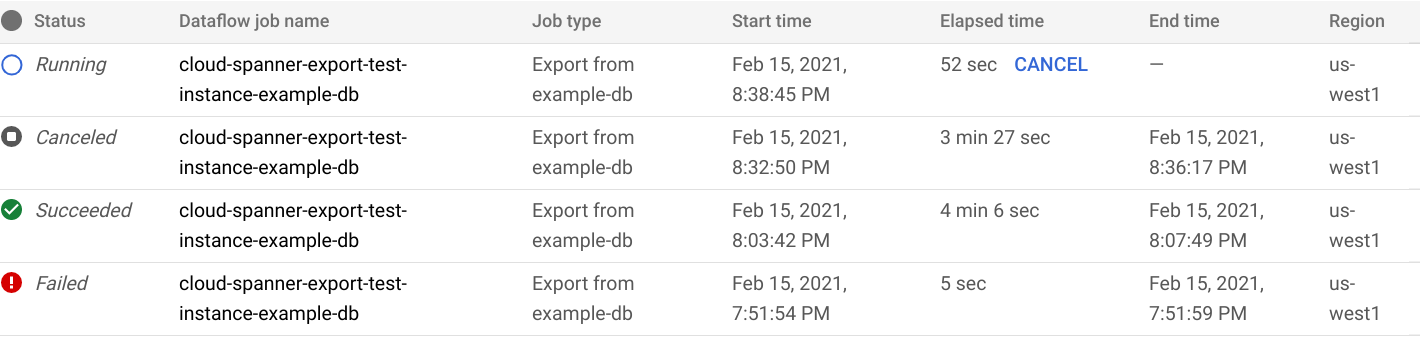

La console Google Cloud affiche la page Importation/Exportation de base de données, qui affiche désormais une ligne de votre tâche d'exportation dans la liste des tâches d'importation/exportation, y compris le temps écoulé :

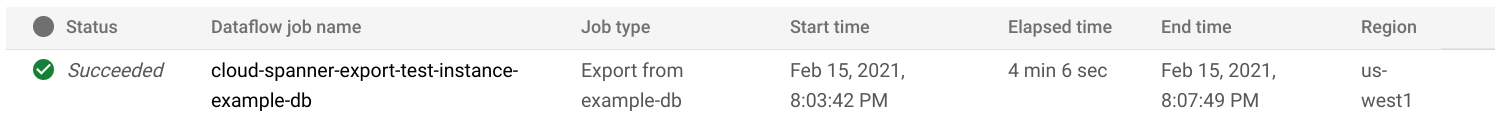

Lorsque la tâche se termine ou est interrompue, l'état est mis à jour dans la liste d'importation/exportation. Si la tâche a abouti, l'état Réussie s'affiche :

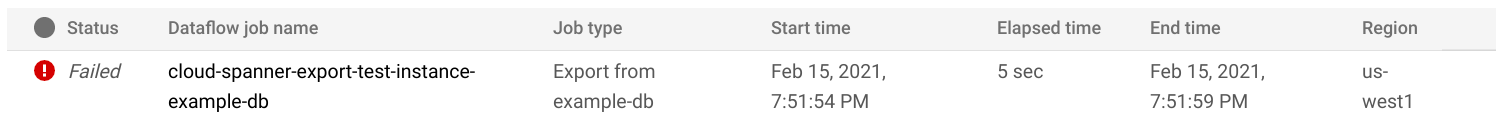

Si la tâche a échoué, l'état Échec s'affiche :

Pour afficher les détails de l'opération Dataflow correspondant à votre tâche, cliquez sur le nom de la tâche dans la colonne Nom de la tâche Dataflow.

En cas d'échec, consultez les journaux Dataflow de cette tâche pour connaître les détails de l'erreur.

Afin d'éviter une facturation Cloud Storage pour les fichiers créés par une tâche d'exportation ayant échoué, supprimez le dossier et ses fichiers. Pour savoir comment trouver le dossier, consultez Afficher votre exportation.

Remarque sur l'exportation des colonnes générées et des flux de modifications

Les valeurs d'une colonne générée ne sont pas exportées. La définition de colonne est exportée vers le schéma Avro en tant que champ d'enregistrement de type null, la définition de colonne comme propriétés personnalisées du champ. Jusqu'à la fin de l'opération de remplissage d'une colonne générée, la colonne générée est ignorée comme si elle n'existait pas dans le schéma.

Les flux de modifications exportés en tant que fichiers Avro ne contiennent que le schéma des flux de modifications, et non les enregistrements de modifications de données.

Remarque sur l'exportation de séquences

Les séquences (GoogleSQL, PostgreSQL) sont des objets de schéma que vous utilisez pour générer des valeurs entières uniques.

Spanner exporte chacun des objets de schéma vers le schéma Avro en tant que champ d'enregistrement, avec son type de séquence, sa plage ignorée et son compteur comme propriétés du champ. Notez que, pour éviter qu'une séquence ne soit réinitialisée et ne génère des valeurs en double après l'importation, la fonction GET_INTERNAL_SEQUENCE_STATE() (GoogleSQL, PostgreSQL) capture le compteur de séquence lors de l'exportation du schéma. Spanner ajoute un tampon de 1 000 au compteur et écrit la nouvelle valeur du compteur dans le champ d'enregistrement. Cette approche permet d'éviter les erreurs de valeurs en double qui peuvent se produire après l'importation.

Si la base de données source reçoit d'autres écritures pendant l'exportation des données, vous devez ajuster le compteur de séquence réel à l'aide de l'instruction ALTER SEQUENCE (GoogleSQL, PostgreSQL).

Lors de l'importation, la séquence commence à partir de ce nouveau compteur au lieu de celui trouvé dans le schéma. Vous pouvez également utiliser l'instruction ALTER SEQUENCE (GoogleSQL, PostgreSQL) pour mettre à jour la séquence avec un nouveau compteur.

Afficher votre exportation dans Cloud Storage

Pour afficher le dossier contenant la base de données exportée dans la consoleGoogle Cloud , accédez au navigateur Cloud Storage et sélectionnez le bucket que vous avez choisi précédemment :

Accéder à la page Navigateur de stockage

Le bucket contient maintenant un dossier dans lequel se trouve la base de données exportée. Le nom du dossier commence par l'ID de votre instance, le nom de la base de données et l'horodatage de la tâche d'exportation. Le dossier contient :

- Un fichier

spanner-export.json. - Un fichier

TableName-manifest.jsonpour chaque table de la base de données que vous avez exportée. Un ou plusieurs fichiers

TableName.avro-#####-of-#####. Le premier nombre figurant dans l'extension.avro-#####-of-#####représente l'index du fichier Avro compté à partir de zéro, tandis que le second correspond au nombre de fichiers Avro générés pour chaque table.Par exemple,

Songs.avro-00001-of-00002est le deuxième des deux fichiers contenant les données de la tableSongs.Un fichier

ChangeStreamName-manifest.jsonpour chaque flux de modifications de la base de données que vous avez exportée.Un fichier

ChangeStreamName.avro-00000-of-00001pour chaque flux de modifications. Ce fichier contient des données vides avec uniquement le schéma Avro du flux de modifications.

Sélectionner une région pour votre tâche d'importation

Vous pouvez être amené à choisir une région différente en fonction de l'emplacement de votre bucket Cloud Storage. Pour éviter les frais de transfert de données sortantes, choisissez une région qui correspond à l'emplacement de votre bucket Cloud Storage.

Si l'emplacement de votre bucket Cloud Storage est une région, vous pouvez bénéficier de l'utilisation gratuite du réseau en choisissant la même région pour votre tâche d'importation, à condition que cette région soit disponible.

Si l'emplacement de votre bucket Cloud Storage est birégional, vous pouvez bénéficier de l'utilisation gratuite du réseau en choisissant l'une des deux régions qui composent l'emplacement birégional pour votre tâche d'importation, à condition que l'une des régions soit disponible.

- Si aucune région colocalisée n'est disponible pour votre tâche d'importation ou si l'emplacement de votre bucket Cloud Storage est multirégional, des frais de transfert de données sortantes s'appliquent. Consultez les tarifs de transfert de données de Cloud Storage pour choisir la région qui générera les frais de transfert de données les plus bas.

Exporter un sous-ensemble de tables

Si vous ne souhaitez exporter que les données de certaines tables et non l'intégralité de la base de données, vous pouvez spécifier ces tables lors de l'exportation. Dans ce cas, Spanner exporte l'intégralité du schéma de la base de données, y compris les données des tables que vous spécifiez, et laisse toutes les autres tables présentes, mais vides, dans le fichier exporté.

Vous pouvez spécifier un sous-ensemble de tables à exporter à l'aide de la page Dataflow de la console Google Cloud ou de la CLI gcloud. (La page Spanner ne propose pas cette action.)

Si vous exportez les données d'une table enfant d'une autre table, vous devez également exporter les données de sa table parent. Si les parents ne sont pas exportés, la tâche d'exportation échoue.

Pour exporter un sous-ensemble de tables, lancez l'exportation à l'aide du modèle Spanner vers Cloud Storage Avro de Dataflow, puis spécifiez les tables à l'aide de la page Dataflow dans la console Google Cloud ou de la CLI gcloud, comme décrit ci-dessous :

Console

Si vous utilisez la page Dataflow dans la console Google Cloud , le paramètre Nom(s) de la table Cloud Spanner se trouve dans la section Paramètres facultatifs de la page Créer une tâche à partir d'un modèle. Plusieurs tables peuvent être spécifiées dans un format séparé par des virgules.

gcloud

Exécutez la commande gcloud dataflow jobs run et spécifiez l'argument tableNames. Exemple :

gcloud dataflow jobs run my-export-job \

--gcs-location='gs://dataflow-templates/latest/Cloud_Spanner_to_GCS_Avro' \

--region=us-central1 \

--parameters='instanceId=test-instance,databaseId=example-db,tableNames=table1,outputDir=gs://my-gcs-bucket' \

--max-workers=10 \

--network=network-123

Pour spécifier plusieurs tables dans gcloud, vous devez échapper les arguments de type dictionnaire.

L'exemple suivant utilise "|" comme caractère d'échappement :

gcloud dataflow jobs run my-export-job \

--gcs-location='gs://dataflow-templates/latest/Cloud_Spanner_to_GCS_Avro' \

--region=us-central1 \

--parameters='^|^instanceId=test-instance|databaseId=example-db|tableNames=table1,table2|outputDir=gs://my-gcs-bucket' \

--max-workers=10 \

--network=network-123

Le paramètre shouldExportRelatedTables est une option pratique pour exporter automatiquement toutes les tables parentes des tables choisies. Par exemple, dans cette hiérarchie de schéma avec les tables Singers, Albums et Songs, il vous suffit de spécifier Songs. L'option shouldExportRelatedTables exportera également Singers et Albums, car Songs est un descendant des deux.

gcloud dataflow jobs run my-export-job \

--gcs-location='gs://dataflow-templates/latest/Cloud_Spanner_to_GCS_Avro' \

--region=us-central1 \

--parameters='instanceId=test-instance,databaseId=example-db,tableNames=Songs,shouldExportRelatedTables=true,outputDir=gs://my-gcs-bucket' \

--max-workers=10 \

--network=network-123

Afficher ou dépanner des tâches dans l'interface utilisateur de Dataflow

Après avoir démarré une tâche d'exportation, vous pouvez en afficher les détails, y compris les journaux, dans la section Dataflow de la console Google Cloud .

Afficher les détails d'un job Dataflow

Pour afficher les détails des tâches d'importation ou d'exportation exécutées au cours de la dernière semaine, y compris les tâches en cours d'exécution :

- Accédez à la page Présentation de la base de données correspondant à la base de données.

- Cliquez sur l'élément de menu du volet Importations/Exportations à gauche. La page Importations/Exportations de la base de données affiche la liste des tâches récentes.

Sur la page Importations/Exportations de la base de données, cliquez sur le nom de la tâche dans la colonne Nom de la tâche Dataflow :

La console Google Cloud affiche les détails de la tâche Dataflow.

Pour afficher une tâche que vous avez exécutée il y a plus d'une semaine :

Accédez à la page des jobs Dataflow dans la console Google Cloud .

Recherchez votre tâche dans la liste, puis cliquez sur son nom.

La console Google Cloud affiche les détails de la tâche Dataflow.

Afficher les journaux Dataflow correspondant à votre tâche

Pour afficher les journaux d'une tâche Dataflow, accédez à la page des détails de la tâche, puis cliquez sur Journaux à droite du nom de la tâche.

Si une tâche échoue, recherchez les erreurs dans les journaux. Si des erreurs ont été enregistrées, leur nombre s'affiche à côté du bouton Logs (Journaux) :

Pour afficher les erreurs relatives à une tâche :

Cliquez sur le nombre d'erreurs à côté de Journaux.

La console Google Cloud affiche les journaux de la tâche. Vous devrez éventuellement faire défiler l'affichage pour voir les erreurs.

Repérez les entrées signalées par l'icône d'erreur

.

.Cliquez sur une entrée de journal pour développer son contenu.

Pour en savoir plus sur le dépannage lié aux tâches Dataflow, consultez Résoudre les problèmes liés à votre pipeline.

Résoudre les problèmes liés aux tâches d'exportation ayant échoué

Si les erreurs suivantes s'affichent dans les journaux de vos tâches :

com.google.cloud.spanner.SpannerException: NOT_FOUND: Session not found --or-- com.google.cloud.spanner.SpannerException: DEADLINE_EXCEEDED: Deadline expired before operation could complete.

Dans la consoleGoogle Cloud , vérifiez la latence en lecture de 99 % dans l'onglet Monitoring de Spanner. Si elle affiche des valeurs élevées (plusieurs secondes), cela signifie que l'instance est surchargée, ce qui entraîne l'expiration et l'échec de la lecture.

Cette latence élevée peut s'expliquer notamment par le fait que la tâche Dataflow s'exécute à l'aide d'un trop grand nombre de nœuds de calcul, ce qui surcharge l'instance Spanner.

Pour spécifier une limite de nœuds de calcul Dataflow, au lieu d'utiliser l'onglet "Importer/Exporter" sur la page des détails de l'instance de votre base de données Spanner dans la console Google Cloud , vous devez démarrer l'exportation à l'aide du modèle Spanner vers Cloud Storage Avro Dataflow et spécifier le nombre maximal de nœuds de calcul, comme décrit ci-dessous :Console

Si vous utilisez la console Dataflow, le paramètre Nombre maximal de nœuds de calcul se trouve dans la section Paramètres facultatifs de la page Créer une tâche à partir d'un modèle.

gcloud

Exécutez la commande gcloud dataflow jobs run et spécifiez l'argument max-workers. Exemple :

gcloud dataflow jobs run my-export-job \

--gcs-location='gs://dataflow-templates/latest/Cloud_Spanner_to_GCS_Avro' \

--region=us-central1 \

--parameters='instanceId=test-instance,databaseId=example-db,outputDir=gs://my-gcs-bucket' \

--max-workers=10 \

--network=network-123

Résoudre les problèmes de réseau

L'erreur suivante peut se produire lorsque vous exportez vos bases de données Spanner :

Workflow failed. Causes: Error: Message: Invalid value for field 'resource.properties.networkInterfaces[0].subnetwork': ''. Network interface must specify a subnet if the network resource is in custom subnet mode. HTTP Code: 400

Cette erreur se produit, car Spanner part du principe que vous avez l'intention d'utiliser un réseau VPC en mode automatique nommé default dans le même projet que le job Dataflow. Si vous n'avez pas de réseau VPC par défaut dans le projet, ou si votre réseau VPC est en mode personnalisé, vous devez créer un job Dataflow et spécifier un autre réseau ou sous-réseau.

Optimiser les tâches d'exportation lentes

Si vous avez adopté les paramètres initiaux suggérés plus haut, vous n'avez en principe aucun autre réglage à effectuer. Voici toutefois quelques possibilités d'optimisation supplémentaires à envisager si l'exécution de votre tâche est lente :

Optimisez l'emplacement de la tâche et des données : exécutez la tâche Dataflow dans la même région que celle où se trouvent votre instance Spanner et votre bucket Cloud Storage.

Veillez à ce que les ressources Dataflow soient suffisantes : si les ressources de votre job Dataflow sont limitées par les quotas Compute Engine pertinents, la page Dataflow correspondant à ce job dans la console Google Cloud affiche une icône d'avertissement

ainsi qu'un message de journalisation :

ainsi qu'un message de journalisation :

Dans ce cas, l'augmentation des quotas en termes de processeurs, d'adresses IP en cours d'utilisation et de disques persistants standards peut accélérer l'exécution de votre tâche, mais également augmenter les frais facturés pour Compute Engine.

Vérifiez l'utilisation du processeur associée à Spanner : si vous constatez qu'une instance présente un taux d'utilisation du processeur supérieur à 65 %, vous pouvez augmenter la capacité de calcul pour cette instance. La capacité ajoute davantage de ressources Spanner et la tâche devrait accélérer, mais vous devrez payer plus de frais pour Spanner.

Facteurs qui influent sur les performances des tâches d'exportation

Plusieurs facteurs influent sur le temps nécessaire pour mener à bien une tâche d'exportation.

Taille de la base de données Spanner : le temps de traitement et les ressources requises augmentent avec la quantité de données à traiter.

Le schéma de la base de données Spanner, y compris :

- Nombre de tables

- Taille des lignes

- Nombre d'index secondaires

- Nombre de clés étrangères

- Nombre de flux de modifications

Emplacement des données : les données sont transférées de Spanner à Cloud Storage à l'aide de Dataflow. Dans l'idéal, ces trois composants doivent se trouver dans la même région. Dans le cas contraire, le déplacement des données entre les régions ralentit l'exécution de la tâche.

Nombre de nœuds de calcul Dataflow : les nœuds de calcul Dataflow optimaux sont nécessaires pour de bonnes performances. En utilisant l'autoscaling, Dataflow choisit le nombre de nœuds de calcul pour la tâche en fonction de la quantité de travail à effectuer. Le nombre de nœuds de calcul sera toutefois limité par les quotas en matière de processeurs, d'adresses IP en cours d'utilisation et de disques persistants standards. L'interface utilisateur de Dataflow affiche une icône d'avertissement lorsque des limites de quota sont atteintes. Dans ce cas, la progression est ralentie, mais la tâche doit néanmoins aboutir.

Charge existante sur Spanner : une tâche d'exportation ajoute généralement une faible charge sur une instance Spanner. Si cette instance présentait déjà une charge importante, l'exécution de la tâche est ralentie.

Quantité de capacité de calcul Spanner : si l'instance présente un taux d'utilisation du processeur supérieur à 65 %, l'exécution de la tâche est ralentie.