Puedes usar la función de prueba integrada para detectar errores y evitar regresiones. Para probar tu agente, puedes usar el simulador para interactuar con él y guardar la conversación como caso de prueba.

Cuando guardas un caso de prueba, las coincidencias de intents, las acciones de la guía, los flujos activados y las páginas activadas que se produjeron durante la conversación se guardan como expectativas del caso de prueba. Cuando ejecutes el caso de prueba más adelante, después de realizar actualizaciones en tu agente, se verificarán estas expectativas. También puedes editar estas expectativas cuando creas o editas casos de prueba.

Crea un caso de prueba

Para crear un caso de prueba con el simulador, sigue estos pasos:

- Abre el simulador.

- Conversa con el agente.

- Haz clic en el botón Crear caso de prueba sobre el simulador.

- Se abrirá el panel del editor de casos de prueba. Proporciona el nombre visible del caso de prueba y edita cualquiera de las expectativas como desees.

- Haz clic en el botón Save test case sobre el simulador.

Ejecuta casos de prueba

Para ejecutar un solo caso de prueba, haz lo siguiente:

- Haz clic en Casos de prueba en el panel de navegación izquierdo.

- Selecciona el caso de prueba que quieres ejecutar.

- Haz clic en el botón Ejecutar.

- Se muestran los resultados del historial de casos de prueba.

Para ejecutar varios casos de prueba, haz lo siguiente:

- Haz clic en Casos de prueba en el panel de navegación izquierdo.

- Seleccionaste los casos de prueba que deseas ejecutar con las casillas de verificación de la izquierda.

- Haz clic en Ejecutar seleccionados.

- Se muestran los resultados de la ejecución de prueba más reciente para cada caso de prueba.

Cómo editar un caso de prueba

Cuando editas un caso de prueba, no puedes editar el mensaje del usuario final ni la respuesta del agente, pero puedes cambiar lo siguiente:

- Agrega expectativas

- Cómo borrar expectativas

- Actualiza las expectativas

Para editar un caso de prueba, haz lo siguiente:

- Haz clic en Casos de prueba en el panel de navegación izquierdo.

- Selecciona el caso de prueba que quieres editar.

- Haz clic en el botón Editar que se encuentra sobre el resumen del caso de prueba.

- Puedes expandir la sección Expectativas a nivel de la conversación para editar las expectativas que se aplican a toda la conversación.

- Cada turno de conversación muestra el mensaje del usuario final, la respuesta del agente y las expectativas para el turno. No puedes editar los mensajes, pero sí puedes editar las expectativas a nivel de la vuelta.

Borrar casos de prueba

Para borrar casos de prueba, haz lo siguiente:

- Haz clic en Casos de prueba en el panel de navegación izquierdo.

- Seleccionaste los casos de prueba que quieres borrar con las casillas de verificación de la izquierda.

- Haz clic en Borrar casos de prueba seleccionados.

Expectativas

Cuando proporcionas expectativas para un caso de prueba, puedes proporcionar expectativas a nivel de la conversación o expectativas a nivel de la toma de turno.

Las expectativas a nivel de la conversación se aplican a toda la conversación, y puedes proporcionar los siguientes tipos de expectativas:

- Uso de herramientas

- Invocación de flujo

- Invocación de la guía

Las expectativas a nivel de la vuelta solo se aplican a una vuelta de conversación específica, y puedes proporcionar los siguientes tipos de expectativas:

- Respuesta del agente

- Flujo actual

- Intención actual

- Página actual

- Uso de herramientas

- Invocación de flujo

- Invocación de la guía

Casos de prueba heredados

Puedes usar la función de prueba integrada para detectar errores y evitar regresiones. A fin de probar tu agente, crea casos de prueba con el simulador para definir conversaciones golden y, luego, ejecuta casos de prueba según sea necesario. Una ejecución de prueba verifica que las respuestas de los agentes no hayan cambiado para las entradas de usuario final definidas en el caso de prueba.

En las instrucciones que aparecen a continuación, se muestra cómo usar la consola, pero también puedes encontrar la misma funcionalidad en la API.

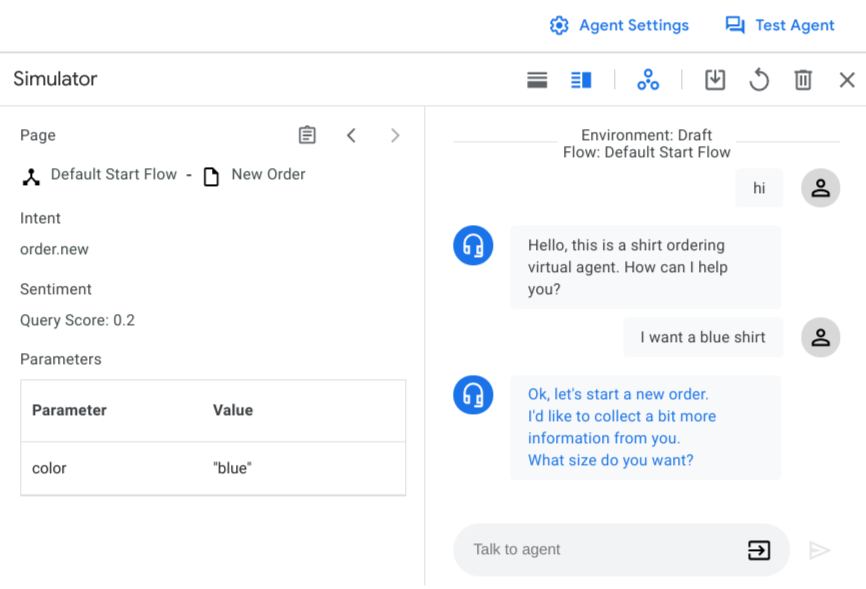

Configuración del simulador

Cuando abres el simulador por primera vez, debes seleccionar un entorno de agente o versiones de flujo y un flujo activo. En la mayoría de los casos, debes usar el entorno borrador y el flujo de inicio predeterminado.

También puedes habilitar o inhabilitar las llamadas de webhook en cualquier momento con el botón de activación de webhook. Inhabilitar los webhooks es útil cuando se definen casos de prueba.

Entrada del simulador

Cuando interactúas con el simulador, proporcionas una entrada de usuario final como texto y, luego, presionas Intro o haces clic en el botón Enviar . Además del texto sin formato, puedes elegir tipos de entrada alternativos con el selector de entrada:

- Parámetro: Inyecta un valor de parámetro. Puedes proporcionar parámetros nuevos o proporcionar valores predeterminados para los parámetros existentes.

- Evento: Invoca un evento.

- DTMF: Envía entradas con señalización multifrecuencia de dos tonos (marcación por tonos) para las interacciones telefónicas.

Crea un caso de prueba

Para crear una conversación, sigue estos pasos:

- Abre la consola de Dialogflow CX.

- Elige tu proyecto.

- Selecciona el agente.

- Haz clic en Test agent para abrir el simulador.

- Chatea con el agente para crear una conversación que abarque la funcionalidad que deseas probar. Para cada turno, verifica los valores correctos del intent activado, la respuesta del agente, la página activa y los parámetros de sesión.

Para guardar una conversación como caso de prueba, sigue estos pasos:

- Haz clic en el botón para guardar.

- Ingresa un nombre visible para el caso de prueba. Cada caso de prueba debe tener un nombre visible único.

- De manera opcional, proporciona un nombre de etiqueta. Las etiquetas te ayudan a organizar los casos de prueba. Todas las etiquetas deben comenzar con "#".

- De forma opcional, puedes proporcionar una nota que describa el propósito del caso de prueba.

- De manera opcional, selecciona los parámetros de los que deseas realizar un seguimiento en el caso de prueba. Se proporciona una lista de parámetros sugeridos. También puedes ingresar otros parámetros para realizar un seguimiento. Si seleccionas los parámetros de seguimiento, la aserción de parámetros se verifica cuando ejecutas el caso de prueba. Encuentra más detalles sobre la aserción de parámetros en la sección Ejecuta casos de prueba.

- Haz clic en Save para guardar el caso de prueba.

Ejecuta casos de prueba

Para ver todos los casos de prueba de un agente, haz clic en Test Cases en la pestaña Manage. La tabla de casos de prueba muestra el nombre de la prueba, las etiquetas, la hora y el entorno más recientes, y el resultado de la prueba más reciente.

Para ejecutar casos de prueba, haz lo siguiente:

- Selecciona los casos de prueba que desees ejecutar y haz clic en Run. También puedes hacer clic en Run all test cases.

- Selecciona el entorno en el que deseas ejecutar los casos de prueba.

- Las pruebas comienzan a ejecutarse y puedes ver el estado en la lista de tareas en cola. El resultado de la prueba se actualizará cuando se complete.

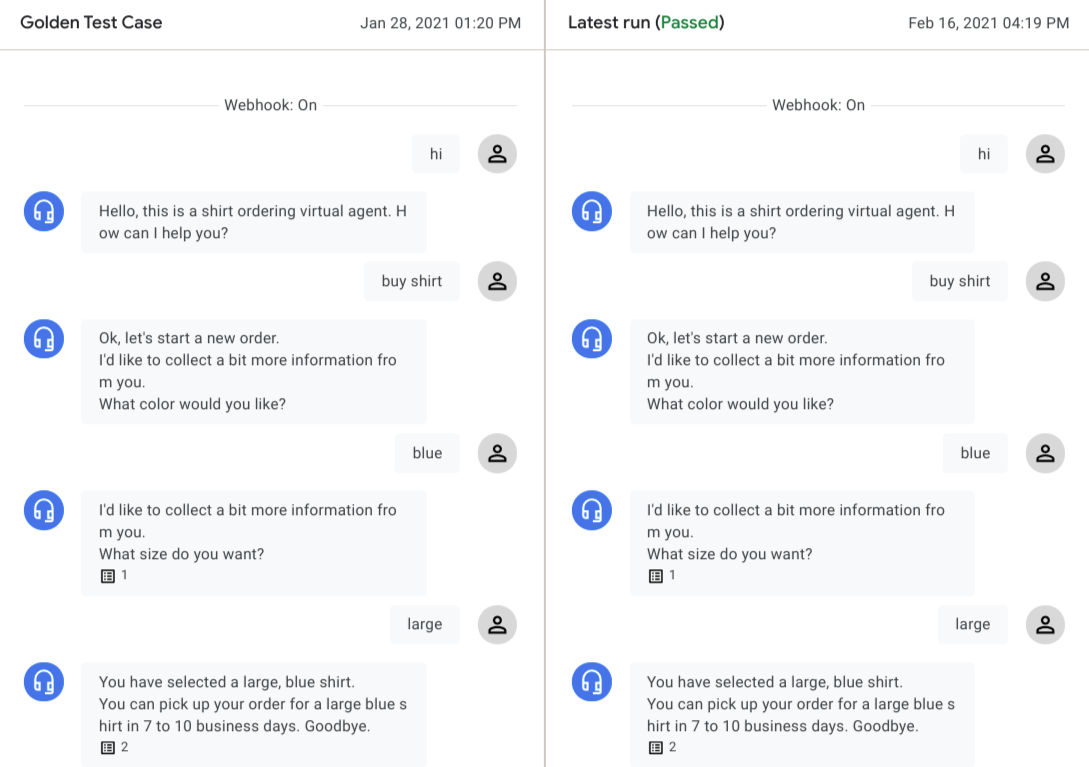

Para ver el resultado de la información de la prueba, haz clic en el caso de prueba. Las conversaciones golden y las conversaciones de ejecución más reciente se muestran en paralelo.

Puedes hacer clic en el turno de conversación de cualquier agente para ver los detalles de ese turno. El motor de prueba verifica los siguientes tipos de datos por turnos para evaluar el resultado de la prueba:

Diálogo del agente:

Para cada turno de la conversación, el diálogo del agente se compara de golden a la última ejecución. Si hay alguna diferencia, se muestra una advertencia. Estas diferencias no evitan que se pase una prueba, ya que el diálogo del agente suele variar para el mismo estado del agente.

Intent coincidente:

A fin de pasar una prueba, el intent coincidente debe ser el mismo para cada turno.

Página actual:

A fin de pasar una prueba, la página activa debe ser la misma para cada turno.

Parámetros de sesión:

Si agregaste parámetros de seguimiento cuando creaste el caso de prueba, el motor de pruebas verificará los parámetros de sesión correspondientes y no pasará a prueba si hay parámetros inesperados o faltantes, o si el valor del parámetro no coincide.

En algunas situaciones, un caso de prueba puede tener una falla esperada debido a un agente actualizado. Si la conversación en la última ejecución refleja los cambios esperados, puedes hacer clic en Save as Gold para reemplazar las conversaciones golden.

Edita casos de prueba

Para editar un caso de prueba, selecciónalo de la tabla Casos de prueba y, luego, haz clic en el ícono de editar junto al nombre del caso de prueba. Aparecerá el cuadro de diálogo Actualizar casos de prueba.

Para editar los metadatos y la configuración del caso de prueba, haz clic en la pestaña Configuración.

Puedes editar los campos Nombre del caso de prueba, Etiquetas y Nota, o agregar nuevos parámetros de seguimiento.

Haz clic en Guardar.

A fin de editar la entrada del usuario para el caso de prueba, haz clic en la pestaña Entrada del usuario.

Agrega, quita o edita las entradas del usuario en formato JSON.

Haz clic en Confirm. Comienza una ejecución de prueba automática y la conversación actualizada se muestra después de que se completa la ejecución de prueba.

Haz clic en Guardar para reemplazar la conversación golden original o haz clic en Guardar como para crear un caso de prueba nuevo con los cambios.

Cómo ver la cobertura de pruebas

Para ver un informe de cobertura de pruebas en todos los casos de pruebas, haz clic en Cobertura.

La página Cobertura incluye las siguientes pestañas:

La cobertura de transiciones se determina para todos los controladores de estado (sin incluir los grupos de ruta) con un objetivo de transición ejercido por el caso de prueba. La página/flujo de origen y la página/flujo de destino de transición se enumeran en la tabla.

La cobertura de los intents se determina para todos los intents que coinciden con el caso de prueba.

La cobertura de los grupos de ruta se determina para todos los grupos de ruta que coincidan con el caso de prueba.

Importa y exporta casos de prueba

Para exportar casos de prueba, haz lo siguiente:

- Selecciona los casos de prueba y haz clic en Export o en Export all test cases.

- Haz clic en Download to local file o proporciona un URI de bucket de Cloud Storage y haz clic en Export to Google Cloud Storage.

Cuando se importan casos de prueba, Agentes conversacionales (Dialogflow CX) siempre crea casos de prueba nuevos para el agente de destino y no reemplaza ningún caso de prueba existente. Para importar casos de prueba, haz lo siguiente:

- Haga clic en Import.

- Elige un archivo local o proporciona una URI de bucket de Cloud Storage.