Das Batch-Quell-Plug-in von Salesforce nutzen, um Leads-Daten in BigQuery zu analysieren

Hier erfahren Sie, wie Sie das Salesforce-Batch-Quell-Plug-in in Cloud Data Fusion verwenden, um Leads-Daten in BigQuery zu analysieren.

Eine detaillierte Anleitung dazu finden Sie direkt in der Google Cloud Console. Klicken Sie dazu einfach auf Anleitung:

Szenario

Stellen Sie sich einen Marketingmanager vor, der eine hochgradig zielgerichtete E-Mail-Marketingkampagne plant, um ein neues Produkt zu bewerben. Sie haben eine Liste mit Leads in Salesforce Sales Cloud. Bevor Sie eine gezielte Kampagne erstellen, möchten Sie die Zielgruppe besser kennenlernen. Dazu verwenden Sie das Salesforce-Batch-Quell-Plug-in in Cloud Data Fusion, um bestimmte Lead-Daten zu extrahieren.

Hinweise

- Sign in to your Google Cloud account. If you're new to Google Cloud, create an account to evaluate how our products perform in real-world scenarios. New customers also get $300 in free credits to run, test, and deploy workloads.

-

In the Google Cloud console, on the project selector page, select or create a Google Cloud project.

Roles required to select or create a project

- Select a project: Selecting a project doesn't require a specific IAM role—you can select any project that you've been granted a role on.

-

Create a project: To create a project, you need the Project Creator

(

roles/resourcemanager.projectCreator), which contains theresourcemanager.projects.createpermission. Learn how to grant roles.

-

Verify that billing is enabled for your Google Cloud project.

-

In the Google Cloud console, on the project selector page, select or create a Google Cloud project.

Roles required to select or create a project

- Select a project: Selecting a project doesn't require a specific IAM role—you can select any project that you've been granted a role on.

-

Create a project: To create a project, you need the Project Creator

(

roles/resourcemanager.projectCreator), which contains theresourcemanager.projects.createpermission. Learn how to grant roles.

-

Verify that billing is enabled for your Google Cloud project.

-

Enable the Cloud Data Fusion, BigQuery, Cloud Storage, and Dataproc APIs.

Roles required to enable APIs

To enable APIs, you need the Service Usage Admin IAM role (

roles/serviceusage.serviceUsageAdmin), which contains theserviceusage.services.enablepermission. Learn how to grant roles. - Erstellen Sie eine Cloud Data Fusion-Instanz.

- Konfigurieren Sie eine Verbindung zur Salesforce API, indem Sie eine verbundene Salesforce-App für Cloud Data Fusion erstellen.

Rufen Sie in der Google Cloud Console die Seite Rollen auf.

Klicken Sie auf Rolle erstellen.

Geben Sie im Feld Titel

Custom Role-Tutorialein.Klicken Sie auf Berechtigungen hinzufügen.

Wählen Sie im Fenster Berechtigungen hinzufügen die folgenden Berechtigungen aus und klicken Sie auf Hinzufügen:

bigquery.datasets.createbigquery.jobs.createstorage.buckets.create

Klicken Sie auf Erstellen.

Rufen Sie die Seite Cloud Data Fusion-Seite Instanzen auf.

Klicken Sie auf den Namen Ihrer Instanz.

Notieren Sie sich das Compute Engine-Standarddienstkonto. Die Seite mit den Instanzdetails enthält diese Informationen.

Der Cloud Data Fusion-standardmäßiges Compute Engine Dienstkonto-Name hat das Format

CUSTOMER_PROJECT_NUMBER-compute@developer.gserviceaccount.com.Rufen Sie die IAM-Seite auf.

Geben Sie in der Filterleiste den Namen Ihres Compute Engine-Standarddienstkontos ein.

Klicken Sie für Ihr Compute Engine-Standarddienstkonto auf Bearbeiten.

Klicken Sie auf Weitere Rolle hinzufügen.

Wählen Sie im Feld Rolle auswählen die Option Anleitung für benutzerdefinierte Rollen aus.

Klicken Sie auf Speichern.

Berechtigungen verwalten

Erstellen Sie die erforderlichen benutzerdefinierten Rollen und Berechtigungen und weisen Sie sie zu.

Benutzerdefinierte Rolle erstellen und Berechtigungen hinzufügen

Dem Compute Engine-Standarddienstkonto eine benutzerdefinierte Rolle zuweisen

Salesforce-Batch-Quell-Plug-in für Cloud Data Fusion konfigurieren

Rufen Sie die Seite Cloud Data Fusion-Seite Instanzen auf.

Klicken Sie für Ihre Instanz auf Instanz anzeigen. Die Weboberfläche von Cloud Data Fusion wird geöffnet.

Rufen Sie die Seite Studio auf.

Klicken Sie auf Hub.

Geben Sie in der Suchleiste

Salesforceein.Klicken Sie auf Salesforce-Plug-ins und dann auf Bereitstellen.

Klicken Sie im Fenster Salesforce-Plug-ins bereitstellen auf Fertigstellen.

Nach Abschluss der Bereitstellung wird ein Dialogfeld mit einer Erfolgsmeldung angezeigt.

Klicken Sie in diesem Dialogfeld auf Pipeline erstellen.

Die Seite „Cloud Data Fusion Studio“ wird angezeigt.

Wählen Sie als Typ der Datenpipeline Datenpipeline – Batch aus.

Klicken Sie im Menü Quelle auf Salesforce.

Wechseln Sie zum Knoten Salesforce und klicken Sie auf Attribute. Daraufhin wird die Seite mit den Attributen des Salesforce-Plug-ins geöffnet.

Geben Sie im Feld Referenzname einen Namen für die Quelle ein. Beispiel:

Leads_generatedKlicken Sie im Bereich Verbindung auf die Ein/Aus-Schaltfläche Verbindung verwenden.

Klicken Sie auf Verbindungen durchsuchen. Das Fenster Verbindungen durchsuchen wird geöffnet.

Klicken Sie auf Verbindung hinzufügen und wählen Sie Salesforce aus.

Klicken Sie im Fenster Salesforce-Verbindung erstellen auf das Tab Konfiguration und gehen Sie so vor:

Geben Sie im Feld Name einen Namen ein, um Ihre Verbindung zu identifizieren, z. B.

Salesforce_connection.Geben Sie im Abschnitt Anmeldedaten die folgenden Details Ihres Salesforce-Kontos ein:

- Nutzername

- Passwort

- Consumer-Key

- Consumer-Secret

- Sicherheitstoken

Klicken Sie auf Test connection (Verbindung testen). Wenn die eingegebenen Details korrekt sind, ist der Test erfolgreich und die Meldung „Verbindung erfolgreich“ wird angezeigt.

Klicken Sie auf Erstellen.

Wählen Sie Salesforce_connection aus und kehren Sie zur Seite mit den Salesforce-Plug-in-Properties zurück.

Daten aus dem Batch-Quell-Plug-in von Salesforce extrahieren

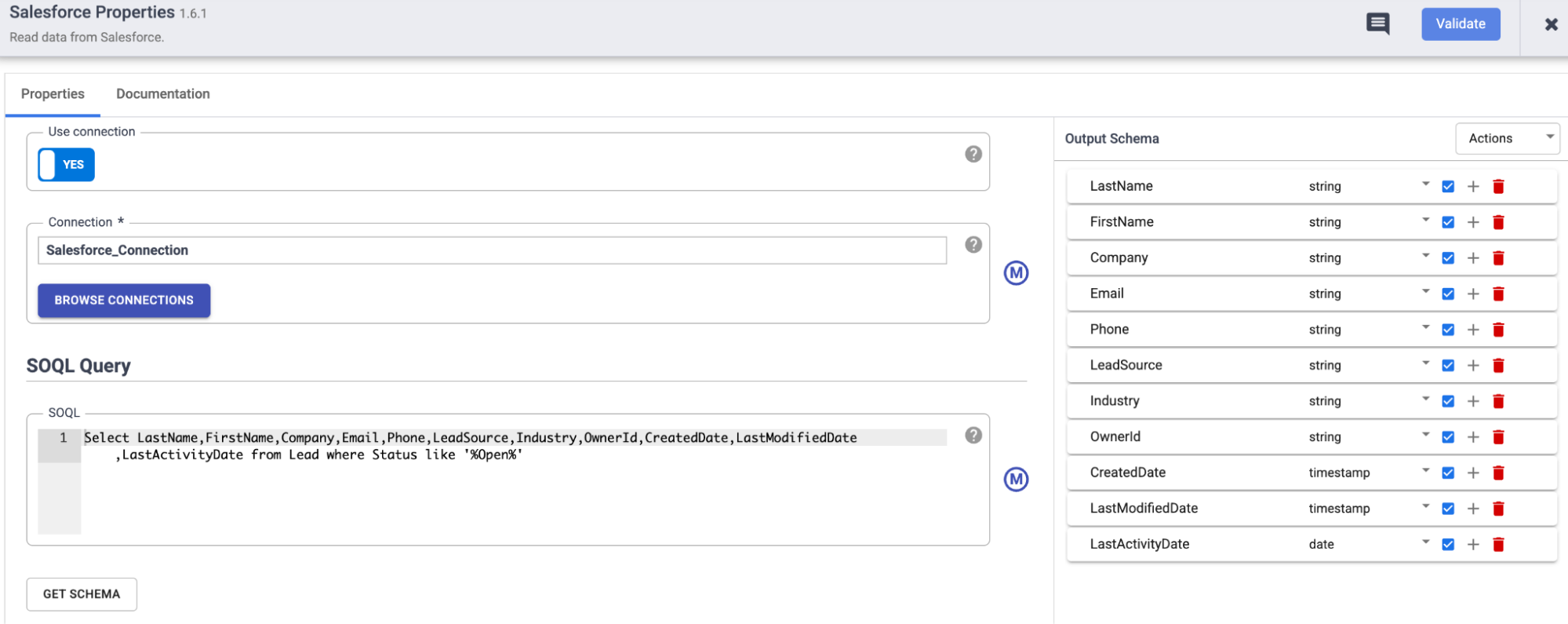

Geben Sie auf der Seite mit den Salesforce-Plug-in-Attributen im Abschnitt SOQL-Abfrage die folgende Abfrage ein:

Select LastName,FirstName,Company,Email,Phone,LeadSource,Industry,OwnerId,CreatedDate,LastModifiedDate,LastActivityDate from Lead where Status like '%Open%'Mit dieser Abfrage werden die Details eines potenziellen Leads aus dem S-Objekt

Leadabgerufen, die für die Durchführung einer Kampagne erforderlich sind.Klicken Sie auf Schema abrufen, um die Gültigkeit des Objektschemas zu prüfen.

Wenn Sie die Daten nach einem bestimmten Datum oder einer bestimmten Uhrzeit für die Ausführung der Kampagne filtern möchten, verwenden Sie die folgenden Felder:

- Zuletzt geändert nach dem

- Zuletzt geändert vor dem

- Dauer

- Offset

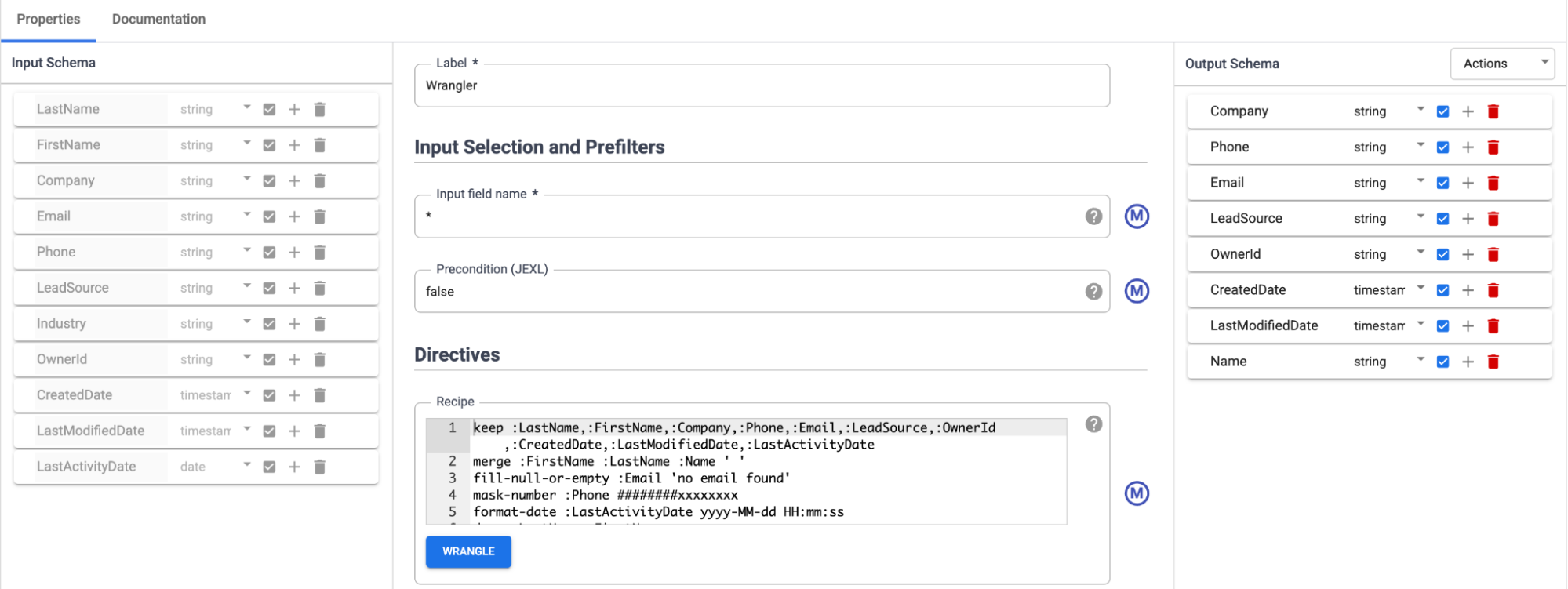

Daten mit dem Wrangler-Plug-in transformieren

So bereinigen und anreichern Sie Ihre Daten mit dem Wrangler-Plug-in in Cloud Data Fusion:

Kehren Sie zur Seite Studio zurück.

Klicken Sie im Menü Transform auf Wrangler.

Verbinden Sie Wrangler mit dem Salesforce-Batch-Quell-Plug-in von Salesforce.

Gehen Sie zum Wrangler-Plug-in und klicken Sie auf Attribute. Daraufhin wird die Seite mit den Attributen des Wrangler-Plug-ins geöffnet.

Das Eingabeschema muss ausgefüllt sein.

Klicken Sie auf Wrangler.

Wählen Sie im Bereich Verbindungen eine gültige Verbindung aus.

Wählen Sie das sObject aus, das Sie transformieren möchten, z. B.

Lead.Transformieren Sie die Daten mit den erforderlichen Direktiven:

keep :LastName,:FirstName,:Company,:Phone,:Email,:LeadSource,:OwnerId, :CreatedDate,:LastModifiedDate,:LastActivityDatemerge :FirstName :LastName :Name ' ' fill-null-or-empty :Email 'no email found' mask-number :Phone ########xxxxxxxx format-date :LastActivityDate yyyy-MM-dd HH:mm:ss drop :LastName,:FirstName

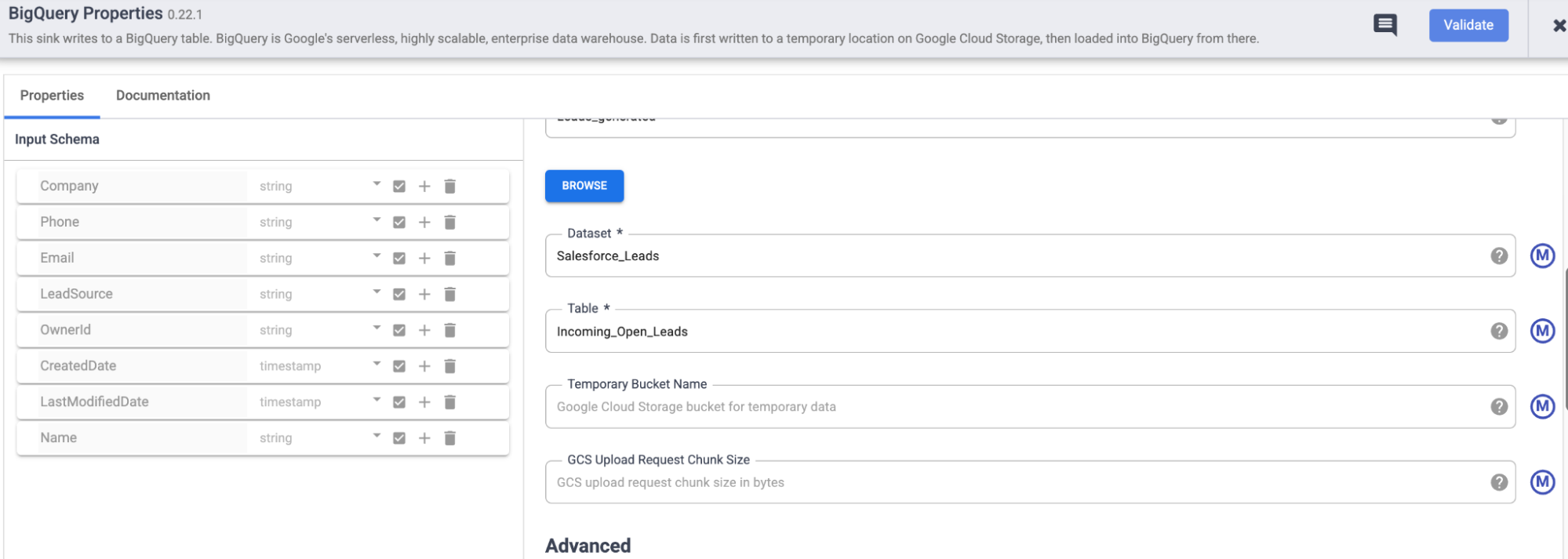

Daten in BigQuery laden.

Kehren Sie zur Seite Studio zurück.

Klicken Sie im Menü Senke auf BigQuery.

Wechseln Sie zum Knoten BigQuery und klicken Sie auf Attribute. Die Seite mit den Attributen des BigQuery-Plug-ins wird geöffnet.

Geben Sie im Abschnitt Grundlegend im Feld Referenzname einen Namen ein, um diese Senke zu identifizieren. Beispiel:

Leads_generated.Geben Sie im Feld Dataset das Dataset ein, zu dem die Tabelle gehört. Beispiel:

Salesforce_LeadsGeben Sie im Feld Table (Tabelle) die Tabelle ein, in der die extrahierten Datensätze gespeichert werden sollen. Beispiel:

Incoming_Open_Leads.Klicken Sie auf Validieren, um das Plug-in zu validieren.

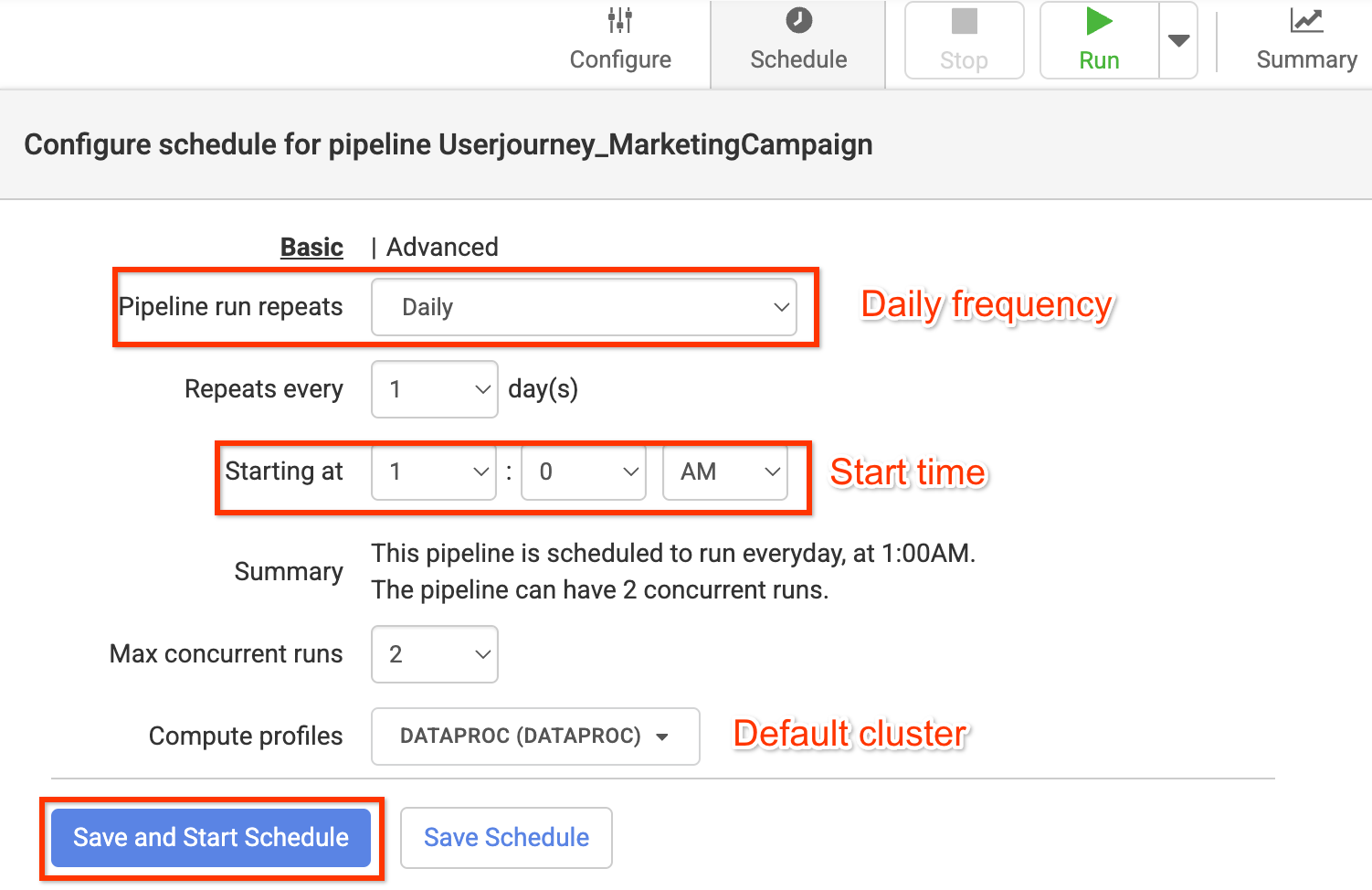

Pipeline bereitstellen, planen und ausführen

Klicken Sie zum Bereitstellen der Pipeline auf Bereitstellen

So richten Sie mit Schedulern einen geeigneten Aktualisierungszeitplan ein:

- Klicken Sie auf Planen.

Geben Sie die folgenden Informationen ein:

- Pipelineausführungwiederholungen

- Wiederholung: alle

- Ab

- Maximale Anzahl gleichzeitiger Ausführungen

- Compute-Profile

Klicken Sie auf Speichern und Zeitplan starten.

Klicken Sie zum Ausführen der Pipeline auf Ausführen.

Datenextraktion und -aufnahme prüfen

Rufen Sie in der Google Cloud Console die Seite "BigQuery" auf.

Suchen Sie nach dem Dataset

Salesforce_Leadsund dem TabellennamenIncoming_Open_Leads, um die extrahierten Datensätze aufzurufen.Klicken Sie zum Ausführen der Abfrage auf Abfrage.

Analysieren Sie die Lead-Daten, um Ihre Zielgruppe besser zu verstehen und maßgeschneiderte Kampagnen im großen Stil zu schalten.

Bereinigen

Mit den folgenden Schritten vermeiden Sie, dass Ihrem Google Cloud -Konto die auf dieser Seite verwendeten Ressourcen in Rechnung gestellt werden:

Löschen Sie die Cloud Data Fusion-Instanz.

Folgen Sie der Anleitung, um die Cloud Data Fusion-Instanz zu löschen.

Projekt löschen

Am einfachsten vermeiden Sie weitere Kosten durch Löschen des für die Anleitung erstellten Projekts.

So löschen Sie das Projekt:

- In the Google Cloud console, go to the Manage resources page.

- In the project list, select the project that you want to delete, and then click Delete.

- In the dialog, type the project ID, and then click Shut down to delete the project.