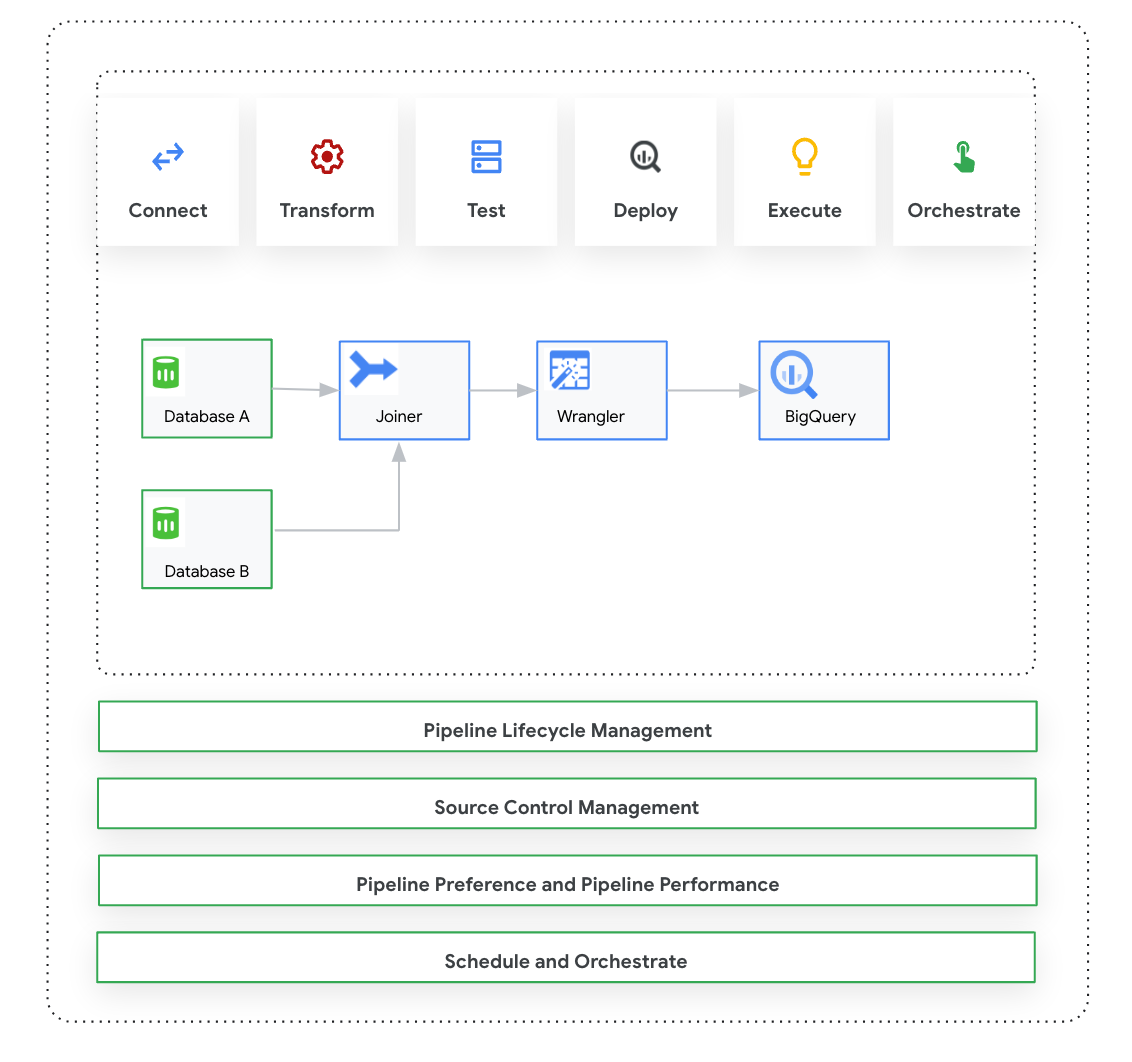

Auf dieser Seite wird Cloud Data Fusion: Studio vorgestellt. Das ist eine visuelle Benutzeroberfläche mit Drag-and-drop-Funktion, mit der Sie Datenpipelines aus einer Bibliothek vordefinierter Plug-ins erstellen und Ihre Pipelines konfigurieren, ausführen und verwalten können. Das Erstellen einer Pipeline in Studio erfolgt in der Regel so:

- Stellen Sie eine Verbindung zu einer lokalen oder Cloud-Datenquelle her.

- Daten vorbereiten und transformieren

- Stellen Sie eine Verbindung zum Ziel her.

- Pipeline testen

- Pipeline ausführen.

- Pipelines planen und auslösen

Nachdem Sie die Pipeline entworfen und ausgeführt haben, können Sie sie auf der Seite Pipeline Studio in Cloud Data Fusion verwalten:

- Pipelines können wiederverwendet werden, indem sie mit Einstellungen und Laufzeitargumenten parametrisiert werden.

- Sie können die Pipelineausführung verwalten, indem Sie Compute-Profile anpassen, Ressourcen verwalten und die Pipelineleistung optimieren.

- Verwalten Sie den Pipeline-Lebenszyklus, indem Sie Pipelines bearbeiten.

- Pipeline-Versionsverwaltung mit Git-Integration verwalten

Hinweis

- Aktivieren Sie die Cloud Data Fusion API.

- Erstellen Sie eine Cloud Data Fusion-Instanz.

- Weitere Informationen zur Zugriffssteuerung in Cloud Data Fusion

- Wichtige Konzepte und Begriffe in Cloud Data Fusion

Cloud Data Fusion: Studio – Übersicht

Studio umfasst die folgenden Komponenten:

Verwaltung

In Cloud Data Fusion können Sie in jeder Instanz mehrere Namespaces haben. Im Studio können Administratoren alle Namespaces zentral oder jeden Namespace einzeln verwalten.

In Studio stehen die folgenden Administratoreinstellungen zur Verfügung:

- Systemverwaltung

- Mit dem Modul Systemadministration in Studio können Sie neue Namespaces erstellen und die zentralen Konfigurationen des Compute-Profils auf Systemebene definieren, die für jeden Namespace in dieser Instanz gelten. Weitere Informationen finden Sie unter Studio-Verwaltung verwalten.

- Namespace-Verwaltung

- Mit dem Modul Namespace Admin in Studio können Sie die Konfigurationen für den jeweiligen Namespace verwalten. Für jeden Namespace können Sie Compute-Profile, Laufzeiteinstellungen, Treiber, Dienstkonten und Git-Konfigurationen definieren. Weitere Informationen finden Sie unter Studio-Verwaltung verwalten.

Pipeline Design Studio

Pipelines werden in der Cloud Data Fusion-Weboberfläche im Pipeline Design Studio entworfen und ausgeführt. Das Entwerfen und Ausführen von Datenpipelines umfasst die folgenden Schritte:

- Verbindung mit einer Quelle herstellen: Cloud Data Fusion ermöglicht Verbindungen zu lokalen und Cloud-Datenquellen. Die Studio-Benutzeroberfläche enthält standardmäßige System-Plug-ins, die bereits in Studio installiert sind. Sie können zusätzliche Plug-ins aus einem Plug-in-Repository herunterladen, dem sogenannten Hub. Weitere Informationen finden Sie unter Plug-ins – Übersicht.

- Datenvorbereitung: Mit Cloud Data Fusion können Sie Ihre Daten mit dem leistungsstarken Plug-in für die Datenvorbereitung Wrangler vorbereiten. Mit Wrangler können Sie eine kleine Stichprobe Ihrer Daten an einem Ort ansehen, untersuchen und transformieren, bevor Sie die Logik in Studio auf den gesamten Datensatz anwenden. So können Sie schnell Transformationen anwenden, um zu sehen, wie sich diese auf das gesamte Dataset auswirken. Sie können mehrere Transformationen erstellen und einem Rezept hinzufügen. Weitere Informationen finden Sie in der Wrangler-Übersicht.

- Transformation: Transformations-Plug-ins ändern Daten, nachdem sie aus einer Quelle geladen wurden. Sie können beispielsweise einen Datensatz klonen, das Dateiformat in JSON ändern oder mit dem JavaScript-Plug-in eine benutzerdefinierte Transformation erstellen. Weitere Informationen finden Sie unter Plug-ins – Übersicht.

- Verbindung zu einem Ziel herstellen: Nachdem Sie die Daten vorbereitet und Transformationen angewendet haben, können Sie eine Verbindung zum Ziel herstellen, an das Sie die Daten laden möchten. Cloud Data Fusion unterstützt Verbindungen zu mehreren Zielen. Weitere Informationen finden Sie unter Plug-ins.

- Vorschau: Nachdem Sie die Pipeline entworfen haben, können Sie mit einem Vorschaujob Probleme beheben, bevor Sie die Pipeline bereitstellen und ausführen. Falls Fehler auftreten, können Sie sie im Modus Entwurf beheben. In Studio werden die ersten 100 Zeilen des Quelldatensatzes verwendet, um die Vorschau zu generieren. In Studio werden der Status und die Dauer des Vorschaujobs angezeigt. Sie können den Job jederzeit beenden. Sie können auch die Protokolle während der Ausführung des Vorschaujobs beobachten. Weitere Informationen finden Sie unter Daten in der Vorschau.

Pipelinekonfigurationen verwalten: Nachdem Sie sich eine Vorschau der Daten angesehen haben, können Sie die Pipeline bereitstellen und die folgenden Pipelinekonfigurationen verwalten:

- Compute-Konfiguration: Sie können das Compute-Profil ändern, mit dem die Pipeline ausgeführt wird. Beispiel: Sie möchten die Pipeline nicht mit dem standardmäßigen Dataproc-Cluster, sondern mit einem benutzerdefinierten Dataproc-Cluster ausführen.

- Pipelinekonfiguration: Für jede Pipeline können Sie die Instrumentierung aktivieren oder deaktivieren, z. B. Zeitmesswerte. Die Instrumentierung ist standardmäßig aktiviert.

- Engine-Konfiguration: Spark ist die Standardausführungs-Engine. Sie können benutzerdefinierte Parameter für Spark anpassen.

- Ressourcen: Sie können den Arbeitsspeicher und die Anzahl der CPUs für den Spark-Treiber und ‑Executor angeben. Der Treiber orchestriert den Spark-Job. Der Executor übernimmt die Datenverarbeitung in Spark.

- Pipeline-Benachrichtigung: Sie können die Pipeline so konfigurieren, dass nach Abschluss der Pipelineausführung Benachrichtigungen gesendet und Aufgaben zur Nachbearbeitung gestartet werden. Sie erstellen Pipeline-Benachrichtigungen, wenn Sie die Pipeline entwerfen. Nachdem Sie die Pipeline bereitgestellt haben, können Sie sich die Benachrichtigungen ansehen. Wenn Sie die Benachrichtigungseinstellungen ändern möchten, bearbeiten Sie die Pipeline.

- Transformations-Push-down: Sie können den Transformations-Push-down aktivieren, wenn eine Pipeline bestimmte Transformationen in BigQuery ausführen soll.

Weitere Informationen finden Sie unter Pipelinekonfigurationen verwalten.

Pipelines mithilfe von Makros, Einstellungen und Laufzeitargumenten wiederverwenden: Mit Cloud Data Fusion können Sie Datenpipelines wiederverwenden. Mit wiederverwendbaren Datenpipelines können Sie eine einzige Pipeline verwenden, um ein Datenintegrationsmuster auf eine Vielzahl von Anwendungsfällen und Datensätzen anzuwenden. Wiederverwendbare Pipelines bieten eine bessere Verwaltungsmöglichkeit. Mit ihnen können Sie die meisten Konfigurationseinstellungen einer Pipeline bei der Ausführung festlegen, anstatt sie beim Entwerfen zu hartcodieren. In Pipeline Design Studio können Sie Makros verwenden, um Plug-in-Konfigurationen Variablen hinzuzufügen, damit Sie die Variablensubstitutionen zur Laufzeit angeben können. Weitere Informationen finden Sie unter Makros, Einstellungen und Laufzeitargumente verwalten.

Ausführen: Nachdem Sie die Pipelinekonfigurationen überprüft haben, können Sie die Pipelineausführung starten. Sie können die Statusänderung während der Phasen der Pipelineausführung sehen, z. B. Bereitstellung, Start, Ausführung und Erfolg.

Planen und orchestrieren: Batch-Datenpipelines können so konfiguriert werden, dass sie nach einem bestimmten Zeitplan und mit einer bestimmten Häufigkeit ausgeführt werden. Nachdem Sie eine Pipeline erstellt und bereitgestellt haben, können Sie einen Zeitplan erstellen. Im Pipeline Design Studio können Sie Pipelines orchestrieren, indem Sie einen Trigger für eine Batch-Datenpipeline erstellen, damit sie ausgeführt wird, wenn eine oder mehrere Pipelineausführungen abgeschlossen sind. Diese werden als Downstream- und Upstream-Pipelines bezeichnet. Sie erstellen einen Trigger für die nachgelagerte Pipeline, damit sie nach Abschluss einer oder mehrerer vorgelagerter Pipelines ausgeführt wird.

Empfohlen: Sie können auch Composer verwenden, um Pipelines in Cloud Data Fusion zu orchestrieren. Weitere Informationen finden Sie unter Pipelines planen und Pipelines orchestrieren.

Pipelines bearbeiten: In Cloud Data Fusion können Sie eine bereitgestellte Pipeline bearbeiten. Wenn Sie eine bereitgestellte Pipeline bearbeiten, wird eine neue Version der Pipeline mit demselben Namen erstellt und als neueste Version gekennzeichnet. So können Sie Pipelines iterativ entwickeln, anstatt sie zu duplizieren, wodurch eine neue Pipeline mit einem anderen Namen erstellt wird. Weitere Informationen finden Sie unter Pipelines bearbeiten.

Versionsverwaltung: Mit Cloud Data Fusion können Sie Pipelines zwischen Entwicklung und Produktion besser verwalten, da die Versionen der Pipelines mit GitHub verwaltet werden.

Logging und Monitoring: Wenn Sie Pipeline-Messwerte und ‑Protokolle überwachen möchten, sollten Sie den Stackdriver-Logging-Dienst aktivieren, um Cloud Logging mit Ihrer Cloud Data Fusion-Pipeline zu verwenden.