Cloud Tensor Processing Unit (TPU)

使用 Google Cloud TPU 加快 AI 開發作業

不確定 TPU 是否符合需求嗎?請查看說明文件,瞭解在 Compute Engine 執行個體中使用 GPU 或 CPU 執行機器學習工作負載的時機。

總覽

什麼是 Tensor Processing Unit (TPU)?

Google Cloud TPU 是經過最佳化調整的特製 AI 加速器,適合用於 AI 模型的訓練和推論作業。這類加速器是各種應用實例的最佳選擇,例如代理、程式碼生成、媒體內容生成、合成語音、視覺服務、推薦引擎、個人化模型等。TPU 為 Gemini 和 Google 的所有 AI 輔助應用程式 (例如搜尋、相簿和地圖) 提供運算效能,這些應用程式為超過 10 億名使用者提供服務。

Cloud TPU 有哪些優點?

Cloud TPU 能以符合成本效益的方式調度資源,並可支援訓練、微調和推論等多種 AI 工作負載。Cloud TPU 具備靈活彈性,讓您可以透過頂尖的 AI 架構加速處理工作負載,包括 PyTorch、JAX 和 TensorFlow。您還可以透過 Google Kubernetes Engine (GKE) 中的 Cloud TPU 整合功能,順暢地對大規模 AI 工作負載進行自動化調度管理。此外,只要運用 Dynamic Workload Scheduler,就能同時安排需要的所有加速器,進而提高工作負載的擴充性。如果客戶想用最簡單的方式開發 AI 模型,則可在 Vertex AI 這個全代管 AI 平台上使用 Cloud TPU。

哪些情況適合使用 Cloud TPU?

Cloud TPU 與 GPU 有何不同?

GPU 原本就是專為處理電腦繪圖而設計的處理器,其採用平行處理架構,非常適合用來執行相關演算法,以處理 AI 工作負載中常見的大量資料。瞭解詳情。

TPU 是 Google 為類神經網路設計的特殊應用積體電路 (ASIC)。TPU 具備矩陣乘法計算單元 (MXU) 和專屬互連網路拓撲等專用功能,是用來加速 AI 訓練和推論工作的絕佳選擇。

Cloud TPU 版本

| Cloud TPU 版本 | 說明 | 可用性 |

|---|---|---|

Ironwood | 我們迄今最強大且最有效率的 TPU,適用於最大規模的訓練和推論 | Ironwood TPU 將於 2025 年第 4 季正式發布 |

Trillium | 第六代 TPU。提升能源效率,並提高單一晶片的訓練和推論運算尖峰效能 | Trillium 已於北美洲 (美國東部)、歐洲 (西歐) 和亞洲 (東北亞) 正式發布 |

Cloud TPU v5p | 強大的 TPU,可用於建構大型複雜的基礎模型 | Cloud TPU v5p 於北美地區 (美國東部) 正式發布 |

Cloud TPU v5e | 符合成本效益且容易使用的 TPU,適用於中大型訓練和推論工作負載 | Cloud TPU v5e 於北美地區 (美國中部/東部/南部/西部)、歐洲 (西歐) 和亞洲 (東南亞) 正式發布 |

其他 Cloud TPU 版本相關資訊請參閱這裡

Ironwood

我們迄今最強大且最有效率的 TPU,適用於最大規模的訓練和推論

Ironwood TPU 將於 2025 年第 4 季正式發布

Trillium

第六代 TPU。提升能源效率,並提高單一晶片的訓練和推論運算尖峰效能

Trillium 已於北美洲 (美國東部)、歐洲 (西歐) 和亞洲 (東北亞) 正式發布

Cloud TPU v5p

強大的 TPU,可用於建構大型複雜的基礎模型

Cloud TPU v5p 於北美地區 (美國東部) 正式發布

Cloud TPU v5e

符合成本效益且容易使用的 TPU,適用於中大型訓練和推論工作負載

Cloud TPU v5e 於北美地區 (美國中部/東部/南部/西部)、歐洲 (西歐) 和亞洲 (東南亞) 正式發布

其他 Cloud TPU 版本相關資訊請參閱這裡

常見用途

執行大規模 AI 訓練工作負載

如何擴充模型

訓練大型語言模型往往像在使用煉金術,但瞭解模型並最佳化效能則不必如此。這本書旨在解析在 TPU 上擴充語言模型的科學原理,包括 TPU 的運作方式和彼此之間的溝通方式、大型語言模型在實際硬體上的執行方式,以及如何在訓練和推論期間平行處理模型,讓模型在大規模運作時也能保持高效率。

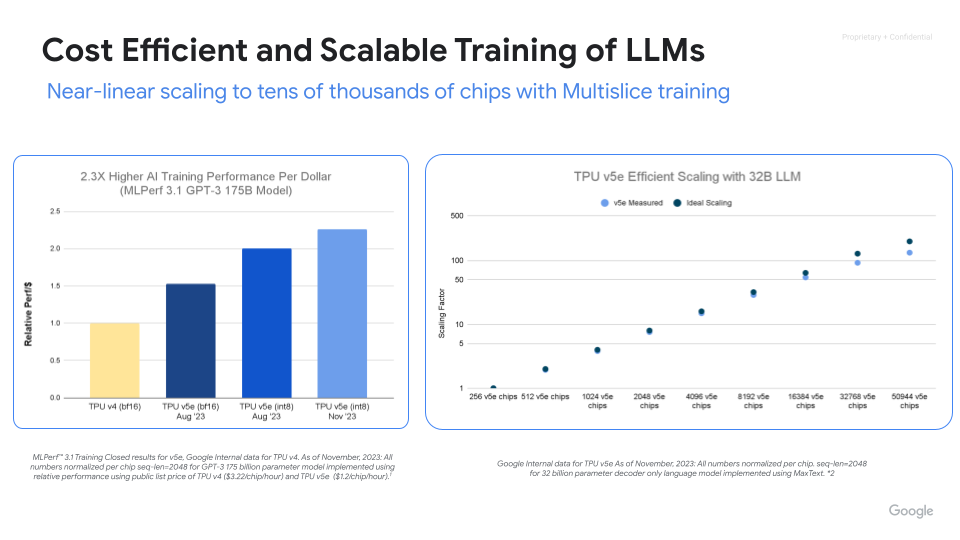

強大、可擴充且高效的 AI 訓練

有了 Cloud TPU,就能將執行效能和效率提升到最高,並在最短時間內創造價值。Cloud TPU Multislice 訓練技術可將訓練規模擴充至數千個晶片,ML Goodput Measurement 可評估並提升大規模機器學習訓練效率,MaxText 和 MaxDiffusion 則可讓您部署開放原始碼參考資源,快速開始訓練大型模型。

操作說明

如何擴充模型

訓練大型語言模型往往像在使用煉金術,但瞭解模型並最佳化效能則不必如此。這本書旨在解析在 TPU 上擴充語言模型的科學原理,包括 TPU 的運作方式和彼此之間的溝通方式、大型語言模型在實際硬體上的執行方式,以及如何在訓練和推論期間平行處理模型,讓模型在大規模運作時也能保持高效率。

其他資源

強大、可擴充且高效的 AI 訓練

有了 Cloud TPU,就能將執行效能和效率提升到最高,並在最短時間內創造價值。Cloud TPU Multislice 訓練技術可將訓練規模擴充至數千個晶片,ML Goodput Measurement 可評估並提升大規模機器學習訓練效率,MaxText 和 MaxDiffusion 則可讓您部署開放原始碼參考資源,快速開始訓練大型模型。

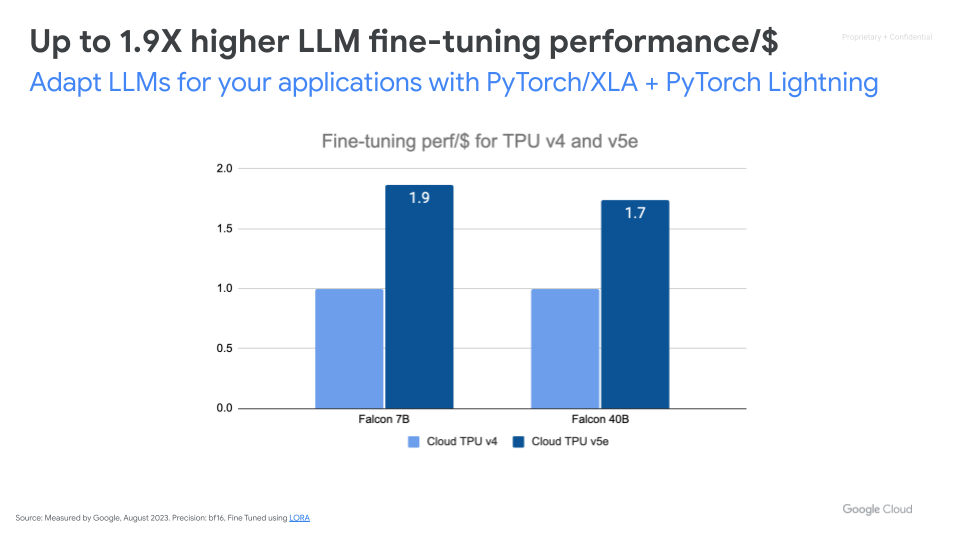

處理大規模 AI 推論工作負載

高效能、可擴充且符合成本效益的推論服務

使用 vLLM 和 MaxDiffusion 加速 AI 推論作業。vLLM 是熱門的開放原始碼推論引擎,專為大型語言模型 (LLM) 推論作業設計,可實現高處理量和低延遲。vLLM 現在提供 vLLM TPU,可透過 tpu-inference 實現高處理量、低延遲的 LLM 推論。它整合了 JAX 和 PyTorch,提供更廣泛的模型涵蓋範圍 (Gemma、Llama、Qwen) 和強化功能。MaxDiffusion 可在 Cloud TPU 上最佳化擴散模型推論作業,以達到高效能。

運用可調整規模的 AI 基礎架構,讓投入的每一分資金發揮最高效益

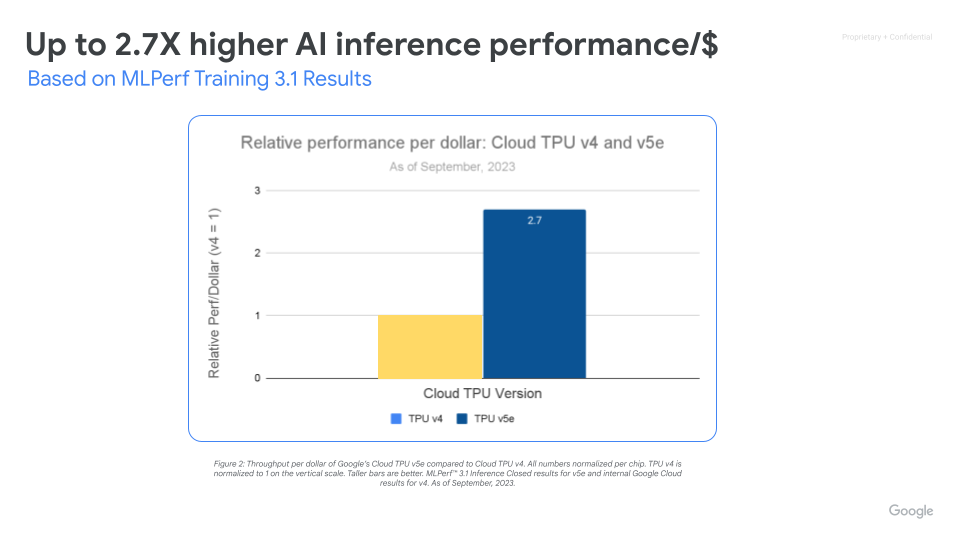

Cloud TPU v5e 能讓各種 AI 工作負載 (包括最新的 LLM 和生成式 AI 模型) 進行高效能且具成本效益的推論作業。相較於 Cloud TPU v4,TPU v5e 每一美元的處理量效能提升幅度最高可達 2.5 倍,速度提升幅度最高可達 1.7 倍。每個 TPU v5e 晶片每秒最多可提供 393 兆次 int8 運算,讓複雜的模型能夠快速做出預測。一個 TPU v5e Pod 每秒最多可提供 10 萬兆次 int8 運算,也就是 100 petaOps 的運算能力。

操作說明

高效能、可擴充且符合成本效益的推論服務

使用 vLLM 和 MaxDiffusion 加速 AI 推論作業。vLLM 是熱門的開放原始碼推論引擎,專為大型語言模型 (LLM) 推論作業設計,可實現高處理量和低延遲。vLLM 現在提供 vLLM TPU,可透過 tpu-inference 實現高處理量、低延遲的 LLM 推論。它整合了 JAX 和 PyTorch,提供更廣泛的模型涵蓋範圍 (Gemma、Llama、Qwen) 和強化功能。MaxDiffusion 可在 Cloud TPU 上最佳化擴散模型推論作業,以達到高效能。

其他資源

運用可調整規模的 AI 基礎架構,讓投入的每一分資金發揮最高效益

Cloud TPU v5e 能讓各種 AI 工作負載 (包括最新的 LLM 和生成式 AI 模型) 進行高效能且具成本效益的推論作業。相較於 Cloud TPU v4,TPU v5e 每一美元的處理量效能提升幅度最高可達 2.5 倍,速度提升幅度最高可達 1.7 倍。每個 TPU v5e 晶片每秒最多可提供 393 兆次 int8 運算,讓複雜的模型能夠快速做出預測。一個 TPU v5e Pod 每秒最多可提供 10 萬兆次 int8 運算,也就是 100 petaOps 的運算能力。

GKE 中的 Cloud TPU

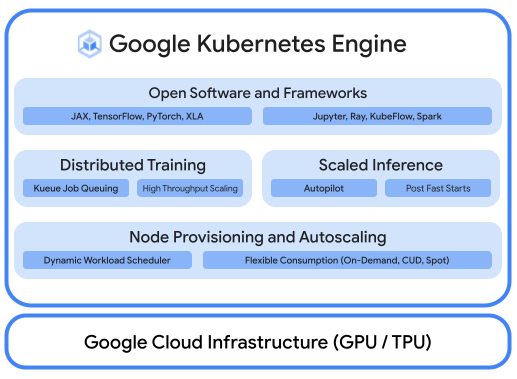

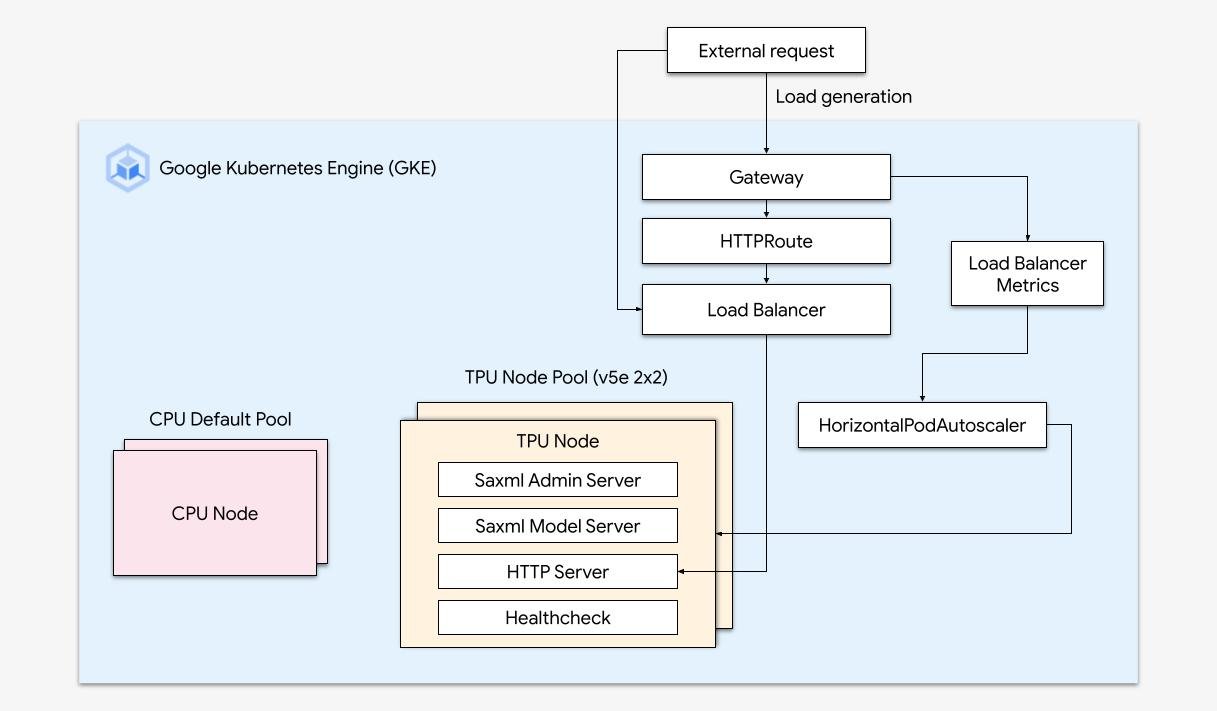

透過平台自動化調度管理,執行最佳化 AI 工作負載

完善的 AI/ML 平台應具備下列特點 (i) 可使用 GPU 進行大規模訓練及提供工作負載的基礎架構自動化調度管理 (ii) 能與分散式運算和資料處理架構彈性整合 (iii) 支援同一基礎架構中的多個團隊,盡可能提升資源使用率。

使用 GKE 輕鬆調度資源

結合 Cloud TPU 的威力與 GKE 的靈活性與擴充性,以更輕鬆快速的方式建構及部署機器學習模型。有了 GKE 提供的 Cloud TPU,您現在可以為所有工作負載打造一致的作業環境,將自動化機器學習運作管線標準化。

操作說明

透過平台自動化調度管理,執行最佳化 AI 工作負載

完善的 AI/ML 平台應具備下列特點 (i) 可使用 GPU 進行大規模訓練及提供工作負載的基礎架構自動化調度管理 (ii) 能與分散式運算和資料處理架構彈性整合 (iii) 支援同一基礎架構中的多個團隊,盡可能提升資源使用率。

其他資源

使用 GKE 輕鬆調度資源

結合 Cloud TPU 的威力與 GKE 的靈活性與擴充性,以更輕鬆快速的方式建構及部署機器學習模型。有了 GKE 提供的 Cloud TPU,您現在可以為所有工作負載打造一致的作業環境,將自動化機器學習運作管線標準化。

定價

| Cloud TPU 定價 | 所有 Cloud TPU 價格皆以晶片小時為單位計算 | ||

|---|---|---|---|

| Cloud TPU 版本 | 評估價格 (美元) | 承諾使用 1 年 (美元) | 承諾使用 3 年 (美元) |

Trillium | 起始價 $2.7000 美元 每晶片小時 | 起始價 $1.8900 美元 每晶片小時 | 起始價 $1.2200 美元 每晶片小時 |

Cloud TPU v5p | 起始價 $4.2000 美元 每晶片小時 | 起始價 $2.9400 美元 每晶片小時 | 起始價 $1.8900 美元 每晶片小時 |

Cloud TPU v5e | 起始價 $1.2000 美元 每晶片小時 | 起始價 $0.8400 美元 每晶片小時 | 起始價 $0.5400 美元 每晶片小時 |

Cloud TPU 定價因產品和地區而異。

Cloud TPU 定價

所有 Cloud TPU 價格皆以晶片小時為單位計算

Trillium

Starting at

$2.7000 美元

每晶片小時

Starting at

$1.8900 美元

每晶片小時

Starting at

$1.2200 美元

每晶片小時

Cloud TPU v5p

Starting at

$4.2000 美元

每晶片小時

Starting at

$2.9400 美元

每晶片小時

Starting at

$1.8900 美元

每晶片小時

Cloud TPU v5e

Starting at

$1.2000 美元

每晶片小時

Starting at

$0.8400 美元

每晶片小時

Starting at

$0.5400 美元

每晶片小時

Cloud TPU 定價因產品和地區而異。