이 페이지에서는 Google Cloud 콘솔을 사용하여 Spanner 데이터베이스를 Spanner로 가져오는 방법을 설명합니다. 다른 소스에서 Avro 파일을 가져오려면 Spanner 데이터베이스 이외의 데이터베이스에서 데이터 가져오기를 참조하세요.

이 프로세스에서는 Dataflow를 사용하여 Avro 파일과 JSON 매니페스트 파일의 집합을 포함하는 Cloud Storage 버킷 폴더에서 데이터를 가져옵니다. 이 가져오기 프로세스에서는 Spanner에서 내보낸 Avro 파일만 지원합니다.

REST API 또는 gcloud CLI를 사용하여 Spanner 데이터베이스를 가져오려면 이 페이지의 시작하기 전에 섹션의 단계를 완료한 후 Cloud Storage Avro to Spanner의 자세한 안내를 참조하세요.

시작하기 전에

Spanner 데이터베이스를 가져오려면 먼저 Spanner, Cloud Storage, Compute Engine, Dataflow API를 사용 설정해야 합니다.

Roles required to enable APIs

To enable APIs, you need the Service Usage Admin IAM

role (roles/serviceusage.serviceUsageAdmin), which

contains the serviceusage.services.enable permission. Learn how to grant

roles.

또한 충분한 할당량과 필수 IAM 권한이 필요합니다.

할당량 요구사항

가져오기 작업의 할당량 요구사항은 다음과 같습니다.

- Spanner: 가져올 데이터 양을 지원할 수 있는 충분한 컴퓨팅 용량이 있어야 합니다. 데이터베이스를 가져오는 데 추가 컴퓨팅 용량이 필요하지는 않지만 적당한 시간 안에 작업을 마치려면 컴퓨팅 용량을 추가해야 할 수도 있습니다. 자세한 내용은 작업 최적화를 참조하세요.

- Cloud Storage: 가져오려면 이전에 내보낸 파일이 포함된 버킷이 있어야 합니다. 버킷 크기를 설정할 필요는 없습니다.

- Dataflow: 가져오기 작업에는 다른 Dataflow 작업과 동일한 CPU, 디스크 사용량, IP 주소 Compute Engine 할당량이 적용됩니다.

Compute Engine: 가져오기 작업을 실행하기 전에 Dataflow가 사용하는 Computer Engine에 초기 할당량을 설정해야 합니다. 이 할당량은 Dataflow가 작업에 사용할 수 있는 최대 리소스 수를 나타냅니다. 권장되는 시작 값은 다음과 같습니다.

- CPU: 200

- 사용 중인 IP 주소: 200

- 표준 영구 디스크: 50TB

일반적으로 다른 조정은 수행할 필요가 없습니다. Dataflow는 자동 확장을 제공하므로 가져오기 중에 사용된 실제 리소스에 대해서만 비용을 지불하면 됩니다. 작업에 더 많은 리소스가 사용될 수 있으면 Dataflow UI에 경고 아이콘이 표시됩니다. 경고 아이콘이 표시되더라도 작업은 완료됩니다.

필요한 역할

데이터베이스를 내보내는 데 필요한 권한을 얻으려면 관리자에게 Dataflow 작업자 서비스 계정에 대한 다음 IAM 역할을 부여해 달라고 요청하세요.

-

Cloud Spanner 뷰어(

roles/spanner.viewer) -

Dataflow 작업자(

roles/dataflow.worker) -

스토리지 관리자(

roles/storage.admin) -

Spanner 데이터베이스 리더(

roles/spanner.databaseReader) -

데이터베이스 관리자(

roles/spanner.databaseAdmin)

선택사항: Cloud Storage에서 데이터베이스 폴더 찾기

Google Cloud 콘솔에서 내보낸 데이터베이스가 포함된 폴더를 찾으려면 Cloud Storage 브라우저로 이동하고 내보낸 폴더가 포함된 버킷을 클릭합니다.

내보낸 데이터가 포함된 폴더의 이름은 인스턴스 ID, 데이터베이스 이름, 내보내기 작업의 타임스탬프로 시작됩니다. 이 폴더에는 다음이 포함되어 있습니다.

spanner-export.json파일- 내보낸 데이터베이스에 있는 각 테이블의

TableName-manifest.json파일 하나 이상의

TableName.avro-#####-of-#####파일. 확장명.avro-#####-of-#####에서 첫 번째 숫자는 Avro 파일의 색인(0부터 시작)을 나타내고, 두 번째 숫자는 각 테이블에 생성된 Avro 파일 수를 나타냅니다.예를 들어

Songs.avro-00001-of-00002는Songs테이블의 데이터가 포함된 두 파일 중 두 번째 파일입니다.내보낸 데이터베이스에서 각 변경 내역의

ChangeStreamName-manifest.json파일.변경 내역당 하나의

ChangeStreamName.avro-00000-of-00001. 이 파일에는 변경 내역의 Avro 스키마만 있는 빈 데이터가 포함되어 있습니다.

데이터베이스 가져오기

Spanner 데이터베이스를 Cloud Storage에서 인스턴스로 가져오려면 다음 단계에 수행합니다.

Spanner 인스턴스 페이지로 이동합니다.

가져온 데이터베이스가 포함될 인스턴스의 이름을 클릭합니다.

왼쪽 창에서 가져오기/내보내기 메뉴 항목을 클릭한 다음 가져오기 버튼을 클릭합니다.

소스 폴더 선택에서 찾아보기를 클릭합니다.

초기 목록에서 내보내기가 포함된 버킷을 찾거나 검색(

)을 클릭하여 목록을 필터링하고 버킷을 찾습니다. 버킷을 더블클릭하여 포함된 폴더를 확인합니다.

)을 클릭하여 목록을 필터링하고 버킷을 찾습니다. 버킷을 더블클릭하여 포함된 폴더를 확인합니다.내보낸 파일이 있는 폴더를 찾고 클릭하여 선택합니다.

선택을 클릭합니다.

내보내기 프로세스 중에 Spanner에서 만드는 새 데이터베이스의 이름을 입력합니다. 인스턴스에 이미 존재하는 데이터베이스 이름이어서는 안 됩니다.

새 데이터베이스의 언어를 선택합니다(GoogleSQL 또는 PostgreSQL).

(선택사항) 고객 관리 암호화 키로 새 데이터베이스를 보호하려면 암호화 옵션 표시를 클릭하고 고객 관리 암호화 키(CMEK) 사용을 선택합니다. 그런 후 드롭다운 목록에서 키를 선택합니다.

가져오기 작업의 리전 선택 드롭다운 메뉴에서 리전을 선택합니다.

(선택사항) 고객 관리 암호화 키로 Dataflow 파이프라인 상태를 암호화하려면 암호화 옵션 표시를 클릭하고 고객 관리 암호화 키(CMEK) 사용을 선택합니다. 그런 후 드롭다운 목록에서 키를 선택합니다.

요금 부과 확인에서 체크박스를 선택하여 기존 Spanner 인스턴스에서 발생하는 요금 이외에 청구되는 요금을 확인합니다.

가져오기를 클릭합니다.

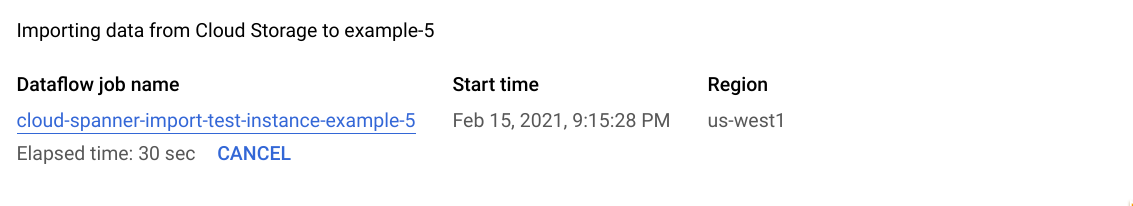

Google Cloud 콘솔에 데이터베이스 세부정보 페이지가 표시됩니다. 이 페이지에는 작업 경과 시간을 포함하여 가져오기 작업을 설명하는 상자가 표시됩니다.

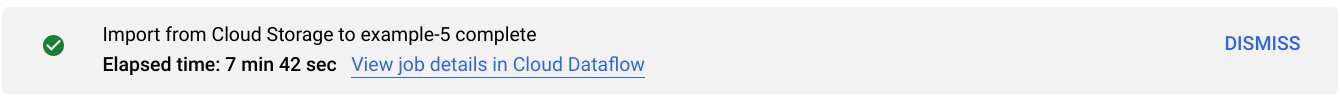

작업이 완료되거나 종료되면 Google Cloud 콘솔의 데이터베이스 세부정보 페이지에 메시지가 표시됩니다. 작업이 성공하면 성공 메시지가 나타납니다.

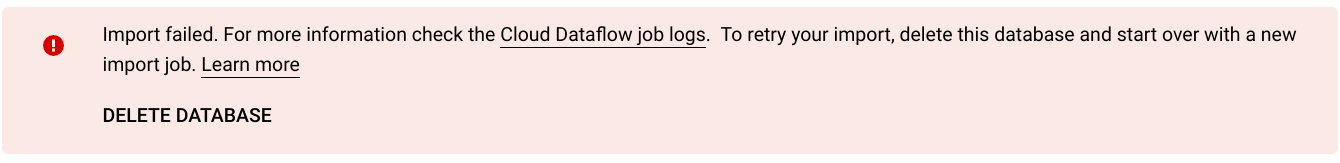

작업이 실패하면 실패 메시지가 나타납니다.

작업이 실패하면 오류 세부정보를 작업의 Dataflow 로그에서 확인하고 실패한 가져오기 작업 문제 해결을 참조하세요.

생성 열 및 변경 내역 내보내기 참고사항

Spanner는 Avro 스키마에서 각 생성된 열 정의를 사용하여 열을 다시 만듭니다. Spanner는 가져오기 중에 생성된 열 값을 자동으로 계산합니다.

마찬가지로 Spanner는 Avro 스키마에서 각 변경 내역 정의를 사용하여 가져오기 중에 다시 만듭니다. 변경 내역 데이터에 Avro를 통해 내보내기 또는 가져오기가 수행되지 않으므로 새로 가져온 데이터베이스와 연관된 모든 변경 내역에 변경 데이터 레코드가 포함되지 않습니다.

시퀀스 가져오기에 대한 참고사항

Spanner에서 내보내는 각 시퀀스(GoogleSQL, PostgreSQL)는 GET_INTERNAL_SEQUENCE_STATE()(GoogleSQL, PostgreSQL) 함수를 사용하여 현재 상태를 캡처합니다.

Spanner는 1,000 버퍼를 카운터에 추가하고 새 카운터 값을 레코드 필드의 속성에 기록합니다. 이 방법은 가져오기 이후 발생할 수 있는 중복 값 오류를 방지하기 위한 최선의 노력 방법일 뿐입니다.

데이터 내보내기 중 소스 데이터베이스에 쓰기가 더 많이 발생하는 경우 실제 시퀀스 카운터를 조정합니다.

가져오기 시에 시퀀스는 스키마에서 발견된 카운터 대신 이 새로운 카운터로부터 시작됩니다. 필요한 경우 ALTER SEQUENCE(GoogleSQL, PostgreSQL) 문을 사용하여 새 카운터로 업데이트할 수 있습니다.

인터리브 처리된 테이블 및 외래 키 가져오기 참고사항

Dataflow 작업은 인터리브 처리된 테이블을 가져올 수 있으며, 소스 파일에서 상위-하위 관계를 보존할 수 있습니다. 하지만 외래 키 제약조건은 데이터 로드 중에 적용되지 않습니다. Dataflow 작업은 데이터 로드가 완료된 후 모든 필요한 외래 키를 만듭니다.

가져오기가 시작되기 전 Spanner 데이터베이스에 외래 키 제약조건이 있으면 참조 무결성 위반으로 인해 쓰기 오류가 발생할 수 있습니다. 쓰기 오류를 방지하려면 가져오기 프로세스를 시작하기 전에 기존 외래 키를 모두 삭제하는 것이 좋습니다.

가져오기 작업 리전 선택

Cloud Storage 버킷 위치에 따라 다른 리전을 선택할 수 있습니다. 아웃바운드 데이터 전송 요금이 부과되지 않도록 하려면 Cloud Storage 버킷 위치와 일치하는 리전을 선택합니다.

Cloud Storage 버킷 위치가 리전인 경우 리전을 사용할 수 있으면 가져오기 작업에 동일한 리전을 선택하여 무료 네트워크 사용량을 활용할 수 있습니다.

Cloud Storage 버킷 위치가 이중 리전인 경우 리전 중 하나를 사용할 수 있으면 가져오기 작업에 이중 리전을 구성하는 두 리전 중 하나를 선택하여 무료 네트워크 사용량을 활용할 수 있습니다.

- 같은 위치에 있는 리전을 가져오기 작업에 사용할 수 없거나 Cloud Storage 버킷 위치가 멀티 리전이면 아웃바운드 데이터 전송 요금이 청구됩니다. Cloud Storage 데이터 전송 가격 책정을 참조하여 데이터 전송 요금이 가장 적은 리전을 선택하세요.

Dataflow UI에서 작업 보기 또는 문제 해결

가져오기 작업을 시작한 후에는 Google Cloud 콘솔의 Dataflow 섹션에서 로그를 포함한 작업 세부정보를 볼 수 있습니다.

Dataflow 작업 세부정보 보기

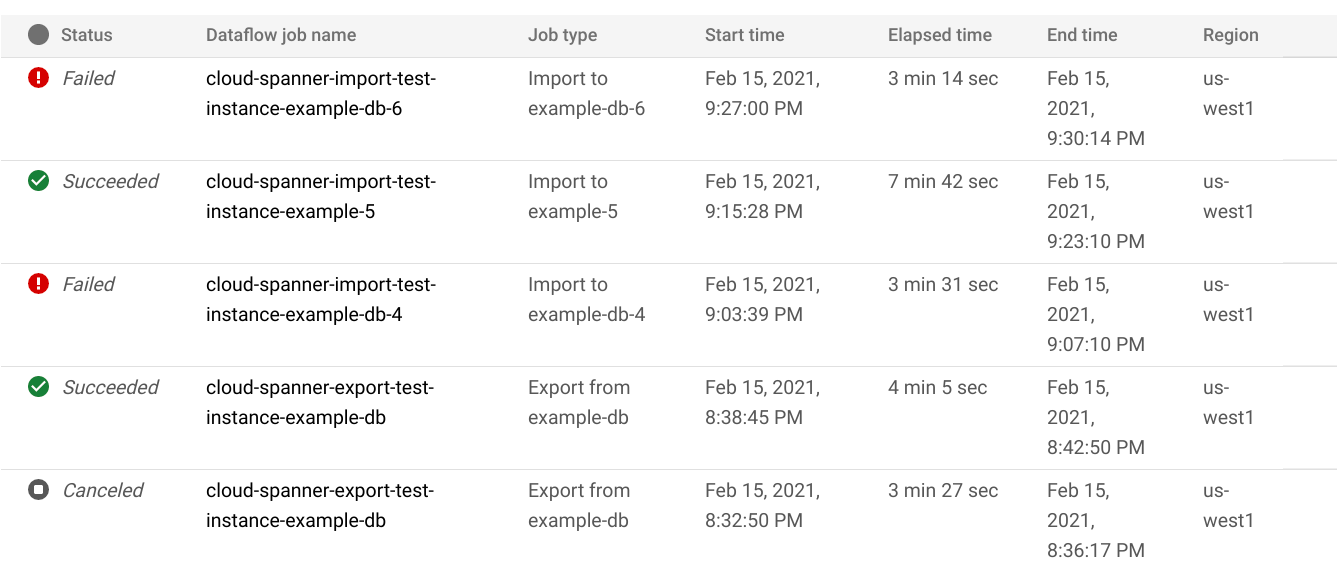

현재 실행 중인 작업을 포함하여 지난주에 실행한 가져오기 또는 내보내기 작업의 세부정보를 확인하려면 다음을 실행합니다.

- 데이터베이스의 데이터베이스 개요 페이지로 이동합니다.

- 왼쪽 창에서 가져오기/내보내기 메뉴 항목을 클릭합니다. 데이터베이스의 가져오기/내보내기 페이지에 최근 작업 목록이 표시됩니다.

데이터베이스의 가져오기/내보내기 페이지에서 Dataflow 작업 이름 열에 있는 작업 이름을 클릭합니다.

Google Cloud 콘솔에 Dataflow 작업 세부정보가 표시됩니다.

일주일 이상 전에 실행한 작업을 보려면 다음을 수행합니다.

Google Cloud 콘솔에서 Dataflow 작업 페이지로 이동합니다.

목록에서 작업을 찾은 다음 작업 이름을 클릭합니다.

Google Cloud 콘솔에 Dataflow 작업 세부정보가 표시됩니다.

작업의 Dataflow 로그 보기

Dataflow 작업의 로그를 보려면 작업의 세부정보 페이지로 이동한 다음 작업 이름 오른쪽에 있는 로그를 클릭합니다.

작업이 실패한 경우 로그에서 오류를 찾습니다. 오류가 있으면 오류 개수가 로그 옆에 표시됩니다.

작업 오류를 보려면 다음을 수행합니다.

로그 옆에 있는 오류 개수를 클릭합니다.

Google Cloud 콘솔에 작업 로그가 표시됩니다. 오류를 보려면 스크롤해야 할 수도 있습니다.

오류 아이콘(

)이 있는 항목을 찾습니다.

)이 있는 항목을 찾습니다.개별 로그 항목을 클릭하여 내용을 펼칩니다.

Dataflow 작업 문제 해결에 대한 자세한 내용은 파이프라인 문제 해결을 참조하세요.

실패한 가져오기 작업 문제 해결

작업 로그에 다음 오류가 표시되는 경우가 있습니다.

com.google.cloud.spanner.SpannerException: NOT_FOUND: Session not found --or-- com.google.cloud.spanner.SpannerException: DEADLINE_EXCEEDED: Deadline expired before operation could complete.

Google Cloud 콘솔의 Spanner 데이터베이스 모니터링 탭에서 99% 쓰기 지연 시간을 확인합니다. 높은 값(수 초)이 표시되면 인스턴스가 과부하되어 쓰기 제한 시간이 초과되고 실패했음을 나타냅니다.

지연 시간이 긴 이유 중 하나는 Dataflow 작업에서 너무 많은 작업자를 통해 실행되어 Spanner 인스턴스에 너무 많은 부하가 발생하기 때문입니다.

Google Cloud 콘솔의 Spanner 데이터베이스 인스턴스 세부정보 페이지에 있는 가져오기/내보내기 탭을 사용하는 대신 Dataflow 작업자 수를 제한하려면 Dataflow Cloud Storage Avro to Spanner 템플릿을 사용하여 가져오기를 시작하고 다음 설명대로 최대 작업자 수를 지정해야 합니다.콘솔

Dataflow 콘솔을 사용하는 경우 최대 작업자 파라미터는 템플릿에서 작업 만들기 페이지의 선택적 파라미터 섹션에 있습니다.

gcloud

gcloud dataflow jobs run 명령어를 실행하고 max-workers 인수를 지정합니다. 예를 들면 다음과 같습니다.

gcloud dataflow jobs run my-import-job \

--gcs-location='gs://dataflow-templates/latest/GCS_Avro_to_Cloud_Spanner' \

--region=us-central1 \

--parameters='instanceId=test-instance,databaseId=example-db,inputDir=gs://my-gcs-bucket' \

--max-workers=10 \

--network=network-123

네트워크 오류 문제 해결

Spanner 데이터베이스를 내보낼 때 다음 오류가 발생할 수 있습니다.

Workflow failed. Causes: Error: Message: Invalid value for field 'resource.properties.networkInterfaces[0].subnetwork': ''. Network interface must specify a subnet if the network resource is in custom subnet mode. HTTP Code: 400

이 오류는 Spanner가 Dataflow 작업과 동일한 프로젝트에서 default라는 자동 모드 VPC 네트워크를 사용한다고 가정하기 때문에 발생합니다. 프로젝트에 기본 VPC 네트워크가 없거나 VPC 네트워크가 커스텀 모드 VPC 네트워크에 있는 경우 Dataflow 작업을 만들고 대체 네트워크 또는 서브네트워크를 지정해야 합니다.

느리게 실행되는 가져오기 작업 최적화

초기 설정의 제안에 따랐다면 일반적으로 다른 조정이 필요 없습니다. 작업이 느리게 실행되는 경우에는 몇 가지 다른 최적화 방법을 시도할 수 있습니다.

작업 및 데이터 위치 최적화: Spanner 인스턴스와 Cloud Storage 버킷이 있는 리전과 동일한 리전에서 Dataflow 작업을 실행합니다.

충분한 Dataflow 리소스 확보: 관련 Compute Engine 할당량에 따라 Dataflow 작업 리소스가 제한되는 경우에는 Google Cloud 콘솔의 작업 Dataflow 페이지에 경고 아이콘

과 로그 메시지가 표시됩니다.

과 로그 메시지가 표시됩니다.

이 경우 CPU, 사용 중인 IP 주소, 표준 영구 디스크의 할당량을 늘리면 작업 실행 시간이 단축될 수 있지만 Compute Engine 요금이 늘어날 수 있습니다.

Spanner CPU 사용률 확인: 인스턴스의 CPU 사용률이 65%를 초과하면 인스턴스의 컴퓨팅 용량을 늘리면 됩니다. 용량을 추가하면 Spanner 리소스가 늘어나고 작업 속도가 빨라지지만 Spanner 요금이 더 많이 청구됩니다.

가져오기 작업 성능에 영향을 미치는 요소

가져오기 작업 완료에 걸리는 시간은 몇 가지 요소의 영향을 받습니다.

Spanner 데이터베이스 크기: 처리하는 데이터가 많을수록 시간과 리소스가 더 많이 소요됩니다.

다음을 포함한 Spanner 데이터베이스 스키마:

- 테이블 수

- 행 크기

- 보조 색인 수

- 외래 키 수

- 변경 내역 수

Dataflow 가져오기 작업이 완료된 후에도 색인 및 외래 키 생성이 계속됩니다. 변경 내역은 가져오기 작업이 완료되기 전, 하지만 모든 데이터 가져오기가 수행된 다음에만 생성됩니다.

데이터 위치: 데이터는 Dataflow를 사용하여 Spanner와 Cloud Storage 간에 전송됩니다. 이 세 가지 구성요소가 같은 리전에 위치하는 것이 이상적입니다. 구성요소가 서로 다른 리전에 있으면 다른 리전으로 데이터를 이동하느라 작업 속도가 느려집니다.

Dataflow 작업자 수: 성능 향상을 위해 최적의 Dataflow 작업자가 필요합니다. 자동 확장을 사용하면 Dataflow는 수행해야 하는 작업량에 따라 작업의 작업자 수를 선택합니다. 하지만 작업자 수는 CPU, 사용 중인 IP 주소, 표준 영구 디스크의 할당량에 따라 제한됩니다. 할당량 한도에 도달하면 Dataflow UI에 경고 아이콘이 표시됩니다. 이러한 경우 진행 속도가 느려지지만 작업은 완료됩니다. 가져올 데이터 양이 많으면 자동 확장으로 인해 Spanner에 과부하가 발생하여 오류가 발생할 수 있습니다.

Spanner의 기존 부하: 가져오기 작업을 실행하면 Spanner 인스턴스에 CPU 부하가 크게 증가합니다. 인스턴스에 이미 상당한 기존 부하가 있다면 작업 실행 속도가 더 느려집니다.

Spanner 컴퓨팅 용량: 인스턴스의 CPU 사용률이 65%를 초과하면 작업 실행 속도가 더 느려집니다.

가져오기 성능을 높일 수 있도록 작업자 조정

Spanner 가져오기 작업을 시작할 때 성능이 향상되도록 Dataflow 작업자를 최적의 값으로 설정해야 합니다. 작업자가 너무 많으면 Spanner에 과부하가 발생하고 작업자가 너무 적으면 가져오기 성능이 저하됩니다.

최대 작업자 수는 데이터 크기에 따라 크게 달라지지만 총 Spanner CPU 사용률은 70~90%여야 합니다. 이렇게 하면 Spanner 효율성과 오류 없는 작업 완료 간의 균형을 잘 잡을 수 있습니다.

대부분의 스키마 및 시나리오에서 이러한 사용률 목표를 달성하려면 Spanner 노드 수의 4~6배에 해당하는 최대 작업자 vCPU 수를 사용하는 것이 좋습니다.

예를 들어 n1-standard-2 작업자를 사용하는 10노드 Spanner 인스턴스의 경우 최대 작업자 수를 25로 설정하여 vCPU 50개를 제공합니다.