Questa pagina descrive come importare i database Spanner in Spanner utilizzando la console Google Cloud . Per importare file Avro da un'altra origine, consulta Importare dati da database non Spanner.

Il processo utilizza Dataflow; importa i dati da una cartella del bucket Cloud Storage che contiene un insieme di file Avro e file manifest JSON. Il processo di importazione supporta solo i file Avro esportati da Spanner.

Per importare un database Spanner utilizzando l'API REST o gcloud CLI, completa i passaggi descritti nella sezione Prima di iniziare di questa pagina, quindi consulta le istruzioni dettagliate in Cloud Storage Avro to Spanner.

Prima di iniziare

Per importare un database Spanner, devi prima attivare le API Spanner, Cloud Storage, Compute Engine e Dataflow:

Roles required to enable APIs

To enable APIs, you need the Service Usage Admin IAM

role (roles/serviceusage.serviceUsageAdmin), which

contains the serviceusage.services.enable permission. Learn how to grant

roles.

Devi anche disporre di una quota sufficiente e delle autorizzazioni IAM richieste.

Requisiti di quota

I requisiti di quota per i job di importazione sono i seguenti:

- Spanner: devi disporre di una capacità di calcolo sufficiente per supportare la quantità di dati che stai importando. Per importare un database non è necessaria capacità di calcolo aggiuntiva, anche se potrebbe essere necessario aggiungere più capacità di calcolo in modo che il job venga completato in un tempo ragionevole. Per ulteriori dettagli, consulta la sezione Ottimizzare i job.

- Cloud Storage: per l'importazione, devi disporre di un bucket contenente i file esportati in precedenza. Non devi impostare una dimensione per il bucket.

- Dataflow: i job di importazione sono soggetti alle stesse quote di CPU, utilizzo del disco e indirizzo IP di Compute Engine degli altri job Dataflow.

Compute Engine: prima di eseguire il job di importazione, devi configurare le quote iniziali per Compute Engine, che viene utilizzato da Dataflow. Queste quote rappresentano il numero massimo di risorse che consenti a Dataflow di utilizzare per il tuo job. I valori iniziali consigliati sono:

- CPU: 200

- Indirizzi IP in uso: 200

- Disco permanente standard: 50 TB

In genere, non devi apportare altre modifiche. Dataflow fornisce la scalabilità automatica in modo da pagare solo le risorse effettivamente utilizzate durante l'importazione. Se il tuo job può utilizzare più risorse, l'interfaccia utente di Dataflow mostra un'icona di avviso. Il job deve terminare anche se è presente un'icona di avviso.

Ruoli obbligatori

Per ottenere le autorizzazioni necessarie per esportare un database, chiedi all'amministratore di concederti i seguenti ruoli IAM sul account di servizio worker Dataflow:

-

Visualizzatore Cloud Spanner (

roles/spanner.viewer) -

Dataflow Worker (

roles/dataflow.worker) -

Amministratore spazio di archiviazione (

roles/storage.admin) -

Lettore database Spanner (

roles/spanner.databaseReader) -

Database Admin (

roles/spanner.databaseAdmin)

(Facoltativo) Trova la cartella del database in Cloud Storage

Per trovare la cartella che contiene il database esportato nella consoleGoogle Cloud , vai al browser Cloud Storage e fai clic sul bucket che contiene la cartella esportata.

Il nome della cartella che contiene i dati esportati inizia con l'ID dell'istanza, il nome del database e il timestamp del job di esportazione. La cartella contiene:

- Un file

spanner-export.json. - Un file

TableName-manifest.jsonper ogni tabella nel database che hai esportato. Uno o più file

TableName.avro-#####-of-#####. Il primo numero nell'estensione.avro-#####-of-#####rappresenta l'indice del file Avro, a partire da zero, mentre il secondo rappresenta il numero di file Avro generati per ogni tabella.Ad esempio,

Songs.avro-00001-of-00002è il secondo di due file che contengono i dati per la tabellaSongs.Un file

ChangeStreamName-manifest.jsonper ogni stream di modifiche nel database che hai esportato.Un file

ChangeStreamName.avro-00000-of-00001per ogni stream di modifiche. Questo file contiene dati vuoti con solo lo schema Avro dello stream di modifiche.

Importare un database

Per importare il database Spanner da Cloud Storage nell'istanza, segui questi passaggi.

Vai alla pagina Istanze di Spanner.

Fai clic sul nome dell'istanza che conterrà il database importato.

Fai clic sulla voce di menu Importa/Esporta nel riquadro a sinistra e poi sul pulsante Importa.

Nella sezione Scegli una cartella di origine, fai clic su Sfoglia.

Individua il bucket contenente l'esportazione nell'elenco iniziale oppure fai clic su Cerca

per filtrare l'elenco e trovare il bucket. Fai doppio clic sul bucket per visualizzare le cartelle che contiene.

per filtrare l'elenco e trovare il bucket. Fai doppio clic sul bucket per visualizzare le cartelle che contiene.Trova la cartella con i file esportati e fai clic per selezionarla.

Fai clic su Seleziona.

Inserisci un nome per il nuovo database, che Spanner crea durante il processo di importazione. Il nome del database non può esistere già nell'istanza.

Scegli il dialetto per il nuovo database (GoogleSQL o PostgreSQL).

(Facoltativo) Per proteggere il nuovo database con una chiave di crittografia gestita dal cliente, fai clic su Mostra opzioni di crittografia e seleziona Utilizza una chiave di crittografia gestita dal cliente (CMEK). Poi, seleziona una chiave dall'elenco a discesa.

Seleziona una regione nel menu a discesa Scegli una regione per il job di importazione.

(Facoltativo) Per criptare lo stato della pipeline Dataflow con una chiave di crittografia gestita dal cliente, fai clic su Mostra opzioni di crittografia e seleziona Utilizza una chiave di crittografia gestita dal cliente (CMEK). Poi, seleziona una chiave dall'elenco a discesa.

Seleziona la casella di controllo in Conferma addebiti per confermare che sono presenti addebiti aggiuntivi rispetto a quelli sostenuti dalla tua istanza Spanner esistente.

Fai clic su Importa.

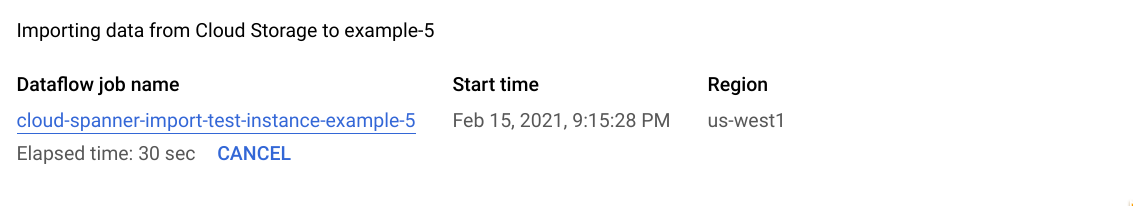

La Google Cloud console mostra la pagina Dettagli database, che ora mostra una casella che descrive il job di importazione, incluso il tempo trascorso del job:

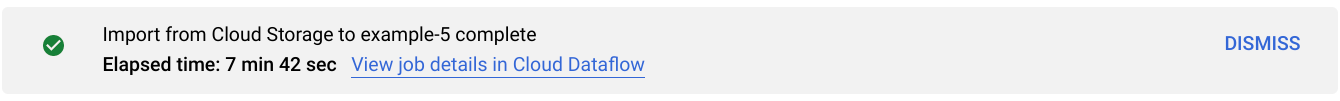

Al termine o all'interruzione del job, la console Google Cloud visualizza un messaggio nella pagina Dettagli database. Se il job viene eseguito correttamente, viene visualizzato un messaggio di conferma:

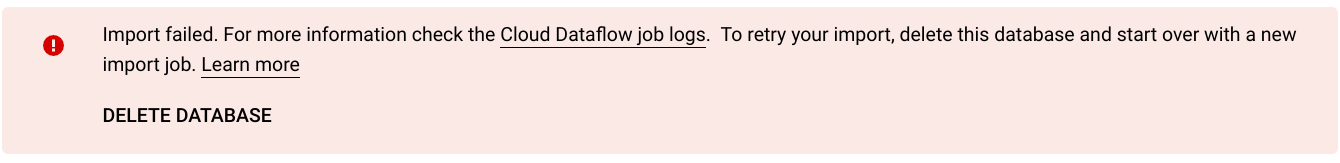

Se il job non va a buon fine, viene visualizzato un messaggio di errore:

Se il job non va a buon fine, controlla i log di Dataflow del job per i dettagli dell'errore e consulta la sezione Risolvere i problemi relativi ai job di importazione non riusciti.

Nota sull'importazione di colonne generate e modifiche in tempo reale

Spanner utilizza la definizione di ogni colonna generata nello schema Avro per ricrearla. Spanner calcola automaticamente i valori delle colonne generate durante l'importazione.

Allo stesso modo, Spanner utilizza la definizione di ogni stream di modifiche nello schema Avro per ricrearlo durante l'importazione. I dati dello stream di modifiche non vengono esportati né importati tramite Avro, pertanto tutti gli modifiche in tempo reale associati a un database appena importato non avranno record di dati di modifica.

Una nota sull'importazione di sequenze

Ogni sequenza (GoogleSQL,

PostgreSQL)

che Spanner esporta utilizza la funzione GET_INTERNAL_SEQUENCE_STATE()

(GoogleSQL,

PostgreSQL)

per acquisire il suo stato attuale.

Spanner aggiunge un buffer di 1000 al contatore e scrive il nuovo

valore del contatore nelle proprietà del campo del record. Tieni presente che questo è solo un approccio

ottimale per evitare errori di valori duplicati che potrebbero verificarsi dopo l'importazione.

Modifica il contatore di sequenza effettivo se vengono eseguite più scritture nel

database di origine durante l'esportazione dei dati.

Al momento dell'importazione, la sequenza inizia da questo nuovo contatore anziché da quello trovato nello schema. Se necessario, puoi utilizzare l'istruzione ALTER SEQUENCE (GoogleSQL, PostgreSQL) per eseguire l'aggiornamento a un nuovo contatore.

Nota sull'importazione di tabelle con interleaving e chiavi esterne

Il job Dataflow può importare tabelle con interleaving, consentendoti di mantenere le relazioni padre-figlio dal file di origine. Tuttavia, i vincoli di chiave esterna non vengono applicati durante il caricamento dei dati. Il job Dataflow crea tutte le chiavi esterne necessarie dopo il completamento del caricamento dei dati.

Se hai vincoli di chiave esterna nel database Spanner prima dell'inizio dell'importazione, potresti riscontrare errori di scrittura dovuti a violazioni dell'integrità referenziale. Per evitare errori di scrittura, valuta la possibilità di eliminare le chiavi esterne esistenti prima di avviare il processo di importazione.

Scegli una regione per il job di importazione

Potresti voler scegliere un'altra regione in base alla posizione del tuo bucket Cloud Storage. Per evitare addebiti per il trasferimento di dati in uscita, scegli una regione che corrisponda alla località del bucket Cloud Storage.

Se la posizione del bucket Cloud Storage è una regione, puoi usufruire dell'utilizzo gratuito della rete scegliendo la stessa regione per il job di importazione, se disponibile.

Se la posizione del bucket Cloud Storage è una doppia regione, puoi usufruire dell'utilizzo gratuito della rete scegliendo una delle due regioni che compongono la doppia regione per il job di importazione, supponendo che una delle regioni sia disponibile.

- Se una regione colocalizzata non è disponibile per il tuo job di importazione o se la località del bucket Cloud Storage è una multiregione, vengono applicati addebiti per il trasferimento di dati in uscita. Consulta i prezzi del trasferimento di dati di Cloud Storage per scegliere una regione che comporti gli addebiti per il trasferimento di dati più bassi.

Visualizzare o risolvere i problemi relativi ai job nell'interfaccia utente di Dataflow

Dopo aver avviato un job di importazione, puoi visualizzare i dettagli del job, inclusi i log, nella sezione Dataflow della console Google Cloud .

Visualizza i dettagli del job Dataflow

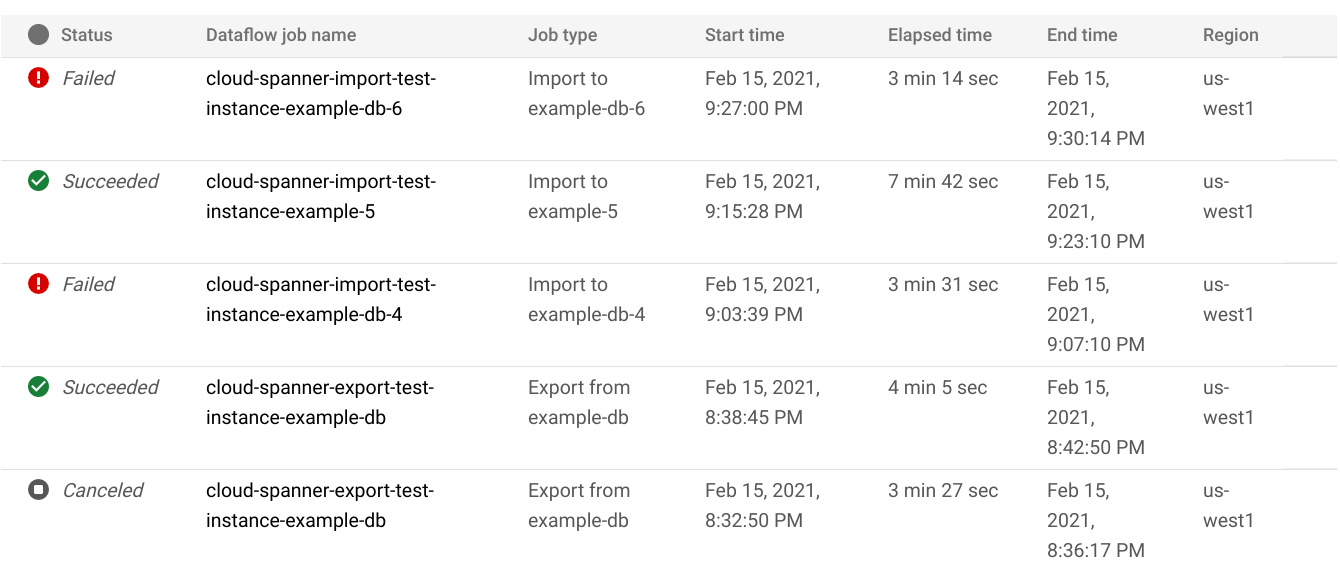

Per visualizzare i dettagli di tutti i job di importazione o esportazione eseguiti nell'ultima settimana, inclusi quelli in esecuzione:

- Vai alla pagina Panoramica del database per il database.

- Fai clic sulla voce di menu Importa/Esporta nel riquadro a sinistra. La pagina Importa/Esporta del database mostra un elenco dei job recenti.

Nella pagina Importa/Esporta del database, fai clic sul nome del job nella colonna Nome job Dataflow:

La console Google Cloud mostra i dettagli del job Dataflow.

Per visualizzare un job eseguito più di una settimana fa:

Vai alla pagina Job Dataflow nella console Google Cloud .

Trova il tuo lavoro nell'elenco e fai clic sul suo nome.

La console Google Cloud mostra i dettagli del job Dataflow.

Visualizzare i log Dataflow per il job

Per visualizzare i log di un job Dataflow, vai alla pagina dei dettagli del job, quindi fai clic su Log a destra del nome del job.

Se un job non va a buon fine, cerca gli errori nei log. Se si verificano errori, il conteggio degli errori viene visualizzato accanto a Log:

Per visualizzare gli errori del job:

Fai clic sul conteggio degli errori accanto a Log.

La console Google Cloud mostra i log del job. Potresti dover scorrere per visualizzare gli errori.

Individua le voci con l'icona di errore

.

.Fai clic su una singola voce di log per espandere i relativi contenuti.

Per saperne di più sulla risoluzione dei problemi relativi ai job Dataflow, vedi Risolvere i problemi della pipeline.

Risolvere i problemi relativi ai job di importazione non riusciti

Se visualizzi i seguenti errori nei log dei job:

com.google.cloud.spanner.SpannerException: NOT_FOUND: Session not found --or-- com.google.cloud.spanner.SpannerException: DEADLINE_EXCEEDED: Deadline expired before operation could complete.

Controlla la latenza di scrittura del 99% nella scheda Monitoraggio del tuo database Spanner nella consoleGoogle Cloud . Se mostra valori elevati (più secondi), significa che l'istanza è sovraccarica, causando timeout e errori di scrittura.

Una delle cause dell'elevata latenza è che il job Dataflow viene eseguito utilizzando troppi worker, il che comporta un carico eccessivo sull'istanza Spanner.

Per specificare un limite al numero di worker Dataflow, anziché utilizzare la scheda Importa/Esporta nella pagina dei dettagli dell'istanza del database Spanner nella console Google Cloud , devi avviare l'importazione utilizzando il modello Cloud Storage Avro to Spanner e specificare il numero massimo di worker come descritto di seguito:Console

Se utilizzi la console Dataflow, il parametro Numero massimo di worker si trova nella sezione Parametri facoltativi della pagina Crea job da modello.

gcloud

Esegui il comando gcloud dataflow jobs run

e specifica l'argomento max-workers. Ad esempio:

gcloud dataflow jobs run my-import-job \

--gcs-location='gs://dataflow-templates/latest/GCS_Avro_to_Cloud_Spanner' \

--region=us-central1 \

--parameters='instanceId=test-instance,databaseId=example-db,inputDir=gs://my-gcs-bucket' \

--max-workers=10 \

--network=network-123

Risolvere l'errore di rete

Quando esporti i database Spanner, potrebbe verificarsi il seguente errore:

Workflow failed. Causes: Error: Message: Invalid value for field 'resource.properties.networkInterfaces[0].subnetwork': ''. Network interface must specify a subnet if the network resource is in custom subnet mode. HTTP Code: 400

Questo errore si verifica perché Spanner presuppone che tu voglia utilizzare

una rete VPC in modalità automatica denominata default nello stesso progetto del

job Dataflow. Se non hai una rete VPC predefinita nel progetto o se la tua rete VPC è in modalità personalizzata, devi creare un job Dataflow e specificare una rete o una subnet alternativa.

Ottimizzare i job di importazione a esecuzione lenta

Se hai seguito i suggerimenti nelle impostazioni iniziali, in genere non dovresti apportare altre modifiche. Se il job viene eseguito lentamente, puoi provare alcune altre ottimizzazioni:

Ottimizza la posizione del job e dei dati: esegui il job Dataflow nella stessa regione in cui si trovano l'istanza Spanner e il bucket Cloud Storage.

Assicurati che le risorse Dataflow siano sufficienti: se le quote di Compute Engine pertinenti limitano le risorse del job Dataflow, la pagina Dataflow nella console Google Cloud mostra un'icona di avviso

e messaggi

di log:

e messaggi

di log:

In questa situazione, aumentare le quote per CPU, indirizzi IP in uso e disco permanente standard potrebbe ridurre il tempo di esecuzione del job, ma potresti incorrere in costi maggiori di Compute Engine.

Controlla l'utilizzo della CPU di Spanner: se noti che l'utilizzo della CPU per l'istanza è superiore al 65%, puoi aumentare la capacità di calcolo in quell'istanza. La capacità aggiunge più risorse Spanner e il job dovrebbe accelerare, ma si verificano più addebiti Spanner.

Fattori che influiscono sulle prestazioni del job di importazione

Diversi fattori influiscono sul tempo necessario per completare un job di importazione.

Dimensioni del database Spanner: l'elaborazione di più dati richiede più tempo e risorse.

Schema del database Spanner, tra cui:

- Il numero di tavoli

- La dimensione delle righe

- Numero di indici secondari

- Il numero di chiavi esterne

- Numero di modifiche in tempo reale

Tieni presente che la creazione di indici e chiave esterna continua dopo il completamento del job di importazione Dataflow. Gli stream di modifiche vengono creati prima del completamento del job di importazione, ma dopo l'importazione di tutti i dati.

Posizione dei dati: i dati vengono trasferiti tra Spanner e Cloud Storage utilizzando Dataflow. Idealmente, tutti e tre i componenti si trovano nella stessa regione. Se i componenti non si trovano nella stessa regione, lo spostamento dei dati tra le regioni rallenta il job.

Numero di worker Dataflow: per ottenere buone prestazioni sono necessari worker Dataflow ottimali. Utilizzando la scalabilità automatica, Dataflow sceglie il numero di worker per il job in base alla quantità di lavoro da svolgere. Il numero di worker sarà comunque limitato dalle quote per CPU, indirizzi IP in uso e disco permanente standard. L'interfaccia utente Dataflow mostra un'icona di avviso se rileva limiti di quota. In questa situazione, l'avanzamento è più lento, ma il job dovrebbe comunque essere completato. La scalabilità automatica può sovraccaricare Spanner, causando errori quando è presente una grande quantità di dati da importare.

Carico esistente su Spanner: un job di importazione aggiunge un carico della CPU significativo a un'istanza Spanner. Se l'istanza ha già un carico esistente sostanziale, il job viene eseguito più lentamente.

Quantità di capacità di calcolo di Spanner: se l'utilizzo della CPU per l'istanza è superiore al 65%, il job viene eseguito più lentamente.

Ottimizzare i worker per prestazioni di importazione ottimali

Quando avvii un job di importazione Spanner, i worker Dataflow devono essere impostati su un valore ottimale per garantire un buon rendimento. Un numero eccessivo di worker sovraccarica Spanner, mentre un numero troppo basso di worker comporta prestazioni di importazione deludenti.

Il numero massimo di worker dipende molto dalle dimensioni dei dati, ma idealmente l'utilizzo totale della CPU Spanner dovrebbe essere compreso tra il 70% e il 90%. Questo offre un buon equilibrio tra l'efficienza di Spanner e il completamento dei job senza errori.

Per raggiungere questo target di utilizzo nella maggior parte degli schemi e degli scenari, consigliamo un numero massimo di vCPU worker compreso tra 4 e 6 volte il numero di nodi Spanner.

Ad esempio, per un'istanza Spanner a 10 nodi, utilizzando worker n1-standard-2, imposteresti il numero massimo di worker su 25, ottenendo 50 vCPU.